- Magisk

- iPhone topik

- Google Pixel 8 Pro - mestersége(s) az intelligencia

- Samsung Galaxy Watch6 Classic - tekerd!

- Telekom mobilszolgáltatások

- Átlépi végre az iPhone az 5000 mAh-t?

- Samsung Galaxy A54 - türelemjáték

- Megjelent a Poco F7, eurós ára is van már

- Redmi Note 13 Pro 5G - nem százas, kétszázas!

- Milyen okostelefont vegyek?

Új hozzászólás Aktív témák

-

Darkness

aktív tag

igen, lehetséges, de kicsit utána olvasva, komplexebb lett a számítási algoritmus.

Mivel az AP csomagok is lassan jönnek, s abból is csak GPU -ra (intel), így kifuttatom és marad az eredeti BOINC. majd megvárom mikor dobják ki az optimalizáltat. Most nincs kedve meghekkelni az XML fájlt. lehet több kár lenne belőle, mint haszon...

bár ha kredit pontokat nézem... baromi nagy esésnek nézek elibe... a 9000+ átlagom, gyorsan fog hullani...

a 9000+ átlagom, gyorsan fog hullani...

de marad a stabil 8. ...

-

coyote55

őstag

Ha már így kisarkítottad a kérdést, fordítsuk meg: dolgoztatom a gépet a "köz javáért", kapok érte valamennyi üveggyöngyöt (kreditet, az értékük körülbelül azonos, azaz alulról tendál a 0 felé), a gép által fogyasztott áram árát pedig a legyek hordják össze... És igen, ha már én fizetem a zenészeket, én mondom meg, mit játszanak.

A nulla kreditet azért nem értem, mert akkor miért regisztrált, ha nem fut a gépén a BOINC? Nem lenézés, csak csodálkozás volt, nem tudom, honnan vetted a lenézést...

Peace! -

DRB

senior tag

Hatékonyabb persze, de hidd el nem sokkal, max 15%(vagy még kevesebb), legalábbis a SETI-ben. Nyilván ez is jobb mint a semmi, egyébként elég nehéz eldönteni, hogy mennyi az annyi, mert össze-vissza hosszúságúak a csomagok. Vagyis nem, hazudok, még is el lehet dönteni könnyen

(letöltök nyolc csomagot, csinálok a BOINC munkamappájáról egy másolatot, utána megnézem mennyi idő alatt számolja ki csomagokat, majd miután készen vannak visszamásolom az elmetett állapotot és Hyper-Threading-el(vagy épp nélkül, attól függően hogy kezdtem) is kiszámoltatom a csomagokat), de nagyon nincs kedvem szórakozni vele. Régebben P4-en kísérleteztem ezzel, akkor kb. 0% javulást hozott, igaz az újabb procik jobban hasznosítják a HT-et, de ebből le kell vonni az intel nagyotmondását, így marad 10-15%. A SETI-nél sajnos az a baj, hogy a magon belül ugyan azt az egységet használják a szálak, így a párhuzamos lefutás gyakorlatilag lehetetlen, csak a soros, vagy majdnem csak a soros. Valaki itt a PH!-n(vagyis a LOGOUT-on) méricskélte a HT-et, de nem találom, volt benne egy szintetikus teszt, azt hiszem az AVX-et használta, és sokkal lassabb volt HT-el, mint anélkül, na a SETI is pont olyan mint egy szintetikus tesz és pont az AVX-et használja. Azért javul mégis valamit a HT-el, mert a SETI mellett még ezer dolog fut egy Windowsban(ha csak az egeret meglököd már indítani kell egy-két-három-akármennyi plusz szálat), még egy frissen telepítettben is, és ezek az egyébszálak jó eséllyel más erőforrásokat használnak a magon belül, így mehet párhuzamosan a két dolog(SETI + akármi). Ha meg nincs bekapcsolva a HT, akkor ezeket nem tudja párhuzamosítani, csak a tényleg létező magok erejéig, és mivel ezer dolog fut, így rendesen lassítják a SETI-t. Szóval összességében igazad van, tényleg gyorsabb lett, de maradjunk abban, hogy „valamivel”, a többi maszlagot meg hagyjuk rá az intek marketingeseire.

(letöltök nyolc csomagot, csinálok a BOINC munkamappájáról egy másolatot, utána megnézem mennyi idő alatt számolja ki csomagokat, majd miután készen vannak visszamásolom az elmetett állapotot és Hyper-Threading-el(vagy épp nélkül, attól függően hogy kezdtem) is kiszámoltatom a csomagokat), de nagyon nincs kedvem szórakozni vele. Régebben P4-en kísérleteztem ezzel, akkor kb. 0% javulást hozott, igaz az újabb procik jobban hasznosítják a HT-et, de ebből le kell vonni az intel nagyotmondását, így marad 10-15%. A SETI-nél sajnos az a baj, hogy a magon belül ugyan azt az egységet használják a szálak, így a párhuzamos lefutás gyakorlatilag lehetetlen, csak a soros, vagy majdnem csak a soros. Valaki itt a PH!-n(vagyis a LOGOUT-on) méricskélte a HT-et, de nem találom, volt benne egy szintetikus teszt, azt hiszem az AVX-et használta, és sokkal lassabb volt HT-el, mint anélkül, na a SETI is pont olyan mint egy szintetikus tesz és pont az AVX-et használja. Azért javul mégis valamit a HT-el, mert a SETI mellett még ezer dolog fut egy Windowsban(ha csak az egeret meglököd már indítani kell egy-két-három-akármennyi plusz szálat), még egy frissen telepítettben is, és ezek az egyébszálak jó eséllyel más erőforrásokat használnak a magon belül, így mehet párhuzamosan a két dolog(SETI + akármi). Ha meg nincs bekapcsolva a HT, akkor ezeket nem tudja párhuzamosítani, csak a tényleg létező magok erejéig, és mivel ezer dolog fut, így rendesen lassítják a SETI-t. Szóval összességében igazad van, tényleg gyorsabb lett, de maradjunk abban, hogy „valamivel”, a többi maszlagot meg hagyjuk rá az intek marketingeseire.

-

DRB

senior tag

Ja, csak majdnem dupla annyi ideig számol egy csomagot. Hiszen nem lett 8 mag a 4-ből a HT-val, annyi történt mindössze, hogy négy virtuális magom lett pluszban, igaz így van esélye némi hatásfok javulásnak, bár az is igaz, hogy jelen esetben a szálak ugyan azon számolóegységeket használnak a magokban, így rossz esetben akár egymást is zavarhatják. Szerencsére ez sem igaz teljese, így némileg mégiscsak gyorsult a történet, de hogy időegység alatt kétszer annyit számolna ki, az még mesének is erős lenne.

-

C0d3r

addikt

A BOINC-ot fejlesztők egy új kredit rendszeren dolgoznak, a CreditNew-n, SETI-ék már ezt használják. Céljuk, hogy létrehozzanak egy egységes rendszert, amibe a projektek tulajdonosai nem tudnak belenyúlni (kódba, beállításokba - mennyit adjanak egy csomagért), így mindegyik projektben ugyanannyi kredit járna a munkaóráért, csalások ellen is ellenállóbb lenne.

Több GPU-s projekt is próbálkozott vele, de gyorsan visszaállításra került a jelenlegi. -

P.H.

senior tag

Abszolút igazad van, én kettő(+1) ok miatt indultam el más úton:

- nem a rendszerpartíción tartom a BOINC mappát, így OS(verzió)/hardver csere után is elég egy BOINC reinstall ugyanoda, és folytatódik minden szinte ugyanonnan; ilyenkor nem járható út az opt. uninstall.

- pár hónapja a Lunatics teljes Download szekciója le volt tiltva a project kérésére problémák miatt (most ránéztem, él megint), akkor az install-csomag sem volt elérhető.

- a problémák hasonló gyökerűek is lehettek, mint most az Collatz OpenCL-részénél: a legfrissebb AMD driverekkel hibázik a számítás (a hibás számítások pedig tovább növelik a szerver-terhelést, ami a Seti-nél eléggé kritikus kérdés):

"A number of people have complained to AMD that the exact same code no longer runs on the new drivers even though it runs on Intel OpenCL, nVidia OpenCL, and previous AMD OpenCL drivers. The in the 13.x versions, AMD tried to better optimize the code. They succeeded in a couple areas but broke others. Some have complained that even simple addition caused a failure in their code depending upon the number of variables, etc. On the up side, AMD says they are working on it. On the down side, that could be 2-3 months away."

A CUDA-nál jobban figyelnek ilyesmire, az AMD-nél kevésbé, ezzel együtt kell élni. -

Rent

senior tag

Hát nem oldotta meg így sem, szépen leszedte az összes fájlt újra, és nagyjából 20-30%-ig jut egy ati-s csomaggal majd becrashel catalyst. Mostmár hagyom az egészet. Nem értem miért nem tudnak egy stabil verziót kidobni. Ha nekik ennyire nem kell a támogatás, én nem erőlködöm tovább.

-

DRB

senior tag

Igazából, hogy most 20 vagy 21(vagy esetleg 19), oly mindegy, már kb .12.-én kinn kellett volna lennie, merthogy akkoriban kezdődött a harc szerverrel, meg amúgy is kidühöngtem már magam, szal akár ki sem kellett volna tenni miattam(ha ki sem írják, akkor akkor sincs semmi, én már úgy is „szúszáztam” vagy két napja addigra).

-

DRB

senior tag

Én is a másodiknál kezdeném.

Nálam soha semelyik BOINC, semelyik projekttel, semelyik csomaggal(CPU, GPU(ATi nVidia)) nem csinált olyat, hogy nem számolná az időt, ezért nem volt ötletem(bizonyára kerestem volna megoldást, vagy legalább megpróbáltam volna, ha tapasztalom). De akkor a soraidból látom, sajnos ez egy általánosabb probléma, mint ahogy én azt hittem, és nem csak egy egyedi hiba Iscariah fórumtársnál. Reméljük, azért csak csak lesz majd megoldás rá.

Nálam soha semelyik BOINC, semelyik projekttel, semelyik csomaggal(CPU, GPU(ATi nVidia)) nem csinált olyat, hogy nem számolná az időt, ezért nem volt ötletem(bizonyára kerestem volna megoldást, vagy legalább megpróbáltam volna, ha tapasztalom). De akkor a soraidból látom, sajnos ez egy általánosabb probléma, mint ahogy én azt hittem, és nem csak egy egyedi hiba Iscariah fórumtársnál. Reméljük, azért csak csak lesz majd megoldás rá.Az első bekezdéshez meg annyit azért hozzátennék, hogy bizony a "Próbálja most" gomb működik(hellyel-közzel), ha meg akadékoskodik(pl próbálkozik fél percig majd újra kiír valami irreális időt), akkor meg kell nyomkodni újra, na persze amikor "egymásodprecezik", hát akkor egy másodpercenként kell megnyomni, nem tudsz mást tenni(egyébként ez a legidegesítőbb, meg sem próbálja és egy másodperc elteltével meg kiírja, hogy ~10 óra múlva próbálja újra). Illetve van még egy lehetőség. Fent a menüsoron az "Aktivitás" gomb megnyomására legördülő menüben, a "Hálózati forgalom felfüggesztve" lehetőségre állítod a pöttyöt, majd kis idő múlva vissza "A hálózati forgalom mindig elérhető"-re, erre általában úgy szokott reagálni hogy megindul a letöltés, de hogy meddig bírja, na az már egy másik kérdés.

Jó esetben, nekem 4-6 csomagot is letölt, mire újfent megakad.

Jó esetben, nekem 4-6 csomagot is letölt, mire újfent megakad.

Én így szoktam megküzdeni vele(velük), de le is szedem a csomagokat, ha törik ha szakad. Persze nem mindig van kedvem társasjátékozni(Ki nevet a végén ) a SETI BOINC csapat ellen, ezek ketten együtt már elég kemény diók.

) a SETI BOINC csapat ellen, ezek ketten együtt már elég kemény diók.

-

#95904256

törölt tag

A Kepler űrtávcsöves dologhoz annyit hozzáfűznék, hogy már két és fél éve üzemel és még úgy kb. egy évet fog is. Ez alatt az egy év alatt számos hasonló bolygó felfedezése várható tőle, holott az elmúlt bő két évben még alig talált valamit. De mindez az alkalmazott eljárásból adódik. Ugyanis a Kepler űrtávcső azt figyeli ahogy egy-egy bolygó elhalad a központi csillag előtt. A biztos érzékelés érdekében legalább háromszor kell azonosítani egy bolygót, ami egyben azt is jelenti, hogy a keringési idejének legalább a kétszeresét ki kell várni. A Föld esetében ez ugye minimum 2 évet jelentene...

Bajban lesznek a SETI-sek, ha több tucat bolygót talál a Kepler.

-

DRB

senior tag

A szavaiból ítélve, jócskán több volt a lemaradása mint két év. Jó esély van rá, ha így folytatjuk, hogy Iscariah fórumtárs még idén behozza a lemaradását, BOINC/SETI információk terén.

Más téma:

Már valamelyik nap akartam írni, hogy van egy új(pár hónapos) project, elég komoly, én már csatlakoztam hozzájuk, elég bonyolult a feldolgozás módja, de ígéretesnek tűnik ettől függetlenül.

-

DRB

senior tag

-

Apollyon

Korrektor

Köszi a választ! Igen láttam, valóban régiek ott már az adatok.

Már csatlakoztam a Hungary csapathoz, végülis gondolom mindegy.

Amúgy az adatlapomon lévő géppel nyomom, Phenom II X4, meg egy Radeon 4670...

Már megcsináltam azóta 2x 5 órás csomagokat, ugye 4-et kapok egyszerre /csomag, minden CPU magra ugye 1-1 szál.Pár órája meg kaptam 35-36 órás csomagokat

Azért ezt nem két nap alatt fogom megcsináltatni

Azért ezt nem két nap alatt fogom megcsináltatni Gondolom a villanyszámlán meg fog látszani hogy SETIvel fűtöm a szobát...

Gondolom a villanyszámlán meg fog látszani hogy SETIvel fűtöm a szobát... -

plömplöm

őstag

köszi, lehet. újabb érdekesség, ezt találtam: [link]

ez azzal indít, hogy:

"CUDAMemTest v0.50a , done by TetedeienchUsing device 0: GeForce 8400 GS

Number of Compute capable device : 1Working on 208 MB of memory instead of 209MB (1664 blocks of 128KB)

Number of threads used for writing : 1, for reading : 32"azaz 208MB-ot "lát", ami viszont kevés a seti-nek, nemdebár?

és ez a fenti programocska valamit tényleg csináltat is a gpu-val, végre mutat valamit aktivitást a gpuz...

-

#95904256

törölt tag

Ugyanaz, csak magyarul: Mégis hallgatóznak

-

cigam

titán

Köszi! Te képben vagy a GPU-k terén?

Konkrétan az lenne a kérdésem, hogy néhány projekt "Double precision GPU"-t igényel, ill. a GPU a vidókonvertálásra is rásegít. Szóval aki nem játékra használbá, csak a fenti 2 dologra, az melyik kártyával kap költséghatékony csendes megoldást? -

DRB

senior tag

Win7 alatt nem szokott problémát jelenteni ez a fajta váltás(nálam is úgy költözött XP-ről W7 64-bitre ahogy leírtam, és semmi gond nem adódott), de ettől függetlenül igazad van, biztosabb kifuttatni a régi rendszeren és utána költöztetni dolgokat. De sürgős volt a költözés, ezért írtam ahogy írtam.

A VGA kérdés is jogos, bár nekem volt egy laptoppom, valami hasonló vidkari volt benne mint Darkness-nek, teszt céljából felraktam a BOINC-ot és hát nem igazán volt gyorsabb a procinál a GPU, bár pontosan nem emlékszem, de mintha kb. egyformák lettek volna. Persze ha azt nézzük, akkor 50%-al növeltem a számítási teljesítményt amikor befogtam a VGA-t, tehát megéri végül is, még ha nem is gyorsabb.

-

DRB

senior tag

Sikerült megoldani/rájönni(google a barátom).

A driver meg a CUDA is rendben volt, a telepítéssel akad egy kis baj. Úgy néz ki nem szabad service ként telepíteni a BOINC-ot, mert akkor valamiért nem fér hozzá a GPU-hoz, az, hogy Nv vagy ATi videókártya tök mindegy, mind a kettővel ez van. Állítólag a Win7/Vista illetve a VGA driver hibája, a BOINC-nak ehhez nincs köze, szerintem meg valahol a kettő között van az igazság. Szóval a lényeg, ha valaki Win7/Vistán ki akarja használni az erre alkalmas GPU-t, akkor normál módon kell telepíteni a BOINC-ot(elvben az XP-nél mehet service-ként, ott nincs ilyen probléma, de ezt le kell még tesztelni), utána ha azt akarja, hogy hasonlóan fusson mintha service lenne akkor kicsit matatni kell a registry-ben, ha valakit érdekel leírom a részleteket is. Szóval nagyjából ennyi, nem lenne ez nagy ügy, persze csak ha tudod mi a pálya, de mivel nem tudtam, eddig nem volt a fenti hibát okozó kombinációban gépem, hát szívtam kicsit vele.

A driver meg a CUDA is rendben volt, a telepítéssel akad egy kis baj. Úgy néz ki nem szabad service ként telepíteni a BOINC-ot, mert akkor valamiért nem fér hozzá a GPU-hoz, az, hogy Nv vagy ATi videókártya tök mindegy, mind a kettővel ez van. Állítólag a Win7/Vista illetve a VGA driver hibája, a BOINC-nak ehhez nincs köze, szerintem meg valahol a kettő között van az igazság. Szóval a lényeg, ha valaki Win7/Vistán ki akarja használni az erre alkalmas GPU-t, akkor normál módon kell telepíteni a BOINC-ot(elvben az XP-nél mehet service-ként, ott nincs ilyen probléma, de ezt le kell még tesztelni), utána ha azt akarja, hogy hasonlóan fusson mintha service lenne akkor kicsit matatni kell a registry-ben, ha valakit érdekel leírom a részleteket is. Szóval nagyjából ennyi, nem lenne ez nagy ügy, persze csak ha tudod mi a pálya, de mivel nem tudtam, eddig nem volt a fenti hibát okozó kombinációban gépem, hát szívtam kicsit vele. -

DRB

senior tag

Nekem is úgy tűnik, hogy sehogy, bár reménykedtem, hogy csak valami beállítást nem vettem észre, ahol ezt lehet szabályozni. Márpedig valahogy meg kéne azt oldani, hogy ne manuálisan keljen már nyomkodni, hogy lebányásszon (astropulse)csomagot. Vagyis úgy értem, hogy legalább is próbálkozzon vele, na persze semmi nem jön, pedig van küldendő csomag a szerveren.

A fel/letöltés résznél nálam volt 10 óra is, bár ez talán egyszer(vagy is egyszer vettem észre, hogy ilyen sok), egyébként olyan 2 óra körül idő múlva próbálkozik újra, ha nem tudja fel/letölteni. A régebbi BOINC-oknál ez eleinte csak fél perc körül, majd kicsit később is csak néhány perc volt, most meg egyből 1-2 óra. A projektfrissítésnél meg nálam tök változó, de tény, hogy eleinte sűrűbben azután, ahogy telik az idő, egyre ritkábban próbálkozik.

-

DRB

senior tag

Ez jó hír.

De vajon lehet majd letölteni Astropulse csomagokat? A múltkori "panaszkodásom" óta egyet sem tudtam levarázsolni, ugyanazokat a "hibákat" írogatja a BOINC azóta is egyfolytában.

De vajon lehet majd letölteni Astropulse csomagokat? A múltkori "panaszkodásom" óta egyet sem tudtam levarázsolni, ugyanazokat a "hibákat" írogatja a BOINC azóta is egyfolytában.

Közben azon gondolkozom vajon melyik lehet a gyorsabb, a GPU/CPU hybrid vagy a sima GPU-s verzió? -

DRB

senior tag

A hibridet használom, vagyis használnám, ha kapnék csomagot, de kb 3-4 hónapja kaptam utoljára astropulse csomagot, ezért reklamálok. És ahogy írod a "home" gépnél be van pipálva mindkét verzió, a többi gép "default"-ban van ott meg nincs bepipálva a két astropulse(ezekben nincs megfelelő VGA, se ATi se nV, procival meg kínszenvedés).

-

P.H.

senior tag

"bár elvileg most van elég"

Az Astopulse eléggé mostohagyerek.A csomagküldés most eléggé kiszámíthatatlan, épp nem most van az ideje változtatni a beállításokon vagy utolsó esélyt adni.

Rengeteg (túl)húzott* NV-kártya van most a SETI szolgálatában, amik az Enhanced-re a hibás eredményeket perces gyakorisággal produkálták, ezt nem bírták a szerverek; ehhez hozzájárul, hogy egy opt. CUDA-app nem mindig adja pontosan ugyanazt az eredményt, mint egy 6.03-as CPU-s; ezért most eléggé belassították a project mozgásterét.

A legjobb most megvárni, amíg véget ér ez a heti 3 napos "scientific and development" leállási időszak, mert ez elég zűrös.

Májusban lecserélték a validate és a pre-estimate algoritmusokat; az előbbi velejárója a 20-25%-kal nagyobb (és egyben egyelőre - CUDA-n legalábbis - átláthatatlan) értékelési rendszer lett; az utóbbi először pár másodperces futási időt becsült, amivel "szerencsésen" leterhelték a download server-eket, ennek következtében bevezették a napi max. 20 csomag/gép elvet. A múlt héten megint lecserélték a pre-estimate rendszert, ekkor meg a fél órás CUDA-csomagokra 7 órát jósol(t), kiürült majdnem az egész client-park cache-e.

Most kb. normális a rendszer, de megint péntekig nem lesz nagy mozgás (download/upload).Nekem 8 napra van beállítva a cache, ez tavaly óta elég (akkor 7 napos cache-el kifutottam egyszer a feladatokból). Mondjun Astropulse-t nem számolok.

*(túl)húzott: nálam a DDR3 1GB-os GT220 hivatalos 800 MHz-es gyári órejelén rontja a csomagokat (végigszámolja, de folyamatos validation inconclusive), ezért megvétele óta 733 MHz-es memóriával használom; a shader-eket és a magórajelet akárhova húzhatom, előbb fagy a teljes rendszer, minthogy hibás csomagot számolna.

A korábbi GDDR3 256 MB-os passzív GT 9500-zal sosem volt ilyen probléma, azt 800-ról 1000-1050-re állíthattam általában. -

DRB

senior tag

Ez az infó inkább nekem kell, de sajnos sem ezzel, sem amit moonguru írt nem sokra jutottam, de mindegy majd egyszer csak lesz valami. Azért köszi.

Viszont ha már a beállításokról van szó akkor lenne még egy kérdésem. Két astropulse van, a sima meg a v5, mindkettőt kipipáljam ha ATi kártyán szeretném futtatni, vagy csak az egyiket? Mondjuk ki is tudnám próbálni, de már nagy kedvem nincsen az egészhez, mindent megpróbáltam ezen kívül, de hiába, ha a fejemen pörgök akkor sem jön le astropulse csomag. És lövésem nincs mi lehet a gond

-

DRB

senior tag

Te érted félre, nem a hírekből másoltam ki, hanem a fórumból, úgy került a fórumba az írás mint pl. ez amit most írok, leírom, nyomok egy entert és annak a pillanatnak a dátuma lesz a post dátuma, ennyi. És írtam azt is, hogy lehet máshol már előbb kiírta valaki, de én nem láttam azt, így nem tudtam róla.

A csomagokra meg írtam, hogy igazad van, a barátom is kapott, csak nekem nem sikerült sehogy lehúzni párat. A szerver státuszból meg a hiába való próbálkozásokból nagyon úgy tűnt, hogy nem oszt csomagot a szerver, de tévedtem. -

DRB

senior tag

"bár én a seti fórum Technical News-éből idéztem be. Lehet máshol előbb kint volt."

Akkor postolta az ember(Matt Lebofsky) amit dátumot kimásoltam, de ott a link meg lehet nézni. Egyébként meg tök mindegy, majd két hete "szarakodnak" ezzel-azzal, emiatt írtam ide is meg máshova is. Nem szidom őket csak a tényeket meg amit tapasztaltam azt írtam le. Tegnap valóban volt olyan pillanat amikor osztott csomagot(barátom kapott 5-6 csomagot, az egész nap folyamán összesen, meg te is ahogy írod), ebben igazad van

, de tényleg csak pillanatok voltak. És szerintem ez nem normális állapot, erre reagáltam, illetve erre az egész kb. két hétre reagálok egyfolytában. Egyébként ha tudnék(ha lenne rá lehetőségem) szívesen segítenék nekik, ez a szakmám, ha gáz van egy sz.géppel meg kell csinálnom.

, de tényleg csak pillanatok voltak. És szerintem ez nem normális állapot, erre reagáltam, illetve erre az egész kb. két hétre reagálok egyfolytában. Egyébként ha tudnék(ha lenne rá lehetőségem) szívesen segítenék nekik, ez a szakmám, ha gáz van egy sz.géppel meg kell csinálnom.

-

DRB

senior tag

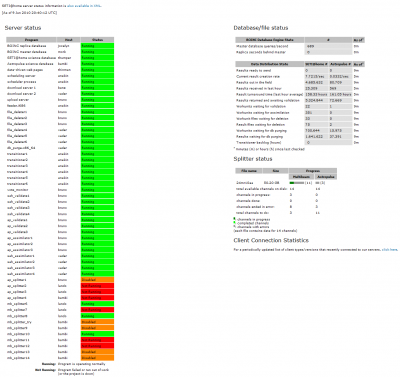

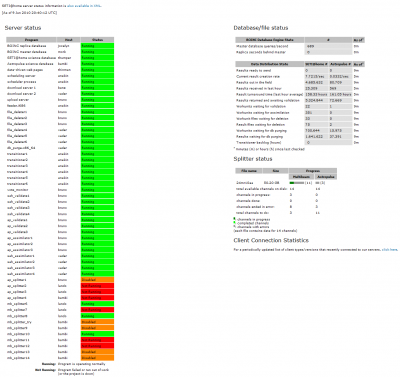

Tegnap biztos nem osztott csomagot, pedig próbáltam elég sokat manuálisan, az összes splitter disabled vagy not running volt gyakorlatilag egész nap, a "Results ready to send" is 0 volt folyamatosan. Aztán egy idő után meguntam a manuális frissítgetést. Jelenleg nekem továbbra sem osztott csomagot, valószínű egyszer manuálisan át kéne futni az összes gépen.

Mindegy, majd kapok előbb utóbb én is csomagot, ahogy nézem a "Results ready to send" sem nullán áll már, illetve a szerver státusz is egyre "zöldebb".

Amit beidéztem 9.-én éjjel került oda, ott a dátum is, bár én a seti fórum Technical News-éből idéztem be. Lehet máshol előbb kint volt.

-

DRB

senior tag

Ez nem a sima karbantartás volt, egész nap az volt az állapot ami képen látszik, illetve rosszabb, nem csak 5-6 után. Már vagy 10 napja birkóznak valamivel és jelenleg sem javult a helyzet.

Amúgy ezt találtam ma reggel a "Technical News"-ben:

"Let me address the "no work" issues as of late. We've been running low on work to send out (or had the schedulers turned off) for several reasons:

1. Each raw data file has to go through a local software based radar analysis - a suite of programs that takes over 3 hours to run per file. This should keep up with the incoming data flow, but some nagging NFS/mounting bugs cause this suite to lock up several times a week. Each time it does the whole systems getting new data on line is clogged until a human can figure out where it was in the process, clean it up, and start the broken file over again (resulting in many hours of lost processing time). For example this morning we found it all jammed last night, cleaned it up around 9am, and finally around 12:30pm new workunits were available again. We're working on adding some band-aid solutions to this particular problem.

2. Server crashes: mork and ptolemy are prone to crashing for no apparent reason. Either of them going down causes the project to halt until we recover. Sometimes it takes days to fully get back to a regular work-flow pace again. We're trying to shuffle services around to get ptolemy out of the picture. Why ptolemy instead of mork? Mork is a much bigger system and therefore much harder to replace - plus when it goes down the download servers are at least still able to work for a while.

3. Some data files error out pretty quickly due to noise or garbage data.

4. The CUDA clients sure burn through work fast.

5. Some CUDA clients were returning garbage. To combat this a fix to the scheduler was put on line this Monday, but was unable to start it without errors. It took Eric, Jeff, and I all day, and most of the next morning, to finally find the obscure problem - which was actually a misleading redirect in the apache config (that was put in many months ago). By the time we fixed it, we were already into the weekly outage.

So lots of battles on this front. In any case we are collecting data at this point (on 2TB drives, which means we'll lose less data waiting for the Arecibo operators to swap out the older 500/750GB drives), and still have a backlog of stuff to process in our archives. The lab is also getting a Gbit link to the world in July so the slow transfers to/from these archives will no longer be a bottleneck. Note this link is for the whole lab and our SETI specific data link will remain at 100MBit. Still, it's an improvement.

- Matt"

9 Jun 2010 22:34:27 UTC -

DRB

senior tag

Még mindig tart.

Ugyan az előző hsz-m után másnap vagy harmadnap "megjavul", de csak pár napig, ráadásul nagyon nehezen ment a csomagok letöltése, nem is tudtam kellő mennyiséget begyűjteni, így per pill gyakorlatilag áll minden(nálam).

Mondjuk most nézem a szerver státuszt, mintha történne valami

Nemrég még az "ap_splitter1"-től lefelé minden piros meg narancssárga volt. -

#95904256

törölt tag

Tudok jobbat is...

Jelenleg ugyanaz a számítógép van a "Legjobb hostok" 19-ik és 23-ik helyén is.

-

#95904256

törölt tag

A gépek számát tekintve minimálisan három gép elég ahhoz, hogy egyik csomag se kerüljön kétszer kiszámításra ugyanazon a gépen. Én jelenleg három quaddal számoltatok és a hétvégén izzítom a negyediket, úgyhogy ez a feltétel biztosan adott. Valószínűleg az a gond ahogy te is gondolod, miszerint a szerveren nem ellenőrzik kinek mennek a csomagok. Ez adódhat figyelmetlenségből vagy szándékosságból. Kérdés, hogy ez mekkora kockázatot jelent a projektre...

-

#95904256

törölt tag

Na, megnéztem az SSE3-as dolgot. Egészen más, egyszerűbb ötleten alapul mint a reciprokos. Itt egyszerűen nem egy, hanem két osztás történik egyszerre. A sebességre gyakorolt hatása kb. ugyanakkora lehet mint a másiknak. Egyébként ugyanez az ötlet merült fel bennem most is elsőként, csak valamiért nem akart működni, így lett a reciprokos megoldás. Némi idő befektetésével a két módszer összegyúrható.

A jelenlegi patch-eket megpróbálhatod keresztezni, az eredmény működőképes kód lesz. De az egyik patch felülírja a másikat. Esetleg úgy érdemes megpróbálni, hogy másodjára az SSE3 patch-et futtatod le, mert az csak egy rutint cserél le.

Majd kerítek időt arra, hogy hogyan lehet kombinálni a kettőt. Csak ott már helyet is kell felszabadítani, mert az SSE utasítások nagyon eszik azt. Jelenleg olyan 112/144 bájtba próbáltam beférni.

-

#95904256

törölt tag

Végeztem pár kísérletet, de sajnos a fentebb vázolt egész osztásos probléma miatt nem megbízható az eredmény. Gyakorlatilag úgy lehet elképzelni, hogy néha az 1,0 helyet 0,99999999999 jön ki. Mivel nem tudom, hogy ez megengedhető-e vagy sem, így marad optimalizálatlanul a SZTAKI kód. Egyébként látszik a kódon, hogy valaki forrás szinten akart rajta optimalizálni csak nem tudta, hogy több "kárt" okozott vele mint hasznot.

szerk.: Ja igen. A SZTAKI kódban az egész számokat először lebegőpontossá konvertálják majd úgy számolgatnak vele. Érdekes elképzelés. A kód elvileg univerzális a dimenziók tekintetében, de szerintem az aktuálisnál (13.) nagyobb dimenziószám esetén az FPU pontossága nem elég, így alkalmatlan nagyobb dimenziók számolgatására.

-

#95904256

törölt tag

A SZTAKI kódra szerintem nem működik a régi opti, ugyanis a kód leggyakrabban futtatott rutinját ( 0x402560 ) az a néhány fdiv qword ptr [ecx] utasítás fogja vissza ami épp újítás ebben a kódban a régihez képest. Ezt a műveletet meglehetősen nehéz kiiktatni egész számokon végzett műveletek esetében. Mivel épp az egész többszörösökre gyúr a program, ahol a CPU kerekítési hibái miatt az a/b sajnos nem egyenlő az a*1/b művelettel... azért majd megnézem, hogy unrollinggal lehet-e itt kezdeni valamit.

-

DRB

senior tag

A fene se tudja, lehet tényleg nincs.

Azt nem is néztem amit beírtál, csak alatta a "Splitter status" résznél láttam hogy vannak csomagok. Na mindegy, majd csak lesz valami, ha meg nem akkor ez a gép pihen tovább.

Azt nem is néztem amit beírtál, csak alatta a "Splitter status" résznél láttam hogy vannak csomagok. Na mindegy, majd csak lesz valami, ha meg nem akkor ez a gép pihen tovább.

szerk: Pl. ezt láttad?

SETI@home # / Astropulse #

Results received in last hour 49,827 / 944

Hogy lehet ha nincs csomag? -

#95904256

törölt tag

Csak annyit akartam mondani vele amennyit írtam.

szerk.: Valóban vezette a listát évekig és valóban nincs rajta egy ideje ( pár hónapja már biztos ). Gőzöm sincs, hogy hova tűnt, gondolom egy SETI benfentes jobban tudja mi történhetett. ( Én ugyanis nem SETI-zek már évek óta. ) A projektek nem szoktak csak úgy eltűnni ebből a listából. Az éppen nem futó, de egyszer már létező projekteket is meg szokták jeleníteni, csak eredmények helyett egy megjegyzéssel ( pl.: felfüggesztve, törölve, stb... ) A SETI-nél ilyesmi sincs. Eltűnt.

-

DRB

senior tag

Nahh akkor menjünk sorban.

1: 9.10-es catalyst van.

2: BOINC 6.10.18 van(gondolom ne rakjam vissza a 6.10.17-et).

3: Igen felismeri a GPU-t, több GPU-s alkalmazás fut is rendesen(MilkiWay@home, Collatz Conjecture), de ezek ki voltak lőve amikor próbáltam.

Lehet, hogy csak egyszerűen nem jó csomagot töltött le. Esetleg tényleg nem jó az app_info.xml, vagy(ez most jutott eszembe), talán nem tetszik neki, hogy 64 bites a rendszer meg a BOINC.

Esetleg tényleg nem jó az app_info.xml, vagy(ez most jutott eszembe), talán nem tetszik neki, hogy 64 bites a rendszer meg a BOINC. -

DRB

senior tag

Félreértetted, nem csomagot nem kapok, hanem az a gond, hogy nem a GPU számol hanem a proci. Pedig az fut amit belinkeltél, de csak a procit számoltatja valamiért.

Csomagot elég könnyen kaptam, persze lehet, hogy csak szerencsém volt, de a lényeg: "csak a procit számoltatja valamiért".

Csomagot elég könnyen kaptam, persze lehet, hogy csak szerencsém volt, de a lényeg: "csak a procit számoltatja valamiért". -

DRB

senior tag

Köszi az infót.

Azért az ilyeneket kiírhatnák az oldalukra, régebben ha volt valami megtették, de most...na mind1. Gondolom a seti fórumon ott volt, csak nem mindenki akar ott egerészni, én sem.

Reggel vagy hajnalban nekem is az összes gépemen megindult a fel/letöltés. A "Próbálja újból"-t nyomkodtam vagy egy órán keresztül, a végén már olyan érzésem volt mintha valami lövöldözős játék lenne.

-

Kinder

senior tag

Köszönöm, így már megy is.

Mivel egy Asrock 330 ion gépem van, a dual atom procit inkább kivettem a számolásból...

Na nem mintha a GPU olyan acélos lenne ( 45 perc/csomag ), de ennél a CPU-nál azért gyorsabban számol ( 5-6 óra / csomag ).

Viszont alig fogyaszt, szóval szép lassan termeli a pontot.

-

Kinder

senior tag

jaja, ma reggel újraindítottam a gépet, és míg az előtt úgy futott a seti, mint a linkelt képemen, tehát 3 mag + 1mag+VGA, azóta 1 mag + 1mag+vga, pedig semmit sem állítottam.

dehát asszem így logikus, mert mire 1 mag 1-2 óra alatt kiszámol egy csomagot, addig a vga kiszámol 1-2 perc alatt akár 100-at is, tök felesleges "kínlódnia" a cpu-nak, akjárhány magos.

úgyhogy ja, most ereszthetek rá bármi mást is simán. -

És ha már így belejöttem

, akkor jöjjön egy kis Einstein is:

, akkor jöjjön egy kis Einstein is:Sep 25, 2008

We have completed processing the S5R3 workunits. S5R3 was the first search using the combined F-stat plus Hough method, which is currently the most sensitive search technique that is known. This search used approximately one year of data from LIGO's first science run (S5) at design sensitivity. The S5R3 post-processing is being led by Dr. Maria Alessandra Papa, one of the inventors of the search technique. -

Core2duo6600

veterán

Ez nem úgy van, hogy amig nem kapja mega server, addig újra és ujra kiküldi, hogy biztosan visszaérkezzen ?

A másik lehetőség :

Vár x ideig, ha addig nem készül el, akkor ujra kiküldi.

Ilyenkor elvben magának kellene eldobnia, hiszen már tudhajtja, hogy nem kell kiszámolni.

Nálam is úgy van beállítva, hogy előe ne tárazzon semmit.

De ezt a szatik-it nem is futtatom épp. -

#95904256

törölt tag

A SZTAKI projekt már csak olyan amilyen. Szerintem annak kell örülni ami van. Igyekszem minél komfortosabbá illetve kevésbé nyűgössé tenni a feldolgozást, és nem azzal foglalkozni hogy "mi lenne ha".

1, Sok és hosszú csomag problémája.

A hosszú csomagokból első körben hozzám is lejött több száz darab. Majd ha sikerül hazajutnom, vissza is dobálom ( user abort ) őket. A betárazás mértékét már átállítottam nullára, így várható hogy mindig csak futó illetve minimális mennyiségű előkészített csomag lesz a gépen. Ebből következik hogy a gépem nem fogja szaporítani a haldokló/kallódó csomagok számát.

-

#95904256

törölt tag

Nálami is akadozik a kommunikáció az Einstein@Home szerverrel.

Egyébként köztudott hogy az Einstein-eseknél a legszűkebb keresztmetszet a sávszélességük. A pár hónapja átadott Atlas-t is részben azért építették meg hogy helyben végezhessék a legsévszélességéhesebb dolgokat.

Megjegyezném, tavaly is ilyen akadozós volt a helyzet az S5R2 végén. Ez attól van hogy a "töredék" workunitok kiszámítása miatt most többszörösére nő az adatforgalom is. Ugyanis a projekt során több nagyobb, egymást követő adathalmaz töltődik le a gépre és ezekből valami 240 workunit képződik. Ha valahonnan nem jött vissza 1-2 eredmény, akkor ilyenkor újra le kell tölteni a feldolgozáshoz szükséges adathalmazokat ( l1, h1 fájlok a projekt könyvtárban ).

Pl. nálam az utóbbi 2 hónapban mindössze 96MB-ra hízott a projekt könyvtáram ( köszönhetően annak hogy akkora pufferel dolgozom hogy szinte mind a 240 WU-t nekem küldi a gép ), de ugyanez a 96MB legrosszabb esetben már 10-20 nem egybefüggő WU feldolgozása esetén is szükséges lehet.

-

#95904256

törölt tag

Hali Joci!

A SETI-nek nincs GPU-ra írt verziója? Amennyire tudom sima 32 bites lebegőpontos számokkal dolgozik, az pedig passzol a GPU-s feldolgozáshoz...

szerk.: A dolog onnan jött hogy az Einstein@Home-nál dolgoznak a GPU-s verzión, ami előre láthatóan kb. 7-szer lesz gyorsabb mint a mostani legjobb idők...

-

#95904256

törölt tag

Sajna nem foglalkoztam vele, de ha jól sejtem akkor a http://lists.ssl.berkeley.edu/mailman/listinfo/boinc_loc linken lehet feliratkozni egy levelezőlistára ami a BOINC fordításokkal foglalkozik. Szerintem érdemesebb lenne ott feltenni ezt a kérdést...

-

Kareszovics

addikt

E4k vagy E2k között csak a 12-es szorzójú jöhetne szóba, konkrétan: E2220 vagy E4600. A kettő között mondjuk 30% árkülönbség van.

Nem hiszem, hogy a két proci között számítási teljesítményben SETI terén 30% különbség lenne, amikor átlag max 5% a cache beli különbség más terülteten.

Úgyhogy valszeg az E2220-ra esne a választás.

-

Csináltam egy kis tesztet a fenti optikkal egy AMD X2-es rendszeren...

Eredményeim (ugyanazzal a csomaggal):

- régi SSE2-snél 2:17:11 (jó, itt mondjuk ment ez-az, így lehet rajta pár perc plusz)

- új SSE3-snál 1:19:28

Iszonyat a gyorsulás... Az éjjel megcsinált több csomagot is, és az átlag 2-3 órás csomagokat 1-2 óra alatt ledarálta (és még a csomag is jól lett számolva); vagyis a hosszú csomagoknál durván 1 órával kevesebb idő alatt végez...Nem tudom, C2D alatt mit tud magából kihozni, de a fenti példa után...

Új hozzászólás Aktív témák

Hirdetés

- Elkezdtek szállingózni az Arctic P Pro sorozatú ventilátorai

- Magisk

- Milyen asztali (teljes vagy fél-) gépet vegyek?

- Milyen videókártyát?

- Béta iOS-t használók topikja

- Azonnali notebookos kérdések órája

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Autós topik látogatók beszélgetős, offolós topikja

- Elektromos cigaretta 🔞

- Pécs és környéke adok-veszek-beszélgetek

- További aktív témák...

- Windows, Office licencek kedvező áron, egyenesen a Microsoft-tól - Automata kézbesítés utalással is!

- Assassin's Creed Shadows Collector's Edition PC

- Windows 10/11 Home/Pro , Office 2024 kulcsok

- Adobe Előfizetések - Adobe Creative Cloud All Apps - 12 Hónap - NYÁRI AKCIÓ!

- Eladó Steam kulcsok kedvező áron!

- ÁRGARANCIA!Épített KomPhone Ryzen 7 7700X 32/64GB RAM RTX 4070Ti Super GAMER PC termékbeszámítással

- ÁLTALÁNOS IGAZGATÓHELYETTES tábla

- Azonnali készpénzes GAMER / üzleti notebook felvásárlás személyesen / csomagküldéssel korrekt áron

- Telefon felvásárlás!! Xiaomi Redmi Note 10, Xiaomi Redmi Note 10s, Xiaomi Redmi Note 10 Pro

- Samsung Galaxy Watch Ultra

Állásajánlatok

Cég: CAMERA-PRO Hungary Kft

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

(letöltök nyolc csomagot, csinálok a BOINC munkamappájáról egy másolatot, utána megnézem mennyi idő alatt számolja ki csomagokat, majd miután készen vannak visszamásolom az elmetett állapotot és Hyper-Threading-el(vagy épp nélkül, attól függően hogy kezdtem) is kiszámoltatom a csomagokat), de nagyon nincs kedvem szórakozni vele. Régebben P4-en kísérleteztem ezzel, akkor kb. 0% javulást hozott, igaz az újabb procik jobban hasznosítják a HT-et, de ebből le kell vonni az intel nagyotmondását, így marad 10-15%. A SETI-nél sajnos az a baj, hogy a magon belül ugyan azt az egységet használják a szálak, így a párhuzamos lefutás gyakorlatilag lehetetlen, csak a soros, vagy majdnem csak a soros. Valaki itt a PH!-n(vagyis a LOGOUT-on) méricskélte a HT-et, de nem találom, volt benne egy szintetikus teszt, azt hiszem az AVX-et használta, és sokkal lassabb volt HT-el, mint anélkül, na a SETI is pont olyan mint egy szintetikus tesz és pont az AVX-et használja. Azért javul mégis valamit a HT-el, mert a SETI mellett még ezer dolog fut egy Windowsban(ha csak az egeret meglököd már indítani kell egy-két-három-akármennyi plusz szálat), még egy frissen telepítettben is, és ezek az egyébszálak jó eséllyel más erőforrásokat használnak a magon belül, így mehet párhuzamosan a két dolog(SETI + akármi). Ha meg nincs bekapcsolva a HT, akkor ezeket nem tudja párhuzamosítani, csak a tényleg létező magok erejéig, és mivel ezer dolog fut, így rendesen lassítják a SETI-t. Szóval összességében igazad van, tényleg gyorsabb lett, de maradjunk abban, hogy „valamivel”, a többi maszlagot meg hagyjuk rá az intek marketingeseire.

(letöltök nyolc csomagot, csinálok a BOINC munkamappájáról egy másolatot, utána megnézem mennyi idő alatt számolja ki csomagokat, majd miután készen vannak visszamásolom az elmetett állapotot és Hyper-Threading-el(vagy épp nélkül, attól függően hogy kezdtem) is kiszámoltatom a csomagokat), de nagyon nincs kedvem szórakozni vele. Régebben P4-en kísérleteztem ezzel, akkor kb. 0% javulást hozott, igaz az újabb procik jobban hasznosítják a HT-et, de ebből le kell vonni az intel nagyotmondását, így marad 10-15%. A SETI-nél sajnos az a baj, hogy a magon belül ugyan azt az egységet használják a szálak, így a párhuzamos lefutás gyakorlatilag lehetetlen, csak a soros, vagy majdnem csak a soros. Valaki itt a PH!-n(vagyis a LOGOUT-on) méricskélte a HT-et, de nem találom, volt benne egy szintetikus teszt, azt hiszem az AVX-et használta, és sokkal lassabb volt HT-el, mint anélkül, na a SETI is pont olyan mint egy szintetikus tesz és pont az AVX-et használja. Azért javul mégis valamit a HT-el, mert a SETI mellett még ezer dolog fut egy Windowsban(ha csak az egeret meglököd már indítani kell egy-két-három-akármennyi plusz szálat), még egy frissen telepítettben is, és ezek az egyébszálak jó eséllyel más erőforrásokat használnak a magon belül, így mehet párhuzamosan a két dolog(SETI + akármi). Ha meg nincs bekapcsolva a HT, akkor ezeket nem tudja párhuzamosítani, csak a tényleg létező magok erejéig, és mivel ezer dolog fut, így rendesen lassítják a SETI-t. Szóval összességében igazad van, tényleg gyorsabb lett, de maradjunk abban, hogy „valamivel”, a többi maszlagot meg hagyjuk rá az intek marketingeseire.

Azért ezt nem két nap alatt fogom megcsináltatni

Azért ezt nem két nap alatt fogom megcsináltatni

Köszi

Köszi