- Samsung Galaxy S25 Ultra - titán keret, acélos teljesítmény

- Így lesz tégla a porszívódból - a Roidmi csődje

- Garmin Fenix 7 és 7S - profi sport megszokásból

- Honor 200 Pro - mobilportré

- Asus Zenfone 8 - komplett kompakt

- Hatalmas kedvezménnyel nyit az Ulefone új csúcsmodellje

- Yettel topik

- Samsung Galaxy S23 és S23+ - ami belül van, az számít igazán

- Huawei Watch GT 5 Pro - egészség + stílus

- Ilyen a Huawei Watch 5 és új érzékelője

Hirdetés

-

Mobilarena

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Petykemano

veterán

válasz

arabus

#64928

üzenetére

arabus

#64928

üzenetére

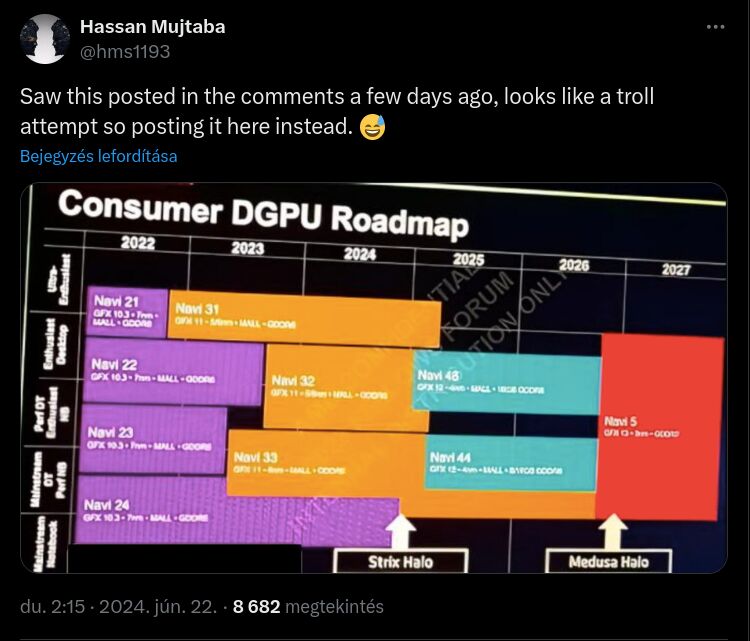

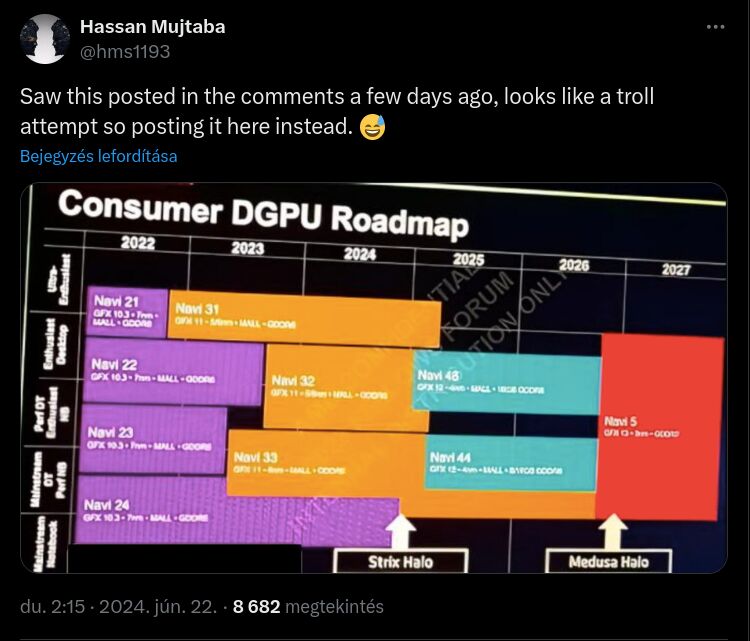

Különös, hogy ezen a roadmapen a Navi33 a product stack szempontjából alacsonyabb szintet tölt be, mint Navi23 - annak ellenére, hogy valamivel gyorsabb. Ami szinkronban van azzal, hogy olcsóbban gyártható és olcsóbb is. De nem ez a különös, hanem hogy a navi 23 nem szerepel, mint a navi33 alatt továbbgyártott termék.

Persze a tervek változhatnak.

Mindenesetre azért segít annak értelmezésében, hogy a Navi48 nem a navi32 teljesítményét fogja hozni, hanem annak a product stackben betöltött helyének megfelelő teljesítményt. Tehát simán lehet, hogy a Navi48 teljesítmény szempontjából a Navi 31 helyébe lép egy - remélhetőleg - olcsóbb áron.

Azért az a 2027-es RDNA5 mindenképpen elkeserítő. De az AI megjelenésével persze érthető, hogy a gaming szektor méginkább háttérbe szorult.

-

S_x96x_S

addikt

válasz

arabus

#64928

üzenetére

arabus

#64928

üzenetére

> Nem lesz,jól nem látszik a képen de annyi azért igen

Az a kép biztosan megbízható?

Rátennéd az életed?

Rátennéd az életed? ![;]](//cdn.rios.hu/dl/s/v1.gif)

Mert gyanúsan nem adtad meg a forrását ..https://x.com/hms1193/status/1804488464567615980

> rdna5-ben lesz valamikor 2027 körül addig pihenjél nyugodtan.

biztos olyan későn és nem hamarabb ?

Ha jól értelmezem, akkor 1 évvel az RDNA4 után várható az RDNA5.

lásd ( wccftech ) "The AMD RDNA 5 GPUs are still years away from launch and it will be around late 2025 or 2026 ... " -

S_x96x_S

addikt

válasz

arabus

#64917

üzenetére

arabus

#64917

üzenetére

> És nem lesz gddr7-sem.

ki tudja ... nagyon gyorsan változik minden ..

Elképzelhető - hogy a RDNA4 - tudja a GDDR7-et is kezelni;

és ha nem is az elején de lehetséges egy GDDR7-es verzió is.

Vagy ha nem az RDNA4 , akkor az RDNA5June 4, 2024 at 6:02 PM EDT

Micron Samples Next-Gen Graphics Memory for Gaming and AI

Ecosystem partners on the Micron GDDR7 memory solution

“At AMD we are committed to creating the most immersive gaming experiences. Our work with Micron on GDDR7 advances our shared goal,” said Joe Macri, senior vice president and corporate fellow at AMD. “We are excited about Micron's launch of GDDR7, and we look forward to leveraging this technology to make gaming even more responsive and lifelike.”

( via Micron Press Release ) -

bitblueduck

senior tag

válasz

arabus

#64769

üzenetére

arabus

#64769

üzenetére

azért, ha a trendeket nézed pl itt akkor azért más a kép, mintha csak egy pontot emelnél ki. lehet hogy notebook fronton stagnálnak de server oldalon kb nulláról indulva folyamatosan stabilan növekednek és nehéz valószínűleg egészséges haszon is van rajta.

de mivel ez gpu topic jobb lenne ilyen látni radeonokkal is

-

Yutani

nagyúr

válasz

arabus

#64769

üzenetére

arabus

#64769

üzenetére

Van versenyképes AMD CPU régóta, de a piac inkább Intelt vásárol. Ezen az sem változtatna, ha szaré-hugyé adná az AMD a procikat, mert ennek a piacnak a nagy részét az OEM-ek adják, ők pedig valamilyen okból Intellel mennek. És nem azért, mert az Intel körbehugyozza az AMD-t teljesítményben.

-

paprobert

őstag

válasz

arabus

#63441

üzenetére

arabus

#63441

üzenetére

For games of today and tomorrow.

Végülis őszinték... becsülendő hogy közvetlenül a marketing anyagba írják, hogy meddig lesz elég a kártya. Holnapig.

Érdekes, hogy a gyártók imádnak az elégtelen shader core count mellé elég VRAM-ot rakni, vagy elég gyors GPU mellé túl keveset. (4060Ti 16GB, RTX 3070)

-

Yany

addikt

válasz

arabus

#62773

üzenetére

arabus

#62773

üzenetére

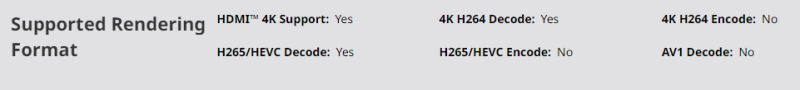

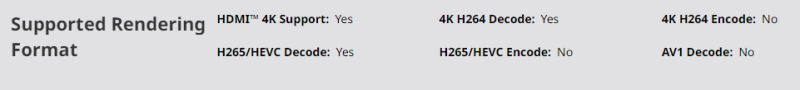

* khm *

6500XT specs

6500XT specsAz AMD csak azokból a termékeiből hagyta ki az AV1-et, amibe épp értelme lett volna. NAS-ba tökéletes transcode feature lenne, de 6500 és lefelé ezt elbaxták. Hogy tiszta legyen: AV1 decode sincs, de az említett gányokból a teljes hw encode hiányzik. Ha valaki ezt nem tudta, annak jusson eszébe, amikor HTPC-be, NAS-ba, vagy bármilyen low-cost gépbe GPU-t tervez. E tekintetben egy sokéves 1650-es is felülmúlja ezeket...

-

Komplikato

veterán

válasz

arabus

#62506

üzenetére

arabus

#62506

üzenetére

Nem. Konkrétan írva vagyon, hogy az új RR funkció menni fog az összes RTX kártyán, a DLSS3 féle extra képkockák maradnak RTX4000 vagy újabb vászon. Tehát az újítás bizony a régieket is menni fog. Persze azért várjuk meg a hivatalos bejelentést meg az első teszteket a CP2077 DLC-vel.

-

válasz

arabus

#62506

üzenetére

arabus

#62506

üzenetére

Miért azon lenne csak ilyen minőség?

Max a sebesség kompromisszumos, 1440P-n 50-60 FPS között tud egy 4070 1440P-n DLSS Quality módban. 3,5 DLSS állítólag gyorsabb a 3.0 hoz képest. Minden kártyán megy, egy 3090 is jó hozzá.

A kártyák árai nem jók az biztos ,de szerintem itt már csoda nem lesz. -

PuMbA

titán

válasz

arabus

#62471

üzenetére

arabus

#62471

üzenetére

"És akkor arra mit mondasz hogy a Vulkan driverben találtak 3x annyi ray tracing teljesitményt?"

Én úgy tudom, hogy ez csak Linuxra vonatkozik, ami mindig is jóval később követte a Windows-os driver fejlesztéseket, hiszen a játékosok 95%-a Windowst használ. Ez a 3x-os ray tracing teljesítmény Windows-on már adott, tehát olyan hírt nem fogunk látni, hogy Windows-on háromszorosára nőtt a ray tracing teljesítmény.

-

PuMbA

titán

válasz

arabus

#62466

üzenetére

arabus

#62466

üzenetére

Ahogy Abu mondja, már nem lehet sok. Az AI teljesen más, mint a DirectX 12, mint ahogy a Linux driverek is más tészta. Ezeknek nincs köze ahhoz, hogy a DirectX 12-ben mennyi maradt, szóval nem jó példák.

Az AMD már nagyon régóta dolgozik a DirectX 12 drivereken, lassan 10 éve a Mantle-t is beleszámolva, szóval egyáltalán nem várható semmi nagy teljesítmény javulás, mert 10 év alatt ha van nagy hiba a kódban, arra már rájöttek volna,

-

Abu85

HÁZIGAZDA

válasz

arabus

#62466

üzenetére

arabus

#62466

üzenetére

Lehet, hogy van még az AMD D3D12 implementációjában is teljesítmény, de sokkal hatékonyabb az erőforrás-kezelésben az NV és az Intel implementációjához viszonyítva. Egyszerűen ugyanaz a bekötési művelet sokkal kevesebb prociidőt igényel. És itt számottevő a különbség. Akkora, hogy félrevezeti még a fejlesztőket is, amikor az Intel-féle hibrid dizájnra optimalizálnak. Pont két hete írta meg az Intel a partnereinek, hogy teszteljék a hibrid magos procikat GeForce-on is, mert attól, hogy nem látják a teljesítményveszteséget a Radeonon a hibrid stratégiából, még nem biztos, hogy nem lesz ott GeForce-on és Arc-on. És ezt úgy tudják ellenőrizni, hogy kikapcsolják a kis magokat. De ha csak Radeonon van tesztelve, akkor az nem elég, mert sokszor ez nem hoz változást Radeon hardveren, míg GeForce-on és Arc-on meglódul a teljesítmény, ha kikapcsolják a kisebb magokat. És ez a driverben lévő implementációs különbség. Az AMD-nél ugyanaz a bekötés sokkal gyorsabb, sokkal kevesebb DWORD-ből áll, tehát bőven elvan a kisebb magokon is, viszont a többi hardveren jó lenne a nagyobb magokra rakni ugyanezt a feladatot, mert látványosan gyorsul.

-

Abu85

HÁZIGAZDA

válasz

arabus

#62450

üzenetére

arabus

#62450

üzenetére

Itt valószínűleg az történt, hogy az AMD-nek egy rakás szabad erőforrása maradt a D3D11 és OpenGL meghajtókat fejleszteni, mert a D3D12, Mantle és Vulkan meghajtók egy közös PAL rétegen fekszenek, tehát egyszerre tudják fejleszteni mind. Ezt például nagyon másképpen csinálja az Intel és az NV. Nekik külön D3D12 és Vulkan implementációjuk van, külön rétegekkel, ami az erőforrás befektetésében kétszeres költség minimum, és az ICD alatti réteg is eltérő a D3D12 és a Vulkan esetében, tehát még az absztrakciós réteg fejlesztési költséges is kétszeres. Emiatt az NV és az Intel nem annyira foglalkozik a D3D11 és OpenGL implementációkkal, mert nincs rá kapacitásuk, míg az AMD-nek van erre kapacitása, mert közös absztrakciós réteget használnak az explicit API-kra, így számukra ezt olcsó fejleszteni, olcsó kihozni belőle a teljesítményt, kevés humánerőforrás befektetését igényli.

Emiatt már nem igazán igaz az, ami régen, hogy a D3D11-ben az NV a kiemelkedően jó, D3D12-ben és Vulkan API-ban pedig az AMD. Ezek régen általános nézetek voltak, de manapság a D3D11-ben igen gyors lett az AMD meghajtója, mert valóban fejlesztik, tehát gyorsítják folyamatosan. Az Intel is ezt csinálja, és az NV is tudná ezt, ha nem a modernebb API-kra raknák az erőforrást. De ez az NV esetében normális, mert nekik a D3D12 meghajtójuk hatékonysága nem olyan jó, mint az AMD-é, sőt az Intel meghajtójának hatékonysága is jobb.

Egyébként hatékonyságban most kb. az van, hogy a D3D11-ben van még kis előnye az NV-nek, de jönnek fel a többiek. D3D12-ben az AMD-nek elég nagy előnye van a többletterhelés oldalán, míg Vulkan API-ban az Intel implementációja tűnik a legjobbnak, de nincs messze tőle az AMD és az NV sem. Tehát látszik azért, hogy a cégek közelítenek egymásra, egyedül a D3D12-ben van még látványosabb különbség.

-

Ribi

nagyúr

válasz

arabus

#62450

üzenetére

arabus

#62450

üzenetére

Erős a gyanum, hogy maga a teszt is "rossz". 3dmark oldalát ha böngészgeted, a többi tesztben a 4090 előrébb van. Viszont pont a fire strike alatt (top100) kb. ugyan ott van. Lehet ez valami engine limit vagy akármi. Plusz az is fura, hogy míg 7900xtx pontjai mint az ökörhugyozás 75-100k között minden is, addig a 4090 viszonylag stabilan 85-90k körül.

Azt hiszem ennek az egésznek nem sok köze van az AMD gpu jövöjéhez, max 3DMarkhoz. Így meg eléggé rossz topik.

-

Ribi

nagyúr

válasz

arabus

#62446

üzenetére

arabus

#62446

üzenetére

DX11 és ahogy a ebben a cikkben is írják, jóval kevesebbet kell számolnia, alatta és bejön a cpu limit. De egyfriss teszt program esetén nem így néz ki. A másik ok amit sok más tesztben is láthatsz, hogy cpu limit határ közelében AMD VGA-k jobbak. Abu is mondta számtalanszor, HUnboxed is emlegette ezt sokszor. De ettől még ebben az esetben nyilván full CPU limit van, mert nem erre vannak tervezve a VGA-k. Se az 7900xtx se a 4090. FS Ultra tesztben már látható mennyi az annyi.

-

Ribi

nagyúr

válasz

arabus

#62442

üzenetére

arabus

#62442

üzenetére

Firestrike már nem mai cucc, és ezek a kártyák már bőven 4k-ra vannak tervezve. Ezen 2 ok miatt érthető is, hogy elfogy a cpu. De pontosan ugyan ez volt amikor 10-15 éve valaki 3dmark 2001-el tesztelte az akkori friss VGAkat "kis felbontáson" és szarabb eredményt kapott mint az előző szériával. Nem a VGA hibája, hogy nem úgy és arra használják amire tervezték. Amúgy pedig nincs az eredeti potenciálhoz képest nem azt hozza amit "kellene". Valami nem oké vele, nem olyan lett amint amilyenre tervezték. Nem az abszolut tudásával van igazán a gond, hanem amit kellett volna tudnia.

-

-

Abu85

HÁZIGAZDA

válasz

arabus

#52970

üzenetére

arabus

#52970

üzenetére

Nincs támogatva ez az 2004-es Windowsban. Eleve a Microsoft augusztusban jelentette be, hogy jön. Csak a DirectX 12 Ultimate van támogatva a 2004-es Windows-ban. Ami megjegyzem, hogy tök ugyanaz, csak egyenként kell lekérdezni, hogy a funkció elérhető-e. Olyan nagyon nem szúrják magukat tökön a fejlesztők attól a 10 sornyi extra kódtól, amitől majd az FL12_2 megszabadíthatja őket jövőre.

A D3D_FEATURE_LEVEL_12_2 a Microsoft ígérete szerint a 21H1-es Windows frissítés része lesz. Jelentősége igazából nincs, mert mindent használhatsz most is, csak pár extra ellenőrzőkód kell hozzá, nagyjából 20 másodpercnyi többletmunka, ami egy több évig tartó projekt tekintetében elhanyagolható.Ha amúgy meg akarod nézni, akkor az Iron kódnevű Insider Preview már támogatja a D3D_FEATURE_LEVEL_12_2-t.

DirectX 12 Ultimate játék egyébként van a piacon, a DiRT 5 és a Godfall is ezt az API-t használja.

-

Abu85

HÁZIGAZDA

válasz

arabus

#52945

üzenetére

arabus

#52945

üzenetére

Mert a GPU-Z egy kurva szar program az információk kiolvasására, ugyanis ezeknek az adatoknak egy jó részét nem kiolvassa, hanem egy belső adatbázisból tölti fel. Tehát akkor lesz feature_level_12_2 a Radeon, ha a GPU-Z fejlesztője hajlandó lesz hozzáadni ezt a beállítást.

De egyébként akkor sem, maximum azt hazudja rá a program, mert nem csak ezzel kompatibilis hardver kell hozzá, hanem a 21H1-re tervezett Windows frissítés is. A mostani Windows verzióban ugyanis még nincs benne a feature_level_12_2. A Microsoft hagyja használni a DirectX 12 Ultimate funkciókat, de csak jövő tavasszal fogják meghozni rá az FL szintet. Tehát egy alkalmazás a mostani Windows 10 alatt nem tudja az OS-ből kiolvasni az FL12_2-t. Nincs benne a leszállított DirectX 12 runtime-ban. Maximum FL12_1-et lehet kiolvasni ma, de ugye a GPU-Z nem olvas, hanem csak irkál random dolgokat a rubrikákba.Az AMD aktuális meghajtója a táblázatos képből támogat mindent, annyi a különbség, hogy a shader model az nem 6.5, hanem 6.6, a tiled resources az nem TIER_3, hanem TIER_4, a sampler feedback az nem TIER_0.9, hanem TIER_1, illetve a virtuális címzés nem 40, hanem 44 bites.

Ha valós képet akarsz kapni a hardverekről, akkor minimum AIDA64-et használj, ne olyan programokat, amik kézzel töltik fel a rubrikákat.

-

Abu85

HÁZIGAZDA

válasz

arabus

#52943

üzenetére

arabus

#52943

üzenetére

Van már a drivernek DirectX 12 Ultimate támogatása. Sőt, több is, mert a sampler feedback esetében nem csak a kötelező TIER_0_9-es szintet támogatja, hanem a TIER_1_0-s is, illetve az RDNA 2 már támogatja a texture tile data-inheritance-t is, ami szintén egy opcionális funkció.

-

Mumee

őstag

válasz

arabus

#50363

üzenetére

arabus

#50363

üzenetére

Alapból MPT fájlként menti, de átnevezve valóban betölti .rom -ként is, tehát lehetséges manipulálni.

Viszont az aki ezt felrakta az egy valid leaker, tehát nem látom okát miért járatná le magát ezzel.

Főleg miután Igor is közel ugyanezeket az infókat hozta már le tegnap.Ha pedig mindketten kamu BIOS-t kaptak volna az feltűnt volna, mivel egy BIOS fájl cirka fél MB, míg az MPT fájl átnevezve alig pár kB.

-

Robi BALBOA

őstag

válasz

arabus

#49384

üzenetére

arabus

#49384

üzenetére

Mondjuk előbb utóbb muszáj lesz váltani Gddr-ről, mert az sem állapot, hogy 8-10(16-20)-24 modul kell egy karihoz, amik igen igen szépen fogyasztanak és nem olcsóak, valamint a gddr mem vezérlő nagyobb helyet foglal a lapkán mint a HBM vezérlő, úgyhogy nem sok érv szól mellette.

-

Raki

aktív tag

válasz

arabus

#49358

üzenetére

arabus

#49358

üzenetére

Én átlag gémer felhasználónak tartom magam, a számomra lényegesnél jobban nem ásom bele magam soha adott technológiába. Ami nekem most szempont, hogy kell egy kártya, ami 1070-nél legalább 2x erősebb, mivel új monitor lett. Engem az fps értékek érdekelnek a releváns címek alatt, a többi nekem érdektelen.

Számomra a "semmi" az azt jelenti, hogy pirosaknak hosszú évek óta nincs top-tier kártyájuk, nekem pedig a középkategória nem elég teljesítményben.

Nem AMD ellenes vagyok, sőt drukkolok is most nekik, de azért egy egészséges szkepticizmus van bennem, főleg utóbbi éveket elnézve vga fronton, ennyi.

Egyébként, ha az 5700XT valóban középkategória és mindig is az volt, akkor anno miért nem jöttek ki a 2080 ti párjával, erre mi a válasz ez érdekelne azért? -

Alogonomus

őstag

válasz

arabus

#49352

üzenetére

arabus

#49352

üzenetére

Reálisak a fogyasztási értékek a bemutatott 2 és 3 ventillátoros 2 slotos kártyákhoz. Ezért is tűnik erősnek, hogy a leak alapján 300 wattos sima 6900 is erősebb lenne a 350 wattos 3080-hoz képest, míg a 340 wattos 6900XT a 400+ wattos 3090-et előzi le, és még ott van bő 60 watt, amit az AMD a jövőben bedobhat a harcba mondjuk 6900XTX kártyaként. És még úgy is csak az eredeti 3090 fogyasztását érik el.

-

Mumee

őstag

válasz

arabus

#48598

üzenetére

arabus

#48598

üzenetére

Igen, elsőt rosszat linkeltem, de a második képen a CU-król arról volt egy másik leak is miszerint :

"#BigNavi CU/SP may work a little different in terms of throughput perf.. like how 2xCUDA on RTX3k doesn't = double performance. [unverified + salt]"Lehet, hogy lesz valamiféle CU trükközés még.

Az eddig leakek alapján, amit ma lehoztak 192bit 40CU az a Navi22 2070S-2080S közé.

-

Yutani

nagyúr

válasz

arabus

#48547

üzenetére

arabus

#48547

üzenetére

Hát cimbora, az élet néha elég értelmetlennek tűnik... Do u speak hungarian, my friend?

Nem érted egyébként, amit írtam. Az, hogy kaptak egy jó adag ostyát, attól még az nem segít a GPU gyártáson, mert a bejegyzés szerint konzolra megy el az a budget, nem GPU-ra. Capisce?

-

TESCO-Zsömle

titán

válasz

arabus

#48549

üzenetére

arabus

#48549

üzenetére

Ezek cikkek a Bloomberg-féle HOAX-ról, amivel 3.5%-al lejjebb verték a SONY részvényeit*, mielőtt bevásároltak belőle, hogy ennyivel is nagyobbat kaszálhassanak, mikor a PS5 berobban...

TSMC-től nyár elején volt hír, hogy akkor jártak 70% fölött. Innen a Pinky Demon által említett 0.09hiba/cm^2. Ebből egy fórumozó TPU-n kiszámolta, hogy a chip-ek méretére leosztva és a redundanciát figyelembevéve a következő kihozatali arányokkal lehet számolni:

XSX ~ 90%

PS5 ~ 95%* - Ezért is van update, mert általában az ilyen HOAX-okra a gyártók nem szoktak reagálni, de a SONY-nak nem volt kellemes a részvények megzuhanása.

-

Cathulhu

addikt

válasz

arabus

#48547

üzenetére

arabus

#48547

üzenetére

elvileg ezzel az AMD havi 43k ostyanal tart. Az 58% yield honnan jon? Tavaly decemberben 0.09-es defektnel jartak 7 nanon, ami egy akkora chipnel is mint az xsx is joval tobbet tud mint 58% hibatlan, nem beszelve arrol, hogy ezekben redundancia is van, szoval a hibasak egy resze is felhasznalhato.

-

KillerKollar

őstag

válasz

arabus

#48498

üzenetére

arabus

#48498

üzenetére

Már most is van jópár...

Control, Battlefield 5, Call of Duty: Modern Warfare, Call of Duty: Black Ops Cold War, Fortnite, Minecraft, Metro Exodus, Shadow of the Tomb Raider, Quake 2 RTX, Wolfeinstein Young Blood, Atomic Heart, Bright Memory: Infinite, Dying Light 2, Vampire: The Masquerade — Bloodlines 2, Watch Dogs: Legion, stb...

Persze ezek közül sok olyan van, ami már egy ideje megjelent és mivel eddig csak az NV támogatta a ray-tracinget így nyilván mi mást támogattak volna, mint az Ő implementációjukat, de sok olyan cím is van itt, ami még nem jelent meg és az big Navi megjelenése után fog kijönni...

Plusz az NV elég nagy cég, ha kell akkor fizetni fognak a kiadóknak/fejlesztőknek, hogy tegyék bele az RTX-et, az a kérdés, hogy AMD kártyákon egyáltalán be lehet-e majd kapcsolni az Nvidia féle RTX-et és ha igen, akkor nagyobb lesz-e a performance hit, mint NV kártyák esetén...

(#48499) Malibutomi

Erre nagyon kíváncsi leszek, főleg mert akkor itt nem csak teljesítményben, hanem minőségben is lesznek majd különbségek... lehet, hogy az AMD kártyák is annyi teljesítményt veszítenek csak ray-tracing mellett mint az NV kártyák, de ha közel sem néz majd ki olyan jól mint az NV megoldása akkor az egy ok lesz az NV mellett, igaz ez nehéz helyzetbe hozhatja Őket marketing szempontból, mert a benchmark slide-okon nem látszik a grafika, csak a számok... -

Devid_81

félisten

válasz

arabus

#47969

üzenetére

arabus

#47969

üzenetére

Jah nem is azert linkeltem ide be, csak osszehasonlitasi alapnak ez volt, nincs alaporajelesem, soha nem ment ugy a kartya miota nalam van

Annyit lehet max leszurni belole, hogy 2x5700XT teljesitmenye kb 10% al erosebb alapon mint egy alaporajeles 2080Ti.

Tehat ha csak ennyit csinaltak belole semmi tobb is mar van a 2080Ti/3070-nek konkurencia.

Es ha igaz az hogy magas orajeleken is jol erzi magat es meg jol skalazodik is csereben akkor nem lenne lehetetlen egy ujabb 10-15% csak orajel novelesbol ezek melle, meg akkor semmi ujitas, IPC novekedes (ha lesz, de valaminek lennie kell) semmit nem raktunk hozza.

En azt mondom, hogy egy magabiztos 2080Ti+35% elkepzelheto a Big Navitol, ezt nem tartom lehetetlennek, sott.

Az meg par % lemaradasra lesz a 3080-tol, csak jo ar kell, megfelelo driverek + 16GB ram. -

Petykemano

veterán

válasz

arabus

#47957

üzenetére

arabus

#47957

üzenetére

Tudni az AMD-től lehet.

Mindenki más:

- ilyen-olyan valós, vagy kitalált partnereknek tulajdonított vagy más belsős fülesekre hivatkozva tesz kijelentéseket.

VAGY

- valamilyen korábbi termék vagy valamilyen rokon-jellegű friss termék (konzol) ismert információira alapozva számol.Értsd jól:

Ezek a narratívák nem "tudások" és "biztos információk". Ha így volna, abu már megírta volna cikkben.

Olyan valamilyen logikára felfűzött, vagy akár logikusnak tűnő számításra építő elképzelések. Ez az, amit magad is ellenőrizhetsz, aztán vagy hihető valami, vagy nem.

Abban meg sosem lehetsz biztos, hogy a belsős infó az igaz, mert

- a neked tálaló személy lehet, hogy kitalálta

- a neked tálaló személynek elmondó személy lehet, hogy kitalálta

- a neked tálaló személynek elmondó személy lehet, hogy félre akarta vezetni azt aki neked tálalja

- a neked tálaló szemnélynek elmondó személy lehetnek elmondó személy lehet, hogy szándékosan félrevezette

stb."a 30-40% hogy jön ki mikor két elsö gen kártya hoz 80%-ot jelenleg."

A tpu táblázata szerint a 2080ti 34%-kal erősebb az 5700XT-nél.

A 3070-et az nvidia tette a 2080ti szintjére [link] -

ati3x

senior tag

válasz

arabus

#47756

üzenetére

arabus

#47756

üzenetére

Eddig én is erre gondoltam. De Linus videója rávilágított, hogy az NV nem igazán az új AMD ellen indult csatába, és nem azért lett ilyen az árazas. Hanem az új konzolok a PS5 és az új xbox ellen. Ugye ezek is 500-600 dollár körül indulnak, és a PS5 esetében 2080 körüli garfikát igértek. Az AMD ráadásuk elég kényszer helyzetben van, mert ugye az új konzolok is AMD grafikát használnak. Tehát nagyon nincs érdekükben, hogy valami übergrafikával/sebességgel száljanak ringbe a PC-s vonalon. Tehát kb egy 2080 teljesítmény 2-300 dolláros áron "kicsit" kockázatos lenne a konzol üzletágra. Erre jött az NV, akinek ugye nem nagyon van érdekeltsége a konzolban, sőőőt inkább a PC gaming felfutásában érdekelt. Erre kihoznak konzolárban egy olyan grafikakártyát, ami már most körbrajzolja a meg se jelent konzolok teljesítményét. (játszható sebesség raytracingel 4k-ban, nem csak valami összetoldozott grafika, hogy legyen meg a 30FPS négykában...) Szóval végül is az NV mégiscsak jól "beintett" az AMD-nek.. Szal lehet, hogy NV lesz a kövi karim az RX580 helyett? Pedig már igencsak gondolkodtam egy 5600 esetleg egy 5700XT-n.. De gondoltam megvárom ezt a bejelentést. (igaz megint csak a "szokásos" 20-30% os teljesítmény növekedést vártam, amit a márketingesek elednak valami hiper szuper forradalmi dolognak. Vagy mint a raytracing, a 20-as szériánál. Új ficsőr, csak be ne kapcsold. ) Szóval most hátradől, és pattint egy sört..

-

Devid_81

félisten

-

tzsolesz

nagyúr

válasz

arabus

#40226

üzenetére

arabus

#40226

üzenetére

Mondtad mindezt ezt egy régi ATI fanboy-nak.

DE:

1. Te csak ne turkálj az én pénztárcámban, semmi közöd ahhoz hogy jelenleg én PC-re mennyit szánok.

2. Úgy tudom nem szóltam hozzád, a komád aztán végképp nem vagyok, és nem is akarok az lenni.

3. "Legalább tudnád milyen jok ezek a kártyák de te csak bégetsz itt." Ki nem állhatom ha valaki személyeskedik.

4."Az meg hogy te kis csoro lajos ként mit hablatyolsz smafu." Azt ugye tudod, ezért akár pihenőre is küldethetnélek?

5. Azt javaslom, hogy ettől a perctől kezdve ne reagálj az én hozzászólásaimra, és ha lehet kerüld az ilyen, és ehhez hasonló megnyilvánulásokat ezen az oldalon. -

#45185024

törölt tag

válasz

arabus

#39383

üzenetére

arabus

#39383

üzenetére

arabus: b. azt akarta ezzel mondani hogy

a 2019-es év az az év amikor AMD 7 Intel 10 NV 12 nmes termékekkel jön és ő egy 14 nm-esről beszél , jó hogy nem kockacukorból rakjuk ki otthon a tranzisztort

Szánja bánja az új AMD kártya leak közben a flamet és reméli nem jelenti be senki ITT

B. nem volt neked egy fogadásod amit elvesztettél véletlen és ezért egy AMDs háttérképet kell kiraknod egy hétre? Hoztam is neked egyet, látod látod itt mekkora a választék ?

-

válasz

arabus

#39383

üzenetére

arabus

#39383

üzenetére

jaja egyértelmű, főleg ebben az alternatív univerzumban.

200 K fölött, de már inkább 180 K fölött nehéz eladni az 1080TI-t, max ha sok garis vagy új, akkor elmegy. Ha 260 K lesz a radeon 7 akkor nem pár ezrest kell rádobni mint ahogy az RTX 2080 ra sem. Személy szerint azt gondolom teljesen felesleges pénzkidobás.

-

válasz

arabus

#29465

üzenetére

arabus

#29465

üzenetére

No igen, ezek a szép álmok. A valóságban:

- Az a kisebb gond, hogy a 2 hónap közelebb van a 3-hoz, ha minden költséget hozzáveszel (kíváncsiságból kiszámoltam, egy 4db 570-ből álló rig ára 80 nap alatt jön vissza jelen difficulty és árfolyam mellett)

- A fő baj viszont az, hogy pl. az ETH / ETC esetén a difficulty átlag 60%-kal nőtt eddig havonta (és most, hogy booming van, ez nyilván jobb nem lesz). Ha ezzel korrigálod a hozamot, akkor a VGA-k ára meg sem térül, mert kicsit több, mint 4 hónap múlva kevesebb coint termel a rig, mint amennyi áramot fogyaszt. Ezalatt a beszerzési költségének a felét hozza vissza.Persze ha jó időben átállítod másfajta coinra, akkor abból kijöhet valami, csak ahhoz szerencse kell (ie. mint ha januárban elkezdesz ETH-t bányászni), szó sincs garantált hozamról. Szóval, ahogy a bitcoin esetén, most is gold rush van, és jól csak az jár, aki korábban szállt fel a vonatra.

(#29470) Yutani: igen, én is ezt néztem. Kezdj el vele számolni.

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- AMD Ryzen 9 / 7 / 5 9***(X) "Zen 5" (AM5)

- Milyen notebookot vegyek?

- Samsung Galaxy S25 Ultra - titán keret, acélos teljesítmény

- Autós topik

- Futás, futópályák

- Villanyszerelés

- Építő/felújító topik

- Nők, nőügyek (18+)

- Sony MILC fényképezőgépcsalád

- HiFi műszaki szemmel - sztereó hangrendszerek

- További aktív témák...

- BESZÁMÍTÁS! AOC 24B1XHS 60Hz FHD IPS 7ms monitor garanciával hibátlan működéssel

- LG Gram 14 WUXGA IPS i7-1360P 5.0Ghz 12mag 32GB DDR5 1TB SSD Intel Iris XE 10óra Akku Win11 Garancia

- iPhone 16 128GB Black -1 ÉV GARANCIA - Kártyafüggetlen, MS3096, 97% Akkumulátor

- Telefon felvásárlás!! Apple Watch SE/Apple Watch SE 2 (2022)

- LG 38WN95C - 38" Ívelt NANO IPS - 3840x1600 - 144hz 1ms - Nvidia G-Sync - AMD FreeSync - ThunderBolt

Állásajánlatok

Cég: FOTC

Város: Budapest

Attól, hogy az Nvidia elkefélte a volument nem feltétlen fogja az AMD is.

Attól, hogy az Nvidia elkefélte a volument nem feltétlen fogja az AMD is.

Rátennéd az életed?

Rátennéd az életed? ![;]](http://cdn.rios.hu/dl/s/v1.gif)

(Meg nem nevezett, közkedvelt jutuber)

(Meg nem nevezett, közkedvelt jutuber)