-

Mobilarena

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Kajoszbobber

lelkes újonc

Konkretan az Azor azt nyilatkozta hogy nem 300, de nem is 1000 dollar lesz az ara, na most ez eleg tag intervallum

''Amikor bejelentjük az RDNA4-et, lesz egy erős kártya - de nem kerül 300 vagy 1000'' magyar forditasban. Boven benne van a 700-750 dollar a pakliban, es nezve egyes gyartok modelleit lesz is annyi, sot 850 is.

Nem gondolnam hogy ilyen felepitesu vga-kat mint ez : 500-550 dollaerert adnanak, mikor ranezesre csak a hutes 150 dollar. Nyilvan ez egy gyartoi csucsmodell, ettol lehet majd olcsobb is.

500-550 dollaerert adnanak, mikor ranezesre csak a hutes 150 dollar. Nyilvan ez egy gyartoi csucsmodell, ettol lehet majd olcsobb is. -

Busterftw

nagyúr

Ezert mondtam, hogy nem egyszeri/random anomaliakra kell alapozni, hanem azokra a globalis eladasokra, trendekre es aranyokra, amit a Steam generaciok ota lekovet.

Tudjuk minden generacioban es evben, hogy mennyit szallit le az AMD.

Egyszeruen ha Abu fejre all a kituno gimis statisztikajaval, akkor sem fognak nagyban elterni az aranyok. -

huskydog17

addikt

"Ezt most úgy kellen venni, hogy mikivel járnak az utcán és kérdezik a közembert, hogy "Ön fél a B580-tól kedves Marika Néni"?"

Nem. Ezt eladási számok tudják kimutatni, de ehhez még túl korán van, az AMD és Intel tudja kizárólag, hogy egy adott negyedévben melyik SKU-ból mennyit adtak el. Ha ezt az adatot a jövőben publikálnák, akkor lehetne biztosat mondani, de ennek hiányában csak találgatás.

Mivel ilyen információkat nem szoktak soha publikálni a GPU gyártók, így az egyetlen dolog, amire hivatkozhatunk a Steam hardware survey marad. Jelen pillanatban az RX 7600-at a Steam még csak nem is listázza, annak ellenére hogy lassan 2 éve a piacon van. Ha 2 éven belül a B580-at listázni fogja a Steam, akkor az egyértelműen azt fogja mutatni, hogy az emberek nem csak nem féltek a B80-tól hanem többen vettek olyat, mint RX 7600-at. Ezt azonban ahogy írtam még nagyon sok idő, mire ez kiderül, jelenleg azonban semmi értelme, sőt értelmetlen olyannal dobálózni, hogy az emberek félnek a B580-tól, főleg az igencsak pozitív review-k után. Majd az idő megmondja, hogy mennyire féltek tőle, én erősen kétlem. -

S_x96x_S

addikt

(valószínüleg/találgatok)

1.) Talán 5hét elég lesz, hogy az AMD driver fejlesztők is megcsinálják

az RDNA4-es "Fake frame" módot ;

hogy teljesen pariban legyen az nVidiával.2) Az AMD -nek olyan tesztek kellenek a marketing anyagaiba,

amikor az RTX 5070 vs. RX 9070 -et hasonlítják össze.

(beleértve a Fake Frame-es módot)Én nem hagynám ki az AMD részéről azt a zizzert:

hogy:

- Jensen/nVidia szerint: RTX 5070 ~ 4090 Performance

- és mellé tenni, hogy a független tesztelők 99% szerint

RDNA4 RX 9070 > nVidiaRTX 5070 ( mind teljesítményben és mind ár-érték arányban)

Amitől sok potenciális nVidia vásárló összezavarodna.3.) Az AMD a middle piacot célozta

és ez az eladások 85-90% -a!

jelenleg nincs annyi RDNA4 kártya legyártva, hogy ne legyen hiány.

( az nVidia RTX 5080, 5090 - csak a forgalom pici részét teszi ki ; ide nem kell annyi kártya; de az AMD-nek most nincs ilyen flagshipje. ) -

Quadgame94

őstag

5070-et az év gyökerei vesznek majd csak (a feltételezett RX 9070 áraik mellett). Még a két generációval idősebb 3070-től is alig lesz 40-45 százalékkal gyorsabb. De azok a tulajok egyrésze már váltott bőven 4070/Ti-ra mert ugye a 3070-et drágán vették, aztán eladhatták viszonylag kevés veszteséggel. Barátom pont ezt csinálta. Nagyon drágán vette a 3070-ét, majd eladta 200 körül és vett egy 4070 Ti-t.

-

Alogonomus

őstag

Azért ha a február eleji tesztek alapján kijön egy akár 40% ár/érték előny a 9070-ek javára az 5070-ek ellenében, akkor valószínűleg sokan kivárják majd a márciust.

Az 5070 Ti 4070 Ti-hoz képest +20%-a 750 dollárért még a 4080 szintjét sem éri el, míg a 9070 XT állítólag ott lesz a 4080 szintjén és 500 dollár körüli árat jósolnak hozzá.

Az 5070 4070-hez képest +20%-a 550 dollárért pedig elmarad a 4070 Ti szintjétől, míg a 9070 állítólag ott lesz a 4070 Ti/7900 XT szintjén és 400 dollár körüli árat jósolnak hozzá.

Az egyedüli komoly kérdés az, hogy a friss helyzetet látva az AMD felemeli-e az új kártyái árát, vagy továbbra is az "eredeti" árakon küldi azokat a versenybe, amivel hatalmas ár/érték előnyt tudna felmutatni. -

Abu85

HÁZIGAZDA

Ez azért annyira nem kritikus dolog. Amikor teszten van egy új VGA, akkor szinte naponta jönnek hozzá új driverek. De dokumentálva van, hogy mi változik. Tehát ha mondjuk csak egy játék, akkor tök felesleges újratesztelni mind. De ha mondjuk az az egy játék szerepel a tesztben, akkor azzal érdemes. Tehát itt nincs olyan, hogy újra kell tesztelni ezeket, mert a cégek dokumentálják, hogy miben lesz változás.

-

Busterftw

nagyúr

Az hagyján , de borderline user megtévesztés, másik topikból a hsz-em:

Mobil 300 szeria ami Zen5, 200 szeria ami Zen 4, aztan utobbinal ugyanugy van "9", ami ugye a csúcsot kellene hogy jelentse.

Max Plus/ Prorol ne is beszeljunk.

Azan handheld, a Z2 Extreme az Zen5 es RDNA 3.5, raadasul a magok sem egyformak (Zen5 es Zen 5c)

A Z2 (Z1 Extreme rebrand) Zen4 magokkal jon es RDNA 3-al.

A Z2 Go valoszinuleg Zen3 es RDNA2. -

S_x96x_S

addikt

> PCI-E-re elég sok mindent lehet kötni amivel lehetne tesztelni.

csak akkor tudjuk kimérni,

hogyha konkrétan az lesz a szűk keresztmetszet> De ahogy nézem SSD-k latencyje sem lett kevesebb.

Még mindig az Optane SSD a király, de nem sokáig.

A 3200 MT/s kategóriájú flash SSD -k talán jövőre jönnek ;

az kb 33% -al gyorsabb lesz a jelenleginél. -

S_x96x_S

addikt

> Erre a latency csökkenésre van bármi teszt vagy hogy legalább mennyivel kisebb?

Egyenlőre csak

a kínai "Moore Threads MTT S80" -nek van 16GB Gen5 x16 -ja - ( ~ $164 )

de azon kívül, hogy a világ legelső - extrém olcsó Gen5-ös GPU-ja,

mást következtetést nem nagyon tudunk levonni,

mivel tele van problémákkal.Majd jövőre lesznek tesztek az RTX 50 -el a megjelenés után

és az majd vagy megerősíti vagy cáfolja a spekulációmat.

( Szoktam tévedni )

) -

S_x96x_S

addikt

szerintem nagyrészt ugyanarról beszélünk.

A sakkprogramozás jól párhuzamosítható, mert az algoritmus lehetővé teszi a lépések kombinációinak egymástól független kezelését.

hogy valami párhuzamosítható-e, nagy mértékben az algoritmustól függ.

Az algoritmus struktúrája és logikája határozza meg, hogy a feladat mennyire osztható szét párhuzamosan végrehajtható részekre. Ha az algoritmus úgy van kialakítva, hogy a feladat független részekre bontható, akkor jól párhuzamosítható.> Nem az algoritmustól függ,

a klaszikus sakkprogramok jellemzően a "minimax algorithmust" vagy annak bővítését használják, és a nevében is benne van, hogy "algoritmus".

https://www.chessprogramming.org/Alpha-Beta

The Alpha-Beta algorithm :

-

S_x96x_S

addikt

hát igen ..

A részvényeknek meg van az az előnye,

hogy ott tétje is van a véleményeknek ..

ellenben más elemzői véleményekkel szemben.

( az itteni névtelen és arctalan fórumozásról már nem is beszélve)

de ha már mindenki nVidia részvényekről beszél, akkor

az erős jelzés, hogy valamikor jön majd egy korrigálás is .> Intel és Nokia sem 1 év alatt került oda ahova.

Jensen még első generációs alapító és vezető,

és benne még megvan a józan paranoia,

úgyhogy tényleg kicsi az esély a hasonló sorsra ..

de sose lehet kizárni ..Az AMD oldalon

a lehetséges adu a chipletes dolog

és a gyenge pont a szoftveres rész.

És innentől ez már technológia menedzsment és nem tisztán közgazdaságtan.szerintem 5-8 éves távlatban az AMD -nek van reális esélye megcélozni a 20-30%-os AI piaci részesedést.

Persze az AI/ML GPU piac specializálódni fog, a HPC külön válik

és az inference -ből kiszorulnak a hagyományos GPU-k.> nem tudja megszámolni mennyi pénzük van.

amúgy ez azért valós probléma ..

ha szinte minden veterán nvidiás milliomos lett,

( dolgozói részvényprogram )

akkor mivel lehet őket motiválni ?> Itt meg 1 év múlva már azt vizionalizálják páran,

> hogy hirtelen megfordul a világ.Az AI miatt a világ már eleve lassú fordulásban van ..

( amolyan inflexiós görbén )

és sajnos túl gyorsan és túl sok minden változik ..Amúgy az Nvidia/TSMC/AMD esetén

a kockázat egy kínai-taiwani katonai konfliktus.-------------

A kérdés még mindig nyitott:

Mennyire lesz versenyképes az 5nm Blackwell,

az RDNA5/Mi400X ellen, hogyha az AMD már 3nm-res lesz. -

S_x96x_S

addikt

"Az nVidiát kritizálni nem kell félnetek, jó lesz, ha mindenki egyetért, én nem ellenzem."

![;]](//cdn.rios.hu/dl/s/v1.gif)

> hogy nvidia stocks

az a befektetők várakozásait jellemzi

és nem az nVidia tényleges jövőbeli teljesítményét,

és egy bővülő piacban még az is belefér,

hogyha 10-15-30% -os piaci részesedést elbuknak, mert akkor is egy valag pénzt termel.> Nvidia legrosszabb forgatókönyve perpillanat az,

> hogy nem tudja megszámolni mennyi pénzük van.

> De biztos ott rettegnek a sarokbanhasonlóan mint a csúcson az Intelnél és a Nokiánál is.

vagyis az, hogy most extrém jó a cashflow és rózsaszínű a jövő

nem sokat jelent a jövőre.> Van még kérdés?

csak ugyanaz, amire nem válaszoltál ..

Mennyire lesz versenyképes az 5nm Blackwell,

az RDNA5/Mi400X ellen, hogyha az már 3nm-res lesz. -

Abu85

HÁZIGAZDA

Ez mindig így volt. Nem fogják a specifikus gondjaidat egy csomó pénzből megoldani. Igazodj hozzájuk. Vagy ha nem, akkor használj nyílt forráskódú alternatívát, és azt igazíthatod, ahogy akarod. De mondjuk az efféle felskálázók és generálók nem annyira kényesek. Bár persze lehetnek olyan esetek, ahol valami nem stimmel velük egy adott motorban.

Az NV egyáltalán nem tesztel játékokat a dll-hez, nincs szükség erre.

Le van írva, hogy miképpen működik az eljárás, és arra kell szabni a motort. Az NV és az AMD sem fogja átszabni, ha az nem jó.

-

Abu85

HÁZIGAZDA

A DLSS-t nem tudod a motorhoz igazítani, mert nem nyílt forráskódú. De alapvetően maga az eljárás a jellege miatt csak ritkán okozhat gondot.

#63833 Albus_D : A DLSS-nek is lehetnek hibái, de ezeket az NV javítani szokta. Itt viszont nehezebb az ügy, mert az UE5-nél van egy olyan tényező, ami miatt gondokba futnak ezek az eljárások. Most ez már a harmadik játék, aminél előjön valami. Más motorral nem. Szóval itt van valami probléma a motornál is. Azt mondom, hogy egyszer jön valami baj, akkor oké, kétszer még lehet véletlen, de háromszor...

-

Abu85

HÁZIGAZDA

Nem minden gond függ a motortól, de az UE5 esetében ez már a harmadik játék, ahol gond van valamelyik felskálázóval. Két korábbinál a DLSS3-mal, míg most az FSR3-mal. Ez már trend. És fura, hogy más motornál nincs ilyen gond egyikkel sem.

#63815 Albus_D : Mert az Immortals of Aveum esetében annyi történt, hogy próbálták a javításokat sokáig, majd inkább implementálták az FSR3-at. De ettől még ez csak az egyik UE5 játék, ahol voltak gondok.

#63818 b. : Kétlem, hogy az eljárásokkal lenne probléma. Írtam, hogy már a harmadik UE5 játék jön, ahol valami gond van vagy a DLSS3-mal vagy az FSR3-mal. Ez trend. Itt valami a motornál nem stimmel. Más motorral nincsenek gondok.

#63822 b. : Ha az NVIDIA hibája lenne a DLSS3-mal kapcsolatos hiba, akkor ki tudták volna javítani, és nem kellett volna az FSR3-hoz hozzányúlni. Valószínűbb, hogy itt az UE5-tel van valami, amire még nem derült fény.

-

Alogonomus

őstag

Hát a 128 bites 4060 és a 192 bites 3060 összehasonlítása maximum annyiból érdekes, hogy a papíron 20%-kal nagyobb számítási teljesítménnyel rendelkező 4060 FHD esetén még élesben is tud realizálni 15% előnyt, de QHD esetén már a nagyobb L2 - és fejlesztett architektúra - ellenére is 9%-ra olvad az előnye, ami valószínűleg a 2/3 szélességű memóriabusz következménye.

-

-

arabus

addikt

Ez nem 2001 hanem a mostani teszt és annyi hogy a directx réggebbi verziója jobb teljesitménnyel fut rajta mint az nv-n magyarul nyers erőben az xtx jobb.

Ezen a kódon már nagyon nem fejlesztenek a driverben a gyártók hiszen már megtette mindkét oldal.Úgymond kihozták a maximumot ami meg is látszik.

Ha lesz rá normális directx 12.2 driver majd akkor is ugyenezt fogod irni? -

S_x96x_S

addikt

>> "egyre nagyobb lesz az igény a garázsban futtatott AI rendszerek iránt.

>> pl. A Hacker News -on napi átlagosan 3-4 kapcsolatos hír van ezzel kapcsolatban."

> miértjére nem kapok választ. Nem érdekel Nokia, nem érdekel

> hogy egy cég miért erőltet rá másra. Mit csinál vele valaki otthon a garázsban?A "garázs" az amerikai startup kultúrában különleges jelentőséggel bír, mivel sok sikeres tech cég, például az Apple, garázsban kezdte tevékenységét. Ez a fogalom szimbolizálja a szerény kezdetekből, önálló erőfeszítésekkel induló innovatív ötleteket. Az "egyre nagyobb lesz az igény a garázsban futtatott AI rendszerek iránt" kijelentés azzal a gondolattal áll összefüggésben, hogy az AI technológia elérhetővé és alkalmazhatóvá válik kisebb, kezdeti fázisú vállalkozások és hobbi fejlesztők számára is, nem csak a nagy tech óriásoknak.

A "Hacker News" ( https://news.ycombinator.com/ ) egy Y Combinator által üzemeltetett weboldal, ahol a technológiai és startup közösség megoszthatja és megvitatja az iparág legfrissebb híreit, projekteit és ötleteit.

Vagyis itt gondolj egy hobbi fejlesztőre aki beruház a jövőjébe.pl. a tinygrad gépe is 15.000 USD ( 5-6 Milló Ft ) -ért rendelhető ..

vs. egy profi AI suttogó akár évi $335 000 USD-t is meg tud keresni - alkalmazottként

( és ez már 120 Milla felett van / év ; ~ havi 10 millió )

“It’s probably the fastest-moving IT market I’ve worked in for 25 years,” says Mark Standen, who runs the staffing business for artificial intelligence, machine learning and automation at Hays in the UK and Ireland. “Salaries start at £40,000, but we’ve got candidates on our database looking for £200,000 to £300,000 a year. Expert prompt engineers can name their price.”és még lehet folytatni ...

-

hokuszpk

nagyúr

"Én meg azt kérdezem, hogy Eccségjózsi micsinálna vele"

valami olyat, ami neked még nemjutott eszedbe. de legyen többesszám : nekunk még nemjutott eszünkbe.

viszont az ezzel kapcsolatos ötleteimet majd megosztom akkor, amikor befutott valamelyik es eppen milliardokert adom el a cegem

-

S_x96x_S

addikt

> Pont itt van a probléma. Valamiféle megoldás próbálnak eladni emberek

> kb nem létező problémára, amivel otthon semmit sem tudsz kezdeni.És ezen miért csodálkozol?

eddig minden trendet túltoltunk és buborék lett belőle ..

https://en.wikipedia.org/wiki/Dot-com_bubbleVagy ott van a minden "okos" IS

trend

trend

.. okoshütő ; okostermosztát ; okoskanál ..

És ez már marketing is ..

mindenki csinálja - emiatt kénytelen mindenki más is ..A jelenlegi mobiltelefonos trendet is ki látta 25 évvel korábban? Nem sokan.

És aki benne volt - még az is benézhette - pl. Nokia .

Úgyhogy ha nem látod benne a trendet - az teljesen normális.

És a profikkal is megesik (Nokia vakság)

https://en.wikipedia.org/wiki/Technology_lifecycle> kb nem létező problémára, amivel otthon semmit sem tudsz kezdeni.

annó a 8 bites personal computerekre is ezt mondták - hogy csak játékra jó ..

viszont felnőtt rajta egy generáció programozó és fejlesztő ..

Az AI -is egy lehetőség

és most még csak a TSMC/Nvidia keres rajta egy valag pénzt, mindenki más csak befektet.Amúgy ha nem látsz egyáltalán lehetőséget, akkor ne bolygasd ..

amúgy se kell mindent tudni ..

Mert ha összekapcsold a robottechnológiát + biotechnológiát az AI-val ;

akkor nagyon furcsa jövő vár ránk.

https://bostondynamics.com/atlas/

https://neuralink.com/ -

S_x96x_S

addikt

> . Eccségjózsi mégis mit is csinál ezzel a garázsban?

most még semmit ..

"Eccségjózsi"-k mindig a technológiai életgörbe csúcsán szállnak be,

most még az életciklus elején vagyunk.

Majd ha lesznek customizált,

leegyszerűsített konzerv megoldások, akkor "Eccségjózsi" is érdeklődni fog.És ha valaki be lenne pánikolva, hogy még jobban felmennek a gaming GPU árak

akkor ne legyen, a TomsHw - cikk

bár felveti a lehetőségét, reménykedik

"Hopefully we can avoid a repeat of the cryptomining-GPU situation"

Persze az NvIdiában mindig bízhatunk, hogyha a Gaming GPU-ból pénzt lehetne csinálni, akkor gondoskodik róla, hogy a következő generációban erre már ne legyen esély![;]](//cdn.rios.hu/dl/s/v1.gif)

mert kiheréli a lehetőséget.Remélhetőleg AMD MGPU ROCm támogatás a konzumer GPU-kban hibamentesen működni fog ( a jövőben is) ;

mert ha az AMD kiszedi, akkor a TinyGrad terve nem fog működni .

"Multi GPU training:

Trees, rings, and collnets oh my! AMD gets us P2P for free. "

" -

Busterftw

nagyúr

Illetve en azt realisabbnak tartom, hogy amiatt nem lesz xx90 SKU, mert nem fog az AMD ellen kelleni, eleg lesz a xx80, mintsem azert, mert a technologia korlatozza oket.

Mar csak azert sem, mert ez a gen megmutatta, ugy csusztatjak a szamokat ahogy akarjak.

Sajat velemeny, de nekem a regi xx80 es xx80ti felso hatar jobban tetsztett.

-

S_x96x_S

addikt

> Ezek a találgatások olyan légbőlkapott hülyeségek,

légbőlkapott == felhő == cloud

de amúgy az LK-99 mindent megváltoztat.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Room Temperature Superconductor LK-99 May Change Chip Industry -

Alogonomus

őstag

A Techspot/HUB tesztjében.

Nagy különbség nincs a két kártya között, de a Plague Tale esetén lényegében nem változik a két kártya erőviszonya a 1080p->1440p váltással, a Last of Us esetén a TPU tesztjében és a HUB tesztjében is 14-15%-al kevesebbet csökken a 7600 teljesítménye a felbontás növelésétől, a Hogwarts Legacy esetén csak a HUB eredményei vannak meg, de ott is 8-9%-kal jobban jön ki a 7600 a több adatot mozgató magasabb felbontásból.

Az nyilvánvaló, hogy a játékokban nem ugyanott mért a két tesztoldal embere, mert mindegyik játék esetén határozottan más értékeket mértek, de mindkét tesztoldal által ugyanott lemért eredmények a két kártyára nézve hasonló tendenciát mutattak. -

Alogonomus

őstag

Az Intel még bőven nem tart ott, hogy ilyen infinity cache típusú finomhangolásokkal foglalkozzon.

Az Nvidia pedig pont arra próbálta terelni a hangsúlyt leginkább a 4060-ak kapcsán, hogy a 16-szorosra felbővített L2 cache 32 MB-ja majd kompenzálja a 128 bites memóriabusz szűkösségét. A tesztek alapján viszont ez nem nyert megerősítést, mert az idei év memóriakapacitás-paráját megalapozó játékokban, mint a Plague Tale: Requiem, Hogwarts Legacy, Last of Us esetén átlagosan rosszabbul teljesített, mint a szintén 128 bites és 8 GB-os hasonló nyers számítási teljesítményű 7600. Szóval az Nvidia nagyon is dolgozik az infinity cache mintájára egy saját cache technológia kifejlesztésén, de eddig még elmaradnak az AMD megoldásának a hatékonyságától. -

PuMbA

titán

Lehet, de meg is említi ugye, hogy az eddigi sok száz mérésében sosem mért még ilyet

Az is érdekes, hogy csak a SAM bekapcsolása hozza ezt a hatalmas kiugrást. Na meg a patch sem mindegy. A tesztek többsége a kiadáskori verzióval történt, amin már hatalmasat változtattak és ugye sok helyen Intel-lel tesztelnek, ahol megint máshogy működik a SAM.

Az is érdekes, hogy csak a SAM bekapcsolása hozza ezt a hatalmas kiugrást. Na meg a patch sem mindegy. A tesztek többsége a kiadáskori verzióval történt, amin már hatalmasat változtattak és ugye sok helyen Intel-lel tesztelnek, ahol megint máshogy működik a SAM. -

Alogonomus

őstag

A fogyasztási értékek elvileg mind a két esetben a teljes kártya fogyasztását jelentik, azzal nincs gond.

A gond ott van, hogy Igor 6950 XT tesztjében egyértelműen beazonosítható, hogy FHD, QHD és UHD mellett mennyit fogyasztott nála a kártya, míg a 4070-es tesztben jobbik esetben is csak összemosta az értékeket egy átlagszámba. Ráadásul a TPU maximumértékénél is gyanúsan magasabb értéket mért már FHD felbontáson is a 6950 XT esetén, míg a 4070 esetén "sikerült" a TPU maximumértékét hoznia a kártyával. -

Abu85

HÁZIGAZDA

Nem pont a textúrázás határozza meg a VRAM terhelését, hanem maga az alkalmazott leképező. Vannak kifejezetten memóriakímélő leképező algoritmusok, majdnem minden forward renderer, de ezeknek megvan a maguk baja, például a számítási kapacitás szempontjából a megnövekedett igény. Ezért alternatíva a deferred renderer opció a különböző lehetőségekkel, mert az kevésbé eszi a TFLOPS-ot, de több memóriát zabál. Játékfüggő, hogy melyik fejlesztő számára mi a fontos, és ebből a szempontból nagyon egyedi döntések születnek. Leginkább az határozza meg ezt, hogy a fejlesztő hogyan érzi az adott címre a vállalható limitet, a memóriát jobb-e lezabálni, vagy a számítási kapacitást.

-

Raggie

őstag

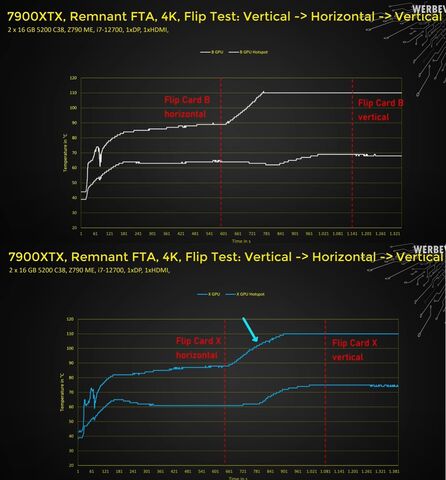

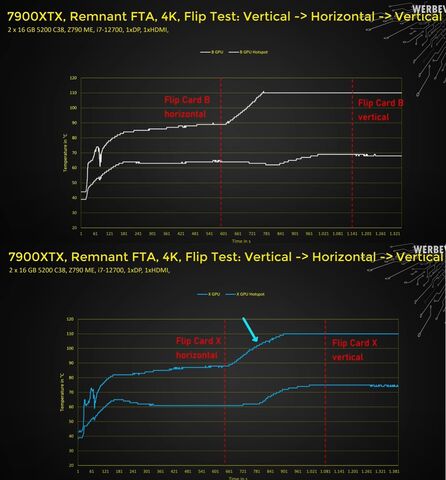

Itt van két különböző kártyának a grafikonja. Mindkettőn látható a GPU diódának is a hőmérséklet emelkedése is, csak az nem egyből kezdődik el és a fehér grafikonon jóval kisebb mértékű(de ott van).

Saját teória:

Szerintem nem kell egyből mennie mindennek fel akkor sem, ha a vapor chamber "átesik". Ekkor nem válik hőszigetelővé a vapor chamber, csak jóval kevésbé lesz jó hővezető. Tehát valamennyire még ekkor is vezeti a hőt.

A hotspot a legmelegebb pontot nézi, azaz azt a pontját a chipnek ami a legtöbb hőt termeli épp. Itt lesz leghamarabb és legjobban érezhető a hőelvezetés csökkenése.

A normál GPU dióda ebben a terhelésben jóval kevésbé melegedő részt mér direktben. Tehát az tovább "elviseli" a kisebb hőelvezetést is, mert még azzal is valamennyire elvan, és csak amikor már a környezetében minden felmelegedett és tényleg elégtelenné válik a hővezetés akkor kezd el melegedni. -

Petykemano

veterán

Előrebocsátom, nem tudom a részleteket, de az általad említett különbség úgy hangzik, mintha a kártya 4K-ban GPU limites volt, és 1440p-ben eltérő CPU használata miatt mutatkozott különbség. De ez a feltételezés csak akkor állná meg a helyét, ha tudnánk, hogy tényleg eltért a CPU.

-

Ez korábban ki lett már tárgyalva, két külön utat követnek:

- nV: magasabb single idle, alacsonyabb multi monitor idle

- AMD: alacsonyabb single idle, magasabb multi monitor idleEbből fakadóan az általad linkelt 33W multi monitor idle a 6700XT esetén egyáltalán nem problémás, a mostani 100W, az teljesen más kategória, ezért jutott sok tesztelő arra, hogy ez valszeg driver szintjén orvosolható kéne, hogy legyen.

Nekem btw az elmúlt 10 évben nagyobb driveres gubancom nem volt AMD oldalon (ettől még természetesen nem voltak teljesen porblémamentesek, ami ugyan úgy igaz nV esetén is) és általánosan el lehet mondnai, hogy kb mindkét gyártó hasonló arányban baszarint el driveres dolgokat, így én egyáltalán nem értek egyet az alábbi kitételeddel

Drivert egyszerűen képtelenek írni

-

Szelektálni kell, de ez minden oldalra igaz. Ettől még a hír konkrétan a [news.bitcoin.com] oldalról indult el (a link benne van a cikkben). Átvette kismillió másik oldal, szóval ha csak amiatt nem vagy hajlandó megnézni, mert éppen a WCCFTech oldalról linkeltem be, az már a Te bajod...

-

Busterftw

nagyúr

Ez meg a masik. Nem ugyanaz a ketto.

Plusz kb 2 ev mulva a kovetkezo gen kozepkategoriaba kuldi a jovotallo kartyat.

2-3 evre boven eleg a 10GB, amikor a jatekosok tobbsege 1080p-ben jatszik, meg csak most jon fel a 1440p, a 4k meg 1%.Eltunik a dx11, de mikor tunik el? Mar 4 eve jon a dx12...

Tul van ez reagalva. Kb senki nem vesz 6-8 evre kartyat. Elobb fog keves lenni eroben a Big Navi, mint a 16GB vram. -

#09256960

törölt tag

Ezzel azért én vitatkoznék hogy trend.

Vannak fejlesztési irányok.

Magát kártyát akkor szabad venni ha vannak összehasonlító tesztek. Pro Kontra látod a kártya előnyeit hátrányait.

és Te kiválasztod magadnak mi a fontos belőle.

Csakhogy ahhoz érteni kell a jövőt, az új fejlesztéseket,

pl hogy a DirectX11 januártól megszűnik így aki tudja már nem ad neki jelentőséget.

Abban igazad van hogy néha vannak tévút fejlesztések, mivel a VR nem jött be már most próbálják újraéleszteni szerintem kevés sikerrel, ezért aki amiatt vett annó erős kártyát az bukta nem mennek az AAA játékok rá max most ez a star wars szimuláció.

Azt is mondták ez a dual GPU majd jobb lesz hozzá mert szemenként 1 GPU jobb eredményeket produkál , aztán az is elhalt.

Eddig True ! De ha megnézel konzolokkal foglalkozó elemzéseket akkor mind azt mondja hogy most fog a legnagyobbat robbanni a grafika. Az RT az RT szép de a SSD meg az Unreal 5 demo az teljesen más tészta! A durván megnövekedett betöltési sebességek meg a szinematik assetek mindent megváltoztatnak.

Magát a játékfejlesztést. Az hogy kimész az erdő szkennelgetni hazamész betöltöd a programba és nem kell időigényesen downgradelgetni arra a szintre amit a gép képes egy teljesen alapjaiban más játékfejlesztés jön, Brutális töltési sebességek hatalmas memóriák és sávszéleségek kora (vagy aki akarja cacheval megoldani azzal)

Ez nem vagylagos. Amint kijönnek a konzolt kihasználó játékok EZ LESZ mindegy Te mit gondolsz ! vagy viszi a géped vagy nem.

Ha csak a mába gondolkozol akkor elég a 12 GB. -

Petykemano

veterán

Az a beetetés is köcsög húzás volt a potenciális vásárlókkal szemben.

De a piaci helyzet alapján nem volt semmilyen kényszerítő ereje a konkurenciára nézve.Magunk közt szólva én hangosan méltatlankodtam, amikor a Navi10 árazása beállt az Nvidia perf/$ vonalára és most is hangosan méltatlankodtam, amikor a zen3 árakon emelt az AMD úgy, hogy pont az alsóbb szegmens kapta a legnagyobb drágítást

-

.Ishi.

aktív tag

Eh, én ezt úgy látom, hogy vannak a fanatikusok, vannak a tech kedvelők (akik valóban elolvassák a teszteket, akik igyekeznek informált döntést hozni), és csak ezután jön a nagy többség, akik szerint az a jobb videókártya, amin több memória van...szerintem mindannyian láttuk már, hogy néha mik mennek a kiskerekben, és ez kőkeményen ki van használva.

-

Devid_81

félisten

Jo hat ezt lehetne folytatni akar a Ryzen 3300X-el, konkretan alig beszerezheto meg mindig.

Vega, de Polaris is mission impossible volt eleinte.

NVidiatol nem ezt "szoktak meg" a userek, pedig Turing se volt startnal.

Talan itt most az a baj, hogy a konyhas video nagyon jol sikerult, es azzal krealltak egy nagy urt, sokan ereztek, hogy ez az a kartya amire nagyon vartak, de kozben nincs.

Es ahogy haladunk elore az idovel ugy egyre tobb fura leak jon, + kozben Jensen is mondta, hogy iden majdnem felejtos a 3080/3090.

Fura az egesz nah

-

HSM

félisten

Persze, világos.

Írják is a végén: " If the finding here is accurate, then the 4GB RX 5500 XT will consequently become very difficult to recommend as the majority of the people shopping with this budget will likely not opt for expensive PCIe 4.0-capable X570 motherboard offerings.".

Írják is a végén: " If the finding here is accurate, then the 4GB RX 5500 XT will consequently become very difficult to recommend as the majority of the people shopping with this budget will likely not opt for expensive PCIe 4.0-capable X570 motherboard offerings.".

Az is szépen látszik, a 8GB-os szépen elvan 3.0-n is, míg a 4GB-os mindkét illesztőn szenved, csak a 4.0-n kicsit kevésbé látványosan. [link]

[link] -

Mumee

őstag

Sima 5700-ból nem kell custom, mert alapból is kellőképp hűvös csak a ventiket kell átállítani, hogy halk legyen. XT az aminél a referencia kevés.

Ez már ígyis OC-zott referencia 2100rpm-ről 1300rpm-en, ami logikusan túlzás csak anno az alját kerestem, ami még 100fok alatt marad, de 1300rpm-en halkabb, mint bármelyik custom.

1800rpm körül van a normál custom-ok zaja, amin a kártya gyári beállítások mellett a 80 fokot is alig éri el junction.

-

Abu85

HÁZIGAZDA

Van a Wattmanban cél és maximális hőmérsékletre való beállítás. De eléggé ki kell tesztelni, hogy a custom dizájnoknak mi az optimális, hol érik el az ideális perf/wattot.

(#43237) paprobert: Nem úgy állították be. Ennek megvannak a tipikus működési normái, hogy mikor és hogyan marad stabil a hardver.

(#43238) Ribi: A hogyan kérdése leginkább attól függ, hogy hogyan lesz stabil a hardver. Ez részben tapasztalati módszerrel lesz meghatározva. Szóval nem kötelező így működnie, de így van beállítva. Bizonyosan jó okkal.

(#43243) sutyi^: A régi hardverek sokkal szarabbak voltak, mint a Navi. De a Navi esetében már lehet így is működtetni, hogy előnyt kaparj ki belőle. Azzal, amit az AMD alkalmaz manapság, el kell felejteni minden régi kötöttséget, amit a DVFS jelentett. Az innentől kezdve kőkorszaki technológia, ezért lett lecserélve AVFS-re, ami sokkal rugalmasabb. Csak az AVFS-t nagyságrendekkel nehezebb megcsinálni, nem véletlen, hogy az AMD is 15 év alatt jutott el ide.

(#43239) Petykemano: Vega 20

-

Abu85

HÁZIGAZDA

Ha a hardver power limitbe ütközik, akkor a feszültség változik először és azt követi az órajel. Ha hőmérsékleti limitbe, akkor az órajel változik először, és azt követi a feszültség. Nagyjából negyed milliszekundum az a maximum időtartam, amíg a hardver képes átvészelni stabilan azt, ha csak az egyik paraméter változik. Bármelyik lehet. Viszont ha az órajel nő először és nem a feszültség, akkor azzal nagyobb perf/watt jár. És bár a negyed milliszekundum nem hangzik soknak, de a Navi 10 nanoszekundumonként tud órajelet és feszültséget váltani, ezért jelez a hardver vissza egy átlagos órajelet és feszültséget, mert maga a monitorozás másodperces szintű, tehát az előző másodperc órajeleit és feszültségét átlagolja a hardver, és azt adja vissza a szoftvernek. Ennek igazából akkor van előnye, ha a program beleütközteti a hardvert a hőmérsékleti limitbe. Ha nem, akkor a referencia esetében is a power limit lesz a döntő tényező, ahogy a custom esetében is, így a feszültség fog előbb változni.

-

-

X2N

őstag

Jobban teljesít frametime grafikonon persze, de azért nem szar a 2080-se. Ez csak 1 játék, viszont a zöld biztos hogy kevesebbet fogyaszt és nem melegszik annyira, és nem kell neki 650W-os táp. Egy átlag user már ezek miatt sem vega-t fog venni. Egyszerűen ennyi kevés sajnos, pedig én is gondolkozok ha eladom a 980Ti-t akkor elég lenne nekem egy Vega56, és HBCC-t használnák valami Freesync-es monitorral, de mostanában már amúgy se játszom sokat. Jelenlegi játékokra meg ez a kártya is bőven elég 2560x1080-ban.

-

Abu85

HÁZIGAZDA

Nem kell több. NUMA-aware módon kell programozni. Ez a szervereknél eleve nem gond, mert ott ilyenek a programok. [link]

A késleltetés egyébként az igazi gond, de csak akkor, ha a program érzékeny rá. A NUMA-aware lényege pont az, hogy az alkalmazás működése toleráns legyen a késleltetéssel, ugyanis a szervereknél vannak többutas rendszerek, amiket csak így lehet jól kezelni.

-

Abu85

HÁZIGAZDA

Ezek nagyon kevés helyet igénylő linkek a tokozáson. Nem azért limitálják ezeket, mert nem férne el, hanem azért, mert elég akkora sebesség, amekkora amúgy is szokott lenni a lapkán belül. De elméletben, és tulajdonképpen gyakorlatban is, nem jelentene problémát az 1 TB/s sem, csak overkill. Ágyúval felesleges verébre lőni.

-

épp ez a lényeg hogy ez attól hogy 36 modulból áll egy egységet képez.Persze minél szeparáltabban használják, annál nagyobb probléma az általad felvázolt, gondolom én, persze ezek csak találgatások.Épp ezért írtam, hogy ha egyenlőre 4 modullal abszolválnák a gyártók már az is egy hatalmas előrelépés lenne.

De egyébként ha megnézed a cikket ezt írják benne:

"100GB/s I/O bandwidth per chip." tehát elég gyors kommunikáció lenne a modulok között. -

Az MCM nél az egy fontos szempont, hogy többféle stackot és akár eltérő memóriát is alkalmazhatsz külöböző blokkokhoz, amit egy központi csatorna gyűjt egybe. Elég fantasztikus megoldás, sok mindenre adhat lehetőséget.. Például ha x számú modul az RT-t számolja az mehet HBM rammal,a kevésbé ramigényes megoldásokhoz elég lehet olcsóbb megoldású GDDR6 memória is. Elméletileg képes arra is megfelelő vezérlővel, hogy egységként kezelje az egész 36 egységet és a 87 millió tranyót de akár 36 részre osztva is tudja vezérelni, vagy akár le is tudja kapcsolni a nem használt modulokat. Tehát egy fejlesztőre lenne bízva , hogy most teszem azt 10 modult befog RT gyorsításra 20 at meg általános számításra satöbbi. Nagyon ez a jövő szerintem, remélem 2 generáción belül AMD és Nvidia is lehozza gamer szegmensbe még ha nem is 36 modullal de egy 4 modulos megoldással már megoldódna a dedikát hardveregységek problémája a Raytracingnál valamint egy könnyebben gyártható VGA-t eredményezne jobb kihozatallal.

-

Raymond

titán

Azert ilyen aron sokan megveszik, pedig meg az AMD-s reddit-en is inkabb az volt hogy "haggyadbeken" ami meglepo volt. De szerintem ennyi penzert jo ajanlat volt egy kis UV beallitasok es jatszadozas utan meg jo (vagyis inkabb hasznalhato) is lehet a kartya. Na persze most kint vannak a 1660Ti tesztek igy megint mas a fekvese

-

Oliverda

titán

-

Envo_

aktív tag

Mit is lehetett tudni?

leaket maximum...

leaket maximum...(#38797) solfilo

"Igen, nyugodtan elvárhatjátok, hogy azt a helyet fel fogjuk tölteni, ami kimaradva látszik" Ha mégsem így lenne akkor nem mondhatott volna ilyet. Másrészt van több piaci oka is, hogy nem e legnagyobbat mutatták be. -

Tyrel

őstag

Nem mintha az RTX demo nem ilyen lett volna...

Amúgy a Navi bejelentését én is valószínűtlennek tartom, pedig nagyon örülnék neki. Szerintem csak Vega refresh jön, az is várhatóan kb. olyan "jó" lesz mint az RX 590 az 580-hoz képest.

Mondjuk ha meg nem lesz igazam akkor rájuk borítom a pénztárcám az biztos.

-

Z10N

veterán

Most ki jatsza a sertodottet?!

AMD-s topikban, amd-s tech-rol beszeltem egy lehetseges amd gpu-rol. Erre tovabbra is folytatod a nv emlegeteset. What for? Ebbol latszik, hogy meg mindig nem esett le. Olvass vissza Stratova kollega belinkelte.

Rendszer memoriabol meg igy s ugy is egyre tobb kell, amikor mar bongeszesre sem eleg a 8GB. Az szerencsetlen, hogy a ddr4 draga, de nekem meg a ddr3 megfelel, abbol van 16gb. Majd akkor rakok be 24-32-t olcson. A gddr5 viszont dragul es nem valaszthatod meg. A gddr6 meg szinten draga lesz. Es az alap problemat tovabbra sem oldjak meg.

"lehet neked pont elég lesz 1GB ram, de akkor 1GB-ból kb elég lenne gddr is"

Tevedes. Pontosoan ebbol latszik, hogy meg mindig nem erted. Szoval jobb lesz, ha hagyod a temat."De inkább hagyuk, mert amint valamiért leírom NV, te csak erre reagálsz..."

Ezenkivul pedig ne ferdits... -

Abu85

HÁZIGAZDA

Igazából nem kell. A HBCC alapvetően azt csinálja, hogy van a shared memory, ami a játékoknál az a terület, amit a CPU és a GPU is elérhet. DirectX memóriának is szokták hívni, de nem hívjuk így, mert más API is így működik. A HBCC lényegében ezt a területet kezeli ügyesebben. Ugyanis normál hozzáférésnél a VRAM-ba teljes allokációk kerülnek át a CPU és a GPU között megosztott memóriából, míg a HBCC ezt felügyeli, így csak szimplán blokkokat helyez át. Olyan blokkokat, amelyekre valóban szükség van, és ha csak 1 MB-nyi adat kell, akkor ne kerüljön bele a GPU melletti memóriába egy 100 MB-os allokáció, mert a maradék 99 MB lényegtelen, csak a helyet foglalja, de nem kezd vele a hardver semmit. A HBCC-nek azért kell beállítani a működését előre, mert ki kell jelölnie a rendszernek, hogy a RAM melyik részéből fog gyorsítótárazni, és a WDDM 2.0 innentől kezdve elmondja az OS-nek, hogy a CPU és GPU között megosztott memóriát arra a részre allokálja. Ettől egyébként lehet benne más is, de HBCC a driveres móddal csak olyan allokációt tud gyorsítótárazni, ami shared.

-

Z10N

veterán

Mi az hogy hisztizni?! Te kezdtel el kotekedni es "pampogni", hogy nem eleg. Szoval hiaba forgatod a szemeid.

HBM-rol volt szo es vele egyutt a HBCC-rol.

1GB nem csak nekem lenne eleg, abbol ami sporol, illetve dragan implementalhato. Ha tobb kell ott a 2GB verzio. A hbm teszteket nezd meg deus ex-nel, ne az nv teszttel peldalozzal.

-

Z10N

veterán

Latom nem sikerult felfogni mirol beszelek.

7790-560-Vega14/16 vonalrol volt szo.

Ide a "csoda" hbm2" eleg 1-2GB kivitelben.Nem tudom hogyan sikerult idekavarni az NV-t.

Ismetlem casual gaming-rol van szo.

Ertsd alapesetben is 2-3GB hasznalat.A peldadban a 1060-3GB ehhez boven eleg.

HBM-bol meg ennyi:

entry: 1GB

low: 2GB

mid: 4GB

high/ultra: 8GB+ -

HSM

félisten

Itt adtak neki rendesen, és egészen szépen bírta: [link].

Illetve több topikban is azt olvastam, hogy az egyetlen ok, amiért throttlingol, hogy 70 fok magasságába rakták a határát BIOS-ból, ami nem éppen indokolt, de ez a megjelenés környékén volt, azóta nem követtem a dolgokat.

A fenntartásaid amúgy sajnos teljesen jogosak, nagyítóval kell keresni a normálisan meghűtött notebookokat komolyabb hardverrel.

(#34143) Jack@l: "Viszont te még mindig desktop procit akarsz beletuszkolni egy laptopa, ez eddig mindig bukta volt a gyártóknál."

Remélem, tisztában vagy vele, hogy ez az érv itt ebben a kontextusban teljesen irreleváns...

-

HSM

félisten

Én remekül megvoltam a 2900 közvetlen leszármazottjával, a 3870-el. Sőt, számomra jóval meggyőzőbb volt, mint a kortárs 8800 GTS 320MB. (Mindkettő referencia, saját gépben tesztelve.)

Az FX-eknek pedig egy rossz szavad nem lehet a többszálú teljesítményére, a mai napig korrekt, amit tud. Egyszálon persze, nem lett erősebb, nyilván. -

Abu85

HÁZIGAZDA

Az FX 8350-et le lehet nézni, de a legújabb procitesztünkben csak az R5 1400 volt a játékokban gyorsabb nála, mármint az átlagolt eredmények tekintetében. Igen, mi is nagyon meglepődtünk, de ez van.

No persze az eredmények között alig van különbség. De PH-s mércével ugye néha kettéhúgyozásról is beszélhetünk.

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Formula-1

- WoW avagy World of Warcraft -=MMORPG=-

- Honor Magic6 Pro - kör közepén számok

- DUNE médialejátszók topicja

- Milyen okostelefont vegyek?

- Bevonják az AI-t az atomreaktorok építésébe

- Sweet.tv - internetes TV

- 6 év biztonsági támogatást ígér a Motorola

- Kerékpárosok, bringások ide!

- Milyen egeret válasszak?

- További aktív témák...

Állásajánlatok

Cég: Promenade Publishing House Kft.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

spongyát rá, melóban vagy

spongyát rá, melóban vagy

![;]](http://cdn.rios.hu/dl/s/v1.gif)

)

)

trend

trend "

"

Az is érdekes, hogy csak a SAM bekapcsolása hozza ezt a hatalmas kiugrást. Na meg a patch sem mindegy. A tesztek többsége a kiadáskori verzióval történt, amin már hatalmasat változtattak és ugye sok helyen Intel-lel tesztelnek, ahol megint máshogy működik a SAM.

Az is érdekes, hogy csak a SAM bekapcsolása hozza ezt a hatalmas kiugrást. Na meg a patch sem mindegy. A tesztek többsége a kiadáskori verzióval történt, amin már hatalmasat változtattak és ugye sok helyen Intel-lel tesztelnek, ahol megint máshogy működik a SAM.

Pazarló VRAM használat esetén is ott van a rendszermemóriában az adat.

Pazarló VRAM használat esetén is ott van a rendszermemóriában az adat.