- MIUI / HyperOS topik

- Milyen okostelefont vegyek?

- Szívós, szép és kitartó az új OnePlus óra

- Apple Watch

- Motorola Edge 50 Neo - az egyensúly gyengesége

- Fotók, videók mobillal

- Minden a BlackBerry telefonokról és rendszerről

- Xiaomi Smart Band 10 - a hetedik napon megpihen

- Külföldi prepaid SIM-ek itthon

- Samsung Galaxy Z Fold7 - ezt vártuk, de…

Hirdetés

-

Mobilarena

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

gV

őstag

válasz

KillerKollar

#59034

üzenetére

KillerKollar

#59034

üzenetére

ja meg az L2 jó része + 1 NVENC, 2 NVDEC, de mennyit foglalnak ezek? ez a kérdés.

-

bitblueduck

senior tag

válasz

KillerKollar

#58996

üzenetére

KillerKollar

#58996

üzenetére

legkésőbb december 13 gondolom, mert az a megjelenés, de azthiszem előtte 1 nappal lesz teszt.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#58243

üzenetére

KillerKollar

#58243

üzenetére

Nem tudom a beállításokat. Nincs meg a footnotes.

Időközben annyi infó van még, hogy a 7900 XTX kb. olyan viszonyban van a 4090-nel, mint a 6900 XT volt a 3090 Ti-vel. Valahol megveri, valahol nem. Viszont sokkal olcsóbban gyártható, így most nem annyira kritikus ráárazni a hardvert a csúcs-GeForce-ra.

Egyébként prótipp. Az átlag javulás a 6950 XT-hez viszonyítva 55% 1440p-ben. Tehát a 6950 XT eredményeiből lehet számolni.

#58250 FLATRONW : Nem ismerjük a per játék javulást. Tehát az átlagot így nem lehet rárakni valamire, inkább egy teszt több játékos átlagára.

-

Komplikato

veterán

válasz

KillerKollar

#58064

üzenetére

KillerKollar

#58064

üzenetére

Közben pletyi alapján RX 7900XTX lesz a "szörny" neve. Gondolom a 7950 majd az után jön, ha lesz 4090Ti.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#58010

üzenetére

KillerKollar

#58010

üzenetére

ECSM ezt a Twitter posztot fordította át: [link] - amit egyébként Bullsh1t_Buster egy viccnek szánt, hogy újra kiröhögtesse a Videocardz-ot, akik két éve az RDNA2 megjelenése előtt rakták ki ezt: [link] - aztán az RDNA 2 megjelenése után törölték a posztot.

#58011 Devid_81 : Azért tudja az AMD most ezt ennyire sokáig kussban tartani, mert az utolsó utáni pillanatban küldik a pletykáló kínaiaknak az adatokat. Ezért ugye nincs is mit leakelni még. Annyit tudnak a kínai gyártók, hogy a Navi 31-es VGA előállítási költsége nagyjából annyi, mint az azóta megboldogult GeForce RTX 4080 12 GB-nak. És ettől egyébként elég sokan beszartak, mert például a PC Partnertől tudom, hogy a GeForce RTX 4090-en az árrés 3-5% közötti, tehát ekkora hasznot termel a gyártó, ha MSRP áron adja el. Ergo, most mindenki fosva nézi az AMD árazását, mert nincs mozgástér árat csökkenteni, különben veszteséget fognak termelni minden eladáson.

-

Devid_81

félisten

válasz

KillerKollar

#58010

üzenetére

KillerKollar

#58010

üzenetére

Tovabbra is azt momdom az RDNA2.0-at RTX 2080Ti szintig vartuk, nem egeszen az lett a vege.

Erdekes modon az AMD teljesitmeny leak valahogy sokkal tovabb varat magara.

Kb 2 hettel az Ada elott joforman mindent tudtunk, 3DMark eredmenyt meg mar tobb hettel elore tudtuk.Valahogy az AMD-nek jobban megy a hallgatas, vagy nincs annyi fizetett leakere mint a zoldeknek akik toljak a hype vonatot?

-

Busterftw

nagyúr

válasz

KillerKollar

#57899

üzenetére

KillerKollar

#57899

üzenetére

Szerintem meg pont forditva, mert raszterben sosem volt az, hogy duplaztak, csak hoztak azt a bizonyos 20-30%-ot.

De a demok alatt sem mutattak kb raszter osszehasonlitast, minden DLSS 3 Performace modeban kellett erteni.

Ami raszter teszt kikerult meg nem volt hatalmas ugras. -

Alogonomus

őstag

válasz

KillerKollar

#57896

üzenetére

KillerKollar

#57896

üzenetére

Az RTX 3090 most 480-500k, RTX 3090 Ti pedig 600k. Ezek pedig már a használt kártyák által lenyomott árak.

Az RTX 4090 "állítólag" az RTX 3090 Ti-hoz képest sima helyzetben némileg dupla teljesítmény alatt lesz, míg raytracing esetén dupla-tripla teljesítményt nyújt. Persze a független tesztek után tudunk biztosat, de az eddigi állítások alapján simán érhet a vásárlóknak dupla árat, és ehhez jön még hozzá a kezdeti időszak "milking" felára.

A csúcs Navi 31-ről szóló pletykák is hasonlót ígérnek, csak lényegesen alacsonyabb fogyasztásból, és raytracing esetén határozottan alacsonyabb bázishoz mérve. Szóval a fő kérdés az lesz, hogy az RTX 4090 fogyasztásáig felhúzható lesz-e az RX 7900 XT, és az mennyi plusz teljesítményt fog eredményezni az AIB kártyák esetén. Ja meg plusz a SAM 10-20% teljesítménye a már PCI-E 5.0 és DDR5 segítségével. -

Abu85

HÁZIGAZDA

válasz

KillerKollar

#57810

üzenetére

KillerKollar

#57810

üzenetére

Ez nagyon jó kérdés. Ha látszik a hardveren valami fizikai sérülés, akkor esélyes, hogy belekötnek, és ugrik a gari.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#57806

üzenetére

KillerKollar

#57806

üzenetére

Nem magával az adapterrel lehet gond. Az nyilván megtervezhető, de két kábel összeköttetésénél nagyobb az esélye annak, hogy az aljzatba tömött fémdugasz elmozdul a helyéről. Ilyenkor közelebb kerül az aljzaton belül a műanyaghoz, és van esély rá, hogy elég. Minél több ampert visz át, annál nagyobb az esély erre. Szóval itt nem egy minőségi probléma van, nyilván megcsinálják ezt jóra, de az extra csatlakozásnál keletkezhet egy előre nem látható érintkezési gond. Akár minimális is lehet, ekkora áramerősségnél az is bajt okozhat.

Pusztán papíron szabványban tuti jó lesz. De nem lehet kizárni azt a gyakorlati problémát, hogy a két kábel összedugásánál az érintkező akár egy picit is elmozdult-e, mert ilyen terheléssel már nagyon pici változás is vezethet a csatlakozó kiégéséhez. -

válasz

KillerKollar

#57806

üzenetére

KillerKollar

#57806

üzenetére

A 4090 nem 810 wattos TGP vel lesz.

-

Ribi

nagyúr

válasz

KillerKollar

#57803

üzenetére

KillerKollar

#57803

üzenetére

AMD sem a saját pénztárcája ellensége.

Átalakító nélkül modu táppal is van 2 csatlakozás, átalakítóval meg 3. Annyival nem rosszabb a helyezet, de tény hogy vannak dzsunka kábelek.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#57803

üzenetére

KillerKollar

#57803

üzenetére

Én a barátibb árat nem hallottam. Azt igen, hogy olcsóbb előállítani, de ez pusztán amiatt van, hogy kisebb a lapka.

Ha jók a vezetékek az adapteren, akkor igen, el kellene bírnia. Itt leginkább a csatlakozással lehet gond. Mert amíg az új csatival ez táptól VGA-ig kábel, addig átalakítóval lesz benne egy átkötés, ami sérülékennyé teszi. Ez a köztes bekötés lesz a szűk keresztmetszet, és erre borzasztóan nehéz tervezni.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#57799

üzenetére

KillerKollar

#57799

üzenetére

A mérnöki mintákon még klasszikus 8 tűs van. De azt tudom, hogy az AMD nem tiltja meg az új tápcsati használatát a partnereknek, viszont nem ragaszkodnak hozzá, mint az NV. Az Ada úgy van tervezve, hogy annak nagyon hasznos az ATX 3.0 és az új tápcsati, míg az RDNA 3-nak nincs nagy haszna az új szabványokból, mert nem szükségszerű az extrém áramtüskék elviselése.

Ez egy dizájnbeli eltérés lesz. A Navi 31 pillanatnyi maximális terhelhetősége 450 watt alatt marad. Tehát ennél többet még pillanatnyi tüskékben sem fog felvenni. Az NV-nél az AD102 pillanatnyi maximális terhelhetősége 810 watt. Ugyan tartósan messze nem fogyaszt ennyit, de szüksége van az ATX 3.0 pillanatnyi 180%-os túlterhelhetőségére, amit az új tápcsati biztosít neki.

Az AMD partnerei is felszerelhetik persze az új tápcsatit, de nem tudják majd kihasználni, mert az Navi 3x nem az ATX 3.0 specifikációkhoz lett tervezve, képes maximum teljesítményen működni ATX 2.x-szel is. Az NV GPU-ja is tud ilyen tápokkal működni, csak megszűnik az extrém túlterhelhetőség, ami nélkül a turbó nem fog úgy működni, ahogy ATX 3.0-s tápokon.

-

Yutani

nagyúr

válasz

KillerKollar

#57240

üzenetére

KillerKollar

#57240

üzenetére

Minél közelebb vagyunk a fotorealisztikus megjelenítéshez, annál kevésbé látványos a fejlődés, mivel kisebbek már a lépcsőfokok is. Emiatt érzed azt, hogy mintha nem lenne előrelépés. A full RT még odébb van, addig okosan kell használni a technológiát részfeladatok megoldására.

-

Komplikato

veterán

válasz

KillerKollar

#57237

üzenetére

KillerKollar

#57237

üzenetére

Fiam most játszotta végig a Half Life 2 részeket. Én meg csak bámultam, mit ki nem hozták az akkori proocikból, 1GB ram és kemény 256MB Vram felállásból. Pálya design, textúra, arc és karakteranimáció, fizika alapú puzle terén.

Na ILYEN nem akar jönni a mai vasakra.

-

HSM

félisten

válasz

KillerKollar

#57237

üzenetére

KillerKollar

#57237

üzenetére

Sajnos nem nagyon volt időm az utóbbi 5-6 évben játszani, így nem tudok érdemben nyilatkozni a felhozatalról.

Ami nekem ennek ellenére nagyon felkeltette az érdeklődésem, az a Metro Exodus Enhanced Edition, bár az tudtommal teljesen jól fut egy 3090-en, akár kimaxolva is, és talán a konkurens 6900XT is megüt egy elfogadható szintet, és elég komoly lett az RT-s kivitelezés [link]. Én egyébként azt gondolom, az RT az az effekt, amivel rengeteget lehet most nyerni képminőségben megfelelően implementálva (főleg a GI/megvilágítás effektekre gondolok), de ennek komoly ára lehet teljesítményigényben. Kíváncsi leszek, hova fog fejlődni a technika, és milyenek lesznek a kifejezetten erre optimalizált játékok, motorok. Illetve az UE5 Nanite rendszerére is kíváncsi leszek majd pár év múlva a gyakorlatban, miket lehet majd kihozni belőle.

-

HSM

félisten

válasz

KillerKollar

#57235

üzenetére

KillerKollar

#57235

üzenetére

"de akkor se mentegessük már a fejlesztőket"

Félreértés ne legyen, még véletlenül sem a rossz kivitelezés miatt gyengén futó alkotásokat próbálom védeni. Persze, pl. egy rossz porttal könnyen lehet gyártani erőforrás zabáló, de cserébe rosszul futó címet, ez nyilván nem az, amire az előbbi hsz-emben gondoltam.

Persze, pl. egy rossz porttal könnyen lehet gyártani erőforrás zabáló, de cserébe rosszul futó címet, ez nyilván nem az, amire az előbbi hsz-emben gondoltam.

Mind az általam felsorolt Crysis, mind a GTA4 esetén jó oka volt az erőforrások használatának felhúzott grafikán. -

Cifu

félisten

válasz

KillerKollar

#57220

üzenetére

KillerKollar

#57220

üzenetére

Ez esetben a Crysis-effekt áldozata vagy, azt gondolod, hogy azért, mert csúcs kártyáról beszélünk, automatikusan max. felbontáson is max. képfrissítési frekvenciával kell futnia minden játéknak maximális beállítás mellett. Ha pedig nem fut, akkor a fejlesztő meg a gyártó a hülye, nem a felhasználó...

De még csak a Crysis-ig se kell előre menni, a 3Dfx Voodoo is úgy volt anno a Guru-ban ajnározva, hogy na, mostantól minden 30fps-el fog futni. Igaz valójában egy játék sem futott stabil 30 fps-el (a Tomb Raider is anno beszakadt 10 fps alá 3Dfx patch-al), de nach so...

Nem, egyáltalán nem elvárható, hogy egy CP2077 szintű játék 4K-ban 120 Fps-el fusson natívban akár egy RTX 3090 vagy RX6900 XT kártyán. Fut 4K Ultraban RT nélkül 60-80 FPS-el vagy 4K High-ban 120 FPS-el, vagy 4K /w Quality DLSS-en RT ultrában 60-70 FPS-el RTX 3090-en. Rád van bízva melyik választod.

Ha meg nincs 3090-re vagy 6900 XT-re pénzed, akkor még mindig lehet játszani a beállításokkal, hogy élhető kompromisszumot válassz.Ettől lesz jó egy játék.

Valójában a CP2077 egy GTX 960 kártyán is teljesen játszható 50-60 FPS-el medium körüli beállításokkal 1080p-ben egy i7-4770 szintű procival.

A kártya gyártója pedig nem ígérte, hogy minden játék max. beállítással fog 4K-ban 120 FPS-el futni a méregdrága csúcskártyán...

-

Alogonomus

őstag

válasz

KillerKollar

#57216

üzenetére

KillerKollar

#57216

üzenetére

Az új generációs csúcskártyák azért sokaknak valószínűleg nem lesznek alternatívák. Például a jelenlegi időnként 500 watt közelébe kerülő kártyákkal szemben az új kártyák már stabilan 500-600 wattos kártyák lesznek, amik valószínűleg néha még feljebb tévednek a számításigényesebb szituációkban, így valószínűleg riser kell majd hozzájuk, hogy ne az alaplapot fújják a 80+ fokkal teljes erőből. A csúcskártyák így valóban csak extrém gépekbe kerülhetnek, de el is hozzák a 100-120% gyorsulást.

A mostani generáció csúcskártyáinak a fogyasztási szintjére érkező új kártyák viszont szerintem csak jövő év második felében érkeznek. Egy 6900 XT vagy 3090 szerintem még messze van a nyugdíjazástól, még elég sokáig képviselhetik ezek a kártyák az "értelmes" csúcskategóriát. Persze jön a 6950 XT meg a 3090 Ti, de csak a listákon való versenyzéshez lesznek jók. Nagyjából 10% extra teljesítménytől nem tudsz majd eggyel magasabb grafikai minőséget választani.

Szélesebb körben majd akkor érkezik el a generációváltás, amikor a Navi 32 megjelenik. A Navi 31 kártyákból (RX 7900/7800?) még a gyengébbik is valószínűleg túl drága és "meleg" lesz a tömegeknek. A Navi 32-es (RX 7700?) lehet majd az első valós opció, mint volt az 5700 XT/2070 Super a 1080 Ti helyett, vagy a 6700 XT/3070 a 2080 Ti helyett. Az RX 7700 XT/RTX 4070 érkezéséig viszont a jelenlegi csúcskártyák szerintem bőven jók lesznek.

A megfizethető GTX 1060/1050 Ti és RX 570/580 kártyák ideje valóban lejárt, de még a 150 ezer forintos felsőközép-kategóriás 5700 XT sem jön vissza. Talán az Intel hoz valami jó ár/érték arányú kártyát piaci részesedésének a növeléséhez. -

Cifu

félisten

válasz

KillerKollar

#57205

üzenetére

KillerKollar

#57205

üzenetére

Amíg az 1-2 mFT áron is elfogynak a csúcs dVGA kártyák, addig nem hiszem, hogy a gyártók problémázni fognak ezen...

Márpedig elfogynak... -

Abu85

HÁZIGAZDA

válasz

KillerKollar

#57210

üzenetére

KillerKollar

#57210

üzenetére

A felbontásnál szerintem sokkal nagyobb baj, hogy a zseblámpára nem generál a játék árnyékot. Hello 2022...

-

Busterftw

nagyúr

válasz

KillerKollar

#57207

üzenetére

KillerKollar

#57207

üzenetére

Jo de akik annyit fizettek szerinted panaszkodnak? Mar kb masfel ev ota ez a GPU helyzet es nem ez az elso jatek ami igy fut.

Ertem az elegedetlenseget, de engem meg ezek az ismetlodo kommentek zavarnak, amikor mar 2 eve ez a helyzet.Ezen ugy lehetne valtoztatni, hogy senki nem vesz GPU-t, de az meg eselytelen.

Talan akkor, ha annyira beesik a crypto vagy mar POS miatt nem eri meg. -

Abu85

HÁZIGAZDA

válasz

KillerKollar

#57203

üzenetére

KillerKollar

#57203

üzenetére

A Dying Light 2-nek nagyon el lett baszva a motorja. Eleve ez egy nagyon sokat csúsztatott játék volt, amit igencsak konzolra optimalizáltak, de itt gond, hogy a PC-s shaderek nagyon különböznek. Egy rakás kód meg van írva konzolra SM6.x-be, és PC-ben mégis SM 5.x-ben van futtatva egy jóval butább és jóval lassabb verziója ugyanannak a kódnak.

Nagyon szembetűnő, hogy maga a DX12-es kód alapvetően el van baszva. Ez ott látszik, hogy egy RX 6900 XT a DX11 driveréből ~170 fps-re képes Full HD-ben, míg DX12-ben ugyanez az adat, ugyanazzal a grafikával ~160 fps. És ugye az AMD-nél megszoktuk, hogy gyorsulni szokott a DX12-től. Az NV-nél a driverek stagnálnak, mind a DX12 mind a DX11 kód ~150 fps tud ugyanitt RTX 3090-nel, ez valami CPU-limit lehet, amin az NV hardvere/drivere nem tud túljutni. De a CPU egy 12900K, tehát kezdeni se lehet vele semmit hardveresen. Talán az 5800X3D segíthet picit, de nem fogja megváltani a világot.

Na most az eddigi adatok alapján azért nem gyorsul a DX11-ről DX12-re váltásnál, mert a fejlesztők mindent amit lehet direkten a root signature-be mentenek. Ez azért nem ajánlott, mert maga a root signature nem támogat minden formátumot. Ahhoz, hogy ez működjön a Dying Light 2 veszi a konzolos formátumokat, beleírja a memóriába egy leíróhalmazba, majd ott átkonvertálja őket egy olyan formátummá, amit a root signature direkten kezel, és ekkor átmásolják oda a puffert, amivel dolgozik a játék. Majd minden frissítéskor visszamásolják a leíróhalmazba, ahol visszakonvertálják az eredeti formátumba. Ez olyan bődületesen nagy marhaság, hogy elmondani nem lehet, és csak ezen a konverzió-másolós hülyeségen minimum 30%-os teljesítményt veszít a játék DirectX 12 alatt. Valószínűleg ebből jön a DX11-hez viszonyítva a lassulás, mert ott nem kell ez a konverzió.

Röviden akkora marhaságot csinálnak a Dying Light 2-ben, hogy azt a Microsoftnak oktani kellene egy "mit ne csinálj" előadáson. Sokkal gyorsabb lenne, ha direkten dolgoznának a leíróhalmazokba konverzió és másolás nélkül, és még lehetne minimum +20%-ot nyerni ha wave intrinsics függvényeket használnának DirectX 12 alatt SM 6.x-ből.

Ami látszik, hogy ez a játék alapvetően DX11-re készült, és az RT effektek miatt valahogy belehánytak egy alapszintű DX12 támogatást, ami úgy szó szerint kerülőutakkal belehegesztettek "éppenhogycsakműködőre". A sebesség itt nem számított, mert arra nem volt idejük. És itt igazából egy gyártó is tehetetlen. Ha rosszak az alapok, akkor az NVIDIA sem tud mit kezdeni vele, hiába támogatják pénzzel a fejlesztést. Az alapok annyira mélyek, hogy azoknak az átírása hónapokat venne igénybe, amit lehet, hogy beterjesztettek a kiadónak, aztán miután kiszámolták, hogy mennyi pénzbe kerülne, még a másik épületben is lehetett hallani, hogy: nein-nein-nein...

Én egy alapvetően elbaszott játékokból nem indulnák ki, de igen, szar dolog, hogy ez PC-n még megtörténik. Nyilván szar dolog, hogy megtörtént hasonló a BF2042-vel és a CP2077-tel is.

-

Busterftw

nagyúr

válasz

KillerKollar

#57205

üzenetére

KillerKollar

#57205

üzenetére

1199 euroert vettem.

4K@60 RT mellett? Mert anelkul meg van az, Youtube videok alapjan.

A varosban 1440p High-on kb 120FPS az atlag es ez launchkor.

Persze orulnek en is, ha 4K@300 fps lenne RT-vel, de nem tudom hol voltal az elmult 5+ evben amikor minden AAA/AA jatek igy jon ki launchkor es ez meg a jobbik eset.Miert csinalunk ugy, mintha a jatekok nem valtoztak volna az evek soran?

Ezt mar irtam mashol is, egy 1080p jatek 8 eve nem olyan technikailag es kinezetre mint a mai 1080p.Az arak meg elszalltak, aligha a dev studiok tehetnek rola.

-

Busterftw

nagyúr

válasz

KillerKollar

#57203

üzenetére

KillerKollar

#57203

üzenetére

Szerintem nem annyira veszes a dolog, epp most keszul RT/DLSS patch fix is.

1440p High-on nalam RT nelkul siman van 100+ FPS a varosban, RT DLSS Quality meg 70+.Es ez csak javulni fog.

-

Rico33

aktív tag

válasz

KillerKollar

#56953

üzenetére

KillerKollar

#56953

üzenetére

30 perc alatt felhúzni egy konyhát? Necces..

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Busterftw

nagyúr

válasz

KillerKollar

#56953

üzenetére

KillerKollar

#56953

üzenetére

16:00 a gyerekek nezik, az Nvidia/Intel pedig a felnotteknek szol akik mar vegeztek a meloval.

-

TESCO-Zsömle

titán

válasz

KillerKollar

#56810

üzenetére

KillerKollar

#56810

üzenetére

Ezek mondvacsinált ürügyek, de vegyük sorra őket.

Energiaárakról nincs értelme beszélni attól a ponttól kezdve, hogy kiadtál 1000$-t egy videókártyára. Egyszerűen nincs. Vagy azért, mert megtehetted és csak játszol rajta, ergó luxuscikk, vagy azért ,emrt munkaeszköz és kitermeli.

A hűtést se nevezném problémának, ott vannak az RTX3090-ek, de erre a szintre én már borítékolnám a vízhűtést. Bőven belefér.

Hogy a házban mit kezdesz 500W-nyi hővel, az megint meddő vita. Ugye 1000$-os VGA... Jusson normális házra, szellőzésre, de AIO-t amúgy is tipikusan kifele fújóra szokás feltenni, videókártyáét meg egyenesen elő is írja a gyártó, jó esetben úgy van rajta gyárilag a vnetillátor, hogy másképp fel se tudd tenni.

És ha elég régi motoros vagy, még új tápot se kell venned, mert az SLI/CF időszakban betárazott 1000+W-os szörnyeteg köszöni most is elég. Ha meg eleve nem játszott anno az SLI/CF, akkor most se lesz rá pénz, mert gyakorlatilag ugyanaz a helyzet, csak most egy kártyán kapod meg azt, amit régen 2 kártyával.

Az iránnyal nincs semmi gond, csak el kell fogadni, hogy kitolódtak a határok. Azonban neked nem kötelező a 250W-os procit és a 600W-os videókártyát venned, veheted a 105W-os procit a 250W-os kártyával ugyanúgy, ahogy eddig. Annyi a különbség, hogy most már nem az lesz a platform teteje. -

Petykemano

veterán

válasz

KillerKollar

#56711

üzenetére

KillerKollar

#56711

üzenetére

Abban igazad van, hogy a TOP kártyáért, bármilyen kis mértékű elsőség ellenére is jelentős felárat fognak kérni. Viszont az összes tier ára csúszik felfelé - nagyjából generációnként $50-t.

Az általános chiphiány rendeződésével kapcsolatban vannak nyilatkozatok. Enyhülés 2022 vége (Lisa Su), rendeződés 2023-2024.(Pat Gelsinger) De ezt hagyjuk.

Viszont a GPU-k terén miért, milyen okból kéne elhinnünk, hogy rendeződni fog?

Szerintem az csak vetítés a gyártók részéről, hogy itt csakis az otthon unatkozó covid-gamerek által keltett magas kereslet dobta meg az árakat. Bár otthon is lehet bányászni a játékra drágán vett kártyán, de ez ma már professzionális ágazat is egyben. Ha csak arról lenne szó, hogy az emberek otthon hobbi-bányásznak, akkor az árak nem a kártyák profitabilitási sorrendje alapján állnának be.A bányászat hardverigénye pedig kielégíthetetlen - hiszen ha nő a teljesítmény, akkor nő a teljesítmény-igénye (difficulty) is. Az egyes hálózatok versengenek a részesedésben - mivel az új coin leesésének esélye az adott hálózathoz a részesedéssel arányos. Érdekük növelni a bevont kapacitást, hogy előnyre tegyenek szert a részesedésben. A versengés során a bevont kapacitást folyamatosan növekedik.

A kurrens játékszabályok szerint két esetben torpan meg a hardverigény:

a) Ha a coin ára és a tranzakciós költség lecsökken. Ez pénzügyi kérdés. Mitől vonódna ki a hatalmas, többszáz(vagy ezer) milliárd dolláros pénztömeg a kriptovalutákból? Ez döntően nem olyanok vagyona, akik nagyon hisznek a államsemleges, technovalutában, hanem olyan vagyon, amit a nagy jegybankok nyomtattak. Tőzsde. Beomlások persze lehetnek, de ahhoz, hogy ez végleg beomoljon, ahhoz ennek a pénznek el kéne tűnnie. Kisemberekhez, vagy adó formájában a jegybank által megsemmisítve. Az, hogy az ezermilliárd dolláros vagyon kiszáll a kriptoból és átnyergel valamilyen más befektetésre, aranyra, részvényre. Az csak átmeneti.

b) Ha a "termeléshez" szükséges energia ára brutálisan megemelkedik és már nem fogja megérni. Namost ezzel két probléma van. Egyrészt ha a energiaárak brutálisan megemelkednek, akkor az mindannyiunk életére jelentés hatással lesz. Másrészt olcsó energia reményében elindulhatnak olyan energiatermelési folyamatok, amelyek fittyet hánynak a környezeti károkra. (Pl mi akadályozná meg a gazdag arab országokat, vagy oroszországot, hogy olaj/gáz égetésével GPU-kat hajtson, ami akár még több pénzt is termelhet, mintha benzinként vagy fűtési célű földgázként adnák el a lakosságnak?)Változni akkor fog valami, ha a játékszabályokon változtatunk.

Pl az ETH2 talán egy jó esély erre. De tudjuk, hogy bármennyi kriptovaluta hálózat létezhet. Egy nagy farm megteremheti a saját coinját és csak fel kell piszkálni valahogy a mohó befektetőket. Nem azt mondom, hogy egy könnyű feladat, de szerintem nem kivitelezhetetlen, hogy az ETH1 helyét átvegye egy másik PoW típusú feltörekvő hálózat.

Ha az ETH2 beválik, még az is lehetséges, hogy EU, USA és Kína szinten betiltják a PoW típusú hálózatokat. És persze lehet vagyonadót kivetni.

Ezek kivitelezése persze kérdéses. De ha jól tudom, Kína épp betiltott minden kriptovalutás tranzakciókat. -

válasz

KillerKollar

#56712

üzenetére

KillerKollar

#56712

üzenetére

Szerintem nem 2000 dollár lesz, hanem annál jóval több, főleg ha véletlenül valaki professzionális használatra is használja, minta Radeon VII karit vagy a Titan V-t. Amúgy a Titan V 3000 dollár volt nagyjából a piaci hatása nulla volt, presztízsnek jó volt.

Ezt abból gondolom, hogy az Nvidia nem erőlködik a Hopper féle dizájn gaming bevezetésén az előzetes szivárgások szerint, ami MCM , hanem az ADA-t elégnek gondolják a valós piaci versenyhez.

nagyon korai még erről amúgy ilyeneket nyilatkozni, mert konkrétan mindegyik cég össze vissza szivárogtat, de az MCM nek azért jelen esetben nem lesz feltétlenül még költségcsökkentő hatása, mikor kisebb GPU kra is alig van kapacitás, plusz miért is adnák olcsóbban ugye neked attól hogy nekik talán olcsóbb valamivel gyártani. Ez inkább jobb kihozatal és nagyobb haszon a cégnek. Ehhez még kell 1-2 gen szerintem. -

Abu85

HÁZIGAZDA

válasz

KillerKollar

#56712

üzenetére

KillerKollar

#56712

üzenetére

Hát a legkisebb RDNA3 az a Navi 33 lesz, és az nem MCM-es, hanem egy nagy lapka csak. Annak a teljesítménye a 6800 XT és a 6900 XT közé van prognosztizálva. Ezzel szemben a BOM inkább 6600 XT és 6700 XT közötti. Szóval árban az AMD az RDNA3-mal mehet elég alacsonyra is, ha akarnak, de szerintem nem akarnak.

Most pusztán elvi alapon, ha a Navi 33-as GPU-val rendelkező VGA-t 349 dollárért adnák, akkor az azzal a BOM költséggel, amivel számolnak, még simán masszívan nyereségessé teszi. Valószínűleg olyan 200 dollár az a szint, ahol már rezeg a léc.

-

válasz

KillerKollar

#56708

üzenetére

KillerKollar

#56708

üzenetére

Ilyen nem lesz Szerintem ( tippre és tényleg csak találgatva )a csúcs navi a maga MCM dizájnjával olyan limitált brutál drága cucc lesz, minta Titan sorozat a zöldeknél.. igazán valós kereskedelmi fogalomba az alatta lévő kártya fog kerülni, de az meg a jelen infók szerint azért nem kicsit lesz lassabb egy fullos MCM dizájnos kártyánál, főleg hogy a középkategória elméletileg RDNA 2 refresh lesz.

-

Petykemano

veterán

válasz

KillerKollar

#56708

üzenetére

KillerKollar

#56708

üzenetére

"jóval olcsóbb" -elnézést

de nekem az Űrgolyhók jutott eszembe.

Ma már nincs olcsó.- expensive

- very expensive

- ridiculously expensive

- ludicrously expensive

-

Alogonomus

őstag

válasz

KillerKollar

#56595

üzenetére

KillerKollar

#56595

üzenetére

A konzolokon szinte minden játék dinamikusan változó felbontással működik, hogy a célként meghatározott fps folyamatosan meglegyen az adott kimeneti felbontás mellett. A konzolok az upscaling eredeti célterepe. Egy erősebb konzol esetén pedig ritkábban kellene a 4K helyett akár FHD szintig visszaváltania egy konzolnak, hogy tartani tudja a célként meghatározott mondjuk 120 fps értéket az adott játékban. Az új drágább konzollal végeredményben szebb képminőséget kapna a felhasználó.

-

Petykemano

veterán

válasz

KillerKollar

#56588

üzenetére

KillerKollar

#56588

üzenetére

> 2 év után refresh? Minek?

Szerintem:

- zárcsökkentés

- lapkaterület csökkentése, kihozatal javítása, termelési kapacitás növelése

Az N6 egyrészt nagyobb mértékben EUV, mint az N7(P), ezért

- javul a hibaarány is, ezáltal tovább javul a kihozatal

- nem kell quadruple patterninget használni, ezáltal gyorsul a gyártási folyamat, vagyis adott gyártósoron adott időn belül több wafert lehet megmunkálni

- elvileg némileg csökkenthető a lapkaméret is (upto 18%)Ahogy MLiD mondta, a cél nem egy erősebb konzol kihozatal, hanem egy olcsóbban és/vagy nagyobb mennyiségben gyárthatóé.

Hogy ezt van-e értelme pro-nak nevezni az nyilván attól függ, hogy változik-e még ezen kívül valami. Én a Sony helyében nem változtatnék semmin, csak portolnám N6-ra és kiadnám olcsóbban PS5 slim néven. Pont azért, amit mondtál, hogy különben nagyon fragmentálódik a konzol hardver.@Raymond

Én úgy vettem a vázolt pletyka-információkból, hogy épp az lenne a lényeg, hogy a jelenlegi 24-ből 20aktív felállást módosítanák arra, hogy 24-ből 24 aktív.

Ez persze azt jelenti, hogy ami eddig hibás volt, de el tudták adni. Azt már nem tudják.

De láttuk, hogy az AMD hibás PS5 chipeket is eladja -

Raggie

őstag

válasz

KillerKollar

#56576

üzenetére

KillerKollar

#56576

üzenetére

A Horizon Zero Dawn pont nem igazán jó példa. A PS4 Pro settingjei a Medium beállításnak feleltek meg a PC-n. És efölött még volt a high és ultra...

-

Jacek

veterán

válasz

KillerKollar

#56576

üzenetére

KillerKollar

#56576

üzenetére

Fullos eger/bill support es ezekhez sem kell support, egy rendes desktop es viszlat, de egyenlore nem erdekuk.

Majd ha kivereztettek teljesen a PC gaminget akkor. -

Alogonomus

őstag

válasz

KillerKollar

#56576

üzenetére

KillerKollar

#56576

üzenetére

Legnagyobb hiányként az MMO-k nem jönnek ki konzolokra. Az RTS-ek népszerűsége már inkább hanyatlóban van.

A Decima motoros játékoknál, mint a Horizon: Zero Dawn pont megjelent egy lényeges grafikai ugrás a PC-n megjelenéshez. Az eredeti konzolos szint az a közepes beállítási szintnek felel meg, fölötte pedig van még két minőségi szint. -

Alogonomus

őstag

válasz

KillerKollar

#56574

üzenetére

KillerKollar

#56574

üzenetére

Bizonyos játéktípusok eleve nem érkeznek konzolokra, de amikből érkezik konzolokra is játék, abból a típusból is sokkal nagyobb a választék PC-n. Aki csak akármivel, de játszani szeretne, annak tökéletes lehet a konzol, de a játékosok jelentős részének nem megoldás a konzol, így azok mindenképpen eltartják a PC gaming piacot.

És persze igaz az is, amit te is leírtál, hogy a konzolok most még nagyjából jó teljesítményt nyújtanak (RTX 3070 és RX 6800 XT közötti kategória effektív teljesítményt), de egy 2022-ben összerakható komolyabb gaming PC-vel szemben valószínűleg már játékteljesítményben sem lesz esélye egy konzolnak.

A konzol pár exkluzív címre vágyó játékos esetétől eltekintve régen is a kompromisszum/megalkuvás eredménye volt. Ezért is fogadták el a konzolosok például a 30 fps melletti játékot, míg PC-n 60 fps alatt már tikkel a játékosok szeme, és ideálisnak a 120 fps fölötti üzemelést tekintik. -

Senki9876

tag

válasz

KillerKollar

#56472

üzenetére

KillerKollar

#56472

üzenetére

Lehet időközben kapott frissítést.

Valami olyasmit emlegetett ABU hogy a doom hoz külön kell profilt csinálni minden kártyához -

GeryFlash

veterán

válasz

KillerKollar

#56006

üzenetére

KillerKollar

#56006

üzenetére

En egyebkent ezzel egyetertek. Fogalmam sincs hogy mekkora valos impactje van a vilagra desktop CPU-k fogyasztasanak a CH kibocsatasra, valoszinuleg elenyeszo (1% alatt), ettol fuggetlenul ha mar mindent takarekosra csinalunk, mindent probalunk ujrahasznositani, ha az elmult evekben a notebook fogyasztasa a felere csokkkent akkor igenis itt ne legyen mar egy forditott trend. Indultunk onnan hogy 2006-ban egy csucs DX9-es kartya (Radeon X1950, Geforce 7950GT) 65 wattokat fogyasztottak. Aztan a DX10-es VGA-knal mar (4890, GTX 280) inkabb 200wattot, utana jottek a PCI-E VGA-k, GTX490-590 es 5970 is megevett 300-350 wattot es kezdett nagyon elharapozni a dolog. Utana viszont evekig egy konszolidalodast es TDP csokkenest lattunk, es 2080TI-ig max TDP 250 watton belul maradt.

Viszont a mostani uj generacional megint oruletes TDP-k lettek, es most mar nem csak csucsban hanem a kozepkategoria is jelentosen nott (6700XT 192bites busszal 230watt WTF). Mindezt ugy hogy folyamatosan jobb gyartastechnolgian keszulnek a VGA-k. Az, hogy a szupertakarekos 5nm-en 350-450 wattos kartyakat gyartsunk az olyan szintu f*szsag es mernoki beleszaras. Elszallt fogyasztassal ,,barki" kepes nagy teljesitmenyt hozni. Kicsit azt erzem, mint a jatekfejlesztoknel, hogy segguk ala van tolva a jo hardver es b*sznak optimalizalni (na nem a fejlesztok kivansaga ez, hanem a jatekkiadok-managerek felol jovo nyomas). Ugyanez van most itt a , adott lesz egy fasza gyartastechnologia a TSMC reszerol, es ahelyett hogy 230-250 wattban maximalizalt high-end kartyakat hoznanak a 3090-hez kepest +50%-kal, ehelyett inkabb megy a szamhaboru es hoznak 20 ezer core-os 400 wattos vadallatokat... HOVA? A next gen konzolok mar most kb csak egyszinten vannak a jelenlegi desktop VGA felhozatallal. Regen, amig nem x86 alapuak voltak a konzolok addig nagyokat lehetett hozni a konzolra valo optimalizalassal (lasd Xbox 360 512MB fedelzeti memoriaval 260GFLOPS-szal futtata a GTA V-t), addig most mar alig van elonye a fix hardvernek.

Egy 10FLOPS-os PS5-t alig tud jobb teljesitmenyt hozni mint a vele pariban levo 5700XT.

Ergo mar most kicsit outdatek a next-gen konzolok Es ezek meg velunk marad 5 evet, teljesen erthetetlen szamomra hova a 3090-hez kepest 2-2,5szer nagyobb teljesitmeny. Legyen +50%, de a TDP menjen vissza egy kevesbe elborult tartomanyba.

Es ezek meg velunk marad 5 evet, teljesen erthetetlen szamomra hova a 3090-hez kepest 2-2,5szer nagyobb teljesitmeny. Legyen +50%, de a TDP menjen vissza egy kevesbe elborult tartomanyba.

8K monitorok kvazi nem leteznek, 60HZ feletti 4K monitorok aranyarban mennek es valasztek sincs beloluk szoval ,,felesleges" ekkora teljesitmeny ugras...Az hogy ennek a rendeletnek lesz e barmilyen impactje... Hat erosen ketlem pedig szerintem jo lenne ha igen.

-

Devid_81

félisten

válasz

KillerKollar

#56006

üzenetére

KillerKollar

#56006

üzenetére

Mehetne vele a banyaszat is, az is pocsekolja rendesen az aramot

-

Pakmara

őstag

válasz

KillerKollar

#56006

üzenetére

KillerKollar

#56006

üzenetére

Ezt hogyan tervezik "mérni" (75kWh/year and if they include a discrete GPU it cannot exceed 100kWh/year.). Van egy RTX 3090-el szerelt gépem és napi 2 órában böngészek vele vs ugyanezzel a géppel 0-24 mennek a botok vmi online gameben...

-

Petykemano

veterán

válasz

KillerKollar

#55506

üzenetére

KillerKollar

#55506

üzenetére

Ugyanő nemtom kb egy évvel ezelőtt azt mondta, a magas árak miatt jöhetnek új belépők a piacra. Például 28nm-es gyártástechnológián 600-700mm2 méretű lapkával magasabb fogyasztással, de egy új belépő $200-300-ért is kínálhatja.

Azóta persze kiderült, hogy a chipgyártás minden területén szűkösség van.

Aki szerintem fog hozni saját megoldást az az Apple. Saját maguk irányítják a szoftveres környezetet is,.driver nem gond, nem kell százféle hardverhez igazítani. És persze Legjobb gyártástechmológián készül majd. De valószínűleg csak macben lehet megvenni.

Én sokáig reméltem, hogy ilyen árak mellett fog készülni imagination dGPU. Erre legnagyobb esély mégiscsak az őket használó Apple-től lenne. És az előzőekben elmondottak miatt mégsem.

Ugye azt tudjuk, hogy a dGPU nem a.gamerek kedvvéért jön létre, hanem a pro, felhős és AI szolgáltatásokért. Tehát attól várható bármi, aki ebben utazik. Az Apple akkor kínálgat dGPU-t is talán, ha a szerverparkját is elkezdik saját hardverrel feltölteni ide értve gpukat, ha egyáltalán ilyenre szükségük van kártya formájában.

Szóbajöhetne még az amazon.

És persze szerintem Kínából jöhet még ilyesmi. Nekik van saját 14nm-es gyártásuk is. Persze ott is elsősorban AI/compute selejtjeként.

Hát, igazából nincs sok esélye annak, hogy új szereplők rázzák helyre a versenyt. Talán akkor, ha a chiphiány megszűnik, beesnek a wafer árak, de a gpu árak nem.

De hát ez a beesnek a wafer árak olyan, hogy majd ha piros hó esik. -

killbull

aktív tag

válasz

KillerKollar

#55506

üzenetére

KillerKollar

#55506

üzenetére

Egy érdekes hír válaszként, nem tudom mennyire lehet komolyan venni!

[Intel could make NVIDIA GPUs (in case of emergency)]

Pont ezért nem érdekel már az AMD mit csinál, másik oldalon ugyan abban az ársávban akár 2+ FAJTA termék vár mindig, míg az AMD nél kapsz 1 et és mehetsz a dolgodra tetszik vagy sem, ezt az AMD sz rul csinálja.

-

Televan74

nagyúr

válasz

KillerKollar

#55506

üzenetére

KillerKollar

#55506

üzenetére

A gyártók nagyon szépen elkényelmesedtek a hiány okozta magas áraktól. Nem fogják sokkal lejjebb adni.

A következő generációra szerintem lehet mondani a középre egy 160.000 -190.000 Ft körüli árat. És a next gen konzolokat sem fogjuk megúszni 250.000 Ft alatt. -

Alogonomus

őstag

válasz

KillerKollar

#55506

üzenetére

KillerKollar

#55506

üzenetére

A csúcskivitelek mindig is drágák voltak. Ezért is fogalmazott úgy, hogy az AMD csak átveszi a Titan helyét és árazását a rangsorban. A Titan már korábban is 2500 dollár volt.

Egy csúcsot jelentő sportkocsi, vagy luxuslimuzin is bőven 100 millió forint fölött van, de az igazán elrugaszkodott példányok közel milliárd forintos tételek. Ennek ellenére bőven lehet találni általános használathoz tizenpár milló forintért észszerű igények esetén kompromisszummentes élményautót.

Az RDNA3-nál az lesz a kérdés, hogy egy UE5 szintű látványvilághoz és legalább 100 fps-hez milyen felbontás mellé milyen szintű kártya kell majd. Egy közepesnek számító RDNA2 kártya is elég jelenleg szinte maximális grafikai beállítások mellett a 1440p 144fps játékélményhez. A pletykált csúcs RDNA3-as kártya a csúcs RDNA2-es kártya teljesítményének duplájával (triplájával?) a jelenlegi játékokban már valószínűleg raytracing mellett is maximum 4k 144fps esetén lenne pár esetben gondban. Amennyiben egy majdani közepes RDNA3 kártya a jelenlegi 600-700 dolláros csúcskategória áráért hozza a jelenlegi 1000-1500 dolláros csúcskategória teljesítményét, akkor nagy gond nem lesz. A csúcskategória pedig mindig is az extrém árakról és extrém rossz perf/$ mutatókról szólt szólt, de extrém teljesítményt nyújt. -

Yutani

nagyúr

válasz

KillerKollar

#55506

üzenetére

KillerKollar

#55506

üzenetére

Csúnya jövő elé nézünk.

-

GeryFlash

veterán

válasz

KillerKollar

#55469

üzenetére

KillerKollar

#55469

üzenetére

A Series S kiadasa korubelul haborus buncselekmennyel ert fel. Kiadtak egy vagott verziot hogy a Sonyt belekergessek egy masszivan veszteseges kiadasba, szerencsere a Sony volt annyira igenyes hogy o nem vagta meg, csak a bluray lejatszot vette ki, de emiatt a Digital Only kiadas masszivan veszteseges (lenne, ha lenne, de tippre nagyon kis szamban gyartanak, ugyis viszik a sima kiadast es azon kisebb a buko).

Szerintem (remelem) a jovoben ettol fuggetlenul nem lesz problema, abban is gyors SSD van, a tobbit meg majd lehet butitassal kezelni. Ami megy majd PS5 pro-n az majd ott 360/480p-rol felskalazott (FSR) 720/1080-n fog menni + effektekbol/szurokbol is visszavesznek + agressziv VRR. Kivancsi lennek egyebkent hogy mik az eladasi aranyok a ket konzol kiadasa kozott (PS5 vs digital only illetve X es S kozott), tippre azert kevesebb olyan takejozatlan ember van aki ne hallott volna arrol hogy a S-t tilos megvenni.

Ettol fuggetlenul abban igazad van, hogy a nativ felbontasnak kisebb a jelentossege es igen, 8K tv elterjedese az 3-4 even belul nem igen lesz meg. Szoval jogos, benne van h megse lesz Pro.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#55442

üzenetére

KillerKollar

#55442

üzenetére

Valamennyit tényleg segít, hogy integrálva van/lesz a GDK-ba, de ha nem lenne, akkor nem ettől szúrnák tökön magukat a fejlesztők, mert eleve GPUOpen a cucc, tehát csak portolni kell, ami ekkora projekteknél minimális tétel a kasszának. Szóval ez nagyobbrészt marketing, annak egyébként elég ügyes.

Azt nézd amúgy, hogy ezeknél az effekteknél a nehéz rész a megoldás kigondolása a problémára. Ha az megvan, akkor onnan már egyszerűbb azt implementálni. A GPUOpen sem olyan dolog, ami csak AMD ötleteket használ, hanem vannak benne bizony nagyon sok régebben publikált ötletek is, csak újragondolva.

Például a CACAO alapjaiban az Intel algoritmusa. Az AMD csak fogta az ötletet és átdolgozta úgy, hogy magas minőségű SSAO megoldássá váljon, mert az Intel megoldása egyébként rohadt gyors volt, csak komolyabb dedikált GPU hiányában sose törődtek azzal, hogy jó minőségű legyen az eredmény. Ugyanígy az SSSR sem AMD találmány, hanem egy Frostbite által használt algoritmus ráncfelvarrása. Igazából a Parallel Sort is egy szimpla Radix Sort algoritmus, csak át van rakva SM6.0-ba, így ez most az elérhető leggyorsabb. Ezért van az, hogy a Microsoft sem rakta be a GDK-ba az összes FidelityFX effektet. Csak az kell nekik, amelyek igazán hasznosak, mert például Radix Sort kódot azért bárki tud írni (merik remélni![;]](//cdn.rios.hu/dl/s/v1.gif) ). Talán nem olyan gyorsat, mint az AMD, de itt mikromásodperces előnyről beszélünk.

). Talán nem olyan gyorsat, mint az AMD, de itt mikromásodperces előnyről beszélünk. -

Abu85

HÁZIGAZDA

válasz

KillerKollar

#55440

üzenetére

KillerKollar

#55440

üzenetére

-

GeryFlash

veterán

válasz

KillerKollar

#55428

üzenetére

KillerKollar

#55428

üzenetére

Reméljük nem úgy ahogy a geforceok is ,,tripláztak" TFLOPS-ban

-

Alogonomus

őstag

válasz

KillerKollar

#55152

üzenetére

KillerKollar

#55152

üzenetére

"Ne a 3080-at hasonlísd össze a 2080-al"

Azért a 3080 vs. 2080 szituációt idéztem, mert azt maga az Nvidia állította a saját sajtóanyagában. És arra utaltam vele, hogy még ha igaz is lesz egyes speciális esetekben ez a 2,5-3x , az nem azt jelenti, hogy maga a kártya lesz annyival erősebb.

"a 3090-et a 2080 Ti-vel vagy még inkább a Titán RTX-el"

Ami a 3080 vs. 2080 szitációban előjött azért, mert a mínusz 2 GB VRAM miatt az egyiknek már "swapelnie" kellett, az előjönne a 3080 vs. 2080 Ti esetén is, ha 11 GB-nál többet igényelne a beállítás. A Titan RTX sem azért lenne így erős, mert több aktív SM van rajta, hanem mert az eleve szélesebb memóriabuszra még dupla kapacitású memóriamodulokat is tettek, így nem lenne memóriaelőnyben a 3090.

Azért is nem a Titan RTX vs. 3090 összehasonlítással reklámoztak, mert a 280 wattos RTX Titan helyett a 350 wattos 3090 a perf/watt terén nem hozott nagy előrelépés. 126% teljesítmény 125% fogyasztás mellett."a sima 2070-et még épphogy verte"

A simát mondjuk már induláskor is abszolút verte, 2020 közepétől pedig a 2070 Superrel is egálban volt.

Abszolút csúcskategóriában valóban nem volt AMD kártya, de a középkategóriás kártyák esetén a vágatlan 5700 XT és a vágatlan 6700 XT között például meglett a 30% nyers erő különbség, miközben a fogyasztás sem nőtt, pedig még az RT is belekerült. És persze az a 30% is úgy jön ki, hogy az 5700 XT-n kipörögte magát a ventilátor a maximumig, míg a 6700 XT-n az AMD bekorlátozása miatt félteljesítményen megy csak a ventilátor.

Az RDNA3 már kisebb csíkszélességgel is jön, plusz az Nvidiának "köszönhetően" a fogyasztásban sem kell már annyira takarékosra belőni. -

Abu85

HÁZIGAZDA

válasz

KillerKollar

#55160

üzenetére

KillerKollar

#55160

üzenetére

Csak jelzem, hogy az Ubisoft sebességnövelésre használja a ray-tracinget. Tehát az egyes RT eljárások aktiválásától pont, hogy nagyobb lesz náluk az fps. Ez is benne lehet egyébként az eredményekben, hogy az Ubi elsődlegesen onnan közelít, hogy mit lehet gyorsabban megcsinálni RT-vel, amivel a hagyományos raszterizálás túl lassú.

-

válasz

KillerKollar

#55146

üzenetére

KillerKollar

#55146

üzenetére

Természetesen ezt pletykaként kezelni .Ezek architektúrák, nem feltétlenül geforce és gamer szegmensre vonatkoznak hanem lehetnek professzionális architektek is. Nem tudjuk melyik architektúra mit jelöl.

De eddig kopite amit leakelt az nagyjából bejött. Nehéz megmondania fenti számok mire vonatkoznak és mivel ő erősen nvidia leaker ezért azt gondolom az AMD-s számokat is az Nvidiától veszi, akik így terveznek.

Az mellett ezek szerintem szigorúan vett TFLOPS számok azt gondolom, nem játékbeli teljesítmények ,ami viszont MCM dizájnnal nagy növekedést eredményezhet megfelelő sávszél mellett. Erre( is) van például szükség a dedikált RT hardverek elhagyására. -

Alogonomus

őstag

válasz

KillerKollar

#55146

üzenetére

KillerKollar

#55146

üzenetére

A 2,5-3x teljesítményugrás nyilván csak pár speciális esetben lehet majd igaz, ahogy az "RTX 3080 dupla olyan erős, mint az RTX 2080" állítás is csak a Doom Eternal 8 GB VRAM fölött, de 10 GB VRAM alatt igénylő játékbeállítása esetén volt meg néhány esetben, míg általánosságban az a 200% inkább a Tomshardware listájának megfelelően 150% lett a játékokban.

Na ez a top RDNA3 is adott esetben hozhatja majd egy RX 6900 XT teljesítményének 250-300%-át egy speciálisan az RDNA3-ra programozott helyzetben, nagyon eleresztett fogyasztással, 8 csatornás DDR5 memóriákra támaszkodó és továbbfejlesztett SAM segítségével, sőt talán némi driverrel megtámogatott CPU előfeldolgozással is megtámogatva. Szóval ez a 2,5-3x ugyanúgy nyilván a best case lehet majd, úgy pedig nem sokkal elképzelhetetlenebb annál, mint amit az AMD hozott ebben generációban. -

paprobert

őstag

válasz

KillerKollar

#55146

üzenetére

KillerKollar

#55146

üzenetére

A többivel nagyjából egyetértek. Ennyi feldolgozónál csökkennie kell az órajelnek, az adatot messzebbre kell vinni, azaz nő a fogyasztás. + MCM veszteség.

Szóval vannak hátrányok, de olcsó node-on a reticle limit áthidalására, illetve csúcs node-on apró chipekkel spórolásra ez a megoldás.

-

Petykemano

veterán

válasz

KillerKollar

#55146

üzenetére

KillerKollar

#55146

üzenetére

A számokat a teljesítmény növekedésére vonatkozólag nyilván 8K és/vagy 4K+RT kell értelmezni. Így a skálázódási probléma nagyjából kihúzható.

Az AMD és az NV is Gyártástechnológiát vált, az azért sokmindenre lehetőséget ad. Szerintem nem irreálisak a számok, csak nem a teljes vonalra kel értelmezni.

De ne csüggedjünk, mert azért mindenkinek jut majd valami emelkedés:

Aki 8K+RT módban játszik, és ki tud perkálni $1000-2000-t annak lesz 2-2.5x gyorsulás.

Aki 1080p-1440p játszik, annak meg 2-2.5x drágulás jut. -

paprobert

őstag

válasz

KillerKollar

#55146

üzenetére

KillerKollar

#55146

üzenetére

Az azért nem elhanyagolható különbség, hogy egy CPU latency érzékeny, míg egy GPU nem. Az utóbbi nagyobb mozgásteret ad az interconnect-nek.

Negatív tényező viszont, hogy nem 60(desktop) és nem 200(szerver)GB/s tempót kellene szétosztani a lapkák között, mint ahogy az AMD-nél láttuk, hanem egy CPU-hoz képest 4-10x sebességet.

Tekintve hogy az Epyc 80W-ot elhasznál erre a TDP-ből, van mérnöki kihívás.

-

killbull

aktív tag

válasz

KillerKollar

#54907

üzenetére

KillerKollar

#54907

üzenetére

Csak az RX 5500XT 4GB szenved tőle.

Nálam azon van a hangsúly hogy magát a slotot szeretném úgy használni hogy nincs korlátolva. Meg még pár apróság hogy volt egy időszak kb 2 hét amikor csontra fagyott állandóan a gépem a driverek miatt. AMD nél meg semmi olyan nincs ami érdekelne, a játékok többsége nem AMD nek kedvez.

-

killbull

aktív tag

válasz

KillerKollar

#54905

üzenetére

KillerKollar

#54905

üzenetére

-

Z_A_P

addikt

válasz

KillerKollar

#53746

üzenetére

KillerKollar

#53746

üzenetére

Ok, de te azt irtad low sem eleg, en arra irtam.

-

Busterftw

nagyúr

válasz

KillerKollar

#53741

üzenetére

KillerKollar

#53741

üzenetére

1440p 60fps-t is irtam, illetve minden a ketto kozott.

Egy 3060ti-vel siman meglesz 80-90-100-120 fps jatektol fuggoen tobb ev mulva is high beallitas.

De eleve a gtx 1060 szint az atlag a piacon, szoval a 1080p 60-144fps meg alap lesz.

Az emberek most kezdtek elindulni tomegesen a 1440p 60hz iranyaba.Azert irtam, hogy tul van reagalva. Nyilvan nem az 5-6 evente megjeleno optimalizalatlan aktualis csucs fos jatek a merce, ahova a 3090 is keves. Retegigeny.

-

arn

félisten

válasz

KillerKollar

#53439

üzenetére

KillerKollar

#53439

üzenetére

Csak egy pelda, de tuti lesz meg, ha mashogy nem majd az amd rarepul erre a hianyossagra nehany cimnel.

-

Busterftw

nagyúr

válasz

KillerKollar

#53310

üzenetére

KillerKollar

#53310

üzenetére

Hagyd, mar 50x el lett neki mondva.

Mar a 2080 8GB es a RadeonVII 16GB kartyaknal is voltak ilyen jatekok, persze hogy tobbet foglalt ha volt mibol, az mas kerdes hogy nem hasznalt annyit, es 8GB-al a 2080 gyorsabb volt mint a RadeonVII.Egyik nap a tobb vram = tobb fps a tema, majd masnap a magasabb orajel = tobb fps.

Volt erre egy jo szo itt a topikban valakitol, "fanatik"?

-

Alogonomus

őstag

válasz

KillerKollar

#52879

üzenetére

KillerKollar

#52879

üzenetére

Ampere refresh nagyjából csak idő és pénzpazarlás lenne szerintem.

Tekintve, hogy FHD és 1440p mellett - még optimalizálatlan driverrel - stock kialakítású kártyákat nézve is a sima 6800 250 wattból csipkedi alulról a 330 wattos 3080-at, a 300 wattos 6800 XT pedig a 350 wattos 3090-et szorongatja, így jó eséllyel a szintén 300 wattos 6900 XT már 4K mellett is legalább hozza majd a 3090 teljesítményét. Ezek pedig még csak a referenciakártyák az RDNA2 vonalról.

Az Ampere kártyák alig tuningolhatóak, 140 százalékos fogyasztással is csak kicsit 110 százalék fölé húzható a teljesítményük, miközben az eddigi RDNA2 kártyák teljesítménye szépen nőtt a fogyasztás emelésével, pedig ezek még csak referenciahűtéssel rendelkeztek. A most szerdán érkező valamennyire tuningolt RDNA2 kártyák várhatóan le is előzik az eddig szorongatott ellenfelüket, és az igazán megvadított 6800-as kártyák valószínűleg még nem is érkeznek novemberben.

Az Ampere valószínűleg architekturális korlátok miatt nem tuningolható, amin egy refresh sem segítene. Előnyösebb cost/frame érdekében olcsósított kártyaként csak még gyengébbekké válnának, több/gyorsabb memóriával tuningolt verzióban pedig csak még inkább elszállna a fogyasztásuk.Egyedül talán a 12 GB-os 3080 Ti lehetne jó út, ha a 3090 memóriabuszával kiadnak egy - a mínusz 12 GB GDDR6X miatt - 30-40 wattal takarékosabb kártyát. Akkor talán lehetne egy bő 300 wattos kártyájuk, amivel a custom 6800 XT ellen is felvehetnék a versenyt.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#52879

üzenetére

KillerKollar

#52879

üzenetére

HA átviszik a Samsungról a TSMC 7 nm-re, akkor az olyan 2021 legvége leghamarabb. A TSMC nem része a Common Platformnak, onnan komplett áttervezés kell, ha valaki elvisz valamit a Samsungtól. Még a GlobalFoundries-hez is háromnegyed évet mondtak portolásra, és az arab bérgyártó része volt a Common Platformnak, tehát egy rakás ponton portolható a dizájn.

Én elhiszem, hogy ezt a bérgyártók közötti ugrálást egyszerűen képzeli el a média, de közel sem ilyen egyszerű. Jelentős erőforrást kell az ilyen portolásokba fektetni, ez nagyrészt az új generációtól lesz elvéve, tehát ha átviszik a gaming Ampere-t TSMC-hez, akkor az 5 nm-es fejlesztéseik kapásból csúsznak fél évet, stb. -

Skyhunter

őstag

válasz

KillerKollar

#52300

üzenetére

KillerKollar

#52300

üzenetére

Nekem most i5-8600k van (z370-ben). A monyó 3440*1440, 100 Hz-es. 3080 vagy 6800XT a cél. Játékok : WoW, Ultra modded Skyrim, BF5, Cold War. A Bf5 a jelenlegi "sima" 2070-el is eldöcög "high"-on 80-90 fps-el. Bajban leszek egy 3080/6800XT mellett a 8600k.-val? Mi lenne a jó alternatíva? 9700k vagy 9900k-t beletenni a z370-be? üdv

-

awexco

őstag

válasz

KillerKollar

#52278

üzenetére

KillerKollar

#52278

üzenetére

Most mit mondanak ?

-

Z10N

veterán

válasz

KillerKollar

#52267

üzenetére

KillerKollar

#52267

üzenetére

https://prohardver.hu/tema/amd_talalgatos_topik_2/hsz_52203-52203.html

-

Mumee

őstag

válasz

KillerKollar

#52278

üzenetére

KillerKollar

#52278

üzenetére

Így hogy a 3000-es Geforce-ok még mindig túlárazottak és főleg a 3080 nem is elérhető kellőképpen, nem csoda hiszen sokan rárepülnek majd azok közül is, akik eddig Nvidia-t vettek.

A hiány mértéke és üteme az érdekes inkább és a proshop jóvoltából nagyjából végig lehet majd követni. [link] -

Abu85

HÁZIGAZDA

válasz

KillerKollar

#52220

üzenetére

KillerKollar

#52220

üzenetére

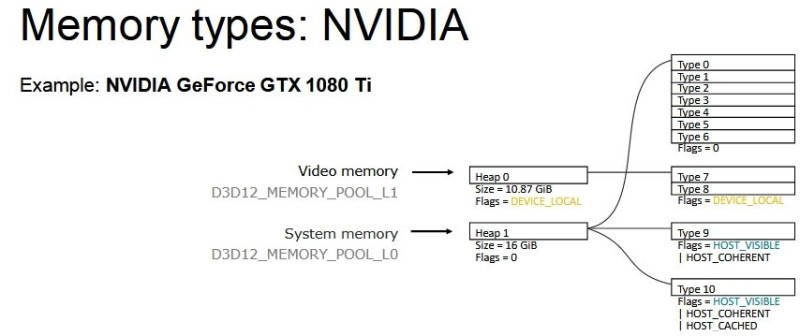

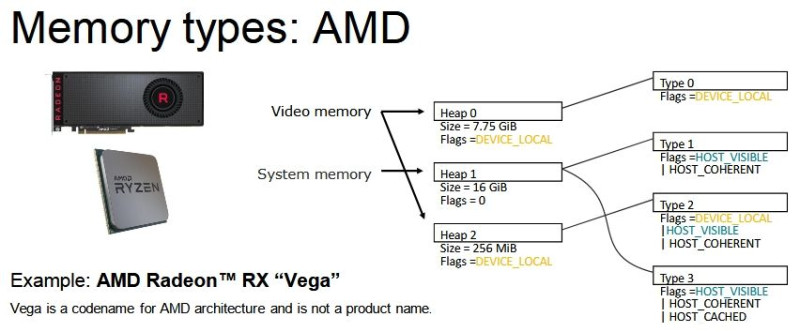

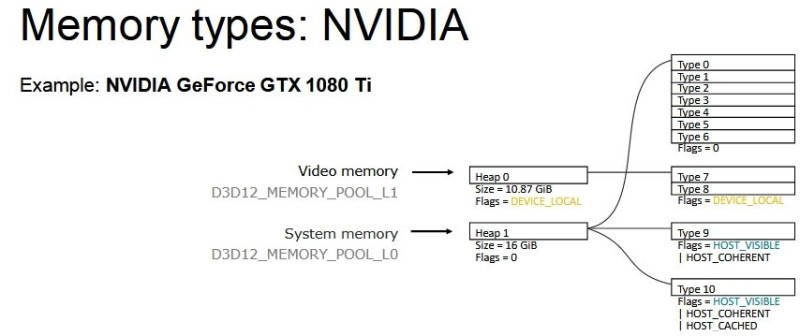

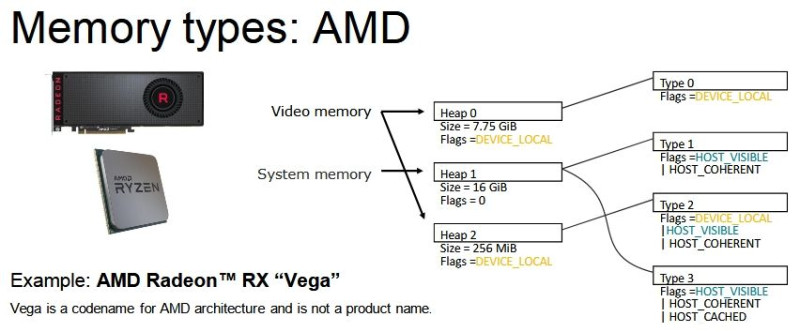

Annyit tud betölteni. A memóriaallokáció eleve egy kényes kérdés PC-n, a Godfall az AMD-nek a D3D12MA-ját használja. Ez némileg módosítva van, mert már van némi direkt támogatás is az SMA-ra, illetve az Infinity Cache-re is lehet ezzel optimalizálni. De nagyjából úgy működik, ahogy a publikus verzió, és ezen belül azért eléggé máshogy van kezel a Radeon és a GeForce. A D3D12MA felépítése nagyon húz az AMD rendszere felé. És ez nagyon lényeges, mert a heapek logikai kezelése tekintetében brutális különbség van az AMD és az NVIDIA struktúrája között. Régebben megosztottam, hogy miképp szegmentálnak a gyártók, itt vannak még egyszer a képek:

Az NVIDIA így szegmentál:

Míg az AMD így:

A hardver itt ki van emelve, de máig nem változott a logikai működés, csak a memóriák mennyisége.

Ezt a különbséget a program oldalán le kell kezelni, már az eléggé lényeges eltérés, hogy az AMD a non-BAR device_local heaphez egy type-ot társít, míg az NVIDIA kettőt. Effektéve az AMD oldalán a hardverre rakott VRAM egységes, míg az NVIDIA kettévágja, és a két részt külön type-ban kezelik le. És erre a program oldalán is így kell optimalizálni. Na most az AMD reálisan használhatóvá teszi a GeForce-hoz a D3D12MA-t, de nem optimalizálnak rá. Elvégre openszósz az egész, ha az NVIDIA számára fontos, hogy jól menjen, akkor majd írogatnak bele ők is kódokat. Az Intel már ezt teszi. De a gyári optimalizálás miatt az AMD jóval jobban ki tudja használni a VRAM-ot a D3D12MA-n keresztül.

Azt, hogy ezt egy adott programban hogyan érdemes lekezelni, alapvetően a lehetőségek határozzák meg. A régi DirectX 11-es dolgok itt már megszűntek. Nincs az, hogy szépen skálázódott az egész program, mert a driver mindent megoldott. Itt a program oldalán kell biztosítani a skálázást, és ha az egy hardverre hiányzik, akkor nem fog hatékonyan működni. Nincs köztes kernel driver, ami majd mindig megmondja a tutit, a programnak kell mindenről gondoskodnia. Nem véletlen, hogy az AMD a Vulkan és a DirectX 12-höz is külön middleware-t ad VMA és D3D12MA néven. Aránylag gyorsan felismerték, hogy a szabadság jó, de vannak hátrányai, mert innentől kezdve nincs mindent problémát megoldó, mindent megfelelően működőre varázsló kernel driver. A helyére csináltak middleware-eket, amik adnak a fejlesztőknek egy headert, ami párezer kódsort kínál arra, hogy ha nem is tökéletesen, de csettintésre azért működjön valahogy az alkalmazás, nagyjából olyan alapot adva, mint amit régen a kernel driver biztosított. De ezt maguknak csinálják, és nem az NVIDIA-nak, illetve az Intelnek. Ők is írhatnak kódokat ezekbe a middleware-ekbe, de ha nem teszik meg, akkor az AMD leszarja, nekik csak a Radeon fontos. Az Intel egyébként nagyon szépen kitömte már saját kódokkal a VMA-t, és a D3D12MA-ba is portolják ezeket a változásokat. Ők is felismerték, hogy ha nincs kernel driver, akkor legalább valami legyen, ami segít a fejlesztőknek.

A GeForce-okra jellemzően a fejlesztők szoktak specifikusan optimalizálni, de az közel sem olyan hatékony, mintha az NVIDIA csinálná meg, mert nem ismerik annyira a hardvereket. Ráadásul a fejlesztők feje fölött ott a kiadó, aki ostorral csapkodja őket, hogy ne ezzel törődjenek, hanem a játék minőségével, mert a textúrarészletességet lehet szabályozni on-the-fly is, és sokkal egyszerűbb ezzel élni, mint konkrétan optimalizálni. Idővel valószínűleg az NVIDIA is elkezdi majd saját kódokkal kitömni az AMD middleware-jeit, főleg úgy, hogy memóriában szegény VGA-kat hoztak, nekik ez kiemelten fontossá vált. Csak nagyon sok kapacitást leköt náluk a réjtrészing és a DLSS, és más dolgokra nem igazán koncentrálnak, mert az API eleve nem teszi lehetővé a kernel meghajtó oldalán az optimalizálást. Ennek az az oka, hogy nincs is kernel meghajtó az explicit API-kon, de ez nem jelenti azt, hogy nem lehet segíteni a fejlesztőket, erre bizonyíték, hogy az AMD és az Intel megtalálta ehhez az utat.Az NVIDIA egyébként hozzászokott ahhoz, hogy a program olyan amilyen, volt egy rakás erőforrásuk arra, hogy majd a driverből jóra varázsolják. Ilyen erőforrással senki más nem bírt. Viszont a DirectX 12 és a Vulkan kihúzta alóluk a szőnyeget. Innentől kezdve nem tudják miben jóra varázsolni a működést, ha a program nem lesz olyan jó. Effektíve elvesztették azt a piaci előnyüket, amiben nagyon-nagyon jók voltak, és nem is reagáltak időben arra, hogy a DirectX 12-ben és a Vulkánban miképpen kell nagyon-nagyon jónak lenni. Nem véletlen, hogy GeForce-on, erős proci mellett a DirectX 12-ről DirectX 11-re való visszaváltás sokszor okoz sebességnövekedést, míg a Radeonon ez pont fordítva van.

-

válasz

KillerKollar

#52213

üzenetére

KillerKollar

#52213

üzenetére

-

Mumee

őstag

válasz

KillerKollar

#52162

üzenetére

KillerKollar

#52162

üzenetére

Mint mondtam csak a hivatalos AMD diákból indultam ki.

Alapból a Warhol kapcsán már volt szó róla, hogy lehet nem is lesz végül.Én személy szerint inkább az alábbi infónak hiszek :

TSMC 5nm 2021 H2-ben már mass production és Zen4 illetve RDNA3 2022 H1-ben jöhet, vagy talán Q1. [link]

-

Raggie

őstag

válasz

KillerKollar

#52116

üzenetére

KillerKollar

#52116

üzenetére

Vártad volna ki az RX 6800XT-t és nem lenne problémád a kártyád árával és elavulásával...

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

TESCO-Zsömle

titán

válasz

KillerKollar

#52111

üzenetére

KillerKollar

#52111

üzenetére

"szerintem egy 700$-os "flagship" kártya ami a "csúcs" (legalábbis desktop gamer PC-kben) GA102-es lapkára épül és alig 10%-al lassabb az 1500$-os 3090-nél szerintem ki kell, hogy elégítse ezt az elvárást."

Erre az elvárásra térjünk vissza, mikor a "kielégítéshez" nem 1440p-ben meg 1080p-ben kell renderelni és onnan felskálázni 4K-ra...

Kezd ez az "Ultra" beállítás olyan lenni, mint usákoknál az iskolai eredmények... Nem elég jók a mutatók, hát csökkentjük a ponthatárokat.

Szerintem egy grafikára gyúró AAA játéknak pont arról kéne szólnia, hogy beletesznek mindent, ami technikailag lehetséges, optimalizálják amennyire lehet, aztán majd jön valami, ami képes is az összes effektet egyszerre kitolni.

Mint ahogy a 3090 se képes 8K-ba játékokat futtatni értelmes sebességgel. Eleve ha fél tucat játék van, aminél egyáltalán be lehet állítani akkora felbontást... -

válasz

KillerKollar

#52106

üzenetére

KillerKollar

#52106

üzenetére

Én értem mire akarsz kilyukadni, de az egész vita alapja az, hogy már megint túl van misztifikálva az AMD propaganda, amit ide Abu le szokott hozni. Még jó, hogy az ő forrásai azt mondják amit

A valóság meg ezzel szemben rendre máshogy nézett ki évek óta.

A valóság meg ezzel szemben rendre máshogy nézett ki évek óta.

A helyzet valószínűleg az, hogy a 10GB VRAM évekig elég lesz mindenre. Mindenre ami nem AMD-s techdemo, és nem direkt azért és úgy fejlesztették, portolták. Az nvidia is csinált ilyet anno a földalatti felesleges tesszelálással crysisban. Nem ezeknek a játékoknak a mesterségesen felsrófolt igényéből kell kiindulni. És főleg nem a leszarom pénzhajhász fejlesztők és kiadók fos minőségű portjaiból. A DX12 sem azért kell, mert milyen jó, hanem hogy a fejlesztőknek még kevesebb munkát kelljen rakni a portba. Amiből ugye már többszáz világmegváltó teljesítményű, és grafikájú játék kéne legyen az AMD-s mantra szerint.

Mindig elő volt húzva a kalapból egy játék, ami az épp aktuális mantrát kellett alátámassza valahogy. A kutyát nem érdeklik ezek, de tesztelni muszáj velük, mert csak. Ennyi erővel az RDR2 is lehetne etalon, mert olyan hardver igénye van mint semmi másnak. Mert egy szar port. De mivel ezen a sok VRAM sem segít, az AMD persze hogy nem ezt lóbálja mindenkinek az arcába

Ugyanolyan hitkérdés van itt ebből csinálva, minthogy az AMD-nek valami csoda folytán nem lesz készlethiánya startkor Nem persze... most még megy a nagy arc, aztán mikor 1-2-10 hét múlva beüt a valóság, akkor mind csendben lesznek.

Nem persze... most még megy a nagy arc, aztán mikor 1-2-10 hét múlva beüt a valóság, akkor mind csendben lesznek.

Igen, az nvidia valszeg jönni fog jövőre super vagy ti kártyákkal, mint mindig is jött, amin valszeg több VRAM is lesz. Némelyiken. De nem azért, mert kell, hanem mert addigra már majd lehet, és ebbe az irányba IS előre tudnak lépni. De olcsók sem lesznek, az is biztos. -

TESCO-Zsömle

titán

válasz

KillerKollar

#52102

üzenetére

KillerKollar

#52102

üzenetére

"a PC-s változatnak azon a hardveren kell jól futnia ami a legtöbb PC-ben van"

Szerintem aláhúztam a lényeget. Jól kell futnia, nem pedig Ultra-n.

Crysis óta szerintem megszokott, hogy fullmax beállítások mellett a játékoknak legyen elvárása a tulajdonosok gépével szemben és ne a tulajdonosoknak a játékkal szemben. Ha valami megjelenéskor nem képes semmin fullmax beállításokkal futni, az nem szarul van optimalizálva, hanem jövőtálló. Szarul optimalizálva az van, ami minimumon sem fut semmin normálisan...

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#52106

üzenetére

KillerKollar

#52106

üzenetére

Olyan kevesen vették meg a hiány miatt, hogy nagy bajuk ebből nem lesz. Nem mellesleg nem kellett atomfizikusnak lenni hozzá, hogy a 10 GB bizony kövéske.

És most mit csináljon az NV? Ennyi memóriát tudnak tenni a VGA-ra. Ez attól sem változik meg, ha tudják, hogy kevés. Vagy kiadják így, vagy nem adnak ki semmit. A 20 GB nem opció, mert nincs 2 GB-os GDDR6X stack, 20 darab 1 GB-os GDDR6X memóriát pedig marha drága lenne felszerelni egy 700 dolláros termékre. Ha a mérnökök egyesével tökön szúrják magukat, akkor sem tudnak ezen változtatni. De meg fogják tenni a lépéseket, amint lehetőség lesz rá, például, amint lesz 2 GB-os GDDR6X. Addig csak szét tudják tenni a kezüket, hogy tudják, hogy nem jó, de semmit sem tehetnek ellene, nem az NVIDIA-n múlik.

#52107 CME : Nem, de a textúra az, aminek a minősége könnyen módosítható, így ezzel lehet skálázni a kevésebb memóriára.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#52100

üzenetére

KillerKollar

#52100

üzenetére

A marketing az lesz, hogy fél éves frissítés, még jobbak lettek a VGA-k. Amikor itt a frissebb sorozat, akkor olyan mindegy, hogy mi lesz a régivel.

Ez nem hiba, hanem kényszer. Bizonyos anno jónak tűnő döntések vezettek ide, amik most visszagondolva rosszabb döntésnek tűnnek. De ezt régen nem tudták ám, vagy a Micron korábban azt ígérte, hogy lesz 2 GB-os GDDR6X a startra, stb. Ezernyi oka lehet. Ha mondjuk lenne elég GDDR6X, és lenne 1 és 2 GB-os opció, akkor nem lenne itt semmi probléma. Lehet, hogy eredetileg így volt tervezve, csak közbejött valami, amit nem bír gyorsan megoldani a Micron és az NV. Ilyenek azért bőven előfordulnak a fejlesztés során.

A fejlesztők nem akarják az NV tulajokat hátrányba hozni, be lesz építve egy olyan textúrabeállítás, amivel menni fog a játék 10 GB-os VGA-n is. Mivel ez fix paraméter, így az indításkor simán lekérdezhető, hogy mennyi VRAM-ja van a VGA-nak, és a textúrarészletességet automatikusan berakja a megfelelő szintre. Nagyon egyszerűen kivitelezhető, az NV felmérése szerint a játékosok döntő többsége eleve be sem megy az options menübe, tehát különösebb bajt ez nem okoz, a játék beállítja a pont jó minőséget. Tehát jól fog futni, csak nem biztos, hogy maxon.

-

válasz

KillerKollar

#52102

üzenetére

KillerKollar

#52102

üzenetére

Es ki mondta, hogy nem fog jol futni

Ha nem fer bele a VRAM-ba az adott textura reszletesseg, szepen leskalazza a textura felbontast. Ennyi. -

válasz

KillerKollar

#52100

üzenetére

KillerKollar

#52100

üzenetére

az NV a piacvezető így a legtöbb játékot úgy fogják optimalizálni, hogy az Ő termékeiken is jól fusson max grafikán is.

Jaja, foleg a konzol portokat...lol

![;]](//cdn.rios.hu/dl/s/v1.gif)

Veletlenul nem 3080-ad van?

-

válasz

KillerKollar

#52097

üzenetére

KillerKollar

#52097

üzenetére

Ha igaz, hogy nincs elég GDDR6X, akkor kényszerből van 10GB a kártyán, nem pedig készületlenül érte őket az új konzolgeneráció. Ehhez jön még, hogy utolsó pillanatban a GA102-nek kellett beugrania a GA104 helyére, mert lemaradtak volna.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#52097

üzenetére

KillerKollar

#52097

üzenetére

Biztosan tudták, csak a GDDR6X egészen más árszinten mozog, mint a GDDR6. Tehát nekik meg volt kötve a kezük. Ugye a GDDR6 esetében van 2 GB-os stack, tehát egy 16 GB-os kártyához elég nyolcat használni. GDDR6X-ből csak 1 GB-os stack van, ergo dupla memóriához dupla mennyiségű chip is kell. Bármit is látnak, a dolgot megölte az, hogy az árba ennyi chip nem fér bele. Veszteséggel meg egyik cég sem kezdi el árulni az új generációt. Az túl nagy hülyeség lenne.

Az NV-nek az a biztonságos út, ha megvárják, amíg a Micronnak kész lesz a 2 GB-os GDDR6X stackje. Ez februárra reális, legalábbis a Micron ekkora ígérte korábban. Tavasszal tehát már lehet hozni frissítéseket a kiadott GeForce-okra, dupla memóriával. És tavaszig tényleg nem sok olyan játék lesz, ahol a 10 GB-os kapacitás drámaian kevés lenne. Tavasztól kezd el ez a dolog bedurvulni, de akkorra meg bőven lesznek nagyobb VRAM-mal rendelkező GeForce-ok.

Igen a 8 GB is kevés lehet, nem véletlen, hogy az egyel kisebb Navit 12 GB-tal tervezi az AMD. De nekik sokkal könnyebb ám mozogni a GDDR6 és az infinity cache miatt. Az NV-nek nincs infinity cache számukra nehézkesebb a mozgás most. Ezen kár törniük magukat, mert változtatni nem tudnak rajta, a fő cél, hogy tavasszal legyen egy frissítés.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#52048

üzenetére

KillerKollar

#52048

üzenetére

Akörül igen.

Nézd, a memória olcsóbb kártyára is rárakható. Lehetne 16 GB-os 3070-et is csinálni, csak meg kell egyezni a Hynixszel, hogy szállítson memóriát, mert az AMD felvásárolta a Samsung 2 GB-os stackjeit, azokat rakják a kisebb kártyákra is. De a Hynix is gyárt ilyeneket, sőt, a Micron is.

A VRAM használatában annak van szerepe, hogy miképpen működik a leképező, milyen minőségűek a modellek, illetve milyen minőségű textúrákat szállítanak a fejlesztők. Teljesen lényegtelen, hogy az AMD vagy az NV szponzorálja a címet. A Godfall azért igényel sok VRAM-ot, mert 4096x4096 texeles textúrákat használ majdnem mindenre. Így állították be a PS5-re a játékot. Természetesen meg lehetne csinálni, hogy PC-re csak 2048x2048 texeles felbontásig hozzák át az egyes tartalmakon a textúraminőséget, és akkor 10 GB-ba beférne, de akkor meg az lenne a baj, hogy a konzolon jobb az elérhető minőség. Ráadásul a textúrarészletesség maximalizálása csak egy extra beállítás, nem érint senkit negatívan, mert ha nincs elég VRAM a kártyán, akkor lehet találni olyan beállítást, amivel bőven jól fut a játék. A VRAM használatát tehát nagyrészt az határozza meg, hogy mit hoznak át a fejlesztők a konzolról. Mivel az új konzolok a memóriaalrendszer szempontjából brutálisak azzal a marha gyors SSD-vel, így mostantól igencsak el lehet szállni ezeken a gépeken a textúrarészletességgel, egyszerűen csak egy virtuális textúrázásra szabott rendszer kell hozzá, ami pont van az Unreal Engine 4-ben.

Egyébként pont az AMD mondta a Radeonokra vonatkozó deep dive előadásokon, hogy nem véletlenül raktak mindhárom kártyára 16 GB-ot. Még a legkisebbre is. Eredetileg úgy számolták, hogy 12 GB elég lesz a következő egy évre, de aztán látták a tavaszig megjelenő konzolos címeket, és a mostani szimulációik alapján még a 16 GB-hoz is komolyan optimalizálni kell a PC-s portot. Szóval úgy döntöttek, hogy 16 GB-tal hozzák mindhárom cuccot. Ez van. Bivaly lett a konzolok memóriaalrendszere, és erre úgy rárepültek a fejlesztők, mint gyöngytyúk a takonyra. Viszont ezt egyelőre, megfelelő API-k hiányában csak nyers memóriakapacitással lehet helyettesíteni PC-n. Hosszabb távon jobb lesz a helyzet, de már készül olyan cím is konzolra, ami 16kx16k texeles textúrákat használ, amihez 16 GB VRAM is édeskevés lenne, oda majd kellenek az újítások, amiket a Microsoft tervez 2022-től a PC-be. De ez még messzebb van, egyelőre az elkövetkező egy év jelent problémát.

#52049 arn : A konzolon gyakorlatilag az SSD, illetve az alkalmazott technikai háttér miatt eléggé el lehet szállni a memóriahasználattal. Virtuális textúrázás kell hozzá, és olyan szintre küldheted a részletességet, amilyet sosem alkalmaztak még PC-n sem. Ennek az oka, hogy az SSD elég tempós ahhoz, hogy a memóriát gyorsítótárként használhasd. És igen. Pont ezért pakoltak 16 GB VRAM-ot a legkisebb Radeonra is, mert ezt a működést csak nyers kapacitással lehet PC-n ellensúlyozni, tehát ha nem korlátozzák a PC-s portoknál a minőséget, és áthozzák mindazt a tartalmat, amit konzolra szállítanak, akkor az bizony durván memóriagyilkos lesz. És ezt nem lehet menedzselni. Vagy ott van az adat, vagy nincs, utóbbi esetben jönnek az akadások.

A memóriahasználat gyártótól független. Azt nem lehet kihasználni, maximum győzködni a fejlesztőket, hogy van ám 16 GB-os VGA, nyugodtan hozhatják PC-re a konzol textúraminőségét. De nem hiszem, hogy nagyon győzködni kell erről őket, mert ez csak egy beállítás PC-n. Akár külön textúracsomaggal is lehet szállítani. Senkit nem ér hátrány, ha van egy extra beállítási szint.

-

Mumee

őstag

válasz

KillerKollar

#52048

üzenetére

KillerKollar

#52048

üzenetére

MSRP meg a jelenlegi NV generációnál csak marketing immáron több oldalról is megerősítve.

Pl. Tech Jesus által : [link]Szóval eleve nincs $700 3080 és $500 3070 sem.

(Első hónapban/2 hétben Nvidia bónuszt ad az eladott kártyák után a pletykák szerint az AIB-oknak $50-$100, ezért a kezdőár MSRP közeli csalinak )

)Tehát egy valós $1000 20GB 3080ti még korrekt árnak is nevezhető.

-

arn

félisten

válasz

KillerKollar

#51670

üzenetére

KillerKollar

#51670

üzenetére

nem letezik olyan, hogy nvidia raytrace... dxr 1.0 volt eddig, most meg 1.1 van. mindketto a ms termeke.

az amd engedelyezi a dxr 1.0at?

-

Malibutomi

nagyúr

válasz

KillerKollar

#51674

üzenetére

KillerKollar

#51674

üzenetére

Ez mondjuk logikusan hangzott akkor hisz sem a konzolok sem az AMD kartyak nem voltak tervezve az eredeti novemberi CP launchra.

Plusz ugy enem art nemi optimizalas is. -

Alogonomus

őstag

válasz

KillerKollar

#51674

üzenetére

KillerKollar

#51674

üzenetére

"so only PCs with the latest GeForce cards will experience the glory of simulated light in Cyberpunk’s neon-infused world"

Hát ez óriási öngól lenne a CD Projekt Red részéről, bár gondolom szerződésben vállalták.

Mondjuk nem egyértelmű, hogy a "latest" valóban az Ampere kártyákat jelöli-e. -

Laja333

őstag

válasz

KillerKollar

#51674

üzenetére

KillerKollar

#51674

üzenetére

Azzal nincs gond ha november végén jön hozzá a patch, mert maga a játék se jelenik meg december előtt.

-

Jacek

veterán

válasz

KillerKollar

#51674

üzenetére

KillerKollar

#51674

üzenetére

Vagy halasztjak meg egy ket honapot

-

Laja333

őstag

válasz

KillerKollar

#51670

üzenetére

KillerKollar

#51670

üzenetére

DXR-t használ, miért csak NV kártyán menne?

-

awexco

őstag

válasz

KillerKollar

#51343

üzenetére

KillerKollar

#51343

üzenetére

A miértet értem , de olyan az egész mint ha kevesebb benzin kellenne egy 24h futamra mint egy 10 körösre

Szal Vicces

-

X2N

őstag

válasz

KillerKollar

#51343

üzenetére

KillerKollar

#51343

üzenetére

Kivétel persze amikor nem, és a 3080 se proci bottleneckes 1080p-ben mert gyorsul még 720p-n is.

-

awexco

őstag

válasz

KillerKollar

#51295

üzenetére

KillerKollar

#51295

üzenetére

-

keIdor

titán

válasz

KillerKollar

#51031

üzenetére

KillerKollar

#51031

üzenetére

A 6900XT válogatott, jobban sikerült GPU-t sejtet, ami biztos limitált példányszámban várható, tehát némi felár indokolt.

Ráadásul az RTX-3090 ellen megy, az meg +50%-al drágább, szerintem a 6900XT ára rendben van.

Ahogy a 6800XT-é is.A 6800 túl drága, de ugyanez megfigyelhető a Ryzen 5600X és 5800X-nél is, azok is drágák.

Terelik a népet a drágábbra, most már megtehetik. -

Abu85

HÁZIGAZDA

válasz

KillerKollar

#51031

üzenetére

KillerKollar

#51031

üzenetére

Inkább a 6800 túl drága.

A 6900 XT ellesz 999-ért, mert a teljesítményen túl e-péniszt is ad. Azokra hajtanak, akiknek ez megér 350 dollárt. Találni fognak nem kevés ilyen embert.

A 6800 viszont túl közel van a 6800 XT-hez.

-

devast

addikt

válasz

KillerKollar

#51031

üzenetére

KillerKollar

#51031

üzenetére

Egy szó mint száz, a 6900XT nem éri meg a +350$t a 6800XT-hez képest, a 6800XT viszont BŐVEN megéri azt a +80 dodót a 6800-hoz képest.

Pontosan. Ezt páran már mondták, hogy a sima 6800nak nem jó az ár/érték aránya. A 6900xt-nek sem. Persze a családon belül. -

Televan74

nagyúr

válasz

KillerKollar

#50945

üzenetére

KillerKollar

#50945

üzenetére

Pont azért van. 6900XT+5950X+ Hard Core Ultra baszó X570 lap!

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- One otthoni szolgáltatások (TV, internet, telefon)

- MIUI / HyperOS topik

- Milyen okostelefont vegyek?

- Lopakodva befutott a Radeon RX 9060

- AliExpress tapasztalatok

- Kerékpárosok, bringások ide!

- Építő/felújító topik

- Szívós, szép és kitartó az új OnePlus óra

- Először égett le egy újságnál a GeForce RTX 5090

- Kormányok / autós szimulátorok topikja

- További aktív témák...

- Samsung Galaxy A12 64GB Kártyafüggetlen 1 év Garanciával

- DDR5 16GB 8GB 32GB 4800MHz 5600MHz RAM Több db

- Akciós Windows 10 pro + Office 2019 professional plus csomag AZONNALI SZÁLLÍTÁS

- AKCIÓ! Apple MacBook Pro 13 2022 M2 8GB 256GB SSD garanciával hibátlan működéssel

- iPhone 15 Pro 128GB Black Titanium Új eredeti Apple akkuval, USA model

Állásajánlatok

Cég: FOTC

Város: Budapest

Persze, pl. egy rossz porttal könnyen lehet gyártani erőforrás zabáló, de cserébe rosszul futó címet, ez nyilván nem az, amire az előbbi hsz-emben gondoltam.

Persze, pl. egy rossz porttal könnyen lehet gyártani erőforrás zabáló, de cserébe rosszul futó címet, ez nyilván nem az, amire az előbbi hsz-emben gondoltam.

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Es ezek meg velunk marad 5 evet, teljesen erthetetlen szamomra hova a 3090-hez kepest 2-2,5szer nagyobb teljesitmeny. Legyen +50%, de a TDP menjen vissza egy kevesbe elborult tartomanyba.

Es ezek meg velunk marad 5 evet, teljesen erthetetlen szamomra hova a 3090-hez kepest 2-2,5szer nagyobb teljesitmeny. Legyen +50%, de a TDP menjen vissza egy kevesbe elborult tartomanyba.