Új hozzászólás Aktív témák

-

vader108

tag

válasz

#85552128

#22992

üzenetére

#85552128

#22992

üzenetére

Én is valószínűnek tartom ott a reflektor fényének megjelenését. Maga a reflektor állása, és világítási szöge is arra felé néz. Ebben az esetben csak egy grafikai glitch is lehet.... Illetve az éppen lövő csóka golyó iránya is arra mutat. Mi van akkor ha a jelenetben, ott kilőtték éppen az asztalt, és a fény ott hatol át?

Azért erre bemagyarázza Abu a feature-t, hogy ez mennyivel jobb, elég nagy baklövés lenne

-

Abu85

HÁZIGAZDA

válasz

#85552128

#22987

üzenetére

#85552128

#22987

üzenetére

Persze. A DX11 csak egy leképező a motor mögött. Eleve támogatta a motor. Tehát csak annyit kellett csinálni a Steam portnál, hogy az UWP API helyett a Win32 API-ra ültetik, na meg persze meg kellett kerülni azokat az eljárásokat a leképezőnél, amelyeket a DX11 nem támogat. Erre vannak gyártói kiterjesztések. A DX12 módot is képesek áthozni, ha a Steam megengedi az UWP API-s programok futtatását. Ezt biztos nem fogják Win32-re portolni, ha már annyira nem törődtek a Steam verzióval, hogy a két gyártó ugyanolyan minőségű képet állítson elő.

-

Abu85

HÁZIGAZDA

válasz

#85552128

#22984

üzenetére

#85552128

#22984

üzenetére

Teljesen mindegy a jelenet egy screen space effektnél, amit mellesleg DX12-en a GeForce jól megjelenít. Az, hogy másképp lő az ellen nem magyarázza az egyes árnyékok és fények hiányát.

Egy multi-engine-re tervezett programnál ez normális, hiszen rákényszeríted single-engine-re, amikor az egész motorstruktúrát nem erre írták. Mindkét gyártón eléggé ingadozik ez a paraméter. Akit zavar majd megy DX12-re. Ott jóval stabilabb, mert multi-engine a kód.

Nem tud a Steam UWP programot futtatni. A DX12 verzió pedig az UWP API-ra épül.

-

Abu85

HÁZIGAZDA

válasz

#85552128

#22981

üzenetére

#85552128

#22981

üzenetére

A videorögzítés nem csinál olyan különbséget, mint ami van a második képen, ahol van a faszi mögött a fedezékként használt asztal árnyékolásánál. Meg a felvétel nem tünteti el a GeForce-on a szék mögül a világítást.

(#22982) FragMaster: Fogalmam sincs, hogy mi a különbség. Így látszatra a DX12-es kódhoz a Radeon képe van közelebb. És DX12-ben ilyen a GeForce is. Valami a DX11 leképezőben van. Az NV esetleg más kódot futtat. Ez elképzelhető, egy DX12-höz kialakított játéknál. Lehet, hogy az NV-nek nem volt olyan kiterjesztése, amivel megoldható a DX12-es leképező portolása DX11-re, míg az AMD-nek volt. Lehet, hogy később csinálnak és akkor korrigálják, de az is lehet, hogy szarnak bele, akinek ez fontos majd megveszi a DX12-es verziót a Store-on.

-

Abu85

HÁZIGAZDA

válasz

#85552128

#22941

üzenetére

#85552128

#22941

üzenetére

Komoly? Kipakolták belőle a legerőforrásigényesebb számítást, és így produkálja ezeket a gyenge fps-eket? Akkor ez a DX11 mód vagy nincs kész, vagy nem optimalizáltak. Scaling nélkül legalább 50%-kal jobb fps-ekre lenne szükség, mert annyiba kerül kb. a scaling DX12 alatt.

-

Abu85

HÁZIGAZDA

válasz

#85552128

#22936

üzenetére

#85552128

#22936

üzenetére

Mit vártatok? A Quantum Break egyszerűen nagyon sokat számol. És DX11-ben is nagyon sokat fog számolni ahhoz, hogy előállítsa azt a képminőséget, amit kínál. Sőt, DX11-ben nincs aszinkron compute, amiből ez a játék simán nyer +15%-ot. Emellett nincs aszinkron DMA sem, ami miatt minden másolásnál le kell állítani a teljes feldolgozást. És az MSAA megoldásuk miatt ez négyszer fog bekövetkezni képkockánként.

-

Ren Hoek

veterán

válasz

#85552128

#22931

üzenetére

#85552128

#22931

üzenetére

"Azért kíváncsi leszek egy 480 vagy Fury X lesz e gyorsabb, főleg 1440p/4K-n

![;]](//cdn.rios.hu/dl/s/v1.gif) "

"Hát igen, erre én is... Papíron a 480 harmatgyenge a Fury X-hez képest, ahogy eddig bizonyított DX12-ben. Ha mesterségesen kihozzák győztesnek / Fury-t bebutítják, akkor az orbitális nagy saller lesz a Fury tulajoknak. (Már ha vannak még). Atomdrágán megvették HBM1 kísérleti nyúlként és még ki is veszik a kraftot alóla

-

imi123

őstag

válasz

#85552128

#22922

üzenetére

#85552128

#22922

üzenetére

Nem lesz itt sem gyorsulás sem extra effect.

Mióta hallhatjuk ezeket a süketeléseket.

Amikor meg bizonyítani kellene akkor mindig van magyarázat hogy miért nem jött el a megváltás.Ugyan olyan jól fog futni Nv és AMD-n is.

Persze majd nagyítóval megállított dzsatubés videón biztos meg lesz az az 1 pixel plusz.

-

Abu85

HÁZIGAZDA

válasz

#85552128

#22922

üzenetére

#85552128

#22922

üzenetére

Nem. Már megkapták a áruházak az utasításokat. A BF1 csak olyan konfigurációhoz és VGA-hoz reklámozható, amiben Polaris 10 van. Ezeket ugye most rakják össze a BF1 startjára, mert kell egy kis idő, hogy berendeljék az alkatrészeket és összeállítsanak egy rakás gépet. Más erősebb GPU-hoz egyáltalán nem reklámozható. Nem is fut le minden, amit a motorba beleraktak.

-

Abu85

HÁZIGAZDA

válasz

#85552128

#22912

üzenetére

#85552128

#22912

üzenetére

Polaris 10 mellé jön a BF1. Ezt választotta a DICE ajánlott kártyának. Raknak a programba olyan exkluzív eljárásokat, amelyeket sehol máshol nem lehet használni, csak és kizárólag Polarissal. Ez a többi GCN-re is igaz. A specifikus eljárások többsége bekapcsolható GCN-es Radeonon, de pár csak Polarison. Ha nem ilyen GPU-d van, akkor nem fut le a kód és visszavált egy szabványos eljárásra.

-

Abu85

HÁZIGAZDA

válasz

#85552128

#22860

üzenetére

#85552128

#22860

üzenetére

Attól függ, hogy kinek. Én nem várok rá, mert az AMD kiterjesztésekkel már megoldotta a problémát. Ellenben jó lenne, ha ezek gyártófüggetlenül működnének. Ez lenne a shader model 6.0 célja.

(#22861) mlinus: Van ezzel a porttal annyi probléma, hogy simán tudnak javítani rajta, de csodát ne várj. Az ilyen HT-s dolgokat simán lehet javítani. Anomáliának nem mondanám ma már. Eléggé dokumentálva vannak azok a problémák, amiket a HT-re optimalizálásnál figyelembe kell venni. Az MS-t ez csupán nem érdekelte.

-

Abu85

HÁZIGAZDA

válasz

#85552128

#22781

üzenetére

#85552128

#22781

üzenetére

A konvertált kód eleve meg van fosztva az optimalizálástól. Amíg mondjuk egy préselés az Xbox One-on két függvény, amire ráadásul direkt hardveres utasítás van, addig PC-n aktív lane-enként egy atomic. Az eredmény ugyanaz lesz, csak utóbbi legalább százszor lassabban fut. Ez GCN-en egy wave-re 64 atomicot jelent, ami erősen alert típusú kód, csak úgy jönnek a vörös jelzések a fejlesztőeszközökben tőle. Ugyanez történt az előző Forza esetében is. Aztán nekiestek a gyártók is kicserélték a kódokat.

(#22785) imi123: A Microsoft is megoldja ezt a gondot a shader model 6.0-val. Ott nem kell majd konvertálás, hanem tényleg szállíthatók PC-re az Xbox One shaderei.

-

válasz

#85552128

#22731

üzenetére

#85552128

#22731

üzenetére

Az utolsó kérdésem valójában felesleges volt.

Viszont felvetődik, hogy:

1. A Vega 10 vajon RX 490 néven jön?

2. A Vega 11 vajon RX 580 néven jön? (Ekkor lehet a P10-et RX 560-ná minősíteni, ha vágott V10-et akarnak 570-ként kihozni.)

3. Vagy a Vega 11 RX 485-ként fog jönni?

-

#Morcosmedve

veterán

válasz

#85552128

#22663

üzenetére

#85552128

#22663

üzenetére

(#22662) schawo: N+1 esetet találhatsz a topikjában és a Goolge/YT segtségével. HBM2 talán már megfelelően lesz implementálva.

De WQHD-ra nem elég, akkor megint csak belefut az ember a hibába

390-em is bőven elszaladt 5-6GB-ig FHD-n, pedig már butítottam a grafon, szóval én abban nem hiszek, hogy elég a 4GB, persze, le lehet még jobban venni a graf. beállításokat, de akkor meg minek az egész (és akkor egy TriX 290X-et használtan meg se említek, hogy mennyivel jobb vétel, egyedül a fogyasztás a hátrány a Polarisokkal szemben).

390-em is bőven elszaladt 5-6GB-ig FHD-n, pedig már butítottam a grafon, szóval én abban nem hiszek, hogy elég a 4GB, persze, le lehet még jobban venni a graf. beállításokat, de akkor meg minek az egész (és akkor egy TriX 290X-et használtan meg se említek, hogy mennyivel jobb vétel, egyedül a fogyasztás a hátrány a Polarisokkal szemben).

Első VGA, ami értelmesen elégnek tűnik WQHD-ra az a 980 Ti, de most, hogy itt a 1070, inkább azt veszik/érdemesebb. -

-

Abu85

HÁZIGAZDA

válasz

#85552128

#22380

üzenetére

#85552128

#22380

üzenetére

Nem azért nem volt aktív, mert nem volt elérhető játék, hanem azért nem volt az, mert nem jól működött a nyári implementáció. Emiatt letiltották. Az persze nyilván előny volt, hogy ez nyáron történt meg, mert az ubiszezon miatt amúgy sem volt játék hozzá, de alapvetően egy hiba miatt nem aktív, amint azt javítják újra bekapcsolják. Az AGS 4.0 leginkább a Battlefield 1-hez fog kelleni, mert annak maga a leképezője is ezekre a függvényekre épül. A Deus Ex használ Ballot-t és ReadFirstLane-t. Használ a rendszer, mert használ, de nem annyit, mint a Doomban, vagy annyit, amennyit a BF1-ben fog.

-

Abu85

HÁZIGAZDA

válasz

#85552128

#22371

üzenetére

#85552128

#22371

üzenetére

Írtam korábban, hogy az AGS 4.0 DX12 alatt még nem működik. A Vulkan egyszerű, mert a Khronos a shader fordításra nagyon jó struktúrát alakított ki a SPIR-V-vel. Ezt az IR-t ki lehet egészíteni, vagyis pusztán a rendszer alapvető fordítóinfrastruktúráját használva lehet egyedi függvényeket beletenni. A DirectX alatt a D3BC nem kiterjeszthető, vagyis ahhoz, hogy ott működjön egy ilyen rendszer mellé kell építeni egy alternatív fordítóinfrastruktúrát , ami megkerüli az fxc-t. A nehézséget az adja, hogy a rendszernek egy helyett két fordító biztosítja a shader programot, és ezt össze kell hangolni. Emiatt nincs még engedélyezve a complier pass through DX12-re.

-

válasz

#85552128

#22349

üzenetére

#85552128

#22349

üzenetére

Na igen, csak a variancia miatt a gyengébben sikerült kártyák órajelét veszik alapul adott TDP kerethez, hogy biztosan mindegyik bele férjen. Kisebb varianciával a gyengébb példányok kevésbé múlnák alul az átlagot, ergo gyárilag magasabb órajelen lehet kiadni a szériát.

-

keIdor

titán

válasz

#85552128

#22225

üzenetére

#85552128

#22225

üzenetére

Százalékosan ugyanannyi 980Ti tulaj engedhette/nem engedhette a statisztikát, mint Fury széria tulaj.

Azt is tudjuk, hogy a Fury szériát nagyon nem vitték, aki meg vitte az is már eladta egyéb okok miatt.

Nem mondom, hogy száz százalékra pontos ez a statisztika, mert biztos nem, de körülbelül korrekt.

Egyébként sincs másik, szóval nincs se pontosabb, se pontatlanabb, nincs mihez viszonyítani.

Kivétel ez: [link] de ez meg azt is mutatja, mint a képem. [link] -

Abu85

HÁZIGAZDA

válasz

#85552128

#22056

üzenetére

#85552128

#22056

üzenetére

Ez egy GPU-driven pipeline motor. Itt már DX11 alatt sem a grafika eszi a legjobban a processzort, ami miatt Full HD-ben is nagyon könnyen GPU-limitet kaphatsz. Az a munka, ami eddig a procin volt, zömében át lett pakolva a GPU-ra. Ez egy kezdődő, és a jövőben domináns irányzat lesz. A Frostbite csak előrébb tart, mint a többiek.

-

Laja333

őstag

válasz

#85552128

#22018

üzenetére

#85552128

#22018

üzenetére

BIOS limit nem biztos hogy sokat számít. Legalább is a Nitro 480-ból én is kiolvastattam a Bios-t, és abban 150 W volt a power limit, szemben a ref Bios 110 W-al. Aztán GPU-z szerint "extreme" OC-nál 226 W-nál járt.

Meg azt ne felejtsd el, hogy hogy a TDP a teljes kártyára van számolva, szóval ha 200W-ot enged a Bios a GPU-nak, akkor a teljes kártya már 230-250W körül van.

-

proci985

MODERÁTOR

válasz

#85552128

#22018

üzenetére

#85552128

#22018

üzenetére

persze, ez mind igaz

inkább arra írtam, hogy performance / watt javulásnál ne a TDPből induljunk ki Maxwellnél, mert az csak visszafogottan ad reális képet (senki sem vett refet kb).

G1et én nem tuningoltam, de jellemzően 1500 körül mentek. az EVGA meg szépen megvette a superflower gold platformját, ami kb az egyik csúcsplatform az utóbbi években. jó táp

.

. -

proci985

MODERÁTOR

válasz

#85552128

#22010

üzenetére

#85552128

#22010

üzenetére

970 g1 gyárilag 1392-1420 között boostolt, három kijelzővel (1080phez képest ez magasabb terhelés jellemzően), adott esetben konstans 99%os GPUterhelés mellett (pl Borderlands 2 ultrán kikapcsolt vsynccel). szóval a Strixhez képest simán 10%al magasabb órajeleken járt. még egyszer, ez a gyári értéke volt, és a topikban nem csak az enyém ment ennyin.

de a G1 a strtix / msi lightninghoz képest is egy külön állat volt, 250Wra állított VRM limittel és hiperagresszív órajelemeléssel.

Habugi: Hawaii szivárog. a Matrix Platinumom tetejében nagyon alacsony ASIQos (lehet arra válogatott LN2 tuning miatt), 70Wot nyertem a teljes gép fogyasztásán csak azzal, hogy kapott egy vizesblokkot. ennyit jelentett, hogy 94 helyett 62-65fokon tetőzött a GPU.

ami ennél is súlyosabb, hogy a nagyobb fogyasztású kártyák simán 310-330W körül fogyasztanak, szóval nem véletlenül kritikus a hűtésük. meg nem véletlenül nőtt a kereslet az épített vizek után.

-

Abu85

HÁZIGAZDA

válasz

#85552128

#21923

üzenetére

#85552128

#21923

üzenetére

Nem hiszem, hogy lesz Radeon Experience. Ha a GeForce Experience nem tudott olyan felhasználóbázist kiépíteni, amit kiépített a Raptr, akkor az AMD-nek ebbe felesleges belevágni. A Raptr egész egyszerűen ezen a területen verhetetlen.

Az a helyzet, hogy az NVIDIA, az AMD és az Intel képes ilyen experience programokat készíteni, de nem tudnak közösséget építeni. Ez az, amihez a Raptr sokkal jobban ért. Egyszerűen van ~60 millió felhasználójuk, és ezek a felhasználók innen nem akarnak elmenni. Olyan ez mint a Steam. Van már Origin, Uplay, Galaxy, akármi, de akkor is a Steam a kedvenc.

-

TTomax

félisten

válasz

#85552128

#21881

üzenetére

#85552128

#21881

üzenetére

Ami majdnem olyan jól néz ki mint a GeneralsZH 2003ból...

(#21883) gollo91

Úgy mint a Polaris a Pascal ellen....Nekem egyre gyanúsabb,hogy az történik mint cpu fronton,az amd ignorálja a versenyt mert nem tehet mást.Az nvtöl meg jönnek a bicskanyitogató árak mint ahogy az inteltöl is korábban...

-

Abu85

HÁZIGAZDA

válasz

#85552128

#21795

üzenetére

#85552128

#21795

üzenetére

Nem a játékot kell normálisan összerakni. Meg kell mondani a drivernek, hogy hol a frame buffer. Ha crash-el, akkor azért teszi, mert nincs meg a memóriacím, amivel dolgozhatna. Ez nem egy általánosan működő dolog, ahogy látod. Eleve semmi sem kötelezi a fejlesztőket arra, hogy megmondják a drivernek a frame buffer címét. Anélkül pedig a driver meg van lőve. Teljes képernyős ablak módban tud egyébként címet szerezni a driver, de az meg nem olyan jó, mint az exkluzív teljes képernyő.

-

proci985

MODERÁTOR

válasz

#85552128

#21788

üzenetére

#85552128

#21788

üzenetére

koszi, ezt kiprobalom.

gyiku: megnezem, ebben nem vagyok biztos, hogy tudja a lap.

gbors: ez ilyen

. csaladtag atlag leghuteses gepet (Fractal Define, Thermalright hutes, ATX, egy VGA, 2 disc) masfel ora alatt kenyelmes tempoban kave es sutiszunettel raktam ossze (es ebben bennevolt a vezerlopanelen a ventik belovese es a szep kabelrendezes is), a sajat gepemnel kb 40 oras az osszeszerelesi ido. van itthon meg ket radim amit agyalok, hogy integralni kene a rendszerbe (meg esetleg ketkorositeni a hutest), de szerintem a ket unnep kozottig biztos nem nyulok hozza.

. csaladtag atlag leghuteses gepet (Fractal Define, Thermalright hutes, ATX, egy VGA, 2 disc) masfel ora alatt kenyelmes tempoban kave es sutiszunettel raktam ossze (es ebben bennevolt a vezerlopanelen a ventik belovese es a szep kabelrendezes is), a sajat gepemnel kb 40 oras az osszeszerelesi ido. van itthon meg ket radim amit agyalok, hogy integralni kene a rendszerbe (meg esetleg ketkorositeni a hutest), de szerintem a ket unnep kozottig biztos nem nyulok hozza.---

DSR tema: szvsz a 4xes az egyik legszebb eredmenyt adja kepminoseg szempontjabol, mas kerdes, hogy 1080phez 4Kban szamoltatni azert eroforrasigenyes. a koztes megoldasok a pixellekepezes miatt viszont lehet elmosottabb kepet adnak. en mondjuk nem nagyon hasznaltam, 5760x1080nal a DSR gyakorlatilag 4K eyefinitynek felelne meg.

-

proci985

MODERÁTOR

válasz

#85552128

#21691

üzenetére

#85552128

#21691

üzenetére

290X CF high (ish, AA kikapcsolva), 5760ban tol 30as AVGt.

CF nem tudom megy-e mert afterburnerrel nem hajlando elindulni, hofokok alapjan talan. ha megy rendesen a CF az elegge vicces mert 4Kra ide tenyleg multiGPU kell meg mindig.

kieg: vegigmertem ultra - very high - high - medium preseteken 1080pben, fpsre 30rol (lehet ultra textura nem volt bent) felment 36ra az fps (mediumra), remelem 1-2 patchen belul jo lesz mert ez igy nagyon nem oke. Lehet egyébként a multiGPUt kene kikapcsolni, vagy a szelso monitorokat, vagy a beallitasokat... vagy... tokmindegy, nem engem fizetnek ezert es ha minden mas jatek mukodik akkor nem az en rendszeremben van a hiba.

Ja igen: ha gondolkodsz rajta de meg nem vetted meg varj par hetet. A launchot sikerult jobban elszurni mint a Just Cause 3 eseten, miután mar egyszer fel evet toltak rajta. A jatek a jelen formajaban meg nincs kesz.

-

Abu85

HÁZIGAZDA

válasz

#85552128

#21654

üzenetére

#85552128

#21654

üzenetére

Az AF sebességvesztése attól függ, hogy szögfüggő vagy sem. A mai játékokba nem építenek szögfüggőt, mert bírja a hardver. Lényegében ugyanannyit lassul az AF mindkét gyártón, ha megegyezik az algoritmus. Persze a szoftverfejlesztő dönthet úgy is, hogy az egyik gyártóra szögfüggő AF-et rak be, míg a másik gyártóra teljeset. Ezt nem szokás megtenni, de csak döntés kérdése az egész. A Deus Ex-ben nem szögfüggő AF van.

-

-

válasz

#85552128

#21505

üzenetére

#85552128

#21505

üzenetére

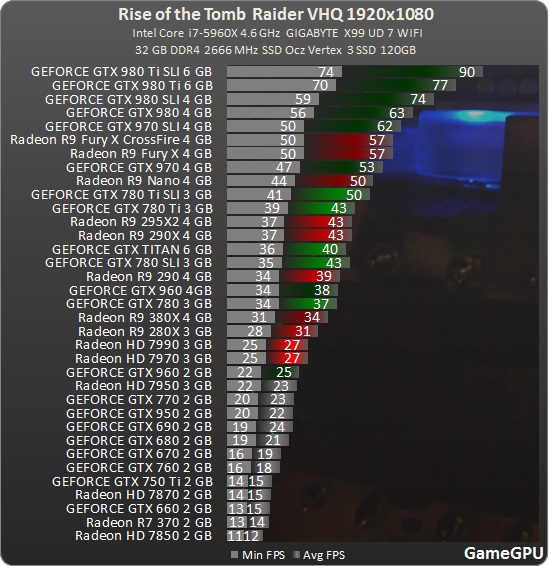

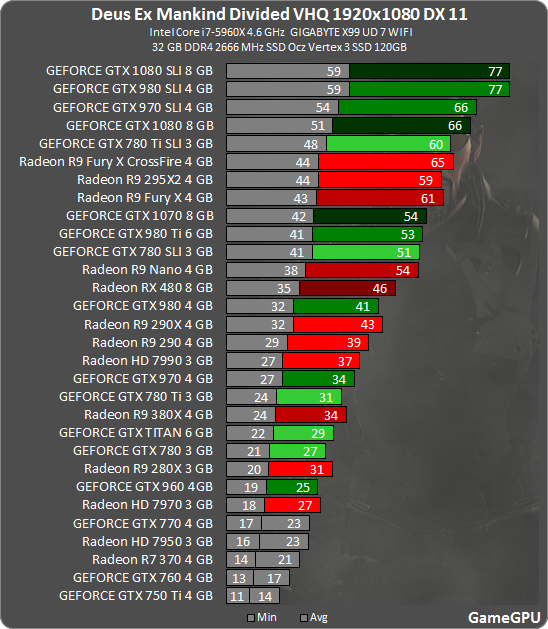

Hát a DX12 nehéz dió... de nem csak nekik... láttál te bárhol eddig normális DX12 játékot?

Amugy a DX11 az nem rossz, ez kb egy reális sebesség a TR után, figyelembe véve hogy a DeXM elvileg sokkal jobb grafikával rendelkezik.

Ahhoz képest ez a mértékű lassulás a kettő között nem nagy.

vs

-

-

-

letepem

aktív tag

válasz

#85552128

#19622

üzenetére

#85552128

#19622

üzenetére

Ha tudom, hogy a termékem cirka 35-40 wattal többet fogyaszt és az OEM-ek is szeretik, ha valami hűvös , a vásárlók annál inkább

, akkor tervezek rá egy normálisabb hűtést.

, akkor tervezek rá egy normálisabb hűtést.Ha ez megtörtént volna 480-nal:

-199 és 229 helyett 200 és 230 dodóért kellett volna kiadniuk, mert kb. ekkora extra költség

-review-kban már most előrébb lenne 1060-nál, mivel Tjmaxot elérve a kártya visszavesz.És lenne egy sikeres ref, amit még többen rendeltek volna elő és nem várna mindenki a customokra.

-

válasz

#85552128

#19566

üzenetére

#85552128

#19566

üzenetére

1440p-ben 6%-kal gyorsabb az 1060 az RX 480-nál. Egész jó a varázsgömböm.

(#19611) Harley quinn: Ja, hát a 15% nem jött be, ráadásul a korábbi hsz-ek alapján DX12-ben már lassabb.

-

Kicsimix

őstag

válasz

#85552128

#19245

üzenetére

#85552128

#19245

üzenetére

Több tranzisztor.. Most ezt úgy mondtad mintha abból meg 2x több lenne benne 970-hez képest. (5.2 970 vs 5.7 480). Közben pedig a ROP-ok felezve vannak amit az opengl meghálál a maga egyszerűségével. (Amit amúgy már alig használnak.) Azért bízom benne 2016-ban már el is felejtik. Hjaa.Szerintem hatékonyabb és "szerintem" ez még mindig nem a vége amit a Doom mutat. Mondjuk én azok közé tartoztam végig akik hittek a lowlvl létjogosultságában míg mások bullshitezték közben a bullshites kommentek váltak most bullshitté : ))) Ehhez kell még egy kis idő mire kiderül mire is elég még. De legalább egy Time Spy ami rendesen tesztel. Peace

-

#45185024

törölt tag

válasz

#85552128

#18911

üzenetére

#85552128

#18911

üzenetére

Megint nem azzal van itt a baj hogy a 4 raszter motorból úgy vágtak hogy egy nem működik.

Azt senki nem várta el hogy 1080 teljesítményt kapsz az 1070-nél, csak megint úgy vágtak hogy megy az eltusolás, és nem tud nem eszedbe jutni a 970 akármennyire is akarod, Itt a mondanak valamit és oszd el kettővel elv kezd teljesen általánossá válni. Amikor azt hallod hogy mind a kettő 64 ROP akkor nem azt várod hogy a teljesítmény negyedét bukod a rasztermotor vágása miatt...

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- exHWSW - Értünk mindenhez IS

- Magga: PLEX: multimédia az egész lakásban

- Kerékpárosok, bringások ide!

- Nintendo Switch 2

- Intel Core i3 / i5 / i7 / i9 10xxx "Comet Lake" és i3 / i5 / i7 / i9 11xxx "Rocket Lake" (LGA1200)

- PlayStation 3

- Intel Core i5 / i7 / i9 "Alder Lake-Raptor Lake/Refresh" (LGA1700)

- Fortnite - Battle Royale & Save the World (PC, XO, PS4, Switch, Mobil)

- RAM topik

- Elemlámpa, zseblámpa

- További aktív témák...

- Eladó használt Gigabyte AMD Radeon HD 6750 videókártya

- Garis ZOTAC GeForce RTX 4070 Ti Trinity 12GB GDDR6X videokártya

- ASUS TUF Gaming GeForce GTX 1660 Ti OC 6GB GDDR6 192bit

- ASUS Dual RTX 4070 SUPER EVO OC Edition 12GB - AQUA garancia 2027.12.19.

- ASRock Radeon Challenger Pro RX 6700 XT 12GB OC Videokártya

- ÁRGARANCIA!Épített KomPhone i9 14900KF 32/64GB RAM RX 9070 XT 16GB GAMER PC termékbeszámítással

- BESZÁMÍTÁS! ASUS ROG Zephyrus GA403UV Gamer notebook - R9 8945HS 16GB RAM 1TB SSD RTX 4060 8GB WIN11

- Telefon felvásárlás!! iPhone 15/iPhone 15 Plus/iPhone 15 Pro/iPhone 15 Pro Max

- ÁRCSÖKKENTÉS Lenovo ThinkPad T570, T580, P51s, P52s eredeti Lenovo, belső akkumulátor eladó

- Frederick Forsythe: Isten ökle (nem olvasott)

Állásajánlatok

Cég: Promenade Publishing House Kft.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)

390-em is bőven elszaladt 5-6GB-ig FHD-n, pedig már butítottam a grafon, szóval én abban nem hiszek, hogy elég a 4GB, persze, le lehet még jobban venni a graf. beállításokat, de akkor meg minek az egész (és akkor egy TriX 290X-et használtan meg se említek, hogy mennyivel jobb vétel, egyedül a fogyasztás a hátrány a Polarisokkal szemben).

390-em is bőven elszaladt 5-6GB-ig FHD-n, pedig már butítottam a grafon, szóval én abban nem hiszek, hogy elég a 4GB, persze, le lehet még jobban venni a graf. beállításokat, de akkor meg minek az egész (és akkor egy TriX 290X-et használtan meg se említek, hogy mennyivel jobb vétel, egyedül a fogyasztás a hátrány a Polarisokkal szemben).

Megy a kukába.

Megy a kukába.