- Nem tiltották be a Teslát Kaliforniában, Robotaxival ünnepelt a márka

- Apró változásokkal, elődjénél jobb áron kezd a Google Pixel 10a

- Visszatért a Snapdragonhoz az Infinix, itt a Note 60 és Note 60 Pro

- Esélyes, hogy drágul a Nothing Phone (4a) széria

- Lelkiismeret-furdalás nélkül zabálhatod a süteményt a Galaxy S26-tal

- iPhone topik

- Minden a BlackBerry telefonokról és rendszerről

- Samsung Galaxy S23 és S23+ - ami belül van, az számít igazán

- Apple iPhone Air - almacsutka

- EarFun Air Pro 4+ – érdemi plusz

- Soundcore Sleep A30 - a hosszú házasság titka

- Google Pixel topik

- Samsung Galaxy S25 - végre van kicsi!

- Samsung Galaxy S21 FE 5G - utóirat

- Sony WF-1000XM6 – ez évi etalon?

- Luck Dragon: Alza kuponok – aktuális kedvezmények, tippek és tapasztalatok (külön igényre)

- gban: Ingyen kellene, de tegnapra

- Luck Dragon: Asszociációs játék. :)

- mefistofeles: Az elhízás nem akaratgyengeség! 2 Ahogy én csinálom.......

- Candy: IGPU dGPU passthrough, avagy a nem minden arany, amin megy a Furmark

Új hozzászólás Aktív témák

-

S_x96x_S

addikt

válasz

KAMELOT

#51081

üzenetére

KAMELOT

#51081

üzenetére

> Amikor jön a Rubin

A GTC-n valamit belejelentenek

( Groq LPU ? )"NVIDIA’s CEO to Unveil Chips the “World Has Never Seen Before” at This Year’s GTC, Likely Pointing Toward Rubin or Next-Gen Feynman AI Lineups"

https://wccftech.com/nvidia-ceo-to-unveil-chips-that-the-world-has-never-seen-before/ -

S_x96x_S

addikt

válasz

Busterftw

#51082

üzenetére

Busterftw

#51082

üzenetére

egy kis verseny mindig jó.

A META az AMD kiemelt partnere,

és annyira nagy ügyfél - hogy az nvidának is fontos."NVIDIA Manages to Bag In One of AMD’s Biggest AI Customers, Meta, Offering Next-Gen Vera Rubin In a “Multi-Generational” Partnership"

"Before we dive into the specifics of the deal, let's look at how the Meta-AMD partnership is moving. Meta is one of AMD's largest AI customers, accounting for more than 40% of the total revenue last year. More specifically, Meta is also a primary adopter of the Instinct MI300X AI server racks, indicating that the company has shown a deep commitment to Team Red's infrastructure. Interestingly, AMD has also designed its Helios rack around Meta's ORW specifications, but considering the recent MI455X delay rumors, it would be interesting to see how Helios turns out for Meta." -

Busterftw

nagyúr

"This partnership will enable the large-scale deployment of NVIDIA CPUs and millions of NVIDIA Blackwell and Rubin GPUs."

Like hotcakes. -

-

-

WayneGace

őstag

Pont emiatt írtam példaként azt, amit, mert nem direkt, amit fel kell tüntetni, hanem közvetve.

Meg nem is értem ezen a vitát. Amikor, hogy kinek mi tetszik az tényleg szubjektív, nekem ez, neked az. Mindenki választhatja a neki tetszőt. Ez nem olyan, mint az fps szám vagy hőfok. -

PuMbA

titán

válasz

Busterftw

#51074

üzenetére

Busterftw

#51074

üzenetére

"3x annyian tartottak jobbnak a DLSS-t mint az FSRt."

Ezt én nem tartom helyes konklúziónak, ugyanis a táblázat tetején oda van írva, hogy a legjobbra kellett leadni a szavazatot, így ez a teszt nem alkalmas a DLSS és FSR közötti arány mérésére, hiszen még volt két másik lehetőség

Nem tudjuk, hogy a másik két eshetőségre szavazók a DLSS-re vagy FSR-re szavaztak volna, ha csak ez a két lehetőség lett volna.

Nem tudjuk, hogy a másik két eshetőségre szavazók a DLSS-re vagy FSR-re szavaztak volna, ha csak ez a két lehetőség lett volna. -

PuMbA

titán

válasz

WayneGace

#51072

üzenetére

WayneGace

#51072

üzenetére

Szponzorációt fel kell tüntetni minden esetben, ha jól tudom, mert YouTube szabályzat

DigitalFoundry-nál is feltűnően ki van írva, ennél például: Nvidia GeForce RTX 2070 - RTX 5070 Evolution: The Transformation of 1440p Gaming [Sponsored]

DigitalFoundry-nál is feltűnően ki van írva, ennél például: Nvidia GeForce RTX 2070 - RTX 5070 Evolution: The Transformation of 1440p Gaming [Sponsored]Illetve a videó leírása azonnal kezdődik, hogy biztos észrevedd: Many thanks to Asus for sponsoring this video. Látszik is, hogy tele van MFG-vel a videó, hogy vegyenek 5070-et az embörök

-

PuMbA

titán

válasz

FLATRONW

#51067

üzenetére

FLATRONW

#51067

üzenetére

"Lehet ezt úgy is értelmezni, hogy az FSR 4-et csak a felhasználók 15 százaléka látta jobbnak, a maradék 85 pedig nem. "

Ez amúgy elég jó szám, hogy ennyien a legjobbnak látták, tekintve, hogy az FSR4 már 11 hónapja jelent meg, míg a DLSS 4.5 1 hónapja.

KAMELOT: Ez jó meglátás.

-

PuMbA

titán

válasz

FLATRONW

#51067

üzenetére

FLATRONW

#51067

üzenetére

Lejárt a szerkesztési időm, szóval persze, hogy lehet

Ezért gondoltam tovább, hogy itt még sok hasznos adatot ki lehetne nyerni, ha több fordulója / része lenne a tesztnek, mert ugye relatíve korlátozott így, hogy a csak legjobbra koncentrál és azt mutatja meg (a második helyre ugye a készítők szerint se alkalmas, pedig azt is jó lenne tudni), de hogy mi a helyzet a teljes képet nézve. Szóval ebben még van / lenne bőven lehetőség mazsolázni, informálódni.

Ezért gondoltam tovább, hogy itt még sok hasznos adatot ki lehetne nyerni, ha több fordulója / része lenne a tesztnek, mert ugye relatíve korlátozott így, hogy a csak legjobbra koncentrál és azt mutatja meg (a második helyre ugye a készítők szerint se alkalmas, pedig azt is jó lenne tudni), de hogy mi a helyzet a teljes képet nézve. Szóval ebben még van / lenne bőven lehetőség mazsolázni, informálódni. -

Nincs nagy gond az FSR 4-gyel meg hát akinek Radeonja van az úgy sem megy semmire azzal , hogy jobb a DLSS.

Azért jók ezek a tesztek, mert ösztönzik az AMD-t a fejlesztésre, ezzel nyernek a felhaszhálók.

Kész van állítólag a DLSS 5.0 csak az Nvidia új genhez fogja kötni a megjelenését. -

Abu85

HÁZIGAZDA

A gyártók és a stúdiók kiszámolják a képet teljes felbontáson. Ez nagyon fontos objektív adat, mert alapvetően az összes felskálázó torzít. Tehát a cél az, hogy a ground truth-hoz viszonyítva a torzítás minimális legyen. Jelenleg viszont nagyon érdekes, hogy egyre inkább a torzítás erősítése felé haladunk, tehát egyre messzebb kerülünk a ground truth-tól. A DLSS-nél például a DLSS 3 volt ehhez a legközelebb, az FSR-nél viszont az FSR 4 került közel hozzá. Az kérdés, hogy az AMD ezt merre viszi, mert ők is eltávolodhatnak a ground truth-tól, mint a DLSS, mert az van belenevelve a játékosokba jelenleg, hogy minél jobban torzít, annál szebb.

-

Yutani

nagyúr

válasz

huskydog17

#51049

üzenetére

huskydog17

#51049

üzenetére

Fele társaság a DLSS-t választotta a vakteszten, mint legjobb képminőség. 40%-nyi valami mást, míg 12% szerint mind hasonlóan jó. Technikailag a DLSS a superior, de látható, hogy az emberek felének tulajdonképpen a többi megoldás is megfelel.

Átterve 9070-re, Borderlands 4 alatt azt mondom, hogy nem tudom azt állítani, hogy az FSR-rel láthatóan rosszabb lenne a kép, mint 3060 Ti-n DLSS-sel. (Persze 3060 Ti medium volt, a 9070 meg high+.)

Nyilván korábban sokkal rosszabb volt az FSR, de ahogy látom, túl van lihegve ez a dolog. De mondom, abban nincs kétség, hogy a DLSS a legjobb.

-

PuMbA

titán

Nagyon ritka, hogy YouTube videókban ground truth-hoz hasonlítanak, de a Digital Foundry csinál egy ilyet ritkán: Death Stranding 8xSSAA-val [link]

A gyártói felméréseknél is SSAA a ground truth?

#51053 Yutani: Bennem is ez fogalmazódott meg, hiszen aki nem a DLSS-t választotta, az mást választott, mint legjobb minőség.

-

Abu85

HÁZIGAZDA

Egyébként ezt nem így szokták csinálni a gyártói felmérésekben, mert szubjektív tényezőnek ad teret. Az objektivitás miatt van még egy minta, ami a ground truth. Tehát az, hogy milyen, amikor tényleg kiszámolná a hardver a maximális felbontáson, amivel elméletben lehetne.

-

PuMbA

titán

válasz

huskydog17

#51049

üzenetére

huskydog17

#51049

üzenetére

Nem állítottam, hogy ezt jelenti, hiszen kérdőjelet raktam a mondatok végére

Én nem szoktam csavarni a dolgokat, csak más megközelítésből kezdtem el nézni az adatokat, mert egy adatnak mindig van egy másik oldala. Rendben.

Én nem szoktam csavarni a dolgokat, csak más megközelítésből kezdtem el nézni az adatokat, mert egy adatnak mindig van egy másik oldala. Rendben. -

huskydog17

addikt

"Viszont ez azt is jelenti, hogy a megkérdezettek fele nem a DLSS 4.5-öt tartotta a legjobbnak, ugye?"

Nem, nem azt jelenti. Ezt gondold át újra és próbáld meg értelmezni a leírtakat! Megint úgy próbálsz csűrni-csavarni egy végtelenül pofon egyszerű eredményt, hogy egy hülyeséget sikerült belőle kikövetkeztetned.

"Tehát 48,2% mondta, hogy az a DLSS 4.5 legjobb, míg 52.8% nem?"

Mondat első fele igaz, a második fele nem igaz.

-

PuMbA

titán

válasz

huskydog17

#51046

üzenetére

huskydog17

#51046

üzenetére

Jaja, nem vitatom az eredményt

A százalékok sorrendbe rakása volt nekem fura. Viszont ez azt is jelenti, hogy a megkérdezettek fele nem a DLSS 4.5-öt tartotta a legjobbnak?

A százalékok sorrendbe rakása volt nekem fura. Viszont ez azt is jelenti, hogy a megkérdezettek fele nem a DLSS 4.5-öt tartotta a legjobbnak?"DLSS 4.5: 3249 (48,2%)

TAA: 1619 (24%)

FSR 4: 1013 (15%)

Nincs különbség: 866 (12,8%)"Tehát 48,2% mondta, hogy az a DLSS 4.5 legjobb, míg 52.8% nem?

-

huskydog17

addikt

Igen, tudom és ezt én is leírtam az előző kommentben:

"Nagyon fontos, hogy nem itt sorrend felállítása volt a kérdés/feladat, hanem egyszerűen a legjobbra kellett szavazni és mivel ez egy vakteszt volt, értelemszerűen az olvasók nem tudhatták, hogy melyik melyik, egyszerűen csak le lehetett adni a voksot arra, amelyik a legjobban tetszett."Szóval nem tudom miért hívod fel erre a figyelmet, amikor ezt már én is megtettem. Itt egyszerűen arról van szó, hogy a CB olvasóinál a három képminőség közül messze a DLSS 4.5 a legnépszerűbb, a legtöbb felhasználónak az tetszik a legjobban, míg az FSR 4-re szavaztak a legritkábban azok közül, akik különbséget véltek felfedezni a három mozgóképen.

"Tehát szó sincs arról, hogy a natív TAA jobb lenne az FSR4-nél"

Se én, se a CB nem állítottuk, hogy a TAA jobb lenne, mint az FSR 4, nem értem ezt honnan szeded, továbbá az is érthetetlen számomra, hogy miért feltételezed rólam egyáltalán, hogy nem olvastam el végig.

Amúgy nekem nem kell angolra lefordítanod, mert értek németül, ráadásul a németem sokkal jobb, mint az angolom, így ezt a lépést az én esetemben nyugodtan megspórolhatod, ha valamit idézni szeretnél nekem a CB-től, akkor inkább az eredeti német szöveget, köszi! -

PuMbA

titán

válasz

huskydog17

#51044

üzenetére

huskydog17

#51044

üzenetére

Fontos információt tartalmaz a cikk vége, ami angolra fordítva: "But to reiterate, because it's very important: The results only show how often each technology was chosen as the best. What the results don't show, however, is what was perceived as second and third best. Neither the question nor the surveys themselves were designed to reveal that. So, native image quality isn't second best, but rather was the second most frequently rated as having "best image quality." The same applies to FSR upscaling."

Tehát szó sincs arról, hogy a natív TAA jobb lenne az FSR4-nél

-

huskydog17

addikt

A ComputerBase-en véget ért a két hetes felskálázó olvasói vakteszt. Az olvasóknak két hét állt a rendelkezésükre, hogy szavazzanak a három meg nem nevezett képminőség közül. Nagyon fontos, hogy nem itt sorrend felállítása volt a kérdés/feladat, hanem egyszerűen a legjobbra kellett szavazni és mivel ez egy vakteszt volt, értelemszerűen az olvasók nem tudhatták, hogy melyik melyik, egyszerűen csak le lehetett adni a voksot arra, amelyik a legjobban tetszett.

A CB olvasói egyértelműen a DLSS 4.5-öt jelölték meg győztesnek, ráadásul nem is kis előnnyel, hanem óriási fölénnyel nyert az NV legújabb felskálázója.

A második legtöbb szavazatot - messze elmaradva a DLSS 4.5 számaitól - a natív, azaz a játék saját TAA algoritmusa szerezte meg, míg a harmadik helyen az FSR 4 végzett.

A negyedik kategória azon felhasználókat takarja, akik nem tudtak különbséget tenni a három képminőség között.Tehát a CB olvasói által leadott szavazatok összesen a 6 játékra:

DLSS 4.5: 3249 (48,2%)

TAA: 1619 (24%)

FSR 4: 1013 (15%)

Nincs különbség: 866 (12,8%) -

Abu85

HÁZIGAZDA

Mert a P-mag fogyasztása egészen magas szintre nőtt, és emiatt nem tudtak elég P-magot rakni a lapkába. Erre csináltak E-magot, ami jóval kisebb fogyasztású. Így keverik őket. Az AMD azért nem kezdte el, mert nekik a Zen magjuk fogyasztása relatíve alacsonyan van tartva. Kb. az Intel-féle P-mag felénél.

#51027 Busterftw : Az Intelnek a fogyasztása az kényszerű lépés. Nem azért szabják az új tokozást 700 wattos PL4-re, mert ez annyira jó ötlet, hanem azért, mert kiszámolták, hogy így lesznek ott teljesítményben, ahol a Zen 6 lesz 230 wattos PPT-vel, vagyis a PL4-gyel megegyező paraméterrel. Egyszerűen azzal, hogy elvették a magoktól a Hyper-Threadinget, az Intelnek minden szál mögé fizikai erőforrást kell raknia, és ez veszettül fogyaszt abban az esetben, ha mindkét cég 50 szál körülire tervezi a következő kört. Az AMD-nek a 48 szál mögé elég jóval kevesebb erőforrást építenie, mert van SMT-je.

Ezzel az Intel úgy 2030-ig nem fog tudni mit kezdeni, mert addig nem jön az új, Zen-szerűen tervezett mag.

#51026 proci985 : Az alaplapok esetében már most megoldják az alaplap gyártók azt, hogy az Intel lapokra más komponenseket szereznek be. Technikailag most is drágábbnak kellene lennie egy Intel alaplapnak a magasabb fogyasztási paraméterek miatt, de az Intel követelményei kevésbé szigorúak emiatt az AMD követelményeinél, így megengedik az olcsóbb komponenseket is. Ilyen szempontból tehát lesz mozgástere az alaplapgyártóknak.

#51032 Busterftw : 52-magos lesz a Nova Lake. Viszont itt a gyártók ezt nem magként értelmezik, hanem szálként, mert szálakon futtatod a folyamatokat. Ezért küld ellene az AMD 48-szálas Ryzent. Valószínűleg ha 48-magos Ryzen jönne 96 szállal, akkor a PPT fogyasztása úgy 450 watt lenne, ami még mindig kisebb a 700 wattnál, de láthatóan nőne. Viszont az AMD-nek nincs szükséges 48-magos Ryzenre ezen a szinten, mert nagy teljesítményű magokat terveznek ide.

#51034 paprobert : Nem fog az AMD ilyet csinálni, mert a Panther Lake előállítási költsége magasabb a Strix Halo dizájnnál is. Ez azért nagyon jelentős probléma lenne az AMD-nek, mert nekik az árrésük sokkal nagyobb az Intelnél, hogy reális nyereséget tudjanak termelni. Emiatt az AMD ide Strix Halo rendszert kínál inkább, amit drágábban adhat el.

-

S_x96x_S

addikt

válasz

KAMELOT

#51038

üzenetére

KAMELOT

#51038

üzenetére

Ezt így felesleges számolni, mert ha az 5090 mellé teszel egy erős cpu-t akkor még ettől is jobban megy.

milyen erős CPU -ra gondolsz ??

Mert amit belinkeltem azt - ezzel a konfiggal mérték:

[ AMD RYZEN 9 9950X3D![;]](//cdn.rios.hu/dl/s/v1.gif) / X8670E Taichi / 2x 16GB DDR-6000MT/s / WD_BLACKSN850X ]

/ X8670E Taichi / 2x 16GB DDR-6000MT/s / WD_BLACKSN850X ]> Ezt így felesleges számolni,

Én nem hiszem hogy felesleges lenne,

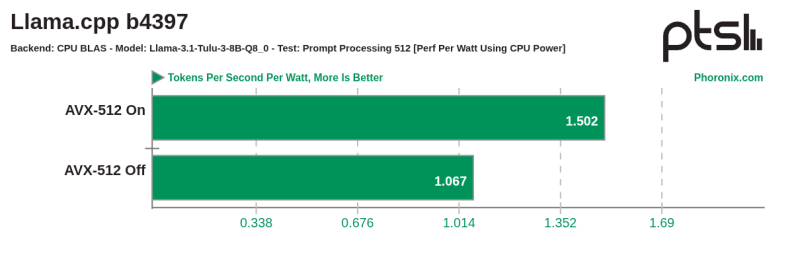

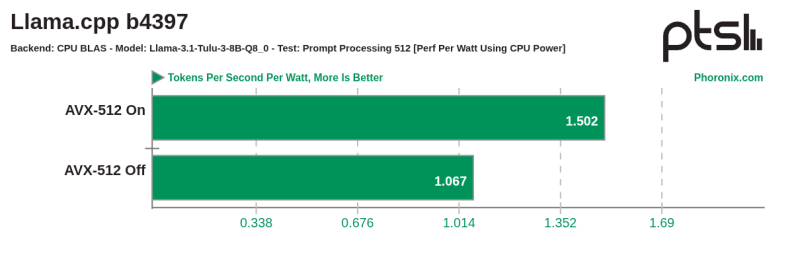

a Phoronix elég jó teszteket szokot készíteni.A legnagyobb probléma, hogy a gyárilag konfigurált CPU / GPU -k

nem mindig a leg-nergiahatékonyabb beállításokkal futnak.És az AVX-512 hatékonyságát is egyszerűen lehet szemléltetni.

( ami sajnos a consumer Intel cpu-kban most még nincs )

-

KAMELOT

titán

Ezt így felesleges számolni, mert ha az 5090 mellé teszel egy erős cpu-t akkor még ettől is jobban megy. Sőt 8K-ban is tudja a 60fps-t.

Közben nézd meg ezt is hova tart az egész. -

S_x96x_S

addikt

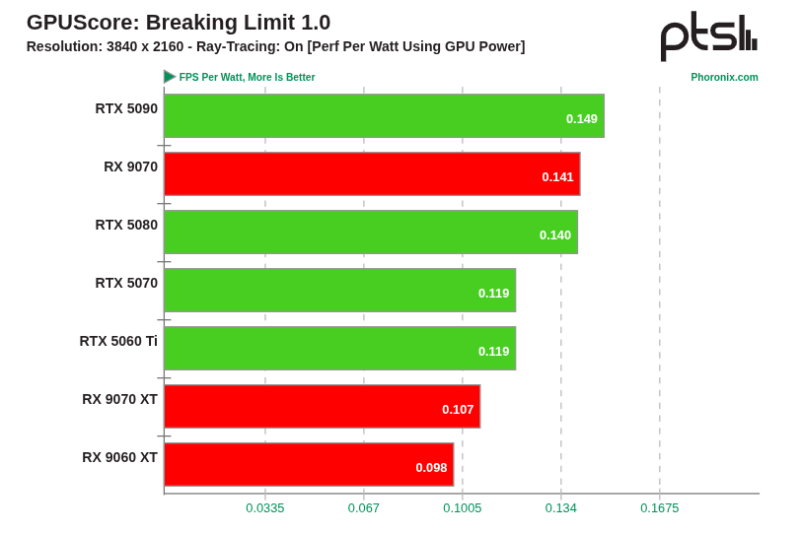

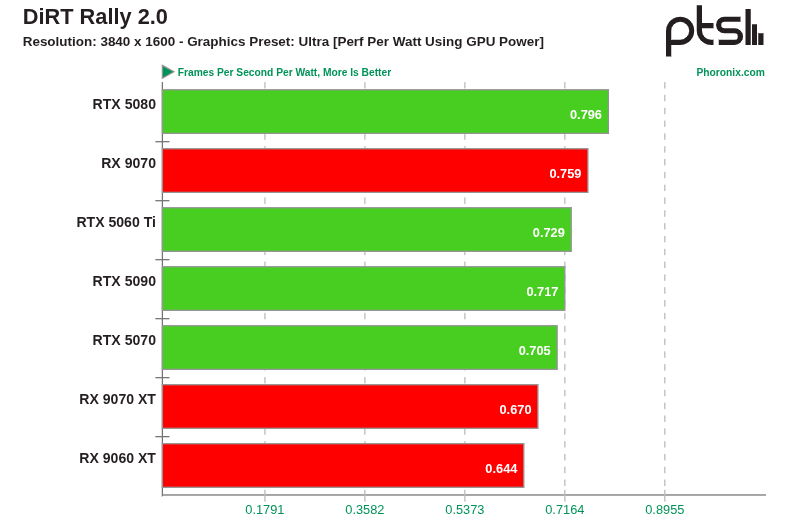

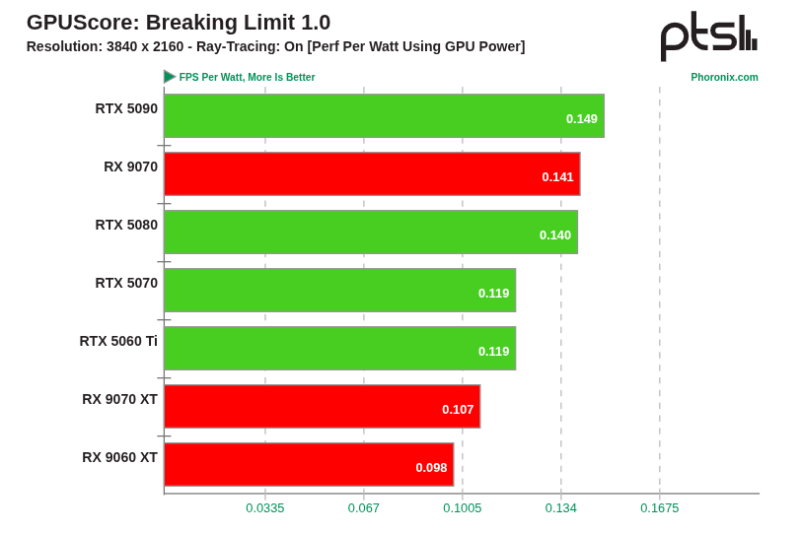

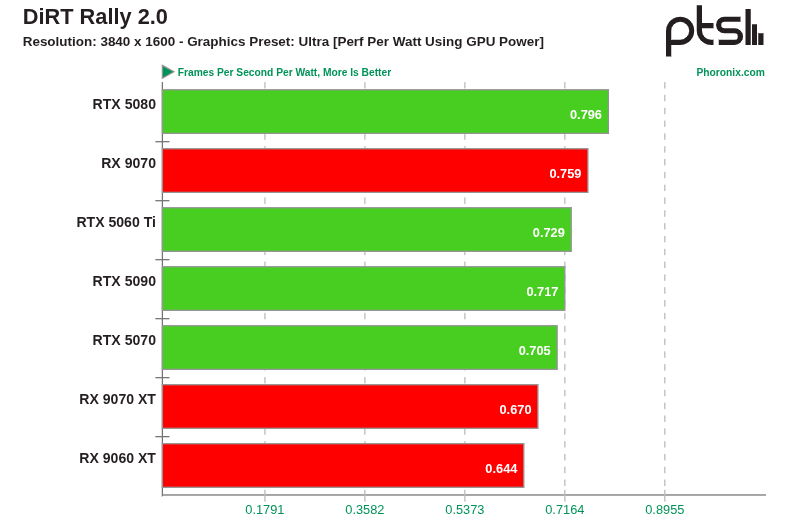

a phoronix -on van FPS/Watt mérés ( bár Linux -os )

pl. ebben a tesztben:

az RTX 5090 tényleg egy picivel hatékonyabb mint az RX 9070.

viszont az RX 9070 -nek se kell szégyenkeznie,

mert az RTX 5080, 5070, 5060 Ti -nél meg jobb.viszont RX 9070 XT és a 9060 XT meg roszabb,

valószínüleg az optimális fogyasztási beállítást a sima 9070 kapta.

itt is hasonló az eset,

A sima RX 9070 eléggé optimális fogyasztással rendelkezik.

-

PuMbA

titán

válasz

Busterftw

#51035

üzenetére

Busterftw

#51035

üzenetére

"Egy 1:1 RTX 5090 szintű Radeon mennyit fogyasztana?"

A TechPowerUp szerint a Relative performance táblázatban az 5090 átlag 82%-kal gyorsabb a 9070XT-től

A kártya 304W-os TDP-t szorozzuk meg 1.82-vel, tehát 554W-ot fogyasztana a 9070XT-vel azonos konfigurációban. Valamivel kevesebbet, ha több feldolgozó egységet raknak bele, de kisebb órajellel, illetve ehhez még hozzá kéne számolni, hogy a GDDR7 mennyivel fogyaszt máshogy a GDDR6-tal szemben.

A kártya 304W-os TDP-t szorozzuk meg 1.82-vel, tehát 554W-ot fogyasztana a 9070XT-vel azonos konfigurációban. Valamivel kevesebbet, ha több feldolgozó egységet raknak bele, de kisebb órajellel, illetve ehhez még hozzá kéne számolni, hogy a GDDR7 mennyivel fogyaszt máshogy a GDDR6-tal szemben."Ezt mondom én is, nem lehet összehasonlítani, ahhoz kellene egy 52(16P + 32E + 4 LP-E) konfiguracióval rendelkező Ryzen."

Igen, ilyen nincs, legfeljebb a kisebb magokból indulhatunk ki, tehát Zen5c, Zen6c mag fogyasztásokból.

-

Busterftw

nagyúr

Ezt mondom én is, nem lehet összehasonlítani, ahhoz kellene egy 52(16P + 32E + 4 LP-E) konfiguracióval rendelkező Ryzen.

"Az 54 magos Ryzen se fogyasztana sokat"

Milyen tesztekre alapozva?

Egy 1:1 RTX 5090 szintű Radeon mennyit fogyasztana?

Senki nem azt mondta, hogy a perf/watt előnye nem maradna meg a Ryzennek, csupán annyit hogy ez így nem 1:1. -

paprobert

őstag

https://www.phoronix.com/review/intel-core-ultra-x7-358h-linux

Éppen most jött egy olyan Intel fejlesztés, amely energiahatékonyságban legtöbbször nyer, azon az áron, hogy nyers teljesítményben kikap kb. 5-10%-kal.On average across the 300 workloads the Core Ultra X7 358H had a 15 Watt power consumption and a recorded peak of 64 Watts, below the ~19 Watt average of the AMD Strix Point laptops tested while often delivering the best performance too.

Nem lenne rossz, ha az AMD is hozna egy hibrid jellegű dizájnt, mert ezt igazából a szilíciumot nem sajnáló packaging-gel hozta össze az Intel, műszakilag egyébként gyengébb magokból.

-

PuMbA

titán

válasz

Busterftw

#51032

üzenetére

Busterftw

#51032

üzenetére

Ezt így nem lehet egy az egyben összehasonlítani, hiszen az AMD mind a 24 darab magja az Intel P magjának felel meg, illetve annál jobb, mert AMD oldalon van HT/ SMT. Az Intel úgy 54 magos, hogy nem 54 darab P magja van. Az 54 magos Ryzen se fogyasztana sokat, ha a 24 nagy mag mellé odaraknának a kis fogyasztású Zen 6c magokat.

-

Busterftw

nagyúr

válasz

DudeHUN

#51028

üzenetére

DudeHUN

#51028

üzenetére

De mi a hulyeseg? Miert csodalkozunk, hogy egy 24 magos CPU kevesebbet fogyaszt mint egy 54 magos, meg akkor is, ha az AMD hatekonyabb?

Egy 54 magos Ryzen mennyit fogyasztana, ez a kerdes, ez lenne a fair hasonlat, csak ugy mint egy 5090 szintu Radeon.S_x96x_S

"Az idén megjelenő MI400 vel az AMD all-in -t nyomott ..."

Aminek semmi koze nincs a peldahoz. A kerdes az, hogy az RDNA4 mennyit fogyasztana, ha 1:1 hozna a 5090 teljesitmenyet. -

S_x96x_S

addikt

latency ... bár sokan nem értik mi is az ... és miért fontos,.

Szerencsére Jensen tudja ..."OpenAI’s Latest Codex Model Runs on Cerebras Infrastructure, Hinting at a ‘Serious’ Second Option for AI Inference Beyond NVIDIA"

"But when we talk about inference at scale, NVIDIA dominates the tokenomics, and we saw this in the company's recent talk about how it has lowered token costs by up to 10x with Blackwell. OpenAI's Sachin Katti says that with Cerebras, the company adds on "complementary capabilities", but the AI lab's loyalty in the compute race is all towards NVIDIA. However, with Codex-Spark, we can clearly see that the bottleneck today is latency, and at the hardware level, NVIDIA's tech stack isn't well-positioned to dominate this area.""Introducing OpenAI GPT-5.3-Codex-Spark Powered by Cerebras"

"Powered by the Cerebras Wafer-Scale Engine, it runs at over 1,000 tokens/s, enabling near-instant feedback in live coding environments." -

S_x96x_S

addikt

válasz

Busterftw

#51027

üzenetére

Busterftw

#51027

üzenetére

> kell Nvidia 5090 XY fogyasztassal.

> Amikor megkerdezem hogy az AMD ekkora teljesitmenyu kartyaja

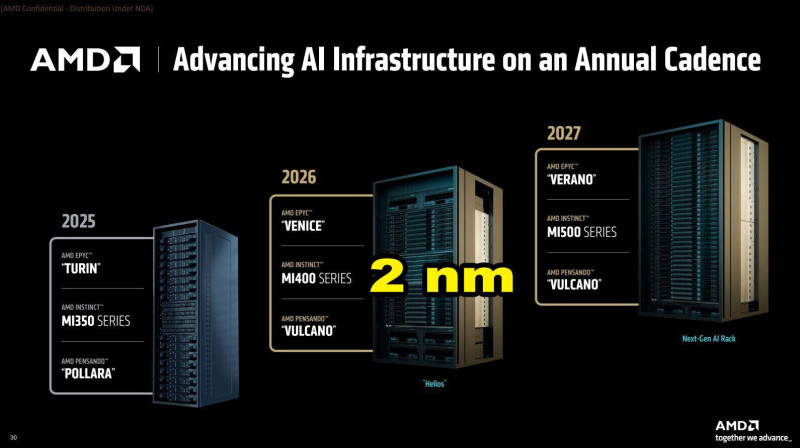

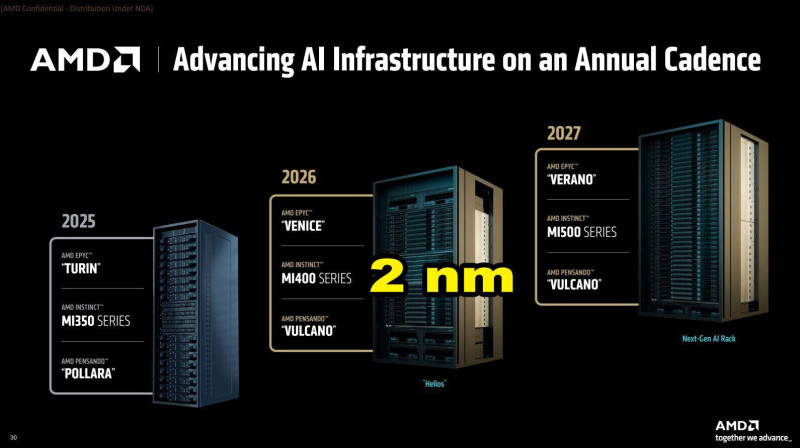

Az idén megjelenő MI400 vel az AMD all-in -t nyomott ...

és TSMC 2nm -en készül;TSMC N2P (2 nm)

- XCD (Accelerator Core Die)

TSMC N3P:

- AID (Active Interposer Die)

- MID (Media Interface Die)

-

DudeHUN

őstag

válasz

Busterftw

#51027

üzenetére

Busterftw

#51027

üzenetére

Nem hülyeség. Intel pont azért ment el kényszerből a hibrid irányba, mert nem voltak versenyképesek az AMD-vel szemben hatékonyságban. Ezért kényszerpályára kerültek, amíg nem változtatnak úgy, ahogy az AMD csinálta anno.

E és LPE magok nélkül nagyon le lennének maradva. P magok nélkül meg teljesítményben.Nvidia más. 5090 kis undervolttal brutál hatékony cucc. Csak ők megtehetik, hogy ne legyen annyira fontos a fogyasztása a csúcs szegmensnek annyival előrébb vannak még.

-

Busterftw

nagyúr

Szerintem ez ilyen egyszeru.

Ez kb olyan mint amikor azon huledeznek a nepek, hogy nekik nem kell Nvidia 5090 XY fogyasztassal.

Amikor megkerdezem hogy az AMD ekkora teljesitmenyu kartyaja mennyit fogyasztana, akkor pedig csend van.

Persze nyilvan itt a teljesitmeny a ket CPU-nal ismert lesz.Egyszeruen hulyeseg ilyen formaban osszehasonlitani a kettot.

-

S_x96x_S

addikt

> Tudtommal lesz az AMD-nek Threadripperje, nem a PRO,

> hanem a normál a következő körben, és abban 96 mag lesz,

ott már az új XEON -ok ( AVX512,AMX ) is versenyeznek.

( 4 és 8 csatornás verzióban )

https://prohardver.hu/hir/intel_xeon_600_szorongatna_meg_amd.htmlés AMX képesség nem lesz még a zen6-os magokban.

-

Abu85

HÁZIGAZDA

válasz

proci985

#51020

üzenetére

proci985

#51020

üzenetére

A gyártási költség biztos, de valószínűleg azért tudnak rajta hagyni elég hasznot így is. Azért az AMD ma már jóval magasabb haszonkulccsal dolgozik, mint az Intel, így nyugodtan számíthatnak arra, hogy annyira magas áron fogja az AMD is adni a sajátját, hogy azt szimplán lekövethetik, és nem lesz veszteségük.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#51021

üzenetére

Busterftw

#51021

üzenetére

Ez nem ilyen egyszerű. Az Intel azért csinál most 52-magos CPU-t, mert nincs Hyper-Threading a P-magban. Tehát ahhoz, hogy nekik 48 darab szabadon felhasználható száluk legyen, fizikailag is kell ennyi P- és E-mag. Az LPE-magok ugye a rendszerfolyamatokra vannak, tehát azok ideális esetben nem kapnak a programoktól feladatot. Az AMD viszont tud csinálni 24 magból 48 szálat, mert nekik SMT-s a magdizájnjuk.

Tehát a programoknak rendelkezésre álló szálak számában ugyanott lesznek, csak az Intelnek ehhez fizikai magok kellenek, és nyilván ebben a formában a saját konstrukciójuk energiahatékonysága el fog maradni attól, amit el lehetne érni például Hyper-Threadinggel, ha volna. Valószínűleg ezért mondta Lip-Bu Tan, hogy ne foglalkozzanak a fogyasztással, mert most már kellene valami olyat mutatniuk, hogy teljesítményben nem az előző generációs AMD dizájnokat célozzák.

Tudtommal lesz az AMD-nek Threadripperje, nem a PRO, hanem a normál a következő körben, és abban 96 mag lesz, vagyis 192 szál, de annak a teljesítménye nagyságrendekkel jobb lesz. A TDP-jét 350 wattra tervezik, mert itt is limitál a platform, ami nem lesz új, csak a mostani alaplapokhoz jön egy új BIOS. Emiatt a 350 watt még mindig a Nova Lake TDP-je alatt lesz.

Ebből a szempontból egyébként az Intel kifejezetten realista. Tudják, hogy amíg kis-nagy magoznak, addig nekik el kell engedni a fogyasztást, mert a koncepció, amit alkalmaznak nem alkalmas arra, hogy hozzák a Zenek energiahatékonyságát. 2030-ra jön a váltás, amikor úgy fognak dolgozni, ahogy az AMD csinálja mag. Vagyis lesz egy alapmag, ami pont jó teljesítményű lesz, és annak lesz kétféle verziója, de ezek már fizikailag nem eltérő magok, csak eltérően lesznek implementálva, tehát az órajeltartományuk más lesz. Addig viszont marad az E-mag és P-mag, és az ezzel járó szívás. Azt is tudni, hogy az új, egységes magot azok tervezik, akik az E-magot, tehát az Intel a P-magot tervező csapatot feloszlatta. Ez szintén nagyon helyes döntés, mert a cég gondja alapvetően az, hogy a P-mag energiahatékonysága sokkal rosszabb az E-magénál.

Igazából az Intel gondja hasonló, mint az AMD-nek a Bulldozernél. Akkor az Intel fő előnye az volt, hogy egy maggal oldottak meg két szálat, míg az AMD fizikailag is dedikált feldolgozókat rakott a szálak mögé, aminek a hatékonysága rosszabb volt, hiába raktak a lapkába kétszer annyi magot. Az a helyzet, hogy a jelenlegi fizikai limiteket tekintve az az optimális, ha a szálak mögé nem mindig raksz fizikai erőforrást. Működni fog persze, ha megteszed, csak ahogy a Bulldozernél, illetve az Intel mostani hibrid dizájnjainál, a fogyasztása messze nem lesz arányban a leadott teljesítményével. És ahhoz, hogy tartsák a lépést azokkal a dizájnokkal, amik se nem lassú, se nem gyors, hanem pont jó teljesítményű magokat használnak, el kell engedni a fogyasztást.

-

Busterftw

nagyúr

"Tehát az Intel simán megengedheti magának a 400 wattos TDP-t, amit terveznek az LGA-1954-re, szemben az AMD 170 wattjával, amit a Socket AM5 tartósan elbír."

Nyilvan teljesen mas a matek egy 52 magos es egy 24 magos CPU-nal.

Mennyit fogyasztana az AMD 52 maggal ilyen felbontasban? -

Abu85

HÁZIGAZDA

válasz

Busterftw

#50981

üzenetére

Busterftw

#50981

üzenetére

A Socket AM5 tokozású AMD CPU-k PPT limitje 230 watt körüli. És itt nincs olyan, hogy ezt feloldhatnád, mert ez bele van tervezve a processzorba.

Mivel a Zen 6 is ugyanebbe a tokozásba jön, így ennek is ez lesz a felső határa. Az AMD-nek muszáj igazodniuk a mostani alaplapok specifikációihoz, nincs olyan mozgásterük, mint az Intelnek, hogy az új tokozással új határokat szabnak majd meg. Viszont ez az alaplapgyártók szerint nem jelent különösebb gondot, mert még 120 watton belül is képes tartósan 5 GHz-et hozni a Zen 6. Ez volt a projekt legfontosabb fejlesztése, hogy plusz 1-1,5 GHz-cel tudjanak gazdálkodni a fogyasztás növelése nélkül.

Az Intelnél a változást az teszi lehetővé, hogy egyrészt új tokozást hoznak, amire új specifikációkat lehet szabni, így el lehet vinni a követelményeket 700 wattig is, másrészt Lip-Bu Tan kiadta a parancsot, amikor még kinevezték, hogy nem érdekli mekkora fogyasztásból, de hozni kell a teljesítményt, mert az nem jó, hogy úgy néz ki az Intel a tesztekben, mintha egy-két generációval le lenne maradva. És ebben egyébként van ráció, mert a fórumokban jellemzően linkelt tesztekben nem mutatják azt, hogy mennyit fogyaszt az adott proci. Tehát az Intel simán megengedheti magának a 400 wattos TDP-t, amit terveznek az LGA-1954-re, szemben az AMD 170 wattjával, amit a Socket AM5 tartósan elbír. És elvileg az előzetes tesztekben ez elég jól mutat, mert a Nova Lake nagyon közel van a Ryzen 9850X3D-hez a játékokban, bár az alaplapgyártók szerint még nem veri meg, viszont ez tisztán abból eredhet, hogy a mostani Windows 11 ütemező nem kezeli jól a Nova Lake ötsebességes magcsoportosítását, amit az is mutat, hogy ha kényszerűen csak arra a négy egymás melletti P-mag klaszterre korlátozzák a futtatást, ami a leggyorsabb magcsoport akkor a hardver gyorsul, és így már pár százalékkal megveri a Ryzen 9850X3D-t is.

Ezt a részét majd nagyon sokat kell fejleszteni a Nova Lake-nek szoftveresen, mert teljesen más jellegű ütemezést igényel, ugyanis a Windows 11 arra van szabva, hogy két nagyon eltérő teljesítményű magcsoportot kezel nagyjából jól. Na most a teljes Nova Lake-ben lesz 4 LPE-mag, 16 alacsony prioritású E-mag, 16 magas magas prioritású E-mag, 8 alacsony prioritású P-mag és 8 magas prioritású P-mag. Ez annyira extrém kiépítés, hogy még a programok oldalán is módosítások kellenek, hogy jól működjön, tehát nem elég csak a Windows 11-et rászabni. Egyszerűen direkt támogatás kell, hogy a fejlesztő jelezze az OS-nek, hogy melyik feladatot melyik magcsoportra szánja, mert túl nagy a tévedés lehetősége.

-

Abu85

HÁZIGAZDA

Tudtommal - és ez eléggé jó helyről származó infó - az AMD kétféle CCD-t csinál a Zen 6-ra. Az egyik a normál Zen 6 CCD, amiben 12 mag és 48 MB-os L3 cache lesz. A másik elvileg a Zen 6c CCD, amiben 32 darab Zen 6 mag lesz, de nem tudni az L3 cache pontos kapacitását, viszont valószínűleg 64 vagy 96 MB lehet.

Ezek eltérő 3D V-Cache lapkát is kapnak, mert a mostanit mindenképpen át kell tervezni a Fan-out átalakítás miatt. Ezek pontos kapacitása sem ismert, de a kicsi verzióra 96 MB-ot, a nagyra pedig 256 MB-ot mondanak. Valószínű, hogy így jön ki a 2,5 GB-os L3 cache a HPC EPYC-re, amiről szintén van pletyi. -

proci985

MODERÁTOR

Persze, meg a medencét is azzal fűtöm meg nekem is van kint egy hőcserélő.

PCnél egyébként pár gyártónak még van chillerje, de a problémák (páralecsapódás, fogyasztás) nem nagyon tudok olyanról, aki használna. Talán a vízhűtéses topikban volt utóbbi években egy ember aki próbálkozott vele,

-

S_x96x_S

addikt

Kiváncsi vagyok - hogy az NVIDIA N1 mikor jelenik meg.

Nem árt egy kis verseny ...Microsoft says Windows 11 26H1 is for Snapdragon X2, no mention of NVIDIA N1

-

S_x96x_S

addikt

válasz

Raymond

#51007

üzenetére

Raymond

#51007

üzenetére

köszi;

Valószínüleg a GLM-Image -ből általánosíthattak a GLM5-re,

2026-Jan-14:

"The company, also known as Zhipu, said Wednesday in a statement that its open-source image generation model, GLM-Image, is the first state-of-the-art multimodal model to complete training using Huawei Technologies Co.’s Ascend chips.

Zhipu’s model was based on Huawei’s Ascend Atlas 800T A2 server and MindSpore framework, according to the statement. The server carries Huawei’s Kunpeng-branded processors and Ascend-branded AI chips." Blomberg-2026-Jan-14 -

S_x96x_S

addikt

érdekesség:

A GLM-5 - teljesen Huawei Ascend - en lett tréningelve;

vagyis a kínaiak tényleg komolyan dolgoznak az nvidiáról (nyugati technológiáról) való levállásról."In a strategically significant move, GLM-5 has been trained entirely on Huawei Ascend chips using the MindSpore framework, achieving full independence from US-manufactured hardware. This positions GLM-5 not only as a technical achievement but as a milestone in China's drive toward self-reliant AI infrastructure — and a direct challenger to models such as OpenAI's GPT-5 and Anthropic's Claude.

" https://glm5.net/ -

Alogonomus

őstag

válasz

Busterftw

#51000

üzenetére

Busterftw

#51000

üzenetére

Az is lényeges kérdés, hogy a Nova Lake előállítási költsége hogyan alakul, mert minden bizonnyal drágábban lesz gyártható a:

- valamilyen leosztásban Intel 18A-n és TSMC 2nm-en készülő 2 Compute Die, 1 Hub Die, 1 Platform Controller Die, 1 iGPU Die elemekből "összelegózott" 52 szálas Nova Lake processzor,

- mint a 2 db TSMC 2nm-es CCD és 1 db TSMC 3-4-5 közül valamelyiken legyártott IO-die együtteséből "összelegózott" 48 szálas Zen6.Zen6 esetén a die area már kiszivárgott. A CCD az a videocardz oldalon is szereplő 76 mm², az IO-die pedig elvileg 155 mm².

A Nova Lake esetén pedig a videocardz alapján akkor a Compute Die 150 mm², és ha ez az ábra méretarányos, akkor további kb 150 mm² lesz a Hub Die, meg olyan további mondjuk 60 mm² és 40mm² a PCD és az iGPU.Az biztosan lényeges költségkülönbséget okoz, hogy a Nova Lake így nagyjából 500 mm²-nyi cutting edge és így drága wafer kapacitást igényel majd, míg a Zen6 csak 150 mm²-nyi cutting edge wafer kapacitást igényel, míg a másik 150 mm²-nyi lapka lényegesen olcsóbb TSMC gyártósoron készülhet hozzá.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Fejhallgató erősítő és DAC topik

- Beleremegett Hollywood Brad Pitt és Tom Cruise AI harcába

- Luck Dragon: Alza kuponok – aktuális kedvezmények, tippek és tapasztalatok (külön igényre)

- Allegro vélemények - tapasztalatok

- Napelem

- Linux kezdőknek

- gban: Ingyen kellene, de tegnapra

- AMD Ryzen 9 / 7 / 5 9***(X) "Zen 5" (AM5)

- Milyen autót vegyek?

- Luck Dragon: Asszociációs játék. :)

- További aktív témák...

- HP ZBook Studio G8 i7 32GB RAM 1TB SSD RTX A3000/Garancia

- MacBook felvásárlás!! MacBook, MacBook Air, MacBook Pro

- GYÖNYÖRŰ iPhone 13 256GB Midnight -1 ÉV GARANCIA - Kártyafüggetlen, MS4447, 100% Akkumulátor

- GYÖNYÖRŰ iPhone 14 Pro Max 128GB Deep Purple - 1 ÉV GARANCIA -Kártyafüggetlen, MS3702

- HIBÁTLAN iPhone 15 Pro 128GB Natural Titanium -1 ÉV GARANCIA - Kártyafüggetlen, MS4226

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: Laptopműhely Bt.

Város: Budapest

DigitalFoundry-nál is feltűnően ki van írva, ennél például:

DigitalFoundry-nál is feltűnően ki van írva, ennél például:

![;]](http://cdn.rios.hu/dl/s/v1.gif) / X8670E Taichi / 2x 16GB DDR-6000MT/s / WD_BLACKSN850X ]

/ X8670E Taichi / 2x 16GB DDR-6000MT/s / WD_BLACKSN850X ]