- Apple iPhone 17 Pro Max – fennsík

- „Új mérce az Android világában” – Kezünkben a Vivo X300 és X300 Pro

- Netfone

- iPhone topik

- Google Pixel 9 Pro XL - hét szűk esztendő

- Telekom mobilszolgáltatások

- Fotók, videók mobillal

- Motorola Edge 50 Neo - az egyensúly gyengesége

- Határtalan erő - szabadjára engedve

- Samsung Galaxy S25 Ultra - titán keret, acélos teljesítmény

Új hozzászólás Aktív témák

-

gV

őstag

-

huskydog17

addikt

DF videója a PS5 verzióról.

Bizony, a játéknak vannak gondjai, a motor inkább visszafejlődött a FF XV óta, az AMD Fidelity FX csomag úgy tűnik elég pocsék minőséget ad konzolon is, az AO annyira rossz, hogy a sok éves DX 11-es VXAO jobb minőséget ad.

Ezen felül ha a textúrát High-ra rakod, akkor a motor kb. Quake 2 szintű textúrákat ad 8 GB VRAM mellett, mert High beállításhoz legalább 12 GB VRAM kell, továbbá kameramozgatásnál meghülyül a frametime.

Amúgy szerintem Frey haja egészen jó, legalábbis 4K YT videón keresztül gameplay és átvezetők alatt jónak tűnik, számomra abszolút meggyőző, de lehet, hogy a veszteségmentes képen nem annyira szép, ezt nem tudhatom. A játék elején a macsek viszont nagyon jó lett.Persze az is tény, hogy a DirectStorage 1.0 működik benne, mert veszettül gyors a betöltés, de kérdés, hogy vajon megérte-e az emiatt masszívan megnövekedett VRAM igényért cserébe. Szerintem nem, én arra tippelek, hogy a játékosok többsége inkább várna még néhány plusz másodpercet a szebb textúrákért cserébe.

Ezért a fos PC portért kér el a Square Enix 80 eurót. Szép, még szerencse, hogy engem messze nem érdekel annyira a játék, hogy pénzt adjak érte, egy videósnál kezdtem el nézni a játékot 4K-ban. A játéknak sok gondja van, amire számítani lehetett, hiszen a japánok nem nagyon tudnak PC-re fejleszteni (Capcom kivétel), emiatt engem ez a pocsék PC port nem lep meg. Az is várható volt, hogy a Square Enix-nek sokkal nehezebb dolga lesz PC-n, miután elment tőlük a Nixxes. -

Petykemano

veterán

Állítólag...

Míg korábban az 5nm-es gyártástechnológiára túljelentezés volt, addig most már kezd beesni a gyártókapacitás kihasználtsága 70% alá.

[link]Nem teljesen egyértelmű, hogy ez a kurrens kapacitásra vonatkozik-e visszamondások miatt, és a tsmc a következő hetekben allokálhat kedvezményes áron másoknak, vagy a következő 1-2 évre érvényes foglalásokra kell érteni.

-

Petykemano

veterán

Tartok.tőle, hogy az olcsóbban gyártható érvet kinullázta a váratlan teljesítményhiány.

Ha a 7900XTX valóban a 4090 körül teljesítene, igaz lenne az olcsóbb gyárthatóság.

De azt kétlem, hogy az n31 olcsóbb lenne az AD103-nál.Ami a készleteket illeti, én nem látom, hogy folyamatosan csökkenő árakkal egyre kétségbeesettebben próbálnának túladni a prevgen készleteken. Lehetne azt mondani, hogy szép nyugisan várakoztatják az új szériát, de a régi szériánál is felmerült, hogy a raktározás elég drága ahhoz, hogy bizonyos ár alatt inkább megérje elégetni, mint még fél évig tárolni, amíg el nem fogy. Ugyanez nyilván a felhalmozott/visszatartott új kártyákra is érvényes.

Én két dologra tudok gondolni:

- egy ilyen lapka megtervezése és piacra dobása - figyelembe véve azt, hogy mennyi mindennek lesz ugyanez építőkőve - igazából bagatell összeg. Vagyis a fix költségek.annyira kicsik így kártya árába beépítve, hogy nem éri meg azon gondolkodni, hogy volumen növeléssel növeljék a megmaradó pénzt.

- csak a margó számít, a profit volumene nem érdekes. Ezért nem érdemes 2-3x nagyobb keresletre hajtani, mert hiába lenne abból mondjuk kétszer akkora összegű profit, ha közben a margó mondjuk 40% helyett csak 20%. -

Petykemano

veterán

"Most ezek után ha szerinted a 7900XT 899$ árán nem fanyalgott senki akkor a 4070Ti kb hasonló teljesítményén fog majd sopánkodni valaki 799$ áron?"

Amilyen véleményeket én láttam ezzel kapcsolatban az alapján nekem az jött le, hogy azért nem fanyalog senki, mert a $899 annyira irreálisan közel van a $999-hez, ami ráadásul az árnövekményt meghaladó teljestíménynövekedést jelent, hogy kábé senkinek meg sem fordult a fejében, hogy $899-es 7900XT-t vegye.

Nekem úgy tűnt, eléggé egységes az álláspont, hogy a $899-es 7900XT valójában egy decoy product"Ezzel az árazással ( meg a hűtő balhéval) AMD előkészítette a terepet a kártyának. ( Mond hogy ezek után is kétségeid vannak a két cég összejátszásáról. Mindkét kártya azonos, 899 dolláros áron jött volna."

Azt nem feltételezném, hogy az AMD szándékosan bénázott volna. Ha egy 4090 körül mozgó termék jött volna $1000-ért, amit vártunk, akkor talán most elégedettek is lehetnénk a versennyel.

A hangsúly persze az $1000-on van. Ám abban az esetben nem biztos, hogy annyi is lett volna. Ezzel a teljesítménnyel ezekkel az árakkal ($899, $999) sem vagyok megelégedve az AMD-től. Szokás szerint az történt, hogy az Nvidia emelte az árakat, az AMD pedig úgy követte, hogy a megemelt árú termékek összehasonlításából itt-ott némi jóindulattal némileg pozitívan jöhessen ki belőle.Nekem semmi kétségem nincs az összejátszással kapcsolatban. Ahogy Coreteks megfogalmazta, a "price fixing" jelenséghez (gondolom itt valami bírósági/jogi értelemben kell venni, tehát hogy ki lehessen mondani, aminek aztán lesz valamilyen versenyjogi következménye) nem szükséges az, hogy bizonyítást nyerjen, hogy füstös szobában egymásra kacsintva (vagy bármilyen más kommunikációs csatornán) előre egyeztették.

Általában az áremelést az Nvidia kezdi (ezt követi némi hőbörgés)

és általában az AMD-re terelődik nagyobb figyelem és felelősség, hogy versengnek-e vagy kooperálnak.Az a kérdés, hogy miért jutnak mindig arra a következtetésre, hogy nagyobb hasznot/előnyt, vagy jobb pozíciót eredményez, ha kooperálnak és igazítják az árakat az Nvidia által megszabotthoz, ami jobb margókat eredményez, de legjobb esetben is stagnáló eladást/részesedést és miért nem hozza ki azt a számológép, hogy ha beleállnak a versengésbe, akkor az a nagyobb volumen miatt jobban terítődő fix költségek eredményeképp eredményez nagyobb hasznot.

-

HSM

félisten

Én ezen a képen azt nem értem, hogy nem úgy volt, hogy valami speciális hővezető lesz rajtuk?

A tesztekben is más anyagúnak tűnik, lásd pl [link] . A hűtő aljának esetleges megmunkálási minőségét is említi, az övé sem volt tökéletes. Egyébként úgy tudom, ezeknél a vapor-chamberes hűtőknél ez ismert jelenség, azért is szoktak hozzá speciális pasztát vagy grafit padot használni, ami jobban tolerálja az egyenetlenségeket. -

Raggie

őstag

Ez a komment a Navi21-ről szól. Tehát igazából nem zárja ki azt, hogy ezekből tanulva az AMD most a Navi31-nél szigorúbb quality controllal vagy más gyártósori technikával jobb és konzisztensebb Ref kártyákat adjon ki a kezei közül... bár persze simán lehet még rosszabb is.

-

HSM

félisten

Erről a domború GPU-jú 3080/3090-ek jutnak eszembe, meg az AIB kártyák, amik a legsilányabb hővezető padokat használták a forrófejű GDDR6X-re. Kész üzletág épült fel ezen kártyák utólagos használhatóvá tételére, hogy ne throttlingoljon a 100+ fokon izzó memória miatt, mai napig megtalálhatóak pl. itt is az aprón az ilyen szolgáltatásokat kínáló hirdetések.

Én egyébként nem tartom problémának ezt a fajta carbon hővezető anyagot, számomra inkább előny, mivel saját tapasztalataim alapján egy jó minőségű nem marad el egy jó pasztától, sőt. A felületi egyenetlenségeket elméletileg még jobban tolerálja, mint a paszta, és ahogy említi az idézeted, nem romlik semmit idővel a teljesítménye.

Nekem egyébként nagyon tetszenek ezek a referencia hűtők, ahogy a 6800XT/6900XT hűtője is igen szimpatikus volt. Különösen jónak tartom az irányt, hogy nem 40 centi hosszú és 20 centi széles óriások, amikhez kb. már speciális házat kell venni, hanem józan, szűk 3 slot magas méretek, de abból igényesen megkonstruálva, hagyományos, bevált tápcsatlakozókkal.

A magyarázata, hogy a referencia mellett érvelek egy nem referencia (XFX Merc 319) 6800XT-vel az adatlapomon, hogy ezt sikerült a szimpatikus példányok listájáról beszerezni.

Eléggé ki is lett centizve a 34 centis hossza miatt, pedig nem pici a házam.

Eléggé ki is lett centizve a 34 centis hossza miatt, pedig nem pici a házam. -

-

HSM

félisten

No, valami ilyesmi arányt simán el tudnék fogadni, amit itt fejtegettek.

A driverre gondoltam én is, kíváncsi vagyok, hoz-e majd javulást.#45863 Raymond : A Turing-nál nem lep meg, korábban többször volt róla szó, hogy vannak azért szűk keresztmetszetei RT-vel, aminek látszottak azért jelei is. Persze, a Radeonokon is, de azért nem ilyen meredeken.

-

huskydog17

addikt

NVIDIA Responds to Melting Cables, Warranty Concerns, & 12VHPWR Adapter Failures

Ha jól értem, a zöldek minden problémás kártyát cserélnek garanciában, annak ellenére, hogy nem ők tehetnek az egészről. A szabvány egyszerűen nem lett kellő mértékben "hülyebiztosra" tervezve.

-

Jacek

veterán

Igen ez egy , erre válaszoltam , majd össze mostad a válaszoddal. hagyjuk.. Volt a kezedben ilyen kártya?

Ezt ide rakom neked, ha kiszedtem csinálok a TUF és a SuprimX viszonyáról képet neked.Ezt ide rakom azért

[link] 6:45

[link] 6:45

-

Petykemano

veterán

De akkor elég lett volna a 4090Ti-re rárakni ezt a hűtést, nem?

Mondjuk a 3090 hűtése is elég lehetett volna nagyjából. Nem?Én inkább azt gyanítom, hogy az Nvidia nem tudta a legelején, hogy pontosan hol fog landolni az RDNA3. Magában az AD102-ben van még kb 10% CUDA és a fennmaradó 25% L2$. Szerintem a fennmaradó TBP-t a letiltott részek fogják majd kihasználni. Csak nem tudták előre, elkészítették a hűtőt és annyi letiltást eszközöltek a végén, amennyi az Navi31 meggyőző legyőzéséhez szükséges.

Abu mondott valami ilyesmit a TUL vagy Compal-os kontaktjától, hogy az AMD "lastminute" engedte el a 450W-os kártya lehetőségét. Lehet, hogy nem volt annyira lastminute, mint azt Abunak megüzenték. Mivelhogy más források arról számoltak be, hogy a frekvencia skálázása nem lett jó, azért nem megy 2.5Ghz fölé és kell egy respin.

Tehát lehet, hogy amikor az NVidia ezt megtudta, akkor már készen álltak a 4090 kártya 450W-os designjai (+ a 600W-os a 4090Ti-hez) és lastminute már nem tudtak változtatni a hűtőn, ezért letiltottak annyit, amennyi elegendő és elengedték a 600W-os kártya gondolatát.

-

huskydog17

addikt

Igen.

"GPU decompression is supported on all DirectX 12 + Shader Model 6.0 GPUs."

Ezen felül speciális GPU optimalizálásokkal még több sebességet lehet nyerni:

"However, one of the benefits of DirectStorage 1.1 is that GPU hardware vendors can provide additional optimizations for their hardware, called metacommands."

Az Intel csinált egy konkrét mérést az Arc A770-el, ami majdnem 3× volt gyorsabb kicsomagolásban, mint egy Core i9-12900K. Ez pedig még csak az első lépcsőfok. Ígéretes.

Az NVIDIA mérései és blog bejegyzése itt található, míg az AMD bejelentése itt.

-

Jacek

veterán

Nem tom en beraktam valos arakat 4080 Strix OC 2000 euro de nem hiszik el az emberek

Lesz Feleki Kamil par nap mulva

Lesz Feleki Kamil par nap mulva

A TUF nonOC- nak van rendes ara 1550 euro, na abbol probaljatok majd venni legyartottak mar oszagonkent a 15 darabot. TUF OC 1875 euro. Mondjuk a svedek sosem a olcsosagukrol voltak hiresek meg a szurke se megy nagyon

-

Devid_81

félisten

Csodalatos valasztas lesz $1200-ert

![;]](//cdn.rios.hu/dl/s/v1.gif)

NVIDIA GeForce RTX 4080 gets tested in Geekbench, 30% to 37% faster than RTX 3080

-

-

Dtomka

veterán

Igen tudom, hogy egy lábon állnak. De azért valljuk be nem jó az irány amit mutatnak vagy amifele viszik ezt a szegmenst. Most, hogy az Intel is beszáll a "játékba" (amire már régóta vártunk, hogy legyen több "résztvevő") ezáltal előbb vagy utóbb stratégiát kell váltaniuk.

Mert ha ezt az irányt követik, akkor szerintem sokan a másik 2 gyártó által kiadott vga-k között fogják megtalálni ami számukra megfelelő és szükséges.

De tudjuk jól idővel minden kiderül.

-

Dtomka

veterán

Lehet rossz példát hozok fel de mégis megteszem. Az INTEL éveken át morzsákat dobot nekünk, mert elég az nekik - gondolták. Lefordítva "alig" növekedett a teljesítmény az előző genhez képest mégis mindenki hajbókolt.

Az NVIDIA szerintem átesett a ló túloldalára. Brutál teljesítményt mindenáron elv lett a fő céljuk. Lehet ezt azért teszik mert látják, hogy a piros kis csapat évről évre egyre jobb és ettől félnek ennyire? Ezért nem számít ha leég a vga, biztosan a user elhajlította vagy nem jól csatlakoztatta a tápcsatit.

Ejj azért ha hibázik az ember (ez esetben cég) akkor azt lássa be. Tanuljon belőle és az által fog fejlődni javulni. Szóval csak azt szerettem volna átadni, hogy van amikor az alig fejlesztés sem jó, de a túlzott sem. Fokozatosan és szem előtt tartva a hatékonyságot, számomra ez a legfontosabb dolgok egyike. (A melom során is ezt vallom és teszek is érte nem csinálom meg 3x ugyanazt a melót mert 2. alkalommal már a makrót írom )

) -

Dtomka

veterán

Ettől függetlenül még lehet, hogy tényleg tudni fogja amit látunk. És ha igaz lesz akkor nem értem miért nem TI jelzésű?! Mert még a házon belüli előző gen. legerősebb tagját is sokszorosan felülmúlja.

Olvastam a TI-t még ezek után "akarták piacra dobni". Hova, minek és kinek? A tápcsati problémák (és az áram drasztikus drágulása) miatt tuti egy ideig nem lesz 4090TI. Bár nem is én vagyok a célközönség

-

Dtomka

veterán

Legalább de egy tölgyfába vésték volna hihetőbb lenne...

Megnéztem, és volt aki kételkedett, hogy 4x nagyobb teljesítménye lenne mint a 3090TI-nek.

És ez így 100% -ban hivatalos? Mert majd ezekután nem grafikonokat hanem excel táblázatokat fogunk látni a gpu-k review oldalain.

-

Yutani

nagyúr

Arm is anti-competitive and monopolistic!

Arm Changes Business Model OEM Partners Must Directly License From Arm

No More External GPU, NPU, or ISP’s Allowed In Arm-Based SOCs After 2024

Kills Samsung AMD GPU licensing dealTehát csak az ARM-től származó GPU-t lehet majd a designba tenni, ha jól értem. Azok melyikek? Mali?

Mit jelent majd ez a piacon vajon? Nincs rálátásom, most hogy mennek a dolgok.

-

Yutani

nagyúr

i9 13900K vs R7 5800X3D - RTX 4090 | 10 Games Test

Asszem, ez eldőlt. Új platformra kell váltaniuk a tesztelőknek.

-

Yutani

nagyúr

Persze, egyrészt vannak gondok az interconnecttel, másrészt a GPU-kkal, meg még akármi mással is, amit nem részleteznek. Írta is az ember, hogy ilyen projekteknél szoktak gondok lenni, főleg, ha ilyen volumenű a dolog. Tehát igazából nincs itt semmi látnivaló, csak fel lett fújva a dolog.

-

Yutani

nagyúr

Hivatkozott InsideHPC cikkből, fordítóval:

Whitt nem volt hajlandó a Frontier jelenlegi kihívásainak nagy részét az Instinct GPU-k működésére fogni. "A problémák sok különböző kategóriát érintenek, a GPU-k csak az egyiket."

"Sok kihívás ezek körül összpontosul, de nem ez a kihívások többsége" - mondta. "Elég jól eloszlanak az alkatrészhibák gyakori okozói között, amelyek nagy szerepet játszanak. Nem hiszem, hogy ezen a ponton sok aggodalomra adnának okot az AMD termékek. Sok olyan korai életkori jellegű dologgal van dolgunk, amit már láttunk más, általunk telepített gépekkel, szóval ez nem túl szokatlan."

Abu elfogultságában nem említi az AMD-t, de nem is az AMD GPU-k a kizárólagos, vagy akár csak legfőbb hibaforrás.

-

Petykemano

veterán

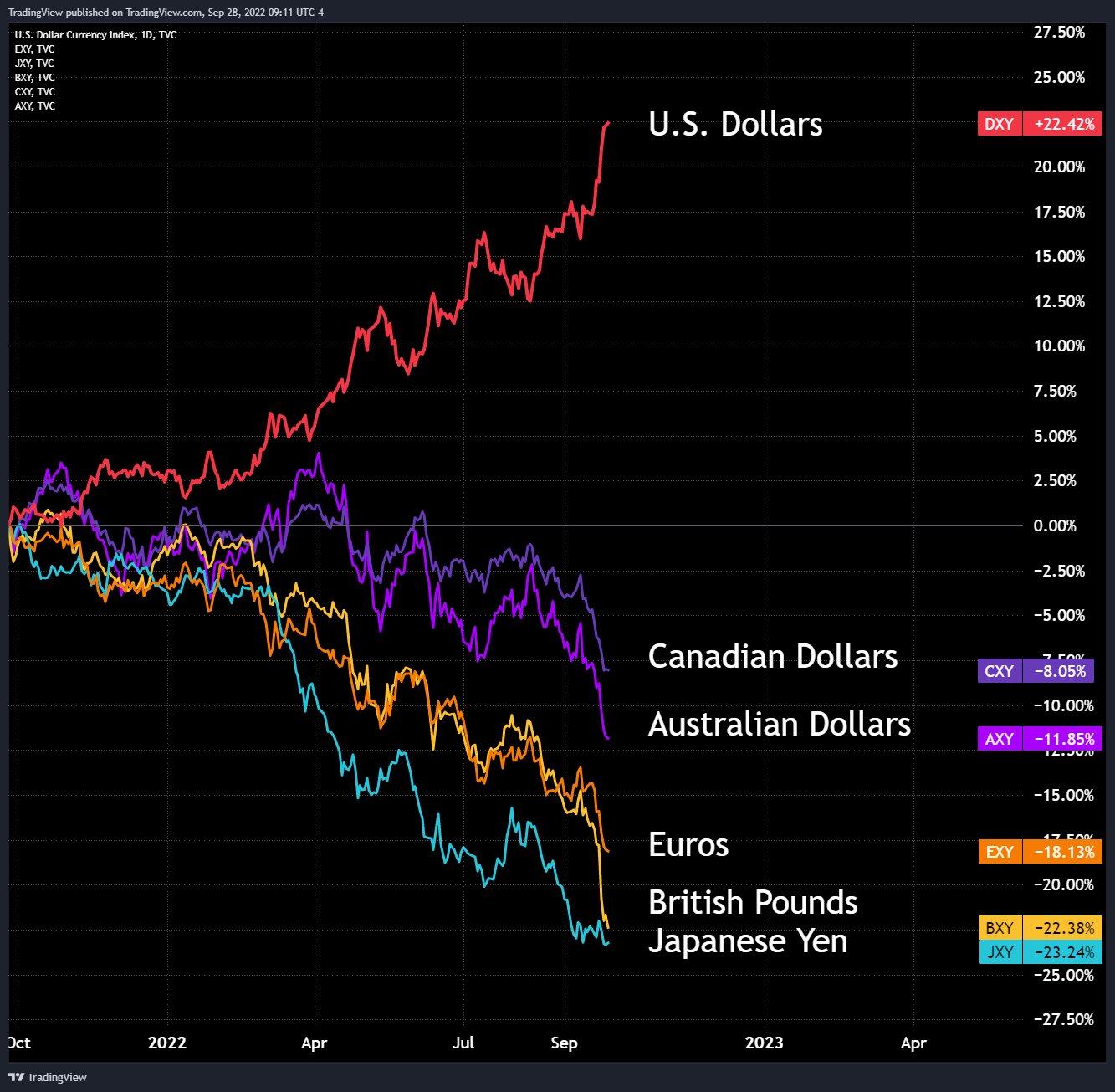

Nem tudom, hogy mennyire pontos/hiteles, de egy ilyen ábrát láttam ma:

A google szerint az USD viszonya a kínai Yuan-nal is hasonlóan változott. Az első negyedévben $1 még Y6.4 volt, most épp Y7.1, tehát valahol ott tartanak, mint a CAD/AUD

A google szerint az euró árfolyama $1=E0.86 volt 1 éve, most $1=E1.02

Az szám szerint 18%-os esést jelent a dollárhoz képest.

Ezt csak azért számoltam ki, hogy segítsen az ábraértelmezésében. Tehát az ábrát nem úgy kell értelmezni, hogy a dollár felfelé ívelő grafikonja és a többilefelé ívelő grafikonja közötti távolság a tényleges értékcsökkenés, hanem a lentiek a dollárhoz képest, a dollár pedig kitudja mihez képest 22%-kal értékesebb.Összehasonlításul:

1 éve $1=310Ft, most $1=430Ft => ez 38%-os értékvesztést jelent. Magasan a legsúlyosabb. (Az okokról beszélhetnénk, de szétfeszítené még az offot is.)De e amúgy a dollárban számolt eszköz árak is magasak, amit az elmúlt 1-2 év emelekdett költségeivel és az általános inflációval, valamint az új technológiák (DDR5, Pcie5) magas bevezetései költségeivel lehet magyarázni, de akkor is rátesz egy lapáttal.

Megkockáztatom, hogy esetleg valamikor valamilyen módon beavatkozni lesz kénytelen az USA kormányzat/FED, mert nem biztos, hogy olyan jó nekik, hogy a megerősödő dollár / dollárhoz képest gyengülő világdevizák miatt nem tudnak exportálni.

-

zsid

senior tag

Ez nekem nem világos. Azért van enkóder a GPU mellett, hogy ne kelljen a processzort használni. Eddig sem terhelte a régebbi NVENC sem a processzort, de még az AMD enkóderei sem. GTX1070-nel is simán tudtad tolni a 4K H264 streamet, nem kellett hozzá erős processzor.

Az AV1 bitrátája azonos minőség mellett pont alacsonyabb, mint a H264/H265 bitrátája, jobban tömörített az anyag. Ezért fér bele ugyanabba a sávszélességkeretbe magasabb felbontású AV1 stream, mint H264.

Az NVENC simán nyomja real-timeban az anyagot. Azért van a fenti táblázatban is, hogy 1 enkóder chip 3 sessiont tud kiszolgálni ( ennyire vannak korlátozva a desktop kártyák ), de ez szerintem inkább a párhuzamos enkódolásra vonatkozik. Ilyen a 7gen NVENC 30Mbit H264-nél(felvételre beállítva, streamelni csak fele/negyed ekkora bitrátával tudsz):

A 8gen biztosan hatékonyabb ennél, de egy normál forrásnál szerintem teljesen felesleges a 2 "enkóderchip". Szerintem ide azért jött dupla enkóder, mert ezek a kártyák már alkalmasak magas felbontáson is sok FPS-t kitolni és a 8K60-hoz valamint a 4K120-hoz azért már valszeg kell a két enkóder. De "alacsony" felbontásra felesleges.

A HDR lehet más világ, de az ma még messze nem általános. -

Busterftw

nagyúr

"This slide is arguably misleading at best. If you ignore the table and just look at the headline, it sounds like AMD delivers a massive increase in value — up to 90% more FPS per dollar! Except, that comparison uses the recent Radeon RX 6400 and pits it against the six-years-old GTX 1050 Ti, which also happens to cost more than the newer GTX 1650."

lol.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Vezetékes FEJhallgatók

- Audi, Cupra, Seat, Skoda, Volkswagen topik

- Semmibe veszi a KRESZ-t a Tesla Mad Max módja

- iPad topik

- 3D nyomtatás

- NVIDIA GeForce RTX 5070 / 5070 Ti (GB205 / 203)

- Milyen autót vegyek?

- Luck Dragon: Asszociációs játék. :)

- Xiaomi Mi Box androidos médialejátszó 4K és HDR támogatással

- BestBuy topik

- További aktív témák...

- Magyarország piacvezető szoftver webáruháza

- BESZÁMÍTÁS! Intel Core i7 4790 4 mag 8 szál processzor garanciával hibátlan működéssel

- BESZÁMÍTÁS! Asus H370 i7 8700K 16GB DDR4 512GB SSD RTX 2060 Super 8GB RAMPAGE Shiva A-Data 650W

- HP ZBook Firefly 14 i7-1165G7 16GB 512GB Nvidia Quadro T500 4GB 14" FHD 1 év garancia

- Honor 90 512GB, Kártyafüggetlen, 1 Év Garanciával

Állásajánlatok

Cég: NetGo.hu Kft.

Város: Gödöllő

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

,igaz 9900k-val

,igaz 9900k-val

Eléggé ki is lett centizve a 34 centis hossza miatt, pedig nem pici a házam.

Eléggé ki is lett centizve a 34 centis hossza miatt, pedig nem pici a házam.

![;]](http://cdn.rios.hu/dl/s/v1.gif)