- Vivo X200 Pro - a kétszázát!

- Milyen okostelefont vegyek?

- One mobilszolgáltatások

- „Új mérce az Android világában” – Kezünkben a Vivo X300 és X300 Pro

- Samsung Galaxy S25 Ultra - titán keret, acélos teljesítmény

- Samsung Galaxy S24 Ultra - ha működik, ne változtass!

- Nagyon ismerős a Nothing Phone (3a) Lite

- Samsung Galaxy S25 - végre van kicsi!

- Hat év támogatást csomagolt fém házba a OnePlus Nord 4

- Apple iPhone 16 - ígéretek földje

Új hozzászólás Aktív témák

-

Yutani

nagyúr

válasz

Crytek

#27993

üzenetére

Crytek

#27993

üzenetére

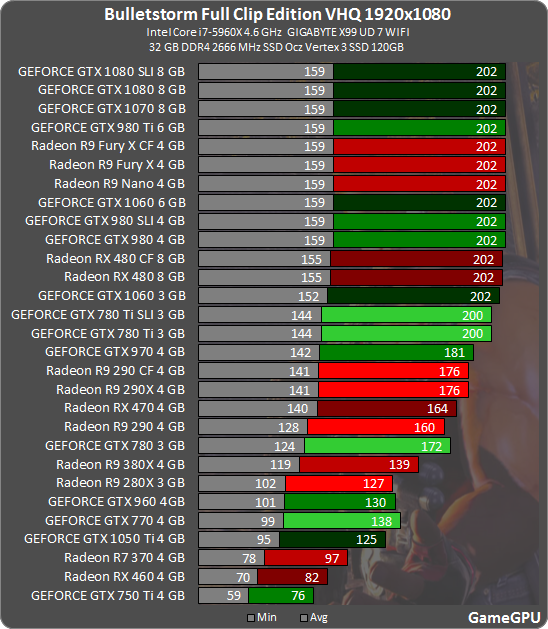

Ez egy fos. Mennyire reális a GTX 960 36FPS vs 380X 29FPS? Vagy a GTX 1060 58FPS vs RX 480 40FPS? Elárulom: semennyire. A szintén UE4 GOW4 bencmark alapján nevetséges ez a játék technikailag.

-

Petykemano

veterán

válasz

Crytek

#27993

üzenetére

Crytek

#27993

üzenetére

Ezt a játékot úgy/annyira optimalizálták - eddig . hogy 1080Ti@4K elérje a 60fps-t. Az nvidia kártyáira a megszokott módon szépen skálázódik, tehát fekszik az architektúrának. Az AMD nem skálázódik, ezért annak valószínűleg nem. Persze magas felbontáson nem ér el kellően magas fps-t, ami azért nem jó. Reméljük innen csak felfelé megy az út.

-

_drk

addikt

válasz

Crytek

#27921

üzenetére

Crytek

#27921

üzenetére

Az a 4k 32" ips 10 év múlva is fasza lesz! Az 1080 ti addigra gyűjtők polcain Max.

6 éves lett most az 590, múltkor volt egy teszt az 580ról hogy még el lehet vele játszogatni de a High beállításokat már nem szereti.

Jóbarátom a 10 éves 32" 720p-s tv-t nem tudja lecserélni mert a 4k még mindig felesleges és drága!

-

füles_

őstag

válasz

Crytek

#27163

üzenetére

Crytek

#27163

üzenetére

Ha jól emlékszem Abu azt mondta, hogy már a Volta is hardveresen fogja menedzselni a memóriát, szóval ott is sokkal hatékonyabb lesz e téren a rendszer és nem fog kelleni brutális mennyiségű memória. Ha ezt figyelembe vesszük akkor tuti fake, mert sokkal drágábbak lennének így az azonos kategóriájú NV kártyák.

Szóval az a találgatás a cikk végén nálam alapból azt sugallja, hogy fake az egész.

-

szmörlock007

aktív tag

válasz

Crytek

#27158

üzenetére

Crytek

#27158

üzenetére

Üdv

Nyilván a játékot két finn srác csinálja alacsony költségvetésből, ahhoz képest hihetetlen!!!

Nyilván a grafika egésze is szép de itt két dolog ami brutális. Egyrészt a felhőszimuláció+fények, másrészt a víz illetve víz alatti fénybeszűrődés azok amik szerintem sehol sem néztek még ki ilyen jól. -

-

távcsőves

senior tag

válasz

Crytek

#26962

üzenetére

Crytek

#26962

üzenetére

Nagyon röviden: szó sincs arról, hogy a dx12 milyen hatásal van a játékok grafikájára pl. Arról van szó a videóban, hogy az amd és nv gpu-k és driverek mekkora terhelést rónak a cpu magokra/szálakra és miért és főleg hogyan teszik ezt az új low level apikban és a régebbiekben (pl dx11). Levonja a következtetést a múltra, jelenre és a jövőre is, hisz a VEGA még nem jelent meg, és a RyZEN is nagyon friss. (Ha jól tudom még mindig várható ott optimalizáció OS szinten is. ) És akkor a lényeg, ebben semmi új nincs számomra, nv kitűnően oldotta meg a feladatott, míg az amd befürdött. Eddig, de az új apikban élre állt, és az új hardvereinél , Polaristól kezdve törekszik arra hardveresen is, hogy a régebbi api használata esetén is mérsékelje a cpu overheadet egy szálra. (Vagyis csak ott, mivel az új low level apikban erősen nyerésre áll ebben a kérdésben. Nem az abszolút fps számokról van szó!) De azért csak nézd végig, ha kell megállítod , visszatekered. Főleg a vége érdekes, de az eleje nélkül szerintem nem jó nézni, hisz kell hozzá, hogy megértsd a végét is.

Na jó, végül is ez a VS fórum, szóval khmm, említi, hogy az nv zsozsóval is igyekszik kezelni a helyzetet a játékfejlesztőkön keresztül, izé, nem teljesen az általános érdekeket szem elött tartva.

-

füles_

őstag

válasz

Crytek

#26960

üzenetére

Crytek

#26960

üzenetére

Azért mert az iparági nagyoknak (Intel, nVidia) nem érdekük a low level API-k terjedése. Nem érdekük, hiszen nem rendelkeznek olyan képességű hardverrel és szoftverrel, mint az AMD rendelkezik, ha a DX12-ről vagy a Vulkanról van szó.

A rendszereik a jelenlegi környezethez vannak igazítva (DX11), nem mint az AMD-é. Ergo ha visszafogják a fejlődést, akkor nekik sem kell fejleszteniük és az AMD-t is szép lassan tönkreteszik, ha nem készít olyan hardvert és szoftvert amivel beáll a nagyok közé, viszont ha ez megtörténik akkor tényleg teljesen lefagy a fejlődés.Sajnos az AMD túl kicsi ahhoz, hogy ezt a koncepciót egyedül véghez vigye.

-

Abu85

HÁZIGAZDA

válasz

Crytek

#26911

üzenetére

Crytek

#26911

üzenetére

Jól fog ez futni NV-n is. Az AMD-nek csak azért fut jól már most, mert nagyon jó a driverfejlesztési struktúrájuk, amit kialakítottak. Az az egy nagy csapat sok emberből áll, és nem csak az agyonreklámozott, hanem a fű alatt megjelenő játékokra is van bőven erőforrás, emiatt a Radeon Software-ben már van a játéknak profilja, ki vannak cserélve a shaderekben a tipikus operációk, meg a szokásos (ez bőven hoz úgy +15-20%-ot). Az NV-nek a csapata három részre van vágva, és ott a committeléssel keletkező bugok javítása is rengeteg erőforrást elvisz. Effektíve a feladatokra elérhető erőforrás tekintetében az NV-nek kevés az embere, mert rosszul van struktúrálva a fejlesztési folyamat. Ugyanaz a baj, amikor az AMD havi egy WHQL Catalystet hozott. Ezért ugyan az agyonreklámozott játékokhoz tudnak hozni profilt időre, de a csak simán megjelenőkhöz már nem. Lenne amúgy elég emberük rá, ha nem kellene egy bugot háromszor javítani sorban a három összevonás miatt, ez időben és emberi erőforrásban is háromszoros teher. Valószínűleg egy-két hét múlva kiadnak majd egy profilt a játékra, ami javít a teljesítményen.

-

Abu85

HÁZIGAZDA

válasz

Crytek

#23549

üzenetére

Crytek

#23549

üzenetére

Nyilván a DX12 kód erősen többszálú, így egy 8 magos procin nagyobb előnyt tud biztosítani a DX11 kódhoz, mint egy erősebb négymagoson. Pusztán a skálázás lehetősége miatt. Emiatt az egy szálú teljesítmény kevésbé domináns, mint DX11-ben, amiből minden rendszer képes profitálni. Hasonlóan viselkedhetnek a kevésbé erős négymagosok is.

Az Intel gyors négymagosával a skálázásból nyert teljesítmény kevésbé domináns, így inkább a hátrányok jönnek elő. A Frostbite alatt ez a GeForce-okat különösen érinti, mert a motor nem tud UAV-t menteni a root signature-be, illetve az NV egy extra másolásra kényszerül, amikor a compute shader adatot ír ki. Az AMD-t bekötési modellje jobban illeszkedik a DX12-höz, így nem zavarja, ha a root signature-ben nincs UAV, illetve a konstans puffer elérése pont ugyanolyan gyors, mint más pufferé, vagyis nem kell másolgatni a compute shader adatkiírását. Emiatt az AMD DX12 alatt gyorsulni tud a DX11-hez képest minden körülmény esetén.

-

keIdor

titán

válasz

Crytek

#23448

üzenetére

Crytek

#23448

üzenetére

De mennyi lehet a frametime? Olyan keveset beszélünk róla, pedig fontosabb lehet, mint a képkocka/másodperc.

Remélem egyszer eljutunk oda, hogy nem csak a Digital Foundry foglalkozik vele és méri le.Itt egy érdekes példa rá miért fontos: [link]

The Division: hiába ad jó fps értéket egy 1070 SLi meg egy Titan X Pascal is, kb. egyformát, ha egyszer az SLi-vel a frametime sokkal nagyobb. Tehát azzal darabosabb játékélményt kapsz, mint egy erősebb GPU-val.

Az AMD meg több játékban nem a jó frametimeról híres. Ezért is panaszkodnak annyian microlaggokra. Magas frametime... -

mlinus

őstag

válasz

Crytek

#23026

üzenetére

Crytek

#23026

üzenetére

pontosabban 1 magot terhel agyon - de ettől függetlenül használja a többit is, csak nincsen normálisan elosztva a load. i7-en orvosolható a core 0 letiltásával, ilyenkor sokkal jobban elosztja a load-ot a maradék 7 szálon. Így se tökéletes, de érezhetően gyorsabb és kevesebb a rángatás.

mindamellett alacsony a gpu kihasználtság is, 720p low és 4k ultra között nálam pl semmi különbség nincs fps számban

-

-

#85552128

törölt tag

válasz

Crytek

#23008

üzenetére

Crytek

#23008

üzenetére

Ugyanúgy fut, nem rosszabb pár FPS a különbség AMD-vel is Quantum Break: Better on DirectX 11! GTX 970/1060 vs RX 480 Gameplay Frame-Rate Tests

"Nvidia cards get a noticeable frame-rate boost (up to 33% on the GTX 970) with DirectX 11, but curiously AMD cards such as RX 480 run identically either way. Tom explains all."

Néha vannak anomáliák, hogy a GPU usage ingadozik, ennyit kéne javítani.

-

cyberkind

félisten

válasz

Crytek

#15212

üzenetére

Crytek

#15212

üzenetére

Persze, az se a Store hibája hogy csak partíciót adhatsz meg neki ahova tegye a játékot, és persze olyan nevet ad a mappának hogy qrva nehéz megtalálni a játékot, de ez csak egy a sokból, amivel nem lenne baj ha nem lenne fizetős konzolon a multijuk kb 15 éve, és egy fikarcnyit se értenének hozzá, pedig ez van mert fogalmuk sincsen milyen a jó kliens, ha nem lenne csak storeexkluzív ez meg az, még Windows-t se venne az ember, rég volt ekkora hulladék a M$.

-

daveoff

veterán

-

huskydog17

addikt

válasz

Crytek

#14938

üzenetére

Crytek

#14938

üzenetére

980Ti-vel te könnyen beszélsz, egy 7870-es Radeon kicsit más kategória.

Amúgy most megtaláltam a trükköt a sebesség visszanyeréséhez. A gond a V-Sync-el van összefüggésben, mert ha az be van kapcsolva, akkor a teljesítmény azonnal összeomlik, amint sok vegetációt kell kirajzolnia. Egész pontosan leesik fix 30-ra, ami nekem nagyon gyanús volt, így további teszteket és kísérleteket folytattam, míg megtaláltam a megoldást: mindössze a játék betöltése után egy Alt+Tab-ot kell nyomni majd vissza menni a játékba és kész, a sebesség máris normalizálódik. Ha nincs bekapcsolva a V-Sync, akkor nincs szükség Alt+Tab-ra, vagyis a játékban valószínűleg hibás a V-Sync kód, de legalább van egy működő Workaround, így most már a Redux változatot is 60 FPS-el tudom tolni maxon egy 7870-el. Not bad!

-

huskydog17

addikt

válasz

Crytek

#14932

üzenetére

Crytek

#14932

üzenetére

Csak nem erre a "gyöngyszemre" gondolsz? Ez egy olyan szintű kártevő, hogy a kutya se meri piszkálni, üresek a Steam fórumok és tesztek sincsenek róla, senki nem akar hozzányúlni. Ezt nem mondanám valami jó reklámnak.

Amúgy ahány UE4 játékkal találkoztam, mindenhol katasztrofális volt a teljesítmény akárhogy módosítottam a grafikai beállításokon, vagyis a skálázódás is szinte nulla. Például próbáltad a TVoEC Redux változatát? The Astronauts profikból áll, de még ők sem tudtak mit kezdeni az UE4 sz*r D3D11 leképzőjével.

Az eredeti, UE3-as változat full maxon 4×MSAA mellett 60 FPS-el megy, csak néhol esik le 40-50 környékére. A Redux változat (UE4) mindenféle élsimítás nélkül és visszavett grafikai részletességgel is kínkeservesen tudta tartani a 30-at. Amikor dinamikus (animált) vegetáció kerül a képbe, azonnal összeomlik a teljesítmény, ellentétben az előddel.Én inkább úgy mondanám, hogy ami alapból sz*r, azt adhatod bárkinek, nem lesz jó a végeredmény (hacsak át nem írják teljesen a leképzőt, ami egy indie fejlesztőnél teljesen kizárt).

#14934 Abu85: Van publikus lista arról, hogy mely játékokhoz vették meg? Csakhogy tudjam, hogy a jövőben mely címeket kell messziről elkerülni.

![;]](//cdn.rios.hu/dl/s/v1.gif) Viccet félretéve lesz dolguk vele bőven.

Viccet félretéve lesz dolguk vele bőven. -

huskydog17

addikt

válasz

Crytek

#14909

üzenetére

Crytek

#14909

üzenetére

Na mi az, az UE4 annyira f*s, hogy még az MS-nek is beletört a bicskája?

![;]](//cdn.rios.hu/dl/s/v1.gif)

Biztos amikor meglátták, hogy mennyire kéne átírni az egész motort, inkább bedobták a törölközőt.

Most az Epic-nek aztán fájhat a feje! Kitől fognak DX12 build-et kapni? Egész eddig az MS-re várt az Epic, hogy Redmond majd kijavítja a finoman is csak trágyadombnak nevezhető motorját, de ezzel a lépéssel már tuti nem kapnak semmit. Az ARK-nál meg majd bejelentik, hogy a DX12 mód - ami már bő fél éve szúszik - csúszik még egy fél évet, aztán fél év múlva bejelentik, hogy bocs, a DX12 nem fog menni, elég lesz nektek a 10-15 FPS is DX11-ben.

Bocs, nem lehetett kihagyni!

-

válasz

Crytek

#14719

üzenetére

Crytek

#14719

üzenetére

Ha azt várod a DX12-től, hogy oldja meg azokat a problémákat, amikkel 10+ éve minden AAA játék érkezik, akkor tényleg áll a futballos hasonlat. A GoW-nak az a fő gondja DX12 szempontból, hogy a két igazán érdekelt fél közül (AMD, MS) egyiknek sem volt fontos, hogy villantsa a DX12 értékeit.

(#14729) rocket: aye, és júniusig az kb. H1, valamint tényleg 2 tucatról volt szó. Tekintettel arra, hogy folyamatosan vannak listák, hogy mi jön mindjárt, szerintem júniusig felesleges verdiktet előrejelezni.

-

válasz

Crytek

#14719

üzenetére

Crytek

#14719

üzenetére

ez csak a te elképzelésed, a tények mást mondanak. ha ékkőnek szánta volna az m$, akkor nem a port2pc.exe végezte volna a portolást. nyilván egy erre szakosodott, hozzáértő csapatot megfizetni más költségszint lett volna. kis pénz, kis foci. és hogy még jobb legyen, az egészre rátolták még a windoze store limitációit is.

ez egy poc, hogy jé működik, kb. azon a szinten, ahogy én néha rácsodálkozok, hogy jé, lefordult, mire nem képes egy compiler! -

válasz

Crytek

#14711

üzenetére

Crytek

#14711

üzenetére

Mindenki látta előre, akinek egy csöpp realitásérzéke van, hogy idén nem lesz dömping a DX12-es játékokból, különösen nem az olyanokból, amik komolyan újra vannak gondolva az új API lehetőségei szerint. Neked is javaslom a hype cycle nevű analitikai eszközt, nagyban segíti az ilyen hype-ok lefolyásának megértését. A DX12-vel még nem vagyunk az árok alján, de közeledünk hozzá.

-

mcwolf79

veterán

-

#45185024

törölt tag

válasz

Crytek

#14003

üzenetére

Crytek

#14003

üzenetére

Nem olyan rossz a UE4 ?

Akkor biztos nem az ARKos 20-30 fps ekre gondolsz maxon több százezer forintos kártyákon.

Még ha fog is emelkedni 20% ot direct x 12n ahogy igérik akkor se éri el a 60 at.

És ez full hd nem 4k , ez az ami jónak számít? Szépnek szép azt nem mondom, de még a városi kocka és vonal környezetet se hozza 60 al. -

huskydog17

addikt

válasz

Crytek

#13996

üzenetére

Crytek

#13996

üzenetére

A Caffeine egy rossz vicc, ugyanis trágyadomb motort (UE4) használ, aminek alapból sz*r a DX11 és a DX12 leképzője is. A játék csak akkor tud sebességet nyerni, ha az UE4-ben optimalizálnak valamit és a játékot a srác átrakja a legújabb motorverzióra. A készítő még csak nem is programozó. Fogta az alap UE4-et és összehányt valamit, itt a DX12 csak marketingre jó, de mérésre nem! Egy UE4 játéknál semmilyen következtetést nem szabad levonni az API-kkal kapcsolatban, legfeljebb a Fable Legends-nél, de ott is csak a DX12 lesz jó majd valamikor a jövőben. Összességében azonban az UE4 játékok technikai szempontból borzalmasak, ennél még a Unity 5 és fényévekkel jobb.

-

#85552128

törölt tag

válasz

Crytek

#13996

üzenetére

Crytek

#13996

üzenetére

Caffeinenek már van DX12 módja. [link]

Caffeine - The First DirectX 12 Game!

With Caffeine - Episode One being released with full DirectX 12 support, It is officially the first game (that is not in an Alpha state) to utilize the new API from Microsoft.

DirectX 12 allows for up to a 20% performance increase on Windows 10 systems, which helps bring to life the visually stunning world of Caffeine. -

huskydog17

addikt

válasz

Crytek

#13759

üzenetére

Crytek

#13759

üzenetére

Na látod, itt van a probléma gyökere. Miért illetsz negatív jelzőkkel egy olyan tesztet, amit nem is vagy hajlandó elolvasni? Sok fontos részlet/információ pont a szövegben rejlik! Ha viszont téged nem érdekelnek a szövegek és nem vagy hajlandó elolvasni a leírásokat, amiben sok kérdésedre választ kapnál, akkor legalább ne írj végtelenül buta, értelmetlen hozzászólásokat, mert pont, hogy ez a viselkedés a szánalmas, nem pedig a teszt.

Nálad mit jelent a maximális grafika/részletesség? Ha azt, hogy minden effektet bekapcsolsz, akkor pont az ellenkezőjét éred el, mert manapság sajnos a játékok többségébe sok olyan effektet építenek be, melyek csak rontják a képminőséget és cserébe sok számítást is elvisznek, vagyis rontják a képminőséget és mellette még a sebességet is, tehát teljesen értelmetlenek. A CB kielemezte, hogy melyek azok az effektek, melyek szinte semmit nem tesznek hozzá a látványhoz, de cserébe nagyon sok sebességet veszítesz velük. Ezeket kikapcsolták, ami teljesen logikus és ésszerű döntés.

Én személy szerint a HBAO+, a tesszelláció és a SSAA mellett még a motion blur-t és a vignette blur-t is teljesen kikapcsoltam volna, ahogy a screen effects-et is, mert ezeknek semmi értelme.

Egyszerűen ha nem tetszik a használt beállítás, akkor nézz másik tesztet, ezért van több különböző teszt!

-

huskydog17

addikt

válasz

Crytek

#13756

üzenetére

Crytek

#13756

üzenetére

El is olvastad, hogy miért nem kapcsolták be? Miért kapcsoljanak be egy olyan effektet, ami SEMMIT nem rak hozzá a képminőséghez? Ugyanez igaz a HBAO+-ra is, csak a sebességet viszik, ezért kapcsolták ki őket. Nem okoznak látható képminőségbeli javulást, vagy ha igen, akkor az nagyon minimális/elhanyagolható. Ezt én inkább ésszerűségnek tartom és én szerintem pont, hogy eddig ezt a teszt a legértelmesebb az összes közül. Ha max grafikát akarsz, akkor ott a PCGH tesztje. Olvasd is el a szöveget, ne csak a grafikonokat nézd!

-

mlinus

őstag

válasz

Crytek

#13730

üzenetére

Crytek

#13730

üzenetére

Hehe, ettől zeng a net?

Olvasom a topicot, de nem látom a nagy felháborodásra való okot. A játék gyönyörű, az egyik legszebb a piacon jelenleg. Nagy a gépigénye, ez tény, de cserébe olyan látványt is kapsz. AMD-n rosszabbul fut, tény. Majd csinálnak hozzá egy game-ready drivert, és jobb lesz. Ez nem újdonság, ez már gameworks előtt is gyakran előfordult hogy aki day1 akart AAA játékot játszani AMD-n néha megszívta.

Egyébként a Batmant az nvidiára kenni elég meredek...

-

#85552128

törölt tag

válasz

Crytek

#13732

üzenetére

Crytek

#13732

üzenetére

Nem tudom miről beszélsz/mivel égetik magukat, de úgy látom nem vagyok vele egyedül. A havas PureHair ami eddig nV bug, de az AMD kártyákon meg botrányos teljesítménnyel megy (és ugye ez még nem zárja ki, hogy ott nem lesz bug)...

Az AMD-nek olyan 9 órája van kiadni a "csodadrivert" ha nem akarják (megint) leszarni a vásárlókat.

A PureHair bug érdekes dolog, mert állítólag nyílt AMD tech az alapja, tehát meglehetett volna rendesen is csinálni főleg, hogy kezdetektől benne a játékban...Javasolnám utánanézni a 2013-as Tomb Raider (akkor még Gaming Evolvedes) startjának, különösen a benchmarkokat

Ahol a 7970 GHz és a Titan nem/alig volt elég az 1080p@60 FPS-hez maxon és ahol a TressFX gyakorlatilag harmadolta a teljesítményt - már ha működött és nem egy kopasz fej lett az eredménye...

-

-

nonsen5e

veterán

válasz

Crytek

#13358

üzenetére

Crytek

#13358

üzenetére

Pont erre gondoltam én is.

Mondjuk notebookcheck alatt az Iris Graphics 5200 az 1024*768 low alatt 26 fps-re volt gépes, akkor gyanítható, hogy az Iris Pro 580 már egy játszható szintet tud kitolni magából.

Csak kérdés, hogy mi értelme van az egésznek, hogy van kb. 2 darab Intel IGP, amin el lehet szenvedni krumpli felbontásban a játékkal épp 30 fps fölött.Pont mint amikor a Grid? alatt is volt olyan beállítás, ami csak Intel grafika alatt futott el (elbírta egyáltalán az Intel grafika akkoriban azt a játékot?)

-

Abu85

HÁZIGAZDA

válasz

Crytek

#13333

üzenetére

Crytek

#13333

üzenetére

Arra, hogy ingyé van hozzáférés a GitHUB-on a forráshoz, illetve van egy saját boltja, amin belül tartalmakat vehetnek, illetve hogy csak akkor kell fizetniük, ha már van 50000 dollár bevételük, és akkor is csak 5%-ot...

A motor választásánál természetesen van több alternatíva, de mondjuk egy CryEngine full licenc már elég drága, míg egy szintén licencelhető Nitrous kezdő cégnek megfizethetetlen. Az ARK-ra összesen a töredékét költik, mint amennyi ma a Nitrous licenc.

-

wjbhbdux

veterán

-

válasz

Crytek

#13330

üzenetére

Crytek

#13330

üzenetére

Az ember... meg az eszköz.

Mondjuk egy programozó, vagy akármilyen tapasztalt használható "senior" szakember bruttó 10 ezer USD (most kerekítsünk ennyire) havonta.

Ha 10 ember dolgozik az 100 ezer USD havonta, ha 100 ember akkor 1 millió dollár.

És akkor még fent kell tartani az irodát (bérelni, vagy venni) + rezsi... akkor a fejlesztőeszközök licencei, egy viszonylag kurrens PC amin dolgoznak 2 monitorral vagy több, stb stb.

(Nyilván van ami már meglehet egy előző projektből is akár... de akkoris... nem ingyen van semmi.)

-

Abu85

HÁZIGAZDA

válasz

Crytek

#13330

üzenetére

Crytek

#13330

üzenetére

Nem mindegy, hogy az embered neve Albert Einstein vagy Budai Józsi*.

Nincs igazán sok szakember az iparágon belül, így aki tényleg tud valamit, és nem csak átlagos programozó, azokat már rég elvitte az EA, a Sony, a Microsoft, és egy csomó nagy cég. A garázsstúdiók nem tudnák megfizetni őket.

*disclaimer: semmi bajom a Budai Józsikkal...

-

Abu85

HÁZIGAZDA

válasz

Crytek

#13326

üzenetére

Crytek

#13326

üzenetére

Nem érteni kell hozzá, hanem pénz kell hozzá. És az MS-nek van pénze ahhoz, hogy az Epic pénzhiány miatt érdektelenné vált, jellemzően komolyabb fejlesztéseit kiegészítse, normálisan megcsinálja. Ennyi a titok. Csak sajnos ami hiányzik az Epicnél, az hiányzik azoknál a stúdióknál is, akik azért választják az UE4-et, mert a kezdés ingyenes.

Fel kell fogni, hogy abba az egyébként tényleg baráti üzleti modellbe, amit az Epic kínál már nem igazán lehet minden egyes platformra minőséget építeni. -

janos666

nagyúr

válasz

Crytek

#11198

üzenetére

Crytek

#11198

üzenetére

Én szinte megszállottan szoktam "optimalizálni" a játékbeállításaimat (addig nem tudok nyugodtan játszani, míg nem elégedtem meg vele) úgy, hogy a játékidő >95%-ában meglegyen Vsync-el a stabil 60 fps (csak nagyon elvétve és/vagy ismerten problémás cutscene jellegű jeleneteknél zuhanjon be [jobb esetben] 45-re vagy 30-ra), azon belül pedig a lehető legszebben nézzen ki. De benne van az is, hogy egy TitanX SLI-vel is kikapcsolnám az olyan post-process szűrőket, amik leginkább csak elmaszatolnak és/vagy elzajosítanak mindent, mert tudom, hogy nem minden azért van a menüben, mert attól egyenes úton és mindig szebb a kép: nem szebb, csak más, ami szubjektív, hogy valakinek épp tetszik-e valamelyik, de biztos nem úgy gondolták a programozók, és szerintem "ízléses" embernek amúgy sem kéne az egymásnak ellentmondó dolgokat egyszerre bekapcsolni (pl. józan ésszel a blurring és sharpening szűrőknek egyszerre semmi értelme, még ha az egyiket kívánja is valaki), csak mert ott vannak a menüben, hogy válogathass közülük ízlésedre nulla és egy-két valami közt (de nem automatikusan mindet). De ide sorolható még az esetek túlnyomó többségében bármilyen post-process anti-aliasing is, amit nagyon ritkán használok (csak ha alaphangon borzalom aliasing-hegy a kép, és viszonylag jobbféle maszatoló-AA, pl. SMAA szerűség van a játékban, de az ML- és FXAA hagyjon békén).

-

proci985

MODERÁTOR

válasz

Crytek

#11190

üzenetére

Crytek

#11190

üzenetére

en egy szem 970el toltam 5760x1080ban, jellemzoen eleg volt. aztan az egy szem 290x is. 1080pre a felhasznalaok 99.9%anak eleg a 970 1080pre (a maradek 144Hzs monitorral, 8xMSAAval tolja jellemzoen valamelyik alapbol is GPUigenyes cimet).

jo, 5760ra mar 290x CFfel tolom, de hetfon elvileg megjon a vizesblokk a masodik kartyara is, aztan utanna par evig nem akarok a GPU alrendszerhez nyulni.

-

schawo

titán

válasz

Crytek

#11193

üzenetére

Crytek

#11193

üzenetére

5 éve a GTX580 volt fullhd maxra, 3,5 éve a 680, 2,5 éve a 780, 2 éve a 780Ti, 1 éve a 980, most meg a 980Ti. A kártyákkal az játékok által támasztott igények, és a játékosok elvárásai is együtt növekednek. 2 év múlva a (biztos nem ez lesz a neve) 1080Ti kell majd, a mai GTX980Ti szint olcsóbb lesz ugyan, de megint kevés lesz az akkori maxhoz.

-

Gainka

őstag

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Vivo X200 Pro - a kétszázát!

- GoodSpeed: Kell-e manapság egérpad vagy sem?

- Milyen okostelefont vegyek?

- VR topik (Oculus Rift, stb.)

- AMD Navi Radeon™ RX 9xxx sorozat

- Vigneau interaktív lokálblogja

- Windows 11

- One mobilszolgáltatások

- Meghalt a Windows 10, éljen a Windows 10!

- „Új mérce az Android világában” – Kezünkben a Vivo X300 és X300 Pro

- További aktív témák...

- BESZÁMÍTÁS! MSI SUPRIM X RTX 3070Ti 8GB videokártya garanciával hibátlan működéssel

- AMD Radeon RX 7900 XT 20GB XFX Speedster MERC310 Garanciás!

- ZOTAC GAMING GeForce RTX 3070 Ti AMP Extreme Holo

- BESZÁMÍTÁS! ASUS ROG STRIX RTX 3080 10GB videokártya garanciával hibátlan működéssel

- SAPPHIRE RX 9060 XT 16GB GDDR6 NITRO+ - Új, Bontatlan, 3 év garancia - Eladó!

- GYÖNYÖRŰ iPhone 13 mini 128GB Midnight -1 ÉV GARANCIA - Kártyafüggetlen, MS3318

- Honor 200 Lite / 8/256GB / Kártyafüggetlen / 12HÓ Garancia

- ÚJ ASUS ROG Hyperion GR701 E-ATX RGB Gépház

- Microsoft Surface Pro // Surface // Surface laptop 10.gen i5, Ryzen // 12,5 13,5 15 //

- LG 27UN880-B - 27" IPS ERGO - 3840x2160 4K - 60Hz - DisplayHDR 400 - USB Type-C - AMD FreeSync - Mac

Állásajánlatok

Cég: Promenade Publishing House Kft.

Város: Budapest

Cég: NetGo.hu Kft.

Város: Gödöllő

Pedig vártam.

Pedig vártam.

![;]](http://cdn.rios.hu/dl/s/v1.gif)