- Vivo X200 Pro - a kétszázát!

- Yettel topik

- Telekom mobilszolgáltatások

- Samsung Galaxy S25 - végre van kicsi!

- Okosóra és okoskiegészítő topik

- Három Redmi 15 érkezett a lengyel piacra

- Android alkalmazások - szoftver kibeszélő topik

- One mobilszolgáltatások

- Samsung Galaxy Z Flip5 - ami kint, az van bent

- Samsung Galaxy A56 - megbízható középszerűség

Hirdetés

-

Mobilarena

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

PuMbA

titán

válasz

gejala

#71679

üzenetére

gejala

#71679

üzenetére

Így is sokkal jobb lesz a helyzet, mint most a sima PS5 esetén

4K RT úgy simán lesz, hogy 1080p-1440p dinamikus felbontás felskálázva, ami FSR4-gyel mérföldekkel jobb képminőséget fog adni, mint a mostani FSR3 vagy PSSR.

4K RT úgy simán lesz, hogy 1080p-1440p dinamikus felbontás felskálázva, ami FSR4-gyel mérföldekkel jobb képminőséget fog adni, mint a mostani FSR3 vagy PSSR. PS5 Pro esetén most is működőképes a 60fps RT-vel, ahol van. Az UE5 hardver igénye meg folyamatosan csökken az évek előrehaladtával az optimalizálások miatt. Láttuk, hogy sima PS5-ön is ment a Witcher 4 60fps-sel RT-vel. Az alacsony felbontás meg nem lesz már probléma PS6-on, ahol még 2-3x erősebb proci is várható.

-

S_x96x_S

addikt

válasz

gejala

#66783

üzenetére

gejala

#66783

üzenetére

> Ha 24 giga lenne 4070 ...

Talán most a 16GB az ideális - jövőálló beruházás egy mai GPU beszerzésnél.

A konzolok miatt.

Jelenleg a konzolfejlesztők egyre inkább a meglévő tartalékok felé fordulnak

és a PS5 -ön ez a VRAM jobb kihasználtságát és a Gen4-SSD nagyobb használatát jelenti.És ez normális is.

Minden konzol életciklusának a végén ( ~ utolsó harmadában, negyedében )

jelennek meg olyan játékok, amelyek megmutatják a hw igazi lehetőségeit.Vagyis ÉN egyre több olyan játékot várok 2025,2026 -ra,

ahol a 12GB már problémás lehet.És 2026/2027 - körül már a PS6 -ra tervezik a játékokat.

Vagyis egy 2026-ban megjelenő - eredetileg is PS6 -ra tervezett játék - PC-s portjának

lehet, hogy 12GB már nem lesz elég. ( és az is lehet, hogy 16GB-al is döcög )--------

Persze az nVidiának erről teljesen más a véleménye

ők kitartanak a 8GB - mellett.

és (várhatóan) 8GB GDDR7 -el szállítják az új mobil GPU-s konfigok közel 90%-át.

( RTX 5050M; RTX 5060M; RTX5070M )

Úgyhogy én nem irigylem a játékfejlesztőket ...--------

És persze nem lehet még tudni az AMD - RDNA4 -es stratégiáját.

De én itt se vagyok optimista. -

S_x96x_S

addikt

válasz

gejala

#65224

üzenetére

gejala

#65224

üzenetére

>>"az AMD RDNA4 az alsó + felső közép kategóriára megy rá"

> A HD4850/4870 korszak óta arra mennek rá.

> Eredmény: 40% piaci részesedésről 10% mára, profitjuk meg kerekítve

> semmi NV-hez képest.Bár a történelem nem ismétli önmagát, de néha rímel.

és remélhetőleg az AMD is tanult

a múlt hibáiból,

( ahogy a Nokia és az Intel menedzsmentje is kénytelen volt,)

most van remény, hogy másképp alakul a helyzet.

Persze, a Blackwell drágán gyártható, és inkább az AI hajtja a keresletet,

mint a gaming, így legalább egy évig nem lesz versenyképes ár-teljesítmény arányban.

Az RDNA4 viszont most az ADA-val száll harcba, és hiába lesz remek az ár-teljesítménye,

ettől még a piaci részesedés nem garantált.

Az árversenyben pedig nehéz dolguk lesz - hogyha az nVidia felveszi a kesztyűt,

de a mobil szegmensben még így is lehet esélyük a 4090 ellen.

( a mobil 4090 az elég gyengusz a desktop 4090-hez képest )Persze, aki már most elköteleződött az RTX 5090 iránt, az egyáltalán nem is akar egy csúcs AMD kártyát, csak olcsóbban akar hozzájutni a vágyott 5090-re,

És ha lenne egy csúcs AMD GPU - akkor azt már csalódásnak érné meg,

mert így már nem az övé a legjobb kártya. -

-

Abu85

HÁZIGAZDA

válasz

gejala

#57151

üzenetére

gejala

#57151

üzenetére

Nagyon sokat fognak ugrani. Részben technológiából, részben pedig a fogyasztás növeléséből, mert az AMD a csúcskártyákat már nem 300 watt alá, hanem 450 watt környékére tervezi. Az NV is fog ugrani, mert ők a top GeForce-ot 600 wattra paraméterezik, ami még nagyobb előrelépést prognosztizál.

És a next kártyákból már a Navi 33 működik, ráadásul csapkodja a Navi 21 hátát, tehát elég erős hardvernek tűnik annak ellenére is, hogy 150 watton belül van a fogyasztása, és a memóriabusza is csak 128 bites. Továbbá a Navi 33 a legkisebb a készülő Radeonok közül, kb. Radeon RX 6600 XT-hez hasonló kiépítésű VGA-k hozhatók rá. Lesz még nála két gyorsabb dizájn.

Ezért se nagyon éri meg a mostani túlárazás mellett vásárolni erősebb hardvert, mert nagyon gyorsan kicsinálják az új VGA-k a jelenlegiket.

-

válasz

gejala

#56930

üzenetére

gejala

#56930

üzenetére

Normális körülmények között nem lenne ezzel nagyon gond, de nincsenek normális körülmények, plusz az igények sem egyformák. A Pascalnál az 1080Ti még igen csak jól tartja magát, ezért jók a csúcs kártyák ha vannak egy egy generációban. A vega az új címekben valamiért nem megy úgy, mint a kis Polarisok, illetve jobban lelassulnak az elméleti teljesítményéhez képest.

-

Televan74

nagyúr

válasz

gejala

#56930

üzenetére

gejala

#56930

üzenetére

Az a szívás hogy nincs a piacon viszonylag megfizethető kártya. Rengeteg ember ki fog maradni az újonnan érkező címekből.

Itt volt a karácsony, vagy 10 gépet mondtak vissza mert nincs megfizethető videókártya. Mikor meg tudták hogy egy konfiguráció 500.000 - 600.000 Ft lett volna egy 6600 -as kártyával, hát sokan a szívükhöz kaptak. Ami valljuk be nem egy évekre szóló megoldás.

-

Devid_81

félisten

válasz

gejala

#56930

üzenetére

gejala

#56930

üzenetére

Pascal mar igy is elhasal par uj cimben.

Mig a Turingok, ahogy irtad is, teljesen jol helytallnak.Halo Infinite eleg jo pelda a Pascalok, Polaris, Vega oregedesre.

A regebbi NV/AMD VGA-kra tenyleg rossz sors var, szinten nem is lenne ezzel baj ha lehetne venni ujat ertelmes aron, de ez ugye mas teszta.

-

Alogonomus

őstag

válasz

gejala

#55582

üzenetére

gejala

#55582

üzenetére

Azért a "sok" definíciója kicsit nagyobb darabszám. Persze lehetnek beragadt fejlesztések, amiket már nincs idő/pénz átírni, meg például ott van a Guild Wars 2, ami máig DX9-es, viszont szinte minden frissebb AAA játék már DX12-es vagy Vulkan alapokon van, mert azokkal lehet az erősebb GPU-k teljesítményét kiaknázni. DX11-el szinte minden esetben a CPU lesz a szűk keresztmetszet.

-

Abu85

HÁZIGAZDA

válasz

gejala

#55572

üzenetére

gejala

#55572

üzenetére

Manapság már default a Vulkan vagy a DirectX 12. DirectX 11 csak kompatibilitás miatt maradt meg, de némelyik játék már ezt se rakja bele, egyszerűbb a DirectX 12 mellé egy Vulkan módot csinálni. A DirectX 11-et a Microsoft gyakorlatilag megölte a DXIL-lel, amit nem portoltak le a régi API-ra, és eközben az Xbox Series X/S már nem fogad el D3BC-t. Ezzel elvágták a DirectX 11 lehetőségét a fejlesztők elől.

-

paprobert

őstag

válasz

gejala

#55560

üzenetére

gejala

#55560

üzenetére

Megelőlegezve, szerintem rosszabb helyzetből indulnak mint amit az AMD produkált az RDNA indulása utáni fél évben.

Ezt az állapotot szerintem csak az tudja javítani, ha a játékfejlesztőknél bevált gyakorlat lesz az eddigi 2 helyett 3 vendorral való alaposabb tesztelés. Az pedig időbe fog telni. -

Alogonomus

őstag

válasz

gejala

#55413

üzenetére

gejala

#55413

üzenetére

A hírek szerint az ütemezővel van a gond, ami ugyanúgy hiányzott a Turing GPU-ból, de még a mostani Ampere GPU sem tartalmazza, helyettük az Nvidia drivere végzi el az adatok jó időben átküldését, de ehhez a CPU erőforrásait kénytelen használni. A jelenlegi driverre így ugyanúgy támaszkodik a legújabb architektúra, ahogy akár egy Maxwell kártya. Ezért is esik pont ugyanúgy vissza jelentősen egy sok éves Nvidia kártya a gyenge processzor miatt, ahogy egy vadonatúj Nvidia kártya. Eközben egy AMD kártya nagyjából egyenletesen reagál az egyre gyengébb processzorokra.

Amíg az Nvidia a Turing érában egyértelműen legalább egy "célegyenesnyi" előnnyel rendelkezett, addig lett volna lehetőségük egy új drivert nyugalomban kifejleszteni, vagy legalább az Ampere kártyába már beletervezni az ütemezőt. Talán a 4k-8k gaminget is az ütemező miatt erőlteti az Nvidia, mert a tesztek alapján a magasabb felbontásból következő alacsonyabb fps miatt már nem jelent komoly gondot a gyengébb processzor.A Pascal kártyák még sok évig velünk maradnak, mert a 1070-1080 kártyák FullHD felbontásra még abszolút jók, és az FSR valószínűleg csak még tovább nyújtja majd a használhatóságuk idejét. Legfeljebb nem a legújabb és kevésbé optimalizált játékhoz fogják használni. Ez a játék például majd valamikor 2023 környékén fog valószínűleg megjelenni, de már a mostani alfa állapotában is gond nélkül elfut egy GTX 1080Ti kártyán 4k felbontáson UE 4.26-os motorral.

A Turing/RDNA előtti architektúrák még sokáig a kártyák túlnyomó többségét fogják képviselni, így amelyik játék legalább a Pascal/Vega/Polaris architektúrán nem fut hibátlanul, annak a játéknak nagyon bekorlátozott lesz a piaca. -

Alogonomus

őstag

válasz

gejala

#55410

üzenetére

gejala

#55410

üzenetére

Csak egy alapjaitól újragondolt driver sok buktatót rejt, amiről az AMD is tudna mesélni az RDNA1 kártyák esetén néhányaknál előforduló hibák kapcsán. Persze az az új megközelítésű driver az AMD kártyáit mára az eredeti konkurensük fölé segítette, de az addig vezető úton számos problémával szembesült az AMD szoftverrészlege. Minden valószínűség szerint az Nvidia útja sem lesz problémamentes, és míg ezt a Turing-éra elején-közepén simán "kimozoghatta" volna a teljesítményelőnyével, addig a mostani head-to-head helyzetben pár itt-ott bugos driver bőven az AMD termékei felé terelhetik a nem elkötelezett vásárlókat.

-

Alogonomus

őstag

válasz

gejala

#55381

üzenetére

gejala

#55381

üzenetére

Viszont aki jelenleg egy játékban csökkentett beállításokkal tudja csak elérni a neki megfelelő fps-t, az az FSR segítségével például már nagyobbra állíthatja a draw distance értékét, bekapcsolhatja a speciális effektusokat, átválthat HD textúrákra, és hasonlók. Ezek még a valamivel életlenebb kép mellett is komolyan megdobják a játékélményt.

-

Petykemano

veterán

válasz

gejala

#55192

üzenetére

gejala

#55192

üzenetére

"A DDR5 jövőre még piszok drága lesz és lassú is. A brutál magas késleltetések miatt 6000 alattit nem lesz érdemes venni, abból meg 32 GB legalább 100k lesz vagy inkább több.

32 GB DDR5 majd talán 2024-től lesz mainstream."Jó, hát nem úgy értem, hogy a Steam Survey-ben 2022-től ezen adat vonatkozásában helycserés fordulat áll be, hanem az újonnan vásárolt konfigokra.

És hát a félmilliós videokártya mellett nehogymár a százezres RAM legyen az akadály. (<= cinikus voltam) -

Abu85

HÁZIGAZDA

válasz

gejala

#55162

üzenetére

gejala

#55162

üzenetére

Attól még a tartalomkikódolás tekintetében a hátrány ott lesz a PC-n. A két új konzolon erre dedikált hardver van. PC-n pedig semmi. Vannak a procimagok és kész, amíg meg nem érkezik a DirectStorage for Windows. És azért a konzolok dedikált egységeit konkrétan több maggal lehet helyettesíteni, ráadásul kellenek magok a jelenetszámításra is.

A fentiek miatt tök felesleges új VGA-kat várni a PC-s DirectStorage előtt. Egyszerűen túl rosszak a körülmények, hogy bármit is érdemes legyen kiadni.

-

Abu85

HÁZIGAZDA

válasz

gejala

#55158

üzenetére

gejala

#55158

üzenetére

A problémát a konzolok jelentik. Most egy rakás erőforrás áll rendelkezésre next-gen fizikát és AI-t csinálni. Ezt ki is fogják használni, és ha erre lövi az erőforrásait a proci, akkor kevesebb marad a rajzolási parancsoknak, amik kezelése eleve sokkal drágább PC-n. Még az explicit API-kkal is, mert a konzoloknak van egy tényleg nagyon low-level rétegük, ahol egy rajzolási parancs nem több három DWORD-nél.

Plusz ugye amíg nincs PC-s DirectStorage, addig a tartalomkikódolás is a procit terheli, ellentétben a konzolokkal, amelyeknek erre dedikált erőforrásuk van.

-

Z10N

veterán

válasz

gejala

#54888

üzenetére

gejala

#54888

üzenetére

Az olyan marketing BS szovegek miatt, mint a "we love pc gaming" es "sweet spot", illetve az altalatd emlitett "where gaming begins". Ha a taiwani videokat megnezed amit korabban linketem es naponta kerulnek fel ujabb videok akkor latod, hogy van beloluk. Nyilvan nem annyi, mint NV-bol (abbol tele van a polc). Szoval itt a ceg megiteleserol van mar szo (taglaltam mar parszor). Sajnos ezzel pedig egyetertek: "szóval ez alatti kártyákkal ők már nem számolnak játékra". De ahogy gondoljak. En meg hosszu ido utan (15 ev) elgondolkoztam, hogy ujra NV kartyat veszek Taiwanrol 2060S vagy az ujra gyartott 1660S.

-

-

Devid_81

félisten

válasz

gejala

#54890

üzenetére

gejala

#54890

üzenetére

Ez teny, hogy nagyon keves a kapacitasuk VGA-ra.

Proci teren szerencsere mar tobb a kapacitasuk. (Ha nem is tobb, de most mar elerheto szinte az osszes CPU)

Ez a konzol+minden mas egyszerre bejelentes nagyon nem volt egy jo dontes.

Mindamellett anyagilag koszonik szepen jol vannak, csak PC user szempontbol ez most a leheto legrosszabb.

Egy kis okossaggal kihasznalhattak volna az nV kezdetei szerencsetlenseget de meg most is a banyalaz kozepen, millio VGA-t eladhatnanak...

Csak azt nem tudjuk, hogy a hatterban mi megy, nem biztos, hogy a konzolok mellett asztali fronton ettol tobbet akarnak az NV ellen.

-

-

Petykemano

veterán

válasz

gejala

#54847

üzenetére

gejala

#54847

üzenetére

Az AMD piaci részesedése két okból csökkenhetett:

1) Ian Cutress kiszámolta, hogy az eladótt 7-8 millió PS5-höz kb havi 10000 waferre volt szükségük. Itt 6 millió eladótt xbox-ról írnak, ami mondjuk szintén havi 8000 wafer lehet.

És hónapok óta gyártani kell a zen3 CCD-ket is a Milanhoz és a Vermeerhez, valamint a Renoirt és a Cezanne-t és erre jöttek még a gpuk

2) Az Nvidia mindent a Samsungtól vett.Eközben mindkét cég minden gpu-t elad, amit legyárt. A piaci részesedés sokkal inkább reprezentálja azt, hogy melyik cég mennyit tud gyártani, semmint azt, hogy melyik termék mennyire kedvelt a játékosok körében.

Másrészt ha én játékfejlesztő lennék, kétszer is meggondolnám, hogy mennyire támaszkodhatok ezekre az adatokra.

Bár a JPR jelentése valóban eladásokat jelent, de játékfejlesztőként egyáltalán nem lehetek biztos abban, hogy ezek az eladások az én célközönségem kezében (gépében) landoltak.Felróvod, hogy a Steam nem is látja az RDNA2 6000-es szériát.

A JPR jelentése szerint 2019-hez képest enyhén nőttek is az eladások (38.5m => 41.5m) - az nvidia rekord bevételeket hozott - és ezen a növekvő tortán belül csökkent az AMD részesedése elég jelentős mértékben úgy, hogy eközben az eltelt közel háromnegyed év alatt az NVidia 3000-es szériája is épphogy csak reprezentálja a magát a steam listákon.Én ebből arra következtetek, hogy az nvidia növekvő eladásai a bányákban landolnak és hogy a JPR által kimutatott piaci részesedés egyáltalán nem biztos, hogy összefüggésben van azzal, hogy a játékfejlesztők célközönsége között milyen a penetráció.

(A jelenlegi piaci részesedés legfeljebb arra utalhatna, hogy ha beomlana a bánya, akkor miből mennyi ömlene rá a gamerekre. De nem fog beomlani a bánya) -

Abu85

HÁZIGAZDA

válasz

gejala

#54851

üzenetére

gejala

#54851

üzenetére

És mi alapján "bütykölik meg"? Ki kell azt is deríteni, hogy miért nem fut jól, és erre szükségesek olyan fejlesztőeszközök, amelyek elég sok információt elárulnak. Xboxon ez megvan, AMD-n is le lehet ásni mélyre az RGP-vel, de NV-n mire fog alapozni? Van disassembler? Nincs, de még ha lenne, akkor sincs dokumentáció, hogy használhasd. Egyszerűen az NVIDIA felkínált profilozói nem elég alacsony szintűek egy csomó dolog kiderítéséhez. Például ezeket sokáig használta az Epic Games. Aztán Radeonra váltottak a Vulkan miatt, és leprofilozták az Unreal Engine-t RGP-vel. Nyertek általánosan (még a GeForce-okra is) +15%-ot DirectX 11-ben, mert olyan hibák váltak láthatóvá, amit az NV profilozója nem mutatott.

Problémát csak úgy lehet orvosolni, ha az látszik, ez kritikus szempont. És ezen a 85%-os részesedés nem segít, ha a másik cég profilozója mutatja meg, hogy itt meg ott van pár bug a kódban.

#54853 morgyi : A D3D12 programoknál a GeForce-ok nagyobb overheadje akkor lesz igazán gond, amikor terjednek az általános felskálázó eljárások. Ott számítani fog, hogy 1440p-s képet raksz ki, de csak 720p-s képet számolsz. Nyilván ez a számítás szintjén is 720p-s igény marad. A Full HD is gond, de nem akkora, de azért pont elég nagy a különbség, hogy erre figyeljenek.

A gond inkább az, hogy ennek a problémának nincs egyszerű megoldása. Nagyon másképp működik az NV meghajtója, mint amilyen optimalizálással a játékok jönnek át Xboxról. Túl sok dolgot emulál a CPU-n a régi hardverek miatt, de eközben újraírni a D3D12 implementációt azért hülyeség, mert 2 évig minimum eltartana, és az átállás aranykorában viszel bele a rendszerbe egy rakás bugot. Nem mellesleg ez a változás a már kiadott D3D12 programokra vonatkozóan nem sokat érne. Nyilván valamelyik kezébe idővel majd beleharap az NV, csak egyelőre nem látszik, hogy melyikbe érdemes. Én a helyükben kivárnék. Reagálni már úgyis késő, és később jobban lehet dönteni. -

Alogonomus

őstag

válasz

gejala

#54847

üzenetére

gejala

#54847

üzenetére

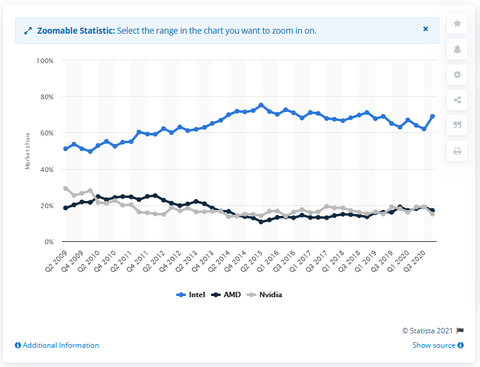

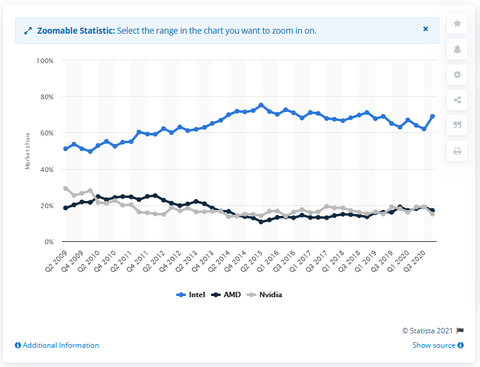

PC graphics processing unit (GPU) shipment share worldwide from 2nd quarter 2009 to 4th quarter 2020, by vendor

Az igazság valahol a kettő között lehet. Valamint a nagyjából 15 millió új konzolt, se felejtsd ki a számításból, amik szintén AMD alapúak, és szépen megdobnák a fekete vonalat, ha beleszámolnák.

-

Abu85

HÁZIGAZDA

válasz

gejala

#54847

üzenetére

gejala

#54847

üzenetére

Az a baj, hogy nagyon leegyszerűsítitek. Egy fejlesztő nem így portol. D3D12 API-val kb. van egy alap kódja Xboxra, amit elkezd áthozni PC-re. Ha a kódnak egy része előnyös Radeonon, akkor az NVIDIA így járt, ha egy másik része előnyös GeForce-on, akkor az AMD így járt. Alapvetően nem fognak nagymértékben belenyúlni a konzolra írt optimalizálásokba, mert a PC-s port hónapokat csúszna.

-

fatpingvin

addikt

válasz

gejala

#54847

üzenetére

gejala

#54847

üzenetére

emögött én elméláznék egy kicsit: mi alapján számították ezt? eladások vagy telemetria alapján?

ugyanis ha utóbbi akkor elgondolkodtató lehet az hogy a nagyipari bányászoknak mennyire érheti meg engedni a valós telemetriaadatokat, révén ezek a számok nagy tételben befolyásolhatják némileg a statisztikákat... nem tudom. nem vagyok közgazdász de ez valamiért megakadt az agyamban -

Alogonomus

őstag

válasz

gejala

#54828

üzenetére

gejala

#54828

üzenetére

Az már lényegében eldőlt, hogy az AMD megoldása nem machine learning megoldást használ, ha a mesterséges intelligencia alatt azt érted. Pont ezért lesz bekapcsolható minden játékban.

Rossz képminőséget adó megoldást valószínűleg nem ad ki az AMD, mert azt úgysem használná senki. Ugyanúgy csiszolják, ahogy a SAM képességet, és majd kiadják, amikor kiadásra éretté válik.b Ami ebben a fórumban szóba kerül, az pletyka és spekuláció, esetleg előzetes ígéret, de semmiképpen sem kész tény. Tényeket majd a tesztekben olvashatsz.

Az eredmény előtt ott van a "talán csak", szóval nem "kijelentő" mód, hanem találgatás amit írtam. A számmal pedig arra utaltam, hogy annál kisebb eredmény komoly előnyt nem jelentene. Valószínűleg ezért is nem adták még ki az AMD.

A DLSS új főverziója valószínűleg inkább a jövő zenéje. Az AMD FidelityFX már elérhető az XBOX játékok fejlesztéséhez, míg a DLSS 3.0 még developer kit szintjén sem mutatkozott be.

Felhívom a figyelmedet arra a valószínűleg szóra, mielőtt ezt is tévesen kijelentésként értelmeznéd tőlem .

. -

válasz

gejala

#54539

üzenetére

gejala

#54539

üzenetére

Mindkét gyártónak anyagi érdeke a jelenlegi helyzet fenntartása, hiába nyilatkoznak bármit is. Nem fog Nv. sem előbb kártyákat juttatni a piacra mint az AMD és fordítva sem lesz. Erre most rá mernék tenni egy kisebb összeget, hogy ha az egyik gyártó kártyái elkezdenek állandó készlettel elérhetőek lenni, egy két héten belül a másik gyártóé is ott lesznek. Pedig két külön gyátócég két külön csíkszél.

Arról most ne is beszéjünk, hogy normál helyzetben most az AMD a felső kategóriában tarolhatott volna , mert nem igazán vették volna a az emberek a 3090-de a 3080 is kétséges- kártyát a 6800XT-6900 XT vel szemben, de mire lesz elérhető 6800- 6800 XT-6900 készlet kint lesz azonos áron a 3080 Ti és a 3070 Ti ,ami megint kétségessé teszi a piacszerzés lehetőségét a gamer szegmensben. -

Petykemano

veterán

válasz

gejala

#54355

üzenetére

gejala

#54355

üzenetére

Én nem vagyok 144Hz-es gamer. Ha választanom kéne, hogy 1080p 144Hz vagy 4K 40-50fps (csak hogy még csak ne is 60 legyen), akkor számomra a 4K-ban több érték lenne.

Azt nem tudom mennyi, de nyilván mindegyik fícsör az 1080p/60fps-hez képest feláras.Ezt most csak azért mondom, hogy értsd: egyetértek veled.

Ezzel együtt úgy tűnik, az AMD meg fogja próbálni $500-ért vesztegetni az 1440p-s kártyáját.

-

Petykemano

veterán

válasz

gejala

#54335

üzenetére

gejala

#54335

üzenetére

Szerintem nem csak a CPU jelent(het) bottlenecket alacsonyabb felbontáson.

Megfordítom: a sok feldolgozó - amivel korábban a GCN rendelkezett - magas felbontáson tud értelmet nyerni, amikor nagyon sok a párhuzamos számítás.Pár éve még az volt, hogy a GCN rendelkezik sok számító egységgel, de alacsony frekvenciát értek csak el. Szemben az nvidia architektúráival, ami vékonyabb volt, de magas frekvencián dolgozott. Alacsony felbontáson relatív kevés párhuzamos számítást kell végezni és ezért lehet, hogy nagyobb arányban fordul elő kihasználatlan számítási kapacitás, miközben a kihasznált számító egységek esetén viszont nagyon fontos a frekvencia, mert az határozza meg a válaszidőket. Véletlen volna, hogy akkoriban tolta az AMD a async compute szekerét?

most valahogy megfordult a helyzet. Az AMD rendelkezik olyan lapkákkal, ami relatív kevesebb számítóegységgel működik, de magas frekvencián és az nvidia rendelkezik olyannal, ami széles, de nem ér el olyan magas frekvenciát.

Itt is az az érvényes, hogy alacsony felbontáson a széles számítókapacitás nem tud kihasználásra kerülni.Csak az Nvidia sikeresen megfordította a viszonítási alapot. (Ezt már az Ampere bemutatájánál lehetett sejteni, hogy az Nvidia a gpu közbeszédet el fogja vinni abba az irányba, hogy a 4K a standard és így is történt)

Ma már nem azt mondjuk, hogy X és Y kártya mit hoz 1080p-ben vagy 1440p-ben és X kártya 4K-ban mutatja meg az igazi erejét (ahogy ez a Fiji és a Vega64 idején volt - más kérdés, hogy akkor a 4K tényleg játszhatatlan volt még)

Hanem feje tetejére állítva azt mondjuk, hogy a 4K-ban mi van és X vagy Y kártya 1080p-ben bottleneckes, ezért abban nem ér az összehasonlítás.Na mindegy, a lényeg az, hogy az AMD a 6700XT-t 1440p-re célozza.

Ez azt jelenti, hogy 4K-ban el fog hasalni pont úgy, ahogy a 3070, minél nagyobb felbontásban nézed, annál nagyobb lesz a gap. -

Pkc83

őstag

válasz

gejala

#53680

üzenetére

gejala

#53680

üzenetére

"egyébként se jobb semmivel más gyártókénál, de ettől még a legdrágább. Kezet foghatnak az MSI-vel."

Azért ezt nem mondanám.

A Strix és a Gaming x az egyik legjobb minőségü

A Strix és a Gaming x az egyik legjobb minőségü

kártya a piacon. Amd-nél meg ugye a Sapphire. Persze ettől még nem érnek meg

akkora felárat mint amekkorát rátesznek de ez van sajnos. -

Pkc83

őstag

válasz

gejala

#53142

üzenetére

gejala

#53142

üzenetére

Aham, értem. Én semmilyen akciót nem láttam ,németbe

legalábbis nem volt. Pont ugyanúgy 800 euró volt a 2080s és

1200 felett a 2080Ti. Én nem akarom elhinni , hogy annyiért megvették

az új kártyák fényében főleg,hogy a használt piac is tele volt

ezekkel a kártyákkal. Biztos van rá példa de nem tömegével,

márpedig egyik napról a másikra eltünt szinte az összes. -

-

Malibutomi

nagyúr

válasz

gejala

#53061

üzenetére

gejala

#53061

üzenetére

Hat az elso pelda pont arra jo hogy azt mutassa hogy minimalis a kulonbseg amit ha nem dfirekt keresed eszre sem veszed.

En is latom hogy szep, es nyilvanvalo ez a jovo.

De JELENLEG es meg vagy 2 kartya generaciora a helyzet az hogy a kulonbseg minimalis, az FPS veszteseg meg hatalmas.

-

Malibutomi

nagyúr

-

-

Pkc83

őstag

válasz

gejala

#53039

üzenetére

gejala

#53039

üzenetére

Nézhetjük a Controlt csakhogy ahhoz meg nincs vga amivel

normálisan futna max grafikán. Na erre mondom , hogy optimalizálatlan.

Pedig ha legalább annyi melót raktak volna bele mint pl a Resi 2 remake-be

akkor egy 2080 erősségü vga-val simán kellene futnia. Csak sza.tak rá.Az új konzol... Oké.. Tényleg szép a grafika de nem is 4k 120Fps.

-

Alogonomus

őstag

válasz

gejala

#53036

üzenetére

gejala

#53036

üzenetére

Plusz feature nincs benne, de elméletileg az Ampere belső adatmenedzselése már a jövőt jelentő DXR 1.1 igényeit figyelembe véve lett kialakítva. Szóval míg a Turing a DXR 1.0-s kódot tudja hatékonyabban futtatni, addig az Ampere a DXR 1.1-est. Aztán hogy mennyi igazság van a marketing mögött...

-

Pkc83

őstag

válasz

gejala

#53035

üzenetére

gejala

#53035

üzenetére

"Addigra annyit fog fejlődni a grafika, hogy egy Control is retro pixelhalom kategória lesz."

Nem értem mire gondolsz.

Az elmúlt években a grafika szinte semmit sem fejlődött csak a gépigény

emelkedett sokat ,gyakorlatilag indokolatlanul. Egy két kiadót leszámítva

semmi energiát nem fektetnek az optimalizációba inkább vegyél kétszer

olyan gyors vga-t holott nem is lenne rá szükséged.

Egyébként van jövőbiztos kártya , mindíg is volt csak lejjebb kell adni

az igényekből.

Például: Fhd 60Hz: Gtx 1660 super/Ti , Rx 5500xt

Fhd 144Hz : Rtx 2060 super , Rx 5600xt

Qhd: 60Hz: Rtx 2070 super , Rx 5700xt

Qhd 144Hz: Rtx 2080 super/TiA 4k-t meg az új kártyák hiánya miatt el kell felejteni.

-

mater799

csendes tag

válasz

gejala

#53030

üzenetére

gejala

#53030

üzenetére

Jovobiztos kartya? Arra aztan lehet varni mert soha nem is lesz.

Lassan az elkepzeles is kihal mint a regi meg bovitheto memoriaval felszerelet vodoo kartyak.

Pusztan SZERINTEM nincs semmi ertelme annak hogy tudja e az a dott kartya az " rtx + et vagy sem ameddig nem jtunk el arra a pontra hogy max 10% fps veszteségem legyen miatta.

Ezen az alapon elindulva talan 3-4 generacio mulva lesznek elerhetoek olyna teljesitmenyu kartyak amik mondjuk tudjak azt hogy 2k 144hz + rtx es nem kell neki majd se dlss se semmi okossag.MSRP / keszletek: MSRP igen egyszeru -> a vasarlo pofajaba kell hazudni hogy csak ennyi es pont. Ez kivalo alkalom volt hogy maximalizalja a naviknak az arrat ugye.

A keszletek szerintem pedig vastagon mestersegesen vannak visszafogva a meg magasabb ar erdekeben. Eleg visszagondolni arra amikor az MSI megbukott vele hogy egy leanyvallalata tobbszoros aron arulja az uj kartyakat az e-bay en ugye... a magyarazat meg annyi volt hogy veletlenul olyan keszletekhez fertek hozza amihez nem lett volna szabad.

Meg a " valasz " kiadasanal is hulyenek nezik az embereket konkretan. -

Alogonomus

őstag

válasz

gejala

#52002

üzenetére

gejala

#52002

üzenetére

Nem a kapacitás, hanem az átviteli sebesség a korlát. A PS5 9 GB/s sebességgel tud adatot beolvasni, míg egy átlagos PCI-E 4.0 SSD PC-n olyan 5 GB/s, míg a csúcs SSD-k ideális esetben (masszívan hűtve) 7 GB/s sebességre képesek. XSX-en legfeljebb visszafogják a grafikai minőséget "pretty good" szintre, mert az XSX nagyjából 5 GB/s olvasási sebessége arra elég.

Persze az MS által nem olyan régen megvett fejlesztők címei talán tényleg nem lehetnek majd szebbek, mint az XSX változatban. -

#09256960

törölt tag

válasz

gejala

#51995

üzenetére

gejala

#51995

üzenetére

Nem, vegyél külső SSD-t ha nyílt világú játékkal akarsz játszani ami a játékok 1% sincs, és emelett azt akarod hogy más játékaid is elférjenek a rendszeren.. így helyes a mondat.

Szép barna a hajad Amigád akkor biztos nem volt

512 KB de a játékok zöme 1024-en indult csak el. ÉSSS ?

-

Abu85

HÁZIGAZDA

válasz

gejala

#51993

üzenetére

gejala

#51993

üzenetére

A legtöbb modell eleve olyan részlegességű, mint ami az UE5 demóban van. Egyáltalán nem ez a probléma. Alapvetően maga lenne a Kánaán, ha elég lenne úgy készíteni a modelleket, ahogy az UE5 kezeli, mert akkor rengeteg tartalomtervezéssel járó munka megspórolható. A gond tehát nem ez, hanem az, hogy az adatokat az adattárolón tárolni kell.

-

#09256960

törölt tag

válasz

gejala

#51987

üzenetére

gejala

#51987

üzenetére

Az a baj hogy úgy hoztak ki egy konzolgenerációt hogy nem tudják megmutatni az igazi erejét. EZ TÉNYLEG BAJ. Mert oda jutottunk hogy vedd meg a PS5-öt mert már a 4-et is megvetted, és ez bizony olyan iPHONE-s fíling.

Értem hogy ABUtól idéztem és ez mekkora nagy szálka sok ember szemébe de ebben a szobában erre elég jól rá lehet keresni.

Igen ez így vadul hangzik amikor azt mondják vegyél meg 3db 450 ezres videókártyát ahhoz hogy majd a harmadikra elérd egy mostani 110 ezres next gen erejét. Tehát van a kapitalizmus meg a vadkapitalizmus, és utóbbi már a márkahűségre nevelt réteg lefejéséről szól. (ájfón meg a videókártya évente milla és nem is kell gondolkoznod lesz e házad valaha) [*Ez társadalomkritika volt]

De ha a valós teljesítményt nézed azokra a programokra amik a konzol valós tudását veszik alapul ez akkor teljesen más.

A shaderek a konzolok sokkal gyorsabbak, a Winnek már nincs komoly bevételi forrása( mennyi egy akciós win kétezer xszáz?? még az ofisszal tartja valahogy magát az egy tizes fölötti "szolgáltatás")

Windowson fontosabb hogy a fész üzeneted kipattanjon azonnal mert mégiscsak életbevágóan fontos tudni hogy a haverodnak épp csiken dinere van (megszakításkezelés)

A konzolon merik egy alaplapon tárolni az elektronikát a PC ettől a videókártya kell dologtól nem mer eltérni, mert milyen baj is lenne ha az alaplapon közvetlen egymás mellett lenne a CPU GPU és közte a koherens memória amire a direct x puffer közvetlen memóriacímzéssel rámutat...

A Game készítés jó 20-30% az hogy a nagyfelbontású "szinematik"beszkennelt vagy grafikusok által létrehozott asseteket

lebutítsák arra a szintre amit a géped bír és hozzáigazítsák az adott memóriákhoz "optimalizálás". ÉS amikor egy rendszer azt állítja magáról hogy mindez nem kell, hanem ezeket a tartalomkészítők által magasminőségű tartalmakat te közvetlenül tudod kezelni (Unreal 5) akár gigás tartalmakat és amikor megfordulsz a kamerával ezt a 100 gigát neked SSDről bependeríti a memóriába...

akkor van olyan ember aki azt hiszi a 2070 erre alkalmas mert valaki 20szor is elmondta...

-

Malibutomi

nagyúr

válasz

gejala

#51987

üzenetére

gejala

#51987

üzenetére

Mondjuk az AC Valhalla PC-n is fos. A 3090 sem tud 4k 60 FPS-t.

Es itt jon be amit irtam hogy fasza a DLSS, csak epp eddig is voltak fosul optimalizalt jatekok ezutan aztan full szarnak bele a fejlesztok. Minek penzt es idot forditani optimalizalni ha ott a DLSS es tarsai

-

Alogonomus

őstag

válasz

gejala

#51699

üzenetére

gejala

#51699

üzenetére

Pont ahogy írtad is, Turingon lassabb a DXR 1.1 futása. Turingon is elfut (esetleg kis szoftveres segítség kellhet), de Turing az eredetileg eleve nem arra tervezett adottságai miatt nagyon rossz hatékonysággal kezeli. Ezért kell az Ampere, amit már célzottan a DXR 1.1 futtatására készítettek föl.

Raymond: Az ugye világos előtted (az ékezetek létezésén túl), hogy a DXR 1.1 akár emulálható is, ahogy az Nvidia driverből most is biztosítja a sugárkövetést a GTX kártyák esetén is. Ettől viszont élvezhető még nem lesz egy játék, csak meglesz a sugárkövetés benne. A DXR 1.1-hez a régi kártyák közül a 3DMark teszt alapján maximum a 2080Ti lehet eléggé erős kis felbontás mellett, a többi elvérzik.

Persze diavetítésre alkalmasak lehetnek.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Z10N

veterán

válasz

gejala

#47610

üzenetére

gejala

#47610

üzenetére

"Gondolom nem is akarsz majd ezekre 3090-t kötni."

Latom nem fogtad fel az analogiat. Nem fogok 3090-t rakotni, de nem is fogok emiatt uj modularis tapot venni, marad az atalalkto. Ertsd a kisebb kartyak miatt se. Latod BALBOA se dobja ki 1000W-t ezert. Ha a kartya melle kap modularis kabelt akkor jo, ha nem akkor vesz. -

TESCO-Zsömle

titán

válasz

gejala

#47476

üzenetére

gejala

#47476

üzenetére

Miért kéne új HW-t venni? Elég lessz a csuszkát "Ultra" helyett csak "High"-ra vagy "Very High"-ra húzni. Ez a szép a PC-s életben. Itt is gond nélkül el lehet lenni egy vassal 5+ évet is.

Sosem értettem ezt a feltételezést, hogy minden generáció-váltáskor rohanni kell a boltba, mert különben... Ha év végén kijönnek a next-gen konzolok (HW) a legkorábban jövőre, de inkább majd csak 2022-ben lesz PC-re olyan játék, ami natív next-gen motorra lesz írva, mert még a motorok is csak az elmúlt fél-egy évben jöttek ki. Onnan kezdve egy jobb játéknak 2-5 év, mire elkészül a zsáner és a lépték függvényében.

Nem volt ez másképp a korábbi konzolváltásokkor és nem lesz ez másképp most sem. Első évben legjobb esetben is csak felpimpelt multigen vagy egyszerűbb exkluzív címek jönnek.

sz: Ahogy Abu-nk is szokta mondani: Előbb a HW, aztán a SW. Nyilván konzolnál ez gyorsabb lefolyású, mert a HW berobban egy pillanat alatt a piacra, de a SW-nek akkor is kell idő.

-

Abu85

HÁZIGAZDA

válasz

gejala

#47467

üzenetére

gejala

#47467

üzenetére

Ne keverjük ezeket össze. A mai GPU-k úgynevezett veszteségmentes színtömörítési algoritmusokat kínálnak. Ezek az AMD és az NVIDIA rendszereiben is 2:1, 4:1 és 8:1 arányú, veszteségmentes tömörítést kínálnak, amelyek ugyan hasznosak, de nem oldanak meg olyan kritikus menedzselési problémákat, mint a töredezettség. Tehát fel lehet ezekre építeni egy marketinget, és van is valós hasznuk ezeknek az eljárásoknak, de a működésük pontosan ugyanaz.

Az allokálás problémáját egyik ilyen veszteségmentes színtömörítési algoritmus sem kezeli, márpedig a VRAM használatának hatásfoka ettől függ, nem attól, hogy pár kilobájtot nyersz a puffer/image adatokon.

Az alternatív megoldásokkal két probléma lesz. A pletykákban szereplő Tensor magos módszer csak veszteségesen tud működni, vagyis minőségvesztés árán vállalod be, hogy többet nyersz a puffer/image adatok tárolásán. De ez minőségvesztés mellett sem oldja meg a töredezettség problémáját, amitől rossz hatásfokú a VRAM használat, illetve a kitömörítés időbe kerül. Egy image adat betöltése egy mai GPU számára nagyjából 50-70 ns körül van. Arra vannak tervezve a hardverekhez szabott optimalizálások, hogy a wave-ek futtatása szempontjából ezt az 50-70 ns-ot áthidalják konkurens wave-ekkel. Tehát egy shader mondjuk allokál valamennyi erőforrást a multiprocesszoron, ami megenged mondjuk 16 wave-et futtatni. Ebből egy belefut egy memóriaelérésbe, jön a következő wave, és kialakul a működésben egy olyan egyensúly, hogy a wave-ek egy része adatra vár, míg a másik része addig dolgozik. Ez a működés a normál memóriaelérésre van szabva, és ezért van megadva minden architektúránál egy minimum wave szám, amit el kell érni a hatékony működéshez. Ha azonban még át is kell méretezni az image adatot a betöltés után, akkor az az 50-70 ns megnő az átméretezés időigényével, ami jó esetben is minimum 100 ns lesz. Így már jóval nagyobb késleltetést kell áthidalni a konkurens wave-eknek, miközben elképzelhető, hogy nem is futtatható annyi wave a multiprocesszoron belül, ami ezt meg tudná tenni. Sőt, a statikus erőforrás-allokálás miatt igen ritka, hogy egy adott shader képes annyi wave-et futtatni, amennyit az architektúra elméletben megenged.

Ez tehát egy egyensúlyi kérdés, hogy megéri-e vállalni a konvertálás extra késleltetését, azzal ugyanis tényleg lehet nyerni a VRAM oldalán, de ennek az az ára, hogy a GPU közben malmozni fog, amíg adatra vár. -

Devid_81

félisten

válasz

gejala

#47470

üzenetére

gejala

#47470

üzenetére

A DLSS as valoban jo, ha ez a resz megmarad es akar fejlodik is akkor az nagyon pozitiv.

Csak azt nem tudom mik lesznek az Ampere nagy es uttoro trukkjei amivel a Turingokat majd szepen ellehet felejteni.

Mivel egy 1.0-as beta hardware igy ha jol sejtem majd lesznek hatranyok elobb utobb, nVidiat ismererve inkabb elobb... mint utobb

(#47471) GeryFlash nalam az RT az pont az az effekt ami nelkul jot alszok, viszont ha valami miatt durvan pofanverik a sebesseget es ezzel probalnak majd az Ampere fele terelni akkor sirni fogok

-

Alogonomus

őstag

válasz

gejala

#47169

üzenetére

gejala

#47169

üzenetére

Nem is RDNA2-re vontam le a következtetést, hanem arra, hogy ha az 5700XT alatt üzemelő 251 mm²-es RDNA1 chip a 2080Ti alatti 754 mm²-es Turing chip RT játékokon kívüli erejének nagyjából 70%-át tudja, akkor bőven elérhette volna az AMD a 2080Ti RT játékokon kívüli erejét egy nagyobb RDNA1 chippel, amihez épített kártya még mindig 700 USD alatt maradhatott volna. 754 háromszor annyi, mint a 251, és "csak" 40%-kot kellett volna fejlődnie az AMD-nek. Valószínűleg egyébként eleinte volt is ilyen terv AMD-nél, mert nem hiába hagytak legalább két szintet az 5700XT fölött számozásban.

Persze ezt már nem tudjuk meg, mert jön az RDNA2 ősszel. -

Alogonomus

őstag

válasz

gejala

#47089

üzenetére

gejala

#47089

üzenetére

"AMD $500 konzolokba hoz RT hardvert. Ha akarják, azt a szintet ki tudják adni PC-n is $300-350 kategóriában."

A PS5-re fejlesztők elbeszélése alapján, a konzolok RT képessége messze meghaladja a 2080Ti RT képességét is. RTX 1.0 < RTX 1.1Azért nem 20% előnyt fognak hozni az ősszel 2-3x áron (1000-1500$) bemutatkozó kártyák. Mondjuk nehéz is összehasonlítani az ősszel érkező konzolokat egy ősszel összerakható DIY számítógéppel. Egy 500$-os konzol viszont biztosan sokkal erősebb lesz, mint egy 500$-ból megépíthető számítógép.

Azért az eléggé nyilvános, hogy milyen RTX játékok érkeznek 1-2 éven belül PC vonalon. [link] RTX azért nem olyan dolog, amit egy indie stúdió csak úgy poénból váratlanul hozzácsap a termékéhez pár hónappal a megjelenés előtt.

-

Alogonomus

őstag

válasz

gejala

#47083

üzenetére

gejala

#47083

üzenetére

A konzolok ára egyáltalán nem a bekerülési költségüktől függ, hanem attól, hogy mennyi pénzt hajlandóak az emberek fizetni értük. Sony és MS is bőven veszíteni fog a konzolokon, de a játékokkal majd visszatermelődik a meghitelezett veszteség.

2022-ig még elég sok idő van. Amint elkezdenek masszív mennyiségben érkezni az RT 1.1 játékok, akkor bőven elég lesz bevezetnie mind a két gyártónak egy altípust a friss architektúrájához, amivel olcsóbb RT kártyákat tud kiadni az addigra már jobban kiforrott technológiához. A közeli jövőben DXR 1.1 játék nem jön, a jelenlegi 1.0 alapján létező pár játék, plusz a Cyberpunk pedig mindenképpen erős - ezért drága - kártyát igényel.

-

Yutani

nagyúr

-

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- GYÖNYÖRŰ iPhone SE 2020 64GB Red -1 ÉV GARANCIA - Kártyafüggetlen, MS2896, 100% Akkumulátor

- AKCIÓ! FEHÉR ipad pro 13" M4 billentyűzet, VADIÚJ! EU-MAGYAR átvilágítós (lézeresen)

- AKCIÓ! ASRock Z370 i5 8500 16GB DDR4 512GB SSD 2060 Super 8GB Zalman Z9 Plus Enermax 750W

- GYÖNYÖRŰ iPhone 11 Pro 256GB Midnight Green -1 ÉV GARANCIA - Kártyafüggetlen, MS2048, 96% Akksi

- Microsoft Surface Pro 6 i5-8350U 8GB 256GB 1 év garancia

Állásajánlatok

Cég: FOTC

Város: Budapest

4K RT úgy simán lesz, hogy 1080p-1440p dinamikus felbontás felskálázva, ami FSR4-gyel mérföldekkel jobb képminőséget fog adni, mint a mostani FSR3 vagy PSSR.

4K RT úgy simán lesz, hogy 1080p-1440p dinamikus felbontás felskálázva, ami FSR4-gyel mérföldekkel jobb képminőséget fog adni, mint a mostani FSR3 vagy PSSR.

Alig van AAA cím, amihez ne lenne DX12-es mód. Persze sok AAA játék rendelkezik korábbról még DX11-es móddal is.

Alig van AAA cím, amihez ne lenne DX12-es mód. Persze sok AAA játék rendelkezik korábbról még DX11-es móddal is.

.

.

![;]](http://cdn.rios.hu/dl/s/v1.gif)