- Élő adás Utazómajommal és Kerek Istvánnal az AI kapcsán

- Honor 200 - kétszázért pont jó lenne

- Okosóra és okoskiegészítő topik

- Huawei Watch GT 4 - kerek karék

- Xiaomi 14T Pro - teljes a család?

- Xiaomi 15 - kicsi telefon nagy energiával

- iPhone topik

- Leica kamerákat kap a Xiaomi Mix Flip 2 is

- Motorola Edge 40 - jó bőr

- Magisk

-

Mobilarena

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

HSM

félisten

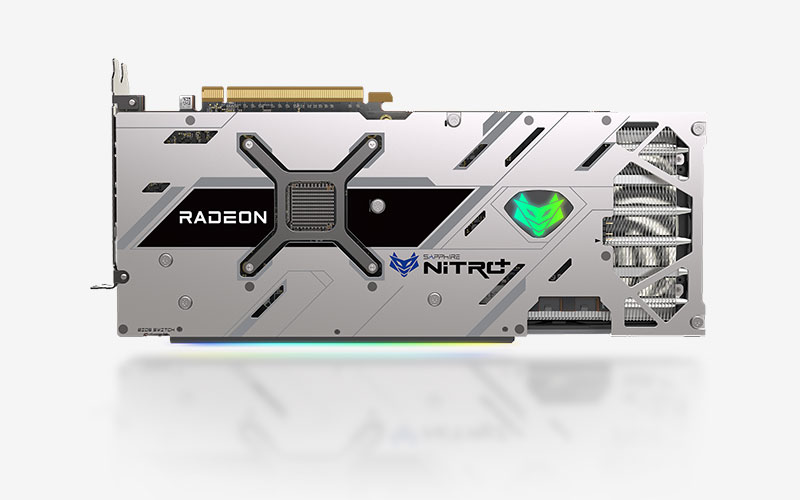

Jelenleg szerintem ami jó vétel, az egy használt 6800XT. Azért gondolom, mert amit kapnék érte használtan mindig arra jutok, hogy annyiért nem érné meg eladni.

Pedig mivel WQHD-ban játszom, van cím, ahol RT-ben jól jönne kis plusz erő. Bár szvsz a 3080-ak között is ki lehet fogni kellően jóárasakat, de ott meg a tipikusan 10GB-os ram a korlát, és annyival meggyőzően nem erősebb csak RT-ben lényeges a plusz.

Pedig mivel WQHD-ban játszom, van cím, ahol RT-ben jól jönne kis plusz erő. Bár szvsz a 3080-ak között is ki lehet fogni kellően jóárasakat, de ott meg a tipikusan 10GB-os ram a korlát, és annyival meggyőzően nem erősebb csak RT-ben lényeges a plusz."és ugye még mindig ott a DLSS, RT, fasza NVENC, stb, ami mind mind extra a puszta számokon túl"

Ezeket egyébként Radeonon is megkapod. DLSS helyett ott az FSR2, szvsz nem lényegesen rosszabb. A natívhoz képest egyik sem győzött meg képminőségre.

RT-t a Radeon is tud. Lassabban, de bőven nem használhatatlan. Az NVENC helyett ugyanúgy van bennük enkóder, csak azonos, alacsony bitrátán van képminőség hátrány, de ez szvsz csak streamereknél lényeges hátrány, ahol fontos, hogy a lehető legalacsonyabb bitrátán a legjobb képminőség legyen elérhető.A használt 3090 ellen szvsz azért szól jópár érv. Egyik a bánya. A kétoldali, erősen melegedő 24GB ram hűtése kevés kártyán volt elfogadhatóan megoldva, ami rengeteg moddoláshoz vezetett, és elfáradt memórialapkák lehetnek a következménye. Ami persze kis szerencsével megfelelő tudású és felszereltségű szakember által persze javítható, de nyilván nem olcsón. A másik a koruk. 300-350 000 forintot adni aprón egy 1-2 éves kártyáért, amin legfeljebb egy, másfél év garancia van, és könnyen lehet sülve a ramjuk?

Szerintem ezzel szemben (és a hasonló áron, 450k körül kínált 4070Ti-al szemben is) jó alternatíva az újonnan, kiskerben, készletről 450 000 forint körül megvehető 7900XT. MSRP alapján az XTX lenne a jobb vétel, de mivel nem kapható, és ha igen, akkor is 600 000-et karistoló árral, annyiért nem tűnik annyival jobbnak.Én arra leszek kíváncsi, mikor fog szelídülni picit az árazás. Mert igazából az elért teljesítmény szvsz egyáltalán nem rossz, a perf/$ arányon lehetne még csiszolni picit.

No, meg megoldani, hogy ne 100W körüli fogyasztású legyen egy videólejátszás/multi-monitor, de remélhetőleg ezt csak idő kérdése lesz a driveres csapatnak kicsit javítani. A Navi21 is először elég magas értékekkel jelent meg, ami pár hónappal későbbi driverekkel lényegesen javult még.

-

Busterftw

nagyúr

-

Abu85

HÁZIGAZDA

A Navi 31 GPU maga olcsóbban gyártható, de a teljes VGA-ra levetítve nincs nagy különbség, mert a NYÁK meg a 4080-nál olcsóbb. A memória meg kb. egyforma.

Az NVIDIA amúgy tudna sokat engedni, mert magát a AD103-at a partnereinek sokkal drágábban adja, mint az AMD a Navi 31-et. De nem azért, mert annyival drágább gyártani, hanem mert annyi kell a magas nyereséghányadhoz. Tehát, ha valaha is árcsökkentés lesz, akkor ahhoz az kell, hogy az NV engedjen az AD103 eladási árán úgy 150 dollárt, akkor még mindig drágább marad a Navi 31 mostani áránál, de nem sokkal, és a partnerek be tudják vinni 1000 dollár környékére.

-

Azt tegyük hozzá, hogy az adott játék konkrétan egy bughalmaz, oldaltól függetlenül...

Nvidia has released a hotfix for its latest Game Ready Driver that it says will fix the issues some players were experiencing in Call of Duty: Modern Warfare 2.

The issue was reported(opens in new tab) by Call of Duty's lead PC studio Beenox on October 28, the day Modern Warfare 2 went into full release. "We've noticed some stability issues with the latest NVIDIA drivers 526.47 on Call of Duty #MWII," the studio tweeted. "For now we'd suggest you keep the 516.59, or 522.25 drivers."

Nvidia later confirmed that there was a problem, saying in an email sent to PC Gamer that "this is specifically why our latest Game Ready Driver wasn't promoted or recommended for this title in the first place." -

Petykemano

veterán

túl szigorú vagy.

A Navi24 nem a RX480/570/580 / 1060+ örököse/utódja, hanem a prüntyögő Polaris23-é.

Feature-setben és árban is oda tartozik.Eközben lassan az RX 6600 is megérkezik a $150-200 tájára.

Az a nagy kérdés, hogy vajon az AMD a NAvi23-nál is kisebb Navi33 kártyát ki meri-e adni / eltudja-e adni ennél drágábban - a tervezett $400 körüli árszinten?

-

Abu85

HÁZIGAZDA

A FreeSync az egy hitelesítő rendszer. A monitorgyártók fizetnek azért, hogy az AMD hitelesíti a termékeiket még a kiadás előtt a VESA-féle Adaptive-Sync FreeSync implementációjára. Ezért a pénzért cserébe kapnak valamilyen plecsnit, aminek megfelel a kijelző, és azt a plecsnit használhatják.

Ugyanúgy működik a G-Sync Compatible is, csak kevesebb kijelzőt hitelesítenek, de ennek is van pénzügyi vonzata, és ezért cserébe a gyártó kirakhatja az NV-nek a logót.

Még annyi, hogy az NV-nél hivatalosan engedélyezett a matricázás is, tehát egy megjelenő kijelző később is megkaphatja a plecsnit, amit a már legyártott dobozokra nyilván rádobnak egy matricával. Az AMD-nél ez nem lehetséges, ők utólag nem hitelesítenek, ha a gyártó a termék megjelenése előtt nem adta le az igényt erre, akkor így jártak.

A plecsnik alapvetően az NV-nél és az AMD-nél is azt szolgálják, hogy ha egy kijelzőn ez megtalálható, akkor garantáltan jól fog működni az adott implementációval. Ha nincs meg valamelyik plecsni, akkor a VESA-féle Adaptive-Sync ugyan engedélyezhető, de az NV vagy az AMD nem tudja garantálni, hogy hiba nélkül működni fog. Ennek azért van értelme, mert ha esetleg az évente érkező sok száz kijelző közül esetleg beesik egy olyan, aminek gondja van valamelyik implementációval, akkor az NV vagy az AMD tudja mostani a kezét, hogy miért nem vettél olyat, amire ők garanciát is vállalnak a hitelesítési rendszerükkel. Persze ilyen távlatban ennek kicsi az esélye, általában már plecsni nélkül is jól működik a VESA-féle Adaptive-Sync, de nyilván az NV és az AMD egy cég, nekik biztos jogalap kell arra, hogy más hibáját ne kelljen lenyelniük.

Az RTX IO a fentiekkel szemben nem hitelesítés. Azt eredetileg arra tervezték, hogy ne kelljen a rendszermemóriát használni, ugyanis az volt a cél, hogy olvassa be az adatot a GPU közvetlenül az NVMe adattárolóról. Ez látszik is az eredeti, két éve megjelent képen. A mostani működés ezt teljesen visszavonta, mert nem lehet ezt a problémát megoldani az AMD és az Intel segítsége nélkül. Az AMD és az Intel pedig rohadtul szarik az NV VGA-piaci igényeire, ők nem módosítják a CPU mikrokódot, hogy valamilyen NV technológia működjön. Ebből pedig az lett, hogy az RTX IO már csak egy brand, mert a működése pontosan megegyezik a DirectStorage API működésével, nem másol semmit sem direkten a GPU-ba az NVMe meghajtóról.

#58749 Petykemano : Nem vásárolnak már annyi wafert a GlobalFoundriestől, hogy gyártani tudják a Polaris 23-at. Valószínűleg amúgy lenne erre anyagi keret, hiszen erős negyedéveket produkáltak az utóbbi időben, de úgy látják, hogy nem éri meg ebbe erőforrást fektetni.

-

Pont az előbb linkeltem be az Nvidiásba az Ada-t [link] amúgy, közel 50% ot lépett előre az RDNA2 höz az is hatékonyságban, úgy hogy ők 301 Wattos fogyasztást mértek. A 4080 jobb perf/ wattban mint a 4090,legalább is TPU szerint, aztán meglátjuk majd ki mit mér, mert pl Tom's -s szerint 251 W a valós fogyasztása ,nem 300 W .

-

Abu85

HÁZIGAZDA

4080 mérések vannak már rendesen, de nem futottam át őket annyira, hogy konkrétan mik vannak. Igazból pár naponta változik a PDF. Nemrég észrevettem, hogy az architecture anyagba is került pár új slide, például a parancsmotorról, ami egyébként tud egy meglepő dolgot. Szóval nagyon változik jelenleg minden, és ezt amúgy tényleg nem követi a lábjegyzet, már egy csomó dolog máshova mutat. Majd valószínűleg a héten véglegesítve lesz.

A perf/watt egyébként attól függ, hogy hol mérik. Van ahol rendesen odaver az új kártya a RTX 4090-nek is. Ha ott nézik a perf/wattot, és főleg konnektorból, akkor ott például nagy lehet az előny, mert a 4090 rég procilimites, amikor a Navi 31 a specifikus multi-draw gyorsítóival még skálázódik, mert leveszi a munkát a GPU-ba épített specifikus hardver a CPU-ról. Szóval csak program kérdése, hogy az AMD kihozza a legjobbnak.

-

Abu85

HÁZIGAZDA

Ott vannak a korábbi PDF-ben, csak az új verzióból kerültek ki, mert kerültek a helyükre más mérések. A 4090 helyett 4080-nal. Korábban ugye nem volt 4080, tehát muszáj volt a 4090-et használni. Most már van 4080, így lehet használni a konkurenst is. Ezért a 4090 kikerült.

Ugyanígy a perf/watt méréseknél is le lett cserélve a 4090 4080-ra. Nyilván októberben, amikor az eredeti PDF készült, még nem volt 4080 a piacon, és nyilván az AMD sem tudott szerezni. A PDF november közepén frissült, és így már lettek benne valós 4080 mérések.

-

paprobert

őstag

A játékok már jól futnak, a driver már nem crashel. Stabilitásban már közel egyenlőség van a két gyártó között.

A professzionális programok integrációja, hardveresen gyorsított video playback néha problémás a pirosaknál. Ezek apróságok önmagukban, de ha szükséged van pont arra, hogy működjön, akkor nagyon idegesítő.

Úgy veszem észre, hogy ahogy egyre több pénz folyik be az AMD-hez, úgy javul az egész szoftveres csomagjuk, kis késéssel. Szvsz idővel még jobb lesz.

-

Callisto

őstag

Piaci részesedést azért is nehéz szerezni (ennyi év lemaradás után főleg), mert az emberek pszichés alapon is döntenek. Hiába van a vásárolni szándékozott alacsonyabb ársávban esetleg még picit többet is adó termék a másik oldalon akkor is abból a márkából fog választani amelyiknek a legjobb terméke van.

-

Petykemano

veterán

Ajánlom figyelmedbe AMD CPU-k jövője - amit tudni vélünk lokál szobát, ha eljövendő vagy épp megjelenő AMD CPU-król szeretnél beszélgetni, találgatni.

-

hahakocka

őstag

Jön az FSR 3.0 is majd S az minden gamen megy míg a DLSS game S Nv exklúzív az ő S a fejlesztők döntèsètől függ. Az RT meg továbbra is 3-4 gameben ha jó ezèrt csorgatni annyit a nyâlat râ. Majd UE5 na az hozhat új RT dolgokat. Olyan pletykàk voltak hogy 2 szeres sima raszter erő S 2,5 szeres RT 6900xt hez kèpest ha ezt hozza olcsóbban S 350W ból a most 2200-2400 akèrt àrult 4090 felkötheti a gatyeszt.

-

Jacek

veterán

Biztos super foleg hogy mostmar kamu kepkockakat is rak bele, ezt a vr jatszok ismerik aws neven szuper cucc.

Majd alkalomadtan VR ben ki kell probalni a dlss-t mindenkinek milyen jo is a kepminoseg:))Tolem aztan mindenki megmagyarazhatja maganak, meg hasznalhatja akar en is benyomom max kenyszerbol.

-

Abu85

HÁZIGAZDA

Az a baj, hogy egy eljárásként beszélsz róla, pedig az elmúlt években legalább egy tucatszor megváltozott, és az MLAA 2.0 egyik nagy előnye, hogy a legkevésbé ez fejt ki negatív hatást a képminőségre, amellett persze, hogy az élsimítás megtörténik (egyedül a temporális zavarok nem kezelhetők driverből, ahhoz mindenképpen programoldali kód kell). Sőt, ez kombinálható a driverbe épített RIS-sel.

Persze, hogy kiadják ezt a fícsőrt. A RIS meghajtón belüli kihasználtsága közel 90%-os, azaz kb. 10-ből 9 Radeont használó ügyfél bekapcsolja. Az MLAA-t is nagyjából a játékosok negyede a mai napig bekapcsolja bizonyos címekre. Ezt ők konkrétan látják.

-

Abu85

HÁZIGAZDA

A driverbe épített post-process AA megoldások közül máig az MLAA 2.0 a legjobb. Csak driverből ennyit lehet elérni. Az mindig egy korlátozott dolog lesz, mert a kész képre dolgozol, és onnan szerzel minden információt. A játékokban is van hasonló post-process AA SMAA néven. Az algoritmus ugyanaz, amit az AMD használ, de a bemeneti adat tekintetében nem csak a végső képre tud építeni. Ez nagy különbség.

#54837 Laja333 : Mert az ML a Microsoft komponense. Az AMD-féle FidelityFX Super Resolution egy keretrendszer. Megadja arra az alapot, hogy különböző módokon elérj jobb minőséget alacsonyabb felbontással. Hogy ebből mit használsz az egyéni tényezőkön múlik. Ha mondjuk kiadod a játékod Xboxra, akkor nyilván használhatod majd a Microsoft FidelityFX Super Resolutionnel kompatibilis komponenseit, és ezek természetesen áthozhatók PC-re. De ha valaki saját komponenseket fejleszt, akkor az is lehetőség. Nem kötelező ugyanis a Microsoft és az AMD komponenseire építeni, mert ezek nem biztos, hogy minden programban jó eredményt adnak. Ez azért van így, mert a DLSS is programfüggő. Hol működik, hol nem. Erre nem lehet egységesen reagálni, így komponensekre bontották le a FidelityFX Super Resolutiont. Ez valójában tehát nem egy eljárás, hanem eljárásokkal való kompatibilitást biztosító keretrendszer, amibe az adott motorhoz legjobban illeszkedő komponensek fejleszthetők, vagy az előre elérhető Microsoft/AMD komponensekből összeválogathatók.

Ezért is integrálta a FidelityFX-et a Microsoft az Xbox saját GDK-jába. Innentől kezdve egy kattintásos fícsőrrendszert akarnak a fejlesztőknek. Aztán eldöntik, hogy duplán ráklikkelnek erre, hogy működjön Xboxon és PC-n, vagy hónapokat áldoznak az idejükből, hogy hasonló minőséget kihozzanak máshogy.

#54831 Alogonomus : A DLSS 3.0-ról sosem beszélt az NVIDIA. Az egy kamuvideós kamuképzelgése volt.

Az NV-nek amúgy nem is a DLSS 3.0 hiányzik, hanem meg kell oldaniuk a D3D12 játékok overhead problémáit, mert az ilyen felskálázós fícsörökben hatalmas előny a Radeonoknak, hogy eléggé jól kezelik a CPU-limitet. Ez azonban az NV-nek egy probléma, mert nem a GPU képessége fog számítani, hanem az, hogy az adott alkalmazás mennyire korlátozza a parancsfeldolgozást, így a felskálázós eljárásoknál azok az eredmények kerülnek elő, amiket a Hardware Unboxed mért Full HD alatti felbontással, és azok nem szépek. Azért nem egy nagy cél, hogy erre menjen el az ipar, mert a probléma nehezen kezelhető az NV számára. -

#09256960

törölt tag

LOL Make my day !

Hévíz kifolyócsatorna , Kovid free, ember free + forró !

Egész érdekes ez az asztal amúgy.

Mire vége lesz ennek a fránya vírusnak sokan fognak rádöbbenni hogy nézd már Jani ez a fa, ez a tó. jönnek szemben az emberek és nem kell elfutni, a sok üléstől szaloncukor pocakos ember mikor kitör -

Simid

senior tag

Egyrészt nem volt szó arról, hogy több mint kétszeres teljesítmény lesz FPS-ben (Tflops-ról volt szó!), másrészt ez az amiben lényegében az optimistábbaknak lett igaza, hiszen Navi10 vs Navi21 volt a téma. Ahol van összesítő grafikon ott mindenhol az jön ki, hogy kb 85-90%-kal jobb a 6800XT és ugye ez nem a fullos GPU, plusz nincs SAM meg OC beleszámolva. Tehát a 6900XT-vel szinte biztosan meglesz a több mint kétszeres sebesség az 5700XT-hez viszonyítva, még játékok alatt is.

Lehet ezen itt fanyalogni, de pl Jack@l 2 hónapja, még gúnyosan röhögcsélt azon, hogy van olyan hülye aki elhiszi, hogy az AMD tud 300W-ból kétszeres teljesítményt. Aztán most ez a realitás. Nem hugyozta ketté a NV-t, még egyértelműen jobb sem lett, de beérték őket, ez tény. -

Petykemano

veterán

Azért kérdeztem, hogy melyik kártya, mert az, hogy a 60CU-s kártya nem 2x a 40CU-hoz képest, az nem lep meg.

Önmagában az sem lep meg, hogy 4K-ban az nvidia erősebb. Hiszen direkt arra gyúrtak (mégha ebben esetleg több volt a kényszer, mint az előre eltervezett szándék akkor is) a "dupla" CUDA magokkal, arra építették fel a marketinget is. Még nyöszörgés is volt, hogy hát a 4K azért a játékosok kis részét érinti.

Én ezzel tökre tisztában voltam és egyáltalán nem lep meg, hogy a magas frekvencia inkább alacsonyabb felbontáson csillan meg.

A tpu-n néztem pár újabbnak hangzó címet, Strange Brigade pl, és ott 4K-ban nem teljesít alul.

Én azt látom, amit vártam az előzetes infók alapján. Az árazás felbaszós, de hát az már csak ilyen.

-

Malibutomi

nagyúr

-

-

Abu85

HÁZIGAZDA

- Pont azért mennek a fejlesztők DXR 1.1-re, hogy ne kelljen adatmozgásra optimalizálni. A most érkező RT implementációk nem DXR 1.0-sok. DiRT 5, Godfall, World of Warcraft: Shadowlands, The Riftbreaker, Cyberpunk 2077, stb. DXR 1.1-gyel jóval egyszerűbb optimalizálni.

- Az AI upscalingnek nincs köze az RT-hez. De mondjuk ez az irány az AMD-nek túlságosan kedvez, mert az Infinity Cache hatásfoka a felbontáson csökkenésével nő, és az AI upscaling megoldások pont kevesebb pixelt számolnak, majd azt skálázzák fel. Ez az Infinity Cache-nek egy mennyország, Full HD-ben nem egy játékban gyorsabb a sima 6800 a 3080-nál, akár 3090-nál is. Az XT meg a 80 CU-s csúcskártya egy másik liga itt. Ez az AI upscalingnek betehet, mert innentől kezdve az NV érdeke is inkább az lesz, hogy 4K-ban mérjék ezeket a hardvereket, ne az AMD-nek kiemelten kedvező AI upscaling technikákkal.

- Előbb nézd meg az új játékokat.

- A Godfall "nem meglepő" módon nem tartalmaz még mindent. Van egy review kód, ami már az összes grafikai beállítást alkalmazza, és az 4K-ban, mindent maxra rakva 12,9 GB VRAM-ot igényel. A réjtrészing megtolja egy picit a memóriaigényt, mert az árnyékok számítása maximális LOD mellett történik. Tehát a távoli objektumokat is be kell rakni a VRAM-ba teljes részletességgel, amelyeket amúgy nem kellene. Ezen majd egy későbbi rendszer javíthat, a cikkben leírjuk, hogy pont ezért tették programozhatóvá az RDNA 2 bejárási lépcsőjét. Ez nagyban segít a memória terhelését csökkenteni, csak egyelőre egyik szabványos futószalag sem támogat programozható bejárást, így kényszerűen ki kell választani a LOD szintet a sugár indításakor. Ez viszont nagyon memóriapazarló.

- Ez így marad egy darabig. -

Abu85

HÁZIGAZDA

A driver ezen nem tud segíteni. Az alkalmazás oldalán lehet csak optimalizálni az adatmozgást DXR 1.0-ban. DXR 1.1-ben nem kell.

#52556 Jack@l : Az Ampere-en nem azért nem gyorsult a régebbi játékokban a DXR sebessége, mert a hardver nem erősebb, hanem azért, mert nincs ráoptimalizálva az adatmozgás. Ugyanakkor az Ampere hardveresen sokkal erősebb, ez látszik például a 3DMark erre vonatkozó RT tesztjén, csak a régebben kiadott játékok Turingra optimalizált adatmozgást használnak, és ez nem optimális se az Ampere-en, se az RDNA 2-n. De ezt elmondta az NV is, hogy a valós változáshoz meg kell várni az új játékokat, amelyek már Ampere-re is optimalizálva lesznek. A régieket nem patchelik fel generációnként.

A jövőben erre amúgy nem is lesz szükség, mert a DXR 1.1 megszünteti ezt a problémát azzal, hogy szeparált shaderek miatti adatmozgás eleve nincs ezen a futószalagon, szeparált shaderek sem lesznek. Tehát az Ampere az jobb lesz, csak meg kell várni az új programokat. Ez a Godfallban egyébként már látszik. -

#09256960

törölt tag

Isten egyszer nagyon megharagudott az emberekre úgy döntött mohóságuk miatt megbönteti őket...pusztulniuk kell.

gyszer csak dörömbölnek nagy dírrel durral a mennyország kapuján.

-Igen mi a kérdésed kérdezte Szent Péter ?

- A 10 GB mindenre elég !!!

-De ez nem kérdés... mindegyis jelentette az esetet Istennek.

-Akkor az magához hívatta prófétát egy esélyt adok az emberiségnek...

Ha el tudod magyarázni ezeknek az embereknek hogy működik a videókártya...

Magyarázta az szent írásokkal, hieroglifákkal, mennyei manával ahogy csak sziszifuszi küldetése engedte.

Majd eléjárultak az emberek hogy megtudják sorsukat.

Szent Péter csak ennyit mondott elcsukló hangon:

A Kovid marad !

-

Abu85

HÁZIGAZDA

A Frostbite teljesen más kategória. Az kvázi nem is szabályosan fut a DirectX 11-es implementációkon. Kb. olyan ez, mint az Ashes of the Singularity. Dan Baker nyilatkozta régen, hogy ha minden gyártó DirectX 11-es implementációján szabályosan futnak, akkor az harmadolná a sebességet. De a gyártók a tipikusan használt motorokat leprofilozzák, és egyszerűen bizonyos DirectX 11-ben sok teljesítményt zabáló szabályokat megkerülnek. Azt hazudják például az API-nak, hogy megcsinálták a törlésre váró erőforrások ellenőrzését, de közben nem. Ezzel egy rakás teljesítményt nyernek, csak ha véletlenül olyat törölnek, ami még kell, akkor marha nagy kapituláció van ám. "DXGI_ERROR_DEVICE_HUNG" hibaüzi a Battlefieldek alatt? Ugye-ugye egyszer-kétszer már előfordult.

Lehet egyébként így dolgozni, de nagy teher ez az AMD és az NVIDIA számára, hiszen gyakorlatilag minden egyes patch-hez új meghajtóverzió kellhet, tehát ahogy fejlődik a játék, úgy kell fejleszteni a meghajtót is. Ez egy rakás erőforrást leköt, és a top játékokra bevállalható, de mindre egyszerűen nem lenne kapacitás. Még az NVIDIA-nak sem. Az explicit API-kkal viszont ez már nem gond, azok ebből a szempontból jobban működnek. Cserébe máshol van velük probléma, de összességében ez egyszerűbben kezelhető ám a befektetett erőforrásokat tekintve.

-

arn

félisten

-

-

arn

félisten

azert epp nem nyuzsgok, mert altalaban addig erdekelnek az ujdonsagok, amig ujdonsag... ha nem sikerul megvenni, akkor egy ideig meg probalkozok, aztan elkezdek gondolkodni, hogy jo a mostani

oszinten szolva ha lenne 400 eur kornyeken (hasznalt) 3950x, azt veszem, mint 570ert 5900xet. de bizakodva azert a rendelest leadtam 5900xre.

oszinten szolva ha lenne 400 eur kornyeken (hasznalt) 3950x, azt veszem, mint 570ert 5900xet. de bizakodva azert a rendelest leadtam 5900xre.es akkor lehet lapot se cserelek, marad az x470. ami nem eppen tokeletes (gyengecske vrm), de egyreszt passziv, masreszt meg van rajta eleg slot - mert pl az "olcsobb" b550/x570 lapokba ugy tudom belerakni a video+capture kartyat, hogy megfeleztem az x570 pcie sebesseget (2x8). akkor meg ugyanott vagyok, mint pcie3 2x16tal. talan gigabol van kivetel, de ennek a lap dolognak majd ujra nekiugrok, ha aktualis.

koszi a tippet, de ez is vmi 400+ eur egyszeruen mar elvbol nem adok ki ennyi penzt egy mainstream lapra, max 200 eur. kicsit messze kerultunk attol, hogy a 2700x + normalisabb lap kijott 500 eurobol a megjelenes utan nem sokkal.

egyszeruen mar elvbol nem adok ki ennyi penzt egy mainstream lapra, max 200 eur. kicsit messze kerultunk attol, hogy a 2700x + normalisabb lap kijott 500 eurobol a megjelenes utan nem sokkal. -

-

Malibutomi

nagyúr

Azert egy mokuskerekes huteshez kepest elegge el kell b@szni egy 3 ventis hutest hogy hangos legyen

AMD helyeben egy dolgot tuti valtoztatnek az 5700 sorozathoz kepest.

Nem raknek be olyan sok szenzort a homersekletre.

Ha a faek egyszeru user nem latja hogy van hotspot akkor nem is aggodik rajta. -

Vagyis erre fognak fejleszteni, hogy ez ne okozzon gondot, ergo a Radeonokon az említett kevés kivételtől eltekintve ott fog pihenni extra 6 GB VRAM.

Rossz oldalról nézed, a fejlesztéseknél az opciók határozzák meg a lehetőségeket. Mondjuk Low-hoz megfutja a 4-6GB, Medium beállításhoz is elég a 8GB, High-hoz már 10GB kell, Ultrához meg 12-16GB...

Ez egy lehetséges felállás, de ilyen téren a Resident Evil 2 és 3 Remake nagyon jó példa... -

#09256960

törölt tag

Nem is azt mondanám Yany hogy mennyire terjed el, hanem ha lesznek Far Cry 6-ok amik kihasználják a 12 16 GBot akkor az gerjesztőhatású, most azért nem írnak mert nincs kártya akkor mire írjanak 16 GBot betöltőt. 20 GB GDDR6Xel te nem fogsz törni utat mert elenyésző eladásai lesznek. De a nagy utat a konzol töri az tuti, azt hallottátok hogy 7 GB/s SSD-t lehet venni a Xboxhoz pluszban? (219 dollár) Az jó gyors

-

paprobert

őstag

"De tudod minimálisan visszavett textúrarészletességgel. Nem látom tragédiának. Amúgy a helyzet az, hogy mivel csúcskártyák 10 GB-ot (is) hordoznak, ezért egy-két elvetemült játékot leszámítva nem lesz jellemző, hogy ezt a határt túllépnék ebben a generációban a játékok."

Ma a 10GB-os kártya mellett érvelni olyan, mint 2014-ben egy 2 vagy 3 GB-os kártya mellett. Biztosan nem lesz elég hosszú távon, középtávon talán.

Abból indulj ki, hogy 10GB lesz a Series X-en a gyors szelet, PS5-ön pedig 16GB mínusz a rendszer.

Nem az NV aktuális kártyája szabja meg a minimumot, hanem a konzolok.Talán az tompít a VRAM hiányon valamelyest, hogy lesz Series S összesen 10GB RAM-mal, illetve a fejlesztők sem akarnak eldobni 150 millió fizetőképes felhasználót az előző generációból, tehát az átmenet potenciálisan el tud húzódni.

-

Petykemano

veterán

Bocsánat, erről biztos lemaradtam.

Korábban amikor pampogtam, hogy MSRP fölött kapható a kártya, az volt a válasz, hogy az MSRP csak ajánlott fogyasztói ár, senkire nézve nem kötelező érvényű. (Akkor az mégse igaz?)Azt gondolnám, hogy egy gyártó annyiért értékesíthet kártyákat, amennyiért akar, kivéve persze ha erre vonatkozólag van az Nvidiával megállapodás.

Nem lehet, hogy arról van szó, hogy az MSI-nek voltak már leadott előrendelései kereskedőktől valamilyen eredetileg tervezett áron, és az MSI azzal próbálkozott be, hogy direkt értékesítési útvonalon kínálja - hasonlóan emelt áron - a kártyákat ahelyett, hogy eredeti - alacsonyabb - áron teljesítse a már korábban a kereskedők által leadott rendeléseket?

De abban nem akadályozza meg az MSI-t semmi, hogy a holnap leadott rendeléseket már $100 vagy $200-ért drágábban fogadja be. Más kérdés, hogy a kereskedő erre mondhatja, hogy akkor inkább a másik gyártótól rendelem.

De elméletben előállhat az, hogy minden gyártó $100-200-ral többért adja minden kereskedőnek, mint 1 hónapja és így a tartósan magas ár nem feltétlenül jelenti azt, hogy az MSRP feletti részt a kereskedők nyelik le. -

#09256960

törölt tag

Nem az ő pontja fordította inggyé

NV kiszervezte az eladását akkor az most ő még ?

De mennyit adott el az MSI amíg lebukott ? és tudod e garantálni hogy külső cégeket ne alkalmazzanak árfelhajtó hatásért?

Kellene egy a cigihez hasonló fixáras megoldás, csak ugye a custom azt mondaná drága a hűtés...

Ezért kellene egy szabvány is először megvennél egy drága réz hűtést

na a réz az az anyag ami MÉHben 9 ezer a videókártyán meg 100.

és naked kártyákat árulni és csak átpattintanád. -

PitLee

őstag

Nem értek az ilyen dolgokhoz, de az AMD-nek talán még ma is van a "Virtuális szuper felbontás" nevű opciója amivel pl egy FHD-s moncsira beállíthatsz nagyobb felbontást amit aztán vissza alakít FHD-ra és állítólag szintén részletgazdagabb egy kicsit az élmény.

Ui: Hmm, de lehet keverem vagy csak simán félreértettem anno -

#09256960

törölt tag

Itt a NATO kontaktja a Neural Supersampling-nak.

Csak hogy ne legyenek kétségeid Zsolnai Fehér Károly féle technológia hol fog kikötni és mire... -

Petykemano

veterán

azt gondolnám, hogy a sony és a MS érdeke is, hogy legyen valami. Hiszen nekik is érdekük, hogy adott felbontáson nőjön az fps vagy hogy magasabb felbontást tudjanak célozni amúgy gyengébb és olcsóbb hardverrel. Nem is beszélve streamingről, amellyel kapcsolatban épp most mutatta be az nvidia ezt a videohívásos megoldást, ami lényegében arról szól, hogy egy low-quality streamet generál és egy nagyfelbontású minta alapján skálázza fel.

És mivel kvázi egy hardvert használnak, így akár közös érdekük is lehetne, hogy szabványos legyen. AMD hardver-only megoldást nem tartok valószínűnek.

-

sutyi^

senior tag

A DLSS akkor válik igazán ütőképes fegyverré ha minden címben akár control panelből kapcsolhatóvá válik.

Jelenleg viszont bármilyen jó a 2.1 még mindig kell hozzá a játékfejlesztőktől az integráció, illetve még mindig az NV szerverein készül a játék specifikus neuron háló ami annyira nem univerzális hogy nem hogy egyik nem jó a másik címhez, hanem a feltanitott hálózat sem minden esetben jó egy játékon belül.

-

Mumee

őstag

Igen, bár nyilván nem lesz mindenben ugyanolyan vagy jobb. Már önmagában az valószínűbb, hogy a teljesítmény jobb lesz, mint hogy egyből azonos tudású DLSS/RT.

Persze lehetnek meglepetések, hisz ha alacsonyabb felbontásban a skálázás miatt jobb lehet a Navi, akkor a "DLSS" skálázást is pozitívan befolyásolja hogy alacsonyabb felbontást számol a VGA.Ezt a DLSS mizériát is jó lenne tisztába tenni.

DLSS quality, balanced, performance, ultra performance.

Ugye ahol jobb képet adhat, mint a natív az csak a quality jelenleg, mert ott még nem túl alacsony felbontásról skáláz.

Mondjuk elég relatív ez a jobb képet ad(hat), hisz ki hogy érzékeli, meg melyik játékban mennyire jó az "AI háló". -

Raggie

őstag

Én csatlakoznék ehhez minimális módosítással:

-ár/értékben nekem elég ha pontosan ugyan azt hozza, mint az nVidia. Nem kell hogy jobb legyen, elvégre nem fogok több örömet kapni semelyik játéktól csak azért mert zöld kártyán megy a piros helyett csak a konkrét teljesítmény számít szerintem.

-az kell hogy kapható legyen és tényleg annyiért

-kell a jó minőségű (és halk) hűtés

-nem árt a 300 W alatti fogyasztás sem, de ha az egyel fentebbi pont teljesül én igazából ezt a pontot lesz@rom

-kell a kapásból jó driver

-egyelőre lesz@rom a dlss és hasonló feljavító technikákat (igen a 2.0-t is)

Szóval szerintem ezekkel már jók vagyunk. Hozzáteszem, hogy nem biztos, hogy a csúcs kártyájukat fogom megvenni, mert valszeg nem lesz rá pénzem, de egyel a csúcs alattira benevezek az biztos. -

Petykemano

veterán

A CDNA biztosan HBM-mel jön.

Azt nem tudom, hogy van-e olyan professzionális, de grafikus workload, amit a CDNA nem tud kiszolgálni emiatt, viszont hasznos az 1-2TB/s sávszélesség. Amennyiben ilyen van, akkor lehetséges.

Ha apple-nek készül kártya, az nagy valószínűséggel az lesz.Tehát ha fentiek közül valamelyik teljesül, akkor látom esélyét annak, hogy legyen egy olyan fejlesztés, ami 80CU-s 2-3 stack HBM (ha három elfér egymás felett egy sorban), amit az apple kap meg, meg professzionális duo kártyákba az kerül és esetleg betámadható vele a High End mobile gaming.

Utóbbira az AMD-nek marketing szempontból van leginkább szüksége. Hogy erősítse azt a vonalat, hogy "AMD laposom legyen, mert az kúl."

De szerintem ez egy félgeneráció múlva esedékes kb úgy, mint a navi 12 volt.

Természetesen ha azoknak lesz igazuk, akik szerint az 536mm2-es lapka már tartalmaz 2048bit HBM2E vezérlőt, akkor hamarabb is jöhet.

-

Alogonomus

őstag

A fogyasztáselőny az már csak az AMD kártyáinak méretéből következően is kijelenthetővé vált. A teljesítmény kérdéses csak, de azzal kapcsolatban is érkeznek a pletykák.

A "3080 és 3090 hűtőjével" szófordulat alatt nyilván nem azt értettem, hogy az Nvidia kártyákkal csereszabatos lehetne a hűtő, hanem hogy a 3 slotos 30-33 centis Nvidia kártyák hűtési megoldását alkalmazzák az AMD kártyák esetén az alkatrészek eltérő helyzetéhez igazítva a hőátvevő felületeket.

-

Devid_81

félisten

-

KRoy19

őstag

Tech Jesus inkább csak a marketinget figurázta ki, miszerint a 3090 egy 8k gaming kártya, hozzáteszem teljesen jogosan.

Ettől függetlenül tudja Steve is, hogy ha a helyén kezelik, miszerint a 3090 egy verhetetlen ár/teljesítményű félprofesszionális kártya,, mert ekkora teljesítmény ennyiért 24gb vrammal szinte ajándék annak aki 3d renderre akarja használni(ráadásul lehet rajta játszani is nem akármilyen teljesítménnyel) akkor nagyon is jó produktum a 3090.

-

Laja333

őstag

Ez a "nem számítottunk ekkora érdeklődésre" a marketing része.

Tudták ők nagyon jól, hogy nagy lesz a kereslet, hiszen azt is tudták, a 1xxx tulajok többsége kivárt (még a videóban is kitér erre Jensen). Azt is nagyon jól láthatták, hogy a lockdown miatt még az is gépet upgradel most, aki azt se tudja mi az hogy PC.

És akkor most erre úgy készülnek fel, hogy nem hónapokkal előtte kezdik el feltölteni a raktárakat, hanem csak augusztus elején. -

Busterftw

nagyúr

Itt spanyolban 2 legnagyobb webshopot neztem 2 oratol, plusz az Nvidia siteot.

14:55-tol kb 10 masodpercenkent frissitettem az oldalt.Mindharom oldal atvaltott Notify me-rol out of stock-ra 3kor.

Fizikailag lehetetlen ennyi ido alatt kifogyni a "keszletbol".

Utana kerdezem a webshopokat hol vannak a kartyak, persze ok is kamuzzak, hogy hatalmas volt az igeny es es nagyon keresett az aru, hamar kifogytak.Erre en kerdezem, hogy pontosan mikor fogytak ki 14:59 55 masodperc es 15:00 3 masodperc kozott?

Nem is valaszoltak.Arra a Zotacra azert erkezetett huszezer rendeles, mert az a modell volt listazva egesz nap es masnap mint kaphato termek.

Meg en is adtam le ra rendelest, mert az osszes EU webshopbol oda ment mindenki.

Na ezert adtak le ra rendelest, mert mashol egyszeruen nem hogy eselyed nem volt venni, hanem nem is volt keszlet. -

Malibutomi

nagyúr

Hagyjuk mar, ha olyan nagy keszlet volt hol van? Mert a boltok nem kaptak belole.

Nem az tortent hogy viszik mint a cukrot es kifogytak a boltok aztan tele a net mar a hasznalatrol a kepekkel es tapasztalatokkal, hanem venni sem lehet mert a boltokba nem is jut el.Megegyszer: nincs a boltokban, nem is volt csak mutatoban par darab es nem is tudjak mikor lesz.

ha ez nem paper launch akkor semmi

-

-

TESCO-Zsömle

titán

Nem biztos, hogy a Noctua egyáltalán vállal custom design-t...

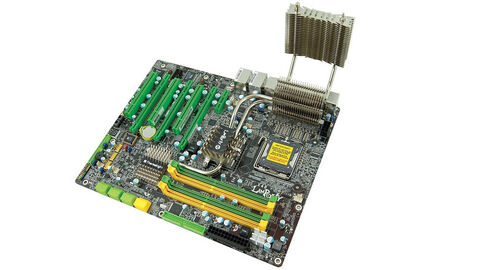

Emlékszem anno a bukánkat p*sáltuk le, mikor a DFI alaplapjára gyárilag a Thermalright adta a hűtést:

Ez annak a korszaknak volt a vége, mikor dívott 2 kiló rezet ráverni a lapra mindenféle ótvar/cirádás hűtő formájában. Akkor ez, a TR-tól megszokott letisztult, hőcsöves design, a hátsó I/O-n keresztül a házventi mögé kikúszó hűtéssel, amihez hasonlót még egyet az NB-ről lecsatolható süni helyére is lehetett helyezni, maga volt a csúcs. Miközben a konkurencia zömmel préselt/lakkozott, a TR mindent forrasztott és nikkelezett. -

Petykemano

veterán

vannak már Fortnite-os screenshotok

Én nem tudom, hogy hogy szokott viszonyulni a tényleges lapka a kártya hátoldalán levő forrasztásokhoz. De ha ez méretarányos, akkor a PCIe csatlakozó 89mm-es méretébe sacc/kb 3x fér bele a hátoldali forrasztás, ami eléggé négyzet alakú.

Nekem kifejezetten nagynak/soknak tűnik a forrasztás.Összehasonlításképp: a polarisé egész kicsi volt

a vegáké hatalmas kiterjedésű

A Navi10-é nagyobb, mint a polaris, de belefért a fém merevítőbeNa mindegy, csak azt akartam ezzel mondani, hogy ha valósághű, akkor szerintem a lapka nagyobb lehet mint a navi 10

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- AMD Ryzen 9 / 7 / 5 9***(X) "Zen 5" (AM5)

- Építő/felújító topik

- Élő adás Utazómajommal és Kerek Istvánnal az AI kapcsán

- Mielőbb díjat rakatnának a görögök az olcsó csomagokra az EU-ban

- Renault, Dacia topik

- A Perplexity felvásárlását fontolgatja az Apple

- Honor 200 - kétszázért pont jó lenne

- Okosóra és okoskiegészítő topik

- Kerékpárosok, bringások ide!

- Beszántaná a marketingért felelős részlegét az Intel

- További aktív témák...

- BESZÁMÍTÁS! Samsung Odyssey G5 32 144Hz WQHD 1ms monitor garanciával hibátlan működéssel

- OnePlus 13 - Black Eclipse - Használt, karcmentes

- ÁRGARANCIA!Épített KomPhone Ryzen 5 5600X 16/32/64GB RAM RX 7600 8GB GAMER PC termékbeszámítással

- Tablet felvásárlás!! Apple iPad, iPad Mini, iPad Air, iPad Pro

- LG 39GS95UE - 39" Ívelt OLED / QHD 2K / 240Hz & 0.03ms / 1300 Nits / NVIDIA G-Sync / AMD FreeSync

Állásajánlatok

Cég: CAMERA-PRO Hungary Kft

Város: Budapest

Cég: PC Trade Systems Kft.

Város: Szeged

Pedig mivel WQHD-ban játszom, van cím, ahol RT-ben jól jönne kis plusz erő. Bár szvsz a 3080-ak között is ki lehet fogni kellően jóárasakat, de ott meg a tipikusan 10GB-os ram a korlát, és annyival meggyőzően nem erősebb csak RT-ben lényeges a plusz.

Pedig mivel WQHD-ban játszom, van cím, ahol RT-ben jól jönne kis plusz erő. Bár szvsz a 3080-ak között is ki lehet fogni kellően jóárasakat, de ott meg a tipikusan 10GB-os ram a korlát, és annyival meggyőzően nem erősebb csak RT-ben lényeges a plusz.

![;]](http://cdn.rios.hu/dl/s/v1.gif)