- Samsung Galaxy S25 - végre van kicsi!

- Kézbe fogható paradoxon lett az iPhone Air

- MIUI / HyperOS topik

- iPhone topik

- Google Pixel topik

- Samsung Galaxy S24 Ultra - ha működik, ne változtass!

- Honor 200 - kétszázért pont jó lenne

- Fotók, videók mobillal

- Poco F7 Pro - jó, de az amatőr sem rossz

- Milyen okostelefont vegyek?

-

Mobilarena

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

#85552128

törölt tag

válasz

Blue Thunder

#25196

üzenetére

Blue Thunder

#25196

üzenetére

75 hz-et nem fogsz 4K-n átvinni és nem úgy működik az a Custom felbontásos dolog, hogy akkor leveszi magát 60-ra... Próbáld meg, hogy 60-at írsz be.

Amúgy miért nem Windowsban állítod a felbontást az adaptertulajdonságoknál pedig a Hz-et [kép] ?(#25200) Blue Thunder: A monitornak/adapternek nincs valami "drivere" ?

-

HSM

félisten

válasz

Blue Thunder

#25196

üzenetére

Blue Thunder

#25196

üzenetére

Hát, praktikusan 60Hz-et kellene ott alul látni, mivel azt tudja az adapter.... De a többi időzítési paraméter sem viccnek van ám... Szval jó lenne ezt PONTOSAN beállítani az adapter képességeinek megfelelően. Persze, lehet próbálkozni (hiszen a felbontás és elvárt frissítés ismert), de az vagy jó lesz, vagy nem....

-

válasz

Blue Thunder

#25196

üzenetére

Blue Thunder

#25196

üzenetére

indíts el egy játékot, vagy filmet, ami 3d frekvenciára emeli a kártya órajelét, és nézd meg úgy a frissítési frekit a monitor osd menüjében. természetesen hdmi-n keresztül.

-

válasz

Blue Thunder

#25192

üzenetére

Blue Thunder

#25192

üzenetére

értem. próbáld meg 3d frekin is, mondjuk játék közben.

-

#85552128

törölt tag

válasz

Blue Thunder

#25190

üzenetére

Blue Thunder

#25190

üzenetére

Írhatsz a Delock vagy AMD supportnak, de a fenti Club3D adapterhez driveres support is kellett anno. Itt is azt írják, hogy még azzal sem ment eleinte minden simán [link] driver/adapter firmware update(!) kellett, hogy működjön. Szóval érdemes lenne a natív DP 1.2-vel kísérletezni, akár a kártya gyártójától újabb BIOS-t kérni.

-

HSM

félisten

Nem észleli automatikusan BOOT alatt.

Ha rosszra dugod nincs kép. Tehát BIOS-ban is IGP-re kell állítani, IGP-be dugni a monitort, és úgy lehet esélyed, hogy képed is lesz, és a VGA-t is látja (áram alá helyezett VGA-t persze). Bár elég kicsi esélyed.

Ha rosszra dugod nincs kép. Tehát BIOS-ban is IGP-re kell állítani, IGP-be dugni a monitort, és úgy lehet esélyed, hogy képed is lesz, és a VGA-t is látja (áram alá helyezett VGA-t persze). Bár elég kicsi esélyed.(#25186) Blue Thunder: Ez a beállítás 8Hz-es, el van rontva.

Ezzel nem csoda, ha nem működik.

Ezzel nem csoda, ha nem működik.

Bár amúgy azt nem teljesen értem, ez miért találgatós topikba és miért nem a 290/390 topikban téma, ott több tapasztalat lehet ebben a témában...(#25188) Sakka: "Amúgy én manuálisan tudnék dual biost mókolni rá?"

Elvileg lehetséges, ha elég ügyesen bánsz a pákával. De akkor már egyszerűbb le és vissza forrasztani az eredeti csipet.

Most írtam hogy lehet... A Te típusodról lespórolták, más típusokról meg nem biztos.

-

válasz

Blue Thunder

#25187

üzenetére

Blue Thunder

#25187

üzenetére

akkor miért nem dp porton keresztül van meghajtva a monitor?

-

#85552128

törölt tag

válasz

Blue Thunder

#25187

üzenetére

Blue Thunder

#25187

üzenetére

Milyen adapter ?

Mert ha nem olyan mint a fenti akkor az HDMI ~1.4-be alakít át.

Mert ha nem olyan mint a fenti akkor az HDMI ~1.4-be alakít át. -

Blue Thunder

senior tag

Na egyedinél állítottam korábban 60-hzre, de akkor a crimson-ba kiírta hogy nem támogatott, na most a kijelzőt meg érzékelte hogy 75hz-ig lehet...na jó mondom kipróbálom...na ennél nem írta ki hogy nem jó sőt el is mentette mint látható, de a monitor felugró "információja" még mindig azt írja hogy 30hz-en van

-

válasz

Blue Thunder

#25165

üzenetére

Blue Thunder

#25165

üzenetére

hdmi-n keresztül 4k@30Hz-t kapsz, mivel a kártya hdmi csatolója 1.4es, és az ennyit tud, akármilyen kábeled van hozzá.

a dp portja 1.2, ez elvileg képes 4k@60hzre minden ráolvasás nélkül. -

Sakka

tag

válasz

Valdez

#25178

üzenetére

Valdez

#25178

üzenetére

Integráltal be tudom hozni a rendszert szép és jó.

Viszont úgy nem ha közben áram alatt van az R9.

Csak úgy ha kihúzom a csatikat, viszont a pCI foglalatban marad, csak a táp megy le róla.Megnézem majd, lehet, hogy csak ennyi lesz köszönöm ezt a tippet!

Amúgy mondták nekem azt is, hogy esetleg multi gpu módot állítsam..

De elvileg ha egy külső kártya áram alatt van és benne van a slot-ba, de a hdmi kábel az alaplapira van csatolva, nem észlelné automatikusan?

-

HSM

félisten

+1.

Én se nyúltam volna a BIOS-omhoz, ha nem lenne kapcsolhatós, az egyszer biztos.

(#25179) do3om: A Club3D-nek van kereskedelemben is azonnal megvásárolható, visszajelzések alapján is működő konvertere: [link]. Kb. 10 000Ft-ért kapható.

Szerk.: megnéztem, itthon is azonnal beszerezhető, nem reklámozok linkkel.

-

Blue Thunder

senior tag

1.4-em az van sőt mint írtam az előbb direkt 2.0-ás HDMI kábelt vettem

-

do3om

addikt

válasz

Blue Thunder

#25173

üzenetére

Blue Thunder

#25173

üzenetére

Kérd Abut ajánljon neked kábelt ami HDMI 1.4-en is ad 4k@60Hz-et, amikor jöttek a karik azt írta ez nem lesz problémaaz AMD majd csinál kábelt. Azóta pár év eltelt biztosan van, és kapni is bárhol.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

válasz

Blue Thunder

#25173

üzenetére

Blue Thunder

#25173

üzenetére

Pedig ennek tudnia kell így... Az Adapter csipszetének adatlapján ezt írják: "Supports display resolution up to 4096 x 2160 at 60Hz frame rate with 24-bit color and 4:4:4 color sampling, using a 4 lane DP 1.2 or DP 1.3 input at the HBR2 (5.4Gbps) data rate"

És legjobb tudomásom szerint már a 290-es Radeonokon is DP1.2a csati volt, HBR2 móddal, a PH tesztben is ezt írják: [link].Ami megérhet egy próbát, az egy újraindítás. Ja, és mégvalami, hogy csak ez a monitor van rákötve a kártyára? Ha van más DisplayPort eszköz is, az elviheti a rendelkezésre álló sávszélességet.

(#25174) Sakka: Az azt jelenti, hogy nincs másik (el nem rontott) BIOS a kártyádon, amivel be lehetne indítani, és egyszerűen helyrehozni a rossz BIOS-t. Gondolom, így egyértelmű, miben hátrány ez....

De, helyre lehet hozni így is... Szépen leforrasztod róla a BIOS csipet, és egy megfelelő programozóval újraírod egy megfelelő BIOS-al, majd visszaforrasztod a kártyára. Természetesen komoly rutin nélkül ezt végrehajtani a legkevésbé sem ajánlom...

Természetesen komoly rutin nélkül ezt végrehajtani a legkevésbé sem ajánlom... -

Blue Thunder

senior tag

A kérdés hogy a DP port az 1.2-es-e...mert hogy a monitoron van HDMI 2.0, illetve DP port, na most a monitor egyetlen szépséghibája hogy DP 1.2 nem frissít ergo szar! Viszont a HDMI 2.0-án ugye ugyanúgy kellene tudnia. Na én ezért vettem egy ilyen DELOCK ADAPTERT, na mondom majd ezzel megy (jah és HDMI 2.0-ás a kábelem is).

És nem megy csak 30Hz-en...kissé kezdek ideges lenni...

A vicc az egészben hogy a radeon beállításoknál érzékeli a képernyő az UHD felbontást és mutatja a 75Hz-et

Na most akkor mivan???

-

HSM

félisten

válasz

Blue Thunder

#25170

üzenetére

Blue Thunder

#25170

üzenetére

Most néztem, elvileg standard mégis a 4K 60hz DP 1.2-n... Akkor lehet érdemes megpróbálnod vele, ha eddig nem DP-on próbáltad használni. [link]

HDMI-n (1.4-et tud a kártya) tuti nem megy ki csak 30hz 4K-n.(#25169) Sakka: Most nézem, a kártyádról le van spórolva a dupla BIOS-os kialakítás, így nem tudod ezt megejteni. Menet közben én tuti nem dugdosnék rá áramot, szerintem amúgysem segítene, ha annyira zokni lett a BIOS, hogy nem is indul vele a kártya....

-

-

Sakka

tag

Köszönöm a választ!

Úgy érted, hogy az alaplapival be bootolok külső usb-vel dos parancs és atiflash? Ott az adapternek beírom az 1-et. és felülír?

Az R9-es a PCI foglalatban benn van, csak nincs rá dugva a táp. (Mivel úgy fekete képet ad)

Közben dugjam rá a tápot?Amúgy 2 bios lenne rajta a kártyán?

A rossz biosra, hogy tudom átkapcsolni? -

HSM

félisten

A kártyán lévő másik, remélhetőleg működő BIOS-al (ha van) bebootolva menthető. Sikeres DOS-ba boot után, de a flash indítása előtt átkapcsolod a rossz BIOS-ra, és felülírod jóval. Ha nem kapcsolható a BIOS a kártyádon, akkor szvsz bukta a dolog. Persze, próbálkozni lehet, hátha valami csoda folytán kihúzva is látja az atiflash, de nem hinném.

-

Sakka

tag

Sziasztok!

Itt is érdeklődök.

Egy S.O.S kérdéssel

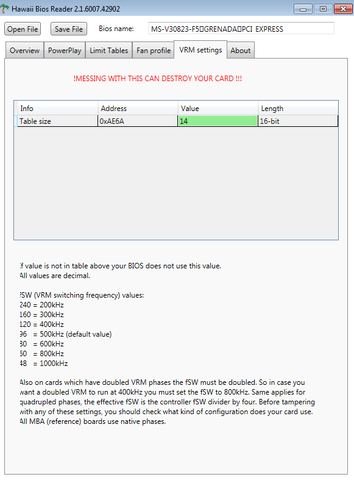

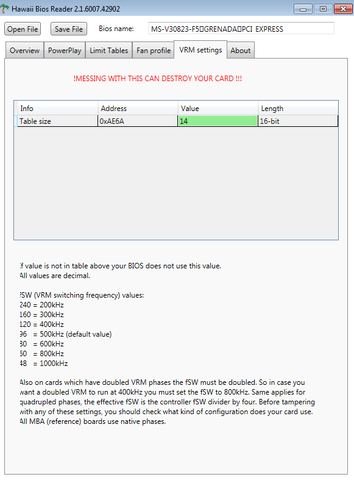

Atiflash programmal biost írtam felül az R9 390-es kártyán, így szépen visszább vettem 8-10 fokot. Szép és jó volt de egy másik beállítással viszont a kártya fekete képernyőt dob.

Az érdekes, hogy ha át teszem alaplapi ra, csak úgy jön be az alaplapi vga-val, hogy az R9 ből kihúzom a táp csatit, tehát kvázi nem kap tápot.

A kérdésem az lenne, hogy ha a kártya nem kap tápot, de az alaplapi kártyával egy külső USB boot-al atiflash-el vissza írható a bios??

Vagy kell neki az áram?

Amit változtattam azok a fesz értékek, de annak jónak kellett lenniük, viszont egy dolgot még a : VRM settings-ben az érték, amit 14-ről 15-re tettem. ( Na ezt nem kellett volna)

Innentől bios felülír és black screen...A képen még a 14-es értékkel van, ezt állítottam 15-re. ( De minek...?

)

)Köszönöm előre is ha valaki tud valami okosat mondani!

-

HSM

félisten

válasz

Blue Thunder

#25165

üzenetére

Blue Thunder

#25165

üzenetére

Szerintem a videókártya több HZ-en is tudja, csak nincs rajta csatlakozó, amin kimenne...

HDMI1.x és DP 1.2 van rajta ha jól emlékszem, mindkettő csak 30Hz-en tudja a 4K-t.... Azaz van elvileg valami megoldás, amivel két DP 1.2 streamként kimegy a 4K 60hz, de azt nem sok megjelenítő tudja.

HDMI1.x és DP 1.2 van rajta ha jól emlékszem, mindkettő csak 30Hz-en tudja a 4K-t.... Azaz van elvileg valami megoldás, amivel két DP 1.2 streamként kimegy a 4K 60hz, de azt nem sok megjelenítő tudja.

-

Blue Thunder

senior tag

Üdv!

Arra lennék kíváncsi, hogy...van egy Asus strix r9 390 VGA-m és egy Philips UHD (Dp port, HDMI 2.0 csatival) monitorom. A kérdés az hogy lehetséges hogy a videokártya tudja az UHD felbontást de csak 30Hz-en? -

-

Abu85

HÁZIGAZDA

válasz

MongolZ

#25161

üzenetére

MongolZ

#25161

üzenetére

Hagyd, nem érti, hogyan működik a GCN. A GCN4-es írásánál is ez volt a forrása: [link]

Amiről szó van itt az a variálható hosszúságú wavefront. Ez egy fontos fejlesztés, de messze nem akkora, mint az utasítás-előbetöltés. A GCN egy SIMT architektúra, így kihasználtság limites, vagyis 64 szállal használható ki a CU. Ezt az új motorok megoldják, mert GCN-re vannak tervezve. A variálható hosszúságú wavefront akkor előny, ha nem 64 szálra van alapozva a kód. Ilyenkor mondjuk 32 szállal arra is lehetőség lesz, hogy a wavefront hossza 4x256 bites legyen, és egyszerre lehet mellette futtatni még egy ilyet. De ennek az alapja az utasítás-előbetöltés, ugyanis ha érkezne 40 darab minimálisra szabott wavefront, akkor az nagyon para lenne enélkül.

-

Oliverda

félisten

válasz

Malibutomi

#25131

üzenetére

Malibutomi

#25131

üzenetére

Akkor ezt vessük össze Abu mester álláspontjával, aki nyilván azért tudja másképp, mert tagja a tervezőcsapatnak.

-

#35434496

törölt tag

Nagy a csend! Nincs valami friss info az új Radeonokról?

-

Z10N

veterán

válasz

Televan74

#25147

üzenetére

Televan74

#25147

üzenetére

Mar van 60k-ert 480?

Mas: Mostanra lettek elfogadhatoak az arak 470/480. A 460 tovabbra is egy hulladek ennyiert. Idokozben az apron mar 40k-ert adnak 290-t es 45k-ert 290x-t. Honap vegen jon az 1050/1050Ti. Az utobbi ~960 szint. A 460 pedig a 950-nel tart lepest. Jon a BF1 is. A p11xt-vel (465) meg mindig adosak. Nem beszelve a 460-470 kozotti resrol. Nagyon kell a vega, ha kaszalni akarnak. Egyre biztosabb vagyok, hogy a polaris felgeneracio.

Ui: Par napja mar lehet hallani a GF20 szeriarol. Ilyen tempoban hbm2 megfizetheto aron 2020-ra lesz

-

#45185024

törölt tag

tailor74: Nem feltétlenól kell erősebb és erősebb GPUkat gyártani, ezt könnyen pótolhatja a tehnológia.

Jobban örülnék egy 4GPUs rendszernek közös HBM eléréssel mint batár nagy GPUknak.Radeon Tech Talk: DirectX® 12 Multi-GPU Frame Pacing

Beszélgessetek róla... -

Simid

senior tag

válasz

#85552128

#25152

üzenetére

#85552128

#25152

üzenetére

Persze, hogy nem gyárthatod le csak úgy. De akkor a GCN4 eredetileg TSMC-re vagy GloFo-ra lett fejlesztve szerinted? Nyilván kellett mindkettőre külön tervezni valamennyire, de kétlem, hogy egymástól független fejlesztések lennének és nyilván az architektúra sajátosságai azért csak kedveznek egyik vagy másik processnek. De persze lehet hülyeség ez, csak korábban volt róla szó, hogy az architektúra meghatározó az elérhető órajel/energiahatékonyság szempontjából. Gondolom nem nyúltak bele komolyabban csak egy másik process kedvéért.

Szóval itt most inkább az optimalizációra gondolok. Nem hiszem, hogy lehet ugyan olyan jól optimalizálni két különböző node-ra. -

Simid

senior tag

Nem tudom szóba került-e már, de nem lehet, hogy a Polaris10-11 olyan architektúrára épülnek ami eredetileg nem is a GloFo 14nm-hez készült, hanem a TSMC 16 nanora? Jövő hónapban jön a PS4 Pro. Ha belevesszük, hogy hónapokkal a megjelenés előtt már van devkit (gondolom kész tartalmakkal akarják elindítani a Pro-t), akkor már jóval az RX széria megjelenése előtt kész kellett, hogy legyen a GCN4-hez nagyon hasonló uarch. A PS4Pro GPU része és a P10 gyakorlatilag minden részegység tekintetében megegyeznek.

Nem lehet, hogy úgy voltak vele: készítik a Vegat, már teljesen a GloFo gyártástechnológiára tervezve, de csak jó fél-egy évvel a Pascal után lesz kész, így addig is kellene valamit gurítani a már kész fejlesztésekből?

Így gyorsan csináltak egy (kettő) lapkát a GloFo nodera egy olyan architektúrával és olyan arányokkal amit már ismernek és nem igényel komolyabb fejlesztést.

Máskülönben nem tudom megérteni miért kezdtek volna a GCN4 fejlesztésében ha fél évre rá kész a GCN5. Tehát gyakorlatilag párhuzamosan fejlesztették.

Logikusabb, hogy csak a GCN5-öt fejlesztették, azt is direkten a 14nm-re. Viszont mivel a Sonynak kellett egy egyedi lapka, így ami kész volt és amit a kompatibilitás megőrzése mellett lehetett azt berakták a PS4Pro fejlesztésbe, a P10 pedig csak ennek a GPUnak az átültetése a GloFo gyártástechre.

Ha a GCN4 nem egy kényszer/öszvér megoldás lenne akkor miért csak két lapkát építettek rá? Még APUba se fog bekerülni, egyedi lapka sem valószínű, hogy épül már rá.

Az is gyanús lehet, hogy a Sony számára nyilván a VR követelmények kiszolgálása volt a cél a Pro verzióval (legalább is ezt kommunikálják) és az RX480-at is úgy reklámozták, mint belépő a VR világába.Szek: Ez jó magyarázat lenne arra is, hogy miért tud a Vega annyival magasabb órajeleket, mint a Polaris (már ha tényleg tud...). A node kiismerése azért egyrészt több idő, másrészt nem szokott 30-40% előrelépést hozni csak úgy. Lehet inkább arról van szó, hogy a Vega már 14nm-es gyártástechnológiára optimalizált uarch, míg a Polaris nem vagy csak részben az.

-

válasz

Televan74

#25147

üzenetére

Televan74

#25147

üzenetére

Az RX480 lehet, hogy jó termék (mert jól van árazva), viszont a Polaris 10 nem egy kimondottan jó GPU. Állítólag drága a 14nm, szóval lehet, hogy nem olcsóbb gyártani, mint a Hawaii-t. A fogyasztása meg sokkal jobb, de nem lépett többet előre, mint a konkurencia, tehát a hátrány továbbra is megvan. Ha pedig nem lenne üveghangon hajtva, akkor a sebessége nem lenne versenyképes. Ezen még bőven van mit csiszolni.

-

Interceptor

addikt

válasz

Ren Hoek

#25137

üzenetére

Ren Hoek

#25137

üzenetére

Most őszintén nem teljesen mindegy? A te megvásárolt vga-d nem lesz ettől gyengébb, egyetlen rossz ami érhet, hogy az új valamelyest lenyomja a használt piaci árát a tiédnek. Bár ez sem feltétlen igaz, pl ha drágábban jön ki az új gen dollárban. A jó oldala meg, hogy van legalább valami fejlődés, persze a legjobb egy komolyabb technikai előrelépés lenne nem ez a 15-30%-os tapicskolás.

-

stratova

veterán

válasz

Yutani

#25146

üzenetére

Yutani

#25146

üzenetére

Szvsz felfogható több lépcsős fejlesztésnek, összelegóztak egy dizájnt, amit most ki lehetett adni s reszelik tovább Vegában. Ha tippelhetnék, akkor Vega jobb teljesítmény/fogyasztás mutatója, éppen a dinamikus wavefront kezelésnek lesz köszönhető, csak működjön is rendesen az ALU lekapcsolgatás.

Azért van egy pár cím (Witcher 3, Fallout 4), amiben Fury/390X nyakára mászott, tipikusan olyan területen, ami eddig a Radeonok gyengéje volt.

-

Televan74

nagyúr

-

-

Ren Hoek

veterán

Teljesen mindegy, mert tartotta az értékét, futottak rajta a dolgok. Csak most a Polaris/1070/1060 verte be az árát rendesen. Hawaiinak is... de előtte egy évig szinte értékvesztés nélkül lehetett cserélgetni.

Csak ezt furcsállom, hogy ezek szerint félévente hoznak egy új lineupot. Új arch, új feature-ök... (Mert úgy tűnik Vegában lesznek újdonságok...)

Miközben DX12, Abu is azt mondta még nemrég, hogy egy arch hosszú ideig lesz piacon, és kihegyezik rá a játékokat. Cserébe generációnként specifikus lehet, vagy amíg ki nem ismerik. (Régi DX12 játék majd rosszabbul fut az új archon pl)....

Ehelyett most meg ömlenek félévente az újdonságok :/ A Polaris és a Pascal is kb egy felesleges lépésnek tűnik...

-

Ren Hoek

veterán

Engem bosszant, mert úgy érzem rossz döntést hoztam és elavult fél éven belül... értékben is.

Valahogy nem rémlett, hogy Maxwell, Hawaii idejében ez volt. Maxwell egy évig forintra pontosan tartotta az árát,.970-nel. Szóval legalább egy fél évig jó lenne ha maradna... most meg az AMD is fossa ki az új archokat... erre válaszul Pascal refresh, aztán Volta? Hová ez a sietség? Pedig csökken a dVGA piac... ez csak azt jelenti, hogy a Polarist elcseszték, elkapkodták.

-

Ren Hoek

veterán

válasz

Németh Péter

#25138

üzenetére

Németh Péter

#25138

üzenetére

Nekem se lenne gond, de jó lenne venni valamit ami legalább fél évig ott van a szeren és nem jön valami refresh polír, ráadásul új arch.

-

Petykemano

veterán

válasz

stratova

#25136

üzenetére

stratova

#25136

üzenetére

Nem tudom elképzelni, hogy a P10-et ne lehetne versenyképesebbé tenni egy steppinggel és/vagy gyártástechnológiai finomítással (Ahogy egyébként tették ezt a 300-as szériával is)

Csak akkor látnék nyíló ablakot ,ha a Vega10 tényleg "majdnem kétszer akkora frekvenciával érkezik, mint a fury" Tulajdonképpen a 4K-s fiji a P10 architekturális körítésével 1300-1400Mhz-en nagyjából megérkezne az 1080-ra. Ha erre még tényleg jön - egyesek szerint nagy, másik szerint kisebb - mértékű architekturális újítás és még 30-40%-kal tudnák növelni a frekvenciát, akkor valóban keletkezhetne egy olyan hézag a P10 és a V10 között, amit egy új, akár P10 méretű, de magasabb frekvenciát elérő lapkával lehetne lefedni.

De az elmúlt 2-3 év az AMD részéről nem arról tanúskodik, hogy szokásuk lenne két egymást követő évben ugyanolyan lapkát fejleszteni. Nem szokása az nvidiához hasonlóan teljes palettát megújítani. Ha ebből indulunk ki, akkor A V11 ennél fogva tehát vagy kisebb, mint a P11, vagy nagyobb, mint a V10.

-

-

stratova

veterán

válasz

#45185024

#25133

üzenetére

#45185024

#25133

üzenetére

Viszont ha olyan piacra érkezik először, ahol P10 nincs jelen/kevésbé versenyképes, vagy eleve gyorsabb a váltás - pl. notebook - akkor nincs ezzel semmi gond. Esetleg kezdetben még Apple exkluzív is lehetne mint Tonga.

A változó hosszúságú wavefront kezeléséről még nyáron jelent meg egy szabadalmuk, kár hogy Polaris nélkülözi. -

válasz

#45185024

#25133

üzenetére

#45185024

#25133

üzenetére

"Jobban várnának az emberek egy technikai áttörést mintsem egy 15-30% bootsos kártyát több shaderrel."

Tényleg nem kötözködésnek szánom, de a technikai áttörés folyamatos az amd-nél, most már csinálhatnának 15-30%-al erősebb kártyákat is a jelenlegiek árfolyamán. Lehet többre mennének vele.

-

#45185024

törölt tag

válasz

Malibutomi

#25131

üzenetére

Malibutomi

#25131

üzenetére

Ezzel azért logikailag is vannak fenntartások.

17 elején biztos nem jön ki olyan vega11 ami leváltja a 480 asokat mert öntökönrúgás esete forogna fenn.

Sőt hasonló kategóriában sem lehet 8 GB HBM2vel tehát nem a 120 140 ezres kategória.

Amit a SIMD-ről ír az örvendetes.

Jobban várnának az emberek egy technikai áttörést mintsem egy 15-30% bootsos kártyát több shaderrel. -

Televan74

nagyúr

válasz

Malibutomi

#25131

üzenetére

Malibutomi

#25131

üzenetére

Már várom a Vega11 -t.Bár addig sincs min panaszkodnom a P10 -el.Számomra kitűnő hírek eddig,aztán majd kiderül mi lesz belőle.

-

Malibutomi

nagyúr

WCCF Vega hirek (szoval nemi fenntartassal kezelni) [link]

AMD’s Vega 10 Debuting Before Year’s End – Features New V9 GCN Architecture

Moving on to Vega 10, the GPU that most of you reading this are probably interested in. Vega 10 will be the very first GPU based on the company’s brand new GCN graphics architecture and 9th generation collection of visual IP.

Completely Redesigned V9 GCN Architecture With Significant AdvancesThe V9 nomenclature refers to AMD’s 9th graphics architecture. Which represents a significant departure from the previous 8th generation GCN architecture of Polaris ,RX 400 series, and AMD’s “Islands” family of R9 200 & HD 7000 graphics cards.

The structure and configuration of SIMD units is entirely new. Each SIMD is now capable of simultaneously processing variable length wavefronts. It also includes clever new coherency features to ensure peak stream processor occupancy in each compute unit at all times and reduce access times to cache and HBM. Memory delta color compression has also been improved. We’ll talk about the new architecture a lot more in-depth in a forthcoming articleAMD’s Vega 11 Coming Early 2017, Faster & More Power Efficient Than Polaris 10

Vega 11 will feature 8GB of HBM2 and is aimed at delivering the highest possible performance in notebook devices as well as replacing Polaris 10 in the midrange on the desktop. The GPU will be faster than Polaris 10 and use less power. Vega 11 will come in mini-ITX SFF and standard PCIe form factors. Most of the GPU’s extra oomph comes from the updated graphics architecture in addition to higher clock speeds compared to the RX 480 and RX 470. Vega 11 based cards will target the same ~$250 mid-range target that’s currently occupied by Polaris 10 and Nvidia’s GTX 1060.

Kivancsi vagyok mi jon be ezekbol.

-

Malibutomi

nagyúr

Jo lenne befejezni az offolast meg trollkodast.

-

Ren Hoek

veterán

válasz

Jack@l

#25121

üzenetére

Jack@l

#25121

üzenetére

+ vagy már megvolt augusztusra a full készlet, de Huang Zsen-hszün Józsi bácsi, a Fab 3 gyártósori takarítójának bal nagylábujjkörméről átugrott egy szilíciumevő csiperke faj... és begombáltak a csippek. Sajnos újra le kellett gyártani bekenve egy kis Canesten Kombival.

(Viccen kívül, volt valami délamerikából származó CD evő gombafaj, ami pont az adatréteget ette meg, és nyekk vége is volt a jó kis Red Alert CD-dnek:d)

-

Jack@l

veterán

válasz

tailor74

#25123

üzenetére

tailor74

#25123

üzenetére

Mindenesetre nem nagyon siettek az októberi vegás pletyka megcáfolásával(sok nagy oldal lehozta):

http://www.guru3d.com/news-story/amd-vega-launch-imminent.html

https://www.techpowerup.com/222403/amd-pulls-radeon-vega-launch-to-october"AMD reportedly decided to pull the launch of its next big silicon, Vega10, from its scheduled early-2017 launch, to October 2016. Vega10 is a successor to "Grenada," and will be built on the 5th generation Graphics CoreNext architecture (codenamed "Vega"). "

Szóval valami már csak elkészült a nyáron.

-

Jack@l

veterán

válasz

Interceptor

#25120

üzenetére

Interceptor

#25120

üzenetére

Akkor rám marad a hálás feladat

Tekintve hogy karácsony előtti időszakba szoktak a vga gyártók a legnagyobbat kaszálni és már ünnepeltek nyár elején a sikeres polaris és vega tervezés miatt, a lehetőségek:

- Nem akarják elrettenteni a konkurenciát, az rx480-al idén így is nagyot fogtak

- Akkora készletet gyártanak le 2017 közepéig, hogy a földkerekség öszes gamerének elég lesz, csak elfogyott a kartondoboz, így a raktárakban pihennek most a kártyák csupaszon.

- Alig van még működőképes hbm2 a piacon, pedig néhány cikk(író) szerint ők kapnak sokkal nagyobb proiritást a gyártóktól.

- Instabil a csip vagy a hbm2 és vagy nagyon alacsony órajelen tudják csak tartani, vagy orbitális módon megemelve a feszt, ahogyan az rx480-nál is, elszálltak a fogyasztással.

- Utóbbi okból kifolyólag még most tervezik újra a tápellátást és a vízhűtést. -

Interceptor

addikt

válasz

#85552128

#25117

üzenetére

#85552128

#25117

üzenetére

Igen, nyilván az a leglogikusabb, hogy nincsenek még készen, nem véletlen kezdtem úgy a kérdésemet. Viszont esetleg az az eset is fennállhat, hogy valamilyen oknál fogva nem éri meg nekik a konkurens termékével egyazon időben kijönni. Persze ebben nem látok túl sok logikát, de azért megkérdeztem hátha valakinek van egyéb ötlete. Remélem nem baj...

-

Malibutomi

nagyúr

válasz

Ren Hoek

#25118

üzenetére

Ren Hoek

#25118

üzenetére

Ha mondjuk februarban kiadjak, akkor a GPU-k mar valoszinuleg le vannak gyartva a vegleges kartyakhoz. ( foleg ha igaz hogy sayinpety mar tavasszal tudta a specifikaciokat)

Ez a normal ablak, kb fel evvel a kartyak kiadasa elott mar keszulnek a chipek.A tervezestol gyartasig evek telnek el, utolso honapokban at mar nem tervezik.

-

#85552128

törölt tag

válasz

Interceptor

#25116

üzenetére

Interceptor

#25116

üzenetére

Nyilván nem azért maradnak le az év legnagyobb vásárlói szezonjáról mert kész vannak vele és már ott pihennek a dobozban a kész VGA-k...

-

Interceptor

addikt

Miért várnak ennyit a vegával? Azért mert nincs kész vagy valami egyéb ok miatt?

-

Simi37

őstag

Mit gondoltok? 32magos amd geekbench. Igaz vagy BS?

-

Most akkor arról van szó, hogy az API előtti rész pl egyszer fut le, de az utána lévő többször, így magasabb a GPU fps a CPU fps-nél? Azaz ugyanazt a jelenetet (ez a szimluáció / present, nem?) a GPU többször is kirajzolhatja (render) pl más szögből? Nekem legalábbis így tűnik lehetségesnek, hogy más a CPU és GPU fps.

-

Simi37

őstag

25092-25110 a párbeszéd ami előtt azt hittem, hogy már értek vmennyit az informatikához

-

uvlight

csendes tag

Szerintem benne van a nevében: Frame Per Second. Tehát ha cpu ha gpu oldalról nézzük is, ugyanazt az eredményt kell kapni átlagban: megjelenített frame-ek száma per másodperc.

Hogy ezt most gpu oldalról speciális esetben a renderelési időből is lehet számolni, máskor meg nem, az más kérdés.

Önmagában a renderelési idő elsősorban az inputlag-be tud számítani. Pl. több GPU és AFR mód esetén eléggé szét tud mászni a megjelenített FPS a renderelési idő reciprokától.Egy GPU-ra ha egy játék ciklikusosan a következőket csinálja:

- Bekéri a user inputot

- Kiszámolja a kamerát

- Fizikázik, AI-zik

- Renderel

- Present

Akkor összhangban tud lenni a GPU-s renderelési idő (GPU-s várakozásokkal együtt) reciproka az FPS-el.

Ha pár dolgot a present után rakunk (AI, pár effekt mint pl environment textúrák renderelése, stb.) akkor a userinput - present közti idő csökken, tehát az input lag is (pl VR-hez ez jó dolog), de az FPS kb változatlan marad.Viszont ilyenkor a Present után akár el is kezdhetnénk rögtön a következő ciklust (input szedés, stb).

Ehhez jók az új API-k, mert egyik grafikus pipeline-on mehet a "hagyományos" renderelés, másik mondjuk compute pipeline-on meg mehet az amit előbb kiszedtünk (pl cube map renderelés). Utána a GPU-tól függ hogy mennyire lehet a kettőt egyszerre tolni, legrosszabb esetben semennyire.Persze kell némi szinkronizáció hogy ne másszon szét a két dolog. Cube map-os példánál maradva a normál renderelés régi cube map-ot használhat míg a compute-on számolódik az új. Tehát a megjelenített cube map 1 frame-t laggelni fog, ez is számít annak eldöntésében hogy mit vehetünk ki a userinput bekérés és present közti részből. De így végeredményben növekedhet az FPS is.

Plusz bonyolítás ha a renderelés a present-ig is már több fázisú és ezeket lapolják mondjuk.

-

Abu85

HÁZIGAZDA

Aha. Már látom, hogy hol csúszunk el.

A frame száma nem számít. Régen azért lehetett relatíve biztonsággal összehasonlítani a CPU fps-t a GPU fps-sel, mert két present között eltelt ms, majdnem megegyezett a frame számításának ms-ban mért idejével. Ez a single-engine feldolgozásnak volt köszönhető. Ma az a probléma, hogy a multi-engine alatt ez nem feltétlenül igaz. Lehet olyat csinálni, hogy a presentek közötti ms eltérjen a frame számításához szükséges időtől, hiszen tulajdonképpen konkrétan az a trükk, hogy a presentek meghívásával játszol. -

Abu85

HÁZIGAZDA

-

Abu85

HÁZIGAZDA

Ez történik a Doomban AA nélkül vagy 8x TSAA-val.

- elkészül a képkocka és megjeleníti. Közben már számolja a következőt. Ez a multi-engine gyönyöre, hogy nem kell megvárni, hogy a számítások befejeződjenek, hanem el lehet kezdeni párhuzamosan a következő számítást egy másik parancslistán betöltve.

- az időzítés nem gond. Ugyanúgy történik, ahogy eddig. Attól, hogy párhuzamos lett a feldolgozás még tuti nem lesz kész hamarabb a következő képkocka.

- Nem készül két kép ugyanabból a scene-ből. Minden teljes scene-hez csak egy frame tartozik. A szegmentálás csak a trükközés működését szolgálja, semmi mást. -

Abu85

HÁZIGAZDA

- az fontos, hogy ezekkel az új API-kkal a CPU-limit értelmezése megváltozik. A limitet engine-enként kell érteni. Régen azért volt ez az egész mindegy, mert single-engine API-k voltak, de ma mindegyik új API multi-engine, és mindegyik játék rá multi-engine. Tehát a vizsgálatnál is figyelembe kell venni ezt a szempontot, mert attól, hogy az egyik parancslista limites még nem biztos, hogy az a másik, vagy nem biztos, hogy limites a fő parancslista. Ezekkel az új lehetőségekkel nagyon sokat bonyolódtak a régen egyszerűen értelmezhető dolgok.

- egy teljes scene-hez egy frame tartozik. De ahhoz, hogy ezek a trükkök működjenek a scene is szegmentálva lesz, tehát lesz egy kicsi részscene és egy nagy résscene, és ezekből lesz egy GPU frame. A két részscene persze megfelel egy teljes scene-nek. Emiatt iszonyatosan sok a trükközésre a lehetőség. -

Yany

addikt

Hm...

Tegyük fel épp egérrel fordulok jobbra. A CPU kiszámolja az új kamerabeállításokat az egér elmozdulásának megfelelően (most leegyszerűsítem), majd a GPU renderel egyet ennek megfelelően.

Ha jól értelek, még mielőtt befejezné a rendert, a gpu nekilát egy következő képkocka számításának (is).

Amit nem értek:

- Eldobja az előzőt képkockét, vagy azért végigtolja annak a renderjét is közben a gpu?

- Hogyan időzíti az új képet?

- A folyamatosan húzott egér (1000Hz) tegyük fel minden képkockára (53fps) új és új nézőpontot eredményez, de a két egymás után kiszámolt képkockán akkor lesz egy microstutter, mert azokon ugyanaz a kamera állapot lesz? (hiszen ugyebár a második számításakor kihagytuk a procit)

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- HIBÁTLAN iPhone 13 mini 128GB Starlight -1 ÉV GARANCIA - Kártyafüggetlen, MS3287

- ÁRGARANCIA!Épített KomPhone Ryzen 5 4500 16/32GB RAM RTX 3060 12GB GAMER PC termékbeszámítással

- iKing.Hu - OnePlus Nord 4 5G Fém unibody, 120 Hz AMOLED, 100W gyorstöltés 16/512 GB

- BESZÁMÍTÁS! 1TB Samsung 980 Pro NVMe SSD meghajtó garanciával hibátlan működéssel

- HIBÁTLAN iPhone 14 128GB Blue -1 ÉV GARANCIA - Kártyafüggetlen, MS3017, 100% Akkumulátor

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: CAMERA-PRO Hungary Kft.

Város: Budapest

Ha rosszra dugod nincs kép. Tehát BIOS-ban is IGP-re kell állítani, IGP-be dugni a monitort, és úgy lehet esélyed, hogy képed is lesz, és a VGA-t is látja (áram alá helyezett VGA-t persze). Bár elég kicsi esélyed.

Ha rosszra dugod nincs kép. Tehát BIOS-ban is IGP-re kell állítani, IGP-be dugni a monitort, és úgy lehet esélyed, hogy képed is lesz, és a VGA-t is látja (áram alá helyezett VGA-t persze). Bár elég kicsi esélyed. Ezzel nem csoda, ha nem működik.

Ezzel nem csoda, ha nem működik.

Mert ha nem olyan mint a fenti akkor az HDMI ~1.4-be alakít át.

Mert ha nem olyan mint a fenti akkor az HDMI ~1.4-be alakít át.

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Természetesen komoly rutin nélkül ezt végrehajtani a legkevésbé sem ajánlom...

Természetesen komoly rutin nélkül ezt végrehajtani a legkevésbé sem ajánlom...

)

)