- Megvan a Pura 80 nemzetközi startja

- Magisk

- Amazfit Active 2 NFC - jó kör

- Honor Magic6 Pro - kör közepén számok

- Milyen okostelefont vegyek?

- A Galaxy Z Fold7, minden színben és oldalról

- Samsung Galaxy S24 Ultra - ha működik, ne változtass!

- Bemutatkozott a Fairphone 6

- Xiaomi Watch 2 Pro - oké, Google, itt vagyunk mi is

- Fotók, videók mobillal

-

Mobilarena

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

-

Abu85

HÁZIGAZDA

A Nixxesnek fontos volt egy feltételes elágazással elérhetetlenné tenni egy beállítást a Radeonokon. Erről van a vita, és ez nem áll össze. Tényleg olyan fontos ez egy olyan játéknál, ami a jelenlegi állapotában random fagy bármivel bármikor? Nem mindegy, hogy melyik bugtól fagy ki? Ha ez számítana a Nixxesnek, akkor ki sem adták volna így a portot.

-

Alogonomus

őstag

A 4070 Ti és 7900 XT között az átlagos különbség közelebb van a 10%-hoz, de persze az sem egy nagy különbség.

Ez a GRE verzió a gyengébbre sikeredett Navi 31 GCD-k kiszórására készül, így ugyanolyan TDP keretből alacsonyabb órajelre lehetnek képesek. Ugyanolyan TBP esetén a mínusz egy MCD és mínusz 2 memóriachip hatására talán minimálisan több TDP kerek juthat a GCD-re, és így az órajelen esetleg nem kell csökkenteni. -

Alogonomus

őstag

Azért átnevezésnél komolyabb a különbség, mert a 16 vs. 20 GB az érdemi eltérés.

Amennyiben Kínán kívül is kapható lesz, akkor nagyjából a 4070 Ti valódi ellenfelének szánhatják a fixen csökkentett memóriakapacitás, és talán szintén csökkentett magfrekvencia bevetésével. Amolyan "új" 6800 lesz, csak ezt most nem a 3070/Ti ellenfelének szánják, hanem a 4070 Ti ellenfelének, hogy a sajtó ne a "teljes" 7900 XT-vel vesse össze a 4070 Ti teljesítményét, hanem ezzel a kisebb és nyilván takarékosabb verzióval, ami már nagyjából csak a 4070 Ti teljesítményét hozza majd. -

S_x96x_S

addikt

> Most őszintén ... 8 K + RT ? itt érzed már hogy marketing az egész.

> Meg fogom venni a Ps5 pro-t is mert Playstation,akkor nálad is jól működik a marketing ..

amúgy extra "vas" lesz benne ...És ha a 8K + RT célozzák be akkor talán

a normális 4K -t is sikerül végre elérni.

amúgy minden "hírportál" másképp foglamaz ..

- 'PlayStation 5 Pro will be targeting improved and consistent FPS at 4K resolution'

- '8K “performance mode”'

- 'Accelerated ray tracing'

- 'Improved frames per second (FPS)'

- 'Better FPS stability performance at 4K resolution'

- ...

amúgy lehet, hogy érdemesebb várni a PlayStation 6 -ra : 2028 -

PuMbA

titán

Most volt nem rég egy Hardware Unboxed videó, amiben olyan gondolatot mondtak, hogy az NVIDIA-nak előnyt jelenthet, hogy őket nem köti a konzol, tehát például nem kell hardveresen visszafele kompatbilitással foglalkozniuk. Az NVIDIA teljesen szabad, két generáció között simán kidobhat dolgokat az architektúrájába, teljesen átszabhatja. Ez is nagyban hozzájárulhat, hogy ennyire más a célirány / másként működik a két cég.

-

DudeHUN

senior tag

Pedig a vörösök GPU gyártó részlege már akkor így állt a konzolokhoz. Az X360 is a jövőben PC-s kártyákon megjelenő képességekkel lett felvértezve. Igazából a 2005-nek azért volt értelme mert vörös hardver már jóval régebb óta van konzolban. Gamecube mondjuk más tészta.

Szóval amit Pletykamano mond már régóta működik. A konzolfejlesztések megdobják a PC-s hardvert is. Nyilván túlzás, hogy nincsen dedikált GPU gyártó banda. De külső szemlélőként valóban magasabb prioritásúnak néz ki amikor konzolba való hardvert is fejleszteni kell. -

Petykemano

veterán

A PS4 talán egyfajta kivétel

Ps4pro 2016 végén jelent meg. Nagyjából.azzal együtt jött a Polaris, ami fogyasztói szemmel nézve (annak ellenére, hogy volt vele probléma, illetve hogy nem verte laposra a konkurenciát) jól sikerült termék volt.

Aztán jött a Vega 2017-ben, Amiről tudjuk, hogy elmaradt megcélzott.ambícióitól.

Az 2019-es RDNA1 nem volt rossz, de nem is kiemelkedő.

A PS5-tel 2020-ban együtt érkező RDNA2 elég versenyképes teljesítménnyel érkezett a teljes termékpalettára.

A 2022-es RDNA3 megint gatya.

Nekem eléggé úgy tűnik, hogy az AMD-nek igazából nincs GPU fejlesztő osztálya, konzol fejlesztői, valamint most már HPC hardverfejlesztői vannak és lehet egy kisebb csapat, amelyik két konzolgeneráció között azt a feladatot kapja, hogy guberáljon össze valamit a két komoly célpiacra készülő fejlesztésekből, ami a GPU piacon használható, vagy legalább bétatesztelhető terméket eredményez.

-

hahakocka

őstag

4070 hez írtam a 7700xt T a Tihez pedig közel a 7800 Ast. 7900 xt 15-20% al van feljebb raszterben az új gameknèl a Ti hez kèpest. Lenne ott egy 20-30% difi

Busterftw: Ezek prototípus fèlkèsz vga-s 3Dmark adatok. Nemrèg linkeltèk de az Iponon is van fent egy cikk erről most màr hivatalos Amd partnerek. -

Petykemano

veterán

> Nem Brute force ez.

A brute force kifejezéssel a GDDR6X-et jellemeztem, ahol PAM4-et alkalmaznak. Mindazonáltal nem értek ezekhez, elnézést ha helytelenül ítéltem meg. A kifejezéssel csak arra utaltam, hogy feltételezésem szerint a PAM4 bonyolultabb és bonyolultabban megvalósítható, mint a PAM3. [link] -

Alogonomus

őstag

Abszolút értékben tényleg 38% és 30% a két kártyával elérhető átlagos fps sebességének a csökkenése. A 14% azt a mértéket jelöli, amennyivel a két kártya között a különbség változott a felbontás változtatásának a hatására. 1080p esetén még kb 2% volt a 4060 előnye, de 1440p esetén már kb 12% lett a 7600 előnye. Vagyis a 7600 összességében kb 14%-kal jobban kezelte a felbontás növekedésével járó extra kihívásokat.

A csapnivaló minimum fps indoka mind a két kártya esetén nyilvánvalóan az elégtelen memória. A tesztútvonal egy bizonyos szakaszán beüt a crach, és feltételezhetően a PCI-Express sín adatátviteli sebessége határozza meg azt az 1% low értéket. -

Devid_81

félisten

RX 6800 MSRP-ert 6800XT teljesitmeny 7800 neven?

A hulyenek is megeri... teljesen ignoralni es nem venni belole

Vicces kedvuek ezek mar megint.

Nyilvan ertjuk, hogy nem adhatjak ingyen, de ez kb a 6700XT-nek az utodja semmi tobb

Majd azzal fognak kampanyolni, hogy nem emeltek arat az RX 6800-hoz kepest

A 7700-at meg passz, hogy mivel akarjak eladni -

Petykemano

veterán

Vajon miért csak oda?

- Kína elvileg nagy piac. Ezért nem tűnik valószínűnek, hogy azért kerülne csak ott piacra, mert nagyon kevés van. Egy ilyen SKU-nak biztos máshol is örülnének.

- Kína elvileg nagy piac. Gesztus volna a kínai piac felé?

- Kína elvileg nagy piac. Ott rendelt volna valaki egy ilyen SKU-t nagyobb mennyiségben? -

S_x96x_S

addikt

akkor nem értünk egyet .. és ez nem baj ..

amúgy én nem látom ennyire drasztikusan versenyellenesnek a jelenlegi helyzetet ..

tény, hogy láthatóan, hogy nem olyan aktív a verseny a consumer gaming - piacon.

és bár a gaming piac is fontos,

de nem a legfontosabb egyik cégnek se, hogy túlzott erőforrásokat elvonjanak más területekről ..> Évek óta a két cég hajszálra pontosan egymáshoz lövi be a termékeit.

> Tehát valahogy tudnak róla, mit hoz a másik.de ez mivel különbözik attól, hogy

egyes nyugdíjasok szerint a hazai élelmiszer boltok összejátszanak,

.. mivel nyilvánvalóan mind egyszerre emelnek árakat ???Mert a GPU-nál is a költségek, a TSMC árak, a Memória árak

és a beszállítói problémák ( covid ) is

egyszerre jelentkeznek mindkét gyártónál.És mivel nem egyszerre jelentik be a termékeket,

mindig a másik bejelentéséhez tudják igazítani az árakat és a kínálatot ..

és ez szerintem normális, régebben is így volt ...amúgy a verseny jó .. és lehetne egy kicsivel nagyobb verseny is ..

-

Alogonomus

őstag

A gondolatmenetedben kicsit meredek feltételezésnek tűnik, hogy a 4080-at 1200$ helyett valóban kiadhatták volna 700$-os áron érdemi nyereség mellett. Ráadásul a 700$-os 4080 esetén a 4070 Ti is csak nagyjából 450$ lehetett volna a 800$ helyett, az eladások tömegét hozó 4070 pedig nagyjából 350$ a 600$ helyett. Mármint a táblázat és a "visszavágottság" alapján kalkulálva.

"AMD elbukta volna az összes kint lévő RDNA2 készletét"

Ezzel kapcsolatban is sokkal többet veszített volna az Nvidia, ha a pénzügyi jelentésében szereplő 5 milliárd dollárnyi eladatlan Ampere készletet nézzük, ami úgy garantáltan minden teljesítménykategóriában eladhatatlanná vált volna.

Ráadásul egy ilyen lépésre válaszként az EVGA-n felül szinte biztosan több másik AIB is beintett volna az Nvidia-nak.Az árak megállapításakor még a Geforce széria bevételeire bőven és jelentősen támaszkodó Nvidia számára ez a lépés a céges szintű nyereséget tekintve is nagy sebet okozott volna, míg az AMD nyugodtan bele tudott volna állni az árversenybe, mert az AMD bevételeinek túlnyomó része a konzolokból, CPU-kból és úgy egészében a HPC piacról származik.

-

S_x96x_S

addikt

> úgy érzem Nv vigyáz az AMD re,mint(számára) megfelelő verseny partnerre.

> ...

> csak a H100 már kint van jó ideje,ősszel jön az új, a Grace és így tovább.nem pontosan értelek ..

- vagyis akkor szerinted az nVidia direkt így tervezte?

- és minden rendben?

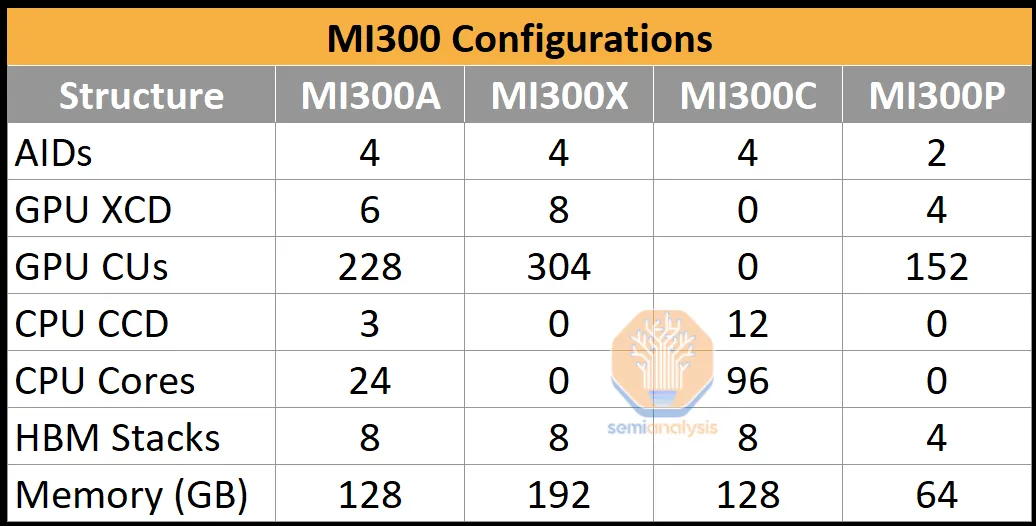

- és az Nvidia szerint az AMD nem veszélyes ????Amúgy ha az AMD az MI300P -t kinyomja az új Threadripperekbe is, ( jövőre? )

akkor az elég erős versenytárs lesz alulról a Grace-nek .. -

S_x96x_S

addikt

> úgy érzem Nv vigyáz az AMD re,mint(számára) megfelelő verseny partnerre.

Mi értelme lenne,

hogy az nVidia a saját aranytojást tojó tyúkjának konkurenciát csináljon?

AMD Has a GPU to Rival Nvidia’s H100 ( MI300X )A HPC/AI a fő stratégiai irány ( az aranytojást tojó tyúk )

és a consumer gaming (RDNA) csak a mellékszáll

( persze a gaming fontos .. de nem annyira, hogy a HPC/AI-t roadmap-be bekavarjanak valamilyen apró RDNA3 teljesítmény problémával )A chipletes technológia kritikus az AMD hosszú távú terveihez ..

és a jövőben az XDNA-t is be kell integrálni ..és az MI300-nál már látszik is a terv ...

https://www.semianalysis.com/p/amd-mi300-taming-the-hype-ai-performance

https://www.semianalysis.com/p/amd-mi300-taming-the-hype-ai-performance -

Petykemano

veterán

Az RDNA3-tól többet vártam. De ezzel szerintem mindenki így van.

Az chipletezés remek lett volna, ha továbbra is nagyon elszállt árakkal és nagyon korlátozott mennyiségben mennének a waferek. De a visszaesés miatt az az előny, hogy nem kell mindennek a legfejlettebb gyártástechnológián készülnie, nem tud érvémyesülni. Cserébe elég sok lapkaméret elmegy a kapcsolódásra.

Azért reméljük, hogy ez csupán az első fecske és idővel kihasználják, hogy chipletek összeillesztésével nagyobb lapkát tudnak összerakni, mintha az monolitikus lenne.

A navi21 520mm2 volt. A navi32-ből származó termékek esetén ~308 (200+108), ~344 (200+144) kerül felhasználásra. A kisebb lapka önmagában, de a chipletezés miatti jobb kihozatali arány, a válogathatóság elvileg jobb gyártósori kihasználtsággal is hozzájárul az olcsóbb előállítási költségekhez.

A navi33 mintájára navi21-ből N6-on gyártva ~450mm2 méretből lehetne kihozni.

Ez a ~300-350mm2-es lapkaméret - ami elég közel van a navi22-höz - elég kicsi ahhoz, hogy ne legyen probléma akár $300-450 szinten árulni.

Csak hát összességében az RDNA3 teljesítménybeli és/vagy hatékonyságbeli előrelépése nem túl látványos.

-

Alogonomus

őstag

Talán a 7800 teljesítményarányos fogyasztása sem is lesz rosszabb a 4070-hez képest. A leaker megosztotta a 7800M XT eredményét is, és a 17842 pont szinte egyezik a 4070 átlagosan 17854 pontjával, ahogy a 7800M XT 189 wattja is körülbelül a 4070 fogyasztását hozza.

Persze az kérdéses, hogy a 7800M XT milyen MCD-t használ, de a 7600M XT az a teljes értékű 7600 asztali chipet használja, csak lejjebb tekerve. -

Abu85

HÁZIGAZDA

Egyébként a frame-ek közötti késleltetést nyilván lehet hibaként értelmezni, de valójában itt arról is van szó, hogy régi API-kat fogsz Vulkanra átültetni, tehát ott nagyon sok olyan tényező van, ami nem mappelhető tökéletesen, és nyilván el lehet érni elég jó eredményt, de a natív megközelítés mindig jobb lesz. Ezt azért annyira nem rónám fel nagy hibának, noha kétségtelen, hogy sokat lehet rajta javítani, mert idővel kezdik kiismerni a problémát, illetve a Valve is hoz manapság olyan Vulkan kiterjesztéseket, amik pont az ilyen mappelési problémákra reagálnak, és ezeket elég könnyű támogatni is.

-

Abu85

HÁZIGAZDA

Más oka aligha lehet annak, hogy nem skálázódik a kód. Ez világosan látszik a profilozó által kiolvasott adatokból. Ez vagy szándékosság, vagy hülyéknek adták a feladatot. Mindenki döntse el maga.

#61875 Yutani : Azok a képek a Valve egyik programozójától származnak, aki a Twitterre feltöltötte, mert ledöbbent, hogy így ki mernek adni egy programot. Nem igazán értette senki, főleg az a fura, hogy RT gyilkosnak van beállítva, és alig terheli az RT részegységeket, ezt le is lehet olvasni a profilozóból.

Az okokat senki sem tudja. Kellene egy olyan ember, aki részt vett ennek a megírásában, de ők nem nyilatkozhatnak. Ha valaki nyilatkozna, akkor el tudná mondani, hogy egyszerűen erőforrást nem kaptak, vagy nem voltak elég felkészült emberek a projekten, vagy felülről utasították őket arra, hogy szarul fusson. Mindhárom lehetséges.

-

Abu85

HÁZIGAZDA

Két oka lehet. Vagy hülyék írták meg, vagy a programozóknak a vezetőség megszabott egy teljesítmény targetet, és addig kellett növelni a regiszternyomást, amíg a targetre be nem lassították a hardvereket. Utóbbit könnyű megtenni, mert csak a szükségesnél több adatot kell a regiszterbe tölteni.

-

Abu85

HÁZIGAZDA

Csak nem azért fut a Portal 2 RTX-ben fosul, mert nagy számításigénye van, hanem azért, mert maga a kód van úgy megírva, hogy fosul fusson.

Ezt nem tudod új hardverekkel megoldani, mert a kód nem tud skálázódni. Egyszerűen túl nagy a regiszternyomás, és pont ez az, ahol a hardverek évek óta nem fejlődnek, és nem is fognak, mert a regiszternyomásra lehet optimalizálni, és az olcsóbb, mint megnövelt regiszterkapacitást beépíteni. De ha a kód erre nem optimalizál, akkor nem is fog skálázódni, mert annyira kevés wave fog futni a hardveren, hogy mindig adatra fog várni a GPU, akkor is, ha 10x annyi feldolgozót építesz bele, mert nincs elég konkurens wave, hogy számoljon valamit a hardver, dacára annak, hogy van benne 10x annyi feldolgozó.

-

Abu85

HÁZIGAZDA

Ott van profilozva az alkalmazás. Láthatod benne, hogy milyen a kód. Feketén-fehéren ki vannak olvasva az adatok belőle. Ez nem egy vélemény, hanem tény, amit a profilozó mond a kódról. Nem muszáj hinned neki, de egy teljesen elfogulatlan program által kiolvasott tényeket tagadsz meg, csak azért, mert nem kompatibilis a világnézeteddel. Mert naívan hiszel annak, hogy a gyártók végletekig optimalizált játékokat akarnak letenni a hardverekre, és biztosan nem tennék azt meg, hogy szándékosan visszafogják a kód teljesítményét, hogy megvedd az 1500 dolláros csodájukat. Á erre tuti, hogy nem vetemednének.

-

Abu85

HÁZIGAZDA

A Portal ezért fut rosszul: [link]

Nem az eljárás a megterhelő, hanem az, hogy az elérhető hardverben rendelkezésre álló feldolgozók 10%-át sem használja. Ráadásul úgy, hogy az RT műveletek igen minimálisak.

Egyszerűen maga a kód úgy van megírva, hogy ne tudjon skálázódni a GPU-kon. Ez nem egy hardveres limitáció, szoftveresen, a programkódban van a sebesség teljesen visszafogva. Sosem lesz olyan hardver, ami ezen segít, mert mindig csak a rendelkezésre álló feldolgozók egy kis része működhet majd, mert a kód maga erre kényszeríti a hardvert.

-

Abu85

HÁZIGAZDA

A legtöbb játékban azért van mindhárom felskálázás, mert a GPUOpenes FSR2 van benne, és arra már sok olyan wrapper érhető el, amire jól ráilleszthető a DLSS2 és az XeSS is. A Starfield nem a GPUOpenes FSR2-t használja, hanem azt, ami az Xbox GDK-ban van, és az elég sokban különbözik az AMD-féle megoldástól, így a tipikus wrapperek, amiket akár a Bethesda megírt korábban, nem működik vele. Írni kell rá egy másikat. A kérdés az, hogy megéri-e ezt a befektetést, vagy inkább költik az erőforrást az extra adatokkal való etetésre.

Jellemzően azokban a játékokban nincs DLSS2 vagy XeSS, amelyben az Xbox GDK-ból van az FSR2. Azokban van, ahol az FSR2 az AMD-től származik. Sajnos ez nem mindegy, mert hiába ugyanaz a két eljárás neve, az implementáció eltérő.

-

Petykemano

veterán

Sokmindenben lehet találni logikát.

A Navi33-ról is az a szóbeszéd járja, hogy a Navi31 körül már kész volt, ami azt jelenti, hogy fél évet visszatartották, míg leapadnak a Navi23 készletek. Elképzelhető, hogy a Navi32 is csak a Navi21 készletek miatt van visszatartva/késleltetve. Végső soron Lisa Su asztalán volt valami lapka, amit a közösség Navi32-ként ismert fel.

Abban persze igazad lehet, hogy úgy kijönni a "javított" Navi32-vel, hogy az borítja az eddigi termékportfóliót nem volna logikus. Akkor már inkább az tűnik jó megoldásnak, hogy Navi31-ből készítenek még egy vágott verziót ebbe a szériába, kiszórják a meglevő Navi31 készletet is és aztán az egészből csinálnak egy refresht-t, amikor az összes lapkából elkészül a javított verzió. Már amennyiben az létezik.

Szóval akkor továbbra is csak akkor tudjuk meg, hogy a Navi32 egyfajta "javított" változatú Navi32-e,a mikor megjelenik.

-

S_x96x_S

addikt

majd meglátjuk ..

> Az RDNA3 hardveres betegségeit az RDNA4 ből származó fejlesztésekből

> fogják orvosolni a pletykák szerint, nem az CDNA3 megoldásaiból...a lényeg hogy a jelenleginél több , ~ négy GPU chipletet kapcsolnak össze.

és nevezhetjük a javításokat RDNA3+ vagy RDNA 3.5 -nek is, habár a nevekkel mindig kavarodás van.> Ami még probléma az időzítés:

> 2023 negyedik negyedévben várható, míg a H100 már van.most csak a consumer desktop-ról spekulálok: RTX 5000 series

#61774Petykemano:

Persze nem olyan egyszerű, mint ahogy állítom,

de szerintem elméletileg lehetséges.> Másrészről a Mi300 bázislapkája tele van IO-val - ide értvea PCIe és CXL-t,

Az miért baj itt?

Egy rendes PCIe-s 5.0 -ás GPU -nak úgyis támogatni kell a PCIe-t és CXL-t

Memória coherens GPU - rulez ! -

PuMbA

titán

Igen, pontosan ez van. Az AMD az NVIDIA-val ellentétes utat jár(t), erősen a hardverre koncentrálva, lásd: Infinity cache, RDNA3 chiplet dizájn, illetve régebben, ahogy írod: HBM memória, GCN architektúra.

A valóságban viszont az látszik, hogy a GPU-knál a szoftver jóval többet dob a latban és így lett az NVIDIA az első számú GPU gyártó. Az AMD a CPU-jait rendbetette, most pedig úgy látszik, hogy végre GPU-khoz kapcsolódó szoftverre is elkezdenek gyúrni: pl. Fidelity FX SDK.

-

Petykemano

veterán

Hasznos info mind a becslés, mind pedig a mérés.

Ehhez majd csak hozzá kell passzintani a tényleges eredményeket - mármint persze ha szóbanforgó névvel kártya végül nem vágott Navi31-re, hanem Navi32-re épülve fog forgalomba kerülni - és egyből látni fogjuk, hogy történt-e "architekturális korrekció" -

S_x96x_S

addikt

> ... Megközelítés kérdése.

igen

de a "alap kiinduló kijelentés" ez volt, amire válaszoltam:

> #61720PuMbA

> ""A sima 4060 majdnem fele fogyasztásból fogja hozni a 7600 teljesítményét""Ha az Igor 2.810 "average Watts by frame per second" -ot mért az RX 7600 -ra ( 1440p)

akkor 1.405 körül kellene lenni a "majdnem fele" esetén,

de azt már nem fogja elérni.persze ez csak szőrszálhasogatás részemről .. az 50% helyett a 36-40%-is elég jó.

és a videós dologból én se nagyon tudnám jobban megbecsülni..elnézést ..

-

S_x96x_S

addikt

> Igor mérése szerint.[link] 1 monitornál 8 W

amúgy szeretek vitatkozni .. de ez tényleg jó meglátás ..

A Guru3D is 7W idle -t ír ... ;Logikai Lehetőségek ( remélem nem hagytam ki semmit se )

- Lehet, hogy a monitor típusától is függ,

- Más módszertan szerint mértek,

- Félre-mértek,

- Egyéb ok ,

- A fentiek kombinációja

-

DudeHUN

senior tag

Azzal, hogy ezekhez méri azt a csoportot akarja megszólítani, akik még mindig ezen kártyákat nyüstölik. Nyilván ez mindenkinek tiszta.

Egyrészt jóval többen vannak, mint az azonos kategóriás Radeont birtoklók. Másrészt meg mi másról érdemes egy RX 7600-ra váltani játékosként? Még az RX 500, meg RX 400-as széria. De ők jóval kevesebben vannak. Mondjuk még a GTX 1650/60-at bedobhatták volna, mint népkártya. De gondolom nem akarták bonyolítani a chartokat.

Ez alapján AMD úgy gondolja, hogy nem a 2-3 éves kártyákat birtoklók az ő célcsoportjuk ebben a szegmensben ahol ez a kártya van (ár és teljesítmény), hanem az egy generációval korábbiak. Mondjuk igazuk is van szvsz. -

Petykemano

veterán

Szerintem rosszul értelmezed. Te azt várod, hogy az AMD győzzön meg téged, miért őket válaszd a sok alternatíva közül.

De ez az ábra csak annyit mond, 1060/2060 kártyáról erre már érdemes váltani - közben semmit nem mond a konkurenciáról.A legtöbb reklám ilyen (általános mosópor)

-

Petykemano

veterán

Nem lehet, hogy csupán egy szemléletbeli különbségről van szó?

A grafikon a 1060/2060 tulajdonosokat igyekszik meggyőzni, hogy érdemes 7600-ra váltani.

Te meg - ezt axiómaként véve - nem azt szeretnéd látni, hogy a 1060/2060 tulajoknak érdemes-e, hanem hogy miért pont 7600-ra lenne érdemes több más alternatívához képest. -

fLeSs

nagyúr

OK, de az AMD-s muksó nem fogja a 3060 Ti-t reklámozni, gondolom nem kell magyarázni, hogy miért.

Egyébként is a 3060 Ti drágább a 7600-nál.

Egyébként is a 3060 Ti drágább a 7600-nál.

A 6650 XT/6700 elméletileg kifutó típusok, szal ezeket sem fogják már reklámozni.

Neki nem az a feladata, hogy egy teljes techpowerup-tesztet egy rakás különböző kártyával egy marketing-slide grafikonba beletuszkoljon, hanem hogy a legújabb cuccot jó színben tüntesse fel.

Az NV DLSS3-as fps-eredményekkel reklámoz, az sztem sokkal inkább hülyének nézés, mint ez.

Btw ha RTX 2060-am lenne akkor nem gondolkodnék a váltáson, mert nem tűnik elég nagynak az ugrás. -

fLeSs

nagyúr

Most akkor melyik volt az első és melyik a második?

Én a régi kártyákkal való összevetéses graffal kapcsolatban kérdeztelek. Sztem az korrekt abból a szempontból, hogy a tesztelők által súlykolt véleménybuborékon kívül valójában az emberek többgenerációnként cserélnek, szal van értelme az 1060-nal és a 2060-nal összevetni a 7600-at.

Azok a régi kártyák anno még drágábban is jöttek ki, mint az RX 7600 és ebben az árérzékeny szegmensben ez érdekli egy potenciális vásárlót hogy mit várjon egy upgradetől. Az AMD próbálkozik meggyőzni őket, hogy GF helyett Radeont vegyenek (márha egy tweet próbálkozásnak tekinthető ).

).A 3060 8 GB-tal való összevetés sztem is enyhe csúsztatás, de nem túlságosan lőtt mellé. Ez sztem amúgyis csak elméleti síkon érdekes, mert a valóságban szinte senki nem fog ilyen cserét csinálni.

RX 7600-ból összesen 5 féle van árukeresőn, 115-139 bruttó között. A többség sztem a Sapphire Pulse-ot venné ami 118.

RTX 3060 8 GB-ból 9 féle van, 105-125 bruttó között (PNY, Palit, Inno a legolcsóbbak).

RTX 3060 12 GB-ból 31 féle van, 120-160 bruttó között.

Szal kb. megegyezik az áruk.

A 6650 XT-t "elfelejtették" megemlíteni, az már 98-tól kapható (ráadásul Asus). -

-

-

Alogonomus

őstag

Az adó nélküli listaár az más néven lényegében az MSRP, ami a táblázatban is szerepel árként. Azért írtam a kifejtettebb formában, hogy egyértelmű legyen, hogy a kiskerárak, amiket látsz, azok már az adót is tartalmazzák.

Vagyis a €799 az valójában €670 a bolt kasszájába, és €130 az állami kasszába.

Ugyanígy az itthoni 316 ezres Hellhound kártyából is 250.000, vagyis kb €680 a boltnál marad, és 66.000 az államkasszába vándorol (szabályos esetben). -

Alogonomus

őstag

Eredeti árakkal kalkulálva reális lehet a táblázat, de a szolid piaci igények miatt a 7500 és 4050 szerintem aligha fog megjelenni. Főleg nem a 6 GB-os verzióik.

A 7800-ak és 7700-ak árai pedig szerintem nem maradhatnak a táblázatban szereplő szinten, hiszen adó nélküli listaáron a 7900 XT már €700 alatt is kapható.

A gyengébb 7800 XT kevesebb memóriával így maximum $600 lehetne, és minden további kártya is egy szintet lépne lefelé. A "sima" 7800 lehetne $530, a 7700 XT $480, míg a 7600 XT akkor mondjuk $350. -

HSM

félisten

"2014 januárban nyújtotta be AMD a kérelmet a CES -után a DP1.2a szabvány módosítására."

Miért nem olvasod el, amire hivatkozom? Le van benne írva világosan, hogy előző év november 25-i a dokumentum. Valamint ahogy #61592 kisfurko is említi, amikor konkrét javaslat van már, azelőtt már szoktak lenni előzetes egyeztetések. Januárban már GMR fázisról írnak, ami eléggé már a vége a folyamatnak...

Le van benne írva világosan, hogy előző év november 25-i a dokumentum. Valamint ahogy #61592 kisfurko is említi, amikor konkrét javaslat van már, azelőtt már szoktak lenni előzetes egyeztetések. Januárban már GMR fázisról írnak, ami eléggé már a vége a folyamatnak...#61595 b.: "Ez egy opcionális funkció, a Vesa nem vezette be a 1.2a szabvány kötelező részeként"

Nem teljesen értem, miért kellene kötelező elemnek lennie. Miért ne gyárthatna valaki ezt nélkülöző monitort? Egy egyszerű irodai monitornak pl. semmi szüksége rá.

Egy egyszerű irodai monitornak pl. semmi szüksége rá.#61596 kisfurko : Az általam linkelt cikk behivatkozta a VESA dokumentumot, kb. mit jelent a GMR fázis. Én sem vagyok tag, de ebből azért már lehet erős következtetéseket levonni.

-

kisfurko

senior tag

Felőlem azt hiszel, amit akarsz, nem fogom megmondani, hogy ki vagyok, meg melyik chipgyártónál dolgozom

Nem is beszélhetek róla, hogy min dolgozom, csak ami már be van jelentve (gyakorlatilag majdnem kész).

Nem is beszélhetek róla, hogy min dolgozom, csak ami már be van jelentve (gyakorlatilag majdnem kész).

Abban igazad van, hogy nem vagyok sem a VESA tagja, de még csak nem is volt részem a szabványban, mindössze próbáltam utalni rá, hogy nálunk ez hogyan megy, milyen időintervallumok vannak, mennyire nyögvenyelős egy ilyen szabvány megalkotása. -

kisfurko

senior tag

Mert nem racionális, amit írsz, csak azt gondolod, mert nincs háttérismereted a félvezetőiparról.

Az tök normális, hogy egy év, mire az elfogadott szabványból termék is lesz. Te kockáztatnál százmillió dollárokat egy még nem elfogadott módosítással? És ez kizárja, hogy előtte hónapokig/évekig piszmogjanak a szabványon, hogy minden résztvevőnek megfeleljen?

Amit te ebből látsz, az a végleges eljárás, az előtte levő egyeztetéseket nem. -

kisfurko

senior tag

Na, ez így már teljesen helyes értelemezés. Csak nem tudjuk, hogy a FreeSync (aminek az AMD csinált ilyen marketing nevet) tárgyalások mikor, mennyire haladtak.

Én megértem az Nvidia lépését is, valószínűleg nekik nem felelt meg az aktuális állapota a szabványnak, de ez is csak a szokásos nem etikus üzleti lépés, amit megszokhattunk már tőle, belekényszerítette a gyártókat, adott is nekik vezérlőlapot. A prémium gamerek nyilván jól jártak a végtelen pénztárcájukkal. De ezért is a legjobb chiptervező cég az Nvidia, mert remekül érzi ezeket a dolgokat. Megteheti, mert piacvezető. -

kisfurko

senior tag

Vettél már részt szabvány létrehozásában? Évekbe kerül. Csak a kidolgozás. És akkor még rá se bólintott az összes résztvevő a boardban. Ha csak azt nézed, amit az átlagember láthat, akkor persze, hogy a szemednek fogsz hinni. Amit te kiszivárogtatásnak hiszel, az semmi ahhoz képest, amik tényleg vannak. Amikor kiszivárog valami, akkor gyakorlatilag majdnem készen van.

Évekre előre terveznek. Nálunk is olyan prototípusok vannak, amik ki tudja, hogy egyáltalán meg fognak-e jelenni, s ha igen, akkor is évek munkája. Szerinted, amikor a követleményeket összeállítják, akkor nem kezdik el a szabványt hozzá csinálni? Ezt is csak akkor, ha a meglévőkbe nem lehet beleilleszteni, mert jó nagy kockázat, semmi sem garantálja, hogy a többiek rá fognak bólintani, pláne, ha csak másodhegedűs vagy. Amennyiben nem csak szoftveres szabvány, akkor még több idő, ehhez hozzájön még a még nagyobb pénzügyi kockázat.

És senki nem mondta, hogy az AMD-t követte az Nvidia, hanem, hogy dolgoztak egy közös szabványon, amiből kiugrott az Nvidia.

A levédetés meg nem így működik. 1-2 hónap, amíg megvizsgálják, hogy van-e ilyen, le lehet-e védetni, aztán benyújtják, és onnantól él, ha majd évekkel később megítélik.

A G-Sync meg nem szabvány, azt egyedül az Nvidia hozta létre. -

HSM

félisten

FPGA-t nem fognak ilyesmire tervezni, ezt levették a polcról... Ahogy a kezdeti monitor kínálat is kb. úgy készült, hogy az egyedi modult belerakták a scaler helyére, és onnan már csak egy profil kellett a kijelző panelhez. Egy zárt technológiával, polcon lévő, drága, általános célú feldolgozókkal ezt könnyen és gyorsan piacra lehetett vinni. A szabványos megoldásnak éppen ez a hátránya, ki kell dolgozni a szabványt, meg kell várni, mire az ellátási lánc szereplői hardvert készítenek rá (új scalerek, nem drága FPGA!), ez mind idő. Láttak itt lehetőséget kis pénzt/marketingértéket teremteni, ráugrottak. Szvsz kb. ennyi a nagy innováció ebben a zöldektől.

-

HSM

félisten

"A Vesa 2014 ben, fél évre rá kb jelentette be..."

Vegyük figyelembe, hogy akkor már vélhetőleg rég dolgoztak rajta. Az általam linkelt cikk alapján volt a Vesa-n belül is felhördülés a G-sync kapcsán...."Nekem szerencsére jól működik az A-sync a Freesynces monitoron"

Mivel a FreeSync az Adaptive Sync AMD-féle implementációja, így meglepő lenne, ha nem működne. Az Nv is ezért tudja ezeket támogatni, hiszen szabványosak... Csak ezért ne válts HDMI2.1-re....

Csak ezért ne válts HDMI2.1-re.... ![;]](//cdn.rios.hu/dl/s/v1.gif)

#61566 Busterftw : "Tehat a FreeSynccel itt az AMD mit innovalt"

Az AMD itt azt szerette volna innoválni, hogy legyen egy nyílt ipari szabvány, amire mindenki építhet azzal kompatibilis monitort/VGA-t, a mobil eDP példája alapján.

Aztán az Nv gyorsan bedobta a saját megoldását, remekül szegmentálva a piacot, és röghöz kötve a felhasználóit, mindezt eladva "innovációnak" (marketing, amiről írtam)...."Ez miben vitatja..."

Ez nem azt vitatja, hanem a másik állításodat, hogy már mióta készült a garázsban.... Ez azt bizonyítja, hogy az Nv is csupán átmeneti megoldásnak szánta, és expressz sebességgel kellett vele piacra lépni."Tudod, gyorsan, az Nvidia elott, innovaltak."

Igen, megoldották ingyen, szoftverből, aminek az Nv-nél 200$-os pluszhardver kellett, ami még felsőkategóriás monitorok esetén is azért elég jól látható összeg. Ezt inkább tekintem innovációnak, mint az Nv akcióját... -

HSM

félisten

"Tényleg prémiumok voltak. ( árban is)"

Amikor végre kijöttek a FreeSync-es alternatívák, ugyanúgy használhattak prémium, széles tartományú panelt benne, és jópár gyártó meg is tette.#61563 Busterftw : "Nem keverem, mindketto Adaptive Sync-re epul"

Az adaptive sync-re épül szerinted az adaptive sync? Nincs több kérdésem.

Nincs több kérdésem."Nem "gyorsan" jott ki ezzel az Nvidia, mar csak a sajat hardveres modult kifejlesztese es gyartasa miatt sem volt ez lehetseges."

Persze, azért jöttek ki egy kutya közönséges Altera gyártmányú kész FPGA-val saját dedikált célhardver helyett, mert olyan régóta készült a boszorkánykonyhájukban.... [link] (forrás: [link] )

[link] (forrás: [link] )"A FreeSync Premium 2020-ban debutalt, olyan feature-rel amivel a G-Sync mar 5+ eve piacon volt."

Jó volna, ha befejeznéd a súlyos tárgyi tévedések tényként való feltüntetését...

Ugyanúgy 2015-től elérhető volt ez a technológia is, csak akkor még nem tartozott hozzá hivatalos certifikáció... [link]"A gond azzal van, hogy hiaba van ez a funkcio a Freesync monitorok tobbsege 48hz-tol mukodik."

Mint írtam, nem a legolcsóbb gagyi típusokat kell megvenni. Ez nem a FreeSync hibája, hogy a technikailag alkalmatlan monitoron nem tudnak bizonyos dolgokat megvalósítani. Egy épkézláb FreeSync monitor már egyébként régen is tudott legalább 48Hz-120Hz tartományt, amivel már működőképes az LFC. Régi G-sync monitorból sem véletlen nem voltak ilyen olcsó megoldások. -

Yany

addikt

Egyetértek, és igen, elsősorban a cím okozott bennem értelmi törést.

Mindenesetre sokat elmond, hogy Abu is képtelen volt említeni akár egy közeljövőben felmutatható innovációs törekvést (és nem NDA-s dolog a piaci trendeket elemezve találgatni, de amikor már egy ősfan is elnémul egy ilyen kérdésre, az többet mond minden szónál).

Mindenesetre sokat elmond, hogy Abu is képtelen volt említeni akár egy közeljövőben felmutatható innovációs törekvést (és nem NDA-s dolog a piaci trendeket elemezve találgatni, de amikor már egy ősfan is elnémul egy ilyen kérdésre, az többet mond minden szónál).És ilyenkor ilyen címadással és ilyen (egyelőre) vérszegény Computex-es jelenléttel ez a rossz érzés csak még tovább sorvasztja az egészséges piaci versenyre áhítózók szívét.

-

-

Alogonomus

őstag

Na az nem lepett meg, hogy Igornál az RTX kártyák az átlagot jelentősen meghaladó eredményt érnek el...

![;]](//cdn.rios.hu/dl/s/v1.gif)

A két gyártó "szara" között annyi a különbség, hogy míg a 4060 Ti híg szar, addig a 7600 legalább már szilárd szar.

Szóval az a szalmaszálad is elszakadt, mert a $270-os 7600 "akár" alternatíva is lehet egy $260-os 6650 XT helyett, csak alig jobb annál, így $270-ért kevés értelme volt most kiadni.

A 4060 Ti viszont $400-ért teljesen versenyképtelen, vagyis minden értelmes ember messzire elkerüli. -

-

Busterftw

nagyúr

Listáztam kíváncsiságból hány pcpartpicker build van ADA vga-val és RDNA3-al.

74 oldal Nvidia: 1480 build

15 oldal Nvidia: 300 buildDe még 4090 buildből is 2x annyi van mint 7900XT és 7900XTX-ből összesen.

Persze nem teljesen reprezentatív, de mégis felveti a kérdést honnan jön az újabb varázsgömb jóslata...

Mese, habbal, amikor épp alig kapar össze valami market sharet az AMD AIB részleg, OEM-estől DIY együttvéve.

-

Alogonomus

őstag

Elolvastad a kifejtésemet is? Komolyan arra számítasz még, hogy a 7600 az állítólagos 165 wattból még a 6650 XT teljesítményét sem fogja elérni?

Engedd el, az csak egy szalmaszál, amibe kapaszkodsz. A prebuilt rendszerekbe nyilván kerülhet majd 4060 Ti, de a DIY gépekbe vagy az N23-as/N22-es kártyák, vagy az N33-as kártyák lesznek a kifizetődőbb választás. A 4060 Ti sem egy totális katasztrófa, az elhivatott Nvidia fanok nyilván veszik majd, hiszen még a 3050-est is vették $300-ért. -

Petykemano

veterán

Az elég valószínű ez alapján, hogy az RX 7600 nem, vagy legalábbis teljesítményben nem kifejezetten versenytársa a 4060Ti-nek. Talán inkább a 4060-nak.

Ha van bármiféle igazodás, akkor talán meg lehet süvegelni, hogy ezt tükrözi a nevezéktan is és nem próbálnak trükközni, lódítani vele.Meg is jelent nemhivatalos adatokra támaszkodó nemhivatalos elemzések: [link]

"Time Spy Graphics (1440p raster): +7%

Time Spy Extreme Graphics (4K raster): +11%

Speed Way (1440p raster+RT): +16%Reminder: AMD advertised +17.4% average perf increase clock for clock for an RDNA3 CU

vs RDNA2 CU, and even more than that for ray tracing workloads."Bár a nevezéktan lehet becsapós, de talán érdemes úgy is megtenni az összehasonlítást, hogy az előző generációs RX 6600-hoz képest a teljesítménynövekedés 30-40%-os is lehet.

Persze ebben az összehasonlításban is minden elsősorban az ár, másodsorban a TDP kérdése. Ha ebben a jobb számokat mutató összehasonlításban próbálnák eladni úgy, hogy $299-ért még olcsóbb is, mint az előző generáció, valószínűleg ezen simán átlátna a közönség.

Nem is beszélve arról, hogy ha azt feltételezzük, hogy ez majd a 4060-nal lesz versenyképes, akkor $299-nél drágábban semmiképp nem is lehetne adni és így már nem is olyan nagy dobás, mégha dobnak is némi generációs perf/$ előrelépést is végre ennek az árszegmensnek.

Azt mondják lesz referencia is.

Ami szerintem elég érdekes lévén, hogy szinte csupán egy rebrandről beszélünk. Jó, persze nem, más a lapka, más az architektúra, csak épp a megszólalásig hasonlítanak egymásra a specifikációt tekintve - olyannyira, hogy több gyártó is bejelentette már, hogy a navi23-nál használt hűtőt fogják használni.Ránézésre ez a design elég fapad, biztos kellően "rossz minőségű" hűtő. Ami "indokolt" is.

A 6600/XT és 6500XT esetén láttuk, hogy sok esetben - legalábbis látszólag - ugyanazt a hűtőt használták. Márpedig azt azért lehet feltételezni, hogy ha egy felakkora lapka esetén is ugyanazt a hűtőt használják, akkor az a felakkora lapkával szerelt kártya nem fog tudni feleannyiba kerülni.Mindenesetre bízom benne, hogy ezek a lépések (A 6600XT/6650XT-nél alacsonyabb frekvenciák, az olcsó hatású hűtő) kifejezetten azt célozzák, hogy árban le tudjanak menni $249-re. Ennek egyébként tényleg nem kéne, hogy problémát jelentsen, hiszen $220 körül mennek az RX 6600-ak.

-

Raymond

titán

$299 aron (329EUR a nagyviz ezen oldalan) azert eloszor a 6650XT keszleteknek kell megcsappaniuk alaposan hogy az uj kartya atraktiv legyen. Most 279-309 kozott van rengeteg azokbol, majd kiderul hogy az itt lathato [link] par szazalek elonybol mennyi mutatkozik meg melyik jatekonal.

-

Alogonomus

őstag

Amennyiben hiszünk a Videocards hírének, és valóban 21 centinél kisebb lesz a 7600 MBA referenciamodell, akkor egy 6500 XT szintű, vagyis 100 watt körüli fogyasztású kártyát képzelhetünk el, ami viszont minimum egy 28 centis és 200 wattos 6650 XT teljesítményét nyújthatja, de talán meglesz a 27 centis és 220 wattos 6700 XT teljesítménye is amíg memóriából bírja. Egy 33 centis és 290 wattos 6750 XT teljesítményének az elérése azért már csodaszámba menne.

Azért ez eléggé jó érv lehet a 7600 mellett, és a 28 centis 200 wattos 6650 XT is azt jelentené, hogy majdnem duplázták a perf/W értéket. -

huskydog17

addikt

Hm...kombinálva ezekkel az információkkal, én arra számítok, hogy a sima RX 7600-as tempója nagyjából az RX 6700-as (non-XT) szintjén lesz és talán meg tudják oldani 120 Wattból. Ha ez a kártya maximum 249 dollár lesz és valóban hozza majd kb. 120 Wattból a sima 6700-as tempóját, akkor azt mondom, hogy az még elfogadható, az még úgy ok.

-

PuMbA

titán

A árral tarolhat az AMD, ami biztosan kevesebb lesz a 4060 Ti-hez képest, mert ugye gyorsabb biztosan nem lesz a kártyájuk, de számottevően lassabb se lesz szerintem

Kérdés, hogy mennyivel lesz kevesebb az ár. Ha 100 dolcsival, az jó helyzetbe rakja az AMD-t és best buy lehet.

Kérdés, hogy mennyivel lesz kevesebb az ár. Ha 100 dolcsival, az jó helyzetbe rakja az AMD-t és best buy lehet. -

HSM

félisten

Ez is pl. arra utal, hogy nem a metszésvizsgálat miatt lassú pl. az RDNA2 RT-je [link] .

A második bekezdésed nem tudom hova tenni, de biztos nem arra reagál, amiről beszéltem.

Azzal teljes mértékben egyetértek, hogy egy épkézláb API nagyon kéne, ami mindkét hardverre elég jó. -

HSM

félisten

Itt megint az a gond, hogy az RT nem csak Ray-triangle intersection vizsgálat... Jól néz ki papíron ez, de a gyakorlati haszna szvsz erősen kérdéses az alapján, amiket eddig láttam RT-s shader elemzések.

Abból is világos lehet, hogy pl. semelyik mai játék semelyik beállításán nem hoz a 3090Ti másfélszeres tempót a 7900XTX-hez képest, és a 4090 is legfeljebb csak dupla tempó, a 4X-esnek a közelében sincs. A 4090 esetén ezt rá lehet fogni az API-ra, a 3090Ti esetén viszont nem, hiszen a mai 1.1 DXR API kb. arra a hardverre íródott. -

Alogonomus

őstag

Az elfogadható kompromisszum mértéke mindig a piaci helyzettől függ.

Amikor horrorisztikusnak tűntek a Turing árai, akkor sokan inkább kompromisszumot kötve Pascal kártyát vettek, és kicsit lejjebb állították a grafikát.

Amikor te vehetted a 3080-adat, akkor még a kriptoőrület miatt lehetett túlkeresleti piac, ezért a 3080-at is csak drágán tudtad megvenni, és fel kellett vállalnod azt a kompromisszumot, hogy amennyit akkor rá tudtál szánni a kártyára, annyiból a 3080-ra futotta, és abból a 3080-ból hoztál ki annyit, amennyit lehetett.Most viszont súlyos túlkínálat van a piacon, ezért már a gyártóknak kell engedniük a profitjukból (kompromisszumot kötniük), nem a vásárlóknak. Egy alapból $400-os 4060 Ti itthon talán 180 ezer is lenne, annyit pedig aligha fizetnének egy 3070 Ti kaliberű kártyáért.

-

Ribi

nagyúr

Ja hogy 6950 és nem 6900

Jóvan, csak irogatok

De azt is tegyük hozzá, hogy sikerült lemérnie a legjobban eleresztett kártyát. Szóval ez ennyit eszik (más tesztekben is bőven 400W felett), de ha a gyártit nézel az nem eszik 400W felett. Nincs a nevében hogy OC, de eléggé az. Gyári tényleg 340-350W körül eszik. Nem igazán fair így az összehasonlítás.

-

Jacek

veterán

No problemo , kinek a pap kienk a papné

Filoztam rajta sokat hogy 4070 vagy AMD akkor tolta le a gatyát a 6950-en az AMD, egy árban volt a legpuruttyább 4070 a 6950 RedDevillel, közre játszott ugye hogy a nagygépemben 4090-van.

Itt meg egy full AMD ökoszisztem dolgozik 5800X3D+6950, így támogattam minkét gyártót

-

PuMbA

titán

A 4070 az NVIDIA-nal az egyetlen szóba jöhető kártya jelenleg és a legolcsóbb új generációs kártya is az AMD-t is belevéve, így én azt megértem, hogy veszik, mint a cukrot, még ha kicsit gyorsabb is, mint a sima 6800. A 3000-res NVIDIA generáció a 8GB VRAM miatt kuka, a több VRAM-osok meg már túl sokat fogyasztanak és kazánok, amire szintén semmi szüksége az emberek többségének. 4060 eladásokra majd kíváncsi leszek én is.

-

Abu85

HÁZIGAZDA

Az AMD nem tudja odaadni ingyen az OBS-nek ezt a technológiát, mert ezért a kódért a professzionális piacon mozgó partnereik, amelyek javarészt még a Xilinxtől vették a licencet, soktízezer dollárt fizetnek havonta. Az OBS-nek is megvan ez a lehetősége, csak nem tudnak kitermelni ekkora összeget, hogy megvegyék a licencet. Az AMD pedig hülye lenne negyedéves szinten millió dolláros bevételről lemondani, csak azért, hogy az OBS-nek legyen egy olyan technológiája, amit amúgy önmaguktól nem tudnak megfizetni vagy kifejleszteni. Odaadják a gémereknek a saját programjukban, a többiek pedig vagy fizetnek, vagy nem kapják meg. De nem, sosem fognak lemondani dollármilliókról úgy, hogy közben a piac tehetős része nagyon is vásárolja a szoftvert.

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- f(x)=exp(x): A laposföld elmebaj: Vissza a jövőbe!

- Hardcore café

- Robogó, kismotor

- Autós topik

- Xbox Series X|S

- Fejlesztői videón a Destiny 2 - The Edge of Fate

- PlayStation 4

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Álláskeresés, interjú, önéletrajz

- Megvan a Pura 80 nemzetközi startja

- További aktív témák...

- Samsung Galaxy A40 64GB, Kártyafüggetlen, 1 Év Garanciával

- LG 45GS95QE - 45" Ívelt OLED / 2K WQHD / 240Hz 0.03ms / NVIDIA G-Sync / FreeSync Premium / HDMI 2.1

- ÁRGARANCIA!Épített KomPhone i5 13400F 32/64GB RAM RX 7800 XT 16GB GAMER PC termékbeszámítással

- Telefon felvásárlás!! iPhone 15/iPhone 15 Plus/iPhone 15 Pro/iPhone 15 Pro Max

- Apple iPhone SE 2020 64GB, Yettel függő, 1 Év Garanciával

Állásajánlatok

Cég: Promenade Publishing House Kft.

Város: Budapest

Cég: CAMERA-PRO Hungary Kft

Város: Budapest

Szóval jól gondoltam, az AMD driveres részlege hozza a szokásos bénázást.

Szóval jól gondoltam, az AMD driveres részlege hozza a szokásos bénázást.

Le van benne írva világosan, hogy előző év november 25-i a dokumentum. Valamint ahogy

Le van benne írva világosan, hogy előző év november 25-i a dokumentum. Valamint ahogy

![;]](http://cdn.rios.hu/dl/s/v1.gif)

amit most ugy hivnak az meg ugyan az hardveres cucc nelkul nem?

amit most ugy hivnak az meg ugyan az hardveres cucc nelkul nem?