- iPhone topik

- Samsung Galaxy S25 Ultra - titán keret, acélos teljesítmény

- Samsung Galaxy S24+ - a személyi asszisztens

- Google Pixel topik

- A Galaxy Z Fold7, minden színben és oldalról

- Samsung Galaxy A54 - türelemjáték

- Google Pixel 8 Pro - mestersége(s) az intelligencia

- Samsung Galaxy S24 Ultra - ha működik, ne változtass!

- Szerkesztett és makrofotók mobillal

- Külföldi SIM-ek itthon

-

Mobilarena

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Petykemano

veterán

válasz

Yutani

#59543

üzenetére

Yutani

#59543

üzenetére

Nem lett borzasztó...

Hát... relatíve nem.az RDNA1-hez hasonlóan a mostani csúcs RDNA3 is csak a harmadik Nvidia sku befogására képes. Lehet persze, hogy ez a lemaradás végig létezett csak az RDNA2 széria esetén ócska Samsung gyártástechnológia elfedte.

De igazából mindegy is, mit nyafogunk, amíg az AMD esetlegesen elért előnyeit nem arra használja, hogy alacsonyabb árakkal szélesebb vásárlóközönséget érjen el, hanem minduntalan hozzáigazítja az árait az NVidia által megszabott szintekhez.

-

válasz

Yutani

#59543

üzenetére

Yutani

#59543

üzenetére

Csak MSRP-t nézni felesleges EU ban.

épp tegnap írtam Nvidia találgatósban erről. A 7900XTX és a 4080 szinte egy árban van nálunk, főleg ha valaki nem ref dizájnt akar( ami érthető) hanem AIB -ot akkor a 7900XTX drágább volt még tegnap is.

Ma bejött egy Pulse egy boltban 1350 euros áron de rányomva már 1430 Euro jön be rá...következő AIB már 1500 euro.

ha valaki REF et vesz akkor 1250 euro az első XTX.de a boltban már az visszaküldött kártyaként van fent valójában 1330 euro. nem látszik az a 200 dollár MSRP eltérés . épp ellenkezőleg. és főleg az AIB AMD kártyák ára magas.

[link]

Totálisan az jön le hogy jelenleg nincs jó vétel igazából, igényeknek megfelelően rossz és rosszabb van.

A 4070 Ti is egyre jobb fényben tűnik fel ilyen árak mellett sajnos. -

Yany

addikt

válasz

Yutani

#59543

üzenetére

Yutani

#59543

üzenetére

Az a baj, hogy egyik sem jó vétel perpill. A 4090-es egy TOP kártya, szemtelen összeget el lehet kérni érte, méghozzá aránytalanul, és ez utóbbin a hangsúly. A durva az, hogy ahhoz árazták a többit és a teljes piac ezt bekajálta, legalábbis a kínálati oldalon, de úgy néz ki, hogy így uborkaszezon közepén az early adopterek a keresleti oldalon is megették ezt. Szóval lesz itt még nagyon durva olcsósodás és a 12-pin problémán somolygó AMD-nek most a Vapor dráma és a megdöglő 6000-es termékek sem használnak. Sőt, a review site-ok által pedzegetett driver gondok sem segítenek a versenyképességben és ugye még mindig ott a DLSS, RT, fasza NVENC, stb, ami mind mind extra a puszta számokon túl.

A legeslegjobbért mindig szinte annyit kérnek, amit nem szégyellnek és a többi termék minden generációban le volt szakadva tőle, nem pedig arányos árakkal mentek alá. Most a 4090 tényleg sokkal jobb, ahhoz képest az ára pedig nem is annyira elszállt, de inkább a visszájáról igaz ez: a többi mászott nagyon rá árban. Ennyi. Ez teszi főleg totál sz@r vétellé az összes kártyát a piacon. Igen, mindet.

Használt 3090-est kell venni, legalábbis én ezt tettem és még a 4070 Ti előttig ez nem is volt kérdés, hogy a jó irány, már nem egyértelmű a 24 vs 12 GB VRAM miatt, de ez már másik topic.

Amúgy meg Petykemano +1

-

Petykemano

veterán

válasz

Yutani

#59541

üzenetére

Yutani

#59541

üzenetére

> túl jó lett a 4090

> Most aztán hogy az NV tudott túl nagyot gurítani vagy az AMD-nek nem jött össze a Navi31

Hát igen és sajnos a 4090 még csak nem is az ászok ásza, hiszen van ott még vagy 10% shader és a L2$ negyede, ami le van tiltva.Az volt a remény, hogy ha a Navi31 önmagában nem is, de a Navi31XTX3D majd felveszi a versenyt a 4090Ti-vel. De Abu szerint az se valószínű, hogy a Navi31XTX3D-nel a 4090 hozható.

Valóban nem tudni. Az Nvidiának látszólag minden összejött gond nélkül.

Hiába mondta Abu, hogy az AMD-nél milyen sok tapasztalt gyűlt össze a TSMC node-okkal kapcsolatban. Látszólag az Nvidiának nem volt gond a Samsungtól a TSMC-hez visszatérni és lekaszálni a másfél generációnyi gyártástechnológia fejlődés eredményét.

Ugyan az AMD is nagyon durva jó sűrűséget ért el. Ez egyébként a NAvi33 esetén is látványos. De ezzel egyszersmind mintha korlátokba is ütköztették volna az architektúrát. Nem tudom van-e valami hardveres hiba tényleg, vagy minden tervezett, de látszólag elvileg az AMD-nek nem igazán sikerült a megcélzott frekvenciát a megcélzott fogyasztás mellett elérni, így az Nvidia zárta az ollót.Az Nvidia remekül növelte meg az L2$-t igen komoly méretűre. Ez mellett az AMD infinity cache-e már nem tűnik nagy számnak. Akkor lenne nagy durranás, ha lehetne és lenne értelme az infinity cache 3D irányú bővítésének. De így az egész 3D felesleges petárdadurrogtatás. Márpedig a TSV ott van, foglalja a helyet az MCD-ben. Holt teher.

A Navi31 és az AD 103 tranzisztorszáma egyébként megegyezik, így tulajdonképpen annyira nem meglepő, hogy ezek versenyképesek egymással. Csak így a chipletezésből fakadó gyártástechnológiai költségelőny elhanyagolható. 20%-kal kisebb N5 lapka, de összességében majdnem másfélszer akkora + szerelés. Közben meg a késleltetésen van bukó. Sok hűhó semmiért.

Szerintem inkább az AMD vétette el a célokat.

-

Abu85

HÁZIGAZDA

válasz

Yutani

#59531

üzenetére

Yutani

#59531

üzenetére

A most érkező drivernél? Valamekkora extra sebesség biztos lesz, mert olyan mindig volt az előző drivereknél is, plusz most ugye új az architektúra, és a launch driverhez viszonyítva mindig lehet találni némi plusz tempót.

De a fő lényege a nagyfrissítéseknek mindig is a funkció volt. Amikor ezekről írtunk, akkor például sosem mértünk sebességet, mert a funkciókon volt a hangsúly. Most is azon lesz. Némelyik funkció új lesz, némelyik felújítást kap, de a működése nem változik, csak hatékonyabbá válik. Például a HYPR-RX miat az Anti-Lag és a Boost át lett szabva, hogy jobban tudjanak egymással működni. És ugye ezeket az átszabásokat külön is megkapják, tehát az új drivertől kezdve új kóddal fut az Anti-Lag és a Boost is, amikor külön kapcsoljuk be. És mivel az Anti-Lag alapja a Chill kódja, így nyilván a Chill is frissül, és hatékonyabban fog működni.

A Boostról annyit tudok, hogy az AMD egyre inkább áttér a klasszikus megoldásról a VRS Boostra. Erről korábban írtunk is hírt: [link] - a változás egyik része lesz, hogy a HYPR-RX általánosan működő technológia, így az új Boost sem per játék szintű lesz, hanem általánosan működő, tehát nem csak a hír táblázatában felsorolt címekben, illetve az azóta hozzáadott játékokban lehet majd bekapcsolni. De ez csak a sima Boostra jellemző, a VRS Boosthoz továbbra is kell a per játékra tervezett VRS mintatérkép. A működés itt úgy nézne majd ki, hogy a sima Boost az lényegében mindenhol aktiválható lesz, és amelyik játékra van VRS mintatérkép, ott nem a sima Boostot kapcsolja be a driver, hanem a VRS Boost verziót.

-

Abu85

HÁZIGAZDA

válasz

Yutani

#59515

üzenetére

Yutani

#59515

üzenetére

Driver lesz, és ugye általában az új architektúráknál szokott lenni némi gyorsulás a launch driverhez viszonyítva, de ugye ez sosem azt jelenti, hogy a feje tetejére áll majd minden. Itt is lesz majd némi gyorsulás, és kb. ennyi.

Amikor az új Radeonok nagyon gyorsak, akkor az azt fogja jelenteni, hogy a játék olyan helyen limitált, amit az egyes újítások kevésbé tesznek érezhetővé, például multi-draw indirect accelerator, stb.

-

Abu85

HÁZIGAZDA

válasz

Yutani

#59498

üzenetére

Yutani

#59498

üzenetére

A Navi 31 a csúcsmodell. Nem lesz annál gyorsabb.

#59503 Petykemano : Az a kép a scalar cache-re vonatkozik. Semmi köze az Infinity Cache-hez és a chiplethez.

#59505 Petykemano : Az RPM és a dual issue nem ugyanaz. Az RPM-re programozni kell, míg a dual issue-t a fordító hozza össze. Ez két külön problémára ad megoldást.

#59508 Petykemano : Manapság nem szokás shader cserét csinálni. Az régen volt hasznos. Ma már optimalizálni szokás, mert nem annyira drága a valós idejű fordítás.

Az AI nem tud ilyet csinálni, mert ezek az optimalizálások nem a GPU-n futnak vagy speckó hardveren, hanem a CPU elemzi ki a kapott kódot, és ott fordítják le a shader fordítók.

-

Petykemano

veterán

válasz

Yutani

#59498

üzenetére

Yutani

#59498

üzenetére

Ismerjük a Navi31 és Navi33 által érintett hardveres hiba történetét.

De ha a Navi32 hamarabb jön, mint 2023 vége, akkor az némiképp meglazítja a hardveres hiba új B-s steppinggel való javíthóságának narratíváját.Persze Abu sem tévedhetetlen. Még nem reflektált arra sem, hogy ő miért tudott teljesen más méretről a Navi33 kapcsán.

(Szerintem egyébként az van, amit mondtál, hogy van egy Navi33, ami a Navi23 újratervezése RDNA3 alapon N6-ra és van egy Navi34, ami pedig a Navi22 RDNA3 alapon. A Navi22 335mm2 volt, ugyanazt lapkaméret csökkenést feltételezve N6-on 288mm2 lenne, ami beleillik az Abu által elmondottakba. És ugyanazzal a 12+%-os gyorsulást feltételezve, amit eddig láttunk, ez a lapka tényleg csapkodhatja a Navi21 hátát)

-

szmörlock007

aktív tag

válasz

Yutani

#59474

üzenetére

Yutani

#59474

üzenetére

Ugyan ezt a lapkát hozta le az Angstronomics még tavaly nyáron mint navi33. Mivel eddig kb minden infó stimmelt onnan, így valószínűleg ez is.

Egyébként már itt is írták, hogy a nvi33 az mobil first fejlesztés, tehát teljesen logikus, hogy oda hozzák elsőre. Megjegyzem a Smartshift meg egyéb Amd platformszintű fejlesztéseknek köszönhetően laptop szinten alapból versenyképesebb lehet hiszen az OEM-eknek adhatják csomagban a Ryzen 7040-es APU-kal.

-

válasz

Yutani

#59290

üzenetére

Yutani

#59290

üzenetére

Többen írják hogy össze vissza ugrál a max órajel sajnos. COD ban van hogy 20 % eltérés van, ami jelentős Blenderben is és CP ben tapasztalnak ilyen dolgot, egyik indításnál 3200+ másiknál meg 2800 alig.

Állítólag nvidia is azért vette vissza amúgy driverben a CoD teljesítményét, nem a Dx12 implementáció az oka amit írt Abu, hanem a stabil működés.

Azt a játékot szerintem tesztelésre értelmetlen használni ebben az állapotában. -

PuMbA

titán

válasz

Yutani

#59290

üzenetére

Yutani

#59290

üzenetére

Vannak más érdekes eredmények is:

[link] "It's getting weirder. First it's running MW2 (1080p) at ~350 FPS with ~2900 MHz clocks. But an hour and a reboot or two later, it's doing ~300 FPS with t~2400 MHz. Same game, same test run, same settings. Now retesting the XTX, suddenly the same thing: +20% FPS out of nowhere."

Most pár hónapra el kell rakni ezt a kártyát, hogy kiderüljön, hogy mi van. Aztán lehet dönteni. Nem szabad ráugrani semmire, ami vadi új, bár ez minden PC hardverre vonatkozik, gyártótól függetlenül. Jól bevált 1 éves cuccokat venni a legjobb, olcsóbb és már megbízható.

-

Raggie

őstag

válasz

Yutani

#59277

üzenetére

Yutani

#59277

üzenetére

Igen ez így van, de még egy kb 80 W-al megtolva meg +11%-ot megy fel a teljesítmény(lásd az OC fület a linkelt tesztben) szóval ez kicsit fura nekem...

@Petykemano: egyébként a kommentek között már írták is, hogy az OC-nál kimaxolták a 3x8pin adta lehetőségeket, azaz 525W volt a kártya fogyasztása. -

Petykemano

veterán

válasz

Yutani

#59263

üzenetére

Yutani

#59263

üzenetére

Hát akkor ez nem valami ígéretes.

a TPU tesztben ha jól értem, akkor a fogyasztásnál az alap AIB kártya adatai szerepelnek

És azton túl van még egy Overclick tab, ahol rádobnak egy OC+UV-t,de ahhoz fogyasztási értéket már nem adnak meg. Mindenesetre úgy az előrelépés már szemmel látható.

Persze melyik kártyát nem lehet tuningolni.Szóval ez így kevés. De Jó döntés volt inkább az alacsony fogyasztásra menni, elengedi a felső 2-5% teljesítmény 100W-ért.

-

Petykemano

veterán

válasz

Yutani

#59236

üzenetére

Yutani

#59236

üzenetére

> El tudom képzelni, hogy az A1 szilícium

Én arra próbáltam célozni, hogy szerintem ez valami komolyabb hiba lehet, amihez legalább B-s stepping kell.

GeryFlash linkelte is, hogy Kepler szerint nem is július, hanem tavaly szeptember óta ismert hiányosság. Mindenesetre az N32 nem érintett. Ez alapján én várok javítást a többi lapkára is. (Úgy értem, hogy emiatt legalább már nem olyan, mint a Vega, van arra utaló jel, hogy nem hiábavaló a javításra várni)

Azt nem tudni, hogy a Phoenix és a N33 elrajtol-e A0-s szilíciummal. -

GeryFlash

veterán

válasz

Yutani

#59216

üzenetére

Yutani

#59216

üzenetére

Jaja, hasonlo szamok jottek ki akkor ott is. Ennyit az 50%-os perf/watt novekedesrol az RDNA2-hoz kepest. COD-nal lehet hogy megvan, cherry picking AMD modra. Tehat kamu volt a dia, es realisan ez a 15% perf/watt amennyire az Nvidiatol vannak. Marmint raszterben, ugye RT-ben meg sehol nincsenek, szoval ez a 15% is ugy jon ki hogy az Nvidiaban ott vannak meg az RT coreok is. Mivel az Nvidia ugyanugy TSMC 5nm-en vannak (csak ok elneveztek nagy ravaszan 4N-nek amit rendre a sok hulye oldal 4nm-nek hisz mikozben ez egy fantazianev es nem jobb node mint az AMD altal hasznalt), ezert ha hozzavesszuk az RT teljesitmenyt is akkor realisan 20-25%-kal jar elorebb architekturalisan az Nvidia az AMD elott.

FLATRONW #59152-es kommentje jol megfogalmazta, hogy az elozo generacioban miert volt olyan kozel az AMD. Most az Nvidia nem sporolt, meglatjuk az AMD-nek a chiplet miatt vajon mennyivel alacsonyabb a gyartaskoltsege.

-

Abu85

HÁZIGAZDA

válasz

Yutani

#59126

üzenetére

Yutani

#59126

üzenetére

Nálunk leginkább a Hitman 3-ban jött ki. Ott látszik, hogy Full HD-ben beleesik sok hardver a motor limitjébe, ami RT nélkül 290 fps körüli, míg RT-vel 190 fps környékén van. De 1440p-ben látszik, hogy a még mindig limites 69x0-en és 4080-on az új sorozat túlmegy. A másik, ahol ez látszik az a Horizon, bár ott kevésbé erős a limit, de 1080p-ben és 1440p-ben jelen van, amitől az RDNA 3 mentesül.

Elméletben a legjobb példa az új CoD MW2 és Warzone 2.0, mert ott tipikusan az a scenario van, amire konkrétan ezt a hardveres hátteret tervezte az AMD. A CoD-osok nagyon panaszkodtak a GPU-gyártóknak még a nyáron, hogy agyonoptimalizálták a motort ExecuteIndirenttel, de így sem tudtak kilépni a CPU-limitből. Az RDNA 3 pedig pont arra van tervezve, hogy ilyenkor léptesse ki a rendszert belőle. De nem láttam még erről tesztet, csak megjegyeztem, hogy ha valahol nagyon látványosan működnie kell, akkor az ez a játék. Ebben a címben nagyon-nagyon sok ismétlődő parancsköteg van, amiket szépen fel lehet venni az erre való pufferbe, és amikor látja a driver a parancslistában ugyanazt, akkor kidobja onnan, majd szól a hardveren belül az MDIA-nak, hogy a GPU-ban letárolt adatot töltse be újra. A többi hardver azért bukik ezen, mert nem tudja hol tárolni az előre felvett parancsokat, egyszerűen minden frame során újra meg kell csinálni. Az RDNA 3 addig csak töltöget, amíg a parancsok ismétlődnek. Tehát az első feldolgozás után minden további ismétlés ingyenes a CPU oldalán.

-

Petykemano

veterán

válasz

Yutani

#59111

üzenetére

Yutani

#59111

üzenetére

"Olyan semmilyen ez a generáció, hidegen hagy az egész launch, de legalábbis nagyon mérsékelten érdekel, hogy milyen."

Bocsánat, pontosítok.

Nem arra céloztam, hogy engem mennyire villanyoz fel. Én november 3-án az előadókon éreztem egyfajta rezignáltságot - hogy csak kötelességből állnak ki. De a mosoly nem őszinte, mert pontosan tudják, hogy bár hozták a kötelezőt (+50% perf/W a túlhajtott 6950X-hez képest), de nem ünnepelhetnek győzelmet. Nekem érzetre más hangulata volt annak az előadásnak, mint a Zen1 vagy Zen2, vagy akár Zen3, vagy RDNA2 esetén. -

S_x96x_S

addikt

válasz

Yutani

#59111

üzenetére

Yutani

#59111

üzenetére

> Azon gondolkodom, mennyire valós szcenárió, hogy

> egy 2-300 dolláros CPU mellett 1300 dolláros GPU dolgozik.legyél nagyvonalú ..

Az amazonon most 345 USD az AMD Ryzen™ 7 5800X3D with AMD 3D V-Cache™ Technology> de továbbra sem tudom értelmezni az XTX típusjelzést.

van benne memória .. és az néha nem árt ..

-

Abu85

HÁZIGAZDA

válasz

Yutani

#59094

üzenetére

Yutani

#59094

üzenetére

Semmi bizonyíték nincs rá. Volt pár hardveres bug megnevezve, például a nincs FMA dual-issue módban, de ezek egyszerűen működnek, és van FMA. Az is volt korábban, hogy mindössze tízezer Navi 31 lesz, oszt mára kiderült, hogy negyedmilliót szállít le még idén az AMD. Ne vegyétek komolyan a Twittert, mert bárki regisztrálhat, és írhat bármit.

#59095 Petykemano : Az RDNA 3-ban dual-issue van, nem co-issue. A kettő nem ugyanaz. A CDNA-nál ezeknek nincs különösebb haszna, mert ott vannak független dedikált feldolgozók és kész.

-

Petykemano

veterán

válasz

Yutani

#59092

üzenetére

Yutani

#59092

üzenetére

Érdekes kérdés.

Locuza számításai szerint a Navi31 esetén a GDDR6 és Infinity cache (=140mm2) nélkül kb 380mm2 lenne. Ha azt megszorzom 1.2-vel, ammennyivel több CU van a Navi31-ben, akkor 456mm2-re jönne ki. Tegyük fel, hogy a több regiszter, meg L1 cache, meg egyéb hóbelebanc is több helyet igényel, simán el tudom képzelni, hogy lehetne akár 550-600mm2-es lapka is.Persze rögtön adódik a kérdés, hogy, hogy ha Abu szerint N5-ön gyártani 7x drágább ($35k vagy $5k) akkor lehet, hogy ennyi erővel megérné inkább 2x akkora lapkát gyártani a 7x olcsóbb gyártástechnológán?

Elvileg az Info_os tokozási technológia bírná ezt a méretet.

Talán erre a válasz nem annyira az elérhető frekvenciában, hanem a tranzisztorok fogyasztásában keresendő.

Mindenesetre azt továbbra sem értem, hogy ha a Navi33 jellegében és paramétereiben a NAvi23-hoz lesz hasonló és N6-on fogkészülni, akkor az miképp lenne kisebb a Navi23-nál. Viszont erős a meggyőződés a 206mm2-es Navi33-ban

Én továbbra is azt sejtem, hogy ez valójában

- két lapka. Egy navi33, ami a navi23 örököse, 128bit, 2k shader, co-issue, N6, és ez a 300+mm2, valamint egy Navi 34, ami a navi24 örököse 64 bittel, stb, ami eleve N6-on készült, tehát nincs lapkaméret nyereség.

(- egy architektúra két különböző libraryvel készítve)Egyébként egy érdekes adalék - szintén nem tudom mennyire igaz - hogy míg a CDNA1-3 GFX9-re épült, tehát Vega származék, addig a CDNA4 már GFX11-re vagyis RDNA3 származék lesz. Abu ezt a kijelentést biztos meg fogja torpedózni, de a lényeg, hogy a CDNA4-ben szintén lesz co-issue. Állítólag.

Ha valami is igaz ebből, akkor lehet mondani, hogy ezért sikerült az RDNA3 ilyen "Vegásra", mert az is.

-

válasz

Yutani

#58940

üzenetére

Yutani

#58940

üzenetére

Ehhez kapcsolódóan találtam ezt az októberi hírt, miszerint készülhet az AMD egy 4/8 Ryzennel AM5 platformra:

AMD Ryzen 3 7300X CPU teased: 4 cores and 8 threads at up to 5.0GHz -

Csokissütis

kezdő

válasz

Yutani

#58935

üzenetére

Yutani

#58935

üzenetére

ha jól látom a graf csak 2022 első negyedévi adatokat dolgoz fel

a jelen más képet mutatMercury Research

AMD MARKETSHARE

Q3/2022 Q2/2022 Q3/2021

Desktop 13.9% 20.5% 17%

Notebook 15.7% 24.8% 22%

Server 17.5% 13.9% 10.2%

Total (inc. SoC & IoT) 28.5% 31.4% 32.4%https://prohardver.hu/tema/amd_cpu-k_jovoje_amit_tudni_velunk/hsz_8278-8278.html

-

Busterftw

nagyúr

válasz

Yutani

#58940

üzenetére

Yutani

#58940

üzenetére

Teljesen egyértelmű, hogy elengedték a dvga piacot.

Egyetértek, az utóbbi 1 évben lett bőven lett volna lehetőség több kapacitást lekötni, hiszen sorra mondta vissza mindenki a rendeléseket illetve kevesebb megrendelés volt.Az elmúlt években látható volt, hogy az AMD félgőzzel fejleszt ide és az erőforrások/kapacitások nagy részét szerverre költi.

-

Alogonomus

őstag

válasz

Yutani

#58937

üzenetére

Yutani

#58937

üzenetére

A "nekik az előző generáció is jó lesz" alapon az Intelnek sem kellett volna készítenie például 12100-at és 12300-at hiszen egy 11400 vagy 11500 van olyan erős, sőt az alaplap is olcsóbb a 11-es szériához, DDR5 lehetősége pedig nem előny egy 12100 esetében.

Az előző generációt valamennyire mindig a second-hand érzése lengi körül. Valószínűleg ahogy Petykemano írta, az AMD szinte állandóan kapacitáshiánnyal küzdött ez elmúlt 2-3 generáció során, és a szűkös gyártókapacitásból a maximumot szerették volna kihozni, ami a Ryzen 5/7/9 preferálását jelentette a Ryzen 3 kárára. -

Petykemano

veterán

válasz

Yutani

#58937

üzenetére

Yutani

#58937

üzenetére

Meg nagyjából beérte az apu az asztali procikat. A korábbi gyakorlat az volt, hogy az új asztali generáció indulásakor készült el az APU. A Cézanne elég versenyképes low-budget alternatívát kínált mintegy fél évvel az asztali procik rajtja után. 1 évvel később megjelent a sima 5600 is. Ezek most már nagyjából az 12100 árában vannak.

Én abban reménykedem (mint fan), hogy az AMD, aminek eddig mindig gondot jelentett elég nagy volumen beszerzése a legdrágább gyártástechnológiából, a chipletezéssel, ami lehetővé teszi, hogy részben vagy akár egészben egy-másfél gyártástechnológiai szintet lemaradjon, majd versenyképes tömegtermékeket fog tudni felmutatni.

-

Alogonomus

őstag

válasz

Yutani

#58932

üzenetére

Yutani

#58932

üzenetére

Zen 2-es időkben még kiadták a 3100, mert még bőven üldözői helyzetben voltak, ahogy az RDNA 2-ből is ugyanezért elkészült a 6400 és 6500.

CPU-k területén a mindshare a Zen 3 kapcsán fordult meg, és már nem is készült 5100, mert eladhatták a CCX-et magasabb árszinten, nagyobb haszonnal. Már nem kellett "kiszórniuk" az olcsóbb szegmensekben az elkészült chipeket. -

Petykemano

veterán

válasz

Yutani

#58930

üzenetére

Yutani

#58930

üzenetére

"Valahol talán Abu írta le, és igazolódni látszik, hogy az AMD nem akar az NV olcsó alternatívája lenni."

Ezt is többféleképpen lehet értelmezni.

Amíg az Nvidia mindshare olyan erős, amilyen, addig nem az ár dönt, mert a vásárlások többsége nem az alapján történik, hogy a vásárló objektíven mérlegeli a perf/$ vagy méginkább value/$ értékeket.

A marketing nyilvánvalóan a szubjektíve érzékelt/értékelt "value" értékre igyekszik hatást gyakorolni és amíg az Nvidia vélt vagy valós alapokon kiválóan magasan tartja az emberek "value" értékelését/érzékelését, addig az value/$ nevezőjében található árat mérhetetlenül kellene lefelé szállítani.>>> "Ha ingyen adnák se kéne, mert szar a driver"

Tehát az érthető, hogy miért nem kíván az AMD szimplán árral versenyezni.Ugyanakkor ha nem akar olcsó alternatíva lenni, akkor miért nem látjuk, hogy az AMD megpróbálná a királytermék kategóriát megszerezni valami gigantikus lapkával. Csinálhatott volna ő is 5-600mm2-es GCD-t + 10 MCD. AZ info_os bírja a méretet (2-2.5x reticle limit)

Ehelyett azt látjuk és ezt mintha mondták is volna, hogy területre optimalizáltak.

Vagyis hogy kicsi legyen és alacsony költséggel előállítható. Meg nagy mennyiségben persze.Nekem továbbra is az a gyanúm, hogy a piaci részesedés nem a DIY piacon dől el, ahol mit itt öljük egymást, hanem a OEM-eknél.

És eddig mindig úgy tűnt, hogy az AMD ha akarna se tudna akkora mennyiséget leszállítani, mint az Intel vagy az Nvidia.

Viszont a kicsi, alacsony költségek és nagy volumenben gyártható megközelítés lehet hogy épp ezt a versenyképességet célozza - csak nem ott és nem úgy, ahogy mi nézzük.Mit gondolsz?

-

Petykemano

veterán

válasz

Yutani

#58924

üzenetére

Yutani

#58924

üzenetére

Nem vitatkozva az elhangzottakkal annyit tennék hozzá, hogy

"Ja persze, miért vennének AMD-t, amikor ... " és számottevően nem is olcsóbb.

(Más kérdés, hogy az igazi fan számára ha meg olcsóbb lenne, azt mondaná, hogy "persze, mert annyival szarabb is")

Nem tudom mi az igazság.

Nem tudom, hogy igaz-e, hogy az AMD azért áraz-e úgy, ahogy, mert rájött, hogy ezek a "majd akkor veszek AMD-t, ha annyival olcsóbb lesz, hogy megérje, hogy kompenzálja a [...]-t" dumák valójában önáltatások, mert a [...] helyére végtelen mennyiségben lehet behelyettesíteni tételeket - fogyasztásról, driverről, tesszelációról, RT-ről, egyéb szoftveres feature-ökről - attól függően, hogy valaki érzelmileg mennyire elkötelezett.

Meg az is lehet, hogy ha az AMD verseng árakban, akkor azzal sok esetben magával húzza az Nvidiát is. (lásd RDNA1 + SUPER) és végül sosem lesz akkora gap, hogy az Nvidia felé elkötelezett vásárlót meggyőzze.PS:

Ilyenfajta elköteleződéstől természetesen az AMD rajongók sem mentesek. Szó sincs arról, hogy az AMD vásárlók / rajongók lennének a racionálisak és az Nvidia vásárlók / fanok pedig az elvakult őrültek. Én legalábbis nem így látom.Ennek ellenére én annyira elvakult vagyok, hogy nem is szoktam Nvidia kártyákat nézegetni. Valahogy nem. Nem gondolom, hogy szar, csak azt feltételezem, hogy piacvezetőként biztosan sosem lesz olyan kedvező ajánlata, ami az én árérzékenységemnek megfelelne.

Ennek ellenére viszont sosem esett nehezemre nemet mondani AMD ajánlatra sem, amit nem tartok a magam számára kedvezőnek, nem okoz nehezemre felróni az AMD-nek ha az árazási gyakorlata fogyasztó-ellenes vagy hogy (ha) nem ők csinálják a legjobb terméket.

-

Yany

addikt

válasz

Yutani

#58920

üzenetére

Yutani

#58920

üzenetére

A legnagyobb gond a magyar társadalommal, hogy binárisan gondolkodik és ennek sajnálatos oka is jól ismert. Hiába hoztam fel építő jelleggel, hogy szeritem(!) min kéne az AMD-nek még gyúrnia, hogy ne csak jelentős, hanem egyerangú szereplő legyen a piacon, rögtön támadásnak bélyegzett, ellenérzésekkel övezett és visszatámadásra késztető sorokká vált a hozzászólásom.

Valamiért a hozzád hasonló gondolkodásra nagyon kevesek képesek, és kvázi saját maguk ellenségeként nem a pénzükért legjobb terméket választják, hanem praktikai értékeket nélkülöző érvek mentén hoznak döntést. És ezt fel sem fogják, hanem üldözik a maguk meggyőzésére alkalmas gondolatokat is, hogy ne csorbuljon a világkép.

Nekem is most ugye 3090 lapul a gépben, de nem magas lóról beszélek lefelé, ténylegesen vágyom arra, hogy AMD vga felhasználóként elszenvedett csorbákat kiköszörülje a cég, hogy számomra is valós alternatíva legyen újra. Biztos vagyok benne, hogy az NVIDIA árnyékában szinte már nevetségesen olcsó AMD kártyák melletti meglepően erős piacvesztési trendet csak azzal lehet megállítani, ha az emberek könnyen meg tudnak őszintén bízni egy Radeonban és melós gépbe is szívesen teszik. És akkor nem olyan videóknak kell születnie a YT-on, hogy "Heló emberek, az AMD kártyája is k*rvajó ám!". (mondjuk szerintem az is segítene, ha a "forradalmi" újításokat nem sorra a konkurenciát másolva jelentené be, hanem a gamerek által vágyott, vagy vágyni vélt feature-ökkel ő lépne elő a színre előbb: pl. vrr, intelligens felskálázás, frame generation, stbstb).

-

Petykemano

veterán

válasz

Yutani

#58920

üzenetére

Yutani

#58920

üzenetére

"Fogalmam sincs, mit haluzol. Az AMD bejelentette, hogy..."

Valószínűleg arra gondol, hogy az AMD topikokban van pár ember (például engem is beleértve, de néha a >fórumon< Abu is szokott erőseket megfogalmazni), akik ábrándoznak, reménykednek, képzelődnek, találgatnak, hogy mi mindenre lehetne is akár képes az AMD - amivel át tudná venni az elsőséget itt vagy ott.

Bizonyára van pár másik gyanútlan, naív ember, akik ezeket az ábrándozásokat, reménykedéseket, szárnyaló képzeletet és találgatást, mint szak- és beavatott személyek jóslataiként értelmezik és minekután ezen reménykedések és ábrándozások az AMD képességei, a piaci verseny és az AMD pénzügyi céljainak háromszögének keretezésében jobbára nem válnak valósággá, míg ezen az ábrándozó gond nélkül továbblendül hozzáigazítva a gondolkodását a valósághoz, a ábrándoknak bedőlő gyanútlan és naív emberek becsapva érzik magukat.

Gondolom valami ilyesmiről lehet szó.

A dolog érdekessége csupán az, hogy ezekkel az ábrándokkal, reménykedésekkel (akár saját, akár valamilyen publikált anyag) ritkán megy át valaki a VS topikba hencegni. Ott kijózanítási céllal számonkérni jogos lenne. De az számomra is érthetetlen, hogy mi céllal megy be valaki a Depeche Mode buliba "A depeche mode szar" táblával a nyakában.

Nem vagyok 100%-ig biztos, mert nem szoktam közelről megfigyelni, de Nvidia találgatós topikban talán tényleg mintha kevesebb ábrándozás, reménykedés, szárnyaló képzelet és találgatás lenne. (Érdekes módon még az árazásra vonatkozó sincs, az Nvidia fanok még az Nvidia árak letörését is az AMD-től várják)

De egyrészt azért ott is elő-előfordulnak vakmerő kijelentések. Mitöbb, azok nem ritkán magától a cégtől származnak. Ez már legalább a második generáció, amikor az Nvidia olyan grafikonokat közöl, amiken a nagy szorzókhoz képest számottevően kisebb értékek mérhetők ki tényleges játékokban.

Persze még az is elég az elsőség megtartásához. -

#36531588

törölt tag

válasz

Yutani

#58916

üzenetére

Yutani

#58916

üzenetére

Jó amd fanboyként ezek szerint nektek tetszik az ilyen fals duma, mint a nem létező csúcs kari és társai. Raszterben ott van? Évekig ment a papolás a fogyasztásról, a zen4 -el meg megjelent a cikkben hogy csúcs cpu-nál mennyire nem számít.

Értem én, erre van igény. Bocs hogy zavartam.

-

Petykemano

veterán

válasz

Yutani

#58845

üzenetére

Yutani

#58845

üzenetére

Mivel abu nem erősítette meg, ezért picit elbizonytalanodtam ebben a respin történetben.

Persze még sokféleképpen kifuthat. Pl úgy is, hogy nincs respin és ez van. Vagy úgy is, hogy van respin, de azt nem forgatják be a 7900XT/X-nek, hanem majd kihozzák amikor megérkezik v-cache. Abu meg ír egy csodálatos marketing-cikket arról, hogy milyen költséges is az adatmozatás és mennyire jó is, ha minden ott tud lenni a cache-ben és az így felszabaduló TDP keretet rá lehet fordítani a GPU core frekvenciára. Ami persze igaz, de az előnyök és csak félig jönnek a megtakarított energiából. Másik részt a respin és persze azt is el lehet hallgatni, ha a v-cache haszna is csak 3+Ghz esetén igazán érezhető, mert 2.3Ghz esetén nem sávszél-limites. -

Petykemano

veterán

válasz

Yutani

#58610

üzenetére

Yutani

#58610

üzenetére

Hát igen, én ezért vagyok csalódott.

Ha ez a cucc (7900XTX néven) elérte volna a 4090-et, akkor egy komolyan vehető mélyütés lett volna az Nvidia számára.

Persze ahogy Abu mondta, a 4080-at így is meggyőzően fogja előzni és ahhoz képest igen versenyképes áron fogja az AMD kínálni. ($1000 vs $1200) Ez így egészen megsüvegelendőnek is tűnhetne.

Ha a 4080 nem lett volna valójában a nevében elődnek számító 3080-hoz képest egy 70%-os áremelés. ÉS ha így nézed, akkor az AMD talán egy kicsit nagyobb versenyképesség (a szokásos +5% teljesÍtmény -5% ár különbségnél nagyobb) felmutatásával de most is beáll a sorba. A burkolt áremelést a nevezéktan csúsztatásával hajtották végre. Sajnos a közönség már megszokta, hogy az Nvidia árat emel, de valószínűleg ha ezek a kártyák 7800XTX és 7800XT néven kerülnek forgalomba $899 és $999 áron akkor abból (a másfélszeres áremelésből) lett volna felhördölés.

Tehát a legjobb, amire lehet számítani az az, hogy az Nvidia leviszi a 4080 árát mondjuk $1000-ra. De ez a legtöbb.És akkor tudni véljük, hogy a respin mondjuk hoz +20% frekvenciát. Nem tudom, mennyi idő lehet, de mondjuk számoljunk 3-4 hónappal, hiszen biztos nem tegnap jöttek rá a hibára. Akkor vajon 3-4 hónap múlva az AMD elindít új kártyasorozatot az új lapkákkal $899 és $999-ért? Dehogy.

A respin lapkákat betolja ezek fölé (pl 7950XT és 7950XTX néven) és többet kér értük.Bár az meglehetősen fura lenne, ha a hibás lapkákat tovább gyártanák. Tehát még el tudnék képzelni valami hasonló megoldást, mint amit az Nvidia szokott csinálni, hogy ugyanazon név alatt több különböző lapkával szerelt terméket is árul a megfelelő képességekre levágva.

Ez alapján lehet, hogy a vágott respin lapka átveszi majd a $999-os 7900XTX helyét. Míg a 7900XT helyét pedig egy Navi32 fogja betölteni. (Vagy lesz egy 7850XTX )Nehéz megmondani, hogy pontosan mi lesz, de az biztosnak tűnik, hogy a gyorsabb respin verziókat ezek fölé és drágábban fogja hozni.

-

bitblueduck

senior tag

válasz

Yutani

#58600

üzenetére

Yutani

#58600

üzenetére

4080 és 4080 között nem feltételezel sebességkülönbséget, főleg nem 20%ot, mert ugyanaz a név. Eltér a memória mennyisége? Hát attól csak olcsóbb lesz, és elég nekem. Ezt gondolná az egyszeri felhasználó.

azért kíváncsi lennék hány százalék (ezrelék) az aki annyira ért PC-hez, hogy maga építi a gépet és 4080 16 vs 12GB között vacilál, de annyira már nem ért hozzá, hogy a többi különbségről is tudjon.

ugyanígy a XT vs XTX.egyszeri felhasználó amúgy is:

-laptopot vesz

-bemegy a mediamarktba, vagy valami boltba ahol vesz OEM-et vagy valaki összerakja neki

-amelyik nagyon felvilágosult már az tanácsot kér szakmai fórumon -

Busterftw

nagyúr

válasz

Yutani

#58593

üzenetére

Yutani

#58593

üzenetére

Jo de ez az user szempontjabol miert relevans?

A chipen kivul a dobozon levo informacio pontosan ugyanarra a specre vonatkozik mindket esetben.

Tehat az user levesz egy olcsobb 7900 dobozt a polcrol, a kulonbseg neki pontosan ugyanaz lesz mint a 4080 eseteben, kevesebb core count, kevesebb ram, kisebb bus, pedig aztan ugyanaz a 7900 van rairva.Itt te most azt hasonlitod, hogy a ketto kozott hany % az elteres, de a lenyeg ugyanaz mindket esetben. Nem a %-k szamitanak, hanem az alapfelvetes mindket esetben ugyanaz.

-

Busterftw

nagyúr

válasz

Yutani

#58579

üzenetére

Yutani

#58579

üzenetére

Oké ugyanaz a chip, de "RX 7900 XT and RX 7900 XTX are separated by core counts, memory capacity, bus width, clock speed, and Infinity Cache. That's because where the RX 7900 XTX utilises six MCD chiplets surrounding the central GCD die, the RX 7900 XT uses just five."

Hol a határ, hogy nem ugyanaz? Mi a spec?

Szerintem ez elég nagy differencia az AMD esetében is, miközben a" név" ugyanaz, hogy ugyanazt a konklúziót levonjuk. -

Abu85

HÁZIGAZDA

válasz

Yutani

#58147

üzenetére

Yutani

#58147

üzenetére

Eleve co-issue lesz az RDNA 3. Tehát órajelenként két FMA-t is megcsinál egy SIMD csoport, ami kétszer annyi, mint az RDNA 2-nél. Tehát innen eleve jön a much lover hit to FPS. Persze, hogy kevesebb lesz a zuhanás, ha az új dizájn kétszer gyorsabban tud számolni már egy órajelre levetítve is.

Elárulom, hogy az RT-nek az basz oda az RDNA 3-ban, hogy eleve co-issue a feldolgozás, tehát mindig van egy szabad ALU egy RT shadernek, amíg a hardver dolgozik valami másik feladaton. Az RDNA 2-nél konkurens feldolgozás volt, nem pedig párhuzamos. Emellett ehhez hozzá is lesz igazítva a regiszter az L0 és az L1 cache is. Fel lesz hizlalva a dizájn a gyorsítótárakkal. Tehát amellett, hogy párhuzamos lesz a feldolgozás, még lesz is elég wavefront. Ez a kulcsa ennek, mert a BVH bejárás valójában az RT számítások nagyjából 3-4%-át teszik ki. Sokkal jobban függ a maradék ~95%-től a sebesség. Viszont ezekben is szarok a mai hardverek, mert túlságosan wave-limitre kerülnek. Erre a megoldás a több erőforrás a több konkurens wave-hez, de még jobb megoldás a programkód szintjén történő változtatás, amire szintén hoz algoritmust az AMD. Erre az algoritmusra épül majd az új RTGI effekt, és a lényege ennek az, hogy a sebessége gyakorlatilag UE5-féle Lumen szintű lesz a mai hardvereken, miközben nem SDF-et használ, hanem AABB-t. Ezzel gyakorlatilag a jelenlegi AABB-s RTGI effekteknél 2-3x gyorsabb az AMD RTGI effektje, és csak attól, hogy az algoritmus gyorsítótáraz. És ez nem csak az új hardvereken látszik meg, hanem minden hardverek 2-3x gyorsabb.

-

válasz

Yutani

#58103

üzenetére

Yutani

#58103

üzenetére

7900 mindegyik, ezek szerint nagyjából hasonlóan magas árazásuk lesz de( tippre a magszám és sávszél alapján) 20% körüli eltérés lesz és - 4 GB köztük egy X betü eltéréssel? Ez fölé még jön egy 7950 is. Elég megtévesztő ez nem?

Mint a Zöldeknél 4080 nak hívni a 12 GB modellt . Persze nem tudom a valós teljesítmény különbséget. -

Alogonomus

őstag

válasz

Yutani

#58034

üzenetére

Yutani

#58034

üzenetére

Ahogy a 4090 fogyasztása abban a pár játékban jelentősen elmaradt a 450 wattól, ugyanúgy a Navi 31-es kártya fogyasztása is elmaradhat a 350 wattól. A 450 watt annak a 4090 FE kártyának az elméleti TBP korlátja, ahogy az állítólagos 350 watt is a Navi 31-es kártya elméleti TBP korlátja lenne. Azonos eredetű értékeket lehet csak érdemben összehasonlítani.

-

Petykemano

veterán

válasz

Yutani

#58026

üzenetére

Yutani

#58026

üzenetére

> ...ettől függetlenül a Nav31-et én is a 4090 köré várom...

> ...nem csodavárás volt, hanem józan gondolkodás...Szerintem most is az.

a TPU adatai alapján a 4090 vs 3090:

1080p: +20%

1440p: +35%

4K: +64%A TPU 5800X-szel tesztelt.

Vannak más teszteredmények is - SkyJuice kommentje alapján:RTX 4090 is just too powerful for CPUs!

4090 vs 3090 Ti

TechPowerUp 5800X:

1080p: 1.15x

1440p: 1.27x

2160p: 1.45x

TechSpot 5800X3D:

1080p: 1.28x

1440p: 1.45x

2160p: 1.59x

[link]Ezzel csak oda akarok kilyukadni, hogy 4K-ban úgy nagyjából 60-70%-os sikerült rápakolni az előző generációra.

Az AMD most fogja majd duplázni a feldolgozók kapacitását. Elnézést a pongyola megfogalmazásért - olyanokra gondolok, amiket itt már pár éve osztottam meg, VLIW2, meg ilyenek. Pont úgy, ahogy az Ampere esetén is volt, ennek majd akkor lesz látszatja, minél nagyobb a számítási igény. Tehát valószínűleg az előrelépés az NVidia előző két generációjához hasonlóan az előrelépés látványosabb lesz 4K-n, mint 1080p-n, ahol inkább majd a frekvencia számít. (Ennek megfelelően kifejezetten hasznos, ha a kisebb, alacsonyabb felbontásokra optimalizált kártyák magasabb frekvenciát érnek el)

Tehát az AMD által ígért +50% perf/W mutatót a csalódások elkerülése érdekében valószínűleg inkább a 4K valamint az RT vonatkozásában érdemes értelmezni.

Vegyük a TPU adatait: 4K-ban a 4090FE-hez képest a 6900XT 57%-ot tud.

Erre tegyük rá a 1.5x perf/W szorzót: 85.5%

És ha 300W helyett 350W-os TDP-t adnánk neki, akkor ha a 16%-kal nagyobb TDP keretet közel lineárisan nagyobb teljesítménnyel is tudja kitölteni, akkor hozzávetőleg megközelíti a 100%-ot.És hát ugye az volt a hipotézisünk, hogy a Navi31 valamivel jobb TDP keret és elfogadhatóbb kártya méret, alacsonyabb gyártási költségek mellett pár százalékkal veszít a 4090-hez képest. Ez a lehetőséget a fenti pongyola számítás megerősíti.

-

Devid_81

félisten

válasz

Yutani

#57982

üzenetére

Yutani

#57982

üzenetére

Itt epp betippetlem ket lehetoseget erre

Nagyon kivancsi vagyok ra melyik jon be ezek kozul.

Ha az AMD ilyen jo eroben lesz akkor minden remenyunk odavan az olcso kartyakra.

Ha az AMD ennyire lemarad akkor olcsobb lesz...de abbol megint csak az lesz, hogy megjobban lemarad a market share.

-

Petykemano

veterán

-

Busterftw

nagyúr

-

-

Aprósólyom

addikt

válasz

Yutani

#57834

üzenetére

Yutani

#57834

üzenetére

Most annyival azért másabb lehet a helyzet, hogy a használt piacra kikerülő bányász kártyák a mennyiség függvényében kihatással lehetnek az új kártyák keresletére/árára is.

Az lesz a kérdéses, hogy mekkora lesz ez a mennyiség. Talán az európai piacra nem annyira érintett a bányászattól. Mert itt korábban sem volt a legolcsóbb az áram... Legfeljebb csak a vilagpiaci árak alakulása révén. szvsz

-

Alogonomus

őstag

válasz

Yutani

#57834

üzenetére

Yutani

#57834

üzenetére

Ez így van. Majd akkor csökkent árat az AMD, ha rákényszerül. A 6x00 és 6x50 kártyák egyértelműen jobb ár/érték arányúak a boltokban, mint a 30x0 kártyák. Ezen felül az AMD kártyákból nincs hatalmas eladatlan raktárkészlet, és a még hatalmasabb használt bányászkártyatömeg nem jelent gondot, mert az új AMD kártyákat árulják olyan ár/érték szinten, mint a használt 30x0 bányászkártyákat.

-

Abu85

HÁZIGAZDA

válasz

Yutani

#57825

üzenetére

Yutani

#57825

üzenetére

Én annyit tudok, hogy a legkisebbet úgy tervezték, hogy a korábbi legnagyobb teljesítményét hozza. Ezt tudja is amúgy. De a legkisebb az eléggé picike, 128 bites busza van például. Egy mérnöki mintáról láttam már homályos képet, és kb. úgy néz ki, mint ez, csak fekete, és van benne pár vörös vonal. [link]

-

Abu85

HÁZIGAZDA

-

szmörlock007

aktív tag

válasz

Yutani

#57669

üzenetére

Yutani

#57669

üzenetére

Amd amúgy simán átvihetne pár dolgot (pl. laptop cpu-k) a Samsung 3nm-re, amúgy is együtt dolgoznak, hiszen ők adják a Samsungnak az igp-t a csúcstelefonokba. Emiatt gondolom alapból van információjuk az aktuális legfrissebb node-ról is. És akkor a kínzó gyártásbeli hiányt kb ki is ütnék.

-

-

Abu85

HÁZIGAZDA

válasz

Yutani

#57631

üzenetére

Yutani

#57631

üzenetére

Igen, bele van rakva egy rakás munka. A Valve előadásai nagyon jól mutatták ezt. Ők ugye kényszerűen AMD hardveren fejlesztettek, mert akkora kódmennyiséget az NV debug eszköze nem tudott kezelni. Szétfagyott az egész a picsába.

Itt van a dia, ami azt írja le, hogy miért az AMD fejlesztőeszközét használták:

Ezt az előadást láttam is, és Rich azt is hozzátette, hogy ha nincs a GPU PerfStudio 2, akkor sose lett volna OpenGL módja az említett két játéknak. Egyszerűen kivitelezhetetlen lett volna egy ekkora kódbázisra az egész, mert egyénileg kellett volna minden egyes függvényt ellenőrizni, hogy az hogyan fordul le xy hardverre, és ott pontosan mit csinál. Az pedig akár 5-6 évnyi munka is lett volna, és olyan időtávban felesleges dolgozni, mert mire ellenőrzik xy hardverre, addigra két-három generációval későbbi hardverek jönnek, amelyekre szintén ellenőrizni kell, vagyis ismét jöhet a munka, bár nem 5-6 évnyi, de folyamatosan patch-ek kellenének, amelyek az érkező hardvereket 1-2 év csúszással támogatják csak.Ezen túlmenően a szabványos kódjuk, meg se moccant az NV hardvereken. Egyszerűen sűrűn szétfagyott, illetve kaptak egy rakás stallt. Ezt úgy oldották meg, hogy a kódot mindig elküldték az NV-nek, amely cég egy új driverrel együtt visszaküldte a kívánt módosítást. Tehát nem csak egy másik kódút kellett, hanem egy specializált driver is, amit mindig használtak, mert ha nem, akkor a módosított kódút is szétfagyott a picsába, és a teljesítménye is kb. a tizede volt annak, amire szükség volt.

Alapvetően ezek voltak az OpenGL bajai, és évek óta ismertek, csak a Khronos egyszerűen nem fordított erőforrást a kijavításukra, mert feltettek mindent a Vulkan API-ra. Ezzel együtt pedig a Valve is befejezte az OpenGL mód supportját. A Vulkan mellett nem volt értelme.

Tehát amikor valaki OpenGL-re dolgozik egy igen nagy programot, akkor igazából gyártói segítség nélkül azt nem fogják összehozni. És a gyártók is egyedi kódokat javasolnak, gyártói kiterjesztésekkel, amit a Valve szintén említett, hogy használják is bőven, mert az ARB-vel sokkal lassabb a program. Ilyen szintű együttműködés ugyan megoldható, de végül lesz gyártónként két-három kódút, és specializált driverek, és a kódutakat úgy kell karbantartani, hogy új driver kell a módosításokhoz. Ma már ezzel nem éri meg foglalkozni. Az egyetlen működő OpenGL debugert sem fejleszti már az AMD. Persze a forráskódját kiadták, hogy aki szeretne dolgozni, az elmaszatolhat vele, de sokkal-sokkal könnyebb Vulkan API-ra váltani.

#57632 b. : Ami ugye Linux alatt megint úgy sikerült, hogy a Valve a saját programjaihoz módosította a meghajtót, vagyis ez sem szabványos teljesen.

A szabványhitelesítés lényegtelen OpenGL alatt, mert az a gond, hogy maga a dokumentáció nem fogalmaz egyértelműen, hogy mik a követelmények. Egy-egy dolog implementációjára több út is van, és a gyártók ezt ki is használják. Itt változott nagyon sokat a Vulkan. Amikor átvették a Mantle API-t, akkor vele átvették az AMD dokumentációját is, és az nagyon szigorúan fogalmazza meg, hogy mit hogyan lehet implementálni. Ezt a Vulkan vitte tovább, tehát alig van olyan tényező, hogy valamiben kérdés merülne fel. Ha van is, azt is nagyon gyorsan egyértelműsítik, hogy ne álljon be az a helyzet, ami az OpenGL-nél.

Az OpenGL dokumentációjával simán lehet olyan meghajtókat írni, amelyek mind átmennek a hitelesítésen, de eközben ugyanazokat a kódokat nem úgy értelmezik. És ez az API hibája, nem egyértelmű a specifikáció, és ezt a gyártók szándékosan félreértelmezik, hogy gyorsabb legyen a meghajtó, csak nem eszi meg a szabványos kódot.

Érdekes módon a workstation piacon mindenki tudja, hogy mi a szabványos és mi nem. Ott eléggé egységesen van kezelve minden, akármilyen gyártói drivert dobsz fel, megeszi a szabványos kódot. Tehát nem hülyék a gyártók sem, csak tetetik, hogy hülyék, mert csak az AMD hozza át a workstation meghajtóját Windows alatt a gaming driverbe. Ez változik meg a következő nagy batch-csel, de ezzel együtt már az AMD meghajtója sem lesz szabványos.#57633 Petykemano : Igen jól érted. Az új meghajtóval a régi játékok OpenGL módja problémás lehet, de mivel alig van OpenGL program, így nagyon egyszerű per alkalmazás szintjén leprofilozni az egészet, és akkor az új meghajtó problémáit célirányosan lekezelni úgy, hogy az AMD még a fordítás előtt kicseréli a programkódot egy olyanra, amit a nem szabványos meghajtó megeszik. Ezt csinálja az NV is. Csak ugye az ilyen modell megöli az API-t, mert így fejleszteni lehetetlen rá, lásd fentebb Valve.

-

válasz

Yutani

#57631

üzenetére

Yutani

#57631

üzenetére

Linux alatt amúgy egyáltalán nem rossz az AMD OGL futasa Nvidiához nézve,sőt.De ott nyílt forráskód ugye.Tehat szinte csak driveren mulik a sebesseg.Ott megoldjak a fuggetlen fejlesztők.

Igen valószínűleg ez van mögötte.Évek óta az első szabványhitelesítéseket pont az Nvidia szerzî meg,tehát annyira nem mennek ők szembe ezzel a dologgal se driveresen se fejlesztői eszközök terén. -

Petykemano

veterán

válasz

Yutani

#57607

üzenetére

Yutani

#57607

üzenetére

kemény.

Pedig a profitability tényleg nagyon alacsony.

[link]De hát ha még a jelenlegi energiaárak mellett is 1 font/nap, akkor a meglevő infrastruktúrát érdemes járatni.

Vagy a fene tudja. Lehet, hogy érdemes elgondolkodni, hogy a hardver amortizációja havi szinten több-e mint 30 font? Mert ha igen, akkor ugye ma többért el lehet még passzolni, mint 1 hónap múlva. (Ugye most egy 3090-ről beszélünk, ami pár hónap múlva jelentős árcsökkenésen mehet át) -

Devid_81

félisten

válasz

Yutani

#57607

üzenetére

Yutani

#57607

üzenetére

Gondolom boldog boldogtalan banyaszik (meg) hatha csurran cseppen, mar mindent bedobnak meg a Casio szamologepet is, hatha valahogy megis meglehet elni dolgozas helyett

![;]](//cdn.rios.hu/dl/s/v1.gif)

Ekozben a profitability meg az ETH arak mennek le, szoval halott ugy.Annyira "megeri banyaszni", hogy jelen UK villanyarak mellett majdnem 1 fontot termelne naponta egy db RTX 3090 jelenleg...teljesen kedvet kaptam hozza

Vegulis ha lenne 1000db RTX 3090-em akkor tok jol elhetnek

-

Petykemano

veterán

válasz

Yutani

#57604

üzenetére

Yutani

#57604

üzenetére

Elnézést. A kártya nem RX.

Gyanítom ez alapján, hogy valójában nem AMD által specifikált hivatalos termék.

(És nem Navi 23, hanem 22)Vélhetően arról lehet szó, hogy a sapphire megállapodott az AMD-vel, hogy a hibás példányokkal azt kezd, amit akar. Ebben a formában ez selejtszórás, semminthogy mesterséges szegmentáció lenne.

-

Senki9876

tag

-

Alogonomus

őstag

válasz

Yutani

#57580

üzenetére

Yutani

#57580

üzenetére

Meglévő AM4-es alaplap esetén ez a "nyamvadék" biztosan olcsóbb, mint egy extra Intel alaplap. Processzort pedig mindkét esetben venni kell. Szóval abban az esetben a kérdés úgy hangzik, hogy az Intel-es alaplap+processzor a drágább, vagy az AMD-s RX6300+processzor.

Új gép építése esetén sem sokkal kedvezőbb a helyzet, mert egy legalább B660-as (60e Ft) alaplap és 12x00-ás processzor párosa versenyez egy B550-es (30e Ft) alaplaphoz és 5x00-ás processzorhoz csapott RX6300-al. Sőt B450-es (20e FT) alaplapban is simán elmegy a Zen3-as processzor. -

Petykemano

veterán

válasz

Yutani

#57476

üzenetére

Yutani

#57476

üzenetére

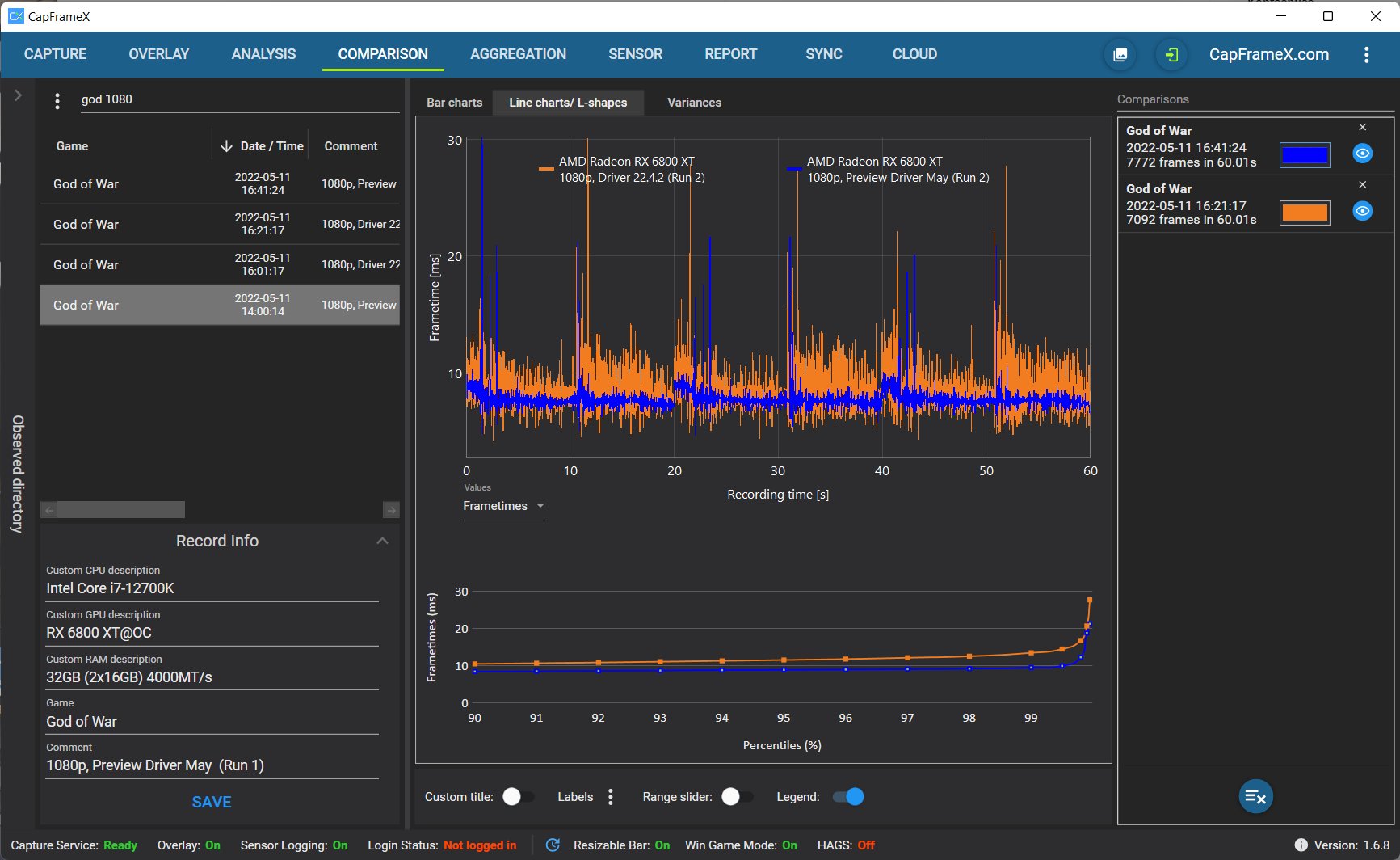

Crysis Remastered up to 24% faster

Assassin's Creed Odyssey Up to 34% better Lows.

God of War Up to 41% better P1

Azt a kisimultságot szerintem szeretni fogja a micro-lagre és stutteringre és más általam nem is ismert problémákra érzékeny közönség szeretni fogja.

Bár ez nagy eséllyel csak a DX11-es játékokban fog legalábbis ilyen mértékű javulást eredményezni, de ezúttal a wundertreiber jelző talán tényleg megilleti.

-

Petykemano

veterán

válasz

Yutani

#57445

üzenetére

Yutani

#57445

üzenetére

Egyetértek.

Annyit kellene csak módosítani, hogy a 64 bites GDDR6 vezérlőt lecserélik IFOP-ra és mondjuk +16MB IFC-re, hogy kevésbé szorítson a DDR cipő.Magas ár? $169-$199-ért ezzel a 107mm2-es lapkával szerelve egy egész kártyát kapsz hűtőstül, GDDR6 ramostul, PCB-vel együtt. MLID egyszer készített BOM listát a 6500XT-hez, az alapján maga a lapka legfeljebb $30 lehet. Tehát egy $200-300-os 5600X/5800X árán legfeljebb $100-t dobhatna.

Vajon a Chromebookokba szánt 180mm2-es Cézanne Barcelo nevű új steppingjének 2 magos (60-70%) illetve 4 magos (50-60%) vágott változataiért mennyit kaphatnak?

Ezzel együtt lehet, hogy tényleg niche piaci igény. a DIY persze önmagában piaci. Máskülönben meg szerintem leginkább azért, mert az OEM-ek nem szeretnék, ha nem ők válogathatnák meg, hogy milyen CPU-t milyen GPU-val párosítanak.

-

Petykemano

veterán

válasz

Yutani

#57442

üzenetére

Yutani

#57442

üzenetére

a Kaby Lake G-t én se.

De azóta azért eltelt pár év.

Az AMD kitalálta az infinity cache-t, amiből 16-32MB szükségtelenné teheti a nagyobb méretű IGP-k esetében a dedikált memóriát. Se interposer, se HBM nem szükséges.(Megkockáztatom, hogy a Kaby Lake G létrejöttéhez lehetett köze a később Intelhez távozott Raja-nak. Úgy értem, hogy egy semi-custom megrendelés leple alatti technológia / know-how transzfer volt)

-

GlitterJohan

csendes tag

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- BESZÁMÍTÁS! Gigabyte Z370M i5 9400F 16GB DDR4 512GB SSD RX 5700XT 8GB ZALMAN S2 TG Corsair S650W

- ÁRCSÖKKENTÉS Lenovo ThinkPad T570, T580, P51s, P52s eredeti Lenovo, belső akkumulátor eladó

- Bomba ár! Fujitsu LifeBook U757 - i3-7GEN I 16GB I 256SSD I 15,6" FHD I HDMI I Cam I W11 I Garancia!

- Akciós Windows 10 / 11 Pro OEM Licenc Kulcs 100% eredeti, jogtiszta!

- Telefon felváráslás!! Samsung Galaxy S22/Samsung Galaxy S22+/Samsung Galaxy S22 Ultra

Állásajánlatok

Cég: PC Trade Systems Kft.

Város: Szeged

Cég: Promenade Publishing House Kft.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)