- MWC 2025: A kicsi és a kamerás - megjött a Xiaomi 15 és az Ultra

- Milyen okostelefont vegyek?

- Telekom mobilszolgáltatások

- Samsung Galaxy S25 - végre van kicsi!

- MIUI / HyperOS topik

- Redmi Note 13 Pro 5G - nem százas, kétszázas!

- Samsung Galaxy A56 - megbízható középszerűség

- Samsung Galaxy S23 Ultra - non plus ultra

- iPhone topik

- Hat év támogatást csomagolt fém házba a OnePlus Nord 4

Hirdetés

-

Mobilarena

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Abu85

HÁZIGAZDA

Sajnos nem, nagyon rossz az eredmény, és iszonyatosan sok a panasz az API-ra. Ha jó eredményt adna, akkor launchra el tudnák készíteni a működő RT-t, de például nemrég a Star Wars Outlaws esetében a PT úgy lett implementálva, hogy hol működött, hol nem. És nem azért, mert így akarta az Ubisoft, hanem azért, mert nem látható a fejlesztő számára, hogy x helyen miért működik, y helyen pedig miért nem. És még ma is van olyan területe a játéknak, ahol valamiért nem működik a PT, annak ellenére sem, hogy aktiválod. Nem tudják, hogy miért, mert black box az egész. Azt tudják, hogy a saját pipeline-juk mikor jó és rossz, az követhető, de a PT külön pipeline-on megy, arra nincs ráhatásuk, és ha ezt összerakod, akkor elég szar dolog, hogy be tudsz építeni valamit, de nem tudod garantálni, hogy mindenhol aktív legyen, sőt, nem tudod, hogy ahol nem kapcsol be ott miért nem. Ez maga a rossz eredmény.

A Megalights az egy alternatív megközelítése annak. És pont azért tervezi magának az Epic, mert ők sem tudják garantálni azt, hogy az NV implementációja működjön, mert nem látnak a driver mögé, nem látják, hogy mi van a feketedobozban. Csak ugye erre nem mindenkinek van erőforrása, mert meg kell kerülni hozzá az API-nak azt a részét, ami a feketedobozt adja. Plusz, ha ezt megkerülöd, akkor az RT hardverek egy részét sem használhatod, mert nem ismered azt a formátumot, amit ezek a hardverek elfogadnak, tehát szoftveres módra kell váltani hozzá, vagyis az ALU-kat kell terhelni a hardverbe épített RT részegységek egy része helyett. Nem mind helyett persze, mert ütközésvizsgálatot gyorsíthatod, de a hardver egy részét elveszíted, és ha ezt elkezdik megkerülgetni, akkor felmerül az a kérdés, hogy mi a fenének vannak beépítve, ha végül nem használják a fejlesztők.

-

Abu85

HÁZIGAZDA

Az ezen semmit sem segít. A probléma az API, nem maga a hardver. Pontosabban az a gond, hogy az egész RT egy nagy black box még ma is.

Már az elején kapta ezért az ívet a Microsoft. Az egész sugárkövetés egy nagy feketedobozként valósul meg bennük. Vannak bizonyos funkciók, amelyeket a shaderekben meg lehet hívni, de ezek nagy része limitált lehetőségeket ad, és maguk az API specifikációk is rendkívül titkolózók az alkalmazott BVH adatstruktúra-formátumával kapcsolatban. Utóbbit nyilván nem is kell ismerni, mert a jelenlegi modell a Vulkan és a DirectX Raytracing esetében is annyiból áll, hogy a limitált lehetőségek szerint megírt kód alapján a driver majd csinál valami, fejlesztői oldalról láthatatlan "fekete mágiát", és ha jó az eredmény, akkor örülni kell. És itt ez pont annyira jó, amennyire rossz, mert felmerülhet a kérdés, hogy mi van akkor, ha nem túl jól muzsikál a megírt kód? Ez a bonyolultabb eset, ugyanis ilyenkor a végére kell járni annak, hogy hol a gond. Netán az alkalmazott gyorsítóstruktúra egyes limitációi erősödtek fel? Lehet, de mivel ez nem ellenőrizhető, így biztosra nem jelenthető ki. Elképzelhető, hogy a munka ütemezése kapcsán került homokszem a gépezetbe? Nem kizárható, de nem tudni, hogy mi az optimális egyensúly az erőforrás-kihasználásban, amire törekedni kellene a sugárkövetés használatakor. És ezeket a kérdéseket lehetne még folytatni, viszont egyértelmű válasz egyikre sincs, mert minden teljesítményt meghatározó döntés a futtatási környezeten vagy a meghajtón belül történik, gondosan elrejtve a fejlesztői szemek előle. És nem azért, mert ez így jó, hanem azért, mert ezt az implementációt követeli meg a Vulkan és a DirectX Raytracing API. Szóval a szabványos sugárkövetéssel kihozható valamilyen módon egy adott sebesség, akár úgy is, hogy a sugarakkal való kalkuláció virtuális távolságát korlátozzák, de érdemi előrelépést biztosító optimalizálásokra nincs lehetőség, mert a szabványos implementációk ezeket egyszerűen nem teszik lehetővé. És amíg ez nem változik meg, addig hozhatnak alá akármilyen hardvert, nem látják a fejlesztők, hogy miért lassú, amit írtak. Ha meg gyors, akkor örülnek, mert sajnos azt sem tudják, hogy miért gyors.

Tulajdonképpen a mostani módszer abból a szempontból brute force, hogy gyakorlatilag csak csinál valamit rejtve mélyen a driver mögött, és fingod sincs róla fejlesztőként, hogy amit éppen akarsz, azt gyorsan fogja megtenni vagy lassan. Nincs előre tervezhetősége a nagymértékű programozhatóság hiányában. Ez egy API probléma, bármilyen hardvert hozol rá, ha az API nem változik meg, a nagymértékű erőforrás-pazarlás megmarad.

-

X2N

őstag

Mi köze van az AMD-nek a gyenge RT-hez? A játékfejlesztő sara hogy nem úgy csinálta meg a játékot. Meg se jelent még az RDNA4 de te már tudod hogy nem kell visszafogni az RT komplexitást? Mégis milyen komplexitást? 70-es évek óta volt már erről szó, akkor is kevés volt rá a hardver, ma is az. Ilyen brute force megoldásokat erőltethetik tovább de nem fog menni 50 év múlva se.

Az egész RT ahogy ma van játékokban, csak trükközés nem is valódi RT, minden késik, zajos, nem számolja távolra a sugarakat, nincs elég iteráció stb. egy kalap sz.r az egész, ha tudod mit kell nézni...developer móddal a játékokban rendszerint ki lehet kapcsolni TAA-t, sharpeninget, Denoisert...

A fizetős cyberpunk RT shader mod-vel amit a youtubon mutogatnak is csak azért néz ki legjobban mert agyon van nyomorítva a DOF-al a kép és nem látsz tovább élesen 5 méternél tovább így ha közelre nézed az autókat pl nem rossz a látvány mert kb eddig van benne raytracing...leg látványosabb játék ami RT-s az továbbra is a Minecraft RT, másik kiemelkedő játék mellette a Control, ahol elég jók a tükröződések...de ott is kedvez a setting a raytracingnek...belső zárt tér, iroda, üvegablakok...a RT GI és az RT árnyákok már távolról se voltak olyan jók...Nem az nvidia csinálta meg a path tracinget. James Kajiya volt 1986-ban majd ezt is továbbfejlesztette(Monte Carlo method) 1997-ben Eric Veach és Leonidas J. Guibas.

Ennyire "új" a technológia. Felesleges itt az nvidiát sztárolni bármiért is.

Monte Carlo method féle RT/PT-t te a büdös életbe nem fogsz játékba látni. Ami a jelengeg Blenderben alapértelmezett Cycles render engine sem tud olyan pontosan szimulálni mert nem is az a cél, és már erre is kevés a jelenlegi csúcs hardver is. -

Komplikato

veterán

Na jó, de az NVidia RTXDI-val UE5-ben két tucat fényforrással egy RTX4090 is megmakkan, a Megalights techdemójában meg elvileg 1000 fényforrás volt.

Én nem akarok ezer fényforrást a játékokba, mert minek, csak nagyon kevés helyen lehet indokolt, de RT játékokban is jó esetben volt egy-két fényforrás, ehhez mért árnyékokkal vagy azzal se.

Ezért nézhetett ki sokkal jobban a PatchTracing a Cyberpunk 2077-ben, a szép részletes árnyékokkal, de milyen áron?

Nyilván erős kompromisszumokkal, de valami távolról hasonlót össze lehet hozni MegaLights-szal, csak félmilliós VGA nélkül. Azért ez is egy előrelépés. Mert az RT elleni jogos kritika volt, hogy HA kihasználnák a játékok, akkor egy RTX3060-at vagy RX6600-at kenhetne a hajára a kedves játékos. És ez igaz is volt.

Szóval jelenleg ebben látom a normális RT játékok eljövetelét. Tévedés jogát fenntartom. -

Komplikato

veterán

Ezért örülök az UE5.5-ben bemutatott MegaLights megoldásnak, mert a csak itt-ott megjelenő RT a játékokban lehetetlenné tette, hogy érdemben kihasználják a játékok az RT lehetőségeit, mert mennie kellett kenyérpirítón is mennie kellett. A MegaLights meg eleve csak RT vason fog menni. Viszont jó időre elássa a realtime PathTracing-et szerintem. Csak hát ugye minimum vagy 2 év, mire ezzel jönnek majd a játékok.

-

Abu85

HÁZIGAZDA

Igazából megoldható. Az AFMF2 egy szoftver, ami a játéktól csak végleges képkockát vár el. Tehát a képkockákat számolhatja a GeForce, az AFMF2-t pedig egy Radeon hozzá. Na most persze ez az elmélet, és elméletben működik is, de persze garanciát egyik gyártó sem fog vállalni kevert konfigra. Emellett ugye több játék esetében van olyan, hogy ha kevered a gyártót egy gépben, akkor nem feltétlenül engedi meg azt, hogy te válaszd meg azt az adaptert, ami fut a program, az esetek többségében hardcoded szinten Radeonra kényszerülsz.

-

S_x96x_S

addikt

> Már lassan nem dolgokat beszélünk meg

> hanem feltételes állításokon megy a vita, amikben a bekövetkezési valószínűsége 10%.nehéz megállapítani a konkrét valószínűségeket a való életben,

de azért 10% esély a végzetes golyóra - egy orosz rulett esetén

már olyan nagy esély - ami miatt én már aggódnék.És egy céges stratégiánál - fel kell készülni mindenre,

és forgatókönyvek kellenek arra az esetre is, hogyha az a 10%-nak becsült esemény bekövetkezne.A probléma, hogy sokan ( a döntéshozók közül is )

nem tudják értelmezni a valószínűségeket. ( lásd aug.20-i tűzijáték és az OMSZ esete. )de a konkrét kérdés: mire érted és mi alapján állítod a "10%." -ot ?

-

S_x96x_S

addikt

> Ugyanennyire nem értelmes a folytonos jövővárás és jövőbe tekintés,

> Most látjuk a tényeket és ez van.

> Nem kell tovább ragozni, mert senki se jövőbelátó.nem tudom, hogy mennyire van műszaki háttered,

de újabban már létezik olyan tantárgy a műszaki képzéseken,

hogy "technológiamenedzsment" / "stratégiai technológiamenedzsment"

És tekintsd úgy, hogy a jövőről mint "technológiai stratégiákról" beszélünk.Az hogy mennyire értelmes a "technológiai stratégiákról" értekezni,

arra nagyon jó (negatív) példa a NOKIA és újabban az Intel és a Boeing.

és talán a pozitiv példák közé tartozik - Steve Jobs - a víziójával.Engem speciel érdekel az ilyen stratégiai szemlélet,

mert fontos dolog és ide tartozik.> Beszéljünk a jelenről.

ez a találgatós ( amolyan stratégiai topik )

A jelenről nincs mit találgatni.

ráadásul minden leak - a jövőről szól. -

S_x96x_S

addikt

> "Én mindig a tényekkel értek egyet, tehát ami gépi tanulással megy, az AI. "

sokszor nem derül ki, hogy melyik irásod

- tény

- és melyik speckuláció

- és melyik szatíra.> "Hát igen. A PSSR a 100%-os AI használatával

> a jelenlegi állapotában nem veri a csak 5%-ban AI-t használó DLSS-t "ha még 3x leirod, akkor a fórum fele elhiszi

hogy ez a véleményed és nem tartod sokra a DLLS-t![;]](//cdn.rios.hu/dl/s/v1.gif)

-

S_x96x_S

addikt

> A probléma, hogy továbbra se tudható,

> hogy az FSR4-hez CPU-ba épített NPU fog-e kelleni,Szerintem van rá esély, hogy az AMD NPU-támogatást IS integrál az FSR4 technológiába, különösen a hordozható eszközöknél.

például Jack Huynh az IFA 2024-es interjúban a hordozható gaming-re fókuszált, és kiemelte az akkumulátor élettartam fontosságát, ami az NPU-k használatát indokolhatja, hiszen ezek kifejezetten hatékonyak AI-feladatok végrehajtásában, és csökkenthetik az energiafogyasztást.

"Jack Huynh: On the handheld side, my number one priority is battery life. If you look at the ASUS ROG Ally or the Lenovo Legion Go, it’s just that the battery life is not there. I need multiple hours. I need to play a Wukong for three hours, not 60 minutes. This is where frame generation and interpolation [come in], so this is the FSR4 that we're adding."

https://www.tomshardware.com/pc-components/gpus/amd-plans-for-fsr4-to-be-fully-ai-based-designed-to-improve-quality-and-maximize-power-efficiency> de ha igen, akkor az FSR4 ott halt meg a DLSS-sel szemben.

mobil Gaming-nél az NPU előnyös.

Ha az nVidia hasonlóan hatékony fogyasztást el tud érni

a mobil GPU DLSS-el mint amilyen az NPU,

akkor van esélye az NPU ellen. -

S_x96x_S

addikt

köszi;

akkor most már értem hogy te miért Abu-val értesz egyet és nem az nVidiával.

- mert hw fókusszal nézitek - és hogy az adott GPU a raszter mellett hány százalékban használja az AI-t. ( Mindenesetre majd Abu pontosítja.)

- de ilyen alapon nézzük akkor PSSR - se 100%. és az FSR4 se 100%

- és Abu valószínüleg alábecsüli - vagy teljesen mást ért AI-alatt.

---

Ellenben az nVidia - általánosságban beszélt a DLSS - AI-ról - mint módszertan,

amit a szuperkomputereken tréningeznek és optimalizálnak - egy-egy játékra.

---Azt már tudom, hogy Abu mit ért AI alatt,

- de TE mit értesz alatta? és jól érted-e hogy Abu mit ért alatta. -

S_x96x_S

addikt

Vagyis ha jól értelek - te konkrétan nem értesz egyet az nVidiával.

Amúgy én az AI-t módszertannak és algoritmusnak tartom.

( vagy még inkább módszertanok és algoritmusok gyüjtő fogalma)

emiatt egy CPU-val ( + "általános számoló egységgel" )

is lehet AI-s dolgokat csinálni ,

a dedikált hardware csak gyorsít rajta, de nem az teszi AI -vá a megoldást.> Abu írta, hogy kb. 5%-ban használ AI-t

kérek pontos linket és kontextust.

-------------

Persze léteznek már teljesen (100%) neurális hálón alapuló játékok,

( a sakkon és a go-n kivül is ) de ezek még nem gyakoriak1 héttel ezelőtti hír:

"Counter-Strike's Dust II runs purely within a neural network on an RTX 3090 — performance is disappointing at only 10 FPS"és a kutatás mögötte

"CSGO DIAMOND 💎 Diffusion World Model Demonstrations"

https://diamond-wm.github.io/

-

S_x96x_S

addikt

> a csak 5%-ban AI-t használó DLSS-t

AI -alatt mindenki mást ért ( hasonlóan mint a "smart" alatt )

emiatt bővebben is ki tudnád fejteni, hogy te itt - miért csak 5%-ra értékeled az AI használatát?-------

szerintem: a DLSS ( = Deep Learning Super Sampling) a mesterséges intelligencián (AI) alapul, mivel a mélytanulás (DL = Deep Learning ) az AI egyik részterülete,

amely mély neurális hálózatokat használ a mintafelismeréshez és az előrejelzésekhez.

És ezért a DLSS-t teljes mértékben AI technológiának tartom.https://developer.nvidia.com/rtx/dlss

"NVIDIA DLSS (Deep Learning Super Sampling) is a neural graphics technology that multiplies performance using AI to create entirely new frames, display higher resolution through image reconstruction, and improve the image quality of intensive ray-traced content—all while delivering best-in-class image quality and responsiveness."

- The AI network analyzes sequential frames and motion data to create additional high-quality, responsive frames.

- DLSS takes advantage of AI models that are continuously improved through ongoing training on NVIDIA supercomputers, providing better image quality and performance across more games and applications.

----- -

Abu85

HÁZIGAZDA

Mert az AMD másik node-ot használ, ami akkor még nem volt elérhető, amikor az NV már kísérleti gyártotta a sajátját. Kb. 3 hónap van a két tape-out között. Ezt ugyan le lehet szűkíteni a megjelenésig, de nem lehet eltüntetni. Ez a hátránya a modernebb node-nak. Az előnye pedig az, hogy modernebb.

-

S_x96x_S

addikt

> Ez is egy érdekes téma, hogy mi lesz az alsó kategóriával,

jó téma.

A megnevezés befolyásolja az előítéleteinket,

emiatt az IGP-t én nem is használnám az újabb chipekre,

mert mindenki alacsonyabb sebességre asszociál.Talán inkább SOC -os integráció illik jobban a jelenlegi trendre.

[ "Az egylapkás rendszer avagy angolul system on a chip vagy system on chip (rövidítve: SoC vagy SOC)" ]pl az Apple M ( CPU+GPU+NPU )

vagy PS5 PRO ( 16GB GDDR6 at 448GB/s ) -re

is furcsa lenne az IGP jelző.

És ezek már középkategóriás megoldások játékra.Az AMD talán emiatt is az "APU" fogalmat használja

és a legerősebb AMD APU: "AMD Instinct MI300A APU"

( ami persze a jövőben csak akkor lesz játékra is alkalmas, ha megkapja az UDNA -t.)De a nagy trend a monolitikus integráció,

és az hogy mindent 1 lapkába sűrítenek.

Emiatt a direct GPU-k alsó kategóriájának - teljesítmény határa folyamatosan egyre feljebb kerül.És a gazdasági racionalitás szerint ( ~ hosszú távon )

egy ugyanolyan teljesítményű SOC/APU olcsóbban kihozható,

mintha 2 külön rendszerben lenne. ( cpu + olcsó GPU )

Vannak kivételek - de azok is a szabályt erősítik. -

S_x96x_S

addikt

> Megérte dolgozni a 3.1-en, ha kb. senki se rakja bele a játékába.

Ezek nem azok?

https://community.amd.com/t5/gaming/amd-fsr-3-1-now-available-fsr-3-available-and-upcoming-in-60/ba-p/692000

És valószínüleg az FSR 4.0 -val átfedésben lesz,

https://prohardver.hu/hir/amd_fidelityfx_super_resolution_4_0_ai_jon.html -

KAMELOT

titán

Te játékfejlesztő vagy, hogy így vágod a FSR dolgokat?

Valami ilyet tudsz csinálni? Mr. Orákulum kicsit buherált!

-

huskydog17

addikt

Nem csoda, mert az XFX Merck 310-es a legszarabb custom design, rohadt hangos, ez a custom design kb. olyan, mint a zöldeknél a Gainward Ghost.

-

S_x96x_S

addikt

> Tehát drágább lesz, mint 4nm-en lett volna

legalábbis a gyártás ( ~ önköltség ); az ebből készülő termék nem biztos.

--------

Amúgy meglepő lenne,

hogyha fejlettebb gyártástechnológiát használna az AMD mint az nVidia.

úgyhogy egy kicsit még emésztem a hírt.Ha racionálisan nézem, akkor valami mobil ( Strix Halo - utód? ) lehet a fókusz.

-

Raymond

titán

A 7800XT most 479eur-nal indul, de a hetvegen volt 449-es akcio is es talan 439 is de abban nem vagyok mar biztos mert nem emlekszek ra pontosan. A 7700XT volt 389-ert de az szerintem nem igazan jo ajanlat most se (ahogy szinte soha nem is volt) mert alig dragabban akkor mar inkabb a 7800XT.

Szerk: Sot, amig van a MF-nal XFX Radeon RX 6800 SWFT 319 Core Gaming 389-ert raktaron addig a 7700XT-nel vegkepp nem sok ertelme van.

-

Devid_81

félisten

Ezzel nekem csak az a bajom, hogy RDNA2 meg most is kaphato itt ott, erre RDNA4 release elott par hettel/honappal vegre elkezdik csokkenteni az arat az RDNA 3-nak, eredetileg ennyinek kellett volna lennie ezeknek amikor kiadtak.

Mar regesregen sokkal olcsobbnak kellene legyen az osszesnek, hacsak nem akarnak 3 generaciot egy idoben arulni

Ez igaz a masik oldalra is, sott ott megjobban, mert ott aztan arcsokkentes nem igen szokott tortenni, inkabb kiadnak egy ujabb termekek ami "jobban megeri".

-

Komplikato

veterán

Az már nem a Lumen, hanem a Megalights.

![;]](//cdn.rios.hu/dl/s/v1.gif)

És pöttyet többet tudott, mint átlag játékban a sima RT, legalább is a kvázi végtelen fényforrás, meg azokhoz leszámolt árnyékot még a PathTracing-gel feljavított játékok sem tudtak, nem lassan, hanem sehogy sem. Ráadásul a realtime techdemót (persze kamuzhattak, de értelme mi lenne?) egy mezei PS5-ön prezentálták. -

S_x96x_S

addikt

> Ez hasonló, mint amikor tavaly rájöttek,

Ez szerintem több ...

ez cég szintű pontosan megfogalmazott stratégiai irányváltás.

" AI is going to be throughout our entire product portfolio."

Ha jól értem, akkor a cél. hogy minden még "Smartabb" legyen az AI-val.

és "mindenben is" legyen valamilyen AI képesség.

pl. BIG APU, de minimálisan egy NPU mindenütt.

Beleértve a:

- Threadrippert és az Epyc -et,

- a desktop procikat.( Am5 )

- valamint a laptop procikat.

Talán még a ZEN CPU magokba is jön.

(ahogy a RISC-V és az ARM procikban már kezd megjelenni.)Szerintem a CPU és a GPU a közeljövőben teljesen összeolvad ( #65915 )

és nem véletlen, hogy annó az nVidia nagyon meg akarta venni az ARM ( CPU )-s cégetA "buta" régi - "dodós" CPU és GPU-knak vége.

Ha már korszakváltás .... ,

akkor egyre biztosabb, hogy az "AR Smart glass" ( szemüvegek )

kinyírják a mobiltelefonok mostani formáját,

És valószínűleg a laptopokat és a notebookokat is.

( Persze csak rövid időre, amíg a NeuraLink típusú agy-gép kapcsolatok teljesen el nem terjednek ) -

hokuszpk

nagyúr

-

Abu85

HÁZIGAZDA

Csak mondom, hogy a PSSR egyelőre minden felskálázót leigáz. Van már róla egy fejlesztői anyag, és tényleg ez az első felskálázó, ami tartalomgenerálásban is AI-hoz nyúl. Ezért nem lesz hozzá mérhető minőség. Viszont ahhoz, hogy ezt megcsinálja nem is a GPU-n fut, hanem egy speciális hardveren. Erről annyit tudni, hogy a Sony specifikusan fejlesztette az AMD-vel, és nagyjából 350 TOPS tiszta teljesítményt ad ennek az eljárásnak. Azért tudnak tartalmat generálni AI-val, mert a DLSS-nek és az XeSS-nek nagyjából 30 TOPS áll erre rendelkezésre, amibe a tartalomgenerálás nem fér bele.

Szóval a PSSR-re végre tényleg rá lehet mondani, hogy AI felskálázó, mert tényleg AI-t használ tartalomgeneráláshoz, ezt semmi más nem tudja jelenleg.

-

Alogonomus

őstag

Azért a videó elején beígért 20 játékot felvonultató tesztet várd még meg a konklúzió levonása előtt, mert azt eddig is tudtuk, hogy a CP:2077 a zöldek hardveréhez készült a zöldek jelentős támogatása mellett. Az XTX a jelentős tartalékainak köszönhetően 4K-ban már a 4080 elé tudott kerülni, de a 1080p és 1440p még megvan a 4080-nak. Közben a 7900 XT már 4K-ban sem tud elég pluszt nyújtani a szembe szél leküzdéséhez.

-

Raggie

őstag

Azért tegyük hozzá, hogy a 4080 Super kevesebb FPS-t is csinál abból a kevesebb fogyasztásból.

4080S = 45 FPS átlag

7900XTX = 53 FPS átlag

Így már nem annyival jobb a perf/watt, mint amire csak a fogyasztási számok összehasonlítása alapján gondolna az ember.

Kb +40% fogyiért kb +20% sebesség.Nyilván így is jobb még a 4080S de nem annyival.

-

X2N

őstag

Ha annyi a biosban a limit akkor azt fel is vesz a kártya. Nem tudom ez neked mióta újdonság. Ellenállás moddolt 980Ti-k is képesek csúcsokban 650W-ot felvenni ha kiiktatod az áram limitet. Nekem 360W-os bios a gyári, ha aláfeszelek már 300W-ot se fogyaszt a kártya. Lehet limitálni a Total Board power-t Adrenalin-ban.

XTX kicsit jobb átlagba meg minimum fps-be is, sokkal folyamatosabb. De gondolom az mindegy

Totál természetvédő mód télleg 300+W-os kártyákkal gépelni egész nap

-

Devid_81

félisten

-

S_x96x_S

addikt

én egyre inkább meg vagyok győződve, hogy:

---------------

UDNA = CDNA + RDNA + XDNA [ mert XDNA nélkül mi értelme lenne? ]

Az RDNA4 kártyákon lesz XDNA(AIE2) -mert az UDNA-t elő kell készíteni, és emiatt tudja majd az FSR4-et.

A Strix Point az XDNA(AI2) miatt - képes lesz az FSR4 -re, még az RDNA3.5 mellett is.

Sajnos a Phoenix tulajoknak - nem lesz FSR4 támogatás. ( nekem ilyen van )A PS5 PRO-ban is lesz XDNA(AIE2).

És 2024-10-10 -kor jelenti be mindezt az AMD.

És elkezdték a munkát az FSR5 -el.

----------------

És azért szivárogtatnak -exclusíve- a TomsHW-nek, ( ~ Jack )

mert rájöttek hogy legalább egy média szövetséges nem árt a következő negyedévben. -

Abu85

HÁZIGAZDA

Igen, és ez a lényeg, hogy a mezei modderek meg tudják csinálni. Egyszerűen a CD Projekt béna, amióta a Cyberpunk megjelent csak a bénaságát bizonyítja a cég, mert rosszul működik a menedzsment.

A fejlesztőket nem kell kikerülni. Az AFMF2 célja az, hogy kb. minden játékban legyen képgenerálás. Ez sosem volt célja az FSR 3-nak, mert nem lehet vele elérni. Az AFMF2-vel el lehet. Ettől még továbbra is az a fő szempont, hogy a játékokba legyen ez építve. De mivel látványos, hogy ezt nem lehet mindenkivel megoldani, így csináltak rá egy alternatívát. Az NV és az Intel is dolgozik hasonlón, csak nem olyan egyszerű ezt kivitelezni. Az NV-nél az OFA részegység miatt, az Intel pedig egy másféle képgenerálást képzelt el, ami funkcionálisan nem úgy működik, ahogy az AMD és az NV képgenerálása. Na most általában egy ilyen projekt fut a cégeken belül, és az AMD megoldása elég rugalmas annyira, hogy gyorsan be lehessen építeni driverbe. Az NV és az Intel megoldása nagyon nem rugalmas ilyen szempontból. Tehát vagy próbálják átszabni, ami idő, vagy lemásolják az AMD megoldását, és implementálják azt. Mindkettő járható út. Időben egyébként nem kizárt, hogy gyorsabban meglennének, ha az AMD megoldását másolnák le, mert azt pont a rugalmassága teszi ütőképessé, kvázi bárhól alkalmazhatóvá.

Az Anti-lag 2 nagyon nem különbözik az Anti-lag+-tól. Annyi az eltérés, hogy a játék hívja meg a driverrutinokat, nem pedig a meghajtóban egy profil. Például a Reflex ennél sokkal másabb, mert ott nem a driverben vannak ezek a rutinok, hanem a játékban. Most ez működésben nem sok eltérést jelent, maximum annyit, hogy sokkal kevesebb kódsort kell beírni az Anti-lag 2-höz, mert a kód nagy részét a driver tartalmazza.

-

Abu85

HÁZIGAZDA

Hiába mész oda, ha a menedzsment elküld. A Cyberpunk azért indult szarul, és azért tartott hónapokig mire játszható lett, mert a menedzsment okosabbnak képzelte magát a programozóknál, akik anno még ott dolgoztak, majd idővel kiléptek. Aztán rájöttek, hogy mekkora hülyék voltak, és elkezdték rendbe rakni a játékot.

Nagyon masszív hibák maradtak a Cyberpunkban emiatt, amiket már sosem fognak javítani, mert túl sok költség lenne, és évekkel korábban hozott rossz döntéseket nyögik vele. Ezért vannak tök jó modok a Nexusmodson, amelyek grafikai degradáció nélkül gyorsítják a játékot +30-60%-kal. Ugye a moddereknek nincs szerződése arra, hogy az xy effekt lassan fusson, ők nyugodtan dönthetnek úgy, hogy begyorsítják az effekteket, mert a lassú futást főleg rossz paraméterezéssel érik el. Ugyanígy ki szokták cserélni a modderek a rosszul implementált beépülőket is.

AFMF 2 azért létezik, mert az AMD-nek ezt egyszerű megcsinálni, mert olyan utat választottak a képgeneráláshoz, amely rugalmas, programozható, magas kompatibilitású. Az NVIDIA-nak azért nincs ilyen, mert más, egyáltalán nem rugalmas utat választottak a képgeneráláshoz, így nekik nagyon nehéz ilyet csinálni driverben. Az NV szimplán csak meghívja a hardverben lévő OFA-t ehhez a feladathoz, de ha az rossz képet generál, akkor nem tudnak mit tenni, mert nem tudják kicserélni a hardvert neked a webről. Ezeket programszinten lehet korrigálni, hogy a hardver problémáihoz igazodj, de driverben minden egyes játékra kellene egy specifikus kód, hogy működjön. Ez vállalhatatlan erőforrásigényt jelent a dolgozók terhelését tekintve. Ezért jobb a szoftveres megoldás, mert ha abban van hiba, akkor kicseréled a szoftvert.

Anti-lag pedig azért került anno a driverbe, mert az AMD megvette a HiAlgo nevű céget, és onnan hozzájutottak a Chillhez. Az Anti-lag gyakorlatilag a Chill másképp paraméterezett verziója. Az NVIDIA-nak ez azért nincs driverben, mert egy Chillhez hasonló rendszert nagyon-nagyon nehéz csinálni. Egyébként ilyenen dolgoztak egészen az előző év végéig, amikor lelőtték a projektet. Egyszerűen túl sok pénzbe kerülne, és túl nagy macera az egész. Egyszerűbb és olcsóbb, ha a fejlesztők implementálgatják a Reflexet. Az AMD is így csinálja az Anti-lag 2-vel. Bár a működési mód azért némileg eltér, mert az Anti-lag 2 még most is driverfunkciókat hívogat, de ez mindegy, mert tök nyolc, hogy az adott funkció programoldalban vagy driverben van implementálva.

-

Abu85

HÁZIGAZDA

Miért az adott eljárás hibája, hogy a fejlesztő nem a 3.0.4-es verziót implementálja, hanem a korábbit, amiben volt egy bug? Javították már, és használható a 3.0.4-es. Semmi gond nem lenne abból, nagyjából két és fél óra újrafordítani a programot. A régi FSR-t is el lehetne hagyni. Sőt, akár az FSR 3.1-et is lehetne használni, az nagyjából egy napos munka lenne.

Ez a CD Projekt sara, és kizárólag őket érinti, máshol ilyen jellegű fejlesztői atombénázást nem is látsz, hogy egy eljárásból két verzió is ott van, mert ugye hülyeség két kódutat karbantartani, ha azok ugyanazt csinálják. Valószínűleg nem is technikai a gond, hanem szerződés eredetű. Ezért nem szoktak a fejlesztők kurvának állni, mert csak magukat szopatják meg vele, ahogy a CD Projekt teszi éppen.

A nyílt forráskód egyébként azon segít, hogy a hibákat magad is javíthasd. Nem kell hónapokig várni arra, akié a kód. Ugye pont emiatt lett gyárilag a DirectSR része az FSR, míg a többi eljárás nem.

-

Abu85

HÁZIGAZDA

-

Abu85

HÁZIGAZDA

Mielőtt nagyon belemennénk ebbe. A PS5 Pro konzolban nem RDNA 4 lesz. Valójában ugyanaz az egyedi RDNA lesz, mint a PS5-ben, csak az egyes részegységek lesznek lecserélve. Például a teljes textúrázóblokk. Onnan van az RT-ben is a változás. Ezért van az, hogy némelyik RDNA 3-ban bevezetett, alapvetően RT-re irányuló képesség hiányzik a PS5 Pro konzolból.

Annyi a lényeg itt, hogy az AMD nem készített külön hardvert a Sony-nak, hanem megkapták az érkező generáció textúrázóblokkját. De mást nem igazán. A Sony erősebb lehetett volna az RDNA 4-gyel, de fontos volt, hogy megőrizzék a visszafelé kompatibilitást. És ugye az RDNA 2-3 között sok volt a változás.

Meg ami még fontos, hogy a PS5-nek az RT API-ja úgy fényévekkel fejlettebb, mint a DXR. Tehát a hozzá szabott hardver sem igazán olyan, mint ami a DXR aktuális verziójához jó. Persze nyilván a jövő mindenképpen a programozhatóságé, tehát ez innentől még hasznos is a PC-s dizájnnak, elvégre idővel a DXR is programozható lesz a bejárás szintjén. Az RDNA 4-et valószínűleg erre elkezdték felkészíteni, már az RDNA 3-at is a dual-issue képességgel.

-

Raymond

titán

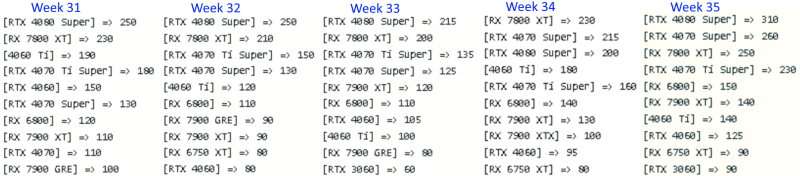

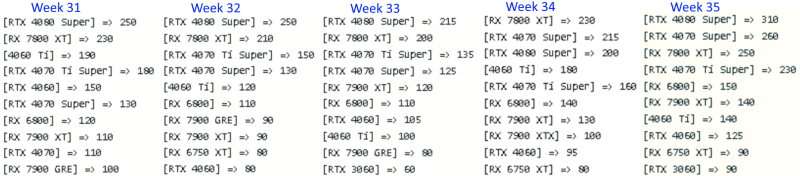

Hosszabb szuntet utan megjelentek az MF listak megint, igy nez ki az utobbi 5 heti top 10:

Ha az MAD fellegvaraban igy neznek ki az eladasok abbol nem lesz piacszerzes hiaba a $600 alatti termekek, mert egyertelmuen nem mindegy az embereknek hogy milyen a feature set annal a termeknel amit vesznek.

-

S_x96x_S

addikt

> hogy market share-t akarnak növelni

> és nem világmegváltó ötletekre pazarolni a pénzt, amik sokszor nem jönnek be,a világmegváltó ötletek sincsenek kihúzva, csak hátrébb vannak sorolva.

Az RDNA5 -ön is dolgoznak,

és az lehet a "One day, we may." momentum.Valamint a 128GB-os egyesített memóriás "Strix HALO"

is egyrészt a top fejlesztőket célozza meg. (WorkStation Notebook)

És ha egy részükben mobil nVidia chip is lesz,

akkor minden fejlesztő nyáltermelése elindul egy ilyen gép iránt.

[ ZEN5(AVX512) + RDNA3.5(128GB) + CUDA ] -

PuMbA

titán

Ebből a nagy irányváltásból látszik, hogy az AMD-nél keményen megszenvedték az RDNA3-at és nem akarnak többé ilyen sorsra kerülni. És jó volt anno a tippem a kártya megjelenése után nem sokkal, hogy ez nem lesz egy fényes generáció és erősen nem lett az. Emiatt erre a megvágott és költségcsökkentett generációra kényszerült az AMD, ami természetesen tök jól is elsülhet, ahogy írtam előbb

paprobert: "A csúcs Battlemage is hasonló osztályba érkezik, vagyis ha igaz Hyunh terve, akkor nagy öldöklés fogja kezdetét venni az Intel és az AMD között."

Fincsi lesz és sokkal jobb, mint ez a mostani befagyott állások

-

Na igen,de most sem látszik hogy az RDNA3 annyival jobb áron lenne mint az Nvidia Ada, hiába csücsül ott a trónon 30 % előnnyel egy 4090. Azt az Nvidia ha akarja kiárulja az RTX professzionális kártyaként.

AZ persze evidens hogy a középkategóriában jó áron hoznak kártyát és ezt mint stratégia előadja és a fejlesztők ettől hanyatt esnek szerinte, de a többit ez nem magyarázza meg.A valós lényege a dolgonak amit nem mond ki, csak áthallásból hogy mennyire fontos nekik az adatközpont, hogy a professzionális szegmens kifizetődöbb és erre akarják áldozni a gyártókapacitást, lásd MI300, mint hogy versenyezzenek a csúcson az Nvidiával

Ahhoza Radeon pro vonalnak átjárhatónak kell lennie a Csúscs RX szériával és szoftveresen olyat kell adnia amiért elkérhetnek 3-4-5000 $-t. AZ Nvidia ezt ügyesen felépítette. Ugyanis ha nem megy el 4090 nek majd elmegy RTX4000 nek, ha meg elmegy 4090 nek azon is nyernek mert drága.

Ezért ha átnézed az utóbbi idők híreit, szoftveresen elmaradtak és erre helyeznek hangsúlyt stb rájöhetsz hogy a Zöldek RTX professzionális kártyái ,a studio, professzionális szegmens , a HPC, mellé a szotfverek,a CUDA , a Studio driver és RTX geforce vonal a totálisan összefügg és üzletileg egy baromira jól felépített rendszer , ami átjárható. Az adatközpontok pedig egy teljesen külön vonal. -

Felvázolta azt a stratégiát amit eddig megcsináltak több gereráción és 2 konzolgeneráción át és nem hozott fordulatot. EZ már volt a vega 56-64, RX 480, RX 5700 stb...A z RDNA2 volt jól a csúcson és nem hinném, hogy veszteségesebb volt mint bármelyik..

de amúgy remélem bejön nekik és jó kártyákat hoznak jó áron de az Ada például nem igaztán drágább mint az RDNA3 . -

PuMbA

titán

Az AMD gyepálásom azt hiszem beérett, többet nem kell gyepálni őket

Először jött a hír pár hónapja, hogy jobban ráfekeszenek a szoftverre és nem csak a hardverre koncentrálnak, aztán most ez a hír, hogy market share-t akarnak növelni és nem világmegváltó ötletekre pazarolni a pénzt, amik sokszor nem jönnek be, mint például Vega HBCC vagy chiplet GPU. Levonták a helyes konklúziókat az utóbbi évekből.

Először jött a hír pár hónapja, hogy jobban ráfekeszenek a szoftverre és nem csak a hardverre koncentrálnak, aztán most ez a hír, hogy market share-t akarnak növelni és nem világmegváltó ötletekre pazarolni a pénzt, amik sokszor nem jönnek be, mint például Vega HBCC vagy chiplet GPU. Levonták a helyes konklúziókat az utóbbi évekből. -

Abu85

HÁZIGAZDA

Abból biztos nem tudjuk meg, mert a Sony egyedi dizájnt kap, ahogy mindig.

Értsétek meg, hogy a PC-s dizájnok különböznek. Van bennük nem kevés eltérés. Az mindegy, hogy a média összemossa a konzollal őket, valójában nem olyanok a mostani konzolok sem, amilyen az RNDA 2. Főleg a Sony verziója alkalmaz érdekes eltéréseket, például ID buffer, stb.

Meg azért az nagy kérdés, hogy a dual-issue feldolgozást mennyire jó egy olyan konzolcsaládra elhozni, ahol az alap konzol ezt nem támogatja. Ezt biztos csak limitekkel engednék, mert sok parát okozhat egy ekkora eltérés az ALU-knál. A DGF szintén kérdés, bár az kisebb, ott azért az elfogad bármilyen geometriát.

-

S_x96x_S

addikt

> Törvények és szerződések értelmezésénél is az van, hogy ami le van írva, úgy

> értelmezzük.azért ez bonyolultabb:

"Alapvető interpretációs elvnek számít: a jogszabályt a maga egészében kell értelmezni, nem pedig annak egyes részeit kiragadva;[6] a törvény betű szerinti követése gyakorta a törvény kijátszásához vezet; [7] ennek során a törvényhozó akaratát kell szem előtt tartani;[8] ennek kétséges volta esetén pedig az enyhébb megoldást kell preferálni.[9]" ( forrás )> Mivel nem volt odaírva, hogy mobil, ezért nem mobil. Kész.

Logikailag ez így nem helyes.

Mivel nem volt odairava, hogy [mobil vagy desktop]

emiatt a szövegösszefüggés számít - mint a jogban.És nem csak a jogszabályt, hanem az akkori beszélgetést is

"a maga egészében kell értelmezni, nem pedig annak egyes részeit kiragadva;" -

mozesapo

tag

Ha neked ez a jövő, hajrá. Kezd a hülyeség begyűrűzni teljesen a pc piacra. [link]

Nyomják itt a dlss-t, fg-t, stb.... Konzolon még azt mondom ok, de pc-n ha van egy 2k, 4k monitorom akkor dolgozzon is meg a gpu és natív képet kapjak, mindenféle felskálázás, meg egyéb nélkül. Nvidia a vérpistikéknek gyárt - figyú 4k rt 500 fps bebebe, közben meg 720p-1080p-ből skáláz fel, meg frame gen, stb... Jól át vagytok verve. Régen a puszta teljesítmény számított, sajnos most már nem. De pár éve minden gen váltásnál az ár kétszeres, közben natív teljesítményben nem tudja a kétszerest. Hagyjuk már. Ennyire nem lehet debil az egész világ. -

X2N

őstag

Helyes, legyen erősebb az RT. Engem aztán nem érdekel, akkor se ha kiadják 500usd-ért és olyan erős lesz mint a jelenlegi kártyám. win-win az AMD-nek és a vásárlóknak is. Neked a vesszőparipád lett a Wukong, mióta lett az etalon? Még csak nem is egy open world belső nézetes játék ahol közel tudsz menni a karakterekhez és megnézheted még a ráncaikat mint a CP2077-nél...pont ezért nem kellenek 4K-s textúrák mindenhova mert nem tudsz közelről nézni semmit a kamera miatt...így nincs annyi memória igénye...(ettől függetlenül érdekelne hogy miért is foglal ~130GB-ot a játék)a Stalker 2 baromira nem ilyen lesz azt már most megmondom.

-

T.Peter

őstag

Amig a konzolok 10/16GB-osak, nem kell attol tartani hogy pc-n elszallna a vram igeny, viszont jo lenne ha 16 lenne a minimum pc-n es 24-32 a kozep/felso hatar, mert igy az eletben nem szabadulunk meg az 1k-2k texturaktol. A konzolokba meg minimum 32 kene, de inkabb 64 osszesen, hogy ertelmes ugras legyen legkozelebb.

-

Abu85

HÁZIGAZDA

PS5-re nincs AGS. Ott saját API van.

Az AGS PC-n van, és az elsődlegesen a precizítást vezérli. Az FSR számítási precizítása több mód között változtatható. Az AGS lehetővé teszi a packed math módot, azokra a hardverekre, amik ezt támogatják. PS5-ön ez létezik, csak nem használt.

-

hahakocka

őstag

Azért a 3 ventiset szokták inkább vinni (ha választani kell ahogy láttam) biztos, ami biztos alapon egy ekkora méretű s fogyasztású vga esetén, hogy sokáig biztos jó legyen, ne legyen baj. Én el is adom mindig a teljes gépet pl. 4-5 év után a vga-val együtt, nem akarom bármi bekrepáljon. (S eddig a 5 gépből csakis 1 nél volt az Asus lehagyjuk a vram hűtést effektus

) . A két kártya azért nagyon más! Egyik főleg RT használatra a másik meg a még ma is általánosabb használatú raszterre, natívra jobb. Ki mire használná a kártyáját inkább csak attól függ. Nem lehet egy az egyben beállítani hogy egálra jön ki emiatt szerintem. Attól függ ki mire használná jobban. Meg hogy pl kedveli e a DLSS-FSR használatát vagy sem. Hisz RT-nél kötelező kb. De akkor már az esetleges artifaktok ghostingolás is bejátszhat, amit írnak most az NV topikban és sok más külföldi fórumon amúgy a használók. De ez már a játékfejlesztők sara is akár. Ki hogy implementálja végül az adott sokféle enginebe. Ezért mondtam hogy nem értem miért mondják AMD rajongónak a HWU t most pl jól odaszólt nekik is, régebben Intelnek, NV nek akinek épp szükséges a marketingjük miatt ami besül épp. Bár most azért várjuk meg a windows patchet ki tudja.

) . A két kártya azért nagyon más! Egyik főleg RT használatra a másik meg a még ma is általánosabb használatú raszterre, natívra jobb. Ki mire használná a kártyáját inkább csak attól függ. Nem lehet egy az egyben beállítani hogy egálra jön ki emiatt szerintem. Attól függ ki mire használná jobban. Meg hogy pl kedveli e a DLSS-FSR használatát vagy sem. Hisz RT-nél kötelező kb. De akkor már az esetleges artifaktok ghostingolás is bejátszhat, amit írnak most az NV topikban és sok más külföldi fórumon amúgy a használók. De ez már a játékfejlesztők sara is akár. Ki hogy implementálja végül az adott sokféle enginebe. Ezért mondtam hogy nem értem miért mondják AMD rajongónak a HWU t most pl jól odaszólt nekik is, régebben Intelnek, NV nek akinek épp szükséges a marketingjük miatt ami besül épp. Bár most azért várjuk meg a windows patchet ki tudja. -

hahakocka

őstag

Ja de kevesebb rammal ami miatt olcsóbb is. Azért spórolja le.GDDRX igaz drágább is de kevesebb mennyiséggel.

208e (7800xt) vs 241e. (RTX 4070) Azért van difi a 3 ventis kiadások esetén pl Úgy hogy picivel gyorsabb raszterben, több vram de gyengébb RT. Azért mondom itt az RT t fizeti meg a vásárló. Amit meg látjuk mostanság hogy optimalizálnak lassan 720p ről kell felfelé skálázni hogy ne 20 fps legyen 1440p-4K ban.

ABU mint igazi szakértő cikkíró , tesztelő : Szerinted is a 16gb vram ma az optimális ala TPU teszt vége? -

hahakocka

őstag

Na ezt nem tudtam látod 5.1 el van csak. De fura hogy 5.0 al ment csak a Black Myth akkor jó régóta fejleszthették már. De most már 5.2 is van nem? Ha jól emlékszem? Az újabb UE5 gamek fejlesztése már 5.2 vel megy általában nem? Stalker 2 pl melyikkel megy végül mert annó UE4 ről váltottak UE5-re fejlesztés közben.

-

hahakocka

őstag

Pont arról van szó hogy a Restirt az NV fejlesztette ki rá de így is láthatod hogy mekkora RT utáni FPS teljesítmény visszaesés van ott is NV nél is 20-30% al kevesebb az esés AMD hez mérte, csak RT magokkal vs no RT magok ugyebár. S pont arról beszélnek hogy ez egy heavy feature túlontúl és emiatt gyenge AMD ken. Lumenen jobban megy a legtöbb UE 5 game AMD-n eddig is voltak ezekre tesztek. De ha a restir megy akkor annyi is nekik. Választhattak volna mást is arról is meséltek. Láttam én. De mégis a restir-t reszkírozták

S T. Peter alant írja is hogy rosszabb eredményt is adhat a restir. Én ezt nem tudom ezt ti jobban tudjátok. Hwrt Lumennel, Nanite-al lehet jobb lett volna az eredmény Black Mythnél. Nem ezt az utat követték ahogy Peti is írja érdekes lett volna látni. De NV ken is nem igazán megy szépen ez a game s ennek örvendtek? El van cseszve a döntésekkel és az optimalizálással ennyi.

S T. Peter alant írja is hogy rosszabb eredményt is adhat a restir. Én ezt nem tudom ezt ti jobban tudjátok. Hwrt Lumennel, Nanite-al lehet jobb lett volna az eredmény Black Mythnél. Nem ezt az utat követték ahogy Peti is írja érdekes lett volna látni. De NV ken is nem igazán megy szépen ez a game s ennek örvendtek? El van cseszve a döntésekkel és az optimalizálással ennyi. -

T.Peter

őstag

Amugy a restir rosszabb eredmenyt ad mint a screen probe gather amit a lumen hasznal. Unreal help leirja. A pt miatt jobb a vegeredmeny.

Ha a df-nek igaza van es nincs vsm a novenyzetnel (es nem is nanite) akkor azert nem volt magas a lec az arnyekokkal kapcsolatban.

Igazan megneztem volna mi az eredmeny ha van hwrt lumen es minden nanite, a novenyzet is, plusz vsm van hasznalva mindenhez. -

PuMbA

titán

Egyébként Lumen esetén is ugyanez játszódik le. Cinematic Global Illumination és Medium Global Illumination között hatalmas sebesség különbség van, mind AMD-n, mind NVIDIA-n és látványban meg szinte semmi. Innen tudni, hogy nem az a probléma, hogy a ReSTIR GI-t NVIDIA-ra írták, hanem a precizitása olyan nagy, hogy azt az NVIDIA bika RT egységei még bírják.

-

PuMbA

titán

Ja most látom, hogy Rester az nem rasztert jelentene, hanem a ReSTIR-t

Így már oké.

Így már oké.

NVIDIA-n egyébként 30%-kal esik a teljesítmény az RT-t bekapcsolva, AMD-n 80%-kal a videó szerint. A precizitás miatt esik-e be az AMD úgy látszik, mert minden más játéknál is a komplex effekteknél lassul be. Ez a legvalószínűbb. Ratchet -nél is minél több RT effekt annál jobb az NVIDIA. -

X2N

őstag

Ha van egy ilyen moiré jellegű probléma akkor az a megoldás hogy elmossuk élsimítással? Ha alacsony felbontásról skálázol fel nem csodálkozom hogy még jobban is zavar, csak a hibát nagyítottad fel

. A kamera gyártók is AA filtert tettek régen a szenzorokra, aztán elhagyta mindenki a szűrőt és megnövelték a felbontást, ezt kellene tenni itt is, 4K-8K kijelzők, 24-32-es maximális monitor méret, retina kijelzők, nem kell több élsimítás, oled, 1000Hz képfrissítés. Az RT-t meg lehet alacsonyabb felbontásba számolni és rávetíteni a jó minőséggel renderelt képre(Ahogy a filmesek is csinálják.), vagy az RT-s 1080p-s képest felskálázni, mert ma még a 4090 teljesítménye is édeskevés RT-re 1080p felett. 1080p a CGI 4K filmnél.

. A kamera gyártók is AA filtert tettek régen a szenzorokra, aztán elhagyta mindenki a szűrőt és megnövelték a felbontást, ezt kellene tenni itt is, 4K-8K kijelzők, 24-32-es maximális monitor méret, retina kijelzők, nem kell több élsimítás, oled, 1000Hz képfrissítés. Az RT-t meg lehet alacsonyabb felbontásba számolni és rávetíteni a jó minőséggel renderelt képre(Ahogy a filmesek is csinálják.), vagy az RT-s 1080p-s képest felskálázni, mert ma még a 4090 teljesítménye is édeskevés RT-re 1080p felett. 1080p a CGI 4K filmnél. -

X2N

őstag

Rontja a képet. Az hogy szemcsés a kép lehet attól hogy a kamra magas iso-n volt vagy utólag tették rá a művészek. Filmet ne keverjük ide az eleve tömörített, 4:2:0, vagy 4:2:2, nem 4:4:4 mint a játék. Valamiért nagyon triggerel téged ez a vibráló él

Nincs semmi baj a képpel, Doom Eternal--nál is ki lehet kapcsolni a a TAA-t sokkal élesebb lesz a kép, a fegyvermodellt látod mennyire részletesen textúrázták, viszont könnyebb kiszúrni a távoli lod fázis váltásokat meg távolabbi gyengébb textúrákat/modelleket.

Nincs semmi baj a képpel, Doom Eternal--nál is ki lehet kapcsolni a a TAA-t sokkal élesebb lesz a kép, a fegyvermodellt látod mennyire részletesen textúrázták, viszont könnyebb kiszúrni a távoli lod fázis váltásokat meg távolabbi gyengébb textúrákat/modelleket.

Van kamerám ami 4K-t tud felvenni 100Mbps-al, ez lassan egy 10 éves kamera, a mostaniak már raw-ban vesznek fel 1900+Mbps-al 10 biten külön SSD-re, úgy hogy túlmelegszik 20 perc alatt a kamera szenzora, simán megtöltve egy TB-os SSD-t... -

X2N

őstag

Nincs értelme, min is néznéd meg? Egy 2560x1440-es kijelzőn, összenyomorítva a 4K felbontást, nem beszélve a 4:2:0 chroma supsamplingről meg a videó tömörítésről...CP2077-ben már nem a recék amik zavaróak hanem maga a monitor pixel response time-ja(ips panel

), ha mozgatod a nézetet a monitor pixelei nem váltanak elég gyorsan. Ennyire részletes a kép. Van persze LG oledem, ott ez nincs, csak ott meg a ppi-miatt távolabbról kell nézned. Ezt maximum személyesen tudnád megnézni nálam(BP), megoldhatjuk ha érdekel a dolog szívesen megmutatom.

), ha mozgatod a nézetet a monitor pixelei nem váltanak elég gyorsan. Ennyire részletes a kép. Van persze LG oledem, ott ez nincs, csak ott meg a ppi-miatt távolabbról kell nézned. Ezt maximum személyesen tudnád megnézni nálam(BP), megoldhatjuk ha érdekel a dolog szívesen megmutatom. -

hahakocka

őstag

FSR 3.1 es is teljesen használható akkor már a 6700xt vel is? Az van neked ha jól emlékszem ugye? Hát igen FSR-RT ben eddig is gyengébb volt az AMD ez elég tény. Nem értem Abunak miért nem az. De amúgy mindkét nagy gyártónál vannak marketing faló vámpírok s fórumozók....

-

Igen ezt nálunk a kereskedelemben tanítják, az angolok nálunk ezt kindulási érveléselméleti technikaként tanítják nekünk.

A tárgyalópartnerrel szemben induláskor az ellenkezőjét állítod a tárgyaló partner által látott és elfogadott megítélésnek és amikor valami mellett érvelni akarsz, felállítasz egy úgynevezett érvelési szakaszt két végponttal és egy origóval. Azaz onnan indulsz ki, hogy amit általánosan ő jónak át az gyakorlatilag rossz amit pedig rossznak az gyakorlatilag a legjobb, tulajdonképpen a cél. Végül a tárgyalópartner annak is örül, ha kihoz egy origót ebből. Igen, biztos vagyok benne régóta, hogy ez érdeke, már elengedtem azt hogy naív és elhisz minden AMD-től érkező marketinget.

Megcsináltam a lányom gépével most jó minőségben az összehasonlítást.60 % felskálázással. [link] Mindeki döntsön a maga ízlése szerint.

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Xbox Series X|S

- Spórolós topik

- Proxmox VE

- gban: Ingyen kellene, de tegnapra

- Milyen billentyűzetet vegyek?

- NVIDIA GeForce RTX 5080 / 5090 (GB203 / 202)

- Battlefield 6

- MWC 2025: A kicsi és a kamerás - megjött a Xiaomi 15 és az Ultra

- Milyen notebookot vegyek?

- Gaming notebook topik

- További aktív témák...

- Bomba ár! HP Elitebook Folio 9470m - i5-3GEN I 8GB I 480GB SSD I 14" I DP I Cam I W10 I Garancia!

- Creative Sound BlasterX G6 7.1 USB külső hangkártya (ELKELT)

- Keychrone Q1 V2 billentyűzet / Számla / Garancia /

- Bomba ár! Dell Latitude 5400 - i5-8GEN I 16GB I 256SSD I 14" HD I HDMI I Cam I W11 I Gari!

- Telefon felvásárlás!! Samsung Galaxy S23/Samsung Galaxy S23+/Samsung Galaxy S23 Ultra

Állásajánlatok

Cég: FOTC

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)

)

)

), ha mozgatod a nézetet a monitor pixelei nem váltanak elég gyorsan. Ennyire részletes a kép. Van persze LG oledem, ott ez nincs, csak ott meg a ppi-miatt távolabbról kell nézned. Ezt maximum személyesen tudnád megnézni nálam(BP), megoldhatjuk ha érdekel a dolog szívesen megmutatom.

), ha mozgatod a nézetet a monitor pixelei nem váltanak elég gyorsan. Ennyire részletes a kép. Van persze LG oledem, ott ez nincs, csak ott meg a ppi-miatt távolabbról kell nézned. Ezt maximum személyesen tudnád megnézni nálam(BP), megoldhatjuk ha érdekel a dolog szívesen megmutatom.