- OnePlus 15 - van plusz energia

- Xiaomi 15 - kicsi telefon nagy energiával

- iPhone topik

- Samsung Galaxy S25 Ultra - titán keret, acélos teljesítmény

- AirTag-riválist hoz Európába a Xiaomi

- Vivo X200 Pro - a kétszázát!

- Google Pixel 9 Pro XL - hét szűk esztendő

- Fotók, videók mobillal

- Okosóra és okoskiegészítő topik

- Egy héten belül itt a Motorola Edge 70 Fusion

-

Mobilarena

Új hozzászólás Aktív témák

-

-

martonx

veterán

válasz

Atomantiii

#20978

üzenetére

Atomantiii

#20978

üzenetére

Javascript (typescript), Asp.net, Java, Go, Rust, Python hogy csak a fontosabbakat említsem.

-

inf3rno

nagyúr

válasz

dabadab

#20973

üzenetére

dabadab

#20973

üzenetére

Megcsináltam a saját változatot, ami jól olvasható jól tagolt kódot eredményez. Cserélhető benne a naptár, hogy dátumokat és időpontokat is tudjon kezelni, és választható, hogy [from, to] vagy [from, to) jellegű az intervallum. Ezen kívül a value mezőket összehasonlító, beállító kód is cserélhető, szóval lehet választani, hogy egy vagy több érték mező van a from, to mellett, és azokat hogyan hasonlítjuk össze, hogyan klónozzuk a rekordot, stb. Lehet még betenni szűrőt, hogy a null értékek vagy a default értékek ne kerüljenek bele az adatbázisba, ha ilyenre állítanánk értéket, akkor törli azt is, ami az adatbázisban van.

A chatgpt változata és az enyém között nincs sok eltérés sebességben. Ugyanazokat a teszteket nálam leggyorsabban 27 msec alatt futtatja, nála 30 msec alatt, szóval nem sikerült nagy mértékben optimalizálnom. Az ő megoldása számomra követhetetlen, olvashatatlan kódot eredményez. A bele annak nem cserélhető. Nekem úgy tűnik, hogy az absztrakt gondolkodás, és annak leképezése valami emberileg értelmezhető modellé, ami hiányzik nála, azért csomagolja rosszul a kódot, hiába adok neki megszorításokat ilyen szempontból. Sok a junior szintű a,b,c jellegű változónév is van benne, vegyesen rövidítések is, ami szintén rontja az olvashatóságot. Szóval összességében működik a kódja, csak ha debuggolni, karbantartani kell, akkor az ember elég gyorsan falba ütközik.Szóval ha valami nagyon gyorsan kell, és kb. lövésünk sincs a helyes irányról, akkor hasznos tud lenni. Ötletelésre is szerintem jó. Komoly fejlesztésre én nem használnám jelenleg. A fenti kód pl. az egyik új projektem alapja, és nem bíznám rá a chatgpt-re, mert elég gyorsan bedőlne, ha fejleszteni kellene rajta bármit. Kivéve persze ha az az irány, hogy a fejlesztést is a chatgpt végzi majd, mert ő ismeri a saját kódját.

-

Atomantiii

addikt

válasz

martonx

#20976

üzenetére

martonx

#20976

üzenetére

Jelenleg annyi biztos, hogy a php az biztosan menne rajta. Milyen PHP alternatívákra gondolsz? Bár ha kell keresek másik tárhelyet is akár.

urandom0: TypeScriptet egyáltalán nem ismerem, na mondjuk a Laravelt sem különösebben de találtam hozzá segédanyagot. Nyilván nem biztos a siker, de így már el tudnék valahogy indulni vele.

-

válasz

Atomantiii

#20975

üzenetére

Atomantiii

#20975

üzenetére

Én manapság inkább a TypeScript irányába indulnék el, bár egy ilyen rendszert sok esetben nehezebb deployolni.

-

martonx

veterán

válasz

Atomantiii

#20975

üzenetére

Atomantiii

#20975

üzenetére

Ha a tárhelyed csak PHP-t támogat, akkor teljesen jó választás a Laravel. Ha más program nyelveket is támogat véletlenül, akkor én mindenképpen elgondolkoznék a PHP alternatíváin.

-

Atomantiii

addikt

MVC rendszerű weboldalt szeretnék csinálni, a chatgpt php + laravel vonalon indítana el, mennyire javasolt ez? Vagy inkább más irányba kéne indulni? Szeretném ha idővel a tárhelyemen lévő weboldalon is tudna futni. Esetleg ha tudtok ezzel kapcsolatban magyar nyelvű útmutatót linkelni annak is örülnék.

-

inf3rno

nagyúr

válasz

dabadab

#20973

üzenetére

dabadab

#20973

üzenetére

A teszteken átmegy, működik, de nem szép a kód, és nem is optimálisak az algoritmusok, amiket használ ránézésre, pedig elég pontos instrukciókat adtam, hogy hogyan lesz optimális. Elemzem még. Szerintem ha gyorsan kell gányolni, akkor jó a chatgpt, ha valami production ready kell, akkor sorról sorra át kell nézni mindent, amit csinál. Tulajdonképp a programozókból ezzel reviewer meg kód csomagoló munkás lesz.

-

inf3rno

nagyúr

ChatGPT-t most próbára teszem. Nulláról megiratom vele a dátum tartomány frissítő algoritmusom unit tesztekkel. kíváncsi vagyok mire jut. szkeptikus vagyok

-

-

-

btraven

őstag

válasz

inf3rno

#20968

üzenetére

inf3rno

#20968

üzenetére

Nekem se jó a felfogóképességem már. Nézek egy Youtube videót, fickó gépeli be a kódot, persze ezerszer elgépeli. Aztán nagy nehezen kész, elindítja, persze nem megy, keresgéli a hibát, összevissza kattintgat villámgyorsan az IDE-ben, és meg csak nézem, régen elvesztettem a fonalat mi a franc történik.

DialogBox helyett DialogueBox-ot ír, persze a dialogue-t is kb hatodszorra sikerül helyesen beírnia. -

cog777

őstag

válasz

dabadab

#20964

üzenetére

dabadab

#20964

üzenetére

"warningokat úgy tüntesse el, hogy átirányítja az stderr-t a devnullba (true story)"

Hat, akkor egesz emberi, nemely kollega ugy tuntette el a c++ warningokat hogy #pagma-t hasznalva kikapcsolta arra a reszre a forditasi uzeneteket.

Azt vettem meg eszre hogy uj session-t kell nyitni minden uj feladatnal, megzavarja a korabbi feladat. Masreszt lehet ha korbe-korbe megy akkor megint session-t kell zarni, es uj nyitasnal felsorolni milyen megoldasokat ne vegyen figyelembe

Uj programozasi platform szuletik: AI pszichologusnak kell lenni, megtanulni hogyan beszeljunk veluk. -

VikMorroHun

őstag

Én legutóbb egy fordítási feladatnál használtam, amikor semmi kedvem nem volt rendesen nekiállni. Adott egy kiindulási alapot, amit kicsit átalakítva egész jó eredményt produkált(unk). Egészen addig, amíg el nem kezdett nekem Bujtor Istvánról szövegelni. Egy fantasy játék fordítása során. Mondom, mivan??

-

válasz

dabadab

#20964

üzenetére

dabadab

#20964

üzenetére

> Aztán emellet van az is, amikor csak körbe-körbe megy a saját farkát kergetve és csak égeti a tokeneket meg össze-vissza hallucinál, főleg akkor, ha már meglévő kódhoz kellene hozzászólni.

Ez a legkellemetlenebb egyebkent szerintem. Mi Geminit hasznalunk, es hajlamos ilyenre.

-

válasz

cog777

#20962

üzenetére

cog777

#20962

üzenetére

Vannak dolgok, amiket tök jól megcsinál (a parserek írása pl. nagyon megy neki), persze kell a felügyelet (nagyobb részeknek általában eleve plan mode-ban küldöm neki), mert hajlamos arra, hogy pl. a warningokat úgy tüntesse el, hogy átirányítja az stderr-t a devnullba (true story) vagy hogy a példafile részeit fixen bedrótozza a kódba, ahelyett, hogy rendesen kiparzolná belőle meg hasonlók.

Aztán emellet van az is, amikor csak körbe-körbe megy a saját farkát kergetve és csak égeti a tokeneket meg össze-vissza hallucinál, főleg akkor, ha már meglévő kódhoz kellene hozzászólni. -

-

cog777

őstag

válasz

inf3rno

#20958

üzenetére

inf3rno

#20958

üzenetére

A premium modelleket erdemes hasznalni, az ingyenesek nagyon egyszeru feladatokra jok csak.

Opus 4.6 most hozott egy latvanyosabb kovetkezo szintet, de megvan a korlatja ennek is - meg.

Nyilvan terulettol, programnyelvtol, sok mindentol fugg a dolog.

A cegnel hasznalhatjuk a legujabb premium modelleket, es jol specifikalt dolgokra nagyon jo, pl parser-t irattam vele egy halozati protokollra, dinamikus reszek vannak benne. Kertem irja meg a unit tesztjet mukodott...

mukodott...

A cegnel sorrol sorra atnezem amit csinalt, egesz jol dolgozik.

Vagy, egy altalam nem ismert state machine konyvtarat kellett hasznalnom, siman megirta par apro hibatol eltekintve az allapotgepet.

Viszont felugyelni kell, tippeket adni, vagy meg kell terveznem az arkitekturat es o maga mar jo esellyel ki tudja tolteni a logikai reszt benne.

Tervezes meg valahogy nem megy neki.

Otthoni projektjeimben is el kezdtem hasznalni, nagyon gyorsan haladok bennuk, annak ellenere hogy sok review-t igenyel, tesztelest, es hibajavitast. De igy is megeri, mert 4 projekten tudok dolgozni otthon - nagyresze vibe code-al. Es sok teruletet nem ismerek, nem vagyok a szakertoje, nekem eleg ha otthon az eredmeny jo. Hogy eri el, az nem erdekel, csak optimalis legyen a futas.

Viszont meg kell tanulni az AI-t is "programozni" pl fogalma sincs a jo tervezesrol, hat megmondtam neki hogyan strukturalja a kodot es unit tesztet irjon a modulokhoz amit headless futtat.

Meg kell ismerni, pl hogyan tudok jobb emlekezetet adni neki, amit fel tud hasznalni tobb projektben, pl ne kelljen kifejleszteni ujbol egy loggert.

Egy nagyobb bonyolultabb projektnel ra kell jonni hogyan lehet jol hasznalni, mert siman elfelejt dolgokat.

Ja, vibe coding-al kapcsolatban rajottem hogy pl a log-olas fontos, onnan tudja meg hogy mi jo es mi nem, nem latja a kepernyot, csak screenshot-ot tudok felcsatolni.

Jah, nem fogja elvenni a munkat egyelore, de meg kell tanulni hasznalni, illetve meg fejlodnie kell. -

inf3rno

nagyúr

válasz

urandom0

#20960

üzenetére

urandom0

#20960

üzenetére

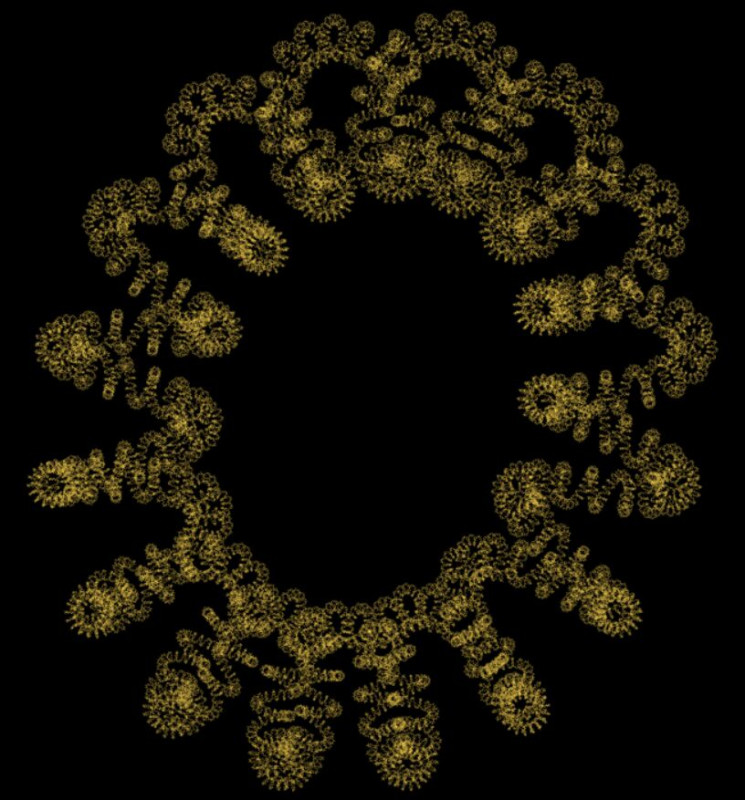

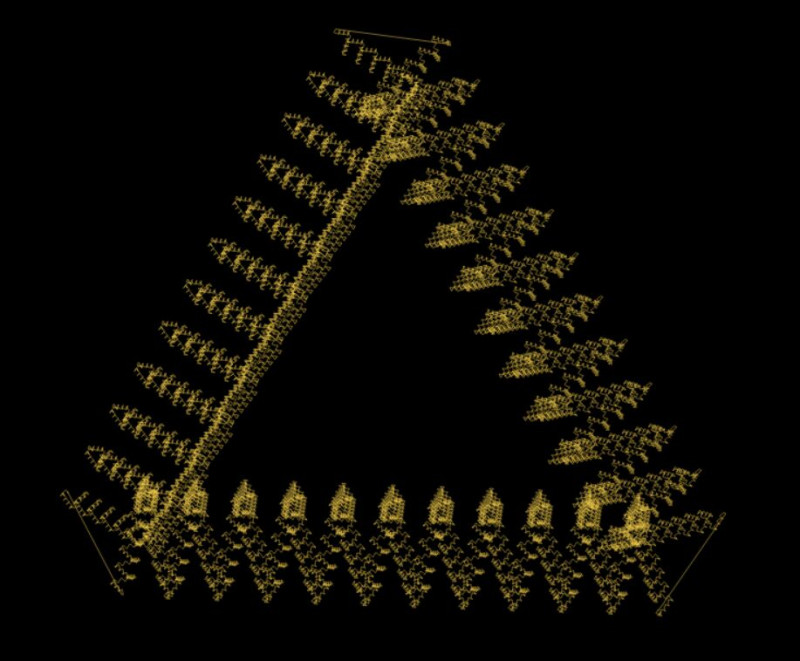

Én eddig 3 renderelésre használtam a fenti fraktáloknál. Íme egy újabb :-)

Ennél pl. lövésem sem lett volna a matekjáról, és csak egy konkrét alakzatot akartam kirajzoltatni.

Ennél pl. lövésem sem lett volna a matekjáról, és csak egy konkrét alakzatot akartam kirajzoltatni. Ezen kívül dátum tartományok tárolására, batch frissítésére SQL adatbázisba terveztem vele hatékony algoritmust. Az utóbbinál meglepett, mert én mentem volna be a málnásba, ha nem szól, hogy rossz az irány. Megoldani úgy is megoldottam volna valószínűleg, de rengeteg időt és szenvedést megspórolt.

Nehéz megítélni, de ezzel a kettővel szerintem 1 hónapot megspóroltam vele összesen. Az órák, amik elmentek meg ehhez képest nem számítanak, nem ugyanaz a nagyságrend, talán ha 10 óra ment el a hülyeségeire pluszban. Azt viszont aláírom, hogy nagyon oda kell figyelni a tanácsainál, és azonnal felülbírálni, ha hülyeséget ír. Nem lehet rábízni, inkább csak tanácsadónak jó. Még erősebben kell gondolkodni majdnem, mint nélküle. Ha viszont megvan, hogy mit akarsz és pontosan meg tudod fogalmazni, akkor sokszor ad jó választ.

-

válasz

inf3rno

#20958

üzenetére

inf3rno

#20958

üzenetére

Nagyon sokszor bele tud vinni a málnásba, de ez csak akkor derül ki, mikor egy óra szüttyögés után rájössz, hogy az általa adott "megoldás" pont nem jó, és saját magadtól 10 perc alatt találtál volna valóban működő megoldást.

Vagy amikor ír egy 20 soros metódust, aminek a legutolsó sorában lenne a lényeg, aztán kiderül, hogy pont olyan metódus nincs a frameworkben, mint amire ő hivatkozik...Én shader írásra és particle editor fájlának szerkesztésére használom, ezekre egész jó, illetve kreatív munkára. Mutatok neki tíz küldetést, amit én írtam, és kérem, hogy írjon még tízet, azt például nagyon jól megcsinálja. Kódot nem íratok vele, legfeljebb metódust terveztek át vele, ha lusta vagyok magamtól megírni.

-

cattus

addikt

válasz

inf3rno

#20958

üzenetére

inf3rno

#20958

üzenetére

Én kerülöm bármilyen AI használatát, szerencsére a jelenlegi munkahelyemen nem erőltetik és eddig teljesen jól megvoltam bármelyik nélkül, szerintem ezután is megleszek.

Az hogy volt syntax error nem annyira meglepő, tekintve hogy ezek a rendszerek még mindig csak (nagyon bonyolult és szofisztikáltan működő) szöveg prediktorok.

-

inf3rno

nagyúr

válasz

FeniX-

#20956

üzenetére

FeniX-

#20956

üzenetére

Ha már szóba került nektek mi a tapasztalat az AI-al? Nekem vegyesek az érzéseim, chatGPT-vel algoritmust volt már, hogy ajánlott jobbat, mint amit én kigondoltam, matekban talán jobban ott van, mint én, de amikor a kód csomagolásáról, optimalizálásáról, stb. van szó, akkor elég durva hülyeségek is előkerültek már, illetve előfordult már syntax error is pl. amikor MySQL kódot ajánlott MariaDB szerverhez, aztán végül kukáztam, amit mondott és dokumentációból kikerestem, hogy hogyan kell. Ha azt nézzük, hogy mennyi idő ment el már rá és mennyit spórolt meg nekem, akkor azért pozitív a mérleg szerintem.

-

FeniX-

senior tag

Szia,

gyakorlatilag code-review -t kérsz egy teljesen ismeretlen kódbázisra, jól értem?A repóban van kb. 2 tucat file, amik több száz sorosak.

Egy átlag programozónak mondjuk 1-2 hét átnézni és megérteni, hogy nagyjából mit csinál a kód...a csetdzsípítível készítettél hozzá legalább magas szintű dokumentációt?

(Mit, miért, hogyan csinál; melyik fileban mik vannak, hogy épül fel a kódod)Így a semmiből szerintem nem nagyon akarja senki megnézni mások kódját.

Pláne, szerintem minden szakmában van egyfajta összetartás, hogy amikor egy - úgymond - amatőr/külsős bejön, és tanácsot kér, akkor jó lenne összeszedni valami kiindulási pontot.Érted, az autószerelőhöz sem megyek úgy oda, hogy "tessék, találtam egy japán blokkot, amit átépítettem és jó lenne, ha még erősebb lenne, de én nem értek hozzá, ezért itt a komplett motorblokk és nézze át az autószerelő..."

Nem akarok vitát indítani és talán a témakörtől is eltérek, de jó pár helyen a managerek is ugyanezt képzelik, hogy " de jó, van Ai, akkor már nem is kell programozó, mert én (mint manager) majd megírom a kódot.. " - aztán jön ,hogy az Ai terjengős, néha szar kódot ír, és optimalizálni kéne, meg mondjuk 0 karbantarthatóság van, vagy át kell írni és nem jó a végeredmény és akkor szomorúság van.

-

válasz

VikMorroHun

#20954

üzenetére

VikMorroHun

#20954

üzenetére

Az nem Windows, amit ott látsz.

-

VikMorroHun

őstag

Hehe...

Elkezdtem beleásni magam a Linux rejtelmeibe. Kellett Wine is, amit egy script szépen felpakolt a rendszerre. OK, működik, ami kell. Aztán egy másik Windows programot is fel akartam rakni, ehhez pedig elkezdtem tanulmányozni a Wine dokumentációt. Az egyik helyen a következőt írják: "Think of Wine as a compatibility layer, when a Windows program tries to perform a function that Linux doesn't normally understand, Wine will

translate that program's instruction into one supported by the system." Tök jó, érthető.Aztán történt egy kis probléma, emiatt frissítettem a Wine-t, emiatt elromlott az is, ami eddig működött, most pedig próbálom letörölni az egészet, majd újra rakni az eredetit. Közben viszont rábukkantam a /home/<user>/.wine/drive_c/windows/ könyvtárra, abban pedig egy komplett Windows-ra (1.7 GB). Mondom, érdekes egy kompatibilitási réteg az, ami úgy mellékesen telepít egy jogvédett szotfvert a Linux alá...

-

czuni

kezdő

Sziasztok,

Szeretnék segítséget kérni és fejlődni. Nem tudtam melyik a relevánsabb topic így két helyne is megosztom.

1. N8N tanulmányozom szeretném a munka folyamataim hatékonyabbá tenni. Localban futtatom. Van aki tudna segíteni nekem ebben? Befektetés és biztosítás.

2. Párhuzamosan local környezetben építek egy fogadási robotot, Python alapon, ChatGPT Codex segítségével.

Itt főleg optimalizálás, teljesítmény, architektúra, hatékonyság növelés a célom.

GitHubon elérhető: https://github.com/czu9ni/tipss_botBármelyik témában szívesen fogadok tanácsot, kritikát és nyitott vagyok akár együttműködésre / társulásra is, ha van közös metszet.

-

-

martonx

veterán

válasz

cog777

#20946

üzenetére

cog777

#20946

üzenetére

szerintem ezt keresed. Első gugli találat volt: GitHub Copilot premium requests - GitHub Docs

-

cog777

őstag

Elofizettem a Github Copilor Pro-ra, hasznaltam majd 1 honapig, majd elfogyott a keret.

Kellene par request, de keptelen vagyok megtalalni hogyan kell vasarolni extra kreditet, requestet.

Google, bing, stb AI keptelen ertelemes valaszt adni.

Sot, valaki csinalt ticket-et hogy o vasarolt extra elofizut, de keptelen volt a rendszer azt hasznalni (VSCode, copilot) kb 20 csatlakoztak hozza

Valahol olvastam vegul hogy hozza kell adni extra budget-et, megcsinaltam a billing alatt, beallitottam 10 dolcsit meg. Gozom nincs hogy hol vannak a bankkartya adatok Github alatt,, hogy levette-e a penzt vagy valahol extra helyen kell engedelyezni.Programozok istene! Valaki tanitsa meg oket UI-t csinalni (meg kiadni par SQL parancsot), mert vannak termekek, akiknek a fejlesztoi penzt akarnak, ok oda raktak egy feltoltes (top-up vagy mi) gombot, amivel nem nehezitik meg a felhasznalo penzkoltesi szandekat!

De persze el lehet rejteni ezt 25 menu pont ala, es komplett API-t kell lezongorazni ha a termeket hasznalni szeretned!

Megkoszonnem ha valaki leirna hol lehet egyeduli (nem enteprise, organization-os) felhasznalokent ezt megcsinalni. -

coco2

őstag

Futott valaki köröket bármelyik NLP-vel (példa: spacy) ? Van egy halom angol szót felsoroló listám, és ki kellene találni a lehetséges szófajokat róluk. Használható az ilyesmire?

A tippeket előre is köszönöm.

-

VikMorroHun

őstag

Néha szembe jönnek ilyen gyöngyszemek...

-

inf3rno

nagyúr

Nekem készen vannak a fraktáljaim:

A fizetési rendszerrel is haladtam sokat, meg elképzelhető, hogy még idén meglesz, mert egy időigényes feature-t kivettünk belőle és a v2-re átraktuk.

-

gergo5991

őstag

ma egy random app ötlet jutott eszembe, és geminivel rákérdeztem van-e ilyen a piacon stb, azt mondta kva jó ötlet, sok benne a fantázia, ilyen a piacon konkrétan nincs.

Nyilván minden igaz amit gemini mondott. Kérdésem az lenne, van itt valaki, akinek sikerült már ötletet pénzé tenni? de olyan szinten, hogy még egy file se lett létre hozva, magát az ötletet eladta. -

inf3rno

nagyúr

Én most spirális fraktál rajzolással küzdök. Nem vagyok annyira toppon a 3d geometriában, de haladok chatgpt segítségével. Néha úgy vagyok vele, hogy jobb lenne utána olvasni, mert túl okos akar lenni a chatgpt, és mindenféle hülyeséget összehord ahelyett, hogy a kérdésre válaszolna.

Fizetési rendszert hegesztek még, az eléggé lefáraszt. Még 2-3 hét van vissza abból a projektből. Remélem azért januárban végzek vele, mert már nagyon unom.

-

martonx

veterán

válasz

VikMorroHun

#20938

üzenetére

VikMorroHun

#20938

üzenetére

Ez tök jó, csak éppen továbbra sem írtál éppen semmi kontextust, hogy vajon milyen programnyelv, milyen keretrendszeréről beszélsz

Azért örülünk, hogy sikerült megoldanod valamit, valamiben, mutatókkal! -

VikMorroHun

őstag

válasz

inf3rno

#20930

üzenetére

inf3rno

#20930

üzenetére

Fun fact: miután leírtam a múltkoriakat, úgy döntöttem, elhagyom a mutatókat. Összesen 5 objektumról van szó, az kézzel is kezelhető. Szépen átírtam a függvényt switch/case szerkezetre (idejét sem tudom, mikor használtam ilyet utoljára); a 20-30 sorból lett 50+ sor, de működött. Miután

ezzel megvoltam, megértettem, mit is olvastam az egyik fórumon, amikor valakinek ilyen jellegű gondja támadt. A megoldás: mutatót kell használni. Igen, azt használtam, és nem működött. Ja, hogy az egész UI-t azzal kellene kezelni...

ezzel megvoltam, megértettem, mit is olvastam az egyik fórumon, amikor valakinek ilyen jellegű gondja támadt. A megoldás: mutatót kell használni. Igen, azt használtam, és nem működött. Ja, hogy az egész UI-t azzal kellene kezelni...

Ma este lettem készen vele. (De nem baj, hogy előtte annyit küzdöttem ezzel, mert a félig jó változat rávilágított néhány programhibára (amit ki tudja, mikor vettem volna észre nélküle), amik kijavítása meglehetősen fontos volt). -

válasz

cattus

#20936

üzenetére

cattus

#20936

üzenetére

Oké, az Angular is csak, csak nem az a useState/setState-es hülyeség, mint amilyen a React (és amilyen a Flutter). Egyszer írtam Flutterben egy egyszerű appot, két hétig volt fenn Play Store-ban, annyira megutáltam, hogy nem volt kedvem tovább fejleszteni. Már a forráskódja sincs meg.

Angular hagyományosan inkább a two way bindinget használja, mint pl. a JavaFX. Bár az igaz, hogy mióta vannak signalok, azóta ugyanott vagyunk, mint Reacttel.

-

cattus

addikt

válasz

urandom0

#20935

üzenetére

urandom0

#20935

üzenetére

Az Angular is egy reactive framework.

Mostanra amúgy eljutottunk oda hogy a legtöbb frontent framework kb. ugyanazt a paradigmát implementálja minimális eltéréssel, pl. a Vue ref(), a React useState, az Angular signal() meg a Svelte $state() kb ugyanúgy működik / néz ki.

-

válasz

martonx

#20934

üzenetére

martonx

#20934

üzenetére

Azt gondolom, hogy ezeknél az ismertebb frameworkoknél (beleértve a React-et, Vue-t, Svelte-t, Angulart, stb.) tudsz valami jobbat.

A Vue szerintem egyértelműen programozó barátabb, mint a React, mondjuk nem nehéz annak lennie, mert a React a JSX-el együtt egy gány tákolmány (bugos is, lassú is). A Svelte-t nem ismerem, de jókat hallottam róla.

Én, ha most kezdenék frontendes projektbe, az összes ilyen reactive frameworköt kerülnék, és szerintem Angularral állnék neki. -

martonx

veterán

válasz

urandom0

#20932

üzenetére

urandom0

#20932

üzenetére

Előre bocsátom, hogy böngészős és .Net vonalat ismerem. És ez azért erősen szubjektív tud lenni, pláne weben, ahol kismillió megoldás van ugyanarra.

Svelte és Vuejs ha böngészőről beszélünk (tudom, tudom ott a hype a React, előtte - mellette pedig az Angular, amik nem is rosszak, csak épp szerintem vannak náluk sokkal jobb megoldások).

.Net vonalon pedig a .Net Maui lett meglepően jó. -

-

inf3rno

nagyúr

válasz

VikMorroHun

#20929

üzenetére

VikMorroHun

#20929

üzenetére

A frontendet (fullstacket) az ilyenek miatt hagytam ott. Programozni nagyon szeretek, UI-t tákolni viszont nagyon utálok.

-

VikMorroHun

őstag

A programozás szépségei...

Van egy UI "ablak", ahol visszajelzést kap a felhasználó.

Ki akartam bővíteni, hogy belerakok néhány objektum mutatót, azokat meg egy tömbben kezelem.A következő változatokat sikerült összehozni:

- a tömb elemszáma folyamatosan nő (érdekes módon az indexek is, szóval a tényleges elemszám konstans, ahogy lennie kell, persze a ciklus 0-tól indul)

- jó a tömb elemszáma, de ha valami megváltozik, újrarajzolásnál szétesik a UI

- ha kihagyok egy utasítást az objektum mutatók létrehozásakor, amivel hozzáadnám őket a tömbhöz (mert látszólag kicsivel korábban már megtörtént), akkor minden remekül

működik, csak a tömb üres lesz, vagyis nem fogom tudni használni az objektum mutatókat (mert nincsenek). Bár a UI mutatja őket.

- látszólag minden remekül működik, nem esik szét a UI sem, csak ha leáll a program, memóriaszivárgás van.Olyan verziót még nem sikerült készíteni, hogy a fentiek közül egyik hiba se jöjjön elő.

-

axioma

veterán

Ujra itt van: [AoC]

Sajnos csak 12 nap lesz. -

-

coco2

őstag

És majd amikor a dap szerverei leállnak, mert "a kellemetlenségekért szíves elnézésüket kérjük" és társai, akkor a szolgáltatás határozatlan ideig elérhetetlen lesz, mert senki sem fog tudni bejelentkezni.

A közelmúltban volt valami kormányzati rendszerek leállásáról, amiről annyit hallottam nyilvánosan, hogy valami szerverben tönkrement egy alkatrész, és nagyon sajnálják. Csak kicsit kiröhögni való szakmai szemmel, hogy kormányzati szinten nem képesek 100.0% üzemstabilitást garantálni.

-

válasz

VikMorroHun

#20916

üzenetére

VikMorroHun

#20916

üzenetére

Szerintem az ötleted jó, de az már nem a te scope-od, hogy a user megfelelően kezelje az e-mail fiókját. Egy fiók/user, 2FA, ... ezeknek azért elég alapvető dolgoknak kellene lennie manapság.

-

coco2

őstag

válasz

VikMorroHun

#20916

üzenetére

VikMorroHun

#20916

üzenetére

Szerintem nem kellene túl szakbarbárnak lenned.

Azokat a problémákat nem informatikailag, hanem jogilag kezelik. Ha a cég rááll email ellenőrzésre, általában belerakja a felhasználási feltételekbe, hogy a felhasználó elfogadja a teljes jogi és erkölcsi felelősséget annak az email címnek a biztonságban tartásáért, amit a titkos funkciókhoz használ, és ha azt a fiókot feltörik, akkor azért ugyan úgy felel, mintha ő maga szándékosan követte volna el mindazokat a cselekményeket, amiket idegen személy követett el. És ott a pont.

A te gondolkodásodban ott a hiba, hogy a dáp is csak jelszavas. Egy jelszó helyett kettőt kell elkapni, esetleg hármat, esetleg még egy mobil számot is lenyúlni, igen, még több védelem, de végső soron egy patchwork, aminek sehol sincsen vége. Nincsen lezárva a kérdés. Kérdőjel van a sor végén ("mi van ha még azt is.. ?"), és nem pont ("lenyeled."), ami egy cég tevékenységét kiszámíthatatlanabbá teszi a jogi kockázatok miatt (beperelik, hogy a cég volt trehány, mert szoftver hiba és a többi).

Szóval nem. Nincsen igazad

Amit mégis ellenőrizhetsz, hogy a felhasználási feltételek és a jogi felelősség összhangban van-e kezelve az informatikai szerelékkel. Ha az nincsen meg, na azért viszont nyafoghatsz a főnöknek, hogy mégis mi az a trehányság?

-

VikMorroHun

őstag

Kiberbiztonság Magyarországon 2025-ben:

Cég: létrehoztunk egy portált, ahol az ügyfelek hozzáférhetnek (érzékeny) ügyféladatokhoz, és néhány dolgot meg is változtathatnak. Fontos, hogy megerősített e-mail címük legyen az adatbázisban, mert oda megy az értesítés, a jelszógenerálási utasításokkal együtt.

Én: Mi lenne, ha integrálnánk a DÁP-ot, mint erős ügyfél hitelesítő alkalmazást a rendszerbe?

Cég: Nem, az e-mail cím a tuti.

Az nem derült ki, hogy mi van, ha

- többen használnak egy e-mail postafiókot

- valaki bekap egy adathalász e-mailt, esetleg keyloggert is

- egy szakértőnek kedve szottyan jelszótörést gyakorolni (mindenkinél más, de mégis ismert a kiindulási adat és a jelszógenerálási módszer) -

Lien

aktív tag

Sziasztok, az itteni fórumozók véleményére lennék kíváncsi, akik jártasak a manuális szoftvertesztelésben. Mit láttok, vajon érdemes ebbe tanfolyamok nélkül, videókat, adatokat halászva belemélyednj, esetleg ebbe az irányba átképeznie magát az embernek? Milyen lesz a jövőbeli kilátása ennek a szakmának? Volt lehetôségem egy nagyon kedves ismerősöm napi munkájába belenézni, hogy milyen és még ha monoton is tetszene. Azért egy automata tesztelés nulla programozói tudással nem menne max sokkal később.

-

inf3rno

nagyúr

válasz

inf3rno

#20908

üzenetére

inf3rno

#20908

üzenetére

Mértem még közben egy bulk insertet. Az talán 5%-al gyorsabb, mint a JSON-os megoldás, viszont közel sem annyira kényelmes ér rugalmas, mint az INSERT SELECT a JSON-al, úgyhogy komplexebb helyzetekben nincs is igazán értelme foglalkozni vele.

Ami még érdekes itt, hogy egyes dátumokra mentek értékeket. Aztán bizonyos tábláknál összefüggő dátum tartományok alakulhatnak ki, amiknél azonos az érték. Azt találtam, hogyha 5+ dátumot átfog egy átlagos tartomány, akkor már megéri from-to tárolni, mert jóval gyorsabb az írása és az olvasása is. Batchben frissíteni úgy, hogy ne fragmentálódjon közepesen bonyolult, de azért megoldható.

Így bizonyos tábláknál a sima 100-as tranzakciós megoldáshoz képest 50x-es írási sebesség is elérhető. Ez kb. olyan, mintha 1 perc alatt bemenne, ami most 1 órába telik. Azért az nem semmi. A problémásabb tábláknál is 5-10 perc, ami várható 1 óra helyett.

-

inf3rno

nagyúr

válasz

dabadab

#20901

üzenetére

dabadab

#20901

üzenetére

Na benchmarkoltam, egyelőre csak annyit, hogy 10.000 rekord van, és másik 10.000-el írjuk felül INSERT ON DUPLICATE KEY UPDATE-el. A sebességek ilyenek voltak:

- egyesével beküldve: 6.000 record/sec

- tranzakcióban beküldve 100-as kötegekben: 10.000 record/sec

- tranzakcióban beküldve 250-es kötegekben: 10.000 record/sec

- JSON-ban beküldve CTE-vel 100-as kötegekben: 80.000 record/sec

- JSON-ban beküldve CTE-vel 250-es kötegekben: 95.000 record/sec

- JSON-ban beküldve CTE-vel 10.000-es kötegekben: 110.000 record/secNekem ebből az jött le, hogy JSON-ban fogom beküldeni CTE-vel ahelyett, hogy tranzakcióval szarakodnék. A 250-es köteg tűnik optimálisnak. Annyi talán még elveszhet, ha valami nagyon félrecsúszik, nem zabál annyi memóriát és sebességben elég közel van a 10.000-es köteghez.

Még csinálok majd egy 4. változatot, aminél először SELECT FOR UPDATE-el lekérem, hogy mi változott, aztán csak utána tolom rá az INSERT ON DUPLICATE KEY UPDATE-et. Így le tudom naplózni a tényleges változásokat is. De ezt csak akkor lépem meg, ha nem annyira lassú, mondjuk hozza legalább az egyszerűbb JSON-os változat 80%-át sebességben.

-

Sonja

nagyúr

Érdekes programozási nyelvet találtam.

"The only compiled language that lets you code with "sus", "slay", and "vibez" while achieving near-c performance."

-

inf3rno

nagyúr

válasz

dabadab

#20901

üzenetére

dabadab

#20901

üzenetére

Hát benchmarknál arra gondoltam, hogy beviszek 10 millió rekordot, aztán beküldök újabb 10 milliót úgy, hogy abból 50k ami tényleges változtatás. Nagyjából valami ilyesmire lehet készülni, max 25 millióra. Igazából a 100 az ilyen hasraütésre született vagy nem tudom mi volt a megfontolás mögötte, simán lehet, hogy 1000 vagy 10000 lesz helyette, most tervezzük újra a rendszert.

-

inf3rno

nagyúr

Nem akarok itt komplett SQL-t írni. Nagyjából úgy néz ki, hogy a SELECT-be rakok egy JSON-t a 100 értékről, azt beparsolja, aztán INNER JOIN-al illesztem a meglévő táblára az értékeket az ON részében meg lesznek a kulcsok meg az, hogyha az érték eltérő, akkor kerüljön csak kiválasztásra. Az INSERT ON DUPLICATE KEY UPDATE meg erre a kiválasztott halmazra íródik.

A 3-as jó lenne, de tudok nélküle élni.

Igazából csak kíváncsi voltam kinek mi a véleménye, megérzése. Így is úgy is le fogom benchmarkolni legalább az első kettőt.

-

JoinR

őstag

válasz

VikMorroHun

#20902

üzenetére

VikMorroHun

#20902

üzenetére

Van benne egy kis programminghorror vibe.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

VikMorroHun

őstag

Ha már log:

A programom 8-10 példányban fut egyszerre, de néha egyik-másik meghibásodik valamiért (nem jöttem rá, mitől). Nincs hibaüzenet, nincs összeomlás, egyszerűen csak megáll, és nem csinál semmit. Eléggé véletlenszerű a dolog; tesztelésnél nem jelentkezik, csak élesben, viszont sok pénzbe kerülhet, ha előfordul, úgyhogy csináltam egy kis log filet, amibe folyamatosan irkálják a dolgaikat, és mindegyik tudja ellenőrizni az összes többit. Ha valamelyik azt látja, hogy leállt az egyik, akkor újraindítja. Tök jó, működik (és így az is kiderült, hogy naponta többször is előfordul ez a hiba). Az egyiket én magam állítottam le, mert nincs rá szükség. A naplóban viszont benne maradt, és buzgón "indították is újra" a nem létező programot. Ok, írtam hozzá egy ellenőrző függvényt, hogy ha valami nem létezik, akkor ne akarják újraindítani, akkor se, ha a naplóban van róla adat. Eredmény: csak fél óránként próbálják újraindítani. Néha egy óráig semmi, aztán valamelyiknek megint feltűnik, hogy nini, hiszen ez leállt, akkor újraindítjuk! Ma írtam hozzá egy másik függvényt, ami kiüti a nem létező programhoz tartozó azonosítót a naplóból, hátha így már nem akarják újraindítani. Kíváncsi vagyok, mi lesz a jövő héten.

Néha egy óráig semmi, aztán valamelyiknek megint feltűnik, hogy nini, hiszen ez leállt, akkor újraindítjuk! Ma írtam hozzá egy másik függvényt, ami kiüti a nem létező programhoz tartozó azonosítót a naplóból, hátha így már nem akarják újraindítani. Kíváncsi vagyok, mi lesz a jövő héten.

Nyilván, ha törlöm a naplót, akkor nincs adat, ami alapján újraindítanák a nem létező programpéldányt, de azért kíváncsi vagyok, sikerül-e végre rendesen megcsinálni...

-

válasz

inf3rno

#20898

üzenetére

inf3rno

#20898

üzenetére

Teljesen tippre az első tűnik a gyorsabbnak, de 100 értéknél tulajdonképpen mindegy is.

Ha viszont tényleg le akarod mérni, hogy a te konkrét adatbázisodnál, a te adataiddal melyik a gyorsabb, akkor meg kapcsold be a slowlogot (egy long_query_time=0 után minden query slow querynek fog számítani) és nézd meg.

Új hozzászólás Aktív témák

● olvasd el a téma összefoglalót!

- Soundbar, soundplate, hangprojektor

- Mibe tegyem a megtakarításaimat?

- LEGO klub

- Azonnali informatikai kérdések órája

- Apple asztali gépek

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Milyen autót vegyek?

- OnePlus 15 - van plusz energia

- HTPC (házimozi PC) topik

- Xiaomi 15 - kicsi telefon nagy energiával

- További aktív témák...

- Thinkpad X13 Gen2i 13.3" FHD+ IPS i5-1145G7 16GB 256GB NVMe SSD gar

- XFX Speedster SWFT 319 AMD Radeon RX 6800 16GB Garancia 2027-ig!

- Tökéletes ajándék! 150 ezerrel olcsóbban mint a bolti ár! 3ÉV GARI BONTATLAN MSI CYBORG 15 RTX 5060

- Lenovo T480S i5 8350U, 16GB RAM, 256GB SSD, jó akku, számla, 6 hó gar

- Latitude 7440 14" FHD+ IPS i7-1365U 16GB 256GB NVMe ujjlolv IR kam gar

- LG 65G5 - 65" OLED Tandem - 4K 165Hz & 0.1ms - MLA Plus - 4000 Nits - NVIDIA G-Sync - FreeSync

- Bomba ár! Lenovo ThinkPad T460s - i5-6GEN I 8GB I 192GB SSD I 14" FHD I Cam I W11 I Garancia!

- Astro A50 4th Gen wireless + base station fejhallgató

- HIBÁTLAN iPhone 15 128GB Pink-1 ÉV GARANCIA - Kártyafüggetlen, MS4510

- GYÖNYÖRŰ iPhone 15 Pro Max 256GB Blue -1 ÉV GARANCIA - Kártyafüggetlen, MS3943, 100% Akkumulátor

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Ennél pl. lövésem sem lett volna a matekjáról, és csak egy konkrét alakzatot akartam kirajzoltatni.

Ennél pl. lövésem sem lett volna a matekjáról, és csak egy konkrét alakzatot akartam kirajzoltatni.

![;]](http://cdn.rios.hu/dl/s/v1.gif)