Új hozzászólás Aktív témák

-

tothd1989

tag

Abszolút releváns kérdés, mit gondolsz, ha egyetlen szó analizálásában téved, akkor egy komplex kérdés esetén mi történik?

Más:

Túrtam az ebayt és találtam tesla k80-at 16000 jó magyar forintért (+a szállítás +be kell szerezni hozzá a tápkábel fordítót).

Megérné ennyi pénzt belefeccölni? Az megvan, hogy 11 éves kártya, de 2x 2496 cuda core és 24(!!!)gb vram. -

Zizi123

senior tag

Szerintem az emberek 1 csomó olyan dolgot kérdeznek az AI-tól amire a Google is kidobja az "eredményt", mégsem azt használják, pedig könnyebb lenne, mint python egysorost írni...

Egyébként meg nyilván nem a végeredmény volt a fontos, hanem gondolkodás tesztelése.Amikor Zsolt felteszi a klasszikus kérdést, hogy "1 kerek asztalnál az embertől jobbra, és balra is 5-en ülnek, akkor mennyien ülnek összesen az asztalnál?" Őt sem az érdekli, hogy mennyi az eredmény, hanem, hogy jó-e, megtudja-e oldani, tud-e gondolkodni...

-

5leteseN

senior tag

A hazai másfél milliárdos piaccal is "kihúznák", de lesz az a duplája is(ha csak a fizetőképességet számolom) a "maradék" 6-7 milliárdból!

Túl tekintve a száraz technológián: Ha úgy magamban minden a helyére teszek, akkor (sajnos ismét) igaz a klasszikus: "Az idő nem nekünk dolgozik!"

Ismét a vesztes oldalon vagyunk!

-

SkyTrancer

senior tag

Mire ezt átnyálazom

De köszi őt már láttam egyszer kétszer, de csak beletekergettem, mert nagyon sok az infó, nekem meg igazából csak érintőlegesen kellene valami, hogy mégis megnézzem, de akármit keresek, letöltős az valahogy mindig kreditbe kerül pedig megnéztem volna hogy mi jön ki a gépből, pl video generálás stb, és ez mennyi idő stb

Köszi mégegyszer -

DarkByte

addikt

Ott talán legegyszerűbb egy venv-et csinálni neki

python -m venv venv

a mappájában, és mielőtt futtatod aktiválod (./venv/bin/activate.sh), és akkor kap egy saját namespace-t ami külön van a host Python-tól.

Utána követed a manual install lépéseit. -

-

consono

nagyúr

Megnézheted a Llamafile-t is, de nagyon CPU függő a dolog. Nekem 8gen i5-ön elég lassú volt.

Meglepő módon az Oracle cloudban lévő ARM procis VM-ben viszont nagyon jól futott Ollama-val pár kisebb modell (pl. Gemma2 2b), pedig ott nincs GPU. Úgy látszik az Ampere A1 jó erre is. -

-

consono

nagyúr

De ha feltöltöd, akkor arról is beszél

Nem véletlenül javasoltam én is pár napja, tényleg ügyes.

Nem véletlenül javasoltam én is pár napja, tényleg ügyes.

Amúgy meg simán lehet, hogy a Google áll megint nyerésre, AI fronton is, még ha mostanság minden az OpenAI-ról is szól. A Gemma is ügyes, de leginkább a Gemini borzalmasan nagy kontext windowja (talán 2 millió tokenes, ha jól emlekszem) miatt több mindent tud fejben tartani... -

Mp3Pintyo

HÁZIGAZDA

Tényleg elképesztő jó. Indítottam én is egy Podcast csatornát a Spotify felületén.

-

-

consono

nagyúr

Csak vicceltem

Megy a hype keltés mindenhol, hogy milyen veszélyes az AI, ezért sütöttem el a poént.

Megy a hype keltés mindenhol, hogy milyen veszélyes az AI, ezért sütöttem el a poént.

Amúgy biztosan vannak ilyen rendszerek, ML alapú anomália detekcióval rég óta foglalkoznak access logok analizálásánál, de talán a hálózati forgalomnál is. Sajnos most konkrét példát nem tudok előhúzni. -

-

5leteseN

senior tag

...és az LMStudionak most jött kia 2.20-as verziójára a ROCm.

Ma kezdem próbálgatni, hogy az én régebbi AMD-kártyáimon fut-e, mert alapból a 6600(XT)-től felfelé futna csak, de "megesett" már párszázszor, hogy a nem bejelentett régebbi modelleken is mentek programok/driverek, egyebek.További jó hír, AMD-seknek hogy az LMStudió már fut 8GB VRAM-os AMD-ken is(akár RX580/8GB VRAM-oson is) a korábbi irreális 16GB helyett.

Még 1-2 évtized és az AMD utoléri a jelenlegi nVidia szintet!

Állítólag a ROCm közelíti a CUDA-t. Van valakinek saját tapasztalata?

-

-

consono

nagyúr

Hát én két dolgot használtam, az "upscale or variation"-t, ott betöltöd lentre a képet, beírod a promptot és kiválasztod, hogy mit akarsz: átdolgozás (kis vagy nagy mértékűt), átméretezést.

A másik amit kipróbáltam az "inpaint or outpaint", ugyan úgy betöltöd a képet, az outpaintnél megadhatod melyik irányban rajzoljon hozzá a képhez. Van az "improve details", azt is használtam, ott meg lehet adni, hogy szemet, kezet, stb. mit javítson. -

5leteseN

senior tag

"Modern-Világ"

![;]](//cdn.rios.hu/dl/s/v1.gif)

Biztos, hogy ilyen lovat akartam?

Kiegészítettem a run_AMD.bat állományomat:

--------------------------------------

.\python_embeded\python.exe -m pip uninstall torch torchvision torchaudio torchtext functorch xformers -y

.\python_embeded\python.exe -m pip install torch-directml

.\python_embeded\python.exe -s Fooocus\entry_with_update.py --directml.\python_embeded\python.exe -s Fooocus\entry_with_update.py --normalvram --use-split-cross-attention

pause

----------------------------------------Ezt is javasolták: --use-split-cross-attention

...nyomtam az ENTER-t, és:

----------------------------------

\Fooocus>.\python_embeded\python.exe -s Fooocus\entry_with_update.py --directml

Already up-to-date

Update succeeded.

[System ARGV] ['Fooocus\\entry_with_update.py', '--directml']

Python 3.10.9 (tags/v3.10.9:1dd9be6, Dec 6 2022, 20:01:21) [MSC v.1934 64 bit (AMD64)]

Fooocus version: 2.1.824

Running on local URL: http://127.0.0.1:7865

To create a public link, set `share=True` in `launch()`.

Using directml with device:

Total VRAM 1024 MB, total RAM 65458 MB

Set vram state to: NORMAL_VRAM

Disabling smart memory management

Device: privateuseone

VAE dtype: torch.float32

Using sub quadratic optimization for cross attention, if you have memory or speed issues try using: --use-split-cross-attention

Refiner unloaded.

...

--------------------------------------

A vége mondjuk ez:

-----------------------------------

Fooocus V2 Expansion: Vocab with 642 words.

Fooocus Expansion engine loaded for cpu, use_fp16 = False.

Requested to load SDXLClipModel

Requested to load GPT2LMHeadModel

Loading 2 new models

App started successful. Use the app with http://127.0.0.1:7865/ or 127.0.0.1:7865

------------------------------------------------------Akár jó is lehet.

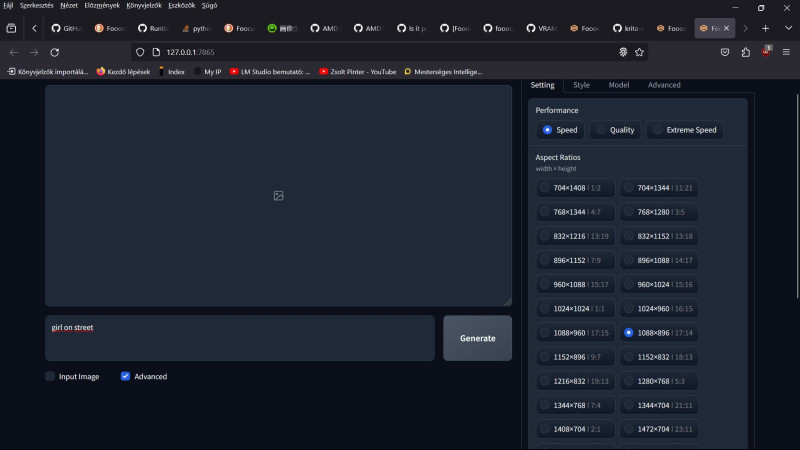

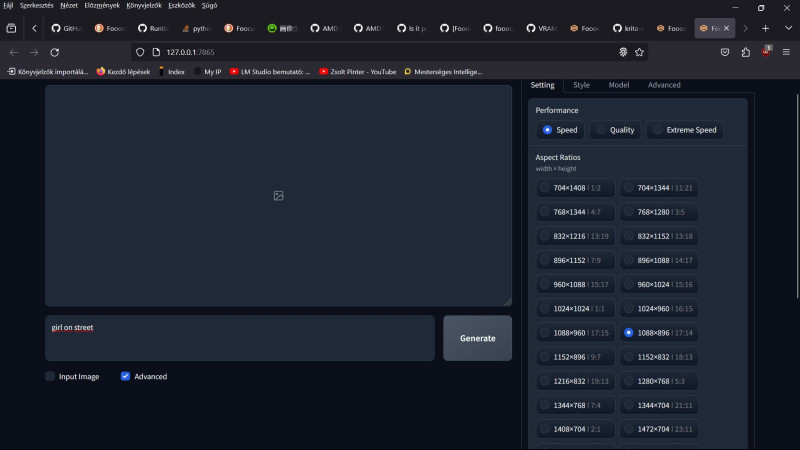

Nézzük a "Girl on street" klasszikust:

----------------------------

return tensor.to(device, copy=copy).to(dtype)

RuntimeError: Could not allocate tensor with 117964800 bytes. There is not enough GPU video memory available!

Total time: 45.18 seconds

--------------------------------------------------

Ehy kép generálást állítottam be és legkisebb felbontásúra tettem a képméretet:

-----------------------------------------

... \Fooocus\Fooocus\backend\headless\fcbh\model_management.py", line 532, in cast_to_device

return tensor.to(device, copy=copy).to(dtype)

RuntimeError: Could not allocate tensor with 117964800 bytes. There is not enough GPU video memory available!

Total time: 10.42 seconds

----------------------------------------------

Az sem sejtetett sok jót nekem, hogy a Firefox-os saját szerveres Fooocus oldal így nézett ki

... amikor működött, közepén megjelent egy a kis állapotjelző szimbólum. Amióta nem működik a Fooocus, azóta a középen látható "hiányzó elem" szimbólum látható a helyén.

Ez csak érdekesség volt.

-

consono

nagyúr

Értettem, és igazad is van

5leteseN Az 1 GB VRAM használatra AMD-n megpróbálhatnád a Fooocus run.bat-jába beletenni a --normalvram kapcsolót a a xxxx.py mögé. Nekem így indulásnál már azt mondja, hogy NORMAL_VRAM módban megy, de generálásnál még mindig azt mondja, hogy loading in lowvram mode és csak 2GB-t használ, pár pillanatra meg fel a képgenerálás végén 4-re. MAjd még nézegetem.

-

5leteseN

senior tag

Sirááály ez a Krita! Ugyan a Fooocus-om szerintem jobb/szebb képeket csinál(lassabban, több hibával), de az a kreatívitás, amit ez az AI-val kiegészített Krita lehetővé tesz, az nekem FANTASZTIKUS! Kis elszántsággal lehet csodákat létrehozni sok-sok éves (száz-ezres)Adobe/Gimp(ingyenes)/és-hasonlók megtanulása és gyakorlata nélkül !

-

User_2

tag

annyi különbséggel, hogy azure esetén talán van valamennyi esély arra, hogy nem eresztik rá az MI-t, de ha egyből MI-be pumpálod az adatokat az nagy könnyebbség.

nem az egyedi vállalat egyedi adata az érdekes, hanem a sok vállalat sok egyedi adatából szintetizált és gyártott trend és outliners az érdekes.

és ez már alkalmas pénzcsinálásra, úgy hogy egyedi adatszivárgásra nem visszavezethető. -

Mp3Pintyo

HÁZIGAZDA

A ChatgPT jelenleg multimodális modell amit a többiek meg sem közelítenek. Ha csak specifikus felhasználás kell és pl mondjuk pont programozá mintha azt említetted volna akkor egy arra finomhangolt modellt kell használnod.

Oobabooga + egy megfelelő LLM letöltve hozzá.

Itt a Colabos változata (nem teszteltem): https://github.com/camenduru/text-generation-webui-colab -

Mp3Pintyo

HÁZIGAZDA

Igen, sajnos nincsen már trial. De rengeteg alternatíva van ami ingyenesen elérhető. A DALL-E 3 berúgta keményen az ajtót. Nagyságrendekkel jobban megérti a promptot, hogy mit szeretnél ha mondjuk természetes nyelven leírsz egy jelenetet. A Bing-en keresztül ingyenesen használható.

Új hozzászólás Aktív témák

Hirdetés

- Easun iSolar SMW 11kW Twin Hibrid inverter // Dupla MPPT // BMS // WiFi

- GAMER PC : RYZEN 7 5700G/// 32 GB DDR4 /// RX 6700 XT 12 GB /// 512 GB NVME

- GAMER MSI LAPTOP : 15,6" 144 HZ /// i5 12450H /// 16GB DDR4/// RTX 4050 6GB/// 1TB NVME

- Manfrotto 055 magnézium fotó-videófej Q5 gyorskioldóval

- Sony ECM-W2BT

- Azonnali készpénzes Intel i3 i5 i7 i9 8xxx 9xxx processzor felvásárlás személyesen / csomagküldés

- Epson Workforce DS-530II Dokumentum szkenner

- Új Apple iPhone 16e 128GB, Kártyafüggetlen, 3 Év Garanciával

- LG 27CN650N-6A - Felhő Monitor - 1920x1080 FHD - 75Hz 5ms - USB Type-C - Quad Core - BT + WiFi

- 0% THM részletfizetés, beszámítás! ÚJ 27% 3 év AMD RX 7900 XT / 7900 XTX készletről KAMATMENTESEN!

Állásajánlatok

Cég: Promenade Publishing House Kft.

Város: Budapest

Cég: PC Trade Systems Kft.

Város: Szeged

+ Muti-muti("mutasd"

+ Muti-muti("mutasd"

![;]](http://cdn.rios.hu/dl/s/v1.gif)