- Google Pixel topik

- Motorola Signature - mielőtt aláírnád...

- Okosóra és okoskiegészítő topik

- Megjöttek Magyarországra a Redmi Note 15-ök, január 22-től ennyiért kaphatók

- iPhone topik

- Xiaomi 15T Pro - a téma nincs lezárva

- Vivo X200 Pro - a kétszázát!

- Samsung Galaxy S25 Ultra - titán keret, acélos teljesítmény

- One mobilszolgáltatások

- Samsung Galaxy S24 Ultra - ha működik, ne változtass!

-

Mobilarena

Sziasztok, udvozlunk mindenkit Magyarorszag legnagyobb VMware forumjaban!

Új hozzászólás Aktív témák

-

Konflikt

addikt

válasz

TheProb

#3799

üzenetére

TheProb

#3799

üzenetére

host warning:

igen, SSH miatt lehet.

host summary-n mi latszik?

host monitor -> issues -> all issues alatt kell lenni egy bejegyzesnek - pl. h az SSH engedelyezve van, az dobal warningot. (lehet suppresselni amugy, es akkor eltunik)VM alarm: szinten monitor -> issues szekcio a VM-en. latni fogod mi a baja.

-

TheProb

veterán

válasz

kraftxld

#3796

üzenetére

kraftxld

#3796

üzenetére

web client, ja. (mi más?

)

)

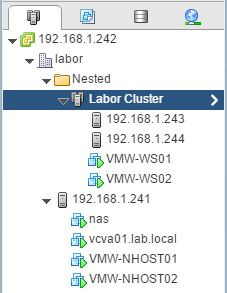

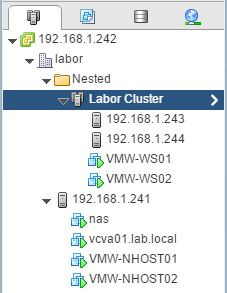

Nem-nem, ahogy nézem még FT sincs beállítva a kritikus VM-ekre se...Itt 1 screen, nemtom miről szeretnél konkrétan. Ebben látszik az is, hogy ha megnézem a kifogásolt hoszton a hw status\alerts & warnings-ot, akkor üres. Log-ban szintén nincs semmi aktuális bejegyzés továbbra se.

-

TheProb

veterán

Sziasztok!

1. vCenter-ben az egyik hostunkra "host warning"-ot ír a rendszer, viszont semmi további infó nincs ezzel kapcsolatban. Gyakorlatilag ez nulla infó, hol kéne keressem, hogy pontosan mi a kehe?

2. Pont a 2 termelési szerverünkre meg azt írja, hogy powered off state-ben vannak, holott pingelni vígan lehet őket és még a termelésből se sikítottak, hogy bármi gond lenne. Ez mitől van? OoD VMware Tools-ra viszont figyelmeztet több guest-nél is, ez lehet a "bug" forrása? -

-

-

bucihost

senior tag

Sziasztok itt is leírom a gondom, hátha

Teljesen át állnék linux használatára, de van 3 program ami miatt elengedhetetlen a windows megléte.

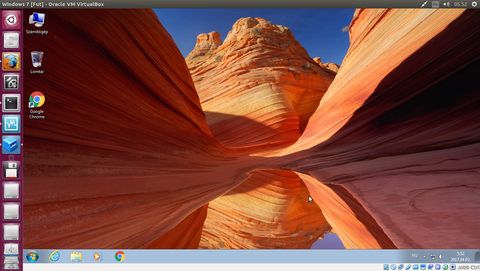

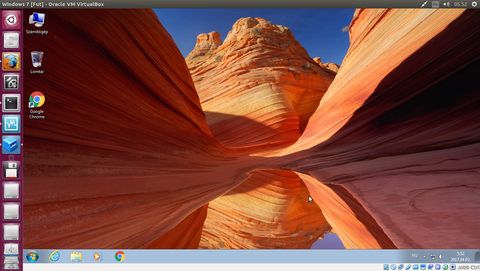

Gondoltam, hogy ha már van egy 6+HT-s xeonom, 12 giga rammal, akkor miért nem virtualizálnám a windows.Ez meg is van. Ubuntu 16.10 alapon, virtualbox, az alatt a win7 x32. Kapott 2+2 magot, meg 4 giga ramot.

Az szükséges programok (Photoshop, Office család, Sam Broadcaster) tökéletesen futnak, működnek, teszik a dolgukat. A probléma ott kezdődik, hogy a mikrofon recseg a VM alatt. (linux alatt tökéletes) Már próbáltam mindent, hogy mi lehet a baj de semmi nem oldotta meg.Próba gyanánt feltettem a VMware player-t, és abba is felraktam ugyan azon rendszert és programokat, ott viszont tökéletes a mikrofon. Látszólag minden ugyan az, mint a virtualboxban, ugyan ugy pulse / intel hd audio, ugyan azok a winses driverek. Mi lehet a gond? találkoztatok már ilyennel?

végül is a vmwplayer is jó lenne nekem, de ahogy nézem abban nincs interakció lehetőség a vboxxal szemben..

vagy csak nem találok?

vagy csak nem találok?

így:

-

kraftxld

félisten

-

Konflikt

addikt

irtam ide egy kis osszefoglalot a VMUG-rol

@(#3776) JasL: ugy emlekszem a free player is tud parhuzamosan tobb VM-et futtatni.

-

JasL

őstag

Sziasztok!

Úgy alakult, hogy én is virtualizálgatok, muszáj. Jelenleg Win10 alól Win10-et, néha linuxot. Az a kérdésem, hogy a VMware Player-nél a PRO licensz engedélyez több VM egyidejű futást? Nem derült ki számomra egyértelműen.

Egyelőre most a TRIAL workstation-nel játszom, a snapshot-ok miatt szimpibb, mint a Player. Igazából nem tudom, megéri-e a felárat a workstation verzió.

-

Konflikt

addikt

válasz

kraftxld

#3772

üzenetére

kraftxld

#3772

üzenetére

igen, a DC tekerese production-ben probelmas, nyilvan. nemtudom lett volna-e ra mas megoldas, ha nem tekerhettem volna.

egyebkent kb 5 percig toltam at, de nyilvan eleg lehet ezis, ha egy win eppen bootol valahol, stb. nalunk ugye 98% dev&test (abbol is 70% linux - amik nem erintettek), igy ennyi belefert

prezi-vel keszitettem

vegul nem jottel oda, en meg nemtudtam kit kell keressek

@bugizozi

irok rola majd egy osszefoglalot -

bugizozi

őstag

Sziasztok!

VMware Horizon 6-hoz honnan lehet beszerezni Eval licenszt?

Köszi!

ui: milyen volt a vmug?

-

Konflikt

addikt

-

Konflikt

addikt

(#3764) kraftxld: az kiraly, hajra

(#3765) bugizozi: sztem nincs hatarido. oylan is volt mar hogy valakit vittem es a helyszinen beregisztraltak

(#3766) AiRLAC: ilyenrol nem tudok, de az eddigieken sem volt

-

Konflikt

addikt

kedden VMUG. fogok beszelni self-signed SSL cert keszitesrol, csererol (es szivasokrol

) is. gyertek

) is. gyertek

-

bugizozi

őstag

Sziasztok!

Magam és az utókor számára egy jó leírás:

VMware Horizon 6 Composer telepítés

Külön SQL szervert kellett telepítenem és néhány fontos dolgot máshol nem nagyon írnak le, pl "Only SQL Authentication is supported.". Nem vagyok egy nagy adatbázis mágus, így nekem hasznos volt ez a szájbarágós leírás, főleg az ODBC terén.

-

Konflikt

addikt

-

kemot0001

újonc

Szia, köszi, jó ötlet, de sajnos nem.

Egyszer megvártam, amíg felállt így az XP, (kb. 1 óra volt!), és CTRL-ALT-DEL után láttam, hogy a taskmanager 100%-on pörgeti a virtuális CPU-t.Tehát olyan az egész, mintha a virtuális gép elindítása után valami rögtön ráülne a virtuális CPU-ra, és ez már a virtuális BIOS szinttől indulva tart...

-

kemot0001

újonc

Sziasztok!

Az a gondom, hogy egy szép reggelen a VMVare 12 alatt futó futó virtuális gépem kék halállal megállt. Azóta minden virtuális gépem iszonyatosan lassan fut, de már az op.rendszer indulása előtt is. Azóta újratelepítettem a VMWare-t, még a fizikai gépemet is helyreállítottam... Mi történhetett, és mi lehet a megoldás?

üdv: kemot

-

mexel

veterán

Sziasztok! Azt meg tudom oldani hogy a vmware-n telepített win lássa azt a meghajtót amire telepítve van a virtuális gép? Jelen esetben a D vinyón van 30 giga neki, de jó lenne ha látná a többit is.

-

laszak

tag

Ezen a tanfolyamon már részt vett valaki?

(Milyen hozzáadott értéket képviselt?)Üdv.

-

válasz

kraftxld

#3743

üzenetére

kraftxld

#3743

üzenetére

Nálunk ez napi tevékenység, pont tegnap volt egy ilyen

Régebben azért sírtatok hogy max virtual disk méret 2TB, most van 62TB-512byte, nektek semmi se jó?!?

Mondjuk a linkelt post hibás egy kicsit, ha egyszer kikapcsolt állapotban növelted a diszket 2TB fölé, akkor utána már volt hot-extend megint.

-

kraftxld

félisten

Jee, ezt sikerült szépen beszopni régebbi vCenter-el: [link]

Eddig nem tudtam róla, valahogy nem marketingelték

-

balaaa88

aktív tag

válasz

Konflikt

#3739

üzenetére

Konflikt

#3739

üzenetére

Köszi a kiegészítéseket,

valószínűleg nem fogom túlbonyolítani.A storage felé (ha szükséges) meglesz a 2 x 10 Gbps a teljes hál. útvonalon (azt, hogy a storage mennyit tud, nem tudom pontosan, de eleget).

A backup szervernél limitálva vagyok az előtte lévő SW-n és a szerveren is 2 x 1 Gbps-ra.Viszont ha kell, tudok replikát iSCSI-ra is gyártani, ami mint ahogy írtátok, tudja alapból a multipathing-ot.

Szóval össze lesz ez kalapálva csak kicsi a környezet meg még nem 100%-os a tervezet sem.

-

Konflikt

addikt

válasz

balaaa88

#3736

üzenetére

balaaa88

#3736

üzenetére

az osszes load balancing algoritmus vSphere-ben akkor mukodik jol, ha vagy a fogado vagy a kuldo oldal tobb vegpontos, igy tud forgalmat elosztani az elerheto osszes linkre. hogy milyen modon teszi, ezt tudod csupan beallitani. (n:m, n:1, 1:m OK)

1:1 eseten (pl. 1 VM-et mentesz ki egy VEEAM szerverre) nem lesz kihasznalva egynel tobb link soha. egy adatfolyamot sem a vSphere algoritmusai, sem az LACP nem bont szet es kuldi ki tobb linken.a masik dolog: jolhangzik a 2x10G link, de minden tudna ezt utkozben? (osszes NIC, switchek, diskek, tombok, disk vezerlo..) mert jellemzoen nem a link szokott a szuk keresztmetszet lenni.

-

Lejárt a szerk....

Szóval az jutott még eszembe, hogy az szép feladat lesz, hogy etherchannelt konfigurálsz a VM-ek load balancingje miatt, de közben ugyanezeken az interfaceken akarsz majd multipath-ozni iscsi-val.

Elvileg LACP-vel megy (nem próbáltam), olyan formában, hogy az iscsi-hoz rendelt 2db vmk interface (1-1 kell ugye mindegyik 10G-s NIC-hez) teamingjét override-olod, és csak 1-et hagysz benne.

Tehát a VM port gorupukhoz a teaming:

- nic1 active

- nic2 activeiscsi vmk1-hez:

- nic1 active

- nic2 unusediscsi vmk2-höz:

- nic2 active

- nic1 unusedMivel te nem fogsz tudni LACP-t csinálni, csak etherchannelt, így azt ki kell próbálni, de véleményem szerint ugyanezzel a megoldással működhet. Így az iSCSI-nál is menni fog a multipath, és a vm-eknél is az ip hash alapú load balancing ugyanazon két interfacen.

Itt egy jó doksi a témában:

https://connect.nimblestorage.com/servlet/JiveServlet/downloadBody/1242-102-1-1173/LACP.pdf

Régi kicsit ugyan, és egy bizonyos storageről van benne szó, de ez figyelmen kívül hagyható.

-

válasz

balaaa88

#3736

üzenetére

balaaa88

#3736

üzenetére

iSCSI amúgy más tészta, mert ott ugye protokoll szinten van round-robin multipath, tehát nem szükséges bűvészkedni interface teamingel, simán megy 2x10G NIC-el a 20G, ha jól állítod be a bindinget esxi oldalon, és target oldalon is jó a multipath config. Az már persze más kérdés, hogy ez inkább elvi dolog, mert target oldalon gondolom nincs olyan storaged ami 20G-t ki tudna szolgálni

-

balaaa88

aktív tag

Köszönöm a válaszokat mindenkinek!

Cél, hogy a VM-ek mentése (és adott esetben visszaállítása) minél gyorsabban végbemenjen.

Ahogy leírtátok, már tiszta, hogy "normális" load balancing nem valósítható meg a vázolt konfigurációval.De ez úgy néz ki, egyelőre nem para, mert a backup oldalon korlátozva vagyok 2 Gbps-ra + a backup szerverben is csak sima HDD-k vannak.

Tehát az ESXi host oldaláról meglesz a 2 x 10 Gbps (úgy, hogy 1 VM max. 10 Gbps-ot tud elérni).

Az meg elég lesz egy esetleges iSCSI-ra + backupra.Köszi még egyszer.

-

Szerintem az általa vázolt felállásra nincs igazán megoldás. De javítsatok ki ha tévedek.

Ha jól értem, akkor az igazi kérdés az, hogy adott időben 1db vm tud-e 1db backup szerverrel komminikálni, úgy, hogy 20G-t kapjon (2x10G fizikai uplinken). A gond az, hogy ez esetben az ip hash és/vagy a virtaul port id mindig ugyanaz lesz, az esxi-nek pedig nincs olyan load balancing algoritmusa ami erre az esetre tudná biztosítani a 2db fizikai uplink összeadott sávszélességét, függetlenül a uplink teaming megoldástól (etherchannel vs. LACP)

Tehát 2x10G uplink esetén a vázolt forgalom mellett 1db vm-nek mindig csak 10G sávszélessége lesz a backup szerver felé. Persze több vm ki fogja tudni tolni a 2x10G-t, vagy 1db vm is ki tudja több darab backup szerver felé. Ez az egész független attól hogy LACP-t vagy etherchannlet használ (vagy pl LBT-t).

Esetleg alkalmazás vagy guest OS szinten lehet megoldani a dolgot, ha a backup megoldás tud kezelni több kliens oldali IP-t/interfacet, vagy ő maga képes 1db vm-et több saját interface-én menteni, akkor növelhető a sáv, tisztán vmware oldalon viszont nem.

Ha viszont eleve arról van csak szó, hogy a backup windowban a sok vm tudja kitolni mindkét 10G-s kapcsolatot (és nem feltétel hogy 1db vm is tudjon 20G-vel forgalmazni önállóan), akkor etherchannelt kell konfigurálnia mert LACP-t nem tud (nincs vCentere- > nincs dVS -> nincs LACP).

-

Immy

őstag

válasz

balaaa88

#3732

üzenetére

balaaa88

#3732

üzenetére

Ha a WAN kapcsolat 1Gbps akkor hiába csinálsz 2Gbps vonalat a WAN modem és az ESXi között, sebességben soha nem fogod átlépni az 1Gbps-et.

Más országokban terjed már az FTTH, ott várhatóan tudnál 1Gbps-nél többet kihasználni, azonban ott se kötném be közvetlenül az ESXi-be a szolgáltatótól kapott kábelt, hanem külön modemet/routert/tűzfalat használnék erre.

Helyi datastore-ot hogyan fogod kialakítani?

Remote storage, mennyire "remote"? Interneten valahol elérhető vagy esetleg site-to-site VPN-el egy másik "közeli" site-ról?Függ attól is, hogy a túloldali hálózati eszköz mit támogat: (lacp) 802.3ad / etherchannel

Itt egy jó leírás: https://kb.vmware.com/selfservice/microsites/search.do?language=en_US&cmd=displayKC&externalId=1004048 -

válasz

balaaa88

#3732

üzenetére

balaaa88

#3732

üzenetére

Itt szerintem minden kérdésedre megvan a válasz:

vCenter nélkül nincs dVS-ed, amivel két módot buksz:

- Route Based on Physical NIC Load (ez viszont nem érint)

- "Route Based on IP Hash" módban az LACP-tAmit tudsz standard vswitchel:

- "Route Based on IP Hash" módban etherchannelt

Mivel ez IP hash alapú, ezért akkor van igazán értelme ha a vm-jeid több destination IP-vel kommunikálnak egyidejűleg. Ha 1db vm-ed akar 1db valamivel kommunikálni, akkor a hash kalkuláció miatt mindig ugyanazon az uplinken fognak kimenni a csomagok, tehát plusz sávszélességet ebben az esetben nem nyersz.

-

balaaa88

aktív tag

Na.

Egy kicsit összekavarodtak a dolgok.Az eredeti terv szerint: 2 db, darabonként 2 portos, 10 Gbps-os NIC-ek lennének az ESXi host-ban.

Amiből 2 port menne a WAN felé, 2 port menne a "LAN" felé.

A WAN oldal csak 1 Gbps-os kapcsolattal rendelkezne (tehát a port 10 Gbps-os, de a "netsebesség" 1 Gbps-os lenne).

A storage alapértelmezetten local SSD-kel lennének megoldva.

Azért kerültek számításba a 10 Gbps-os NIC-ek, mert mivan ha akarunk remote storage-ot.

De erre jelenleg kicsi az esély.Szóval a kérdés, hogy:

standalone ESXi 6.x-el, (jelenleg) VCenter nélkül elérhető-e az valamelyik beépített NIC teaming megoldásával:

- Route based on the originating virtual port

- Route based on IP hash

- Route based on source MAC hash

- Use explicit failover order, hogy egy VM 2 db NIC port sebességét ki tudja használni? (Függetlenül attól, hogy most a port(ok) 1 vagy 10 Gbps-osak?

-

Immy

őstag

válasz

balaaa88

#3724

üzenetére

balaaa88

#3724

üzenetére

vCenter azért fog kelleni, ha normálisan akarod konfigurálni majd a jövőben...

Az ESXi-n fog futni egy tűzfal/router funkcionalitást ellátó virtuális gép, ezért akarod közvetlenül a WAN kapcsolatot bekötni (pl.: pfSense/Netgate)?

Alapvetően etherchannel használata esetén az elméleti sávszélesség összeadódik, azaz 2*10GB/s=20GB/s a Te esetedben. Azonban 2 végponti MAC cím között maradni fog 10GB/s a kihasználható sebesség. Plusz kliensek kellenek szimultán, hogy az etherchannel sebességét ki tudják használni.

Kétségkívül az etherchannel másik előnye a failover képesség, tehát ha az egyik kábel/switchport leszakad, attól függetlenül a kapcsolat tovább él. Ettől függetlenül én nem a WAN kapcsolatra "pazarolnék" el egy fizikai hálózati interface-t, hanem inkább a LAN-ra vagy ISCSI-ra, ahol ténylegesen nagyobb adatforgalom várható általában.

Ha kész az architektúra szívesen ránéznénk, hátha másnak is hasznos lesz a jövőben

-

balaaa88

aktív tag

válasz

kraftxld

#3727

üzenetére

kraftxld

#3727

üzenetére

A storage az local SSD-k lennének, a backup menne hálózaton másik szerverre.

És visszaállítás szempontjából lenne fontos a sebesség.Abban igazad van, hogy csak gigabites portokat írtam, míg valójában 4 x 10 Gbps-os portok lesznek az ESXi hostba.

Az iSCSI storage csak egy lehetőség lenne, hogy azok a vm-ek, akiknek nem kellene ssd, azok mehetnének iscsi-n hdd-ken. Szerintem a 2 x 10 Gbps-al nem lenne probléma az ISCSi (elvileg tud round robin-t de valahol mártuti állítottam be).Vagy van még valami ellenérzésed így is vele?

-

balaaa88

aktív tag

Sziasztok!

ESXi NIC Teaming-el kapcsolatos kérdésem lenne:

Adott 1 db ESXi 6.x, licencel rendelkező host. VCenter nélkül.

Az ESXi hostban van 4 db 1 Gbps-os hálózati port.

2 db port lenne használva a WAN forgalomra.

2 db port lenne használva a többi forgalomra (backup, iSCSI, management, stb.) VLAN-ozva.Kérdés:

Lehetséges-e az, hogy a backup forgalomra (is) használt portokon történő adatmásolás esetén a két hálózati port sebessége egyszerre elérhető legyen? Tehát kb. 2 Gbps-al tudnék másolni.

Körülírva:

Úgy tudom, hogy VCenter nélkül, illetve virtual distributed switch nélkül az ESXi önmagában nem ismeri az LACP protokollt. Viszont default-ban van néhány load balancing-os és failover-es megoldása. Ezek ugye kvázi load-balancing megoldások:

- Route based on the originating virtual port

- Route based on IP hash

- Route based on source MAC hash

- Use explicit failover orderA fentebbiek közül valamelyik megoldás beállítása esetén elérhető-e az, hogy a két port sebessége "összeadódjon" mondjuk Veeam B & R mentése vagy visszaállítás esetén?

Köszik előre is.

-

MeTaL

tag

Miért van szükség 2 db domain controller-re? Nézek youtube videókat és ez még nem derült ki számomra. Egy tippem van, de sztem ez csak fél megoldás. Az , hogy ha lehal az egyik, akkor ott legyen a másik.

Köszi előre is.

-

MeTaL

tag

Sziasztok,

Ha a Vmware oldaláról le szeretnék szedni ingyenes cuccokat, azokat 60 napig ingyenesek. Tanulás céljából szedném le, tudnátok valami megoldást ? 60 nap kevés lesz. Köszi

-

TheProb

veterán

VMXNET 3-nál mi ez a DirectPath I/O? Amennyire sikerült kiguglizni ez is olyan, mint a SR-IOV passthrough, közvetlenül átadja a fizikai NIC-et a vm-nek? Viszont azt honnan tudja,hogy melyik fizikai adaptert akarnám natívan átadni?

Most ez csak azért merült fel, mert most nézem, hogy az összes VMXNET3-mas adapteremnél ez van kapcsolva és nem értem mért...

-

TheProb

veterán

Fizikailag 1 gép sajnos, másikon Hyper-v megy, ugyan ebben a felépítésben.

HA/DRS igen, nested hostonként 1-1 Win Server tesztelési céllal.

Mivel Hyper-V környezetben nem kell "shared storage", így nem volna rossz, ha itt is ki lehetne iktatni a virtual NAS-t, hogy minél egységesebb legyen a 2 környezet felépítést tekintve.

-

bpx

őstag

válasz

TheProb

#3712

üzenetére

TheProb

#3712

üzenetére

Van beépített, csak körülményes (lehet más megoldásokhoz képest), saját játszós környezetben ezt szoktam használni:

Ha a leírás szerint csinálom, grafikus felületről, akkor nekem nem szokott menni, de ha direktben beleírom a .vmx-be a multi-writer flaget a megfelelő device-hoz, akkor működik.

A virtuális NAS annyival tud többet (pl. iscsi), hogy menet közben lehet átméretezni, hozzáadni, elvenni + nem kell előre allokálni a teljes méretet.

-

TheProb

veterán

Sziasztok!

Milyen virtual SAN-nal megcsinálni a shared storage-ot clusternek? Eddig mindenki azt mondta, hogy csináljak egy virtuál NAS-t (laborhoz), mert beépítetten nem lehet megcsinálni, erre múltkor olvasom, hogy van ilyen megoldás is.

-

anarchic

tag

Sziasztok!

VM-ek költöztetését, hogyan tudnám legegyszerűbben végrehajtani?

250-es HDD-n van minden kb 14gb helyet foglalnak.

Egy 60gb-os SSD-re menne át. -

kelna91

senior tag

válasz

bugizozi

#3706

üzenetére

bugizozi

#3706

üzenetére

Ezt így nem szeretném, de kösz a tippet.

Viszont most azon gondolkodom, hogy ha az IGP nem lesz megfelelő, és két VGA-t kell az alaplapra tennem, akkor milyen teljesítményre lesznek képesek a kártyák? Mert ugye a Kaby Lake csak 16 PCI lane-t támogat, és egy GTX1050 vagy 1060 x16-os, vagyis kettő egymás mellett csak x8 üzemmódban fog működni. Ilyenkor mi van? Igaz ugyan, hogy nem terhelném mindkét kártyát egyszerre, de azért képet mindkettő 4k-ban adna. Adna??

-

kelna91

senior tag

Hű, ez nem hangzik egyszerűen...

A VT-d adott lesz, mert i7-7700K lesz a proci, viszont ezt a dupla VGA dolgot jó, hogy mondod. Még jó, hogy olyan procit választottam, amiben van IGP. A VGA-t később akartam beszerezni, de ezek szerint nem tologathatom.2 órával és sok-sok olvasással később...

Ez nem lesz egy egyszerű menet. Külön problémát jelent, hogy 4k monitorom van, és az IGP nem támogatja a 60Hz-es megjelnítést HDMI-n, csak DP-on, az viszont nincs a kijelzőmön. Viszont egyes Gigabyte lapokban van egy integrált DP->HDMI 2.0 konverter, viszont nem minden esetben működik hibátlanul. Lehet viszont kapni másfajta, külső konvertert, de az sem minden esetben működik hibátlanul. Gyakorlatilag amíg ki nem próbálom, nem lehet kideríteni, hogy menni fog-e.

Ez nem lesz egy egyszerű menet. Külön problémát jelent, hogy 4k monitorom van, és az IGP nem támogatja a 60Hz-es megjelnítést HDMI-n, csak DP-on, az viszont nincs a kijelzőmön. Viszont egyes Gigabyte lapokban van egy integrált DP->HDMI 2.0 konverter, viszont nem minden esetben működik hibátlanul. Lehet viszont kapni másfajta, külső konvertert, de az sem minden esetben működik hibátlanul. Gyakorlatilag amíg ki nem próbálom, nem lehet kideríteni, hogy menni fog-e.

Úgyhogy még az is lehet, hogy két VGA-t kell vennem. Bár redditen pedzegették, hogy az átadott VGA-t lehet rebindolni az X újraindításával...Aztán még itt van a memóriaprobléma. Állítólag a guest OS-ben a nagyobb memóriaigényű programok belassulnak, mert valami nem optimális a RAM page-ek kezelésével. Ezt ki lehet küszöbölni huge page alkalmazásával, ez viszont azt jelenti, hogy a guestnek előre allokálni kell az átadni kívánt memóriát, amit a VM kikapcsolt állapotában is nélkülöz a host! Vagyis hiába veszek 32GB RAM-ot, hogy az milyen jó lesz majd vágáshoz, és marad a hostnak is elég, mert ha átadok 24GB-ot a windowsnak, akkor Linuxon be kell érnem konstans 8GB-tal. Ez így elég szívás. Persze kérdés, mekkora teljesítménycsökkenés van huge pages nélkül.

Lehet, hogy az lesz a vége, hogy maradok a dual bootnál. Azért ki fogom próbálni a VM-et, de nem vagyok túl optimista ezek után. Pedig milyen jó ötletnek tűnt!

Akit érdekel, annak itt [egy nagyon jó leírás] a passthrough beállításáról.

-

kraftxld

félisten

-

kelna91

senior tag

Sziasztok!

A munkamhoz szuksegem van az Adobe termekeire, pl. Premiere Pro, Photoshop, Audition, viszont semmi masra nem hasznalom a windowst, es nem is szeretem. Minden mast Linuxon vegzek, mert azt szeretem. A dual boot viszont nagyon megneheziti az eletemet, es szeretnem ha vegre tudnek egyszerre videot vagni es banki atutalast vegezni vagy jatszani kicsit (azt is Linuxon termeszetesen).Azt tervezem, hogy a Linuxomra telepitek egy VMware-t, es abban futtatom a windowst. Utanaolvastam kicsit, es ugy tudom, hogy van olyan hogy vga passthrough, amivel a virtualis gep nativan hozzafer a videokartyahoz. Igy akkor elvileg a gep minden potencialjat ki tudja hasznalni, igaz? Szoval siman menni fog minden gepigenyes feladat, nem fog belassulni a rendereles, az elokep stb., ugye? Mert a procit tudja maxon hajtani, a memoriabol tudok neki sokat adni, es ha a vga is megoldott, akkor nem lehet gond.

Menni fog ez igy? Koszi elore is!

-

skoos

őstag

Sziasztok,

MacBook Pro+ VmWare Fusion 7.1 + Win10

Nyomtató gondom van, semmit nem tudok hozzáadni.

Az MBP-n két nyomtató van telepítve

VMware (elvileg) ugyanazt az alapértelmezett nyomtatót használja és minden nyomtató sharelve van a VMwareben.Semmit nem talál, ad hozzá, vagy lenne telepítve. Documetom Writer, Pdf nyomtató és Fax-ot ajánl a Win.

Már minden beállítást végigpróbáltam, de semmi.

Bármi javaslat?

Új hozzászólás Aktív témák

- 192 - Lenovo Legion 5 (15IRX10) - Intel Core i7-14700HX, RTX 5060 (ELKELT)

- Bomba ár! Lenovo IdeaPad 3: i3-10GEN I 8GB I 256SSD I 14" FHD I Cam I W11 I Garancia!

- Bomba ár! Dynabook Portege X30-G - i5-10210U I 8GB I 256SSD I 13,3" FHD I Cam I W11 I Garancia!

- GYÖNYÖRŰ iPhone 14 128GB Midnight-1 ÉV GARANCIA - Kártyafüggetlen, MS4496

- Lenovo ThinkStation P300 Workstation,i7-4790,8GB DDR3,500GB SATA3 HDD,2GB VGA,WIN11

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

)

)

nem Interakció hanem integráció, bocsi

nem Interakció hanem integráció, bocsi  vagy csak nem találok?

vagy csak nem találok?

![;]](http://cdn.rios.hu/dl/s/v1.gif)