- iPhone topik

- Kijelző került a kamerasávra a Xiaomi 17 Pro és 17 Pro Max hátulján

- Vivo X200 Pro - a kétszázát!

- Mobil flották

- Xiaomi 13T és 13T Pro - nincs tétlenkedés

- Azonnali mobilos kérdések órája

- Apple Watch Ultra - első nekifutás

- Apple iPhone Air - almacsutka

- Huawei P30 Pro - teletalálat

- Samsung Galaxy S24 Ultra - ha működik, ne változtass!

Új hozzászólás Aktív témák

-

HSM

félisten

válasz

Petykemano

#7159

üzenetére

Petykemano

#7159

üzenetére

Az SMT hatásfokához erősen hozzájárulhat, hogy növelni tervezik a pipeline hosszát (nagyobb késleltetés/büntetés, ha nem jött be pl. az elágazásbecslés) valamint alapból az Infinity fabric miatt van némi extra késleltetés. A megnövelt gyorsítótárak miatt akár lehetne is lehetőség növelni az SMT-s szálszámot, bár szerintem ott már könnyen problémássá válhatna ez szoftver oldalról, egy 8 magos procihoz is már 32 szálra skálázódó szoftver kellene...

-

HSM

félisten

válasz

Petykemano

#7129

üzenetére

Petykemano

#7129

üzenetére

Amit írsz teljesen jogos. Sajnos úgy tűnik, minden durván drágul, ugyanazért a termékkategóriáért egyre mélyebben kell zsebbe nyúlni. VGA fronton is ez a trend sajnos.

Mondjuk ettől függetlenül 6 magért durva lenne $450, ennyivel nem ígérkezik jobbnak.

-

HSM

félisten

válasz

Petykemano

#7122

üzenetére

Petykemano

#7122

üzenetére

"Egyben azt is jelenti, hogy miközben persze szélsebesen nő az az egyszálas teljesítmény, csúszunk vissza a 8 magból a 4 magba (mainstream)"

Mivel az elődje (Van Gogh) is négymagos volt, így nem tűnik számomra ez "visszalépésnek".

Én úgy látom a piacot, hogy egyre nagyobb igény van kézikonzol méretű játékos PC-kre (a Steam Deck csak egy kiadás), illetve az asztali belépőszint (négymagos i3 felségterület) is eléggé el volt hanyagolva, lehet, így már megéri ide is hozni valami harapósabb, modern csipet, ha van rá elég gyártókapacitás. A "mainstream" szvsz maradt 8 magon (Rembrandt). -

HSM

félisten

válasz

Petykemano

#7088

üzenetére

Petykemano

#7088

üzenetére

"Egyébként ennek megfelelően - nyilván persze power okokból - a Zen3 MT teljesítménynövekedése alacsonyabb volt, mint a ST."

Itt azért hozzátenném, hogy a szálak között sok adatot cserélő MT alkalmazásoknál a Zen3 a duplaannyi magot tartalmazó CCX-eivel szó szerint felmossa a padlót a Zen2-vel.

Szálfüggetlen MT tesztekben nagyon megy a Zen2 (pl. Cinebench), de a gyakorlatban sok alkalmazásban ezt nem tudod belőle előcsalogatni (pl. játékok). Szóval szvsz MT-ben is a korábbi Zen-ek legnagyobb gyengeségét javították, így elég komoly előrelépésnek tekinteném.

-

HSM

félisten

válasz

GeryFlash

#7055

üzenetére

GeryFlash

#7055

üzenetére

Azt hittem, ezt már megtárgyaltuk a VS-ben.... (Utolsó bekezdés [link] )

És mint azóta megmérték, az M1 Pro-tól már a korábbi AMD-k sem voltak lényegesen jobban lemaradva, mint ami a magszám különbségből következik. [link]

A Macbook árával tisztában vagyok. Úgy tűnik, te nem vagy tisztában a Macbookok üzleti modelljével. Egyébként a Ryzen 7000-esek árazására írtam a 2500-3000 dollárt, arra az esetre ha 30-60 milliárd tranzisztorból építenék fel a vélhetően nem épp olcsó 5nm-es eljáráson.

Úgy tűnik, te nem vagy tisztában a Macbookok üzleti modelljével. Egyébként a Ryzen 7000-esek árazására írtam a 2500-3000 dollárt, arra az esetre ha 30-60 milliárd tranzisztorból építenék fel a vélhetően nem épp olcsó 5nm-es eljáráson.

-

HSM

félisten

válasz

GeryFlash

#7052

üzenetére

GeryFlash

#7052

üzenetére

"az AMD mit tudna felmutatni az Apple M1 pro-val szemben ugyanolyan fogyasztas mellett"

Ennek továbbra is csak akkor lenne bármi értelme, ha hasonló tranzisztorszámról is beszélnénk.

Az M1 Pro/Max-nál teljesen egyértelmű, hogy a legkevésbé sem spóroltak a tranzisztorszámmal, de egy kevésbé rétegtermék esetén viszont egészen más a tervezési szempont. Ami egyébként szvsz örvendetes, én pl. nem örülnék neki, ha mondjuk 2500 dollár lenne a 12 és 3000 a 16 magos modell.

-

HSM

félisten

válasz

paprobert

#7048

üzenetére

paprobert

#7048

üzenetére

"ez a felső órajel-régióban már nem ad hozzá annyit az effektív sebességhez"

A magon belüli késleltetések általában órajelfüggők, pl. L2 késleltetés - 4 órajel, tehát ha nő az órajel, csökken a késleltetés. Így nem nagyon fordul elő, amit írsz.

Persze, más szűk keresztmetszetek előkerülhetnek, pl. memória sávszélesség vagy késleltetés, amik miatt romolhat a skálázódás. -

HSM

félisten

válasz

S_x96x_S

#7022

üzenetére

S_x96x_S

#7022

üzenetére

Köszi a linket, érdekes volt.

#7024 Petykemano : Az elméleted támasztja alá az is, hogy ha jól emlékszem, az eredeti, Warhol/Zen3+ magoknál is előkerült ilyen pletyka, hogy azért került törlésre, mert "jól haladtak" a Zen4-el.

Lehet, hogy az eredeti Warholt/Zen3+ rakták át AM5/5nm-re, a "valódi" Zen4 meg majd jön egy következő generációval? A SA-s kalkulációk alapján kb. ez a félgenerációs IPC + egy generációs gyártástechnológiai előrelépés látszik....

A SA-s kalkulációk alapján kb. ez a félgenerációs IPC + egy generációs gyártástechnológiai előrelépés látszik....

Feltételezhetően ezt így "eladni" is könnyebb lenne, hogy előbb készült el aWarholkhm Raphael, mint kihozni még egy generációt AM4-re, és égni, hogy hát hogy ennyit meg annyit késik a nagyágyú... A lapgyártók is gondolom már tűkön ülve várták, mikor lehet ellőni a rajtot az újdonságoknak. -

HSM

félisten

válasz

S_x96x_S

#6976

üzenetére

S_x96x_S

#6976

üzenetére

Teljes mértékben egyetértek vele.

Nem véletlen írtam már januárban: "a skálázódási probléma megoldási kényszerének áthárítására a szoftverekre, szoftverfejlesztőkre" [link] .

Illetve: "...a hardveresek átdobták a problémát a szoftvereseknek, amiből ritkán szoktak jó dolgok kisülni" [link] (Itt írtam az ARM megoldásáról is.)

De 2021 közepéről is érdekes az utolsó bekezdés innen: [link] ."persze ezzel majd az AMD-nak is meg kell küzdenie majd"

Úgyérted a szoftverfejlesztőknek, akiknek +1 speciális architektúrára kell majd optimalizálni?![;]](//cdn.rios.hu/dl/s/v1.gif)

Egyébként szerintem lehet(ne) ezt okosan csinálni, hogy kellőképpen hasonlóak legyenek a magok ahhoz, hogy ne legyen ennyire kényes kérdés, mi, hova ütemeződik. Tehát a jó irány szerintem az lenne, ha azonos módon kellene optimalizálni a magokra, elég lenne az, hogy a magasabb prioritású feladatok a gyorsabb, az alacsonyabbak a lassabb magokon futnának és a szoftverfejlesztőnek nem kellene másra már figyelnie.#6977 Petykemano: Ha jól tudom, ARM alatt az EAS rendszer segít be [link] . (Itt is ír pár dolgot, ami talán hasznos [link] .)

De ez nem teljesen ugyanaz a probléma, hiszen mobilon a prioritás az energiatakarékosság, míg az Alder esetében amarketingkhm,innováció,akarom mondani "throughput". Tehát röviden papíron az ARM azt csinálja, hogy arra a magra igyekeznek rakni a feladatokat, ami a leghatékonyabban el tudja végezni azokat. Abba most ne menjünk bele, hogy ez a rendszer sem olyan szép a gyakorlatban, mint így leírva....

#6980 S_x96x_S: "az ütemezés - szerencsére szoftveres, amin könnyű változtatni."

Az Alder problémájának azt a részét nem fogja az ütemező megoldani, hogy a szoftveredet mire optimalizáld, pl. van-e HT vagy nincs, vagy befékezi-e a buszt a kis mag vagy sem....

A Zen5-féle megoldásnál majd meglátjuk, hogyan sikerül összerakni a rendszert, lesznek-e hasonló gubancok vagy sem.#6986 Petykemano: Csak a Rembrandt nem hinném, hogy "elvinne" a lábán egy platform startot.

Az még AM4-nél is csak egy erős középkategória lenne. Kéne mellé még valami, ami kicsit nagyobbat szól.

Az még AM4-nél is csak egy erős középkategória lenne. Kéne mellé még valami, ami kicsit nagyobbat szól.

#6993 Pakmara: Pl. gyártási/tervezési költség optimalizálása. Az olcsóbb termékbe elég kevesebb periféria vezérlő/PCIe sáv, a drágábba viszont több kell, így pedig egy lapkával megoldják mindkét igény lefedését. Mint a processzoroknál, 8 magig 1 CCD-t, 8-16 között kettőt raknak rá.

-

HSM

félisten

válasz

T.Peter

#6877

üzenetére

T.Peter

#6877

üzenetére

Jogos az észrevétel. Úgy tűnik, a szoftveres is az általános GPU-s shadereket jelenti.

Ugyanakkor PC-n továbbra is áll, hogy a jelenlegi API-k nem feltétlen jelentenek optimális működést, hiszen konzolokon több minden érhető el.

Ugyanakkor PC-n továbbra is áll, hogy a jelenlegi API-k nem feltétlen jelentenek optimális működést, hiszen konzolokon több minden érhető el.

Bár volt róla szó, hogy lesz fejlődés, nem tudom ez végül megtörtént-e már [link] . Illetve ez is releváns lehet [link] . -

HSM

félisten

válasz

T.Peter

#6875

üzenetére

T.Peter

#6875

üzenetére

Most hirtelen ezt találtam: "Lumen also comes with hardware ray-tracing, but most developers will be sticking to the former, as it’s 50% slower than the SW implementation even with dedicated hardware such as RT cores. Furthermore, you can’t have overlapping meshes with hardware ray-tracing or masked meshes either, as they greatly slow down the ray traversal process." [link]

A korábban olvasottak alapján konzolon megy a ray gyorsítás, de PC-n nincs meg hozzá az optimális működéshez a traversal shader. Erről írt Abu is [link] . Hiába tudná a PC-s RDNA2, ha jelenleg nincs hozzá PC-n API.

Hogy a frissen kiadott fejlesztői változat pontosan mit és mennyire használ, azt viszont nem tudom pontosan, de traversal shader még nincs a DXR-ben.

-

-

HSM

félisten

-

HSM

félisten

válasz

Petykemano

#6833

üzenetére

Petykemano

#6833

üzenetére

"Kompromisszumok és szerény igények mellett"

Igen, jogos. Illetve nagyban függ attól is, ki mivel tervez játszani és hogyan. Pl. a teszteken lévő Battlefield single mérésekhez képest a játék CPU igénye multi módban egy nagyobb térképen lényegesen magasabb. Ebbe nem akartam túlzottan belemenni.

Illetve nagyban függ attól is, ki mivel tervez játszani és hogyan. Pl. a teszteken lévő Battlefield single mérésekhez képest a játék CPU igénye multi módban egy nagyobb térképen lényegesen magasabb. Ebbe nem akartam túlzottan belemenni.Tény az is, a hatmagosok is most nagyon jó árban vannak (~200 euró, ha jól látom egy 5600(X)), azok sem rossz vételek, főleg, hogy ahogy írod, átlagos igények mellé ma még bőven elégnek látszik az ereje.

-

HSM

félisten

A 10 éves FX már akkor gázos volt játszani, amikor megjelent...

De a 3770 is igencsak kompromisszumos volt már legalább 3-4 éve. Persze, nekem nem a kínkeserves, döcögős 60 FPS a cél.#6830 S_x96x_S : Én azért kivárnám, mire ezekből bármi látszani fog a gyakorlatban... Tippre szerintem ezeknek a következő 3 évben szinte semmi látható hatása nem lesz, míg mondjuk az új PCIE5 kompatibilis platform + DDR5 elég paprikás felárúnak tűnik már most is.

-

HSM

félisten

"IGen, az első gen Ryzen egyetlen gyenge pontja..."

Meg a gyenge lebegőpontos egység, a gyenge memóriavezérlő és a CCX-ekre osztottság. Szvsz nem véletlenül adták olyan olcsón, ahogyan.A 3600-as már a problémák nagyját megoldotta, de a kettévágott felépítése továbbra sem passzol jónéhány programhoz. Én 5 évre biztosan nem terveznék vele, hacsak nem 8K-n akarsz játszani brutális GPU-limittel, 2-3 reálisabb lehet, kisebb, inkább nagyobb kompromisszumokkal.

#6822 paprobert : "A jövővel kapcsolatban vannak nem alaptalan kétségeim."

Elnézve azt, hogy azért egész hatékonyan el lehet végezni kb. bármit egy négymagos 15W-os 3-4 évvel ezelőtti ultramobil processzoron is (pl. i5-8250U), így túlzottan nem aggódnék az ezekhez képest erőmű-kategóriás 5900-asok miatt. Azért 12db teljesértékű, egyenként is erős, hatékony mag nem holnap, de szvsz nem is 3 év múlva lesz gyenge kategóriás.

Azért 12db teljesértékű, egyenként is erős, hatékony mag nem holnap, de szvsz nem is 3 év múlva lesz gyenge kategóriás."a jelenlegi igények fölé vásárolni az aktuális sorozatból, jövőbiztosítás céljából gaming-re értelmetlen"

Nehéz ezt előre látni. Addig egyetértek veled, hogy a "jövőbiztosításba" általánosan nem igazán érte meg soha fektetni komolyabb összeget gamingre, de azért kivételeket is lehetett látni az utóbbi tíz évből. Én annak vagyok a híve, hogy kis ráfizetést megérhet, ha valaminek nagyon jó az ér/teljesítmény aránya, még ha ma nincs is teljesen kihasználva. Azért is írtam, az 5900X elég jó ajánlatnak tűnik 400 euróért, de lehet érdemesebb ma venni egy 5600-ast, aztán ha kevés fejleszteni pár év múlva, amikor már 400-ba sem fog kerülni az 5900.

Én is így ugrottam a 3600-asba pár éve, jó áron volt, valami kellett, aztán majd ha kinövöm veszek erősebbet.

-

HSM

félisten

válasz

paprobert

#6818

üzenetére

paprobert

#6818

üzenetére

A Zen1 szerintem nem feltétlen jó példa. Az már akkor is lassúcska volt egyszálon, amikor megjelent. Egy 5000X-es Zen3 viszont bőven megállja a helyét ma is. Én nem félteném a következő években.

400 euróért nekem elég szimpatikus ajánlatnak tűnik egy új 5900X, feltéve, ha valakinek szüksége van ekkora nyers erőre. -

HSM

félisten

válasz

Petykemano

#6731

üzenetére

Petykemano

#6731

üzenetére

"az emberek nagy része visszakérdezés helyett inkább kiválasztják a számukra kényelmesen érvelhető részt."

Ha ezzel most az előző hozzászólásomra gondoltál, nem volt ilyen szándékom. Egyszerűen csak más volt a véleményem arról, amit állítottál.

Te azt írtad, az emberek több CU-t várnának, én erről azt gondolom, bőven elég lehet akár 4 is arra a piacra, amiről beszélünk.Ami pedig a stacking technológiát illeti, én azt gondolom, egy teljesen független dolog. Az emberek többségét szvsz egyáltalán nem érdekli, milyen technológiai módszerrel kapja azokat a szolgáltatásokat, amiket használni szeretne. Lásd pl. 5950X 3 csip síkban, 12900K egy, az 5800X3D megint három, de immár 3D-ben, igazából technikai érdekesség mivoltán kívül nem sok mindenkit érdekel ez, sokkal inkább az, mennyi idő alatt végez el egy rendert, vagy hány FPS-el futtat egy játékot.

Szerintem logikus, hogy nem feltétlen ragaszkodnak a méretek kimaxolására, attól, hogy ~80mm2 mondjuk az IOD, még nem biztos, hogy érdemes egy ugyanekkora méretű IGP-t stackelni rá, hiszen valószínűleg nem növelné annyival a "CPU" piaci értékét, mint amennyibe kerülne legyártani. Ha tesznek rá egy teszem azt harmadakkora chipet, aminek a költsége/kapacitás foglalása kevesebb, mint a harmada, azzal már elérik, hogy az "IGP előny" meglegyen, jóval "olcsóbban". A stacking nagy előnye még, hogy ha később meggondolnák magukat, még mindig tervezhetnek egy nagyobb stackelhető IGP-t az IOD tetjére, nem fog kelleni vélhetőleg másmilyen IOD.

Az 5800X3D-n sem a teljes csip méretű a rárakott extra L3.

Az 5800X3D-n sem a teljes csip méretű a rárakott extra L3.Én legalábbis ebben látom a technológia jelentőségét, hogy lehetővé tesz olyan konfigurációkat, amik "2D-ben" gazdaságtalanok, problémásak, esetleg lehetetlenek voltak, függetlenül attól, hogy végülis pontosan hány MB extra L3-at vagy hány CU-s IGP-t kap.

#6733 Petykemano: Én értem ezt a jelenséget, át is jött, de lásd az előző hsz-em, mivel a konkurencia esetén is így van, nem hinném, hogy bárkit zavarna ez, ha amúgy a CPU rész kellően erős lesz. Ha valakinek pedig annyira prioritás a GPU, akkor még mindig vehet majd Rembrand-ot.

-

HSM

félisten

válasz

Petykemano

#6729

üzenetére

Petykemano

#6729

üzenetére

"Zen4 esetén a stacked 4CU csalódást keltő volna"

Miért lenne az? Szerintem hasznos újítás lenne, általános gyorsítóként besegíteni akármennyi hasznos, képet is ad, HTPC feladatokra is alkalmassá teszi így a csipet külön GPU nélkül. Ez nem olyan, mint a mobil Rembrandt, ahol kifejezetten "játékos" célokra is szánva van az IGP.

A konkurencia is egyébként így jár el, mobil Alderekben jóval erősebb IGP van, mint az asztali verziókban, 32 szemben 96 CU-val. -

HSM

félisten

válasz

westlake

#6642

üzenetére

westlake

#6642

üzenetére

Az AMD nem írja unlocked-nek: [link] .

Innentől kezdve szerintem nincs miről beszélni.

A tuning egyébként mindig saját felelősségre ment, az unlocked csipeknél sem vállalnak rá garanciát. Intelnél lehetett külön venni régen olyan garanciát, ami erre is vonatkozott.#6643 Petykemano : Az összes 7nm-es nyolcmagos elengedve igencsak forrófejű volt, éppen amiatt, hogy már úgy is kicsit túl sok volt az energiasűrűség, nem tudta jól leadni. Ha ezt megfejeled a sűrűbb L3-al, az elvékonyított, "struktúrális szilíciummal" megtámogatott "alap csip" azért így egyszerű józan ésszel is belátható módon lényegesen rosszabb helyzetben lesz kénytelen teljesíteni, mint a hagyományos verzió.

Ezt belekergetni egy durvább OC-ba (amikor alapból is eléggé ki fogja vélhetően maxolni magát, és az alap L3-al is elég forrófejű volt már) nekem nem tűnik egy okos ötletnek.

-

-

HSM

félisten

válasz

Petykemano

#6620

üzenetére

Petykemano

#6620

üzenetére

"eddig szinte kivétel nélkül azt lehetett hallani, hogy jobban teljesít az ADL az E magok kikapcsolásával"

Ez egy érzékeny kérdés. A probléma, hogy amíg nincs jelentős előny a +számítási kapacitásból, addig az E-magok csak lassítani tudnak, ha félremegy az ütemezés, illetve a kis magok használata miatt lelassító ringbus órajel miatt. Viszont, ha vannak "terheléscsúcsok", amik vidáman teletöltik a 8 nagy magot és a kicsiket is pillanatokra, akkor könnyen átcsaphatnak a lassabb magok is pluszosba és simíthatják a görbét.

"Ehhez semmi köze a Ryzen CCX-eknek."

Ott ugyanez a kényes egyensúly áll fenn. Az "eltévedt", keresztbe ütemezett szálak késleltetésbeli hátrányát mikor előzi meg a több bevethető mag nagyobb számítási kapacitása.

"a 8 és 12 magos Ryzenek esetén lehetne még megnézni, hogy az Elden Ring esetén tapasztalt kisimulás bármilyen 8 fölötti magszám esetén tapasztalható"

Ezzel szépen lehetne jópár elméletet igazolni vagy cáfolni.

-

HSM

félisten

válasz

Petykemano

#6618

üzenetére

Petykemano

#6618

üzenetére

Azért ez egy erős feltételezés...

Azt gondolom, ha tudatosan van P/E megkülönböztetés, akkor vélhetőleg a CCX-ek figyelembe vételére is gondoltak, de persze nem biztos.

Elég más egyébként a két rendszer: [link] [link] (Forrás: [link] [link] ).

Tehát AMD-n inkább a CCX-ek közötti kommunikáció, amit érdemes alacsonyan tartani, míg Intelnél a kis magok között nincs gyors kommunikáció, és azt is figyelembe kell venni, hogy lassabbak is, viszont a clusterek közötti kommunikáció lényegesen alacsonyabb késleltetésű.Illetve amiről már régebben is írtam, programozási szempontból elég káosz, ami van, hogy van, amiben 4 kis mag van, van amiben 8, a másik oldalon is van mindenféle kiosztás 6+0, 8+0, 6+6, 8+8, nem biztos, hogy ami az egyiken optimális, az a másikon is.... Valószínűleg jó esetben kitalálnak valami kompromisszumot, ami elfogadhatóan működik az összes kombináción.

"szerintem az egyetlen járható úgy, ha a hardvergyártók "megerőltetik" magukat és olyan áron kínálják a sokmagos procikat, hogy ha nem is használod ki, de megérje."

Igen.

Egyébként komoly lépés volt ilyen téren a 3600-as Ryzen, de a 3900/5900 is. Illetve most az Alder i3 és K-nélküli i5-ök is azért elég komoly erőt hoznak a kevesebb pénzből gépet építőknek is, de a 300 dolláros 5700X is egy lépés a jó irányba. -

HSM

félisten

válasz

-FreaK-

#6616

üzenetére

-FreaK-

#6616

üzenetére

"sok olyan elem van, ami nem igazán párhuzamosítható"

A véleményem szerint sokkal inkább az lehet az ok, hogy a játékot el is szeretnék adni. Ha pedig el is szeretnék adni, akkor nem fognak arra egy nagy halom pénzt költeni, hogy a játék mondjuk 64 magig jól skálázódjon, amikor a vásárlóbázis nagyjából 80%-a van jelenleg 6 vagy kevesebb magos számítógépen [link] , és egy számjegyű százalék 8 mag felett. Inkább fogják, és kivágják/le sem fejlesztik az igazán CPU-igényes részeket, mint pl. fizikai, komplex AI, geometria, térhatású hang, sorolhatnám. -

HSM

félisten

válasz

Petykemano

#6609

üzenetére

Petykemano

#6609

üzenetére

Alapvetően ezért szeretem a "túlméretezett" processzorokat játékhoz, amire a többség csak legyinteni szokott hogy minek, mert egy túlméretezett processzorral sokszor éppen a minimumok javulnak jelentősen, kisimul a futás. Tulajdonképpen itt is éppen ezt láthatjuk, bekapcsolt még egy rakás magot, simább lett a játék. De ugyanezt láthattuk pár benchmarkban pl. 5600X és 5800X vagy 5950X viszonyában is.

Én azt gondolom, a jelenség magyarázata egyszerűen ez, az E-core-ok adta mondjuk +30% extra nyers erő. Hogy ezeken kívül pontosan mi, már érdekesebb kérdés. Hogy a játék tudja-e használni a plusz magokat, vagy pl. az Nvidia drivere telepszik ilyenkor rá a kis magokra, és marad több erőforrás a játéknak a nagyokon, vagy valami más szokatlan együttállás, ez már alaposabb kutatást igényel szvsz.

-

HSM

félisten

válasz

Petykemano

#6592

üzenetére

Petykemano

#6592

üzenetére

Így már értem, hogy gondoltad.

Igen, egyetértek.

-

HSM

félisten

válasz

Petykemano

#6588

üzenetére

Petykemano

#6588

üzenetére

Az első verziód teljesen nélkülözi egy piaci szereplő realitását. Senki nem fog nullszaldósan neked bármit megtermelni és eladni.

Nyilván, éles piaci versenyben szűkös kapacitásokkal alapvetően azt kell priorizálni, amin magasabb a haszon. Ezek a piac szabályai, mi választottuk.

Tehát amikor azt mondja, nem igazán lehet ezt 300 dollár alatt adni, abban vélhetőleg ugyanúgy benne vannak a magasabb potenciális gyártási költségek, és a magasabb profitú termék eladásának lehetőségétől való elesés "költsége" is. -

HSM

félisten

válasz

Petykemano

#6582

üzenetére

Petykemano

#6582

üzenetére

Logikus lépés lenne egy takarékos, 65W-os 8/16-os Vermeer SKU.

Illetve, a termékpaletta is kiadná, hogy az X-esek a 32-96MB-os L3-as verziók, és az X-nélküliekre lehetne más lapka is, amit éppen gazdaságosabb olcsón adni.Egyébként a hivatkozott interjúban is elmondta a CEO, hogy a piaci viszonyok függvényében azért változhat, hol érdemes meghúzni a határt a chipletes termékekkel.

-

HSM

félisten

válasz

Petykemano

#6575

üzenetére

Petykemano

#6575

üzenetére

Nekem ez volt igazán érdekes: [link] . Kb. 20W környékétől már elég jól érzi magát.

Illetve, ami még brutális, hogy a 12900HK még egyszálon is gyorsult 45W helyett 65W limittel, addig a 6900HS látszólag bőven a 35W-os limitje alatt tudott maradni. Szép dolog, hogy pl. Cinebench alatt így 730 pont single a 12900HK, ha ehhez látszólag megeszi a 45W-ot ( ), a 6900HS-féle 23W-ból teljesített 613 pont így lényegesen jobb eredménynek tűnik számomra egy laptop esetében.

), a 6900HS-féle 23W-ból teljesített 613 pont így lényegesen jobb eredménynek tűnik számomra egy laptop esetében. -

HSM

félisten

"a 12600K és az 5600X azonos árban mozog idehaza"

Idehaza. Egy ismert német webshopban pl. 279€ az 5600X, és 298€ a 12600K. Egyébként szerintem érdemes a teljes platform költséget nézni, az megint javít picit az 5600X ár/érték mutatóján. AM4-ből 60€-ért kapsz használható belépő lapot, s1700-ra ez inkább 120€ nagyságrendje ugyanitt. Gyakorlatilag a lapon megspórolt összegből már ki lehet pótolni az 5600X-et egy 5800X-re (358€), az szerintem egy igen jó játékos CPU, bőven méltó ellenfél a 12600K-nak.

Egy ismert német webshopban pl. 279€ az 5600X, és 298€ a 12600K. Egyébként szerintem érdemes a teljes platform költséget nézni, az megint javít picit az 5600X ár/érték mutatóján. AM4-ből 60€-ért kapsz használható belépő lapot, s1700-ra ez inkább 120€ nagyságrendje ugyanitt. Gyakorlatilag a lapon megspórolt összegből már ki lehet pótolni az 5600X-et egy 5800X-re (358€), az szerintem egy igen jó játékos CPU, bőven méltó ellenfél a 12600K-nak.

De egyébként olcsó alternatívának ugyanitt kapható az 5600G 224€-ért, az olcsó lappal még kedvezőbb áron kijön, mint egy 12400F-es konfig és egy bőven használható GPU-t is kapsz mellé, persze, nyilván azért lassabb is CPU-nak. De azt nem mondhatjuk, hogy nincs miből választani, van pár jó ajánlat továbbra is Ryzen fronton.

De azt nem mondhatjuk, hogy nincs miből választani, van pár jó ajánlat továbbra is Ryzen fronton."De ha megnézzük Multi Thredban már nem el hanyagolható az előrelépés"

Itt azért hozzátenném, hogy azért nem mindegy, milyen programban. Ugyanúgy, ahogy a több CCX-es Ryzenek, úgy az új P/E magos CPU-k esetén sem feltétlen jó ötlet pl. a Cinebench eredményből kiindulni, ami sok sok évnyi optimalizálás után tart ott, hogy egyáltalán nem érzékeny az ilyesmikre.Egyébként azzal teljesen egyetértek, hogy az új P-magok nagyon jók lettek.

A "nagyon budget" kategóriában szerintem az i3-12100-nak sokáig nem lesz ellenfele, jól sikerült és olcsón is gyártható a defektes i5-ökből.

-

HSM

félisten

És ahogy szó volt róla, jelenleg nem is nagyon érdemes várni i3 ellenfelet, mivel az AMD jelenlegi lapkáival az nem fedhető le gazdaságosan.

Ami a Raptor Lake i5-öt illeti, az elmélet nagyon szép a kis magokkal, a gyakorlatban viszont egyáltalán nem biztos, hogy széleskörűen támogatott és jól működő lesz a dolog.

Az "efficiency" az az én olvasatomban úgy értelmeződik, hogy így "hatékonyabban" tudnak nagyobb számokat írni a dobozra.

![;]](//cdn.rios.hu/dl/s/v1.gif) Mennyivel jobban fest a K-s i5-nél, hogy 10 mag, nem csak 6?

Mennyivel jobban fest a K-s i5-nél, hogy 10 mag, nem csak 6?

-

HSM

félisten

"a cache vágott Zen2 piacra kerül-e valaha"

Réges rég piacon vannak a Renoir-ok, pl. 4600G [link] ... Számomra túl nagy élményfaktort nem jelent a kikapcsolt IGP-s verzió.#6520 carl18 : "A Raptor Lake pontjait egy biztos a 16 Gracemont mag elég szépen megfogja dobni."

Ezaz, a pontjait. És a valós teljesítményt? Nagyon remélem, inkább azt fogják nézni a tesztelők, mert egyre inkább irreálisnak tűnik pl. a Cinebench általános tempót mérni, mivel egyáltalán nem érzékeny pl. arra, hogy hogyan vannak bekötve a magok. A kis magok ugyanis jóval kevésbé férnek hozzá a memóriához, egy 4-es clusternek volt egy ring megállója az Alderen...#6524 hokuszpk : Egyébként nem kell hozzá nagy tudomány, itt vannak a Cezanne alapú 5800U-k pl, 15W-ból kihoz 8 magot és elég korrekt teljesítményt. 15W-os mérést most nem találtam, de 24W-ból pl. 3523 pont jön ki Cinebench R20-ban [link] .

Szóval elég kevésből is sokat ki tudnak hozni ezek a magok. Szervereknél a sok IF link vesz el nagyon sokat a fogyasztási keretből egyébként. Lásd pl. a 64 magos 3995WX esetén akár 100W is lehet, 180W-ot fogyasztó magok mellett: [link] . -

HSM

félisten

válasz

Petykemano

#6499

üzenetére

Petykemano

#6499

üzenetére

Ez egyébként miért jó?

Kb. az egyetlen fejlesztés, aminél csak a fejem vakartam, hogy ettől mi és miért lesz jobb. Órajelet amúgy is csak mag szinten tud állítani.

Órajelet amúgy is csak mag szinten tud állítani.

-

HSM

félisten

válasz

Petykemano

#6441

üzenetére

Petykemano

#6441

üzenetére

"Eközben az AMD bagóért gyárt gpu-kat (amiből mondjuk a Navi24 N6-on készül, de a többi N7) és gond nélkül kapható a Vermeer is."

Én azt gondolom, más szempontok is játszanak itt. Pl. hogy bizonyos szegmensekbe fontos, hogy jelen legyenek, készüljenek a fejlesztések. Szerintem ezért nem is készül "olcsó tömeg-vermeer" vagy bármi hasonló az igen erősre sikerült Alder i3 ellen. A GPU-bizniszt sem feltétlen lenne szerencsés teljesen bezárni, mert éppen sokan vinnének egy rakás CPU-t. Illetve ott van a jól teljesítő mobil részleg is, ahol szintén óriási hiányok és magas átfutási idők voltak jellemzőek az utóbbi években. Egyébként asztali Vermeer-ből is sokáig hiány volt, pedig oda csak 1-2 CCD kell, nem 8db, mint egy komolyabb EPYC-re.

Illetve ott van a jól teljesítő mobil részleg is, ahol szintén óriási hiányok és magas átfutási idők voltak jellemzőek az utóbbi években. Egyébként asztali Vermeer-ből is sokáig hiány volt, pedig oda csak 1-2 CCD kell, nem 8db, mint egy komolyabb EPYC-re. -

HSM

félisten

válasz

Petykemano

#6411

üzenetére

Petykemano

#6411

üzenetére

"ha manapság előkerülne egy nem B2 steppinges zen3 lapka, akkor valami sántít a chiphiány, meg az azért drága minden, mert mindent eladnak azonnal, ami legurul a gyártósorról történettel."

Ezzel az a probléma, hogy az ellátási láncban még hónapokig lehetnek beragadt darabok. Például tudnám mondani a 3600/3600X-eket, ahol előbbi sokkal gyorsabban fogyott, annyira, hogy konkrétan már doboz sem volt hozzá [link] , míg utóbbiból ugyanakkor az itthoni boltokban még bőven találtál bőven több, mint fél évvel korábban gyártott "beragadt" darabokat, ami azt a furcsa helyzetet eredményezte, hogy a legtöbb "friss" 3600 tuningosabb volt, mint a régebbi gyártású és ráadásul nyilván drágább 3600X.

-

HSM

félisten

válasz

S_x96x_S

#6396

üzenetére

S_x96x_S

#6396

üzenetére

"És ez bennem már "Goodhart's law" -ra rimmel."

Nagyon jó meglátás. Ez már egyébként az első Ryzeneknél is előjött, hogy a 8 magjuk 4+4-es felépítése miatt nem igazán lehetett a korábbi mérésekből reálisan felmérni a teljesítményüket, mert a single és a mérésekhez tipikusan használt jól skálázódó multi appok is jól futottak rajta, de a szálak között többet szinkronizáló, problémásabb szoftverekkel lehettek gondok.

"Azért marketing szempontból ez ideális."

Én is azt gondolom, ez lehetett a fő indok. A konkurencia 16 magja ellen mutatni kellett valamit, ami az egyszerű számok nyelvén is legalább annyi. Azért is írtam, hogy nekem ez nagyon izzadtságszagú lett #6335.Én amúgy azt gondolom, nem lenne elég egy egyszerű mérőszám, ugyanis mivel ezek a megoldások sokban függenek a szoftvertől, így szoftverfüggő, jól fognak-e futni. Rossz esetben el sem indul pl. az Alderen (régi Denuvo), jó esetben viszont meg sem éreznek semmit (pl. Cinebench). Erre is gondoltam, hogy a hardveresek átdobták a problémát a szoftvereseknek, amiből ritkán szoktak jó dolgok kisülni. Az Alderrel még jobban, mint a Ryzenekkel, ahol azért az 5000-esektől már a 8 magos CCX már elég kevés vizet zavar a gyakorlatban, nem igényel különösebb szoftveres odafigyelést/optimalizálást.

Az ARM megoldása egyébként nagyon jól átgondolt.

A gyakorlatban amúgy nem nagyon van 3 szintnél több, talán a legjobban kitalált, amikor van egy/két kicsit pazarlósabb, de gyors X1-es, mellé 2-3 gyors, de energiahatékonyságban sem rossz A78, és egy teljes 4-magos cluster energiatakarékos A55, ilyen pl. a friss 888-as Snapdragon: [link] . Ezzel meg van oldva, hogy a rövid, de intenzív terheléseket gyorsan el tudja végezni az X1, a nagyobb falat feladatokra ott vannak az A78-ak, a kevésbé sürgős dolgokkal meg elszórakoznak az A55-ök, és ezen processzorok között az android ütemezője könnyen tudja pakolgatni a feladatokat. Persze, ez sem feltétlen olyan egyszerű a gyakorlatban, mint ahogyan első ránézésre tűnik [link] .

A gyakorlatban amúgy nem nagyon van 3 szintnél több, talán a legjobban kitalált, amikor van egy/két kicsit pazarlósabb, de gyors X1-es, mellé 2-3 gyors, de energiahatékonyságban sem rossz A78, és egy teljes 4-magos cluster energiatakarékos A55, ilyen pl. a friss 888-as Snapdragon: [link] . Ezzel meg van oldva, hogy a rövid, de intenzív terheléseket gyorsan el tudja végezni az X1, a nagyobb falat feladatokra ott vannak az A78-ak, a kevésbé sürgős dolgokkal meg elszórakoznak az A55-ök, és ezen processzorok között az android ütemezője könnyen tudja pakolgatni a feladatokat. Persze, ez sem feltétlen olyan egyszerű a gyakorlatban, mint ahogyan első ránézésre tűnik [link] .Ugyanakkor fontos észrevenni, hogy egy telefon más terep, mint egy notebook, vagy PC. A telefonon pl. viszonylag könnyű megoldani OS szinten, hogy pl. lezárt képernyőnél ne mehessen háttérfeladat a nagy magokra. Óriási nyereség készenléti időben kb. nulla befektetett energiával. PC-n azért nem lehet ilyen trükköket bevetni.

-

HSM

félisten

válasz

S_x96x_S

#6393

üzenetére

S_x96x_S

#6393

üzenetére

"az Intel 14 magosához képest tényleg kevés"

Erre nem vennék mérget. Szépen látszik a masszív előrelépés (+10-30% Geekbench) az elődhöz képest. Az IGP is szvsz összességében várhatóan a legjobb lesz a piacon. Hozzátéve a tegnap látottakat, hogy kb. még a Cezanne is tartotta a lépést az említett "14" magossal pl. Cinebench alatt (ami ebben az esetben Intelnek kedvez, mert nem zavarja, hogy kicsi vagy nagy mag) kb. 80W-ig, így én különösebben nem látom ezt kevésnek, szerintem éppen oda fog megérkezni, ahova kell neki. Ráadásul nem is lesz ebben a generációban várhatóan nagyobb csip, ez fizikailag is a csip felépítése, "14" mag. Azért írom idézőjelben, mert azért rendesen megtévesztően hat, hogy ebből a 14-ből 8 kb. harmad olyan gyors csak, mint a többi....

Ráadásul nem is lesz ebben a generációban várhatóan nagyobb csip, ez fizikailag is a csip felépítése, "14" mag. Azért írom idézőjelben, mert azért rendesen megtévesztően hat, hogy ebből a 14-ből 8 kb. harmad olyan gyors csak, mint a többi...."akkor "általában" a később gyártottat érdemes megvenni"

Intelnél korábban generációkon keresztül inkább a kezdeti darabokat volt érdemes tuningra, azok között voltak a legjobbak. Ryzeneknél viszont sokszor a frissebbek voltak a jobbak, ez tény.

Ryzeneknél viszont sokszor a frissebbek voltak a jobbak, ez tény. -

HSM

félisten

válasz

Petykemano

#6384

üzenetére

Petykemano

#6384

üzenetére

Részemről akkor látnám ennek a dolognak az értelmét, ha jóval nagyobb lenne a szakadék. Amíg az erős magok ennyire jók, addig nem látom kifizetődőnek a kis magokkal járó esetleges hátrányokat. A 2P+8E mobil megoldásokra egyébként igencsak kíváncsi leszek, mit fognak tudni a jelenlegi 15W megoldásokhoz, vagy akár az asztali 4P+0E i3-akhoz képest.

-

HSM

félisten

válasz

Petykemano

#6378

üzenetére

Petykemano

#6378

üzenetére

Nagyon szépen teljesít az 5700G. Az egyébként szintén asztali APU, éppen mint a 12700, bár fizikailag azonos a mobillal, míg az Aldernél a lapka is más, nem csak a paraméterezés.

Nekem amúgy ez villant be látva a 4 E mag tempóját a 8 P-hez képest: "Does the “E” then really still stand for “Efficiency” and not rather “Error” or “E-Waste”? Wouldn’t a CPU with only P-cores and AVX-512 be the far more economic and ecological approach?" [link]

#6379 S_x96x_S: "van belőle mobil is (12700H )"

Ne tévesszen meg a hasonló elnevezés, az asztali 12700 egy 8P + 4E magos CPU, míg a 12700H egy másik, kifejezetten mobil piacra tervezett lapka, erősebb IGP-vel és 6P + 8E maggal. [link]" ...(12700H ) és a Ryzen 5800H -t teljesítményben veri "

A linkelt hír alja alapján ~95W-ból veri a kb. 50W-os 5800H-t...

80W-on már az 5800H is megcsinál 6100 pontot R20-ban [link] , épp mint a 12700H [link] .

Azért ez igen szép teljesítmény szvsz egy már egy éve piacon lévő terméktől, egy friss, ráadásul lényegesen több magot felvonultató konkurenciával szemben.#6382 S_x96x_S : "szerintem inkább a kevésbé hatásos hőelvezetés lehet a probléma"

Én is erre tippelnék. Főleg egymagos BOOST órajeleken eléggé ki van centizve a 7nm hőleadó képessége, szívtam is vele rendesen a 3600-as Ryzenemen. Egy 5800X is eléggé forrófejű hírében állt. Komoly hővezetési gond egyébként szerintem nem lehet, mert akkor a hővezetés szempontjából kedvezőbb, két CCD-s modellek jöttek volna, ahol két CCD-re oszlik el a ~140W-os fogyasztási limit.

Egy 5800X is eléggé forrófejű hírében állt. Komoly hővezetési gond egyébként szerintem nem lehet, mert akkor a hővezetés szempontjából kedvezőbb, két CCD-s modellek jöttek volna, ahol két CCD-re oszlik el a ~140W-os fogyasztási limit. -

HSM

félisten

válasz

hokuszpk

#6376

üzenetére

hokuszpk

#6376

üzenetére

"az 5800U -nal ez 15W hiaba emeled a tdp -t, nem jon ki belole sokkal nagyobb performace"

Mások viszont arra jutottak, hogy nagyon szépen skálázódik felfelé... [link]

De nem is logikus, ugyanannak a lapkának van 35W-os, és 45W-os variánsa is mobilba, ennek sok értelme nem lenne, ha nem lenne képes skálázódni a lapka...

És akkor a 10-25W cTDP gyártói specifikációról nem is beszéltem.A Vega zsuga azért nem jó példa, mert az nem extrém alacsony fogyasztás. Én sajnos csak az alaposan vágott Renoir-t próbáltam (4650U) és egy olyan nem túlzottan megterhelő játékban, mint a StarCraft2 is jelentős különbség volt a 15W és 23W beállítás között. De ugyanez Cinebench R15-ben is, ha jól emlékszem, 2100 pont körül hoz 15W-on, ebből 2600 pont lesz 23W-on.

Szerintem itt az kavarhatott be, hogy hiába adsz 15W-os hűtés alatt többet neki, nem lesz gyorsabb, mert a thermal throttling megfogja. Természetesen kell rá erősebb hűtő is, ha emeled a TDP-t, de akkor jön is vele a gyorsulás.

-

HSM

félisten

válasz

S_x96x_S

#6373

üzenetére

S_x96x_S

#6373

üzenetére

"manapság már ezekben a marketinges táblázatokban se lehet megbízni .. "

Sajnos nem. Tizenéve tartó trend, hogy egyre lazábbak a specifikációk, és egyre meredekebb dolgokat engednek meg a gyártók a különböző tech szektorokban.

Tizenéve tartó trend, hogy egyre lazábbak a specifikációk, és egyre meredekebb dolgokat engednek meg a gyártók a különböző tech szektorokban.Egyébként ezt a semiaccurate cikke is kiemelte: "One big problem SemiAccurate has is the unethical way AMD compared product lines and tried to bury it in the (actually quite good) footnote disclosures. The claims of high performance and better everything than the preceding Ryzen 5000 line compares 15W R5K CPUs to 28W R6K CPUs" [link]

Szerintem egyébként a háttérben megszüntették a 6800-asoknál az alapértelmezett TDP-t, korábban ugyanis "Default TDP" néven futott a kategóriára jellemző, "közismert" TDP (pl. 15W, 35W, 45W), és mellette volt egy "AMD Configurable TDP (cTDP)" érték, ami azt jelentette, hogy a gyártók hova módosíthatják a megoldásaikon a gyári értéket. Nem újdonság, Intelnél is régóta jelen van, pl. a hatodik generációban a 15W-os CPU-k specifikálva voltak 25W-on és 7,5W-on is, pl. [link] , sokan éltek is ezzel a lehetőséggel.

Ami a pirosaknál érdekes, hogy a "Pro" modelleknél eddig csak a "Default TDP" volt feltüntve, nem volt cTDP, és külön ki volt emelve, hogy nem "unlockolt" a CPU, pl. [link] . Ennek ellenére pl. nálam szépen ketyeg a Pro 4650U 15W helyett 10W vagy 23W-on is a gép gyári drivereivel.

Az új nem-PRO 5800-as is ezt örökölte: [link] , eltűnt a cTDP, és megjelent, hogy nem "unlockolt".

Ami pedig a legérdekesebb, hogy a 6800U-nál eltűnt a "Default TDP", helyette csak cTDP van és hogy nem "unlockolt". [link]

Bár azt azért hozzátenném, hogy az AMD eddig is szeretett elég érdekes módon hozzáállni ahhoz, mi is egy Watt: [link] .

Én egyébként azt gyanítom, hogy az új, erősebb IGP-hez kevés lehet a 15W (a korábbi tempójához is jól jött magasabb keret, nálam legalábbis szépen meglódul 23W-on a 4650U, pedig az csak hatmagos, vágott IGP-vel), így ezzel próbálják "bátorítani" az OEM-eket, hogy inkább kicsit magasabb TDP-t illetve hűtést rakjanak ezen CPU-k köré. Így persze a számokkal is többet lehet játszani a bemutatókon. Én azért örültem volna, ha maradt volna egy publikus, alapértelmezett TDP, legyen mondjuk akár 20W, amit aztán a gyártók kedvükre konfigurálhattak volna 15 és 28W között, így viszont nehéz objektíven hasonlítani a terméket bármihez, hiszen ingatag lábakon áll, hogy milyen TDP-n is kellene egyáltalán megmérni, mi is az, amihez a gyártó optimalizálta a terméket.

-

HSM

félisten

válasz

S_x96x_S

#6371

üzenetére

S_x96x_S

#6371

üzenetére

"Persze az újabb "6800u"-s procikat 15-28W között lehet konfigurálni

a régieket meg csak 15W;"

Nem nyert. A régieknél ez áll a terméklapon: "AMD Configurable TDP (cTDP) 10-25W" [link]

A régieknél ez áll a terméklapon: "AMD Configurable TDP (cTDP) 10-25W" [link] Számomra éppen az volt a furcsa a 6800U-nál (itt írtam is [link] ), hogy emlegetik a nagy fejlődést az energiatakarékosság terén, erre a másfélszeresére nő a minimum cTDP?!

Egyébként nem volt ritka az emelt TDP limit, már a Renoir generációnál is rengetegféle konfiguráció volt. Az én 4650U-mnak is van 10W-os és 23W-os módja is a 15W-os mellett.

-

HSM

félisten

válasz

S_x96x_S

#6355

üzenetére

S_x96x_S

#6355

üzenetére

Szvsz alapvetően ennek úgy lenne értelme, ha a kitömörítést a GPU végezné. Ahogy az Nv megálmodta a saját verzióját erre: [link] .

A másik verzió a nagyobb memória használat, ami egyébként PC-n egyáltalán nem akadály szvsz, 32GB ram manapság már nem extrém egy játékos gépbe, míg konzolon csak 16GB-al lehet kalkulálni, ami a VRAM is egyben.

#6357 S_x96x_S : Pont amitől én is tartottam #6179.

Köszi a linket. Még az is lehet, hogy kikapcsolni sem lesz elég a megnyugtató biztonsághoz.

Köszi a linket. Még az is lehet, hogy kikapcsolni sem lesz elég a megnyugtató biztonsághoz. -

HSM

félisten

"De nyilván a jövőbe a gyártók lehet jobban fogja limitálni a sávszéleséget hogy az emberek "új platformot vásároljanak."

Azért ne gyártsunk összeesküvés elméleteket. Ennél sokkal technikaibb a magyarázat. Pici chipeknél a kivezetések száma erősen korlátozhatja, mekkora tud lenni a lapka (ami ugye költség a gyártónak), illetve mobil felhasználásnál a sávok száma hatással van a fogyasztásra. Így nem meglepő, hogy kevésbé teljesítmény centrikus, belépő megoldásnál hozzanak egy ilyen kompromisszumot.

Ennél sokkal technikaibb a magyarázat. Pici chipeknél a kivezetések száma erősen korlátozhatja, mekkora tud lenni a lapka (ami ugye költség a gyártónak), illetve mobil felhasználásnál a sávok száma hatással van a fogyasztásra. Így nem meglepő, hogy kevésbé teljesítmény centrikus, belépő megoldásnál hozzanak egy ilyen kompromisszumot.

Vélhetőleg egyébként ha a kártya képességeihez jobban passzoló beállításokkal ment volna a teszt (4GB!), nem lett volna ekkora lassulás, tisztán látszik is a 8GB-os modell eredményeiből (aminél vélhetőleg elég volt a fedélzeti tár), ott mindjárt elég lett a 4 sáv is... -

HSM

félisten

válasz

S_x96x_S

#6347

üzenetére

S_x96x_S

#6347

üzenetére

".. akkor igen hamar elavulnak a jelenlegi Gen4-es csúcskonfigok is."

Egy apróságra felhívnám a figyelmed, mielőtt esetleg túlzottan eluralkodna a topikban a pánik...

Ez a jelenség csak a belépő GPU-kat fogja szvsz érinteni, ahol fogyasztás (notebook) és a lapkaméret minimalizálása indokolhatja a kevesebb sáv használatát. Ugyanezen belépő GPU-k esetén szokásos a szűkösre szabott memória méret, ami szintén növeli a forgalmat a rendszermemória felé. Jó esetben egy mai csúcs-gen4 processzor mellé senki sem fog akarni egy ennyire belépő GPU-t tenni. Az RX6600-on, amit én belépő játékos kártyának tekintek, nem véletlen van 8GB ram és 8X-os PCIe is, azzal máris nem ilyen kellemetlen a kép, alig veszít valamit akár 2.0-ás slotban (~4x-es 3.0 megfelelő) [link] . -

HSM

félisten

válasz

Busterftw

#6336

üzenetére

Busterftw

#6336

üzenetére

"Nem értem ezt az E core félelmet."

Részemről nem a nyers erejében látom a problémát. Hanem az egész rendszerben. Pl. ahogy a Ryzenek CCX-re bontottságánál sem az volt a gond, hogy egyszálon nem lett volna elég erős, hanem hogy a szálak szinkronizációja lelassulhat, és emiatt specifikus optimalizálás válhat szükségessé. Ugyanez a baja az Aldernek is, pl. a bekapcsolt E-core csökkenti a Ring órajelet, szűk keresztmetszet lehet, hogy 4 kis mag csak egy ring megállón áll, és probléma, hogy emiatt ki kellett a nagy magon kapcsolni az AVX512-t. Látszik itt is pl.: [link] . Különösen furcsa egyébként, hogy a legnagyobb késleltetés az azonos csoporton belüli E-core-ok között van.

A hatás is éppen ugyanaz, ahogy a Ryzen 3900X-et is sokszor utolért egy sima 3300X játékban, egy 5600X meg porba is alázott (túl sok volt a CCX-ek miatti sebességveszteség, nem skálázódott jól játékokban), az Aldereknél is látszik, hogy ha nem jó az ütemezés az rendesen meg tud mutatkozni a sebességen, lásd pl: [link] ."egy 8 magos 6700k szintű teljesítmény laptopban nem kevés"

Szerintem mindennapi használatra nem valami jó, ha erősen kompromisszumos az egyszálon elérhető teljesítmény. Nem véletlen, hogy inkább egy 2+8-es konfigurációt hozott a laptopokba, és még a mobil 9W-os i3 és Pentium is kap 1-2P magot a 4E mellé. [link]#6342 paprobert : "még több cache miss, és CCX-CCX-RAM közti latency penalty-vel"

A cache miss jogos, de meglepően jól tartja magát így is a hagyományos Zen2 mellett, átlag 10%-on belül van. [link] A CCX-közi kommunikáció szüksége/sebessége szvsz nem fog jelentősen változni a vágott L3-tól. Nem félteném én ezeket az E-core-októl.

Nem félteném én ezeket az E-core-októl.

-

HSM

félisten

"látszik az intel a kis magokat akarja erőltetni"

Azzal "olcsón" lehet nagyobb számot írni a magszám mögé.

"8/16 szál egyenlőre elég minden játéknak, a Kis magok háttérfeladatoknak és renderelni kiegészítésként meg bőven jó"

Papíron nagyon jól mutat a koncepció, csak a gyakorlati kivitelezhetőség bukhat el ezer ponton.

"Hát majd meglátjuk mit hozz a jövő, de legalább elindult a fejlődés."

Fejlődés, ez? Engem jobban emlékeztet egy kényszer szülte izzadtságszagú legóra, valamint a skálázódási probléma megoldási kényszerének áthárítására a szoftverekre, szoftverfejlesztőkre.

Engem jobban emlékeztet egy kényszer szülte izzadtságszagú legóra, valamint a skálázódási probléma megoldási kényszerének áthárítására a szoftverekre, szoftverfejlesztőkre.

Valódi fejlődés az volt, amit az AMD kitalált a chiplet-ekkel, főleg az 5950X igencsak jó processzor lett, a korábbi megoldások helyett töredék áron hozva brutális sebességet. Vagy amikor a Renoir-al bepaszíroztak 8 erős magot 15W-ba, ami a korabeli konkurenciával ellentétben nem csak abban a kb. 3 másodpercben működött normálisan, amíg el nem használta a ~82W-os rövid fogyasztási keretét (pl. i5-10210U). De a mostani 3D-cache is komoly fejlődés az eddigi megoldásokhoz képest.#6333 Petykemano : "Nem tiszta nekem, hogy ez hogy jött ki."

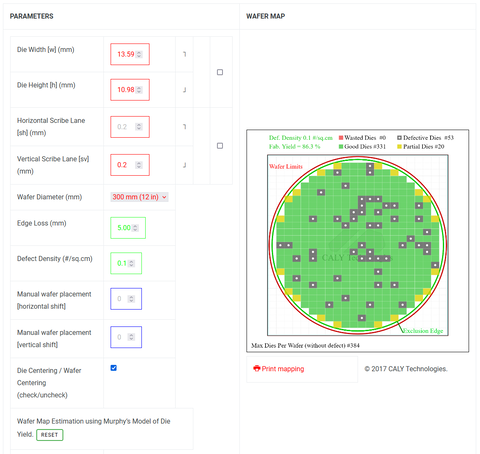

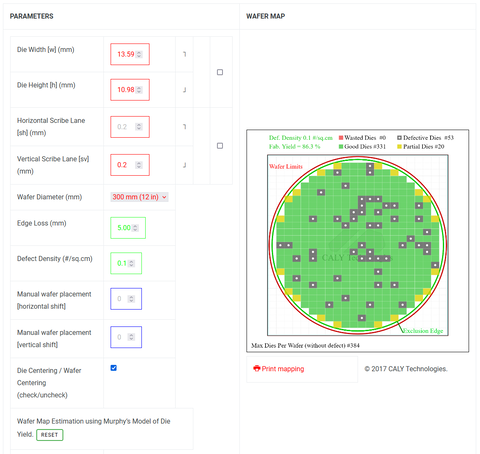

Nekem sem. Csináltam egy számolást a Renoir adataival:

A magméret forrása [link] , a yield-é pedig ez [link] volt.

A wafer áráról pedig ezt találtam [link] , eszerint 10 000 $/wafer volt 2019 áprilisában, azaz azóta ezt emelték elvileg 25-40%-al.

Eszerint egy Waferből 331 jó Renoir készül, 20 hiányos, és 53 hibás, azaz összesen 404. Ez így 86%, de hallani olyan információkat, hogy 90% felett vannak, ez vélhetőleg abból fakad, hogy a hiányos/hibás csipek egy részét még mindig tudják alacsonyabb magszámú/tiltott IGP-s modellként értékesíteni. Ez költség oldalon 10 000 dollárral számolva akkor is 24,8 $/chip, ha mind a 404 darab menthető. 14 000 dolláros árral, és 90% yield-el számolva (364 db értékesíthető chip) 38,5 $/chip.

Illetve ami még fontos, a modern gyártástechnológiákon óriási költség egyáltalán a prototípusok, gyártó eszközök elkészítése is, ez is darabra vetítve egy költség, csak mi ezzel nem tudunk könnyen számolni, a gyártónak viszont kell.

Cezanne-re egyébként ugyanez a kalkulátor [link] a következőket számolja: 268 db jó, 24 db hiányos és 51 db hibás, azaz 90% yield mellett azokból már csak 309 db értékesíthető példány lesz waferenként, ami úgy ~45 $/chip."Lehetséges volna, hogy ennyit számít"

Én azt gondolom, hogy az AMD keze leginkább abban van megkötve, mekkora kapacitást tudnak lekötni, mekkora anyagi háttér van erre, esetleg kockáztatni.

Az Intelnél adott a saját kapacitás, és mivel továbbra is nem túl jó yield-ről lehet pletykákat hallani [link] , így azt gondolom, részükről megoldható az óriási mennyiségű gyártás, nem a lényegesen magasabb profitú termékektől vonná azt el (pl. Milan-X), valamint a pénzügyi tőke is inkább megvan kockáztatni. A gyengébb yield-ből pedig az is következik, hogy a hatmagosnak gyártott költséghatékony Alderekből vélhetőleg bőségesen keletkezik annyi selejt, amivel utána rossz szájíz nélkül kiszolgálhatják az olcsó de erős i3-akra vágyó tömegeket, a jó kockákkal pedig le van fedve a mainstream hatmagos i5 vonal.

Az AMD-nek viszont nem lenne nagy üzlet a kapásból vélhetőleg drágábban gyártott 5600G-t nagyon akciózni, hiszen vélhetőleg a legtöbb Cezanne lapka bőven megfelel a drágább 5700G-nek vagy valamilyen mobil nyolcmagosnak is, és azokat is viszik, mint a cukrot.

Szóval nincs itt jótékonykodás, mindenki a piac szabályai szerint a saját pozíciójából próbálja kihozni a legtöbbet.

"Ebben azért az Intel előtt még hosszú át áll az intel előtt."

A probléma, hogy nem előttük. A szoftveres infrastruktúra előtt. Biztos lesz pár Halo-termék bemutatni ez milyen jó, a folytatásra viszont igen kíváncsi leszek. Elárulom, erősen szkeptikus vagyok ezzel kapcsolatban.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

válasz

S_x96x_S

#6324

üzenetére

S_x96x_S

#6324

üzenetére

Érdekes pont, köszi a hivatkozást. Szóval nem csak a plusz logisztika és összeszerelés növeli a költséget a chipletes megoldásnál, de vélhetőleg a nagysebességű kapcsolat szükségessége miatt is drágább, illetve rejtett költségként jelentkezik a selejtarány növekedése is.

Én is egyébként ilyesmikre gondoltam még itt is: [link] .

#6327 Petykemano : "Az intelnek ilyen szubstrát árak mellett hogy éri meg $100-200-ért adni az i3-t?"

Ilyen nagy volumenű, agresszívan árazott terméknél minden apróság számít...

Pl. hogy a jelenlegi tudtommal mindössze 6 nagy magot és agyonvágott IGP-t tartalmazó verzió alig nagyobb a Renoir-nál (156 vs. 162mm2), tehát alapból relatív olcsón gyártják, nem kell hozzá különleges szubsztrát, összeszerelés, logisztika (a Renoir-nak sem persze), és így jó áron értékesíthető a teljes hatmagos verzió (pl. i5-12400) selejtje. Ezért írtam #6321, hogy technikai/gyárthatósági oldalról a Cezanne 180mm2-en lenne ezzel igazán versenyképes, csak vélhetőleg nem érné meg ide olcsón kiszórni, amikor más piacokon jóval magasabb pl. az erős IGP hozzáadott értéke.#6328 carl18: Engem nem vettek meg az E-magjaikkal, lásd utolsó bekezdés #6183.

Rakhatnak bele 32-t is, akkor sem. Ezen jót nevettem: "Does the “E” then really still stand for “Efficiency” and not rather “Error” or “E-Waste”? Wouldn’t a CPU with only P-cores and AVX-512 be the far more economic and ecological approach?" [link]

Rakhatnak bele 32-t is, akkor sem. Ezen jót nevettem: "Does the “E” then really still stand for “Efficiency” and not rather “Error” or “E-Waste”? Wouldn’t a CPU with only P-cores and AVX-512 be the far more economic and ecological approach?" [link]

"én például belépő szintre el tudok képzelni egy 8 magos "E-Core Celeront"

Elképzelni én is el tudok ilyet, csak sikítva menekülnék előlük. Notebookokba kapható is volt hasonló 4+1 maggal [link] . Korábban a négymagos Pentiumok/Celeronok is ilyenek voltak, csak akkor még nevén, Atomként futottak ezek a magok. Nem csoda, hogy csak csendben mutatták be [link] ...

Notebookokba kapható is volt hasonló 4+1 maggal [link] . Korábban a négymagos Pentiumok/Celeronok is ilyenek voltak, csak akkor még nevén, Atomként futottak ezek a magok. Nem csoda, hogy csak csendben mutatták be [link] ... ![;]](//cdn.rios.hu/dl/s/v1.gif)

"A Zen 4 utodja már hasonló hibrid kialakításban fog megjeleni mint a intel."

Szerintem épp ellenkezőleg, másfajta hybrid kialakítás várható, nem hasonló.

Nem vitatom, hogy a big.LITTLE jelentősen hozzájárulhat a jövőben ahhoz, hogy egy CPU egyszerre lehessen sok szálon terhelve és kevésen is optimális, ugyanakkor ehhez szoftveres támogatás és megfelelő architekturális háttér is szükséges. Jelenleg szvsz egyik sem adott.

"Az alkalmazáson meg szép úgy is elkezdenek majd rájuk is portolni."

Ennél lényegesebb dolgokra sincs sokszor elég tapasztalt fejlesztő és pénz....

-

HSM

félisten

válasz

Petykemano

#6319

üzenetére

Petykemano

#6319

üzenetére

"Zen2-t el tudták adni $100-200-ért."

Ott azért több minden volt. Először is, brand építés. Másfelől, ahogy írod, vélhetőleg sokkal több selejt volt még (ebből lettek a Ryzen 3100, 3300X, utóbbiból nagyon kevés volt kapható). A 3600-akból, amikből tényleg volt komoly készlet, azok viszont elindultak 200 dolláron, és nem is mentek lényegesen ez alá, talán csak egy rövidebb időre, én pl. akkor vettem az enyém, itthon szűk 60K-ért, az volt kb. a legolcsóbb bolti ára.

Egyébként a TSMC is többször volt hír, hogy drágított, itt azt írják 25-40%-ot, az sem kevés. [link]

Egyébként a Cezanne egész versenyképes lenne szvsz, 180mm2-en hozna dupla olyan erős IGP-t és hasonló CPU-erőt, mint a 6+0-ás olcsó Alder Lake 162mm2-en, és annál a több csippel sem kell vesződni a gyártásnál. Bár gondolom, nem lenne racionális arra allokálni túl sok wafert, amikor a szerverekbe raklapszám viszik/vinnék óriási pénzekért a Milan(-X) CPU-kat, és a Cezanne is vélhetőleg drágábban gazdára talál notebookban....

#6320 carl18 : "Most meg nem akarják beismerni, és talán ez a oka amiért nincs jelen helyzetben olcsó cpu."

A korábbi "olcsó" CPU-ik mind egyfelől alulmaradtak sok szempontból a konkurenciától, másfelől relatív olcsó gyártástechnológián készültek, és a felépítésük/méretük is alkalmas volt az olcsó tömeggyártásra. A chipletes Zen2-ről ez nem mondható el. Az inkább a magas magszám mellett előnyös, nem véletlen főleg a 12 magos modellek igen jó ár/érték aránya, és emiatt is van, hogy nem igazán érdemes rá egy erős hatmagosnál kisebb verziót kihozni.

Tulajdonképpen úgy tűnik, az olcsó tömegmodellek beáldozásával tudtak igazán nagyot dobbantani mind notebook, mind asztali, mind szerver oldalon."a kisebb Cache ellenére ugyan annyi pontot gurit Cinebench R20 alatt mindig a nagyobbik társa"

Szerintem ne a Cinebench-ekből induljuk ki. Sok esetben fáj a negyedelt L3. Bár ettől függetlenül nem rossz CPU, de nem véletlen jött ki Zen3-ra épp a 96MB L3-as extra verzió.

"Az 5600X vs 12600K, az utobbi jelentősen többet tud Cinebench R20 alatt is."

A 12600K esetén különösen elengedném a Cinebench-et. A 4db E-core persze szépen meglöki a pontszámot, de finoman szólva sem vagyok róla meggyőződve, hogy ez tükrözi a mindennapi értéküket is. -

HSM

félisten

válasz

Petykemano

#6308

üzenetére

Petykemano

#6308

üzenetére

Az i3-12100 és i5-12400 igen jó lett, erős ár/érték aránnyal. Ezek ellen nem tudom, mit akarnak majd egy vágott Renoir-al.

-

HSM

félisten

válasz

Petykemano

#6266

üzenetére

Petykemano

#6266

üzenetére

"...hogy semmilyen architekturális hiányosságot, vagy spórolást nem lehet frekvenciával megoldani majd a jövőben."

Szerintem ők éppen a fordított verzióval próbálkoztak. Az architekturális hiányosságok éppen a magas órajel elérhetőségének érdekében kerültek beépítésre. Sajnos a megcélzott órajeltől messze elmaradtak, a hiányosságok maradtak, az eredményt pedig láthattuk. -

HSM

félisten

válasz

hokuszpk

#6238

üzenetére

hokuszpk

#6238

üzenetére

Technikai oldalról annak idején leginkább azzal magyarázták, hogy ezek a fajta tüskék nagyobb áramerősség átvitelére alkalmasak azonos érintkezőszám mellett.

Nekem egyébként szimpatikusabb, ha a foglalatban vannak a tüskék, általában egy alaplap jóval olcsóbb, mint egy CPU, ha valami nem sikerül jól, inkább azt dobom ki, mint a CPU-t.

-

HSM

félisten

válasz

hokuszpk

#6229

üzenetére

hokuszpk

#6229

üzenetére

"ez biztosan igyvan"

Én úgy tudom, nem teljesen van így. Ugyanis a dolog hátterében az (is) áll, hogy a 300-as lapoknál még kevésbé szigorú követelmények voltak a VRM vezérlőre, amit a 400-asoknál szigorítottak a megváltozott BOOST rendszer igényei szerint. Persze, biztos voltak lapok, amiknél már a 300-asra is olyan vezérlő került, ami megfelelő, de mivel nem volt előírva, így nem biztos, hogy minden lapon megfelelő van. Rakd össze ezt az 5000-esek tovább finomított PB algoritmusával meg curve optimizer, meg már alapból túl pici BIOS-chipek, és máris látszik, hogy mi okozza nekik a fejfájást.#6231 hokuszpk : "szvsz inkabb azt oldjak meg"

Terjeszd be a JEDEC-nek, hogy követeljék meg a DDR5 memóriák DDR4 foglalattal való kompatibilitását.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

válasz

Petykemano

#6218

üzenetére

Petykemano

#6218

üzenetére

Gondolom a kulcsszó a mennyiségi kedvezmény....

-

HSM

félisten

válasz

Petykemano

#6209

üzenetére

Petykemano

#6209

üzenetére

"ha esetleg az 5800X kurrens árával összevethető lenne (~$350), akkor a ki venné meg kérdés pontosan annyira lenne érvényes itt, mint korábban"

Egy ponton sántít a kérdés. Én személy szerint 3600-ast vettem 2700(X) helyett, de az 5600X is szvsz jobb vétel a 3700X-nél. Mégpedig, mert a két mag hiányát kompenzálja a magasabb órajel és IPC. A V-cache esetén ez nincs így. Bizonyos kódok lehet gyorsulnak vele akár extrém esetben 40%-ot is, míg más kódokban akár lassul is, mert az órajel nincs meg, a magas cache találathoz pedig elég a szintén méretes 32MB alapkiépítés is.

Ebben a kérdésben én biztosan a sima 5800X-ért mennék, ha éppen annyiba kerülne a képzeletbeli 5600X3D is. És valószínűleg az AMD haszna is magasabb lenne az 5800X-en.

És valószínűleg az AMD haszna is magasabb lenne az 5800X-en.

-

HSM

félisten

válasz

Petykemano

#6199

üzenetére

Petykemano

#6199

üzenetére

"And besides, both Intel and Nvidia have far higher margins but neither has abandoned the low end."

Ezzel az a gond, hogy GPU téren az AMD is hozott kicsiket. CPU fronton viszont nagyon nem jó ötlet szerintem az Intelhez mérni, utóbbinál nyilván sokkal komolyabb tervezési, gyártási, anyagi kapacitások vethetőek be, ugye erre utal, hogy már a rajtra volt 4-féle Alder lapka variáns. Asztali piacra egy 8+8-as és 6+0-s [link] , mobil piacra pedig egy 2+8-as, 6+8-as [link] . Ehhez képest a pirosak egy generációban jó, ha egy asztali chipletet és egy mobil APU-t tudnak hozni. Azt gondolom, figyelembe véve a két cég piaci helyzetét és erőforrásait, valamint egy lapka elindításának rendkívül magas költségeit a modern gyártástechnológiákon, ez is szép az AMD-től."de az, hogy nem is keresett alternatív kapacitás-forrásokat olcsóbb termékekhez az már arra utalhat, hogy elengedi az olcsóbb termékekkel szerezhető piaci részesedést a magasabb margó és a magasabb részvényárfolyamokért cserébe."

Vagy egyszerűen csak arra is utalhat, hogy nem akar költeni olyan termékekre, amik már a megjelenésükkor sem lennének versenyképesek.

-

HSM

félisten

Azonos órajelen lenne csak ezt értelme nézni. Illetve azonos csip-revíziókkal. Illetve az sem mindegy, hogy mennyi az eközben elvégzett munka. A kisebb L2-es modell azért is lehet elméletben hűvösebb, látszólag "takarékosabb", mert többet kell várnia adatra a memóriából, hiszen kevesebb esetben tud segíteni az L2.

-

HSM

félisten

válasz

Petykemano

#6193

üzenetére

Petykemano

#6193

üzenetére

"és frekvencia regresszió ott már túl nagy lett volna"

Szvsz ennyire nem fogyaszt sokat egy gyorsítótár. Főleg, hogy spórol is a fogyasztáson, amikor nem a ramokból kell előszedegetni az adatokat."akkor igazán kiadhatták volna 6 magos verzióként is"

Ott valószínűleg a költség lett volna túl nagy, ezt írtam is korábban, hogy inkább felsőbb modelleken tűnik nekem ez reálisnak."A Zen4 eléggé készen levőnek tűnik"

Épp ez is lehet a magyarázat. Ha jól haladtak a Zen4-el, akkor felesleges lett volna késleltetni egy köztes generációval. A Rembrandt esetén kihozták, mert ott mobilra úgyis kellett a versenyképességhez egy új lapka kicsit erősebb IGP-vel, magasabb órajellel és jobb órajel kapuzással."De hogy a malacoknak a Zen3D-ből is csak egy sku jut annak szerintem a Milan/Milan-X-re való kereslet lehet inkább az oka"

Vagy ez, vagy a költségek. Az Alder verziók elég erős ár/értéket hoztak, azok ellen nem tűnik jó ötletnek bevetni egy költségeket jelentősen növelő, kapacitásokat foglaló, de a teljesítményen általánosan akkorát nem dobó technológiát. Így is mindenki egy olcsóbb 5600X-et követel, nem mégdrágább 5600X3D-t.

Az Alder verziók elég erős ár/értéket hoztak, azok ellen nem tűnik jó ötletnek bevetni egy költségeket jelentősen növelő, kapacitásokat foglaló, de a teljesítményen általánosan akkorát nem dobó technológiát. Így is mindenki egy olcsóbb 5600X-et követel, nem mégdrágább 5600X3D-t.

"Ugyanakkor nem érzem azt, hogy maga a termék olyan nagy port kavart volna."

Nem kavart nagy port, hiszen leginkább olcsóbb gépekbe került, ugyanakkor ott azért lehetett pár igen jó review-t olvasni főleg az 5500U ár/érték arányáról.

Bennem személyesen Renoir tulajként az kavart egyébként nagy port, hogy míg az asztali variánsok tudták, a mobilból kimaradt az a pár fontos funkció, és ez sehol nincs világosan leírva, így bennem is csak utólag tudatosult, mikor pár dolog "furcsán" működött a már kezemben lévő laptopon az asztali 3600-asomhoz képest, és úgy nem volt túlzottan kellemes meglepetés egy 1000+ eurós gépnél. -

HSM

félisten

"Starcraft 2 miatt meg kell a brutális ipc és órajel. Sajnos az a játék nagyon kéri az egyszállas teljesítményt."

Arra a játékra világbajnok ár/értéket tudott a 3300X. Arra szinte 1:1-ben tudtál volna cserélni, amíg lehetett kapni. De ilyesmire a friss, kedvező árazású i3/i5 Alderek is szuperek lehetnek majd egy olcsó B660-ban.#6190 S_x96x_S : Nagyon jó!

Nekem kicsit hiányoztak az információk amúgy a Barcelo-ról, mi is az tulajdonképpen, mi fejlődött a Cezanne-hez képest. Gondolom, önmagában +100Mhz-ért nem kapott volna új kódnevet. -

HSM

félisten

válasz

S_x96x_S

#6182

üzenetére

S_x96x_S

#6182

üzenetére

"vagyis az átlaghoz képest - túlérzékeny vagyok ebben a témában."

//Üdv a klubban.![;]](//cdn.rios.hu/dl/s/v1.gif)

Én már annak idején a Ryzeneknél felemeltem a hangom, hogy a 4-magos CCX-ekre bontás, és magonként eltérő turbó órajelek nem feltétlen fognak minden szoftvernek jólesni. (Diplomatikusan fogalmaztam.

) Itt a harmadik ábrán látszik is: [link] .

) Itt a harmadik ábrán látszik is: [link] .

Ezek után engem már különösebben nem érdekel a dolog. Az új generációs processzorok jól átdobták a labdát a fejlesztőknek, oldják meg a probléma nehezebbik felét. Nekem ez különösebben nem tetszik (az Alder kapcsán is leírtam), nem tartom szerencsés iránynak, a legtöbb szoftverfejlesztőnek/cégnek nem lesz erre költségvetése/prioritása, hogy az összes elborult felépítésű processzoron jól fusson az elkészült software-stack...

Szerintem egyébként ez még jóval enyhébb, mint a big-little, itt azért azonos magokról beszélünk, csak az L3 mérete (így a hit-rate) különböző. Az se feltétlen borzalmas nagy baj, ha nem használod ki tökéletesen optimális kóddal, itt azért nincsenek olyan durva felépítési és egyéb korlátok, mint az Aldernél.

"és akkor ott vagyunk a "Thread Director" problémánál"

Szerintem alapvetően rossz ez az irány. Jó kis buzzword ma a gépi tanulás, de a jövőbe az sem lát. Szvsz más felépítés, ami felé mozdulni érdemes. Az AMD szerintem okos megoldást talált ki a skálázásra, az Alder-féle megoldás nekem inkább kényszer-szülte, erőltetett elképzelésnek tűnik. Ezt erősíti, hogy a középkategóriás asztali megoldásokból komplett ki is hagyták az e-magokat, és ME frissítgetésekkel próbálják tiltani, nehogy a user vissza tudja tudja kapcsolni a mesterségesen letiltott AVX512-t. Ez annyira vicces, hogy az már szinte fáj.

Szvsz más felépítés, ami felé mozdulni érdemes. Az AMD szerintem okos megoldást talált ki a skálázásra, az Alder-féle megoldás nekem inkább kényszer-szülte, erőltetett elképzelésnek tűnik. Ezt erősíti, hogy a középkategóriás asztali megoldásokból komplett ki is hagyták az e-magokat, és ME frissítgetésekkel próbálják tiltani, nehogy a user vissza tudja tudja kapcsolni a mesterségesen letiltott AVX512-t. Ez annyira vicces, hogy az már szinte fáj.

-

HSM

félisten

válasz

S_x96x_S

#6180

üzenetére

S_x96x_S

#6180

üzenetére

"( vagyis asszimetrikus architektura és szoftvert kell optimalizálini)"

Egyébként ezt még szvsz egész jól lekezelhetnék a szoftverek, hiszen az ütemező már generációk óta tudja kezelni a preferált magokat. Tulajdonképpen egyébként a mostani 2 CDD-s Ryzenek is ilyenek, egyik CCD általában magasabb órajelekre képes turbózni.

Tulajdonképpen egyébként a mostani 2 CDD-s Ryzenek is ilyenek, egyik CCD általában magasabb órajelekre képes turbózni. -

HSM

félisten

válasz

S_x96x_S

#6174

üzenetére

S_x96x_S

#6174

üzenetére

Valószínűleg az ár lesz itt a nagyon érdekes, mennyiért sikerült mindezt kihozni.

"Don’t get me wrong here, I think the technology is great. But in order for AMD to keep the same margins, it might be more expensive than people think."Azért gyanús, mert csak az 5800X kapta most meg. Szerintem ez inkább "halo product" lesz (akár a 12900KS), mint bármi más, egy chiplettel relatív olcsón megússzák, és egy kitűnő techdemó, mellé megszerzik vele a leggyorsabb gaming CPU címet is és némi gyártástechnológiai tapasztalatot is.

#6176 S_x96x_S : És ha már költségek, a Rembrand sem lett pici, 200mm2+. Ahogy sejthető volt, hiába 6nm, az sem lesz éppen olcsó tömegtermék alap, sőt.

Nekem tetszik, amit eddig látni belőle, bár kissé aggaszt a Pluton támogatása. Ha nem lesz kikapcsolható, akkor nekem biztosan nem lesz ilyen CPU-m.

-

HSM

félisten

válasz

Petykemano

#6170

üzenetére

Petykemano

#6170

üzenetére

Pedig mintha lett volna olyan AMD szabadalom, hogy bizonyos magok plusz utasításokat tudnak.

Ez lenne a logikus, azért teljesen felesleges külön magokat dedikálni, hogy csak egy korlátozott perf/watt tartományban dolgozhassanak, ezt ma is bármi meg tudja oldani FW/SW oldalról. Abban van jelentős takarékossági lehetőség, ha különbözőképpen optimalizált magjaink vannak, pl. lásd ARM oldalon az A5 és A7 magok különbségét.

Ez lenne a logikus, azért teljesen felesleges külön magokat dedikálni, hogy csak egy korlátozott perf/watt tartományban dolgozhassanak, ezt ma is bármi meg tudja oldani FW/SW oldalról. Abban van jelentős takarékossági lehetőség, ha különbözőképpen optimalizált magjaink vannak, pl. lásd ARM oldalon az A5 és A7 magok különbségét.

-

HSM

félisten

válasz

Busterftw

#6168

üzenetére

Busterftw

#6168

üzenetére

Hogy érted?

Én úgy tapasztalom, a középkategória az 1080P 60FPS-t célozza ma is maxon legalább. Sőt, az új konzolokkal már inkább a 60FPS és felette a cél. Más kérdés, hogy a VGA-k viszont drágultak, és így sokan ragadtak sokéves régi középkategóriás kártyákon, ami a legőújabb címekben inkább csak 30 FPS környékére jók, pl. [link] . -

HSM

félisten

válasz

Devid_81

#6166

üzenetére

Devid_81

#6166

üzenetére

"Is 1080p Max possible?

My goal for integrated graphics is for it to be suitable one day for 60 FPS gaming at 1080p maximum settings. At these settings, we're asking a lot of the graphics solution to do lots of compute, sometimes with memory bandwidth that just isn't there. A normal suite does a few of these 1080p Max tests, and the results are almost always dismal:

The short answer is no. You're lucky to break 10 or 20 FPS in most cases." [link]Sajnos, ezt 2-vel megszorozva sem lesz óriási teljesítmény. Persze, régebbi vagy nem túl GPU-intenzív játékokra, vagy közepes részletességű, nem túl magas képkockasebességű FHD játékra jó lehet.

Ez a teszt is érdekes: [link] .Én egyébként éppen tegnap próbáltam ki a StarCraft2-t a Ryzen 4650U IGP-n, ~20W TDP-n egész szépen (jóindulattal 60 FPS körül) futott 1080P maxon. A régebbi lassú IGP-khez képest ez egy csoda, de egy akár 4-5 éves középkategóriás dedikált GPU-tól is még relatív messze van, lásd az előző teszt GTX1060-asát.

-

HSM

félisten

válasz

Petykemano

#6158

üzenetére

Petykemano

#6158

üzenetére

"Ami nagyon meredek az az 1-1 priority és LTDP mag között megosztott 1MB L2$. Ez most egyfajta visszakanyarodás/visszanyúlás a Bulldozer irányba?"

Ez egy nagyon jó megoldás is lehet. Ha ez így van, bármelyik takarékos magról minimális késleltetéssel átrakható lehet egy feladat a gyors közös L2 révén az ahhoz a maghoz tartozó erős magra.

Ha ez így van, bármelyik takarékos magról minimális késleltetéssel átrakható lehet egy feladat a gyors közös L2 révén az ahhoz a maghoz tartozó erős magra.  Szvsz egy jobban megvalósított, ebben a formában sokkal életképesebb Alder.

Szvsz egy jobban megvalósított, ebben a formában sokkal életképesebb Alder. #6162 Devid_81 : Már a Renoir-ban is egész erős iGP volt.

#6164 Devid_81 : A mostani Vega IGP azért nem felsőkategóriába való. Valószínűleg az újabbaké is kevés lesz ahhoz. De egy erős, költséghatékony belépő/alsó középkategóriának igencsak jónak ígérkezik.

-

HSM

félisten

"De a fogyasztok nagy része azt veszi ami árban is elérhető."

Szerintem ne az itthoni helyzetből induljunk ki... Értem én, hogy olcsó, meg ár/érték, de túlzottan nem egy erős CPU. Viszonyításképp, az ultrahordozható ~15W-os laptopomban erősebb CPU van, amiről most írok... (Ryzen 4650U)

Értem én, hogy olcsó, meg ár/érték, de túlzottan nem egy erős CPU. Viszonyításképp, az ultrahordozható ~15W-os laptopomban erősebb CPU van, amiről most írok... (Ryzen 4650U)  Az asztali Ryzen 3600 pedig lesöpri őket tokkal vonóval, pedig azt sem egészen 60K-ért vettem, tehát erősen "budget" opció volt.

Az asztali Ryzen 3600 pedig lesöpri őket tokkal vonóval, pedig azt sem egészen 60K-ért vettem, tehát erősen "budget" opció volt.#6124 Petykemano : Sajnos nem tudom megítélni, megkésett-e, elég kevés róla az információ(m).

"egy Zen2-es CPU-val szerelt APU kissé elavultnak tűnik"

Ezt viszont határozottan nem gondolom problémának, a Zen3 legnagyobb dobása, hogy egyesítették a korábbi kettévágott felépítést, de 4 magnál ez a Zen2 hátrány egyáltalán nem jelentkezik. Így azt gondolom, ez is így "elég jó". Persze, belerakhatnának egy Zen3-at, de szvsz leginkább papíron nézne csak ki jobban.

Azért lenne szvsz érdekes a magméret, mert abból lehetne következtetni, mennyire lenne gazdaságosan gyártható belépő terméknek, de sajnos erről semmit nem találtam. Ugyanakkor a Renoir APU pl. elég nagy, ~150mm2 , az nem jó ilyesmire. [link]

A mag képe alapján jó alaposan meg kéne nyirbálni a GPU és IO részeket is, hogy lényegesen kisebb lehessen: [link] . Azért sem vagyok benne biztos, hogy a Van Gogh jó lenne ilyesmire, mert ott vélhetőleg még nőtt is a GPU rész, a fél CPU elhagyása önmagában még nem teszi picivé a csipet, így az inkább prémium hordozható gépekbe lehet ideális, mint pl. a Steam Deck, és kevésbé tűnik ideálisnak olcsó tömegterméknek.Persze érdekes kísérlet lenne ezt kihozni asztalra, azért lehet, hogy akadna piaca a jó IGP-nek egy nem túl erős CPU-val. Ez jó alternatívája lenne a régi, igen gyenge IGP-jű i3-aknak. A Kaveri-s időkben olcsóbb volt a GPU, és gyengébbek az IGP-k.

-

HSM

félisten

"De azért a konkurencia is közbe fejlődik,+ az intel magának gyárt, így őket nem fogja vissza a TSMC készlethiány."

Pont ezért tehetik meg, hogy terveznek egy gazdaságosan gyártható i3-at is, míg az AMD vélhetőleg jobban teszi, ha nem erre a piacra fókuszálja a jóval korlátozottabb lehetőségeit. Pl. érkezőben a Rembrandt, az igen kritikus lesz a mobil Alder Lake variánsok ellen a prémium/ultraportable mobil szegmensben.

Pl. érkezőben a Rembrandt, az igen kritikus lesz a mobil Alder Lake variánsok ellen a prémium/ultraportable mobil szegmensben.A visszaportolt 12nm egyébként nem lenne rossz ötlet, fel is reppent párszor a pletyka (Monet), kérdés, hogy megfelelő fogyasztást és órajelet el tudnának-e vele érni úgy.

Egyébként van még egy érdekes fejlesztésük, a Van Gogh, arra is azért kíváncsi lennék, pl. mekkora fizikai méretből sikerült kihozni (4mag Zen2 + RDNA GPU, Steam Deck). Bár vélhetőleg az sem egy ideális olcsón gyártható tömegtermék alap.

-

HSM

félisten

A belátás egy dolog, más dolog, hogy megérné-e nekik ezért egy új csipet tervezni, ami vélhetőleg más, fontosabb piaci igények elől vonná el a fejlesztőket és a gyártási kapacitást.

A 12400F-re szvsz hozható versenytárs a jelenlegi megoldásokkal, a 12100F ellenében viszont nem ártana egy kisebb csip, hogy gazdaságos is legyen azon az árszinten. -

HSM

félisten

"az intel árazásai mellet a 5600X elégé drága dolog"

Azért azt ne felejtsük el, hogy a 12400F-et elég cudarul visszafogták, ha minden igaz, a maximum 4Ghz órajelével.

Illetve az 5600X a jelenleg elérhető konkurens modellektől nem marad el sokkal ár/értékben sem: [link] .

Nekem is tetszene egy jóárasított sima 5600, kérdés, hogy ennek mennyi realitása van, amikor drágább termékekbe is elkel minden 5000-es chiplet.

-

-

HSM

félisten

válasz

S_x96x_S

#6108

üzenetére

S_x96x_S

#6108

üzenetére

Az utolsó két pontod szerintem a lényeg. És hozzávehetjük, hogy a jóval olcsóbb TRx4 CPU-k sok felhasználási módnál alig lassabbak a TRx8-nál, tehát gyakorlatilag a saját prémium termékeik elől szívnák el a keresletet az olcsóbban adott, de lényegesen alacsonyabb profitrátájú alternatívával....

Illetve a TRx4 "HEDT" funkciója is szvsz elveszett, mióta az AM4-ben is elérhető akár 16 mag is.

-

HSM

félisten

válasz

Petykemano

#6104

üzenetére

Petykemano

#6104

üzenetére

Itt szerintem a pénz is játszik... Minek tartsák meg a kicsi TR vonalat, amikor úgysem tudnak eleget gyártani és konkurencia sincs... Akinek nem elég az AM4 teteje, legalább fizethet többet a PRO-ért.

Majd ha lesz konkurencia, meg nagyobb termelés, majd feltámasztják ezt is.

-

HSM

félisten

válasz

S_x96x_S

#6066

üzenetére

S_x96x_S

#6066

üzenetére

"de ez alá bemenni kockázatos. ( ~ érhetnek kényelmetlenségek )"

Továbbra is az a meggyőződésem, hogy kellemetlenségek akkor érhetnek, ha ilyen ökölszabályokra bízod, ahelyett, hogy alaposan átgondolnád, és utánanéznél, mennyi ramra is lesz szükség egy adott felhasználásra, különös tekintettel figyelembe véve (és lehetőleg elkerülve) a bővíthetetlen memóriájú konfigurációkat. Én ezzel zárnám is a témát.

-

HSM

félisten

válasz

S_x96x_S

#6064

üzenetére

S_x96x_S

#6064

üzenetére

"ahol a szűk keresztmetszet a memória sávszél, ott számít."

Nyilván... Ugyanakkor így nem áll meg általánosan, hogy visszafogja, hiszen csak néhány specifikus felhasználásban van mérhető különbség.

Ugyanakkor így nem áll meg általánosan, hogy visszafogja, hiszen csak néhány specifikus felhasználásban van mérhető különbség."Amúgy valószínüleg erős 16 maggal és 64 GB memóriával még kényelmesebb lenne ( Gen4-es SSD-vel alatta )"

Persze, több/erősebb mag mindennek jót tesz, de 64GB rammal éppen semmire sem mennék, egy átlagos munkanapon a 70%-át sem érem el a jelenlegi 24GB ramom maximális használatának. Ugyanakkor egy 16 magos munkaállomást hurcolni lényegesen kényelmetlenebb lenne, mint a mostani 14"-os, 1,5kg-os ultrabookot.

A Gen4 nem hat meg, már rég nem a sávszélesség az NVMe szűk keresztmetszete, sokkal inkább a NAND késleltetése. Maradok a jól bevált Gen3-as Samsung 970 Pro-mnál.

"te meg egy 2 és 6 magos példát hozol."

Gondoltam így is átmegy a mondanivalóm. Ugyanígy igaz lenne 32 magra, mit csinálnék a heurisztikád szerint 128GB rammal?! Üresen állna belőle állandóan ~100GB, jó befektetés lenne.

Üresen állna belőle állandóan ~100GB, jó befektetés lenne. -

HSM

félisten

válasz

S_x96x_S

#6061

üzenetére

S_x96x_S

#6061

üzenetére

"És ha azt mondjuk reflexből - a te heurisztikád alapján - hogy 8GB vagy ha van pénze akkor 16GB;"

Az én heurisztikám, hogy megkérdezem, mire fogja használni a gépet, és mik az elvárásai és anyagi lehetőségei, az elsődleges szempont pedig a felhasználási terület. 8GB-ot legfeljebb netezős/"office" felhasználásra szoktam javasolni, nyilván relatív olcsó gépekbe, arra bőven elég (csak mértékkel a Chromium-al![;]](//cdn.rios.hu/dl/s/v1.gif) ).

)."ahol a 4 csatornás memória - 32 mag felett már eléggé visszafogja a teljesítményt."

Anandék tesztje épp az ellenkező konklúzióra jutott: [link] .

De ez szerintem nem igazán kapcsolódik a témához."Talán te valószínűleg nem telepítesz fel új programokat, beéred a régi 5-10 éve megjelent játékokkal, felhasználói programokkal a következő 5 évben is"

Fogalmam sincs, ezt a következtetést miből vontad le. Szakmámból kifolyólag nem engedhetem meg magamnak a luxust, hogy ne legyek naprakész szoftver ügyileg.

A saját példám alapján a korábbi kétmagos laptopomon is nagyjából 20GB kellett a kényelmes munkavégzésemhez, a mostani 6-magoson is éppen ennyi kell. Pedig a heurisztikád egészen mást mondana erre."akkor nem árt a ráhagyás a tervezésben ---> vagyis a fölé tervezés."