- Xiaomi 14T Pro - teljes a család?

- Honor Magic6 Pro - kör közepén számok

- Xiaomi 13 - felnőni nehéz

- iPhone topik

- Nothing Phone (3a) és (3a) Pro - az ügyes meg sasszemű

- Samsung Galaxy S21 és S21+ - húszra akartak lapot húzni

- Android alkalmazások - szoftver kibeszélő topik

- Íme az új Android Auto!

- Samsung Galaxy Watch7 - kötelező kör

- Samsung Galaxy S24 FE - később

Új hozzászólás Aktív témák

-

Abu85

HÁZIGAZDA

válasz

cskamacska

#30041

üzenetére

cskamacska

#30041

üzenetére

A PUBG azért ilyen, mert nagyjából másfél éves az UE4 alapja. Ez a Vega számára nem nagy gond, mert tud vele mit kezdeni az új raszterizálójával, ami kapott új profilt is a 17.8.2-es meghajtóban, tehát nem itt van a vége, amit a linkelt tesztben látsz. A régebbi hardvereknek hiányzik az a másfél év, amiben benne volt a 4.16-os UE4 frissítés is, amiben pont kapnak egy megfelelő kezelést azok a hardverek, amelyekben nincs draw-stream lehetőség. Ezért is tud a Vega az 1080 Ti nyakára mászni, ha nincs bandwith limitje a még nem aktivált pseudo channel mód hiányában.

Szóval ez nem szeretethiány. Egyszerűen a Vega hardverből képes bizonyos problémákat kezelni, amit más hardver nem tud, és nem is lett beépítve a játékba a problémák szoftveres kezelése sem. Nyilván ebben benne van Early Access is.Az ARK fentebb ki lett beszélve. A Windows Store verzió lényegesen gyorsabb mindenen. Érdemes azt vásárolni, ha a Steam verzió teljesítménye nem elég.

-

#00137984

törölt tag

válasz

cskamacska

#30013

üzenetére

cskamacska

#30013

üzenetére

A visszafelé kompatibilitás most akkor nem annyira érdekes AMD-nek, mert mindent a Win10-re és a DX12-re tesznek fel. Rengeteg DX9-10-11 játék van amiről nem szivesen mondana le egy játékos, hogy a legfrissebb játékokban egy kis előnyt élvezzen az Nvidia videókártyákkal szemben. Előre elterveznek néhány évet megemlitve az AMD GCN architektúra Next Gen tudásbeli fölényét, de a DX12-re optimalizált hardveres felépitéssel nem érték el kiemelkedően jó teljesitményt. A GCN 1-2-3 generációk lemaradása egyre nyilvánvalóbb és az R9 390X videókártya kivételével nem hoztak ki még egy ilyen jó játékos kártyát. Nvidia jobb a régi játékok többségében és ez a teljesitmény kiegyensúlyozottabb a régi és új játékcimekben. A 2017 Q4 és 2018-ban megjelenő játékokra meg kiadják a Volta videókártyákat és az már DX12-ben szintén nagyobb tudású lesz, és remélhetőleg a régi DX9-10-11 játékok jó futtathatósága megmarad. Itt még a GTX 1070 vagy GTX 980ti teljesitménye ér majd valamit, de még akár egy GTX 970 vagy GTX 1060 6GB tulajoknak marad egy kis idejük játszani a fejlesztések előtt. R9 390X szerintem még jó lehet közepes kompromisszumokkal.

-

->Raizen<-

veterán

válasz

cskamacska

#30013

üzenetére

cskamacska

#30013

üzenetére

A legteljesebb dx12 támogatást most a vega hozza. Ez oké meg rendben is van. De nv oldalon sem ülnek a babérokon szerencsére a programozók. Tényleg sokat számít a low level mert kvázi sokat tudnak optimalizálni a fejlesztők a grafikus motoron hogy később jobban menjen a játék. Tökéletes példa a forza horizon 3. Nagy gépigénnyel jött ki minimum 6600k meg ilyenek. Aztán kb lassan 1 év alatt addig addig patchelgették, amíg eljutott egy olyan szintre a program hogy a korábbi max high presetes beállítást nyugodtan lehetett ultra presetre tenni és a gépem ugyan az! Gtx 970, i5 6600k. Persze korábban 1 magot terhelt a program, de most már többszálúságra is fel lett készítve és már városban sem laggol tökéletes látványt nyújtva repeszt mindenhol. Jó látni hogy tényleg nem függ már annyira egy vga drivertől a teljesítmény. Na de kérem, azért az nv is fejleszett a drivereken, hogy minél jobban menjenek a kártyái. Az amd nem tud már jelentős teljesítmény többletet sem felmutatni ami azért korábban ment nekik low level alatt. Ez elgondolkodtató. Lehet venni most akármilyen hardvert, mindenen jól fognak menni a játékok egy bizonyos szinttől. És ez jó.

-

mcwolf79

veterán

válasz

cskamacska

#30013

üzenetére

cskamacska

#30013

üzenetére

A remény és a várakozás.

A kulcsszó a szokásos: MAJD.

Szerencsétlen AMD-sek erre a sorsra vannak kárhoztatva már jópár éve

-

Abu85

HÁZIGAZDA

válasz

cskamacska

#29972

üzenetére

cskamacska

#29972

üzenetére

Mindenen jobb. A Microsoft UE4 optimalizálásai nagyjából annyiból állnak, hogy végigmentek rajta a PIX Xbox One verziójával, és az így optimalizált kódot visszaportolták PC-re. Természetesen a shaderek jellemzően Xbox One-ra vannak optimalizálva, de maga a leképező sokkal hatékonyabban működik, tehát abból már minden hardver nagyon sokat nyer.

(#29973) huskydog17: Nekem olyan mindegy, hogy ki melyik verzión játszik. Én csak elmondtam, hogy van egy sokkal jobb port is.

Ha nem adnák háromszor többért, akkor elfogyna a pénzük. Aztán majd eldöntöd, hogy megveszed-e. Ők is csak kényszerből cselekednek.

-

#45997568

törölt tag

válasz

cskamacska

#29627

üzenetére

cskamacska

#29627

üzenetére

Nekem megvan a V(e)GA-m, innentol onzo modon az arazas a tovabbiakban miert erdekeljen?

Amikor a 1080 megjelent, pontosan ezen az arakon indult a FE mint amiert vettem a VEGA-t, a teljesitmenyuk ua, a 1080 ara beallt idovel, a VEGA-ra is ez a sors var, foleg ha sikerul a banyaszokat kiutni a nyeregbol.

Szoval nem kell feltetelezni, done.

-

Abu85

HÁZIGAZDA

válasz

cskamacska

#29424

üzenetére

cskamacska

#29424

üzenetére

A Vulkan aktuális, és igazából a startra felhasználható verziója nem tud mindent, ami kell. Például nincs benne multi-GPU, míg a DX12-ben van. Emellett hasznos, ha van egy alternatív API-d. Igazából csak két back-end kell a motorba. A teljes költséghez képest ez elhanyagolható költség és számos előnnyel jár, hiszen kapásból kedvezőbb döntéshelyzeteket teremt, hogy xy játékba melyiket aktivált (opcionálisan akár mindkettőt).

A Unity-ben már van Vulkan és DX12 is. Főleg a Vulkan leképező, ami jól áll.

Az Epic a SIGGRAPH-on beszélt erről. A Vulkan elég jól áll a 4.17-es verzióban. Már az SM5-ös leképező és RHI (ez a layer, ami a motor és az API között van) az alapértelmezett a Vulkan desktop implementációihoz. Lényegében mindent tud, amit a DX11-es verzió, csak pár apró effekt hiányzik, amit később hozzáadnak. De a rendszer stabil és működik. Hamarosan ez lesz Linuxon a default RHI az OpenGL 4.3 helyett. Windowson még marad a DX11 és a DX12, de később ki tudja.

Azt is elmondták, hogy a következő időszakban optimalizálják a bekötéseket és párhuzamosítják az RHI-t. A GPU oldalon a még hiányzó effekteket pótolják, majd nekimennek a motor optimalizálásának a Radeon GPU Profilerrel és a RenderDoc párosával. Ehhez Sweeney már kapott egy saját Vegát, és úton a többi is. Ezek most a prioritások.Az async compute-ot tudja, csak egy időre kikerült, mert furcsán viselkedett, de aztán készült hozzá egy másik implementáció, amivel újra visszakerült.

A mostani DX12 játékok leginkább semmit nem használnak a nagyobb feature_levelekből. A hardverek a bekötési szintjüknek megfelelően dolgoznak, de igazából sok esetben a motor bekötési modellje még mindig a DX11-hez illeszkedik.

A következő lépés a DX12 bekötési modelljéhez való illeszkedés. Ez az, ami most történik a motorokban. Ezzel kihasználásra kerülnek a resource binding és a resource heap fícsőrök. A resource bindingről eléggé sokat beszéltünk, és ismert az is, hogy mi a különbség a Tier szintjei között. Megjegyzem, hogy belinkelt képen lévő táblázat tuti hibás, mert ha Tier3-as a resource binding szint, akkor nem lehet fix értékben meghatározni az UAV slotok számát. Mindenképpen a teljes halmaz lesz felhasználható, vagyis akár egymillió. Ha a hardvert nem készítették fel erre, akkor ezt emulálni kell a videomemóriában, de Tier3-as visszatéréssel ez nem korlátozható.

A resource heapről kevésbé beszéltünk. De ennek is van két szintje. Röviden a fícsőr több típusra kategorizálja az erőforrásokat. A Tier1 szinten az alkalmazás csak olyan halmazokat hozhat létre, ahol a flagek csak egy kategóriába sorolt típust engednek használni. Tier2 szinten értelemszerűen olyan halmazok is létrehozhatók, ahol a flagek megengedik az összes típus használatát. Utóbbival hatékonyabban működtethető a hardver. Ennyi.

Feature_Levelből 11_1-re ugrunk, mert ez minimum szükséges a DX12 bekötési modelljének optimális használatához. Bizonyos motorok ugorhatnak 12_0-ra, leginkább a shader modell 6 miatt.A ROVs lehet potenciálisan probléma, de ez a Vegát leszámítva rendkívül lassú minden eddig megjelent dedikált GPU-n. Az Intel IGP-in gyors még, azokból csak a nyers erő hiányzik. Főleg emiatt nem használták eddig a DX12-ből ezt a képességet. Valamit támogatni nem minden, a teljesítményt is alá kell rakni. A hiányokat megtalálod az Intel Pixelsync játékok összehasonlító képeinél. Páran csináltak ilyet. A ROVs ugyanezt kínálja.

A konzervatív raszterizálás iránt a legtöbben a GPU-s occlusion culling lehetősége miatt érdeklődnek. Ezt ma leginkább egy CPU-s feladat, de ezzel az újítással áttehető GPU-ra. Viszont ez mindenképpen igényli az inner input coverage funkciót, ami csak Tier3-as szinttől van, tehát ebből maximum csak sebességhátrány lehet, mert egy CPU-s occlusion cullingot úgyis megtartanak a motorokban fallbacknek. Ezt leginkább az Intel erőlteti, mert ők ebből sokat nyernének, és nyilván a Vega mellett az AMD-nek is érdeke lesz. Más hardveren nincs sok érdek mellette, mert nincs támogatva az inner input coverage. Opció lehet még használni a sub-pixel shadow map, ami értékes, és Tier1-től támogatható, illetve gyorsítható vele a mozaikos leképezés is. A Tier2 eléggé haszontalan szint önmagában, valószínűleg csak azért került be, mert az NV Pascal nem támogatta a inner input coverage-et, de képes volt arra, hogy ne vágja ki a degeneratív háromszögeket.Az FP16-ra nyilván az AMD nagyon rá fog feküdni, de ezzel igazából csak teljesítményt nyernek a GCN3/4/5-nek.

-

Shing

őstag

válasz

cskamacska

#29424

üzenetére

cskamacska

#29424

üzenetére

Na az tök jó ha lesz Vulkan és DX12, mert összelehet őket hasonlítani. Szerintem nem fognak törődni a régi szériákkal új címeknél. Láthatóan semmit nem ér a DX12 ha nem optimalizálnak kizárólag a legújabb fícsörökre.

-

Puma K

nagyúr

válasz

cskamacska

#29404

üzenetére

cskamacska

#29404

üzenetére

Milyen géppel nézted az általad felsorolt játékokat?

GLORIOUS MASTER RACE GAMING PÉCÉ-n belül nem tudni milyen komponensekkel rendelkezel.

-

Abu85

HÁZIGAZDA

válasz

cskamacska

#29404

üzenetére

cskamacska

#29404

üzenetére

Nem lesz olyan. A bekötési modell problémája miatt. Vagy a DX12-re tervezed vagy egy legacy API-ra. Igen jól látszik ez a problémakör a Wolf 2-nél, ahol két API lesz, de mindkettő explicit (Vulkan/DX12). De ott az AnvilNext következő verziója is, ami DX12-t támogat, míg a DX11 egy wrapperen keresztül megy. Nem megoldható a kettő együtt. Vagy az egyiknek lesz rossz, vagy a másiknak. Manapság értük el, hogy a legacy API-nak legyen rossz.

-

Puma K

nagyúr

válasz

cskamacska

#29236

üzenetére

cskamacska

#29236

üzenetére

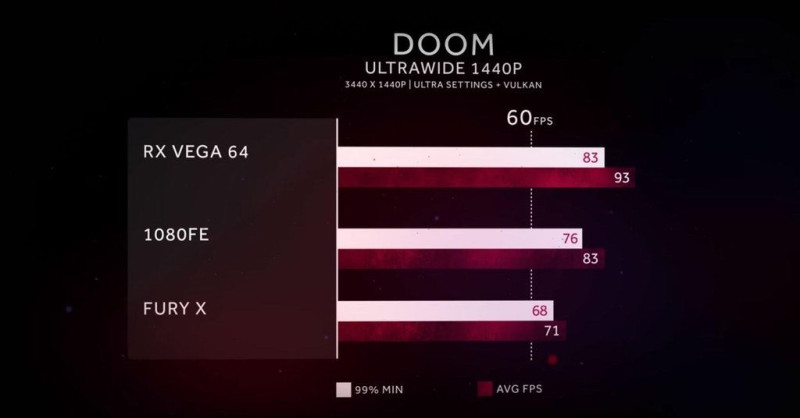

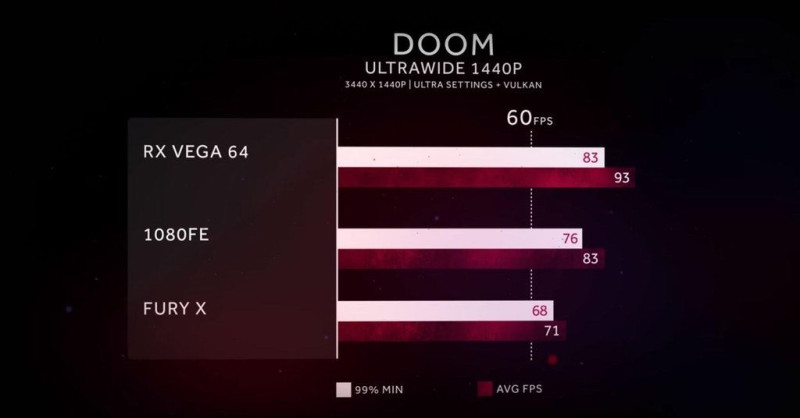

A gyári alap órajeles (FE) GTX 1080-at lelépi Doom-ban Vulkan api-t használva,

1 év után, 400W-ból... Volta ellen

Mi lesz itt jóval populárisabb és technikai szempontból átlagos játékok alatt amik csupán DirectX-et használnak...?

-

válasz

cskamacska

#29236

üzenetére

cskamacska

#29236

üzenetére

Piti vagdalkozás? Pff! Elolvastad egyáltalán, amit írtam?

Igen, a Vega nagy szar lett, sokat zabál, de legalább nem megy. Valamit nagyon elkefélt az AMD.

-

#45185024

törölt tag

válasz

cskamacska

#27517

üzenetére

cskamacska

#27517

üzenetére

Ez egy picit jobb szerintem meg fiúk imádjál lineárisan nézni itt

RX 580 vs GTX 1060 Frame Time Analysis - Prey RYZEN 1600

Na egyből érdekesebb két jó kártya eredményét nézegetni

nem holmi pr refeket... -

Crytek

nagyúr

válasz

cskamacska

#27517

üzenetére

cskamacska

#27517

üzenetére

Akinek nagyon kihajccsa

Remove FPS Cap:

Open %UserProfile%\Saved Games\Arkane Studios\Prey\game.cfg in a text editor

Look for the line with "sys_MaxFPS"

Change the value from 144 to 999 -

#85552128

törölt tag

válasz

cskamacska

#27517

üzenetére

cskamacska

#27517

üzenetére

"az AMD kártyák gyengébb procikon ennyire beállnának?"

Hol tetszett lenni az utóbbi ~10 évben ? Itt azért ekkora a különbség, mert grafikailag nem nagy szám a játék úgyhogy hamarabb fut CPU limitbe, mert 100+ FPS megvan még egy középkategóriás kártyán is. De ez mindig is megvolt, gyengébb prociból egy nV kártya több FPS-t tud "kipréselni".

Elnézve a grafikonokat szerintem ezzel a játékkal nem nagyon lesz Vega demózás

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Motorolaj, hajtóműolaj, hűtőfolyadék, adalékok és szűrők topikja

- PlayStation 5

- Xiaomi 14T Pro - teljes a család?

- Xbox tulajok OFF topicja

- Honor Magic6 Pro - kör közepén számok

- Milyen program, ami...?

- Trollok komolyan

- One otthoni szolgáltatások (TV, internet, telefon)

- Melyik tápegységet vegyem?

- Battlefield 4

- További aktív témák...

- Csere-Beszámítás! Sapphire Nitro+ RX 7800 XT 16GB GDDR6 Videokártya! Bemutató Darab!

- Garis ZOTAC GeForce RTX 4070 Ti Trinity 12GB GDDR6X videokártya

- ASRock Radeon Challenger Pro RX 6700 XT 12GB OC Videokártya

- Csere-Beszámítás! Asus Prime RTX 5060Ti 16GB GDDR7 Videokártya! Bemutató darab!

- 3 hónapos Sapphire NITRO+ AMD Radeon RX 7900 XTX Vapor-X 24GB, még 33 hónap garanciával

- Microsoft Surface Laptop 3 - 15 col - Fekete

- ÁRGARANCIA!Épített KomPhone i5 13400F 16/32/64GB RAM RTX 5070 12GB GAMER PC termékbeszámítással

- Telefon felvásárlás!! Xiaomi Redmi Note 13, Xiaomi Redmi Note 13 Pro, Xiaomi Redmi Note 13 Pro+

- LG 32SQ700S-W - 32" VA Smart - 3840x2160 4K UHD - 62Hz 5ms - WebOS - Wifi + BT - USB-C - Hangszórók

- PROCASTER 40UNB700 40" 101cm televízió + Számla + Garancia

Állásajánlatok

Cég: Promenade Publishing House Kft.

Város: Budapest

Cég: CAMERA-PRO Hungary Kft

Város: Budapest