- Sony Xperia 1 VII - Látod-e, esteledik

- Komoly akcióval érkezik Magyarországra a Honor Magic V5

- Samsung Galaxy Z Flip5 - ami kint, az van bent

- Samsung Galaxy Z Fold7 - ezt vártuk, de…

- Hivatalos a OnePlus 13 startdátuma

- Szinte játékpénzért megvehető a Honor Play 10C

- Samsung Galaxy Z Fold5 - toldozás-foldozás

- Samsung Galaxy Watch4 és Watch4 Classic - próbawearzió

- Samsung Galaxy Watch8 - Classic - Ultra 2025

- Samsung Galaxy A54 - türelemjáték

Hirdetés

Új hozzászólás Aktív témák

-

Zoli0726

aktív tag

Nem, egyelőre csak ő kritizál engem, egy olyan kódról ami rossz, bár sosem látta

Peak/peak nem jön ki? Kész, mivel minden kód pont ugyanazokat a műveleteket hajtja végre, mint a peak számolás, float összeadást + szorzást, ezért lehetetlen, hogy ennél jobb arányt kapjak.

Tény, hogy az opencl-es kód megkérdőjelezhetően optimális cpu-n, viszont semmiképp sem érzem úgy, hogy irreleváns dolgot mondtam volna, tekintve, hogy a linkelt algoritmusokban is volt 33x-os gyorsulás is.

Egyszerűen azok a feladatok a gpu-nak feküdtek, ha annyira, hát annyria. Ha baki lett volna benne, már rég észrevették volna, mivel amint mondtam, mi nem aknakeresőt írunk. Ezzel együtt nem kicsit nagyképűen azt állítod, hogy az velem együtt az összes munkatársam is béna, és te mennyivel jobb vagy csak azért, mert a gpu egy feladatban, aminek sem az elméletét sem az implementációját nem ismered, el tudott húzni ennyivel. Ezzel együtt leszarozod a computebench dolgozóit is, mert nekik 33x-os teljesítménytöbblet is kijött, amiben ha másfélszeres overhead van, még úgy is kijön amiről beszéltem.

Ezzel én ezt a latolgatást befejeztem, amint az látható úgy sem fogunk megegyezni.

Azt, hogy nem láttál gpu-t egyáltalán nem neked szántam. Nem te írtad, hogy egy corei7-t sosem lehet gyorsabb mint egy kaveri. Az oda volt címezve, de ezt már mondtam egyébként is.

-

Zoli0726

aktív tag

Csak olvasok, írni nem írok, miféle hülyeség lenne már, hogy 2 work-item ugyanarra a helyre írja az eredményét. Természetesen az olvasás is úgy van megoldva, hogy eltoltan olvassák a work-itemek a tömböt, hogy ne legyen adathozzáférési probléma. Az eredmény elfér egy változóban is. Szinkronizálva nincs, de kb 0 az esélye, hogy ugyanabban az időben ugyanazt az adatot próbálná meg olvasni két work-item. Annyira azért nem gyakoriak az olvasások a sok számolás miatt. Ahhoz valakinek a 256 közül nagyon be kellene gyorsítani. Nem vizsgáltam ilyen szempontból a dolgokat, de ha 1-2 fennakadás még lenne memória olvasás miatt, annyit a szink is rontana.

Egyébként én nagyon úgy érzem, hogy elkanyarodtunk arról, hogy nem csak a cpu/gpu peak a lényeg, hanem az adathozzáférés, ami gpu esetében jobb. -

Zoli0726

aktív tag

Tényleg nem érted, de lehet, hogy én fogalmaztam érthetetlenül.

Vannak adataim, minden work-item-nek végig kell magát zongorázni rajtuk. Egyszerűen, csak annyit csinálok, hogy a globálisból a lokálisba másolom, és ott zongoráztatok, mivel belefér. Bekerülnek lokális tömbökbe. Tehát a teljes tömbön végig kell menni minden work-itemnek. Viszont ahhoz túl nagy, hogy minden work-itemnek odamásoljam a teljes tömböt, egy köztes megoldás az, hogy akkor a lokálisba másolom, bár közösködni kell, de onnan mégiscsak gyorsabb az elérés, mint a globálisból. A cpu kód meg természetesen nem akkor optimális mint a gpu, de senkit nem érdekel, mikor optimális az opencl kód cpu-n ha úgyis a gpu-n akarom futtatni. A feldolgozásnál ettől függetlenül nem befolyásolják egymást a work-itemek, így értem a függetlenséget, tehát nincs szükség szinkronizációra. Remélem így már világos. -

Zoli0726

aktív tag

Nagyon egyszerűen. Szinkronizációra nincs szükség, az adatok egymástól teljesen függetlenek. Ahogy az eredmények is. Lokális memóriát úgy használok, hogy az adatokat a globálisból a lokálisba másolom, és attól kezdve local id-val idexelek. Illetve a változók is lokális memórában tömbök, így függetlenül elérhetik őket a work itemek. Szerencsére belefértek a keretbe. Ez egy bevett szokás:

http://www.openclblog.com/2011/03/is-your-local-memory-really-local.html?m=1 -

Zoli0726

aktív tag

Nem azt jelenti, hogy így össze kell szorozni, hanem azt, hogy valszeg nálam ennyit jelentett, de igazoltam is, mennyit jelent a lokális memória használata a fenti linkben, amiből az következik, hogy sokat, tehát elérhető Velük az a teljesítmény amiről itt szó van. Tehát nem minden a gpu peak/cpu peak. Azzal a CPU kóddal meg az égvilágon semmi baj nincs, hidd el ülnek még mellettem a munkahelyen olyanok, akik már akkor,programoztak, amikor én még csak a kallofdjutit ismertem a gépen, nem találtak benne kivetnivalót. Nem mentem át assembly-be optimalizálni,de logikailag korrektül volt felépítve, azóta meg ha csak lehet gpu-zunk. Inkább nekem kellene a te kódjaidat megnéni, ha számodra ezek az, eredmények Ennyire hihetetlenek. Persze nvidia openclben le van maradva mint a borravaló, a cuda meg király, de kevésbé gyors.

-

Zoli0726

aktív tag

Csak a te kedvedért:

https://compubench.com/compare.jsp?config_0=13875409&config_1=13503874

Egyébként te mint gpu programozó tudhatnád, hogy nem csak számítási teljesítményben erősek a gpuk, hanem az adat elérésében.

Ez is nagyons sokat jelent. Gpu\cpu 10x +adatelérés 2,5, meg is van, amit a fenti link is,igazol.

Nem is értem miért próbálod azt mondani, hogy csak a gpu számít, és mindegy lenne ha 7970 mellett ddr3 van. A memória sávszélességét és késleltetését vedd figyelembe.

De te egyébként mindent csak megcáfolsz, a saját szabadon kívül meg semmit nem tudsz alátámasztani. Mint mondtam, ha konkrétan alá tudod,támasztani, hogy amit mondtam kivitelezhetetlen, akkor hallgatlak, addig viszont a trollkodásodra nem figyelek tovább. -

Zoli0726

aktív tag

Azt bizonyítja, hogy az opencl-es megvalósítás nem volt jobb, mint a c, mégis gyorsabban lefutott a gpu-n, igazából a kódrész szinte teljesen megegyezett, valszeg az optimalizáció nem tud olyan jó lenni opencl-ben mint a g++ -Ofast.

Igazad van, apu-nál már majdnem ugyanaz a zero copy, mint az egységes címtér. Ettől függetlenül a bemenő buffert akkor is létre kell hozni, csak mutatókból fog állni.

Miféle normál feladat nem lesz ilyen mértékű gyorsulás? Nem értelek. Mi a csuda az, hogy normál feladat? És ki beszélt itt normál feladatról? Úgy hangzott mintha én egy aknakeresőn próbáltam volna ki? Nem ott. Arról, hogy más környezetben mekkora lesz a gyorsulás egy szót sem mondtam, viszont azt elismertem, hogy feladat válogatja és az függvény szinte gpu-ra lett kitalálva.

Sikerült egy jó gpu-s kódot írni, és még én vagyok a béna, biztos elrontottam valamit , a 975/7750M elméleti teljesítménye, illetve a fentebb linkelt alogritmusok is azt bizonyítják, hogy igenis elérhető ilyen mértékű gyorsulás, ezek után vagy bizonyítsd be, hogy nem, nem érhető el, vagy akkor magadat minősítsd.

, a 975/7750M elméleti teljesítménye, illetve a fentebb linkelt alogritmusok is azt bizonyítják, hogy igenis elérhető ilyen mértékű gyorsulás, ezek után vagy bizonyítsd be, hogy nem, nem érhető el, vagy akkor magadat minősítsd.

-

Zoli0726

aktív tag

Nyilván mindenki szar, csak te vagy király, én meg abban lelem örömömet, hogy fórumokon összehazudozzak mindenfélét, meg szar c kódot írok. Nem birom az ilyet. Mint ahogy szerinted a zero copy = azonos címtér, másolgassad csak a mutatóidat és hivatkozzál a ramba a pci buszon keresztül, mikor még az is drámai gyorsulást hoz, ha nem a vramot, hanem a lokális memóriát használod.

Ugye tudod, hogy opencl-t cpu-n is lehet futtatni, gondolod nem próbáltam ki, de igen, kipróbáltam, és még rosszabb eredményt kaptam cpu-val. Egyébként sem az a proci volt, amit belinkeltem, hanem egy i7 975 extreme, de gondoltam, ha lúd hát legyen kövér. Erre te elosztottad a 72-t 3mal..., törődj bele, hogy más is lehet sikeres, nem csak te.

Egyébként meg naná hogy lehet 40+x-es gyorsulás, csak a 7750m helyére egy desktop gpu kerül. 7970-nel jóval több is. -

Zoli0726

aktív tag

[Link]

Aha, melyik algoritumsban is volt gyorsabb a core-i7 a szekvenciális kívül? Ja, hogy semelyikben

Az viszont tény, hogy az egy nagyon jól párhuzamosítható rész volt, 0 szinkronizálás, sok-sok szál.#216 Már megint ezzel jössz, fogd már fel, hogy nem csak az felhasználó, aki a gépe előtt a facebook-ot nézegeti. Az ilyen felhasználó nem fog belőle profitálni, ők a szuperszámítógépből, meg a cudá-ból meg a 64 bitből sem profitálnak, mégis megszülettek ezek a dolgok, és hasznosak és elterjedtek.

És már azt is leírtam 2 hozzászólással feljebb, hogy miért nem mindig jó a dvga, és lehet hatékonyabb egy huma-s apu

-

Zoli0726

aktív tag

A te gépeden

Aki gpgpu programozással foglalkozik annak meg egy újabb kapu nyílik ki, amit örömmel fog használni.

Aki gpgpu programozással foglalkozik annak meg egy újabb kapu nyílik ki, amit örömmel fog használni.

Ahhoz meg egyértelmű, hogy idő kell, hogy az első eredmények megszülessenek, emiatt senki sem hibás, így működik a világ. De biztos ezt akarod hallani: megéri kaveri aput venni ma egy mezei usernek? Az egységes címtér miatt biztosan nem, nincs a vagy nem lesz a közeljövőben olyan program, ami ki fogja használni.

Aki meg a maga hasznára fejleszt az meg fogja venni a fejlesztés elkezdéséhez.#213 Rendben, akkor ne vegyél játékra kaveri aput. Biztosan az összes motort pontosan azon az elven írták meg, amit te itt felvázoltál, és még csak véletlenül sem lehet másképp, nem egyet-kettőt, az összeset.

Az meg, hogy ezek a programok hány szálat használnak ki azt egy cpu skálázódásból jól lehet követni, ha egy 8 szálas fx meg tudja közelíteni a core-i5 ök teljesítményét, amitől szál/szál arányban jócskán lemarad, akkor igenis képes a motor a 8 szálra. -

Zoli0726

aktív tag

Tény, viszon amint azt már említettem, kis feladatot nem éri meg dgpu-ra bízni még akkor sem ha párhuzamosítható, látsd:

ciklus 1000000x{

másolás

kernel hívás

visszamásolás

} ciklus végeilyenkor hiába hívod meg sokszor a műveletet mindig ott lesz az a toldalék, ami miatt már nem éri meg a gpu-t bevetni, viszont egy apunál, ahol a címtér egységes, csak a számolás marad. Kicsin kicsit nyersz, de ha sokszor kell megismételni akkor már számítani fog.

-

Zoli0726

aktív tag

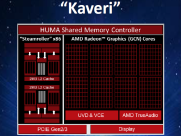

"i7től szerintem a valós használatban sohasem lesz gyorsabb a Kaveri APUk bármelyike."

A személyes stílus erre vonatkozott.

A kaveri apu nagyobb számítási teljesítménnyel rendelkezik mint a leggyorsabb i7, ezt a programozó vagy kihasználja vagy nem, de ez már az ő sara.

Pont ez a hozzáállás ment anno a munkahelyemen. Sokrészecskés szimulációnál egy lépés tette ki a futási idő 95%-át. Futott is vagy 3 napig corei7 extreme-en. Én meg gondoltam egyet, és megírtam a függvényt opencl-ben, és a kis laptopomon elindítottam, láss csodát, 3 óra alatt megcsinálta. Ekkor mondta mindenki azt, hogy hoppá! Mégiscsak megérné kiszakadni a 10 éves programozási módszerek alól és valami újat tanulni.

Ezért érdemes akkor dobálózni az ilyesmivel, ha már kipróbálta valaki.

Nyilván mint minden, ez sem mindig jön be. Egyrészt vannak olyan esetek, amikor nem érdemes vele foglalkozni, pl word, total commander, nagyjából mindegy min fut, nem kell várakozni. Sok számolást igénylő dolgoknál viszont már fontosak ezek a dolgok, persze előfordul, hogy nem lehet párhuzamosításhoz nyúlni, de ilyenkor a készítők ezt már jól átgondolják, illetve a játék, ahol kritikus, hogy a képkocka időben a képernyőre kerüljön. Azért az is túlzás, hogy egyedül a bf használ ki négy magot Ott Dirt3 stb, vagy grid2, far cry, cryengine, tomb raider, asassins creed, metro. Az meg hogy van egy skyrim aminek őskori motorja van felcicomázva, vagy egy cod, ami őskori grafikát vonultat fel crysis3 gépigénnyel már nem az apu hibája.

Ott Dirt3 stb, vagy grid2, far cry, cryengine, tomb raider, asassins creed, metro. Az meg hogy van egy skyrim aminek őskori motorja van felcicomázva, vagy egy cod, ami őskori grafikát vonultat fel crysis3 gépigénnyel már nem az apu hibája. -

Zoli0726

aktív tag

válasz

sad_Vamp

#205

üzenetére

sad_Vamp

#205

üzenetére

2 féle program, vagy programozó létezik:

az egyik azért írja a programját, hogy eladhassa, tehát másnak készül, nem cégen belül lesz felhasználva.

a másik házon belül szeretné használni, a saját érdekei motiválják. tipikusan ilyen szerintem a pénzügy, ahol az elemzések és adatok feldolgozása nem kevés számítással jár, tehát bevett szokás gpgpu-n számítani ezeket, ezekre már rég megszülettek az implementációk. nyilván, sem te, sem én nem találkozunk konkrét megvalósítással, mivel egy ilyen elkészült alkalmazást nem eladni szeretnének, hanem használni, mást nem juttatunk előnyhöz a magunk kárára.

Tehát, míg az elsőnek az a lényeg, hogy minél többen megvegyék a programját, addig a másiknak az a lényeg, hogy minél jobb legyen a programja.

Na most, hogy minél többen megvegyék a programját kell marketing, meg a többi bullshit, és egy nagyon fontos dolog, hogy bárki használni tudja. Itt nem merik bekockáztatni azt, hogy olyan alapokon íródjon a program, amit csak kevesen ismernek, és tudnak használni, tehát maradnak a szokványos kódoknál. Ide hozható fel példának a mante vs dirextx. Melyik az a játék, ami csak mantle-re fog megíródni? Van egy sanda gyanúm, hogy kevesen vállalnak be ilyet, sőt, ha lesz mantle-s megvalósítás, az már csak utólag készül el, ha marad rá keret.

Aki viszont saját magának, vagy egy konkrét megrendelőnek készíti a programot, ott a hatékonyság a fő szempont, tehát bátrabban hozzányúlnak ezekhez a dolgokhoz, keresik az eszközöket, amivel jobbá tehető a saját rendszerük.

Ami miatt az emberek ezekkel nem találkoznak így világos, nem közhasznot szolgálnak, a nagy célközönségnek készült programok viszont túl általánosak kell, hogy legyenek.

Igy viszont igazad van, valószínüleg akkor fognak megjelenni az első olyan programok, amelyek bátran kihasználják az apuk számítási kapacitását, amikor már mindenkinek lesz rá megvalósítása, illetve olyan nagy nevek programjainál, akik megengedhetik maguknak, hogy mindkét megvalósítást elkészítsék. Ezektől függetlenül az APU értékéből ez mit sem von le, csak mezei usereknek kevésbé adatik meg a lehetőség, hogy olyan programmal találkozzanak, amelyik ilyen alapokon íródott. -

Zoli0726

aktív tag

Nem értem, honnan szeditek azt, hogy apu = mantle, soha nem mondott ilyen senki.

Én nem hiszem ezt, meg nem hiszem azt, párhuzamosítottál már valaha egy for ciklust? Gondolom nem. Láttál már párhuzamosított kódot funi gpu-n? Gondolom nem. Miért mondom ezt? Mert ha így lenne, akkor tudnád, hogy simán állva hagyhantá a kaveri apu bármelyik corei7-et egy neki szabott feladatattal.

Mégis hogy? Úgy, hogy pl játékokban a gpu számítaná a fizikát, ai-t, a cpu meg a többit, ami nem párhuzamosítható. De a mai motorok már simán leterhelnek 4+ magot is, tehát van bennük párhuzamosítás bőven, tehát a kaveri apunál adja magát, hogy a párhuzamos kódot a gpu-n futtatom, ha már egyszer úgy is ott van.

A konzolok gpu-ját már most használhatják ilyen feladatokra a grafika számítása mellett, és ha majd portolni kell, akkor az apu gpu-jával a legegyszerűbb kiváltani ezt a funkciót.

És ameddig a xone és a ps4 fénykorukat élik, addig ilyen motorok fognak íródni, tehát elég esélytelen, hogy ezeket a módszereket nem viszik át pc-re.

Az egységes címteret előbb vagy utóbb meg fogja lépni az intel is, mivel az intel gpu-k sem rosszak általános számítások terén.

2013-ban úgy gondolni egy gpu csak játékra használható a tudatlanság jele.

Jönnek a kérdések, hogy de az átlagfelhasználó bla bla....

Melyik az az átlagfelhasználó aki elindít egy programot, és perceket vár a befejezésére?

Ettől függetlenül az összes mai modern böngésző gpu-val gyorsított, grafikus felület gpu-val gyorsított.

Ahol meg egy átlagfelhasználó vár, ott már régesrég van gpu gyorsítás, lástd winrar, mindenféle videókódolók, photoshop. Szuperszámítógép se kell, mert az átlagfelhasználónak nem íródott rá program.

-

Zoli0726

aktív tag

Alkalmazások vannak, Adobe, matlab pl.

játékokhoz el kell telnie valamennyi időnek, hogy a kaverit elkezdjék használni, de a,konzolportoknál jól fog jönni a tudása, mivel ott már most is ezt a módszert használják.

Az,egységes,címtér egy nagy löket lesz a gpgpu programozásnak.

Am meg ha az átlagfelhasználó nem találkozik vele, számítási célokra 1000 más helyen használhatják. -

Zoli0726

aktív tag

válasz

bayarena

#184

üzenetére

bayarena

#184

üzenetére

#183 ez egy példa arra mennyire nem vagy tisztában azzal, mire is jó az apu gpu-ja, ajánlom figyelmedbe a hozzászólásaimat.

Nem a vganak kell hogy besegítsen, hanem a cpunak, az apukáknak meg az az értelme amit már kb 50x leírtam, hogy ha a gput is befogod számolni, akkor megtöbbszörözhető a CPU(apu) ereje. -

Zoli0726

aktív tag

Szerintem meg többen használják mint gondolnád.

Csak ezeket a programokat nem átlagfelhasználóknak célozzák, pláne nem gui-s kattingatható formában, hanem ott, ahol nagyon sokat kell számolni.

Az adobe termékei már rég használnak opencl-t, a matlab is tud számolni gpu-val, és elég erős a gyanúm, hogy a CERN-nek sem sikerült volna megtalálni a higgs-bozont, ha nem néznek valamilyen gpu-s alternatíva után(többszáz gigabájt adat keletkezett másodpercenként). Ilyen még pl. az időjárás előrejelzés is, nagyon sok a számolnivaló.

A főnökökről valszeg igazad van, viszont az enyém pont kivételt képez. Mióta megmutattam mit tud a szutykos laptop gpu-m a core i7-esekhez képest az alkalmazásokban amit készítünk, nem csak gpgpu-s beruházás lett, hanem minden héten tartok órát a munkatársaimnak, közöttük a főnökömnek a párhuzamosításról és a gpgpu programozásról, mert ennyire meggyőzte őket az eredmény.

Olyan esetekben, ahol nem engedheted meg magadnak, hogy várj az eredményre, kénytelen vagy alternatíva után nézni. -

Zoli0726

aktív tag

Nem. hsa-t egy olyan rendszer alkot ami heterogén módon programozható. Ez legegyszerűbben egy amd prociból + modern Radeon vga-ból áll pl. Eredetileg intel+amd is,lehetne azonban a futtatási környezetek ezt nem mindig teszik lehetővé, és így ott már nem beszélhetünk heterogénről.

-

Zoli0726

aktív tag

Ma is lehet programozni heterogén módon dgpuval, ez az opencl. A megosztott memória is megoldott, viszont az egységes címtér csak az apukban fog értelmet nyerni. Dgpunál vagy a gpunak kell a ramban turkálni, vagy a cpunak a vramban, pont erre született meg az apuk egységesített címtere

-

Zoli0726

aktív tag

válasz

GeneraL_XTX

#117

üzenetére

GeneraL_XTX

#117

üzenetére

Nyilván miért ne használhatnád gpu-ként ha úgy tartja kedved, 2 legyet egy csapásra. Nincsenek fejlesztők... Én is az vagyok, 2 éve programozok opencl-ben is, és tapasztalatból tudom hol a gyengéje a cgpus számításoknak. Sajnos ott hogy kis feladatokat nem éri meg rájuk bízni, a plusz műveletek miatt nem tud érvényesülni a gpu. A hsa-val ez egycsapásra megváltozhatna, Számomra egy hatalmas ugrás.

-

Zoli0726

aktív tag

Kész vagyok ezeken a hozzászólásokon, szűk látókörűség

Az integráció nem azt jelenti, hogy 1 dolgot kell venned 2 helyett, hogy játszani tudj!

Kár, hogy gpu-nak nevezik, nem a játék miatt van a cpu mellé téve.

Úgy kellene fogalmazni, hogy a cpu kap egy olyan társprocesszort, ami párhuzamos feladatok végrehajtásában nagyon erős. Nem játékok futtatására lett kitalálva, hanem a cpu-nak fog segíteni a számításokban tehát a cél a jobb processzorteljesítmény, nem a játékok, meg nem is az, hogy ne kelljen dgpu-t venned.

Aztán majd jönnek a tesztek, hogy a kaveri gpu-ján hány fps-sel futnak a játékok, szánalom.

Számítási feladatokkal kell tesztelni, szimuláció, render, ray-trace, fizika stb

NEW ERA OF COMPUTING az Amd mottója. -

Zoli0726

aktív tag

válasz

#06658560

#87

üzenetére

#06658560

#87

üzenetére

Ha egyáltalán nem párhuzamosítható akkor nem mész vele semmire, ez kerek perec így van.

Viszont elég kicsi az esélye egy nagy bonyolultságú programnál, hogy ne lenne benne párhuzamosítható rész,

egyébként sem mondtam azt, hogy az egész programnak párhuzamosnak kell lennie, lesznek soros és párhuzamos részek, a párhuzamosak gyorsabban futnak majd, a sorosak nem, ettől függetlenül lesz gyorsulás, a feladattól függ majd.

Elég ritkán találni manapság olyan cpu intenzív programot, amit nem sufniban raktak össze, és ne tudna megszólalatatni legalább 4 magot, szóval ez már csak hozzáállás kérdése.#89 Pont ezt akartam mondani én is, mindenki azt hiszi, hogy az intel meg az amd azért gyárt cpu-t, hogy a játékok gyorsabban fussanak

-

Zoli0726

aktív tag

Szerintem ennek az egésznek egyáltalán nem az a célja, hogy kiváltsák a középkategóriás vga-kat.

Ez az egész arról szól, hogy az amd le van maradva cpu fronton, viszont van egy erős compute gpu vonala és nagyon szerették volna, ha ez a jó kis gpu nem csak koloncként lógna a cpu nyakán, hanem ő is effektíven ki tudná venni a részét a sok kicsi feladatból is.

(egy nagyobb feladatra továbbra is megmarad a dgpu, mivel ők fogják majt továbbra is a legerősebb gpu-kat kapni + a dedikált nagyon gyors ramokat és buszt, viszont ott továbbra is másolgatni kell majd az adatokat), viszont a cpu frontnak ez egy üde színfolt.

Ezért nem gondolnék úgy a hsa-ra mint egy cpu amin játszani is lehet, hanem egy olyan cpu, amit ha az adott feladat megenged, akkor olyan teljesítmény hozható ki belőle amit eddig még nem láttunk a dgpu-kon kívül.Igen, gpu-ra kötelező a párhuzamosítás, de pont erről van szó, hogy ha már egyébként is párhuzamosítani kell egy feladatot sok szálra, akkor attól a ponttól kezdve már ma is megvan az a lehetőség, hogy a kód szinte teljesen ugyanaz, mintha cpu-ra írnám(tehát hülyeség lenne nem a gpu-t használni)

-

Zoli0726

aktív tag

Nos, ugye ezt te sem gondoltad komolyan?

Közelítsük meg az egészet a párhuzamosság oldaláról.

Ahhoz, hogy ki tudd használni egy i7 erejét, nyílván párhuzamosítanod kell, különben a játékod, vagy bármi más csak 1 magot használna.

Egy kaveriben/i7 cpu teljesítmény aránya nyílván rossz, viszont mivel egy mag teljesítménye mindenképp kevés, párhuzamosítani kell, ekkor egy i7-nél párhuzamosíthatsz 8 szálra, egy kaveriben jóval többre, sőt ha gpu-t használsz erősen ajánlott, és a gpu számítási kapacitásának a nyomában sincs az i7.

Már csak kell egy olyan keretrendszer, amivel könnyen tudd állítani azt, hogy az adott kódrészt most épp a cpu vagy a gpu futtassa le, de gondolom ezt a hsa megoldja.

Nyílván aki még az életében nem írt egy programot sem(gpu-ra), annak ködösek ezek a dolgok, de szerintem ez valami jónak a kezdete. -

Zoli0726

aktív tag

Szerintem a hsa egyáltalán nem a játékokról szól, szóval szerintem lemérni azt, hogy mit tud a benne rejlő gpu játékok alatt, pláne olyanokban ahol hírből sincs hsa támogatás, nem sok értelme van.

Ennek az egésznek az erőssége a (általános) programozásban lesz, mivel a gpu-kon való számolásokat erősen korlátozza a bemásolás, hívás, visszamásolás folyamata, ahol ha ez a 3 lépés annyi időbe telik, mintha a cpu számolná ki, nem éri meg gpu-t használni. Viszont, ha erre nem lesz szükség, és egy erre a logikára épülő függvényt 1milliószor kell lefuttatni, már bőven ki tud majd jönni a gpu előnye.

Új hozzászólás Aktív témák

- sziku69: Szólánc.

- Dacia topic

- Társasjáték topic

- Futás, futópályák

- Hobby elektronika

- Sony Xperia 1 VII - Látod-e, esteledik

- Építő/felújító topik

- Azonnali informatikai kérdések órája

- A fociról könnyedén, egy baráti társaságban

- droidic: Időutazás floppyval: A 486-os visszavág PCem-men

- További aktív témák...

- Eladó Garanciális (2027.10.08) AMD 7700 processzor

- Intel Core i9-13900 24-Core 3.0GHz LGA1700 (36M Cache, up to 5.60 GHz) Processzor!

- Intel Core i5-8600K 6-Core 3.6GHz LGA1151 (9M Cache, up to 4.30 GHz) Processzor!

- Intel I5-6400

- BESZÁMÍTÁS! Intel Core i9 9900K 8 mag 16 szál processzor garanciával hibátlan működéssel

- 15,6" Dell Latitude laptopok: E6540, E5550, E5570, 5580, 5590, 5500, 5501, 5510/ SZÁMLA + GARANCIA

- Telefon felvásárlás!! Apple Watch Series 9/Apple Watch Ultra/Apple Watch Ultra 2

- BESZÁMÍTÁS! Microsoft XBOX Series X 1TB SSD fekete játékkonzol garanciával hibátlan működéssel

- Vállalom Xianomi Okos kamerák, szoftveres javíttását

- LG 65C3 - 65" OLED evo - 4K 120Hz 1ms - NVIDIA G-Sync - FreeSync Premium - HDMI 2.1 - PS5 és Xbox!

Állásajánlatok

Cég: FOTC

Város: Budapest

, a 975/7750M elméleti teljesítménye, illetve a fentebb linkelt alogritmusok is azt bizonyítják, hogy igenis elérhető ilyen mértékű gyorsulás, ezek után vagy bizonyítsd be, hogy nem, nem érhető el, vagy akkor magadat minősítsd.

, a 975/7750M elméleti teljesítménye, illetve a fentebb linkelt alogritmusok is azt bizonyítják, hogy igenis elérhető ilyen mértékű gyorsulás, ezek után vagy bizonyítsd be, hogy nem, nem érhető el, vagy akkor magadat minősítsd.

Ott Dirt3 stb, vagy grid2, far cry, cryengine, tomb raider, asassins creed, metro. Az meg hogy van egy skyrim aminek őskori motorja van felcicomázva, vagy egy cod, ami őskori grafikát vonultat fel crysis3 gépigénnyel már nem az apu hibája.

Ott Dirt3 stb, vagy grid2, far cry, cryengine, tomb raider, asassins creed, metro. Az meg hogy van egy skyrim aminek őskori motorja van felcicomázva, vagy egy cod, ami őskori grafikát vonultat fel crysis3 gépigénnyel már nem az apu hibája.