Az NPU

Az utóbbi időszak alapján világos, hogy a rendszerchipek egyik általános iránya az AI-ra dedikált hardver használata lesz. A Huawei HiSilicon lapkái mellett az Apple, a Samsung, a MediaTek, a Qualcomm, és még mások is elkezdtek ilyen, neuronháló gyorsító egységeket építeni a lapkákba, gondolva itt az ARM-ra és az Imaginationre. Felmerülhet a kérdés, hogy miért lényeges ez, elvégre minden SoC rendelkezik több, akár eltérő képességű processzormaggal, illetve grafikus vezérlővel. Kell még egy extra részegység ezekbe?

Választ erre nehéz adni, leginkább az igényektől függ. A gépi tanulásról tudni kell, hogy két nagy szakaszra osztható. Az egyik a tréning, amikor egy nagyobb teljesítményű szerver készít egy neuronhálót a meglévő adatok megfelelő megoldókulcs melletti feldolgozásával. Ezzel az ultramobil szinten nem kell foglalkozni, hiszen a felhasználókhoz kerülő eszközöknél az úgynevezett dedukció a lényeg, vagyis a már készre tréningelt, feltételezhetően jó hatásfokú neuronháló felhasználása, illetve a feladatok ez alapján történű kiértékelése. Bármelyik szakaszt is nézzük, a gépi tanulás nagyrészt, hozzávetőleg úgy 95%-ban mátrixszorzásból áll, vagyis olyan hardver jó ide, amelyik megfelelő feldolgozókkal rendelkezik a mátrixszorzás (GEMM) hatékony feldolgozásához.

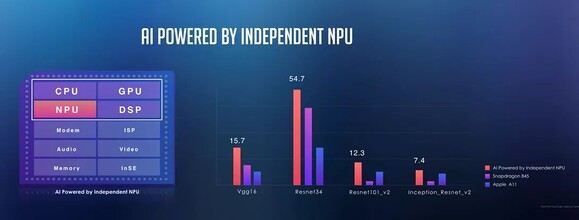

A pontosság is lényeges tényező. A szerverek szintjén jellemző a 32 bites lebegőpontos operációkon keresztül történik a tréningelés, bár ez nem követelmény. A dedukció szakaszban már viszonylag kis pontosság is elég a megfelelő működéshez, ami viszont kellene az a számítási teljesítmény, illetve konkrétan a hatékonyság. Ergo a rendszerchipek ugyan képesek lennének a processzormagokon, illetve a grafikus vezérlőkön is végrehajtani az AI-ra vonatkozó kiértékelési feladatokat, hiszen ezek is jól mátrixszorzásban, főleg az utóbbi, de ha az egységnyi fogyasztás melletti teljesítményt nézzük, akkor már inkább a célhardver a hasznos. Főleg azért, mert ezeket a részegységeket lehet egy konkrét pontosságra tervezni, ami többnyire 4 vagy 8 bites fixpontos, illetve 16 bites lebegőpontos operációkat jelent. A processzormagokat, valamint a grafikus vezérlő multiprocesszorait nem igazán ezekre tervezik, még akkor sem, ha elméletben megoldható az előbbi operációs feldolgozása.

A rendszerchipeket fejlesztő cégek tehát jó okkal dedikálnak neuronháló gyorsítókat az AI feladatokra, ezek számára van is hely, hiszen 10, vagy jobb esetben 7 nm-es node-on készülnek az új lapkák, ami igen sok tranzisztor elhelyezését teszi lehetővé. A legnagyobb limit ma már a fogyasztási keret, tehát ha van egy olyan feladat, amit sűrűn használnak majd az alkalmazások, akkor ma nagyon megéri egy hatékonyságban kiemelkedő, de adott feladatra limitált részegységet beépíteni. Emiatt az AI-ra dedikált hardver egyre több lapkában jelennek majd meg.

Most, hogy az okot kitárgyaltuk, előkerül az igazán lényeges kérdés: melyik hardver a jó? Röviden mindegyik. A legtöbb, rendszerchipet tervező cég nem is készít saját neuronháló gyorsítót, hanem licencel egyet magának. Itt szóba jöhet a Cambricon, az ARM, az Imagination, de az egyes DSP-k (digitális jelfeldolgozó processzor) is kifejezetten hatékonyak itt, tehát akár a Cadence is lehet partner ebben. A kiválasztott vagy kifejlesztett hardver mellé persze mindenki tervez egy saját fejlesztőcsomagot, illetve konkrét alkalmazásokat. Utóbbi miatt nincs jelenleg nagy jelentősége annak, hogy milyen AI gyorsító van az adott lapkán belül, mert ezek között ugyan vannak különbségek, de a legtöbb alkalmazás amúgy is az adott lapkára, és ebből adódóan az adott ultramobil eszközre van szabva. Lényegesebb tehát manapság az okostelefon AI-ra vonatkozó képességeit nézni.

A jövőben azért ez változhat, hiszen a Google már szállítja a 8.1-es vagy újabb Android operációs rendszerekbe az NNAPI-t, ami tulajdonképpen izgalmasabbá teheti ezt a területet, hiszen egy szabványos alkalmazásprogramozói felületet kínál a rendszerchipekben található AI gyorsítókra, de ha ezek hiányoznának, akkor is lehet a programot futtatni a megfelelő eszközillesztőkkel ellátott grafikus vezérlőkön, DSP-ken, vagy legvégső esetben a processzormagokon. Ahogy terjednek majd a Google Play-en az NNAPI-t használó alkalmazások úgy kapnak majd tényleges értelmet a lapkákba épített új lehetőségek, és akkor már elkezdődhet ezek teljesítményének és képességeinek összemérése is, amire valószínűleg jönnek majd megfelelő tesztprogramok.

A cikk még nem ért véget, kérlek, lapozz!