- Samsung Galaxy S24 - nos, Exynos

- Telekom mobilszolgáltatások

- Samsung Galaxy A70 - áram, erősség

- Apple Watch Sport - ez is csak egy okosóra

- Android alkalmazások - szoftver kibeszélő topik

- Samsung Galaxy S21 Ultra - vákuumcsomagolás

- iPhone topik

- Garmin Forerunner 165 - alapozó edzés

- Redmi Note 12 Pro - nem tolták túl

- Samsung Galaxy A54 - türelemjáték

Hirdetés

-

Lenovo Essential Wireless Combo

lo Lehet-e egy billentyűzet karcsú, elegáns és különleges? A Lenovo bebizonyította, hogy igen, de bosszantó is :)

-

SMITE 2 - Napokon belül indul a zárt alfa teszt

gp Több mint egy tucat karaktert próbálhatnak ki a szerencsésebbek, a teljes listát a május első napján esedékes streamben árulják el.

-

Robotkart irányított a majom a kínai Neuralink agyi chipjével

it A mindezt lehetővé tévő Neucybert a Neuralink kínai riválisa, a Beijing Xinzhida Neurotechnology fejlesztette ki.

Új hozzászólás Aktív témák

-

#54625216

törölt tag

Ez itt a lényeg:

Adott célfeladatokra saját maguk tudják integrálni a hardveres megoldásaikat és nem az Intelnél kell kuncsorogniuk.

Persze ha lefuttatsz egy cpu alapú 3d rendert vagy egy zip benchmarkot, akkor ki fog jönni, hogy mennyivel gyengébb egy csúcskategóriás x86-hoz képest, de a user ebből semmit sem fog érezni, mert amire használja, az a dedikált hardveres gyorsításnak köszönhetően gyorsabb lesz az x86 megoldásokhoz képes.

És hogy mennyire nem mindegy a hardveres megoldás a user szemszögéből, álljon itt egy Windows-os példa:

Anno 2010 környékén vettem rokon gyerekeknek ajándékba olcsó netbookot és az Intel Atom és az AMD A4 széria között kellett választanom. Az Atom szintetikus benchmark eredményei sokkal jobbak voltak, de az A4 a beépített Radeon GPU miatt röccenés nélkül játszotta a h264 videókat, jól futottak vele a játékok és általában az egész gép flottabbul működött arra a célra, amire a gyerekek használni akarták. Egy Asus 11" A4 alapú netbook mellett döntöttünk és használták is boldogan vagy 5 évig, függetlenül attól, hogy háromszor annyi idő alatt tömörített egy 100GB-os fájlt egy Intel Atom-hoz képest.Pont az a lényeg a váltásban, hogy egy grafikus, vágó, zeneszerző, vagy mezei user gépének egyáltalán nem kell hatékonyan számolnia a pi első száz számjegyét.

A pro felhasználók azt várják egy mac-től, hogy egy tibeti sátorban ülve tudják raw-ból konvertálni a fotóikat úgy, hogy bírja a gép 20 órán át töltés nélkül, miközben a hardver nem nyom többet fél kilónál.

Vagy hogy a grafikus előkapja az iPadját és az ügyfél orra előtt leskicceli az ötletét, majd az irodában az iMacjén 6K monitoron véglegesíti.Általános számítási feladatokra meg lesz továbbra is kismillió x86 alapú megoldás, az Apple-nek egyáltalán nem kell lefednie azt a piacot is, mint ahogy nincs mainframe és szerver megoldásuk se, mert ezek a területek sosem voltak részei (és feltehetően nem is lesznek) az Apple ökoszisztémának.

-

#54625216

törölt tag

A Windows nem egy termék, hanem egy szabványgyűjtemény. Köztes réteg, "híd" a hardver- és a szoftvergyártók között.

Anno a DOS-os időszakban a hardver kihasználásához a szoftver fejlesztőknek maguknak kellett megírniuk a drivereket, vagy a hardvergyártóknak támogatniuk az egyes szoftvereket. Bezony, VGA kártyához mellékelték az Autocad drivert floppy-n, a játék pedig megmondta, hogy melyik hangkártyát támogatja.

A Windows ezt az áldatlan állapotot szüntette meg: a hardver gyártónak elég volt a windows driverekre fókuszálni, a szoftver fejlesztőnek meg a windows library-kra.Így az MS üzleti modellje a szabványosítás lett: mivel a szabványaihoz alkalmazkodott mindenki, piaci erőfölényre tett szert, amivel újabb szabványokat tudott az iparágra kényszeríteni, amivel tovább nőtt az erőfölénye. Ha valaki megjelent egy új megoldással, akkor azonnal kiadták a Windows megfelelőjét és kiszorították a piacról.

Az ARM-os windowsban viszont továbbvitték mindazt, ami a windowsban rossz az előnyei nélkül. Optimalizálatlan, erőforrás zabáló OS visszafelé kompatibilitás nélkül, miközben a usernek semmilyen extrát nem nyújtott a droidos és iOS-es megoldásokhoz képest.

Abból tehát, hogy az MS elcsesz valamit még nem következik, hogy maga a koncepció rossz.

Elég csak a táblagépekre gondolni: az MS belebukott, az Apple meg sikerre vitte. -

#54625216

törölt tag

válasz

Tigerclaw

#77

üzenetére

Tigerclaw

#77

üzenetére

Az Apple felhasználók sosem a nettó hardver specekre fókuszáltak, hanem a használhatóságra.

Ha kényelmesen és hatékonyan lehet vele videót vágni, zenét és képet szerkeszteni, akkor venni fogják a mac-et függetlenül attól, hogy milyen a hardver.Nemrég láttam egy elemzést a Mac Pro-ról, a csávó visszaállt Win 10-ről macOS-re, pont a Mac Pro miatt. Egyetlen szoftvert, a Davinci Resolve-ot futtatja rajta (még Adobe cuccokat se telepített rá), került vagy 15ezer dollárjába, de mivel munkagép, ki is termeli az árát. Azért döntött a MacPro mellett, mert a dual Radeon Pro és az arra optimalizált OS és szoftver együtt olyan realtime teljesítmény ad, amit windows-on csak dupla annyiért lehet elérni (ha lehet): a 4K raw videóit szanaszét effektezve is realtime kezeli a rendszer.

Az ő esetében pl. a GPU-k adják a lényegi teljesítményt, nem a CPU. És ez a MacPro, nem valami belépő szintű laptop.

Tehát az elmozdulás az "általános célokra elégséges, adott feladatokra célzottan felturbózott" hardver nagyon is működőképes megoldás lehet.Abban egyetértek, hogy az utóbbi időben a Mac-ek nettó ár / teljesítmény mutatói drasztikusan romlottak. Hogy egy már nagyjából használhatónak nevezhető Mac Mini 2500 dollár, az vicc kategória.

Majd meglátjuk, hogy milyen irányba indul el az Apple.

Vagy tartja a jelenlegi (szvsz tarthatatalan) árait és a hardver-os-szoftver optimalizálással a teljesíményen javít (pl. rakhat akár 4-8 saját CPU-t is a MacbookPro-ba) , vagy az olcsóbb cpu-nak köszönhetően lejjebb viszi az árait.

Mindkét megoldás működőképes lehet, majd az év vége felé kiderül. -

#54625216

törölt tag

Csakhogy mostantól semmi sem gátolja az Apple-t, hogy audio feldolgozásra specializált célhardvert építsen a cpu-iba, ha fontos neki az audio piaci.

Az Apple ökoszisztémában pedig meg lehet tenni, hogy kijönnek egy audiora specializált hardver megoldással és fél-egy éven belül az összes komolyan vehető zeneszerkesztő szoftver már támogatja.

Ugyanez PC-n elképzelhetetlen lenne, mert kellene pár év, mire az összes Intel CPU-ban megjelenne a technológia, meg még néhány, mire a userek kellő számban lecserélnék a gépeiket, aztán lehetne küzdeni a windows támogatással, de a hosszú átállás miatt a piaci igény nem érné el a kritikus tömeget, emiatt a támogatást se vennék komolyan, míg az egész kísérletet le nem írnák járulékos veszteségként. -

#54625216

törölt tag

válasz

Ezekiell

#119

üzenetére

Ezekiell

#119

üzenetére

A klasszikus értelemben vett power userek már kb. az XServer vonal leállításakor kikerültek az Apple célközönségéből.

A Mac a tartalomfejlesztőket célozza, azaz hogy bármilyen tartalomfejlesztést (beleértve: grafika, videó, 3D, fotó, zene, stb.) meg lehessen oldani az Apple ökoszisztémán belül. Ennek fő oka nem maga a Mac üzletágon nyert profit, hanem az önállóság: még véletlenül se tudják kirántani az Apple alól a talajt mondjuk egy Windows oldali zárt szabvány bevezetésével, mert azzal nem csak a macOS, hanem az iOS felhasználókat is megszivatnák."Miért olyan marha nehéz elfogadni, hogy igenis sok olyan ember van, akinek SZÜKSÉGE van az erőre?"

Ez oké, de a nagy kérdés, hogy általános számítási teljesítményre is feltétlenül szükség van-e, vagy elég adott, jól behatárolt célfeladatokat kiszolgálni.

[ Szerkesztve ]

-

#54625216

törölt tag

válasz

Ezekiell

#138

üzenetére

Ezekiell

#138

üzenetére

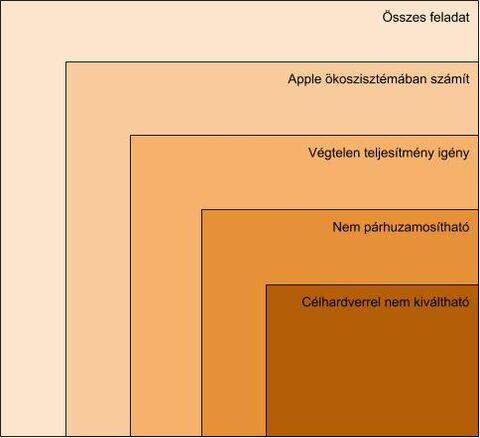

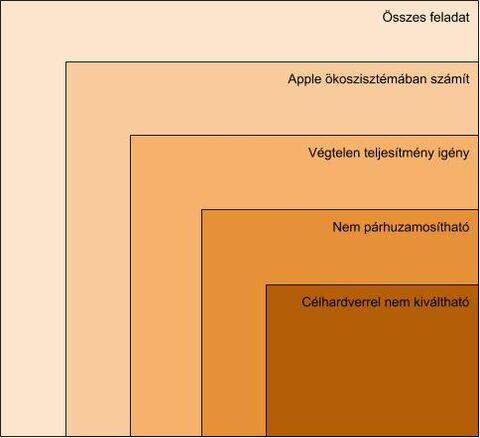

Érdemes különválasztani az "elég jó" és a "mindig az elérhető maximális" teljesítmény igénylő feladatokat.

A videóvágó alkalmazásoknál pl. sokáig a "mindig az elérhető maximális" teljesítmény volt az alap, de mára elértük azt a szintet, hogy ha a rendszer képes 4K 60fps raw videót effektezve realtime szerkeszteni, akkor átkerül az "elég jó" kategóriába és azon felül csak ritkán van szükség extra lóerőre. (Ilyen pl. a Mac Pro dual gpu-val Davinci Resolve-al.)

A "mindig az elérhető maximális" teljesítményigény jellemzően a mérnöki, tudományos feladatoknál jelentkezik, ezekben az Apple szvsz nem is akar versenybe szállni, mert ezek a területek nem részei az ökoszisztémájának.

Van még a "Blinn törvény" területek, mint pl. a 3D render, amikor az ember addig részletezi a látványt, amíg a renderidő még elviselhető, tehát nem az adott feladat teljesítményigénye, hanem a renderidő a konstan. Ezek is a "mindig az elérhető maximális" telejesítményigényű feladatokhoz tartoznak, de itt már figyelembe kell venni a párhuzamosíthatóságot.

Nem nehéz belátni, hogy a többszálú alkalmazások kiszolgálására az Apple garantáltan jobb ár / teljesítményt tud kihozni a saját cpu-iból, mint ha Intelen maradna. Egyszerűen több magot vagy cpu-t rak ugyanabba a rendszerbe és mondjuk 3D rendernél máris ledolgozta az x86-al szembeni teljesítmény hátrányát.

Az A5X-ért anno a Samsungnak 23USD-t fizettek, feltételezhető, hogy az A12Z előállítása sem kerül többe. Ha csak a jelenlegi mac miniket nézzük, az i3-i5 processzor opciók között kb. 400USD az árkülönbség amiből 16 db. extra A12Z processzort, azaz 128 cpu magot tudnának hozzáadni a rendszerhez.Maradnak tehát az:

- egyszálú teljesítmény kritikus

- Apple ökoszisztémába illeszkedő

- "mindig az elérhető maximális" teljesítményt igénylő

feladatok.Ezeknek egy részét viszont le lehet fedni a cpu-ba integrált célhardverrel is, tehát a lista tovább szűkül.

Valójában csak azoknál a feladatoknál jön elő az x86 egyszálú teljesítmény előnye az ARM-al szemben, ami:- egyszálú teljesítmény kritikus

- Apple ökoszisztémába illeszkedő

- "mindig az elérhető maximális" teljesítményt igénylő

- általános, célhardverrel nem lefedhető

feladatok.Szvsz az Apple-nél alaposan kielemezték ezen feladatok körét és ennek tudatában hozták meg a döntést, de persze lehet, hogy tévedek (vagy ők tévedtek).

-

#54625216

törölt tag

válasz

Kilobeat

#181

üzenetére

Kilobeat

#181

üzenetére

Nem szabványokról van szó, hanem a nem párhuzamosítható számítások célhardveren futtatásáról. Pl. a Mac Pro-hoz lehet venni AfterBurner kártyát a ProRes Raw videók realtime dekódolásához, hasonló opcionális megoldásokat lehet alkalmazni a zeneiparban is, ha lesz rá igény.

-

#54625216

törölt tag

válasz

Tigerclaw

#208

üzenetére

Tigerclaw

#208

üzenetére

"Igen, egy Pages, Numbers biztos jo UX-et ad vizualisan, de kozben funckiokban a tizedet sem tudja egy Word, Excel parosnak."

Miért is kellene? Nem ugyanaz a célközönség.

"A Finder a Mac filekezeloje, a mai napig csak egyablakos mukodesre kepes, vagyis azt az egyszeru es hasznos featuret nem tudja, amit egy Norton Commander mar tudott 30 evvel ezelott."

Egyetlen OS default file kezelője sem több ablakos, 3rd party filekezelők meg ugyanúgy vannak macos-re, mint windowsra.

" A kompatibilitas meg a megvasarolt periferiak mehetnek a kukaba."

Ez hülyeség, mert pont, hogy az univerzális portok irányába haladnak. Egy átalakítóval vagy dokkolóval bármelyik korábbi periféria használható sokkal nagyobb skálán, mintha az egyes portokat külön beépítenék.

A legtöbb esetben a régi hardverek a gyártóik miatt mehetnek a kukába. Pl. a 15 éves wacom táblák hardveresen simán működnek az összes macos alatt, de a wacom szándékosan letiltja őket a szoftvereiben."mert naluk az UI es UX minden mast felulir, igy a hasznalhatosagot is"

Abból, mert - érthető módon - a marketing az átlag user számára nyilvánvaló változásokat emeli ki még nem adódik, hogy a rendszer kevésbé lenne használható. Vagy akkor definiáld pontosabban, hogy mit értesz "használhatóság" alatt.

-

#54625216

törölt tag

válasz

ceripapa

#210

üzenetére

ceripapa

#210

üzenetére

Feljebb már leírtam, de a jobb érthetőség kedvéért íme egy ábra:

Az utolsó részhalmaz nagysága az, amin a váltás sikere múlik, illetve hogy azokban a feladatokban nem érzékelnek-e a felhasználók elfogadhatatlan teljesítmény csökkenést.

A többszálú performance mutatók pedig nem olyan szempontból érdekesek, hogy ugyanaz a cpu nagyobb frekire pörgetve eléri-e a másikat alacsonyabb tdp kerettel, hanem hogy több cpu-val kihasználva ugyanazt a tdp keretet el lehet-e érni magasabb többszálú teljesítményt.

Árban ugyanis egyértelmű, hogy az apple oda skálázza a több cpu-s rendszereit, ahova akarja és még úgyis bőven az x86 költségeken belül marad, mert egy intel proci árából tucatnyi saját gyártású cpu-t tud a gépeibe pakolni. -

#54625216

törölt tag

válasz

Tigerclaw

#246

üzenetére

Tigerclaw

#246

üzenetére

"Sosem ertettem, hogy folyamatosan a PC legyozeset vizionaljak, igazoljak hazi, meg megrendelesre keszult statisztikakkal, sosem tettek semmi komolyat, hogy noveljek a Mac OS piaci reszesedeset."

Erre valami linket légyszi, hogy bármelyik Apple illetékes kijelentette volna, hogy a PC legyőzése lenne a céljuk.

A Mac-et az Apple ökoszisztéma támogatása miatt fejlesztik, hogy a tartalomgyártóknak legyen desktop munkaeszközük az ökoszisztémán belül.

Utoljára max. a 80-as években volt cél az Apple-nél a PC legyőzése, azóta a minél nagyobb önállóság és a minél szélesebb hardver-os-szoftver-szolgáltatás ökoszisztéma a fő irány. -

#54625216

törölt tag

válasz

Tigerclaw

#253

üzenetére

Tigerclaw

#253

üzenetére

Egy dolog, ha valaki jobb terméket akar fejleszteni, mint a konkurencia és egy másik, hogy piacvezető szerepre tör. Az Apple bevallottan nem töri magát, hogy piacvezető legyen, pláne nem a PC piacon.

Azzal meg, hogy a saját termékeiket tartják a legjobbnak egyesek egyetértenek, mások meg nem.

Az üzleti eredményeik minden esetre azt mutatják, hogy akadnak jópáran, akik egyetértenek. -

#54625216

törölt tag

"Ahogy amúgy mac-nél is előfordulnak bugok, csak a fórumokon feljetik ezt el, mintha ott minden hibátlan lenne"

Először is a Mac referencia hardver, azaz véges mennyiségű hardver variációra kell tesztelni, így a bugok száma is lényegesen kevesebb, mint más rendszeren.

Másodszor ha mégis becsúszik egy bug, az - szintén a referencia hardvernek köszönhetően - kevésbé random keletkezik a usereknél és könnyebb reprodukálni, így javítani is.

Harmadszor dehogynem felejtik el az Apple bugokat, menetrend szerűen tíz éves sztorikat böfögnek fel minden egyes Apple hírnél. Bármilyen Apple-t érintő bug ugyanis azonnal végigpörög a médián, mert azzal lehet kattintásvadász cikkeket publikálni, windows bugokkal meg nem, mert a windows bug a médiában olyan, mint amikor a "kutya harapja meg a postást", az apple bug meg amikor a postás a kutyát.A Win vs. Mac stabilitás amúgy nem a felhasználók számán múlik, hanem a hardver sokféleségén.

Az MS vitathatatlanul heroikus munkát végez a Windows-al, mert ahhoz képest, hogy n+1 hardveren kell futnia, meglepően stabil.

Maga az ökoszisztéma, azaz hardver+os+szoftver+szolgáltatás együttesen viszont sokkal flottabbul működik az Apple megoldásaiban, pontosan azért, mert egy komplett egész rendszert fejlesztenek, nem pedig önálló komponenseket, mint a többiek.Ebből adódik amúgy, hogy ez a komplett rendszer a felhasználók csak x százalékát tudja lefedni, ezért mindig lesznek, akiknek az Apple megoldásai nem lesznek megfelelőek vagy nem éri meg kifizetni a prémium felárat érte.

-

#54625216

törölt tag

"Az Apple esetén a "csak működik" az egy marketinghazugság, a konkrét valósághoz sok köze nincs, szóval ne ebből akard levezetni a dolgokat."

Mezei user szinten egyáltalán nem hazugság, sőt.

Faterom az első PC-jét 2002-ben vette, azelőtt nem hogy gépe nem volt, de egyenesen ellenséges volt az informatikával. Aztán rá kellett jönnie, hogy írógép+betüjavító+beragasztott fénykép egy dokumentációban már nagyon ciki, így összeraktunk neki egy komplett rendszert PC-vel, scannerrel, rajztáblával, digitális fényképezőgéppel, nyomtatóval.

Na onnantól minden egyes családi ünnepség rendszergazdai tevékenykedésről szól. Több ezer dokumentum a c: gyökérben, vírusok hada, elcseszett őskövület NT driver automatikusan feltepül floppy-ról és csak safe módban lehet kiírtani, stb. el nem tudod képzelni, hogy egy hozzánemértő user miket bír művelni egy windows-al.

Később akart videót is vágni, kipróbáltuk, de feladtuk, mert képtelen volt megküzdeni a különböző kodekekkel és a vágóprogramok számára reménytelenül bonyolult kezelőfelületeivel.

Aztán ingázós munka miatt szeretett volna egy laptopot. Mondtam, hogy na akkor legyen egy macbook pro. És láss csodát, azóta minden megy nála flottul.

Van egy külső hdd-je, arra megy a time machine mentés, azon túl mindent megold magától, mert az egész rendszer az ő hozzánemértésére van szabva. Videót is könnyedén vág iMovie-ban, mert a program egyszerű, mint az ék és az összes videoformátumot kérdés nélkül megeszi.Persze lehet, hogy ma már win10-el könnyebben boldogulna, mint anno win7-el, meg már vannak könnyen kezelhető videóvágó szoftverek, stb. de számára az apple pontosan azt nyújotta, amit ígért: "csak működik".

Persze lehet ezer és egy negatív példát felhozni, hogy nagyvállalati környezetben mennyi hajtépéssel jár több száz mac-et manegelni, de attól még a célcsoport home user szintjén nagyon is helytálló a "just works" szlogen.

-

#54625216

törölt tag

válasz

Ezekiell

#396

üzenetére

Ezekiell

#396

üzenetére

Ez az, hogy nem.

Eleve a usernek ki van jelölve a homokozó, nem tudja pl. a doksijait a gyökérbe menteni, mert ott van a user foldere, alapból csak azt látja.Aztán a backup annyi, hogy rádugja a hdd-t, azt mondja, hogy legyen az a timemachine target és onnantól kezdve akármit elcsesz, visszahozza timemachine-ból akkor is, ha már két hét alatt háromszor felülírta.

Vagy pl. teljes user account hordozhatósága. Új mac, összekötöd a régivel utp-n, ráböksz a userre és átmásol mindent alkalmazásokkal, dokumentumokkal és beállításokkal együtt, beloggolsz és még a wifi jelszót is tudja.

És mindezt 2006 óta.

A videóvágás az egyik legjobb példa a "just works"-re.

Próbálkoztunk windows 7-en windows video makerrel (valami nagyon alap, könnyen tanulható cucc kellett).

Indításkor hisztizett, hogy nem a legfrissebb wmv kodek van fenn, oké, telepítsük (kb. 50kb.-os file-ról van szó). Csakhogy az új kodeket csak a legújabb windows media playerrel együtt volt hajlandó telepíteni. Oké, de az meg igényelte a legújabb internet explorert, az meg lehúzta az összes .net és egyéb rendszerfrissítést, amitől meg más szoftverek rohadtak le. Kb. fél nap telepítgetés után csak egy dolgot nem tudtunk csinálni: videót vágni.Ehhez képest mac-en iMovie elindít, fél óra alatt az egybites user is kiismeri, két óra múlva már tölti is fel a videóját youtube-ra.

Na most idővel persze egy csomó mindenben a windows 10 is felzárkózott a macos-hez, de egy hozzánemértőnek a mac a kezdetek kezdete óta a hülyebiztos, "just works" élményt nyújotta. Ezeknek a usereknek a nagy többsége ezt hajlandó is megfizetni és nem érdekli, hogy amúgy más rendszerek némi időráfordítással és egyes alapszabályok betartásával tudnak hasonlót olcsóbban, mert ennek a rétegnek pont az ár a másodlagos prioritás, ha cserébe nem szopatja a gépe.

-

#54625216

törölt tag

Egy cég magyarázhat, amit akar, ha a user számára a termék használhatatlan, akkor bukik. Az Apple is jó pár termékét bukta, ha a nekik tulajdonított ördögi marketinggel bármire rá tudnák venni a nekik tulajdonított zombihadseregüket, akkor egyetlen termékük sem bukna meg soha.

Az egy más kérdés, hogy az Apple sosem verte magát a hardver specekre, így a "de hát ezért a pénzért dupla ramot kapok meg +1GHz-et" érvelés, ami a "nem a szoftvert optimalizáljuk, hanem a user vegyen jobb jobb vasat" Windows világban megállja a helyét, az az Apple ökoszisztémában nem jelent sokat, mert a felhasználó elindítja a programot, az fut, ahogy kell és magasról tesz rá, hogy mennyi ramból és GHz-ből oldják meg.

Nem mellesleg ugyanezt csinálja a konzol piacon a Nintendo is.

Általában ez az, ami miatt a PC-n szocializálódott fórumozók nem tudják hova tenni az Apple sikereit, ezért jobb híján az Apple célközönségéről feltételeznek valamiféle irracionális márkahűséget, mert ugye világosan el lett nekik mondva, hogy az Apple nem éri meg, mert GHz, erre azok mégis csak a saját tapasztalataikra és nem a fórumhuszárokra hallgatnak. A hülyék.[ Szerkesztve ]

-

#54625216

törölt tag

A powerpc-ről váltás idején nem is értettük, hogy miért nem AMD, mert akkoriban az AMD kb. annyival volt az Intel előtt, mint most a Theadripper sorozattal.

Aztán kijött az Intel Core és minden értelmet nyert: az Apple nyilván jóval az Intel bejelentése előtt már aktívan dolgozott a Core procikkal és össze tudta hasonlítani az akkori AMD-kkel. -

#54625216

törölt tag

válasz

Ezekiell

#444

üzenetére

Ezekiell

#444

üzenetére

Szerintem az egész átállás legizgalmasabb kérdése, hogy az apple magára madar-e a "célhardver" koncepciójával, vagy új trendet indít el.

Az minden esetre jól látszik, hogy a 80-as évek eleje óta a hardver fejlődése tolja előre az iparágat és ez a fejlődés legalábbis az általános célú, egyszálas számítási teljesítményben nagyjából elérte a korlátait.

Ebből a szempontból az Apple váltása csak annyiban merész, hogy ők lépik meg elsőként azt, amit előbb-utóbb mindenkinek muszáj lesz.Ami a hardver optimalizációt illeti, ott van példának a Nintendo Switch. Eleinte volt rá a Zelda meg kb. semmi más, de a Switch eladások így is hamar elérték azt a kritikus tömeget, amit a 3rd party kiadók már nem hagyhattak figyelmen kívül. Így olyan játékokat is portoltak rá, mint a Witcher, ami a konzol megjelenésekor még a kétkedők első számú példája volt, hogy na az biztosan nem lesz rá.

Az Apple ebből a szempontból jó helyzetben van, mert az első pár millió ARM-os Mac-et biztosan el tudják adni csak az "Apple exkluzívokkal", a 3dr party fejlesztők meg kénytelenek lesznek azt a piacot is lefedni, ha nem akarják, hogy a konkurencia eléjük vágjon.Ami az Adobe-t illet, az Adobe eleve szarul optimalizál akármire, mégis a Photoshoppal demózták az ARM-os Mac-et.

Szvsz az Adobe-t első sorban az motíválja, hogy ha nem jelennek meg időben Mac-re, akkor sokan alternatív megoldásokat keresnek és ha kiderül, hogy lehet képet és videót szerkeszteni Adobe nélkül is, azt a PC-s eladásaik is megsínylik.

Az iPad esetében ilyen dilemmájuk nincs, mert bár kereslet lenne rá, de a PS hiánya iPadon nem indít el számukra kedvezőtlen felhasználói trendet. -

#54625216

törölt tag

válasz

Ezekiell

#461

üzenetére

Ezekiell

#461

üzenetére

"A Switch ugye game console, szóval nem nagyon lehet összehasonlítani egy általános célú számítógéppel."

Éppen ebben lesz szerintem paradigmaváltás a consumer piacon. A verseny nem az általános célú teljesítmény növelése lesz, hanem azoknak a számítási feladatoknak hardveres gyorsítása, ami a consumer felhasználók számára kritikusak.

"Az meg hogy az X86/64 elérte az egyszálú korlátait, hát az erős túlzás, bőven van teljesítménynövekedés van year to year. "

2000-2010 között a leggyorsabb intel cpu-k (P4 1.5Ghz - i7 980x) között az egyszálas teljesítmény különbség a PassMark szerint kb. 4.4X, míg 2010 és 2020 (i7 980x - i9 10900K) között 2X.

Többszálas teljesítményben viszont az i7 980x és a csúcstartó AMD Theadripper 3990x között már 12X a különbség, de még házon belül is az i9 10980XE alacsonyabb órajelen 5X gyorsabb.

Tehát jól látszik a trend, hogy az egyszálas teljesítmény növekedése lassul, a többszálasé meg gyorsul.

Az Apple is akkor váltott PowerPC-ről Intelre, amikor egyértelművé vált, hogy a nagyobb teljesítményt csak egyre növekvő fogyasztással lehet PowerPC alapon elérni. Hiába volt még növekedési potenciál a PowerPC-ben, jól látszott, hogy az Intellel szemben már középtávon se lett volna esélye."a multicore performance lesz a lényeg mindig is, sőt évről évre egyre jobban"

Egyetértek, és ez az, amiben az ARM technológia nyerhet, mert ugyanabból a tdp keretből és árból nagyobb többszálú teljesítményt tudnak kihozni. (Csak hogy elébe vágjak a vitának: nem feltétlenül egy chipbe paszírozva jöhet össze a teljesítmény, lehet alacsony fogyasztású és olcsó arm chipekből többet rakni egy gépbe úgy, hogy az össz fogyasztás és az ár közel azonos egy intel cpu-hoz viszonyítva.)

-

#54625216

törölt tag

válasz

Auratech

#476

üzenetére

Auratech

#476

üzenetére

"Szerintem az gyakori hiba, hogy nem tudatosul, hogy a naprakész, profi produkciós szoftvereknek inkább a naprakész gamer pc-k gépigénye dukál, nem pedig egy jobb irodai gép."

Ez windows ökoszisztémában nagyjából így van, de a Mac referencia hardver, azaz a fejlesztő vagy támogatja vagy nem, de ha bevállalja, akkor kénytelen az adott erőforrásokhoz optimalizálni.

Kb. olyan ez, mintha a PC-re fejlesztett játékot konzolra is ki kellene adni: PC-n belefér, hogy ha szarul van megírva a kód, akkor növelnek a hardverigényen, de konzolon fix erőforrásokkal kell gazdálkodni, azaz a fejlesztő vagy optimalizál, vagy bele se kezd. -

#54625216

törölt tag

Szvsz az Adobe termékeket úgy általában nem érdemes benchmarkként használni, mert a legszarabban optimalizált szoftverek a piacon.

A Photoshop külön állatfaj még az Adobe cuccai között is. Emlékszem amikor bejött a CC, előtte azt hiszem 7-es volt az utolsó verzió. A CC-vel áttértek 32 bites motorra úgy, hogy az összes létező képet float-ra konvertálták a memóriában, de 32 bit módban csak néhány hdr formátumon lehetett az eszközök kevesebb, mint 1%-át használni. Viszont így megtriplázódott a program memória igénye és a használhatatlanságig belassult. Konkrétan ha a 7-esben elmentett psd-n akartál CC-ben dolgozni, akkor gyakorlatilag semmilyen új funkciót nem kaptál, viszont vehettél új vasat, hogy rendesen tudjál dolgozni. Szánalom.

Az Adobe a grafikai világ Microsoftja: szar termékeket tolnak le a userek torkán és a piaci erőfölényükből élnek, mert hogy azért használják olyan sokan Adobe-t, mert olyan sokan használják.

(A 3D animációs piacon ugyanez az Autodesk: sorra felvásárolták a 3D animációs szoftvereket és vagy kinyírták őket, vagy használhatatlan bughalmazt kreáltak belőlük, mégis - a piacvezető pozíciójukat kihasználva - piacvezetők tudnak maradni.) -

#54625216

törölt tag

válasz

Auratech

#493

üzenetére

Auratech

#493

üzenetére

Normál esetben a 8 bites képeket is van értelme 16 vagy 32 bites színmélységben szerkeszteni. Ha több effektet pakolsz egymásra és mondjuk az egyik 1 fölé tolja a fényességet (kiégeti a képet), a másik pedig azt korrigálja (mondjuk egy maszkkal), akkor a 8 biten a kiégett részek helyén nem jönnek vissza a részletek, hanem szürke paca lesz, mert az 1 fölötti értékek a műveletek során elvesznek. 32 bites színmélységnél viszont a program képes az 1 fölötti értékeket is kezelni, így tetszőlegesen tolhatsz bármit 1 fölé (vagy akár negatív tartományba).

Csakhogy a PS CC-nél csak a kép bitmélységén módosítottak, az eszközökön semmit, azaz a 8 bites képeken ugyanúgy csak a 8 bites effekteket lehetett használni, így a 32 bitre konvertálásnak az égvilágon semmi értelme nem volt: minden 8 bit mellé írtak még 16 nullát, a műveleteket meg csak az első 8 biten végezték, a plusz 16-ot meg ignorálták. Ezzel nőtt az erőforrás igény, a funkcionalitás meg nem változott.

Azaz vagy maradtak volna 8 bites ábrázolásnál vagy írták volna át az összes eszközt rendesen 32 bitre.Persze az Adobe-nál pontosan tudták, hogy mit csinálnak: a fejlesztők megírták a 32 bites PS-t majd jött a marketing team és szétcincálta, hogy ez a feature megy majd a következő verziókba, ez meg az utána következőkbe, az erőforrás optimalizálás meg az utolsó a prioritások között.

Ilyen az, amikor egy cég erőfölényből diktál egy iparágnak. -

#54625216

törölt tag

válasz

Alchemist

#497

üzenetére

Alchemist

#497

üzenetére

Belinkelem ide is, amit pár (száz) hozzászólással feljebb már írtam:

Apple ökoszisztémában számít: olyan feladatok, amik az apple userek kiszolgálása szempontjából fontosak, azaz pl. a mérnöki-tudományos számítások pont nem ilyenek

Végtelen teljesítmény igény: ezeknél a számítási idő a konstans, mert a teljesítmény növelésével arányosan nehezedik a feladat, amíg a rendszer el nem éri a user számára még elviselhető számítási időt (pl. 3D render: addig bonyolítják a látványt, hogy még le tudja renderelni a gép vállalható idő alatt)

A cpu platform váltás szemponjából tehát az utolsó téglalap az érdekes, abban lehet valódi kockázata az Apple-nek, hogy lesznek olyan - az ökoszisztéma szempontjából lényeges, végtelen teljesítmény igényű, nem párhuzamosítható és célhardverrel nem kiváltható - feladatok, amiben a saját cpu-juk gyengébb lesz az x86 megoldásoknál.

-

#54625216

törölt tag

AIStokes megelőzött, én is a GPU-t akartam felhozni, hogy gyakorlatilag már ma is egy csomó dolgot, ami CPU szinten nem megoldható, hardveres gyorsítással pótolnak.

Azaz ha az iparág el is megy a hardveres gyorsítás irányába, a PC modularitása megmaradhat, mert legfeljebb a dedikált PCI-E gyorsító kártyákat fogják upgradelni, vagy az Apple által bevezetett hardveres megoldásokat (deep learning, stb.) PC-n a GPU-kba integrálják.

Azaz nagyjából ugyanaz fog történni, mint szokott: az Apple lép egy merészet, és ha sikeres, az megváltoztatja a piaci trendeket és egy idő után a technológia eléri a közép és az alsó szegmenseket is.

A különbség is valószínűleg megmarad az Apple és a PC-s világ között: az Apple a saját SoC-nak köszönhetően kevesebb fogyasztással, flottabbul és stabilabban tudja majd bevezetni a hardveres gyorsítókat, PC-n meg több lesz vele a szopás, de a hardver lényegesen olcsóbb lesz. -

#54625216

törölt tag

Hogy a fejlesztő miben hisz, az lényegtelen, mert a cég, aminek dolgozik az úgyis is a pénztermelésben fog hinni, akár Apple-nek hívják, akár másnak.

A zárt, exkluzív rendszer eleve nem csak a pénzszerzésről szól. Ha egy kézben tartod a hardver-os-szoftver-szolgáltatást, akkor nagyobb eséllyel tudod egymáshoz optimalizálni őket. Az appstore szűrés alapkoncepciója is az, hogy a 3rd party fejlesztők vegyék komolyan a fejlesztési irányelveket és ne szemeteljék teli a platformot legacy alkalmazásokkal.

Amúgy az IT szabványok az USA-ban megszokott logikát követik, azaz előbb valaki piacvezetőként elterjeszti a saját megoldását, amit később hivatalosan szabványként szentesítenek. Ebből a szempontból az Apple annyiban különbözik a többitől, hogy nem megy bele technikai kompromisszumokba csak azért, mert mások a piaci erőfölényből lenyomtak egy félmegoldást az iparág torkán.

Nyilván az Apple SoC-ok hardveres megoldásait nem fogják egy az egyben átvenni, hanem a funkcióikat fogják másolni. Mondjuk az FCPX-ben demózták a AI alapú cropolást, ami követi a szereplőt a videón. Ha ez a megoldás népszerű lesz, akkor nyilván nem az A12Z chipet fogják klónozni PC-re, hanem mondjuk az NVIDIA épít AI célhardvert a GPU-iba, a PC-s vágóprogramok pedig azt fogják használni. User szempontból lényegtelen, hogy mi van a motorháztető alatt, a lényeg a funkció és a performance.

És igen, a multiplatform fejlesztőknek mindkét oldalra optimalizálniuk kell, de szerintem ez jó dolog, mert egy rendszer tervezésekor a user legyen a prioritás és ne a fejlesztő kényelme, márpedig olyan szabvány az életben nem lesz, aminek a betartásával minden platformra - a platform specifikációtól függetlenül - a lehető legjobban optimalizált alkalmazásokat lehet fejleszteni.

-

#54625216

törölt tag

Abban is egyetértünk, hogy a fejlesztőknek hinniük kell abban, amit csinálnak és a pénz önmagában nem mindig elég motíváció.

Ugyanakkor nem hiszem, hogy pont az iparági szabványok miatt bárki is kenyértörésre vinné a dolgot a munkáltatójával, mert hogy a fejlesztő hitvallásával ellentétben a cég a saját üzleti érdekeit helyezi előtérbe és nem a nyílt szabványokat.

A fejlesztőnek nem technikai részletkérdésekben kell közös nevezőre jutnia a munkáltatójával, hanem a célban és a koncepcióban.Amúgy az Apple jellemzően nem a saját szabványaival szokta hergelni a piacot, hanem a legacy szabványok korai kivezetésével és az új (jellemzően nem Apple fejlesztésű) szabványok korai bevezetésével.

-

#54625216

törölt tag

válasz

Alchemist

#522

üzenetére

Alchemist

#522

üzenetére

Nem hinném, hogy a macOS az iOS-hez hasonlóan zárt lesz.

A Mac tartalomfejlesztő platform és ahhoz, hogy a macOS zárt lehessen pl. el kellene venni a userektől root jogot.

Ráadásul a zártság nem cpu kérdés, x86 alapon is már évekkel ezelőtt zárttá tehették volna."Ha a korlátozott erőforrású fejlesztő cég nem hisz abban, hogy a user kivárja és megfizeti az optimális eredményt, akkor vagy gyorsan odakennek valamit alibiből a "B" platformra vagy megmaradnak az "A-only" platformos megoldásnál."

Nyilván a fejlesztőnek mérlegelnie kell, hogy mi éri meg neki, a platform fejlesztő meg azt mérlegeli, hogy mennyi usert bukik x% fejlesztő elvesztéséve és mennyit nyer a saját - véleménye szerint nyilván jobb - technikai szabványaival.

Megint csak a Nintendo Switch-et tudom felhozni példának, hogy ha az adott platform piaca eléri a kritikus méretet, akkor a technológiai nehézségektől és szabványoktól függetlenül megjelennek rá a 3rd party fejlesztések is. -

#54625216

törölt tag

válasz

Ezekiell

#543

üzenetére

Ezekiell

#543

üzenetére

"Az 1 szálas teljesítmény a legfontosabb napjainkban - ahogy erről volt szó is itt a topikban."

"Valamint single core performance max játékoknál elsődleges, bármi produktivitás-centrikus

felhasználásnál a multicore performance lesz a lényeg mindig is, sőt évről évre egyre jobban."Bocsi, nem bírtam kihagyni.

-

#54625216

törölt tag

válasz

Ezekiell

#553

üzenetére

Ezekiell

#553

üzenetére

Szerintem consumer vonalon - elméletben - pont nem erős az egyszálas teljesítmény igény.

Windows ökoszisztémában persze igen, mert a consumer szoftvereket próbálják a legminimálisabb hardverkövetelményekhez igazítani, hogy a lehető legnagyobb közönséget érjék el, és ugyebár a legcsirkébb procikban 1 max. 2 mag van, így ahhoz igazítják a szoftvert is. Ezért alakult ki az a tapasztalat a felhasználókban, hogy kétszer annyi GHz többet ér, mint kérszer annyi cpu core, mert az egyszálas teljesítmény növelése azonnal érezhető, a több mag meg nem.

Amúgy már a 80-as évek óta probléma a fejlesztőknél, hogy nem nagyon használják ki a fejlettebb hardvert ha az felülről kompatibilis a gyengébbel, mert úgy nagyobb piacot érnek el akkor is, ha emiatt a szoftver minőségében kell kompromisszumot kötni. Commodore 128-ra pl. szinte semennyi játékot sem fejlesztettek, mert úgyis tudott C64 módban futni. Így viszont szinte mindenki C64 módban futtatta, azaz a fejlettebb hardvert a userek igen nagy százaléka egyszerűen nem használta.Ma ugyanez van PC-n a többmagos CPU-kkal: egy (esetleg két) magot maxra pörget a játék, a többi 3-6-8 pedig tétlenül várakozik, esetleg OS feladatok használják a maradék teljesítmény alig 1-2%-át.

Ezen fejlesztői mentalitás mögött viszont nem technikai, hanem a fent leírt piaci megfontolások vannak, mert pl. a játékok nagyon is ki tudnák használni akár egy 64 cpu-s gép teljesítményét is, hiszen maga a feladat alapvetően párhuzamosítható.Na most Mac-en - mint általában - más a helyzet, mint Windows-on.

Először is pont az ARM-ra váltással megszűnik a "legacy support" probléma, azaz a fejlesztők nem vesztenek piacot azzal, ha a consumer felhasználóknak is többszálú szoftvereket fejlesztenek, így - legalábbis Mac-en - elhárul az üzleti akadály a többszálúsítás elől.

A másik, hogy a Mac nem játék platform, tehát ha a játékfejlesztést visszafogja a PC-s mentalitás (mert nyilván nem fogják a játékok zömét alapjaitól újraírni a Mac kedvéért), az amúgy sem érinti a Mac-es consumer felhasználók zömét.[ Szerkesztve ]

-

#54625216

törölt tag

válasz

#54625216

#555

üzenetére

#54625216

#555

üzenetére

Update: Unity coming to Apple silicon

-

#54625216

törölt tag

válasz

Ezekiell

#563

üzenetére

Ezekiell

#563

üzenetére

Kb. ugyanaz: üzleti megfontolásból nem fektetnek időt és pénzt a fejlesztésbe, mert egy szálon a kenyérpirítón is elfut és ugye attól, hogy nem használja ki az összes magot még nem lesz lassabb.

ARM-os Mac-en viszont lassabb lesz, míg ha kihasználják a több magot és az egyéb hardveres gyorsítókat, akkor akár az x86-ot meg tudja előzni, és mivel nincs visszafele kompatibilitási kényszer, így üzleti szempontból is megéri optimalizálni.

Új hozzászólás Aktív témák

ph A vállalat külön lapkákat tervezne a Mac gépekbe, illetve leporolják az egyszer már jól bevált Rosettát is.

- AMD Ryzen 3600 (pár napig használt, szinte új)

- BESZÁMÍTÁS! ÚJ Intel Core i5 11400F / i9 11900KF / i9 11900K tálcás processzorok 27% áfás számlával

- Beszámítás! Intel Core i3 9100 4 mag 4 szál processzor garanciával hibátlan működéssel

- Beszámítás! Intel Core i3 10105 4 mag 8 szál processzor garanciával hibátlan működéssel

- Intel Core i7-11700K processzor (használt)