- Telekom mobilszolgáltatások

- A Watch7-tel debütálhat a Samsung vércukormérője

- Fotók, videók mobillal

- iPhone topik

- Garmin Forerunner 165 - alapozó edzés

- Samsung Galaxy S24 Ultra - ha működik, ne változtass!

- Samsung Galaxy S23 és S23+ - ami belül van, az számít igazán

- Bemutatkozott a Redmi új szériája

- Oppo Find X5 Pro - megtalálták

- Bluetooth-headsetekről általában

Hirdetés

-

A Video AI lehet a One UI 6.1.1 ütőkártyája

ma Vagy hogy fogja a mesterséges intelligencia manipulálni a mozgóképeket?

-

Robotkart irányított a majom a kínai Neuralink agyi chipjével

it A mindezt lehetővé tévő Neucybert a Neuralink kínai riválisa, a Beijing Xinzhida Neurotechnology fejlesztette ki.

-

VR játék lesz az Alien: Rogue Incursion

gp Az év végén érkező program PC-re, Meta Quest 3-ra és PlayStation VR2-re érkezik a tervek szerint.

Új hozzászólás Aktív témák

-

Kansas

addikt

válasz

#06658560

#63

üzenetére

#06658560

#63

üzenetére

Tíz évvel ezelőtt még nem volt ekkora divat a vízhűtés, sőt, akkoriban még hőterítő fém backplate-ek se nagyon voltak.

Arról nem is szólva, hogy amit az akkori 300W-körüli kártyák tudtak, azt most egy "belépő szintű" GTX1650 vagy pláne RX5500XT a kisujjából kirázza, negyed annyi fogyasztásból.

A mostani 300W-os kártyákra az emberek túlnyomó többségének nincs "szüksége". Persze, minél gyorsabb, annál jobb, de kompromisszumokkal(ahogy itt fentebb is többen írták), bőven meg lehet lenni nélkülük.

Ahogy eddig is (egy kivétellel, bár az inkább kuriózum), szvsz ezután is meg fog állni a csúcs VGA-k fogyasztása 300W körül, és javarészt épp azért, amiről itt diskurálunk: nagyjából ennyit lehet egy VGA kártyára való méretű hűtővel lehűteni. Tudnának ennél nagyobb fogyasztású, erősebb GPU-kat csinálni, csak azokhoz egzotikus hűtés(pl. Peltier-elem+folyadék) kéne, ami erősen megdobná az árát és/vagy korlátozná a rendszerekbe való beépíthetőségét(pl. 4-slotos videokártya).Szóval ja, 300W nem kevés, de biztos lehetsz benne, hogy kitalálnak valamit a megfelelő hangerő mellett való lehűtésére, miellőtt piacra dobják - NVidia se véletlenül kísérletezik új hűtő design-nal...

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

-

arn

félisten

válasz

#06658560

#63

üzenetére

#06658560

#63

üzenetére

igazan halkan tdpben szvsz kb 100w cpu es 200w gpu hutheto meg leghutessel. mindig azt veszem, ami kb ebbe belefer, az ilyen tulhuzott, csucsrajaratott vasakat mindig elkerulom.

[ Szerkesztve ]

facebook.com/mylittleretrocomputerworld | youtube.com/mylittleretrocomputerworld | instagram.com/mylittleretrocomputerworld

-

Darmol

senior tag

válasz

#06658560

#37

üzenetére

#06658560

#37

üzenetére

A HBM technikai paraméterek tekintetében hatalmas előnyben van, ezt nyilván te is tudod. Ott ahol bevetették, és ez nem a játékos kártyák kategóriája, ott kihasználható. Az ára miatt nem terjedt el, ha ár nem lenne probléma, akkor most mindenki, és minden tehát nV is HBM-el menne. Érdekes, hogy pont ezt hoztad fel, mert nem írtam de azon forogtak a fogaskerekeim, ha a bigNavi és Ampere olyan árban lesz ahogy sejtem, én gyártók helyében nem tökölnék és mindkettőre ráraknék 16-32-64GB HBM2-t, mert árban nem oszt nem szoroz.

A CUDA is érdekes példa. Én arra emlékszem, mikor a Vulkan-ról írtak cikket, és abban írták, hogy az OpenCL felejtős hosszú távon, a CUDA-ra nem emlékszem, lehet hogy arra is ugyanezt a sorsot várta. De a telefonok Vulkan támogatás bevezetésének a fényében nem hiszem, hogy nagyot tévedett. CUDA-val ugyanaz a helyzet, mint a GSync-el: nV nagyon magánál akarja tartani a gyeplőt, ezért idővel olyan hátrányba kerül a technológia, ahol nV fel fogja adni. Ez nV számára üzletileg jó, vásárlók számára nem feltétlenül. De az is igaz, hogy ez vagy érdekli a delikvenst vagy nem, illetve a vásárlókat ért hátrány a többség számára nem releváns.Aki azt mondja "nem tudom elhinni az igazságot" az naiv. Aki azt mondja "nem akarom tudni az igazságot" az ostoba. Aki azt mondja "az igazság tilos" az gonosz. Aki azt mondja "én határozom meg az igazságot" az beteg.

-

Abu85

HÁZIGAZDA

válasz

#06658560

#88

üzenetére

#06658560

#88

üzenetére

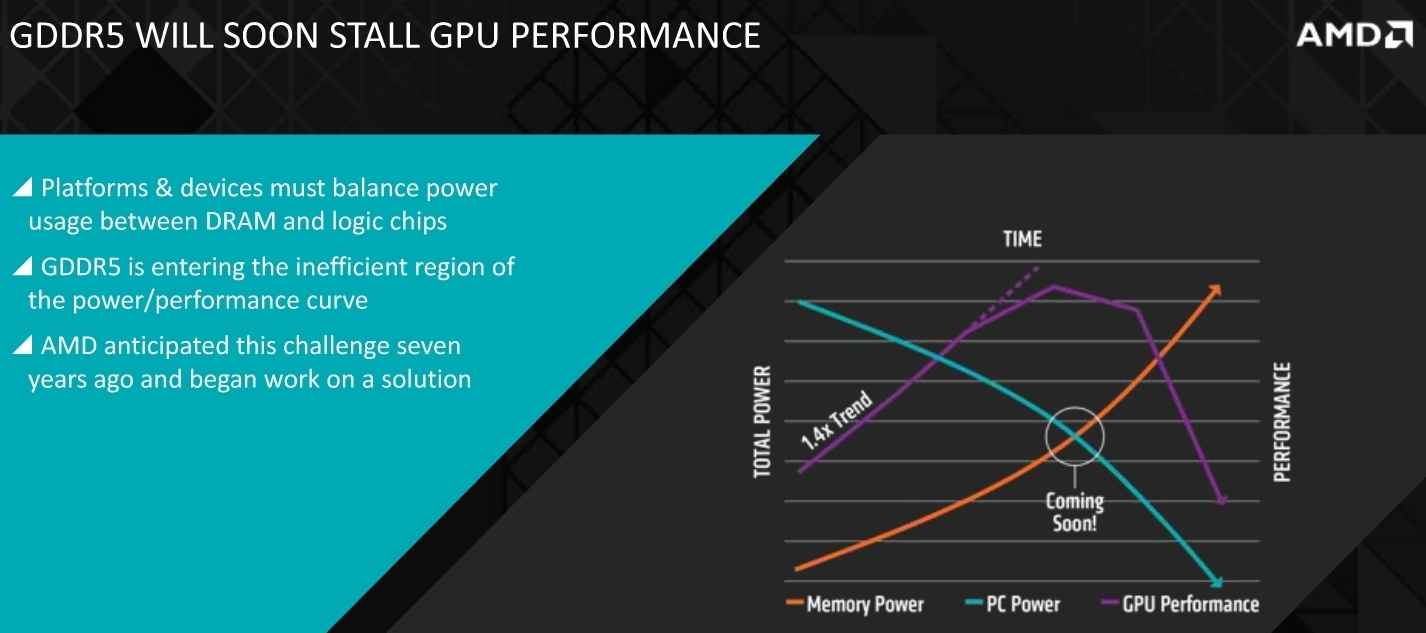

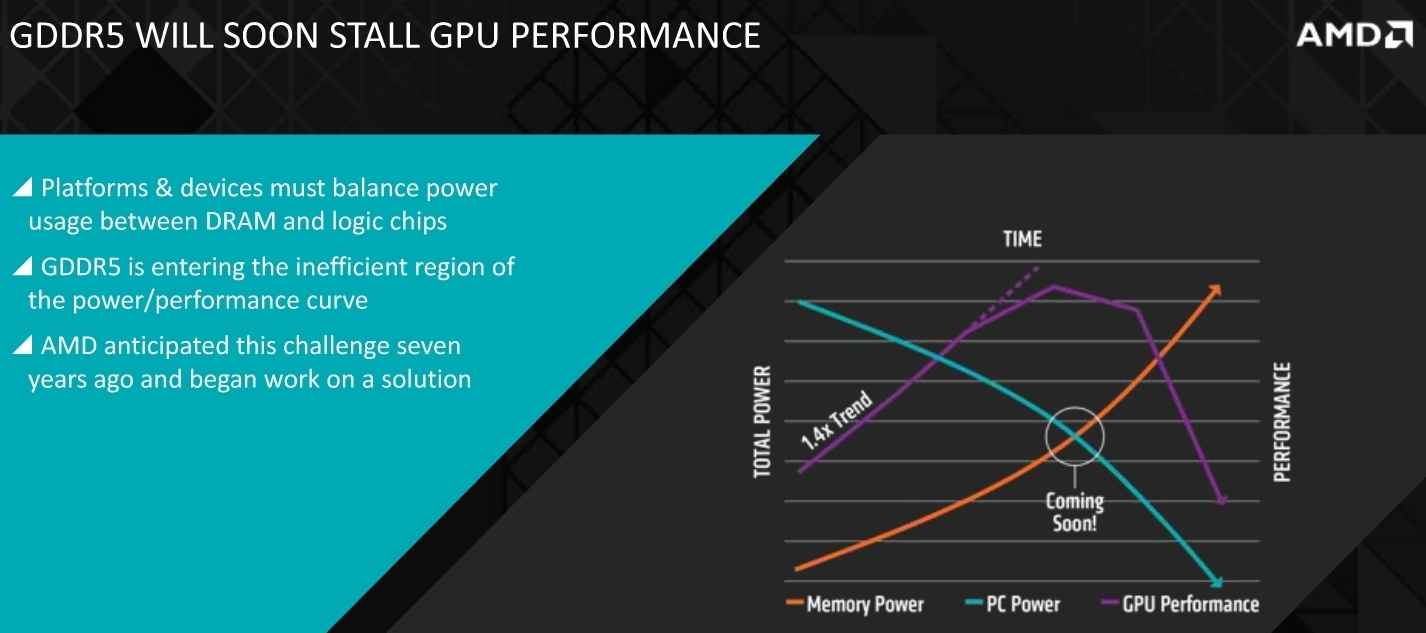

A fogyasztás a HBM legnagyobb előnye a hagyományos memóriákkal szemben. Az egész alaptechnológiát azért dolgozta ki az ipar, hogy a memóriafal jelenségére reagáljon.

Ez a grafikon az alapprobléma. Minden egyes új memóriával az történt, hogy egy stack működéséhez több energiára volt szükség. A GDDR5 volt az első memóriaszabvány, ahol ez az energiaigény nagymértékben nőtt, vagyis bekerült a rossz hatékonyságú régióba. 2 watt per stack, az nagyon rossz hatékonyság, mert ahhoz, hogy növelni lehessen a sávszélt, szélesebb busz kell, de a szélesebb busz miatt több stacket kell használni. 64 bitenként kettőt vagy négyet, attól függően, hogy mennyi memória lesz a végterméken. Tehát már a 2010-es évek előtt átvillant a mérnökök agyán, hogy ha ez így megy tovább, akkor az 1 TB/s-os határ irreálisan magas fogyasztással hozható csak. Olyan magassal, hogy maga a lapka mellé épített memória többet fog fogyasztani, mint a konkrét lapka. És ez azzal jár, hogy ha nem lehet majd az egekig növelni a TDP-t, akkor a gyorsabb memória miatt alacsonyabb órajeleket kell beállítani a lapkára, vagyis összességében csökken a teljesítmény.

Erre reagál a HBM, méghozzá azzal, hogy kiszedi azt a részt, amitől a GDDR olyan baszott nagy fogyasztó lett. Tehát az effektív órajel alacsonyra van véve, cserébe a memóriabusz rendkívül széles. Ez is bajos lesz később, mert csak nyertünk 10 évet, hogy addig kitaláljuk mit kezdünk majd a HBM problémáival, majd olyan 10-15 TB/s környékén. Addig viszont ezt el tudjuk skálázni, és majd ott a HBM is nagy fogyasztó lesz, de ugye a GDDR esetében még az 1 TB/s is egy neves álom.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

Új hozzászólás Aktív témák

ph Az RDNA 2-es dizájnt használó Navi 21 képességekben és teljesítményben is javul, de ez várható volt.

- Windows 11

- Magga: PLEX: multimédia az egész lakásban

- Székesfehérvár és környéke adok-veszek-beszélgetek

- Facebook és Messenger

- Autós topik

- Mozilla Firefox

- HP notebook topic

- Azonnali VGA-s kérdések órája

- Azonnali informatikai kérdések órája

- A Gigabyte is visszaveszi alaplapjainak alapértelmezett tuningját

- További aktív témák...